生成式 AI 项目的工程化范式:基于标准化目录结构的深度解析

《生成式AI项目的工程化实践》摘要:本文系统介绍了一套标准化生成式AI项目结构模板,旨在解决AI项目从实验到生产过程中常见的代码混乱、技术债务等问题。该模板通过模块化设计实现"配置与代码分离",包含config/集中管理参数、src/分层实现业务逻辑、data/规范存储数据资产、notebooks/实验沙箱等核心组件。其突出特点包括:1)模型客户端抽象层实现多模型兼容;2)Pr

在生成式 AI 技术爆发式落地的今天,一个项目从快速原型到稳定生产的跨越,往往受制于混乱的代码结构、模糊的职责划分与缺失的工程规范。大量 AI 项目在初期追求 “快速验证”,却在迭代中陷入 “技术债务泥潭”:配置硬编码在业务逻辑中、模型客户端与业务代码深度耦合、实验代码与生产代码混杂、数据资产缺乏统一管理…… 这些问题不仅导致项目维护成本指数级增长,更让跨团队协作、版本迭代与规模化部署成为奢望。

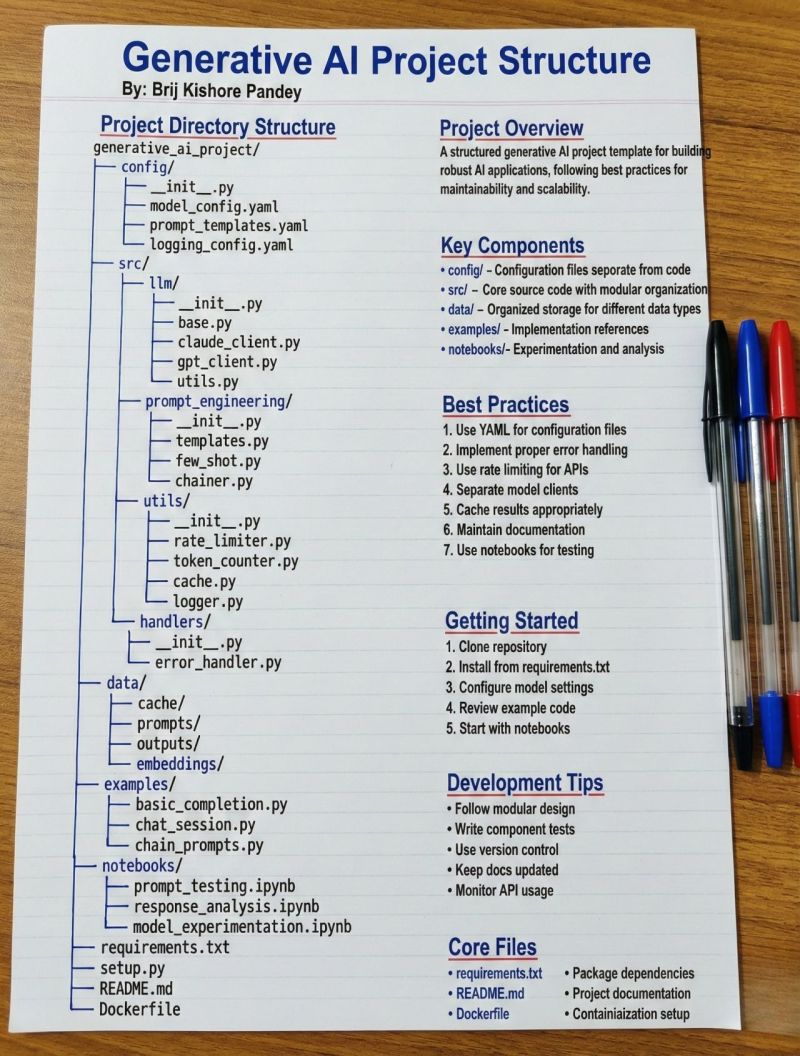

由 Brij Kishore Pandey 提出的这份《Generative AI Project Structure》,正是为破解这一困境而生。它以 “模块化设计、职责分离、可复用性、可扩展性” 为核心原则,构建了一套从实验到生产全链路覆盖的标准化项目模板。本文将深度拆解这一结构的设计理念、目录细节、核心价值与落地路径,为生成式 AI 项目的工程化实践提供系统性参考。

一、项目目录结构:从根目录到子模块的工程化设计

一个健壮的项目结构,本质是 “系统思维” 在代码世界的具象化。这份模板的目录设计遵循 “高内聚、低耦合” 的软件工程原则,将不同职责的代码、配置、数据与文档进行分层拆分,让每个模块都能独立演进且协同高效。

1. 根目录:项目的 “基础设施层”

根目录作为项目的入口,承载着项目的元信息、依赖管理与部署配置,是团队协作与环境交付的基础:

- requirements.txt:项目依赖的 “契约文件”,通过精确指定 Python 包的版本,确保开发、测试与生产环境的一致性,避免 “在我电脑上能跑” 的尴尬。

- setup.py:将项目封装为可安装的 Python 包,支持通过

pip install -e .实现本地开发,同时为后续的 PyPI 发布或内部包管理提供基础。 - README.md:项目的 “用户手册”,需包含项目背景、快速启动、核心功能、目录说明与贡献指南,是新成员快速融入的关键。

- Dockerfile:容器化交付的核心,通过定义镜像构建步骤,让项目可以在任何支持 Docker 的环境中一键部署,彻底解决 “环境不一致” 问题。

2. config/:配置与代码分离的设计哲学

配置与业务逻辑的耦合,是 AI 项目迭代中常见的 “顽疾”—— 当需要切换模型参数、调整 prompt 模板或修改日志级别时,开发者不得不改动核心代码,既增加了出错风险,也降低了迭代效率。config/目录的设计正是为了破解这一问题:

__init__.py:将目录标识为 Python 模块,支持通过from config import *导入配置。model_config.yaml:模型参数的 “控制面板”,集中管理不同模型(如 GPT-4、Claude 3)的 API 密钥、模型名称、温度系数、最大 token 数等参数。例如,当需要从 GPT-3.5 切换到 GPT-4 时,只需修改此文件中的model_name字段,无需改动业务代码。prompt_templates.yaml:Prompt 工程的 “资产库”,将不同场景的 prompt 模板(如客服对话、代码生成、文档摘要)以结构化方式存储,支持通过模板名称动态调用。例如,将 “电商商品文案生成” 的 prompt 模板存入后,业务代码只需传入商品参数即可生成文案,无需重复编写 prompt。logging_config.yaml:日志系统的 “配置中心”,定义日志的级别、格式、输出位置(控制台 / 文件),让日志的调整无需修改代码,只需更新配置文件。

3. src/:核心业务逻辑的模块化拆分

src/(source 的缩写)是项目的 “心脏”,承载了所有核心业务逻辑。其设计遵循 “单一职责原则”,将复杂的 AI 系统拆解为多个低耦合的子模块,每个模块只负责一类功能:

(1)src/llm/:大模型客户端的抽象与实现

大模型是生成式 AI 项目的核心依赖,但不同厂商(OpenAI、Anthropic、Google)的 API 接口差异较大,直接调用会导致业务代码与特定模型深度绑定。llm/模块的核心价值是通过抽象层实现 “模型无关性”:

base.py:定义抽象基类(如BaseLLMClient),统一规范模型客户端的接口(如generate()、chat_completion()),让上层业务代码无需关心底层模型的具体实现。claude_client.py/gpt_client.py:具体模型的客户端实现,继承自BaseLLMClient,负责与对应厂商的 API 交互,处理签名、请求封装与响应解析。当需要新增模型(如 Gemini)时,只需新增一个gemini_client.py即可,无需修改上层业务逻辑。utils.py:模型交互的辅助工具,如响应格式校验、token 使用统计等,提升客户端的健壮性。

(2)src/prompt_engineering/:Prompt 工程的体系化管理

Prompt 是生成式 AI 的 “编程界面”,但复杂场景下的 Prompt 往往需要动态拼接、few-shot 示例注入或多轮对话管理。prompt_engineering/模块将 Prompt 从业务代码中剥离,实现 Prompt 的可复用与可迭代:

templates.py:Prompt 模板的加载与渲染工具,从config/prompt_templates.yaml中读取模板,支持通过变量替换生成最终 Prompt。few_shot.py:Few-shot 示例的管理工具,支持动态加载示例集,为模型提供上下文参考,提升生成内容的准确性。chainer.py:多轮对话与链式调用的编排工具,支持将多个 Prompt 或模型调用串联成复杂的工作流,例如 “先通过摘要 Prompt 生成文档摘要,再通过问答 Prompt 基于摘要回答问题”。

(3)src/utils/:通用工具的沉淀与复用

AI 项目中存在大量跨模块的通用功能,如 API 限流、token 计数、缓存管理等。utils/模块将这些功能封装为可复用的工具类,避免代码重复,提升开发效率:

rate_limiter.py:API 限流工具,基于令牌桶或漏桶算法控制模型 API 的调用频率,避免触发厂商的限流机制,保障服务稳定性。token_counter.py:Token 计数工具,支持统计 Prompt 与响应的 token 数量,结合模型的最大 token 限制,动态调整输入长度,避免请求失败。cache.py:缓存工具,支持将高频请求的结果(如重复的 Prompt 生成内容)存入内存或 Redis,减少重复调用,降低成本并提升响应速度。logger.py:日志工具,基于config/logging_config.yaml初始化日志系统,提供统一的日志接口,支持不同模块的日志分级管理。

(4)src/handlers/:异常与事件的统一处理

生成式 AI 项目面临大量不确定性:API 调用失败、网络波动、参数错误等。handlers/模块负责统一处理这些异常与事件,提升系统的容错能力:

error_handler.py:全局异常处理工具,定义不同异常类型的处理逻辑(如 API 超时重试、参数错误返回友好提示),避免异常扩散导致系统崩溃。

4. data/:数据生命周期的有序管理

生成式 AI 项目的迭代依赖大量数据:Prompt 历史、模型输出、嵌入向量(Embedding)等。data/目录将这些数据按生命周期与类型分类存储,避免数据混乱与丢失:

cache/:缓存数据的存储目录,与src/utils/cache.py配合,持久化高频请求的缓存结果。prompts/:历史 Prompt 的归档目录,用于后续的 Prompt 优化与效果分析。outputs/:模型生成结果的存储目录,支持按场景、时间戳分类,方便后续的人工校验与效果评估。embeddings/:向量数据的存储目录,当项目涉及检索增强生成(RAG)时,用于存储文档的 Embedding 向量,供后续的相似度检索使用。

5. examples/:快速上手的范例代码

对于新开发者或业务方而言,直接阅读复杂的核心代码门槛较高。examples/目录提供了一系列可运行的范例,展示项目的核心功能与典型场景:

basic_completion.py:基础文本生成的示例,演示如何调用模型客户端生成内容。chat_session.py:多轮对话的示例,展示如何通过prompt_engineering/chainer.py实现连贯的对话交互。chain_prompts.py:链式 Prompt 调用的示例,演示如何将多个 Prompt 串联成复杂的工作流。

这些示例不仅是 “新手教程”,更是业务场景的 “模板库”,开发者可以基于示例快速定制自己的业务逻辑。

6. notebooks/:实验与迭代的沙箱

生成式 AI 的开发是一个 “实验驱动” 的过程,需要不断迭代 Prompt、调整模型参数、评估生成效果。notebooks/目录为这一过程提供了交互式的沙箱环境:

prompt_testing.ipynb:Prompt 迭代的实验笔记本,支持快速修改 Prompt 并验证效果,记录不同版本的 Prompt 生成结果,为最终的 Prompt 模板提供依据。response_analysis.ipynb:生成结果的分析笔记本,通过统计、可视化等方式评估模型输出的质量(如准确性、相关性、多样性),为模型优化提供数据支持。model_experimentation.ipynb:模型对比的实验笔记本,支持切换不同模型或参数,对比生成效果,为选型与调优提供决策依据。

Notebooks 的价值在于 “快速验证”—— 开发者可以在不改动生产代码的前提下,完成从 Prompt 设计到模型评估的全流程实验,实验成熟后再将代码沉淀到src/模块中。

二、核心组件:高内聚低耦合的工程实践

这份项目结构的核心优势,在于通过清晰的组件划分,实现了 “业务逻辑、配置、数据、实验” 的解耦,让每个组件都能独立演进且协同高效。

1. config/:配置的集中管理与环境适配

配置与代码分离是软件工程的基本原则,但在 AI 项目中尤为重要。config/目录将所有可变参数(如 API 密钥、模型参数、Prompt 模板)集中存储,带来三大价值:

- 环境适配灵活:通过不同环境的配置文件(如

model_config.dev.yaml、model_config.prod.yaml),可以快速切换开发、测试与生产环境的参数,无需修改代码。 - 权限管控清晰:敏感信息(如 API 密钥)可以通过环境变量或加密配置文件存储,避免硬编码在代码中,降低安全风险。

- 迭代效率提升:调整 Prompt 模板或模型参数时,只需修改配置文件,无需重新部署代码,大幅缩短迭代周期。

2. src/:业务逻辑的分层实现

src/模块的分层设计,让核心业务逻辑摆脱了对具体模型与工具的依赖:

- 抽象层(

llm/base.py):定义统一的模型接口,让上层业务代码无需关心底层模型的差异,实现 “一次编写,多模型兼容”。 - 实现层(

llm/gpt_client.py等):负责与具体模型的 API 交互,处理底层细节,让上层逻辑聚焦业务价值。 - 工具层(

utils/、handlers/):提供通用的辅助功能,提升代码复用性与系统健壮性。

这种分层设计不仅让项目可以快速适配新模型,也让业务逻辑的迭代更加聚焦 —— 当需要优化 Prompt 工程时,只需修改prompt_engineering/模块,无需改动模型客户端;当需要提升系统稳定性时,只需优化utils/rate_limiter.py,无需调整业务代码。

3. data/:数据资产的规范存储

生成式 AI 项目的迭代依赖数据驱动,data/目录的规范存储让数据成为可复用的资产:

- 可追溯性:按时间戳、场景分类存储的 Prompt 与生成结果,让开发者可以追溯每一次实验的输入输出,为效果评估与问题排查提供依据。

- 可复用性:归档的 Prompt 模板与 Embedding 向量,可以在后续项目中直接复用,避免重复劳动。

- 可扩展性:当项目引入新的数据类型(如多模态数据)时,只需在

data/目录下新增子目录即可,无需改动核心代码。

4. examples/:可复用的业务场景模板

examples/目录的范例代码,不仅是新开发者的 “入门指南”,更是业务场景的 “积木库”。开发者可以基于范例快速搭建自己的业务流程,例如:

- 基于

chat_session.py扩展为客服对话系统; - 基于

chain_prompts.py构建文档摘要 + 问答的 RAG 系统; - 基于

basic_completion.py实现商品文案生成工具。

这种 “范例驱动” 的开发方式,大幅降低了业务场景的落地门槛,让项目可以快速响应业务需求。

5. notebooks/:从实验到生产的桥梁

Notebooks 在 AI 项目中扮演着 “实验室” 的角色,它连接了实验与生产:

- 快速验证:开发者可以在 Notebooks 中快速迭代 Prompt、调整模型参数,验证效果后再将代码沉淀到

src/模块,避免将未成熟的代码直接推入生产。 - 知识沉淀:Notebooks 中的实验记录、分析结果与可视化图表,是团队共享知识的重要载体,让新成员可以快速理解项目的迭代过程与决策依据。

- 协作效率:通过 Jupyter Notebook 的共享与评论功能,团队成员可以围绕实验结果展开协作,提升决策效率。

三、最佳实践:保障项目健壮性与可扩展性的底层逻辑

这份项目结构不仅提供了目录模板,更隐含了一系列保障项目长期健康发展的最佳实践,这些实践是从大量 AI 项目的工程化经验中沉淀而来。

1. 配置文件与代码分离:让迭代更灵活

将配置与代码分离,是提升项目迭代效率的核心手段。通过config/目录的集中管理,开发者可以在不改动代码的前提下调整参数,避免了 “改一行代码,全量部署” 的低效模式。例如,当需要调整 GPT-4 的温度系数时,只需修改model_config.yaml中的temperature字段,无需重新部署服务。

2. 实现严格的错误处理:提升系统容错能力

生成式 AI 项目面临大量不确定性,API 调用失败、网络波动、参数错误等问题时有发生。src/handlers/error_handler.py的全局异常处理,让系统可以优雅地应对这些问题:

- 对 API 超时的请求进行自动重试;

- 对参数错误的请求返回友好的提示信息;

- 对未知异常进行日志记录与告警,让开发者可以快速定位问题。

这种 “防御式编程” 的思路,大幅提升了系统的稳定性与用户体验。

3. API 限流与缓存:平衡成本与性能

大模型 API 的调用成本较高,且存在限流机制。src/utils/rate_limiter.py与cache.py的设计,正是为了平衡成本与性能:

- 限流:通过控制 API 调用频率,避免触发厂商的限流机制,保障服务的连续性。

- 缓存:将高频请求的结果存入缓存,减少重复调用,降低成本并提升响应速度。例如,对于重复的商品文案生成请求,直接返回缓存结果,无需再次调用模型 API。

4. 模型客户端与业务逻辑解耦:提升可扩展性

通过src/llm/base.py的抽象基类,项目实现了 “模型无关性”—— 当需要新增模型(如 Gemini)时,只需新增一个gemini_client.py并继承BaseLLMClient,无需修改上层业务逻辑。这种解耦设计让项目可以快速适配新模型,避免了 “绑定单一厂商” 的风险。

5. 实验驱动的开发流程:让迭代更科学

notebooks/目录的实验沙箱,让项目的迭代从 “凭经验” 转向 “数据驱动”:

- 开发者在 Notebooks 中迭代 Prompt、调整模型参数,通过

response_analysis.ipynb评估生成效果; - 实验成熟后,将代码沉淀到

src/模块,实现从 “实验” 到 “生产” 的平滑过渡; - 最终的 Prompt 模板存入

config/prompt_templates.yaml,成为可复用的资产。

这种 “实验 - 沉淀 - 迭代” 的流程,让项目的每一次优化都有数据支撑,大幅提升了迭代的科学性与效率。

四、开发流程与落地指南:从克隆仓库到生产部署

一份优秀的项目结构,不仅需要清晰的设计,更需要可落地的开发流程。这份模板提供了从 “克隆仓库” 到 “生产部署” 的完整指南,让开发者可以快速上手。

1. Getting Started:快速启动的五步流程

- 克隆仓库:通过

git clone获取项目代码,快速搭建本地开发环境。 - 安装依赖:通过

pip install -r requirements.txt安装项目所需的 Python 包,确保环境一致性。 - 配置模型参数:修改

config/model_config.yaml,填入 API 密钥、模型名称等参数,完成环境初始化。 - 参考示例代码:运行

examples/目录下的范例,熟悉项目的核心功能与使用方式。 - 从 Notebooks 开始实验:在

notebooks/prompt_testing.ipynb中迭代 Prompt,验证效果后沉淀到src/模块。

这一流程让新开发者可以在 1 小时内完成从 “环境搭建” 到 “实验验证” 的全流程,大幅降低了入门门槛。

2. Development Tips:保障项目长期健康的实践建议

- 遵循模块化设计:新增功能时,优先考虑是否可以复用现有模块,避免重复造轮子;若需新增模块,遵循 “单一职责原则”,保持模块的高内聚与低耦合。

- 编写组件测试:为核心模块(如

src/llm/base.py、src/utils/rate_limiter.py)编写单元测试,确保功能的正确性与稳定性。 - 使用版本控制:通过 Git 管理代码的版本,每一次迭代都提交清晰的日志,便于回溯与协作。

- 保持依赖更新:定期更新

requirements.txt中的包版本,避免使用过期的依赖带来的安全风险与兼容性问题。 - 监控 API 使用:通过

src/utils/logger.py记录 API 调用日志,监控 token 使用量与调用频率,及时发现异常并优化成本。

这些建议不仅是开发技巧,更是保障项目长期健康的 “底层逻辑”。

五、工程化思维的延伸:从单体项目到规模化 AI 系统

这份项目结构的价值,不仅在于解决单体项目的工程化问题,更在于为规模化 AI 系统的构建提供了可复用的范式。当项目从 “单一场景” 走向 “多场景协同”、从 “单模型” 走向 “多模型融合” 时,这套结构可以通过以下方式演进:

1. 模块化设计的演进:从单体到微服务

当项目涉及多个独立的业务场景(如客服对话、商品文案生成、文档摘要)时,可以将src/模块拆分为多个微服务,每个服务负责一个场景,通过 API 网关实现协同。例如:

- 客服对话服务:基于

src/llm/与prompt_engineering/构建,提供多轮对话接口; - 文案生成服务:基于

src/prompt_engineering/与utils/cache.py构建,提供商品文案生成接口; - 文档摘要服务:基于

src/llm/与data/embeddings/构建,提供文档摘要与问答接口。

这种微服务架构让每个场景可以独立迭代,提升了系统的可扩展性与容错能力。

2. 可观测性与运维保障:从被动响应到主动监控

随着项目规模的扩大,可观测性变得至关重要。可以在现有结构的基础上,新增monitoring/目录,集成 Prometheus、Grafana 等工具,实现对 API 调用量、token 使用量、响应时间等指标的实时监控。同时,通过alerting/目录配置告警规则,当出现异常时(如 API 调用失败率过高),自动触发告警,让开发者可以快速响应。

3. 团队协作与版本控制:从个人开发到团队协同

当团队规模扩大时,需要建立更完善的协作机制:

- 通过 Git Flow 管理代码分支,区分开发、测试与生产环境;

- 通过 Conventional Commits 规范提交日志,便于版本回溯与协作;

- 通过 GitHub Actions 等 CI/CD 工具,实现代码的自动测试、构建与部署,提升交付效率。

这些机制让团队可以高效协同,保障项目的快速迭代与稳定交付。

结语:生成式 AI 项目的工程化未来

生成式 AI 技术的爆发,正在重塑各行各业的业务模式,但技术的价值最终需要通过工程化落地来实现。这份《Generative AI Project Structure》不仅是一份目录模板,更是一套工程化思维的体现 —— 它告诉我们,优秀的 AI 项目不仅需要 “聪明的模型”,更需要 “健壮的工程”。

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)