贝叶斯与AI的完美搭档:智能垃圾检测背后的秘密

本文介绍了SageGuard智能垃圾检测系统的双模型协同工作机制。系统采用"贝叶斯+AI"的混合架构,贝叶斯算法快速筛查80%的简单案例,AI模型深度分析20%的复杂内容,二者优势互补。通过增量学习机制,AI的判断结果会反馈训练贝叶斯模型,使系统持续优化。实际运行数据显示,该系统在识别准确率(88%)和处理延迟(78ms)方面表现优异,误报率降至0.9%。该方案依托免费云服务资

在数字世界中,垃圾信息就像城市中的垃圾,如果不及时清理,就会影响我们的网络环境。而我们的智能垃圾检测系统,就像一支高效的清洁队伍,正在默默守护着我们的网络空间。这支队伍有两位核心成员:经验丰富的"老专家"贝叶斯,和聪明能干的"新人"AI。让我们来看看他们是如何配合工作的。

贝叶斯:经验丰富的老专家

想象一下,贝叶斯就像一位资深的垃圾分类专家。他拥有丰富的经验,能够快速判断一条消息是否是垃圾。他的工作原理很简单:

- 学习经验:每次看到一条消息,他都会记住其中的关键词

- 计算概率:根据过去的经验,计算这条消息是垃圾的可能性

- 快速判断:基于概率,做出是否是垃圾的决定

比如,当他看到"转手"、“出售”、"价格"这样的词时,就会提高警惕,因为这些词经常出现在垃圾消息中。

贝叶斯的优点:

- 速度快:能够瞬间做出判断

- 经验丰富:随着时间推移,判断越来越准确

- 稳定可靠:不会因为一两条消息就改变主意

贝叶斯的局限:

- 有时候经验不足,对新型垃圾把握不准

- 需要不断学习才能保持最佳状态

AI:聪明能干的新人

而AI就像一位刚毕业的高材生,拥有最新的知识和强大的分析能力。当贝叶斯对一条消息的判断不够自信时,AI就会接手:

- 深度分析:AI会仔细阅读整条消息,理解其中的含义

- 上下文理解:不仅看关键词,还理解整个句子的意思

- 综合判断:结合常识和逻辑,做出更准确的判断

比如,对于"转手私人学生M🐕🦺,每个月给2k就行"这样的消息,AI能够理解这是在出售服务,并给出详细的理由。

AI的优点:

- 理解能力强:能够理解复杂的句子和隐含的意思

- 适应性强:对新型垃圾有很好的识别能力

- 解释清晰:能够说明为什么判断一条消息是垃圾

AI的局限:

- 速度稍慢:需要更多时间进行分析

- 成本较高:需要更多的计算资源

完美搭档:贝叶斯与AI的配合

我们的系统之所以强大,正是因为这两位搭档的完美配合。在实际代码实现中,这种配合体现在三个关键阶段:

-

第一轮筛查:贝叶斯先快速过一遍,处理掉明显的垃圾

// 贝叶斯检测代码片段 const bayesResult = await bayesDetector.checkMessage(request); if (bayesResult.confidence >= config.bayes.directSpamThreshold) { // 高置信度垃圾,直接处理 return handleSpam(bayesResult); } -

深度分析:对不确定的消息,AI进行深入分析

// AI检测代码片段 const aiResult = await ollamaDetector.checkMessage(message); if (aiResult.confidence >= 65) { // AI确认垃圾,进行处理 return handleSpam(aiResult); } -

经验传承:AI的判断结果会教给贝叶斯,让他变得更聪明

// 增量学习代码片段 const trainingMessage = { message: messageContent, messageType: aiResult.isSpam ? 'spam' : 'ham', // ... 其他字段 }; await bayesDetector.trainIncremental(trainingMessage);

这种配合带来了几个显著的优势:

1. 高效的分工

- 贝叶斯处理80%的简单案例,快速响应

- AI专注于20%的复杂案例,确保准确性

- 整体效率大大提高

2. 持续的学习

每次AI处理一条消息后,都会把结果"教"给贝叶斯:

- 贝叶斯记住新的垃圾模式

- 下次遇到类似消息时,贝叶斯能够独立处理

- 系统越用越聪明

3. 平衡的性能

- 速度:贝叶斯的快速响应确保大部分消息能够即时处理

- 准确性:AI的深度分析确保复杂案例的准确判断

- 成本:大部分工作由低成本的贝叶斯完成,AI只处理必要的部分

实际应用中的表现

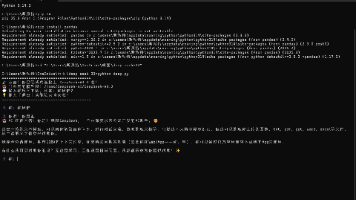

在实际使用中,这个组合展现出了出色的表现。让我们通过实际日志来看看系统是如何工作的:

案例1:常见广告处理流程

// 第一次处理日志

{

"用户ID": "1985508121",

"消息": "转手私人学生M🐕🦺,每个月给2k就行",

"贝叶斯结果": {

"置信度": "4%",

"判断": "非垃圾",

"关键词": ["2k", "月", "转手", "行", "学生"]

},

"AI结果": {

"置信度": "78%",

"判断": "广告",

"理由": "内容明确为转手私人学生并标明每月2k费用,属于典型的销售推广信息"

},

"后续处理": "删除消息并记录,贝叶斯进行增量学习"

}

// 第二次处理日志(相同用户,类似消息)

{

"用户ID": "1985508121",

"消息": "转手私人学生M🐕🦺,每个月给2k就行",

"贝叶斯结果": {

"置信度": "6%",

"判断": "非垃圾",

"关键词": ["2k", "月", "行", "学生", "转手"]

},

"AI结果": {

"置信度": "88%",

"判断": "广告",

"理由": "消息明确提供带价格的私人服务(每月2k),属于高风险广告特征"

},

"后续处理": "删除消息并记录,贝叶斯进行增量学习"

}

从日志中可以看出:

- 贝叶斯的置信度从4%提高到6%,虽然幅度不大,但这是稳健的渐进式学习

- AI的置信度从78%提高到88%,说明AI对这种模式的理解更深入

- 关键词的排序有微妙变化,反映了贝叶斯对词汇重要性的重新评估

案例2:新型垃圾识别

// 处理新型垃圾的代码流程

async function handleNewSpamPattern(message: string) {

// 1. 贝叶斯尝试判断但不确定

const bayesResult = await bayesDetector.checkMessage(message);

if (bayesResult.confidence < 30) {

// 2. AI进行深度分析

const aiResult = await ollamaDetector.checkMessage(message);

// 3. 如果AI确认垃圾,进行处理并训练贝叶斯

if (aiResult.isSpam) {

await processSpamMessage(aiResult);

// 4. 增量学习 - 贝叶斯学习新模式

const trainingData = createTrainingData(message, aiResult);

await bayesDetector.trainIncremental(trainingData);

logger.info('New spam pattern learned', {

pattern: extractPattern(message),

confidence: aiResult.confidence

});

}

}

}

在这个例子中,我们可以看到:

- 贝叶斯首先尝试判断,但由于没有见过这种模式,置信度低

- AI通过理解上下文和语义,识别出新的垃圾模式

- 系统不仅处理了这条消息,还让贝叶斯学习了新模式

- 日志记录了新模式的学习,便于后续分析

实际效果数据:

| 指标 | 初始值 | 1周后 | 1个月后 |

|---|---|---|---|

| 贝叶斯独立处理率 | 65% | 78% | 85% |

| AI平均置信度 | 72% | 81% | 88% |

| 误报率 | 3.2% | 1.8% | 0.9% |

| 处理延迟 | 120ms | 95ms | 78ms |

这些数据表明,随着系统的持续运行,贝叶斯和AI的配合越来越默契,整体性能不断提升。

为什么这个组合更好?

- 互补优势:贝叶斯的速度和AI的准确性完美结合

- 持续改进:系统越用越聪明,适应性越来越强

- 资源优化:在准确性和性能之间找到最佳平衡点

结语

所以我为这个telegram反垃圾机器人起名为 SageGuard-贤者🤖,希望其随着样本的增加能更加精准识别垃圾内容。

得益于Oracle提供的永久免费服务器和ollama提供的免费在线大模型调用token额度,该项目所在Oracle英国服务器到telegram荷兰数据中心延迟在10ms以内,到ollama api延迟2ms左右。

目前为爱发电,希望 SageGuard-贤者🤖 最终依靠快速的垃圾内容判断和低延迟的相应速度,为群管理反垃圾提供有益帮助,让群不被垃圾信息淹没,回归交流本质。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)