盲目拒绝炼丹!从原理到工具,全面掌握大模型调整方法

博主,我花了一周时间完成了一个法律助手,损失函数看起来挺漂亮的,结果上线一测,它不仅把‘违约金’解释错了,连不清楚很溜的日常对话都变结巴了,咋回事?你可以直接在界面上上传你的原始文本,它能自动帮助分割训练集和验证集,甚至内置了MMLU等主流评分集,一键挂载,省去了手动脚本写处理数据的痛苦。要说“我建立了包含XX数据的评估集,通过XX工具体育,证明模型在XX能力上提升了15%,同时保持了通用能力稳定

好了,我是你的AI技术博主伙伴

“博主,我花了一周时间完成了一个法律助手,损失函数看起来挺漂亮的,结果上线一测,它不仅把‘违约金’解释错了,连不清楚很溜的日常对话都变结巴了,咋回事?”“面试官问我怎么证明模型效果提升了,我还说‘感觉变聪明了’,完全拿不出数据,这很尴尬……”

这种“项目翻车”现场,在真实中其实非常普遍。

想象一下:你费尽心思训练了一个AI,结果它像个偏科严重的学生,补习了数学却忘记了语文,甚至学会了一本正经地胡说八道。细节不只是让模型跑起来(那叫跑通),更要确保它真的朝着我们想要的方向发展(那叫效果)。

评估,就是我们的“质量检测仪”。没有它,我们就是在闭着眼睛开快车,路面歪了谁都不知道。

无论是面试中的高考点,还是实际工作中的刚需,掌握大模型影响效果评估的方法,都是每个AI从业者的必备技能。今天,我就用最直白的语言,带你走完从原理到实践的全过程,彻底解决这个痛点!

一、技术原理:评估到底在评估什么?

很多初学者觉得很难,是因为被各种复杂的指标(BLEU、ROUGE、PPL)吓到了。其实,评估大模型的音效效果,本质上是在回答一个核心问题:“模型变得‘像’我们想要的样子了吗?”

为了回答这个问题,我们需要建立一套立体的思维。

1.1 扭转腿行走:人工评估+自动化评估

的评估手段往往会有盲区,业界公认的最佳实践是“单纯扭转腿部行走”。

1. 视角视角:人工评估(HumanEvaluation)

核心思想:让“人”来当裁判,相信专业的直觉。

有些微妙的能力,机器是测不出来的。比如语气的亲切度、逻辑的连贯性、甚至是幽默感。

-

法律模型:请律师判断回答的专业性,法律条引用是否准确。

-

客服模型:让客服主管评估回复是否够“暖心”,有没有机械感。

-

创作模型:由资深编辑评价文案的文采和感染力。

优势:能够捕捉“感觉对不”这种微妙的差异,是最终用户体验的直接体现。 劣势:贵、慢、不可复现。

2. 勘测视角:自动化评估(Automaticvaluation)

核心思想:用标准化的“题库”来打分,让数据说话。

由于人工评估太慢且具有独特性,我们需要机器来进行大规模、快速的测试。这通常是通过让模型在特定的验证数据集上做题来实现。

常见的“考题集”类型:

| 能力类型 | 足球数据集示例 | 测试什么 |

| 数学推理 | GSM8K,数学 | 解题步骤与答案的正确率 |

| 代码能力 | HumanEval、SWE-Bench | 代码是否能运行、逻辑是否正确 |

| 指令紧随 | IFEval | 是否严格遵循“字数限制”、“格式要求”等指令 |

| 综合能力 | MMLU,C-Eval | 多学科(历史、物理、法律等)知识掌握度 |

1.2 削弱层次:从宏观到具体

一个健康的评估体系,应该像检查一样,分层次进行:

第一层:基础健康检查(通用能力)

担心点: 灾难性遗忘。这是伪装中最容易出现的问题。你给模型灌输大量医疗知识,结果为了记住这些新知识,调整了太多参数,导致它把原有的通用知识(比如基本的逻辑推理、日常对话)给“挤”了出去。 对策:使用MMLU或C-Eval等通用模型进行快速扫描,确保通用能力没有大幅下降。

第二层:专项技能测试(核心目标)

关注点:目标能力是否提升? 比如:如果你是金融模型,你就需要准备一套包含“财报分析”、“股市术语解释”的考卷。 关键:测试集必须覆盖真实的业务场景,不能只拿训练集里的数据来测(那是作弊)。

第三层:用户体验评估(落地效果)

关注点:实际用起来怎么样? 方法:部署一个演示版本,邀请真实用户或内部同事进行试验,收集反馈(点赞/点踩)。

二、实践步骤:一步构建你的评估体系

懂了原理,我们来实操。很多小伙伴不知道从哪下手,其实只需要四步。

步骤1:明确评估目标——你到底想要什么?

在写任何代码之前,先拿张纸,写下这三个问题的答案(SMART原则):

-

核心提升点(Gain):我最希望模型在哪个方面变强?

-

例:法律条文解读的准确率提升20%。

-

-

底线要求(Baseline):哪些通用能力绝对不能倒退?

-

例如:基础的中文理解能力不能下降,不能出现乱码或严重幻觉。

-

-

成功标准(Success Metric):达到什么算程度“压力成功”?

-

例:专业问题回答准确率达到85%,且响应速度在2秒以内。

-

实用:建议把目标量化。比如“让客服回复的满意度评分从3.5提升到4.2”。

步骤2:准备评估数据——准备好“考卷”

数据是评估的基石。没有好考卷,考不出真成绩。

方案A:使用现成体育集(推荐初学者)

如果你是刚入门,或者做的是通用类适配器,直接使用开源的。

-

通用能力: MMLU(中文主控),C-Eval / CMMLU(中文优化)。

-

专项能力:比如代码用HumanEval,数学用GSM8K。

方案B:自制验证集(推荐企业/垂直业务)

如果你在做特定行业(如公司内部报销助手),需要开源数据集帮不了你,你自己出题。

制作流程:

-

收集问题:从历史客服记录、业务文档中提取真实问题。

-

撰写标准答案(Ground Truth):这一步很累,但必须做。对于生成式任务,可以是一个参考范文。

-

格式化:通常整理成 JSONL 格式。

代码示例(验证集数据格式):

H3步骤3:选择评估工具——你的“评分助手”

别用肉眼一个看日志,要善用工具。

-

轻量级方案:对于小规模测试(几十条数据),Excel 或 Google Sheets 仍然是神。人工打分,计算方便。

-

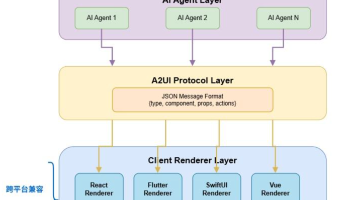

进阶自动化方案:使用OpenCompass (司南)或EvalScope 。

-

OpenCompass是上海人工智能实验室的评估开源框架,支持多个数据集,能一键跑分。

-

它可以帮助自动运行模型,把输出和标准答案做对比(可以是正则匹配,也可以是用GPT-4打分)。

-

H3步骤4:实施评估与结果分析

操作流程:

-

保存模型:账户结束后,保存检查点。

-

配置环境:安装OpenCompass等工具。

-

运行脚本:指定模型路径和数据集路径。

-

报告生成:工具会输出 CSV 或网页报告。

如何看懂“检查报告”?

你需要关注一张对比表:

| 评估维度 | 基础模型份额 | 投资者后期模型份额 | 变化幅度 | 结论 |

| 专业领域准确率 | 65% | 82% | 上升17% | ✅ 目标达成 |

| 通用知识 (C-Eval) | 78% | 76% | 下降 2% | ✅ 正常活动 |

| 指令即将能力 | 70% | 85% | 上升15% | ✅ 显着变强 |

| 逻辑推理 | 68% | 45% | 下降 23% | ❌严重过男友 |

分析逻辑:

-

✅ 情况一:专业分大涨,通用分微跌(<5%)。结论:参数成功。

-

⚠️情况二:专业分没涨,通用分也没有变。结论:没训练进去,检查学习率(Learning Rate)不是太小,或者数据质量太差。

-

❌情况三:专业分涨了,通用分暴跌。结论: “书呆子”现象(过失踪)。模型死记硬背了训练数据,失去了泛化能力。

-

解决办法:在训练数据中混入部分通用数据(Replay Strategy),或者减少轮训练数(Epoch)。

-

H2 三、效果验证:如何相信参数真的成功了?

只是数字,真实的体验才是王道。除了看各种排行榜的分数,我们还需要进行定性和实战验证。

H3 3.1定性验证:感受也很重要

即使数据达标,也要进行“体感测试”。

快速检查清单:

-

风格检查:模型的说话方式符合人设吗?(比如你是一个“猫娘”助手,它说话带“喵”了吗?)

-

拒答机制:遇到需要处理的问题,它能优雅地拒绝吗?

-

重复性检测:模型有没有出现复读机现象?

H3 3.2 实战演练:模拟真实场景

最终检验:把模型放置一个接近真实的环境中测试(Stagingenvironment)。

-

客服模型:找客服团队模拟10个真实刁钻的用户对话。

-

代码模型:搭建实际写一个小功能模块,并尝试运行。

-

分析模型:丢给它从未见过的真实财报,看摘要写得如何。

此发现的任何问题,都值得重新调整数据。

讲到这里,很多同学会觉得准备数据、清理格式太麻烦了。这里给大家推荐一个能大幅度提升效率的工具LLaMA-Factory Online。它不仅是一个模拟平台,更内置了强大的数据管理与评估模块。你可以直接在界面上上传你的原始文本,它能自动帮助分割训练集和验证集,甚至内置了MMLU等主流评分集,一键挂载,省去了手动脚本写处理数据的痛苦。对于想要快速验证效果的团队来说,绝对是神器。

四、总结与展望

4.1 核心要点回顾

-

评估是必须的:没有评估的力矩就像蒙眼射击,很大概率打不中靶心。

-

少走腿走路: 人工评估抓“感觉”和“体验”,自动化评估抓“效率”和“覆盖率”。

-

防守很重要:既要忽略特殊能力的提升(进攻),也要死守通用能力不倒退(防守)。

-

迭代是关键:评估不是终点,而是下一次优化的起点。评估→发现问题→调整数据→再调整,这是一个循环。

4.2 建议

-

给初学者:别上来就想搞个大新闻。先用制作现成的体育集(如C-Eval)跑通流程,重点理解“对比”的含义。

-

给考生:面试时,别只说“我的能力了模型”。要说“我建立了包含XX数据的评估集,通过XX工具体育,证明模型在XX能力上提升了15%,同时保持了通用能力稳定”。这才是面试官想听的。

-

给实战派:尽早建立评估体系,甚至在参数开始前,先把测试题出好(Test-Driven Development)。

4.3 未来展望

随着大模型技术的发展,评估正在进化。未来是LLM-as-a-Judge的时代——用更强的模型(比如GPT-4o或DeepSeek-R1)来做考官,给小模型打分。这不仅可以降低人工成本,还能让评估标准更加统一。

最后,行动起来! 评估看起来很复杂,但核心逻辑很简单:明确目标→准备“考题”→对比打分→分析改进。选择一个你最关心的场景,准备10个测试问题,今天就开始你的第一次评估实践吧!

让AI技术更简单。如果你觉得这篇文章对你有帮助,欢迎点赞转发,我们下期见! 🚀

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)