C++大模型SDK开发实录(三):流式交互协议SSE解析与httplib实现原理

在大语言模型(LLM)的应用场景中,用户体验的流畅性至关重要。传统的“请求-等待-响应”全量模式会让用户在模型生成长文本时面临长时间的空白等待。为了实现类似打字机的实时输出效果,我们需要引入流式传输技术。本文将从理论层面剖析适合LLM场景的Server-Sent Events (SSE) 协议,对比其与WebSocket的优劣,并深入讲解如何在C++中使用库实现流式数据的接收与处理。

目录

前言

在大语言模型(LLM)的应用场景中,用户体验的流畅性至关重要。传统的“请求-等待-响应”全量模式会让用户在模型生成长文本时面临长时间的空白等待。为了实现类似打字机的实时输出效果,我们需要引入流式传输技术。

本文将从理论层面剖析适合LLM场景的Server-Sent Events (SSE) 协议,对比其与WebSocket的优劣,并深入讲解如何在C++中使用 cpp-httplib 库实现流式数据的接收与处理。

第一章:即时通信的基石——SSE协议解析

HTTP协议本质上是“请求-响应”模型的,服务器处于被动地位,无法主动向客户端推送数据。这种“一问一答”的机制在即时性要求高的场景下显得力不从心。

1.1 为什么选择SSE?

SSE (Server-Sent Events) 是一种构建在HTTP协议之上的轻量级服务器推送技术。它允许服务器在建立连接后,主动、持续地向客户端发送文本数据流。

SSE具有以下显著特点,使其成为LLM流式响应的理想选择:

- 基于HTTP:无需自定义协议或额外端口,能够穿透大多数防火墙和代理服务器,兼容性极佳。

- 单向通信:LLM的生成过程正是“用户发送一次提示词(Prompt),模型持续返回生成内容”的模式,完全符合SSE“服务器到客户端”的单向流特性。

- 轻量简单:相比于复杂的WebSocket握手,SSE的数据格式仅为纯文本,解析成本极低。

- 内置重连:协议规范中包含了自动重连机制(虽然在SDK开发中通常由应用层控制)。

1.2 SSE数据格式

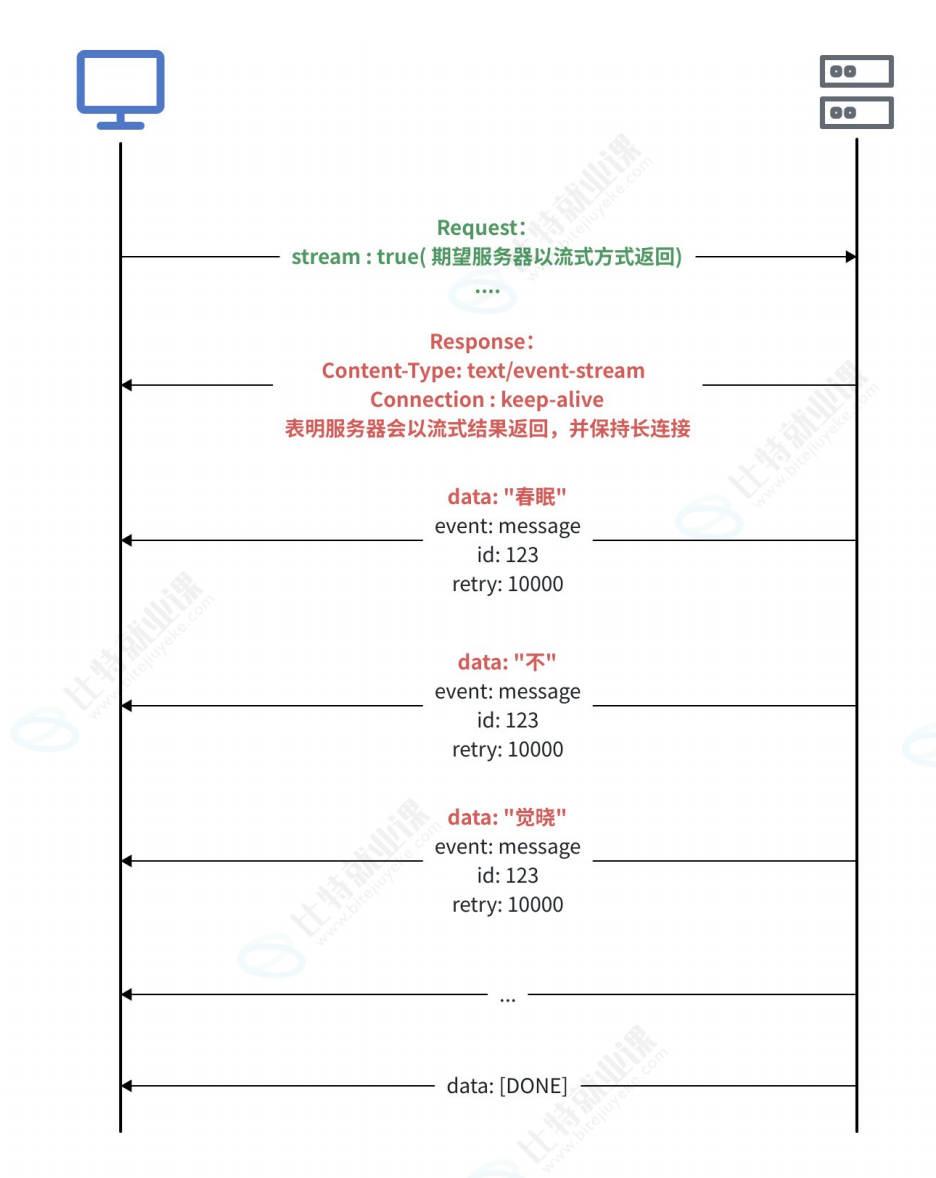

SSE的数据流由一系列文本块组成,每个块之间用空行分隔。LLM常用的数据格式如下所示:

data: {"id": "chatcmpl-123", "choices": [{"delta": {"content": "你"}}]}

data: {"id": "chatcmpl-123", "choices": [{"delta": {"content": "好"}}]}

data: [DONE]

客户端只需按行读取以 data: 开头的内容,解析JSON即可获得增量文本。

第二章:协议选型——SSE vs WebSocket

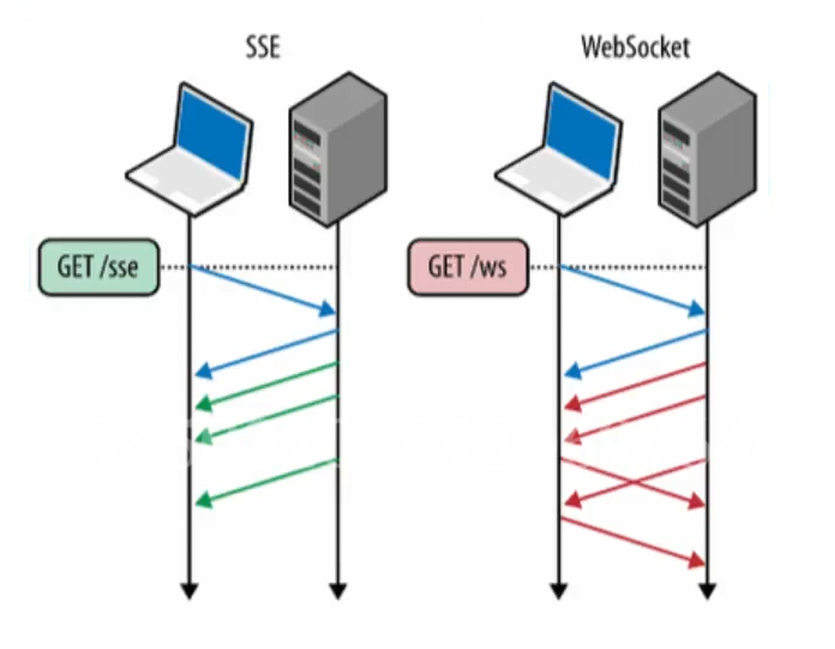

除了SSE,WebSocket也是实现实时通信的主流技术。为什么在ChatSDK中我们坚定地选择SSE?

2.1 轮询与WebSocket的局限

最原始的轮询(Polling) 方式要求客户端不断发送请求询问“生成好了吗?”,这会产生大量无效的网络开销且延迟高。

WebSocket 提供了全双工(双向)通信能力,适用于聊天室、多人游戏等需要频繁互动的场景。

2.2 技术特性对比

| 特性 | SSE (Server-Sent Events) | WebSocket |

|---|---|---|

| 通信方向 | 单向:服务器 → \rightarrow → 客户端 | 双向:服务器 ↔ \leftrightarrow ↔ 客户端 |

| 设计目的 | 状态更新、日志流、LLM生成 | 实时聊天、游戏同步、交易系统 |

| 协议基础 | 标准HTTP协议 | 独立的TCP协议(需HTTP升级握手) |

| 数据格式 | 纯文本(UTF-8) | 二进制或文本 |

| 适用性 | 完美适配LLM流式输出 | 功能过剩,实现复杂度高 |

对于ChatSDK而言,用户发送Prompt后,只需被动接收模型的生成结果,无需在生成过程中向服务器反向发送数据。因此,SSE不仅够用,而且更轻量、更易于调试。

第三章:cpp-httplib的流式处理机制

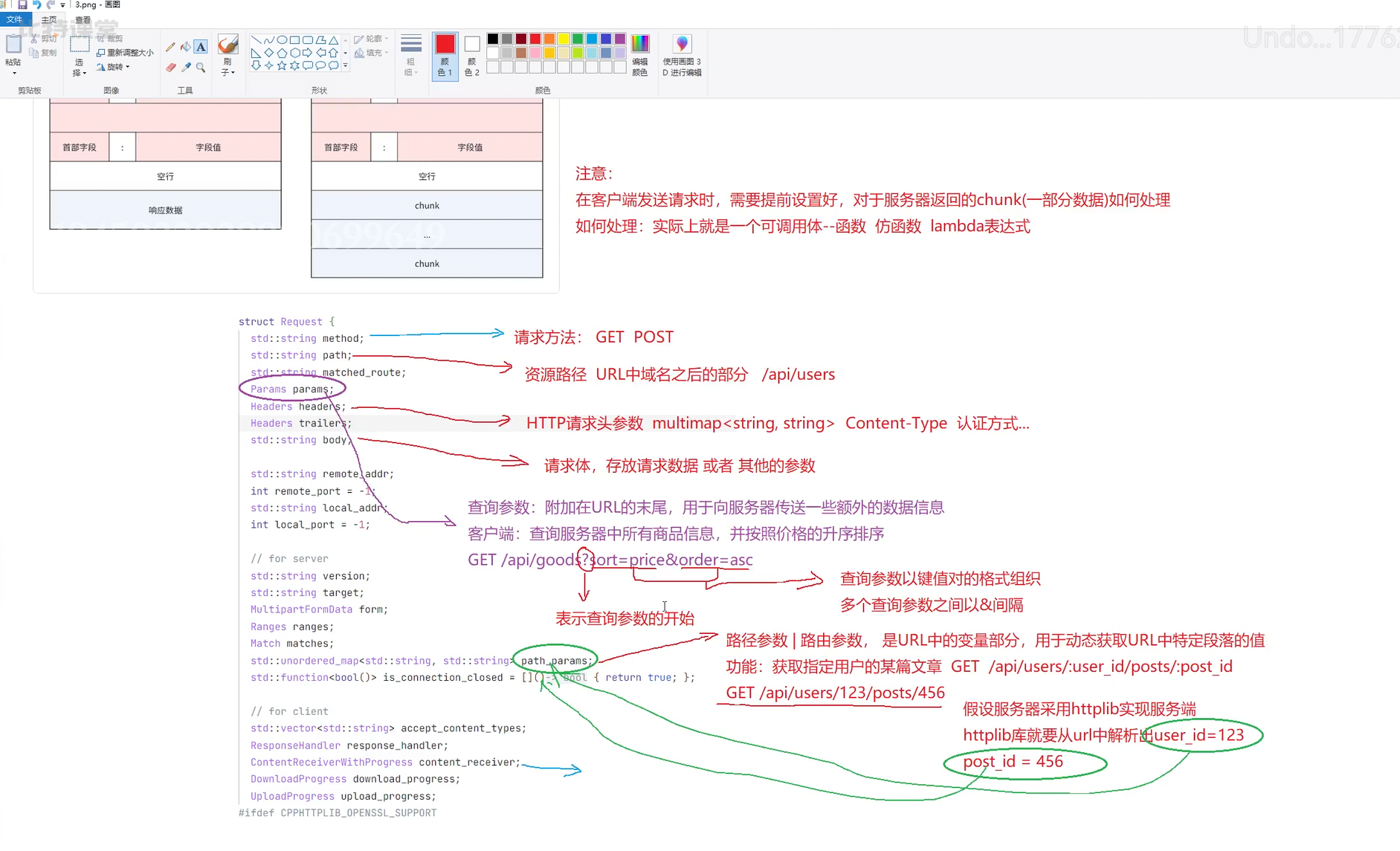

在C++中实现SSE客户端,关键在于如何处理HTTP的“分块传输编码”(Chunked Transfer Encoding)。cpp-httplib 库通过灵活的回调机制提供了完善的支持。

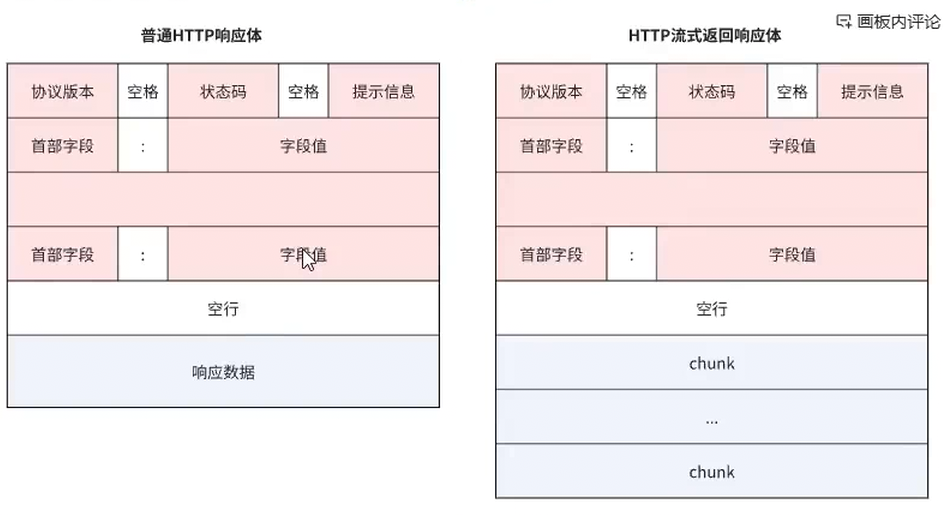

3.1 普通响应与流式响应的区别

- 普通响应:包含一个Header和一个完整的Body。客户端必须等待整个Body接收完毕才能进行处理。

- 流式响应:包含一个Header和多个顺序到达的Chunk。客户端需要在接收到Header后,立即对后续到达的每一个Chunk进行实时处理。

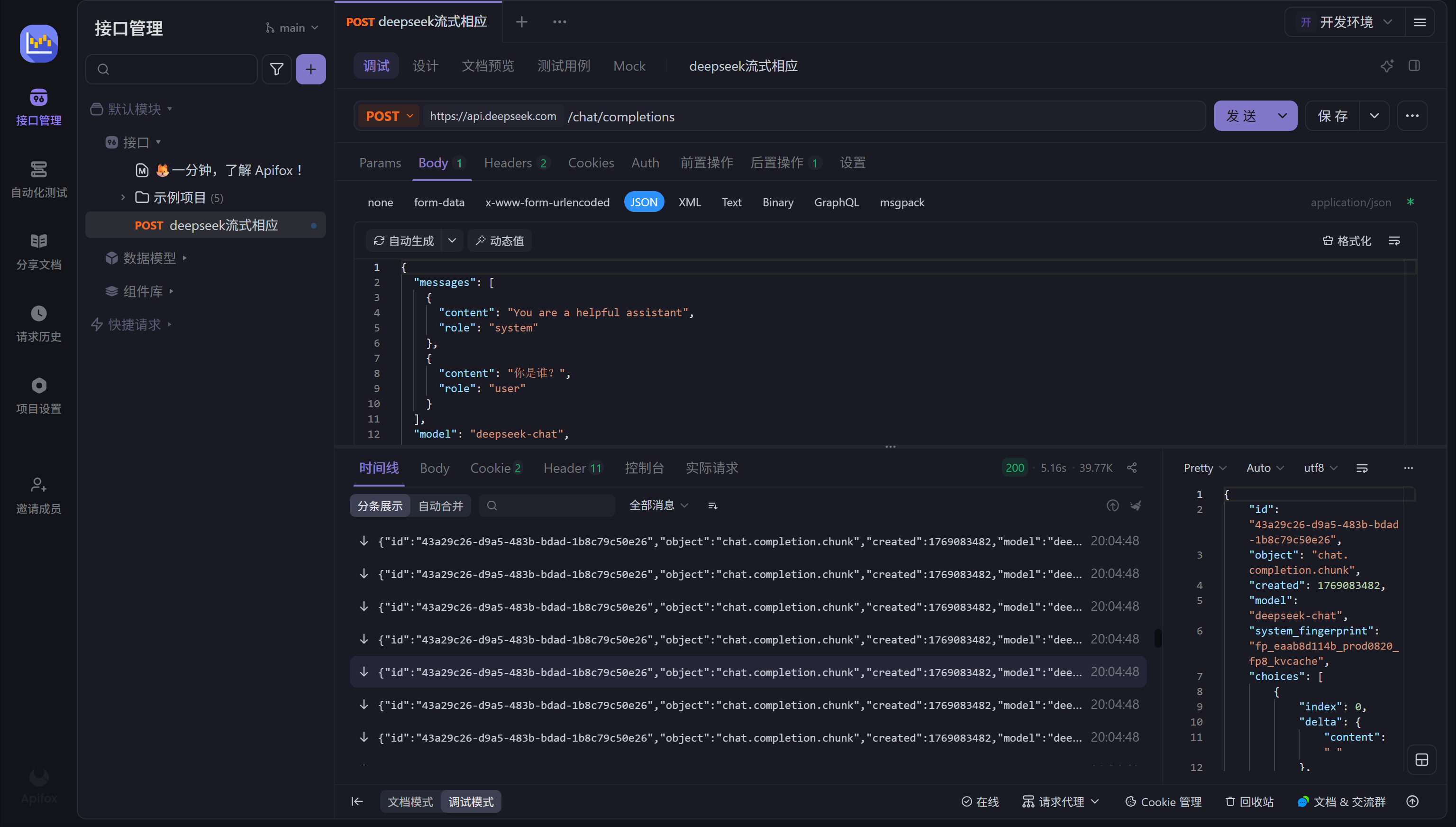

3.2 httplib的核心回调参数

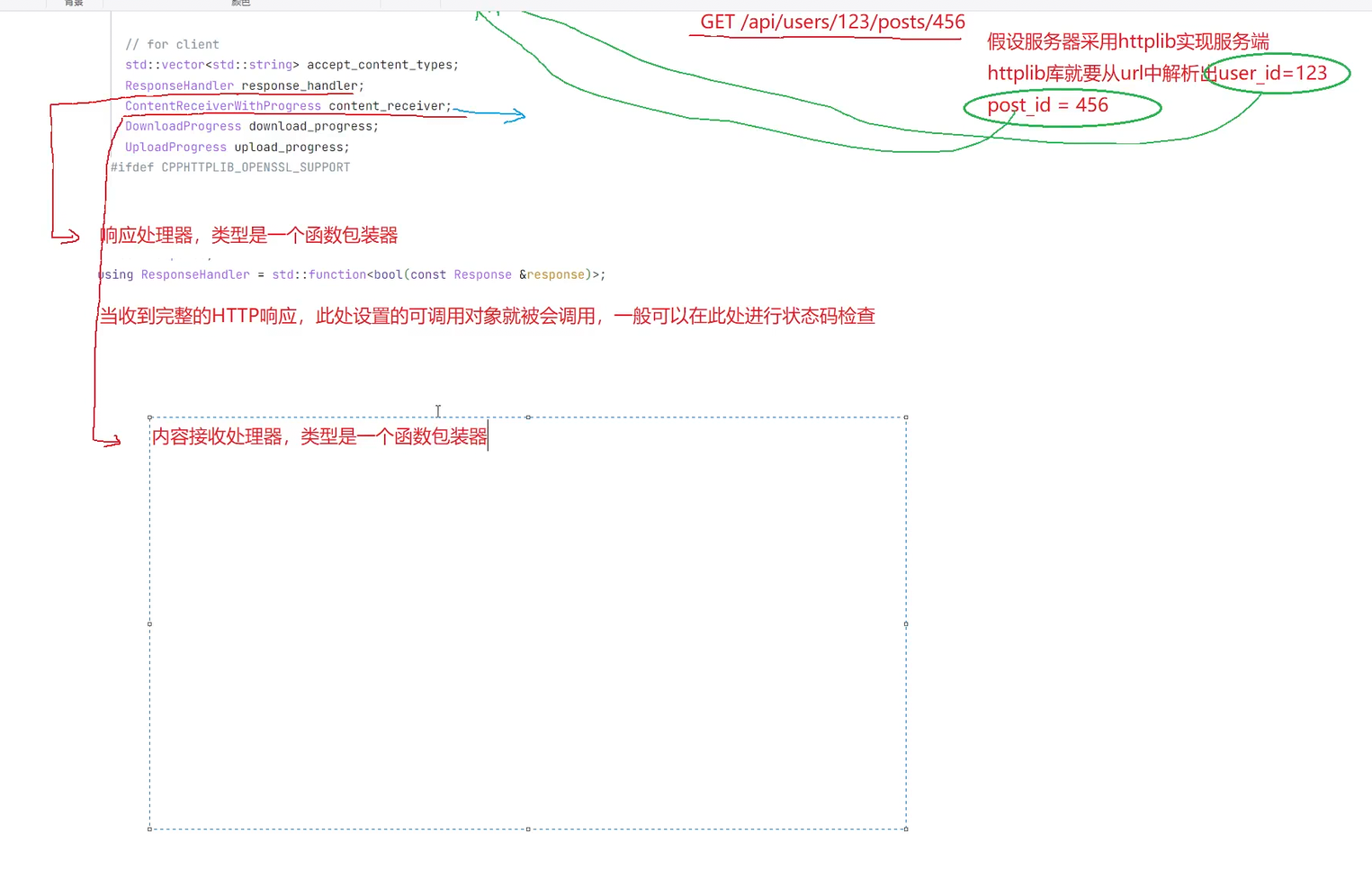

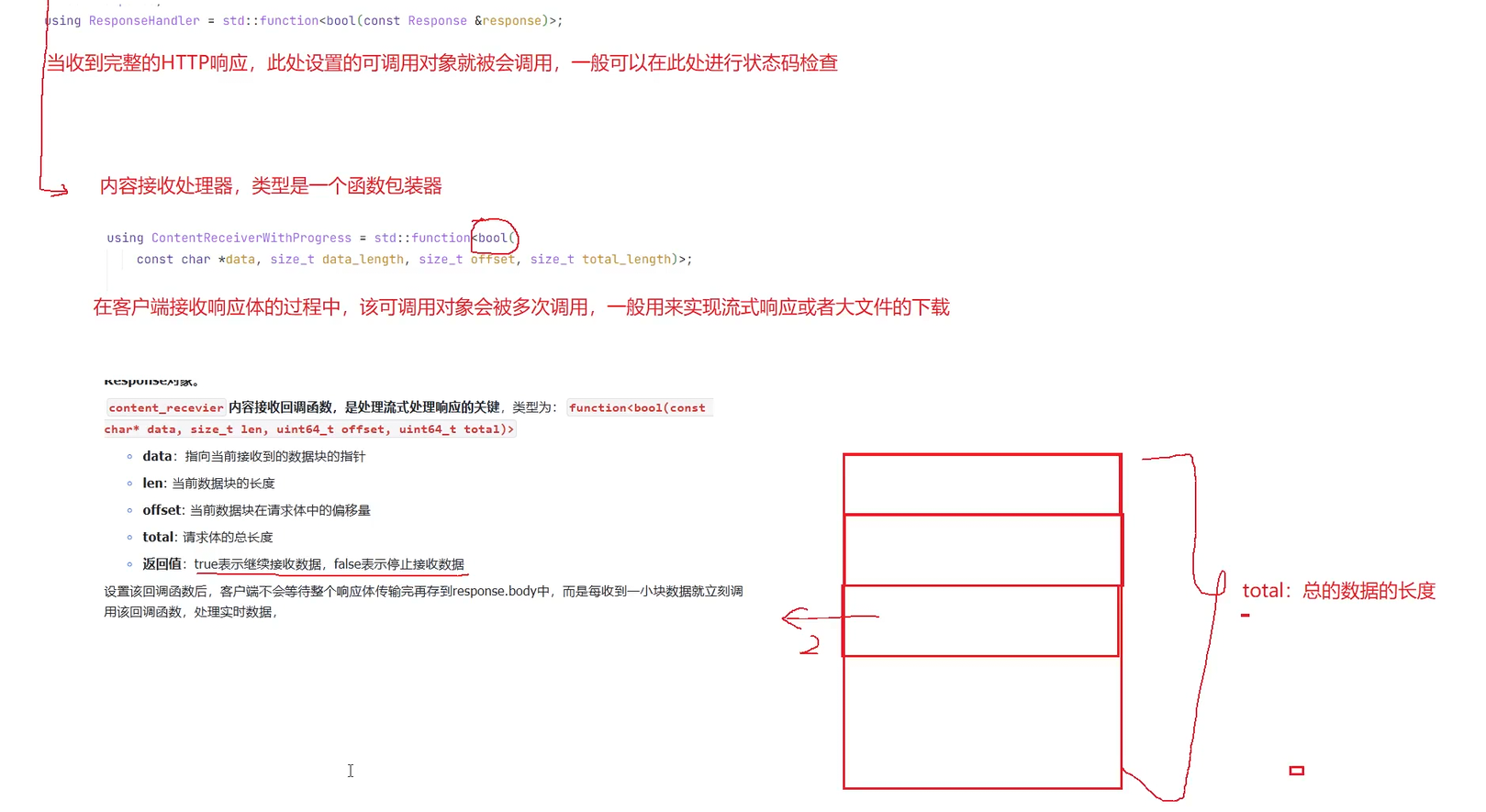

为了处理流式数据,cpp-httplib 在 Post 方法中提供了一组重载,允许开发者传入回调函数来“拦截”数据流。

核心在于 Content Receiver(内容接收器) 回调函数。它的签名通常是一个Lambda表达式或仿函数:

// data: 指向当前接收到的数据块的指针

// data_length: 当前数据块的长度

bool content_receiver(const char *data, size_t data_length) {

// 处理逻辑...

return true; // 返回true继续接收,返回false中断连接

}

以下是库源码中的参数定义截图,展示了不同回调函数的类型定义:

在发送请求时,我们可以通过设置 Params 结构体或直接调用重载函数来注册这个回调。

3.3 实现思路

在接下来的代码实现中(下一篇文章将详细展开),我们将利用这个机制:

- 构造HTTP请求,将

stream参数设为true。 - 调用

client.Post时,传入一个Lambda表达式作为Content Receiver。 - 在Lambda内部,将接收到的

data拼接到缓冲区。 - 检测缓冲区是否包含完整的

data: ... \n\n格式。 - 解析SSE事件,提取增量内容,并通过SDK用户的回调函数向上层抛出。

通过这种方式,我们就能在C++中实现类似Python yield 的流式返回效果,让用户看到模型“一个字一个字蹦出来”的生成过程。

更多推荐

已为社区贡献61条内容

已为社区贡献61条内容

所有评论(0)