大模型仿真进阶攻略:一文看透LoRA与QLoRA,让你的AI更懂业务

在大模型普及的浪潮中,调色技术正在让“通用AI”走向“垂直AI”。维度罗拉QLoRA全部金额硬件需求较低(普通显卡)极低(低显存单卡)极高(多卡资源)训练速度快中等慢性能保持优秀接近全量完美推荐场景快速验证、个人项目极度缺显存、大型模型核心竞争力构建博主结语:AI 2.0时代的竞争,不再是算力的军备竞赛,更是对“行业深度”和“数据价值”的挖掘。同时等待大厂更新那个万能模型,不如扮演出一个最懂你的“

大家好!我是你们的AI技术老友。

在AI大模型(LLM)飙狂的这两年,很多开发者都面临着一个尴尬的境地:手里攥着至关重要的业务数据,一心让模型变得更聪明、更懂行,但看着那昂贵的算力租金和复杂的配置,瞬间就想“劝退环境”了。

当然不是!今天,我将以博主身份的,带你深入拆解大模型强度的三大进阶流派:LoRA、QLoRA以及全量辐射。我会用最接地气的语言把硬核原理讲透,并附上一份“保级”实践指南,帮助你在显存有限的情况下,也能炼出最懂业务的“私人专属模型”。

一、为什么通用大模型需要“二次进阶”?

现在的通用大模型(如GPT-4、Llama 3、Qwen 2)就像是一个**“博览群书的状元才子”**。他上知天文下知地理,作诗写代码样样精通。但在实际的生产环境中,这个“才子”往往会掉链子,主要表现在以下几个方面:

1.领域专业化不足

在医疗诊断、金融风控或特定的法律条文解读等高专业度领域,通用模型很容易产生“幻觉”。它会用非常专业的口吻,一本正经地胡说八道。这是因为通用数据集里虽然有相关知识,但深度和关联性不足。

2. 数据安全与终端化需求

企业的核心业务逻辑、内部培训文档、甚至是个人的隐私日记,这些数据是绝对不能上传到公网API的。为了保护隐私,我们必须在本地或者云端环境下对模型进行气压,以便在没有联网的情况下也能掌握这些蒸发知识。

3.精准的方式遵循

如果你是一个头痛开发者,需要模型百分之百输出严格的JSON结构用于程序对接,通用模型偶尔会因为“话多”多吐出一段解释,导致你的系统直接崩溃。通过曼哈顿,我们可以训练模型的“服从性”,使像精密仪器一样输出。

驱动的本质:就是让那个“通才”去特定的行业“进修”,促使学习到该领域的专业术语、思维模式和规范,从而成为真正的行业专家。

二、技术原理:从轻量化插件到“炼金术”

在江湖里的大模型中,扭矩的方法决定了你对硬件的需求。理解了这三招式的原理,你就可以在面对不同显卡配置的时候游刃有余了。

2.1 全量调整(Full Fine-tuning):重装骑兵的尖端对决

简单来说,就是把大模型内部成百上千亿的参数全部解锁,用你的新数据训练重新一遍。

-

操作方式:模型所有的权重矩阵$W$都会在训练中被更新。

-

优点:它是理论上的性能极限,能够从根本上彻底改变模型的认知逻辑,适合数据量极大、任务极其复杂的场景。

-

劣势:资源消耗极其恐怖。模型一个70B的模型,可能需要多台8卡A100服务器。另外,它极易产生“灾难性遗忘”——模型学会了新知识,却变傻了,连基本的问候语都不会说。

2.2 LoRA:大模型的“外挂插件”

LoRA(低阶适应)是目前开发者圈子里口碑最好、普及率最高的方案。

通俗理解:想象一个大模型是1000页的厚字典。

-

全部量消耗:就是把这1000页全部擦掉重写。

-

LoRA:是给搜索贴贴了几页**“透明便利贴”**。原始页面一个字不动(冻结参数),你只在便利贴上写下针对特定任务的修改建议。当你搜索搜索时,你会结合原文和便利贴的内容给出答案。

技术细节:大模型的参数本质上是巨大的权重矩阵$W$。LoRA 假设在一个过程中,权重的变化$\Delta W$是**“低排序”**的。于是,它引入了两个极小的低排序矩阵$A$和$B$来代替庞大的$\Delta W$。 数学表达式如下:

训练时,原始权重$W$已锁定,仅更新$A$和$B$。因为$A$和$B$的参数量可能只有原模型的0.1%,所以显存占用瞬间暴降,训练速度飞升。

2.3 QLoRA:省钱到极致的“黑科技”

如果你手里只有一张24G显存的显卡(比如RTX 3090/4090),但你想配置一个体量巨大的模型,那么QLoRA(量化LoRA)就是你的救命稻草。

它在LoRA的基础上搭载了三项黑科技:

-

4位NormalFloat(NF4)量化:把16位的浮点数压缩成4位,显存占用直接砍掉75%,且精度损失微乎其微。这就相当于把4K视频压缩成了高质量的1080P,观感依然。

-

双量化(Double Quantization):对量化所需的缩放比例再进行一次量化,把省钱实现最大化。

-

分页优化器(Paged Optimizers):利用显存与CPU内存的动态调配。当显存偶尔“冒满”时,它能够自动把临时数据倒腾到内存里,防止程序因为OOM(显存溢出)而崩溃。

三、实践步骤:手部教你详细流程

理论讲完,我们直接看实操。我们将以最实用的QLoRA为例,演示如何在单卡环境下完成配置。

3.1 准备环境与资源

你首先需要一个基于Linux的开发环境。

-

必备库:

transformers(模型加载)、peft(LoRA核心)、bitsandbytes(量化支持)、accelerate(环球支持)。 -

显存建议:24GB显存可消耗13B-30B模型;如果要玩70B模型,建议多卡或进一步增加量化。

在开始写代码之前,拥有一个稳定、高性能且预装环境好的算力平台让你事半功倍。

3.2 数据集的“精炼术”

数据质量决定了模型的上限。建议将您的业务数据整理成如下指令格式的JSONL文件。

示例格式:

{

"instruction": "你是一名资深的金融理财顾问,请回答以下问题:",

"input": "什么是复利效应?",

"output": "复利效应是指在计算利息时,将上期的利息计入本金以计算下期利息。它的核心在于‘利滚利’。通过长时间的持有,复利可以产生惊人的财富增值效果。"

}

3.3 核心代码实现

以下是基于PEFT库实现 QLoRA 的核心逻辑,我做了简化处理,方便大家理解。

第一步:配置量化参数(QLoRA 的灵魂)

from transformers import BitsAndBytesConfig

import torch

# 开启4-bit量化,这是省显存的关键

bnb_config = BitsAndBytesConfig(

load_in_4bit=True,

bnb_4bit_use_double_quant=True,

bnb_4bit_quant_type="nf4",

bnb_4bit_compute_dtype=torch.bfloat16

)

第二步:加载模型并注入LoRA参数

from peft import LoraConfig, get_peft_model

from transformers import AutoModelForCausalLM

# 1. 加载基础模型

model = AutoModelForCausalLM.from_pretrained(

"model_name_or_path",

quantization_config=bnb_config,

device_map="auto"

)

# 2. 定义 LoRA 外挂配置

lora_config = LoraConfig(

r=16, # 秩大小,决定了“便利贴”的大小

lora_alpha=32, # 缩放因子

target_modules=["q_proj", "v_proj"], # 针对模型中的注意力机制层

lora_dropout=0.05,

task_type="CAUSAL_LM"

)

# 3. 将模型包装为 PEFT 模型

model = get_peft_model(model, lora_config)

第三步:启动训练

使用trl库中的SFTTrainer可以极大地简化训练流程。

from trl import SFTTrainer

from transformers import TrainingArguments

training_args = TrainingArguments(

per_device_train_batch_size=4,

gradient_accumulation_steps=4,

learning_rate=2e-4, # QLoRA 建议的学习率

max_steps=500,

logging_steps=10,

output_dir="./my_private_model",

optim="paged_adamw_32bit" # 分页优化器,防止OOM

)

trainer = SFTTrainer(

model=model,

args=training_args,

train_dataset=dataset,

)

trainer.train()

四、效果评估:如何验证你的“丹”炼增益?

模型跑完了,别急着欢呼。作为一名严谨的开发者,你需要通过三个维度来检验它的“成色”:

1.损失函数(损失曲线)

观察训练中的损失曲线。

-

理想状态:损失平滑下降,最终趋于稳定。

-

异常状态:如果曲线形状震荡,通常意味着学习率(Learning Rate)设置高了;如果损失几乎不动,可能是数据格式没校准,或者模型根本没学进去。

2.困惑度(Perplexity)

在验证集(即模型没有见过的数据)上计算困惑度。这个数值越低,说明模型生成的语言越自然,该领域知识的掌握越精准。

3.Side-by-Side(SBS)人工盲测

这是我最推荐的方法,简单直接:

-

准备50个专业题。

-

让原始模型和你的扭矩模型分别生成答案。

-

隐去模型名称,让业务专家来打分。

-

对比点:术语是否准确?逻辑是否严密?是否严格遵循了你要求的格式?

五、总结与展望

在大模型普及的浪潮中,调色技术正在让“通用AI”走向“垂直AI”。

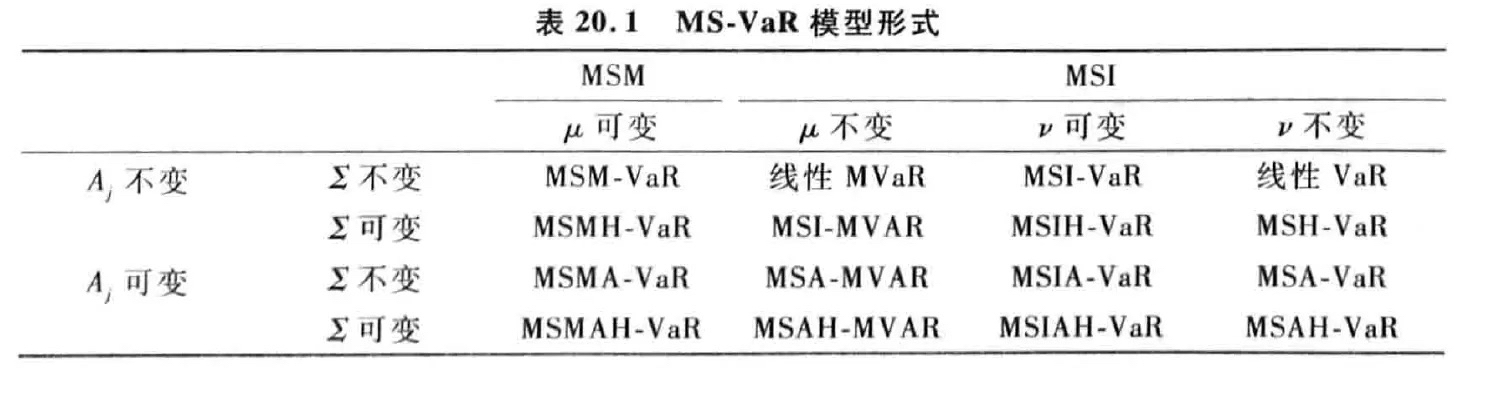

| 维度 | 罗拉 | QLoRA | 全部金额 |

| 硬件需求 | 较低(普通显卡) | 极低(低显存单卡) | 极高(多卡资源) |

| 训练速度 | 快 | 中等 | 慢 |

| 性能保持 | 优秀 | 接近全量 | 完美 |

| 推荐场景 | 快速验证、个人项目 | 极度缺显存、大型模型 | 核心竞争力构建 |

博主结语:

AI 2.0时代的竞争,不再是算力的军备竞赛,更是对“行业深度”和“数据价值”的挖掘。同时等待大厂更新那个万能模型,不如扮演出一个最懂你的“私人助理”。

我个人比较推荐直接上手做一次微调,比如用 LLaMA-Factory Online这种低门槛大模型微调平台,把自己的数据真正“喂”进模型里,生产出属于自己的专属模型。

如果你在训练过程中遇到 OOM 报错,或者不知道如何清理数据,欢迎在评论区留言!

想获取本期的“零基础API架构代码模板”吗?欢迎在评论区留言“ API ”,我会私信发给你!

我们下期再见,一起在AI的世界里持续进阶。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)