大模型开发进阶:如何构建可靠AI系统,解决幻觉问题?

文章探讨AI幻觉问题,提出通过构建"上下文图谱"解决。TrustGraph作为开源解决方案,采用模块化架构整合LLM、向量数据库和图存储引擎。文章详细对比了Neo4j和Memgraph两种图存储引擎的适用场景,强调了可观测性对AI系统的重要性。构建可靠AI应用的关键在于提供结构化上下文,而非简单依赖概率生成。未来AI竞争将围绕上下文图谱构建能力展开。

简介

文章探讨AI幻觉问题,提出通过构建"上下文图谱"解决。TrustGraph作为开源解决方案,采用模块化架构整合LLM、向量数据库和图存储引擎。文章详细对比了Neo4j和Memgraph两种图存储引擎的适用场景,强调了可观测性对AI系统的重要性。构建可靠AI应用的关键在于提供结构化上下文,而非简单依赖概率生成。未来AI竞争将围绕上下文图谱构建能力展开。

前言

引言:当 AI 开始“一本正经地胡说八道” 你是否遇到过这样的场景:向一个先进的 AI 模型提问,它却给出了一个听起来头头是道,但事实完全错误的答案?这种现象被称为 AI“幻觉”(Hallucination),是当前大型语言模型(LLM)普遍面临的核心挑战。

AI 似乎无所不知,但当它开始“一本正经地胡说八道”时,其可靠性便大打折扣。问题的根源并非 AI 缺乏信息,恰恰相反,它淹没在海量的数据中。它真正缺乏的是结构化的、可靠的“上下文”(Context)。

如果 AI 无法理解数据之间的深层关系,而仅仅是基于概率进行文本生成,那么幻觉的产生就在所难免。构建真正智能、可靠的 AI 应用,关键在于从原始数据中构建、管理和部署由 “上下文图谱”(Context Graph) 驱动的精确上下文。而承载这个动态知识网络的核心基础设施,正是图数据库。

本文将通过 TrustGraph 开源解决方案,深入探讨构建下一代 AI 应用的核心思想及关键技术决策。

一、超越 RAG:用“上下文图谱”喂养 AI

为了让 AI 更精准地回答问题,业界提出了 检索增强生成(RAG) 技术。但这还不够——传统的 RAG 提供的往往是孤立的文本块。

上下文图谱 (Context Graph) 的优势

•本体驱动的上下文工程 (Ontology-Driven Context Engineering): 将原本孤立的数据孤岛连接起来,形成一个 AI 可以理解和推理的关系网络。•揭示深层关系: 它不再是简单地告诉 AI“这里有一段相关的文字”,而是清晰地揭示了实体(如人物、地点、事件)之间的具体关系。•减少幻觉: 这种结构化的上下文为 AI 提供了推理的基础。

TrustGraph 项目的核心目标是构建 “能够推理,而非产生幻觉” 的智能 AI 应用。这依靠的是将原始数据转化为由关系和实体构成的精确上下文图谱。

二、告别单体应用:AI 基础设施的“乐高”化

现代 AI 应用是由多个可插拔组件构成的灵活技术栈。这种模块化的架构允许开发者像搭乐高积木一样自由组合最佳工具。

TrustGraph 将自己定位为 “上下文图谱工厂”(Context Graph Factory),通过“配置构建器”(Configuration Builder),用户可以自由选择和组合以下关键组件:

•LLM APIs: OpenAI, Anthropic, Google VertexAI•向量数据库 (VectorDBs): Qdrant (默认), Pinecone, Milvus•图存储 (Graph Storage): Apache Cassandra (默认), Neo4j, Memgraph•云平台 (Clouds): AWS, Azure, Google Cloud

在这套积木中,有一块基石的选择将从根本上决定整个系统的性能和实时推理能力——那就是图存储引擎。

三、核心决策:图存储引擎的权衡 (On-Disk vs. In-Memory)

在 TrustGraph 支持的选项中,Neo4j 和 Memgraph 代表了两种不同的设计哲学。理解它们的差异是做出正确决策的第一步。

Neo4j vs. Memgraph 对比表

| 特性 | Neo4j | Memgraph |

|---|---|---|

| 核心架构 | 基于磁盘 (On-disk) | 基于内存 (In-memory) |

| 实现语言 | Java | C++ |

| 最佳场景 | 系统记录、通用图存储、不频繁写入的静态大数据 | 实时数据处理、流计算、需要极快响应的高频分析 |

| 数据科学库 | GDS (Graph Data Science) | MAGE (Memgraph Advanced Graph Extensions) |

如何选择?

•选择 Neo4j: 如果你的应用依赖于大型、相对静态的知识库,且需要一个持久、耐用的记录系统。•选择 Memgraph: 如果你的 AI 代理必须基于持续变化的实时数据流进行推理(如欺诈检测、动态供应链分析)。其即时执行复杂图遍历的能力,是防止 AI 基于过时信息进行推理的关键。

四、可观测性:为你的 AI 系统装上“仪表盘”

当复杂的 AI 系统进入生产环境,没有清晰的监控,任何瓶颈或成本超支都难以发现。TrustGraph 内置了通过 Grafana 实现的可观测性仪表盘,追踪以下核心指标:

1.LLM 延迟 (LLM Latency): 追踪 AI 模型的响应速度,直接影响用户体验。2.错误率 (Error Rate): 衡量系统稳定性的关键指标。3.令牌吞吐量 (Token Throughput): 衡量 LLM 处理能力和效率 (Tokens/second)。4.成本吞吐量 (Cost Throughput): 实时监控 API 调用成本,防止预算超支 (Cost/second)。5.资源使用率 (CPU/Memory): 定位资源瓶颈,优化基础设施配置。

对这些指标的持续监控,是确保 AI 从一个聪明的实验品转变为可信赖的生产力工具的必要保障。

结论:构建可靠 AI,从上下文开始

解决 AI 幻觉的关键,在于为 AI 提供高质量、结构化的上下文。“上下文图谱” 正是将零散数据转化为 AI 可理解知识网络的强大工具。

构建现代 AI 应用是一个系统工程,需要对从 LLM 到图数据库的整个技术栈进行审慎选择。

未来的赢家将是那些精通构建和部署稳健“上下文图谱”艺术的团队。 你下一个项目的成败取决于此:是将其构建于流沙之上,还是建立在互联的知识基石之上?

说真的,这两年看着身边一个个搞Java、C++、前端、数据、架构的开始卷大模型,挺唏嘘的。大家最开始都是写接口、搞Spring Boot、连数据库、配Redis,稳稳当当过日子。

结果GPT、DeepSeek火了之后,整条线上的人都开始有点慌了,大家都在想:“我是不是要学大模型,不然这饭碗还能保多久?”

我先给出最直接的答案:一定要把现有的技术和大模型结合起来,而不是抛弃你们现有技术!掌握AI能力的Java工程师比纯Java岗要吃香的多。

即使现在裁员、降薪、团队解散的比比皆是……但后续的趋势一定是AI应用落地!大模型方向才是实现职业升级、提升薪资待遇的绝佳机遇!

这绝非空谈。数据说话

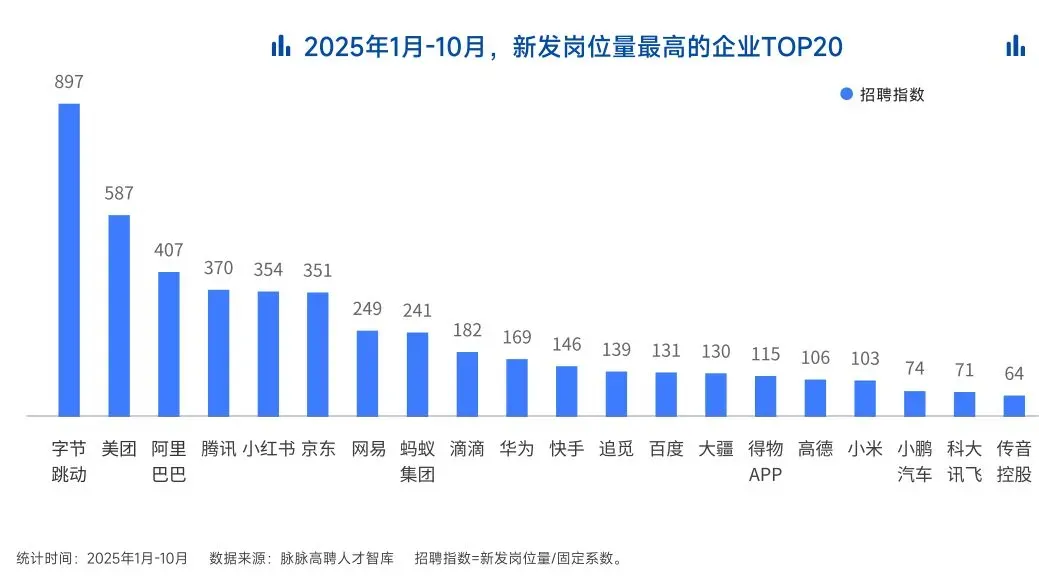

2025年的最后一个月,脉脉高聘发布了《2025年度人才迁徙报告》,披露了2025年前10个月的招聘市场现状。

AI领域的人才需求呈现出极为迫切的“井喷”态势

2025年前10个月,新发AI岗位量同比增长543%,9月单月同比增幅超11倍。同时,在薪资方面,AI领域也显著领先。其中,月薪排名前20的高薪岗位平均月薪均超过6万元,而这些席位大部分被AI研发岗占据。

与此相对应,市场为AI人才支付了显著的溢价:算法工程师中,专攻AIGC方向的岗位平均薪资较普通算法工程师高出近18%;产品经理岗位中,AI方向的产品经理薪资也领先约20%。

当你意识到“技术+AI”是个人突围的最佳路径时,整个就业市场的数据也印证了同一个事实:AI大模型正成为高薪机会的最大源头。

最后

我在一线科技企业深耕十二载,见证过太多因技术卡位而跃迁的案例。那些率先拥抱 AI 的同事,早已在效率与薪资上形成代际优势,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在大模型的学习中的很多困惑。

我整理出这套 AI 大模型突围资料包【允许白嫖】:

-

✅从入门到精通的全套视频教程

-

✅AI大模型学习路线图(0基础到项目实战仅需90天)

-

✅大模型书籍与技术文档PDF

-

✅各大厂大模型面试题目详解

-

✅640套AI大模型报告合集

-

✅大模型入门实战训练

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

①从入门到精通的全套视频教程

包含提示词工程、RAG、Agent等技术点

② AI大模型学习路线图(0基础到项目实战仅需90天)

全过程AI大模型学习路线

③学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

④各大厂大模型面试题目详解

⑤640套AI大模型报告合集

⑥大模型入门实战训练

👉获取方式:

有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献483条内容

已为社区贡献483条内容

所有评论(0)