AI原生应用中的知识抽取:算法、工具与案例

想象你有一个“超级智能助手”,它能自动从新闻里提取“某公司发布了新产品”的关键信息,从医疗文献中总结“某种药物对某疾病的疗效”,甚至从合同里快速识别“违约条款”。知识抽取。本文将聚焦AI原生应用(完全基于AI技术设计的应用,而非传统系统的“AI补丁”)中的知识抽取,覆盖算法原理、主流工具和真实案例,帮助开发者、产品经理理解如何用知识抽取“激活”数据价值。

AI原生应用中的知识抽取:算法、工具与案例

关键词:知识抽取、AI原生应用、实体识别、关系抽取、事件抽取、大语言模型、自然语言处理

摘要:在AI原生应用(如智能助手、医疗诊断系统、金融风控平台)中,如何让机器像人类一样“读懂”文本并提取关键知识?答案是——知识抽取。本文将从“故事引入→核心概念→算法原理→实战案例→应用场景”五个维度,用“给小学生讲故事”的语言,带您理解知识抽取的底层逻辑、主流工具和真实落地案例,最后揭秘大语言模型(如ChatGPT)如何重构这一领域。

背景介绍

目的和范围

想象你有一个“超级智能助手”,它能自动从新闻里提取“某公司发布了新产品”的关键信息,从医疗文献中总结“某种药物对某疾病的疗效”,甚至从合同里快速识别“违约条款”。这些能力的背后,都依赖一项核心技术:知识抽取。本文将聚焦AI原生应用(完全基于AI技术设计的应用,而非传统系统的“AI补丁”)中的知识抽取,覆盖算法原理、主流工具和真实案例,帮助开发者、产品经理理解如何用知识抽取“激活”数据价值。

预期读者

- 对AI应用开发感兴趣的程序员/学生

- 想了解“AI如何处理文本”的产品经理/业务人员

- 希望用知识抽取优化现有系统的技术负责人

文档结构概述

本文将按“故事→概念→原理→实战→应用”的逻辑展开:先用生活故事引出知识抽取的必要性,再拆解实体识别、关系抽取等核心概念,接着讲解传统算法与大模型的差异,然后用Python代码演示实战,最后结合医疗、金融等场景说明其价值。

术语表

核心术语定义

- 知识抽取(Knowledge Extraction):从非结构化文本(如新闻、邮件、论文)中提取结构化知识(如“实体-关系-实体”三元组)的过程,就像从西瓜里“挖果肉”,把有用信息从混乱文本中分离出来。

- 实体识别(Named Entity Recognition, NER):识别文本中的关键对象(如人名、公司名、地名),类似用荧光笔在书上标记“重点词”。

- 关系抽取(Relation Extraction):确定实体间的关联(如“创始人”“成立时间”),像整理家谱时标注“父子”“母女”关系。

- 事件抽取(Event Extraction):提取关键事件(如“公司上市”“产品发布”),类似记录“小明今天早上8点在学校吃了早餐”这样的具体事件。

相关概念解释

- AI原生应用:从设计之初就基于AI技术(如大语言模型、知识图谱)构建的应用,而非传统系统+AI插件(例如完全由LLM驱动的智能客服,而非传统客服系统调用一个AI翻译模块)。

- 非结构化文本:没有固定格式的文本(如微信聊天记录、新闻稿),与Excel表格(结构化)、表单(半结构化)区分。

缩略词列表

- NER:Named Entity Recognition(实体识别)

- LLM:Large Language Model(大语言模型,如GPT-4)

- CRF:Conditional Random Field(条件随机场,传统NER算法)

核心概念与联系

故事引入

周末,你让智能助手小A查“特斯拉的创始人是谁”。小A需要做什么?

- 先“读”大量网页、新闻,找到所有提到“特斯拉”的地方(实体识别:找到“特斯拉”这个公司实体);

- 然后在这些文本里,找“特斯拉”和“人”之间的关系词(如“创始人”“创立者”),发现“埃隆·马斯克”(关系抽取:建立“特斯拉-创始人-埃隆·马斯克”的三元组);

- 最后,可能还会记录“2003年特斯拉成立”这样的事件(事件抽取:提取时间、主体、动作)。

这三步,就是知识抽取的核心——把“特斯拉创始人是埃隆·马斯克”这个知识,从混乱的文本中“挖”出来,变成机器能理解的结构化知识。

核心概念解释(像给小学生讲故事一样)

核心概念一:实体识别(NER)——找“关键角色”

想象你在读一本小说,老师让你用红笔标出所有“人名”“地名”“公司名”。实体识别就是让机器干这件事:从文本中找出“关键角色”,并分类(比如“人名”“机构名”“时间”)。

举个例子:

输入文本:“2023年10月,字节跳动在上海发布了AI大模型‘豆包’。”

实体识别结果:

- 时间:2023年10月

- 机构名:字节跳动

- 地名:上海

- 产品名:豆包

核心概念二:关系抽取——找“角色间的联系”

假设你有一本“班级通讯录”,里面有“小明”“小红”“李老师”的名字(实体),但不知道他们的关系。关系抽取就是要找出“小明是小红的同桌”“李老师是小明的班主任”这样的联系。

举个例子:

输入实体:字节跳动、上海、豆包

关系抽取结果:

- 字节跳动-发布地点-上海

- 字节跳动-发布产品-豆包

核心概念三:事件抽取——找“关键剧情”

看电影时,我们最关注“谁在什么时候做了什么”(比如“主角在第三幕打败了反派”)。事件抽取就是让机器提取这样的“关键剧情”,包括事件主体、时间、动作、结果等。

举个例子:

输入文本:“2023年双11,淘宝的GMV(商品交易总额)达到5000亿元,同比增长10%。”

事件抽取结果:

- 事件类型:电商大促

- 主体:淘宝

- 时间:2023年双11

- 指标:GMV

- 数值:5000亿元

- 增长率:10%

核心概念之间的关系(用小学生能理解的比喻)

知识抽取的三个核心概念(实体识别、关系抽取、事件抽取)就像“搭积木”:

- 实体识别是“找积木块”:先从文本中挑出所有可能的“积木”(如人名、公司名);

- 关系抽取是“拼积木”:把两块积木(实体)用“关系”连接起来(如“创始人”“发布”);

- 事件抽取是“搭完整造型”:用多个积木和关系,拼出一个完整的“故事”(如“某公司在某时间发布某产品”)。

举个生活中的例子:

- 你读一篇新闻:“2024年3月,张一鸣以100亿美元收购了游戏公司米哈游。”

- 实体识别:找到“2024年3月”(时间)、“张一鸣”(人名)、“米哈游”(机构名);

- 关系抽取:建立“张一鸣-收购-米哈游”“收购金额-100亿美元”;

- 事件抽取:总结事件“张一鸣于2024年3月以100亿美元收购游戏公司米哈游”。

核心概念原理和架构的文本示意图

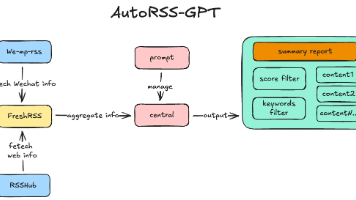

知识抽取的典型流程可概括为:

非结构化文本 → 预处理(分词、去噪) → 实体识别 → 关系抽取 → 事件抽取 → 结构化知识(三元组/事件列表)

Mermaid 流程图

核心算法原理 & 具体操作步骤

知识抽取的算法可分为传统方法(基于规则/统计学习)和大模型方法(基于LLM的提示学习/微调),我们逐一讲解。

一、传统方法:规则与统计学习

1. 规则方法(适合特定领域)

原理:人为定义“模式”,让机器按模式提取知识。例如,定义“[机构名]成立于[时间]”的模式,当文本出现“字节跳动成立于2012年”时,自动提取“字节跳动-成立时间-2012年”。

优点:准确性高(模式明确),适合领域固定(如法律条款、医疗术语)。

缺点:需要人工编写大量规则(成本高),泛化能力差(换领域需重写规则)。

2. 统计学习方法(如CRF、LSTM+CRF)

原理:通过机器学习模型(如条件随机场CRF),从标注数据中学习“如何给每个词贴标签”。例如,训练数据中“埃隆·马斯克”被标注为“人名”,模型学会识别类似结构的词。

数学模型(以CRF为例):

CRF的目标是最大化“给定文本序列时,正确标签序列的概率”,公式表示为:

P ( y ∣ x ) = 1 Z ( x ) exp ( ∑ i = 1 n ∑ k = 1 K λ k t k ( y i − 1 , y i , x , i ) + ∑ k = 1 M μ k s k ( y i , x , i ) ) P(y|x) = \frac{1}{Z(x)} \exp\left( \sum_{i=1}^n \sum_{k=1}^K \lambda_k t_k(y_{i-1}, y_i, x, i) + \sum_{k=1}^M \mu_k s_k(y_i, x, i) \right) P(y∣x)=Z(x)1exp(i=1∑nk=1∑Kλktk(yi−1,yi,x,i)+k=1∑Mμksk(yi,x,i))

其中, t k t_k tk是转移特征(如“前一个标签是‘人名’,当前标签可能也是‘人名’”), s k s_k sk是状态特征(如“当前词是‘马斯克’,标签可能是‘人名’”)。

Python代码示例(用spaCy做实体识别):

import spacy

# 加载英文预训练模型(中文需下载zh_core_web_sm)

nlp = spacy.load("en_core_web_sm")

# 输入文本

text = "Elon Musk, the CEO of Tesla, founded the company in 2003."

# 处理文本

doc = nlp(text)

# 输出实体识别结果

for ent in doc.ents:

print(f"实体: {ent.text}, 类型: {ent.label_}")

输出结果:

实体: Elon Musk, 类型: PERSON(人名)

实体: Tesla, 类型: ORG(机构)

实体: 2003, 类型: DATE(日期)

二、大模型方法(LLM驱动)

随着GPT-3、ChatGPT等大语言模型的普及,知识抽取进入“提示学习”时代:直接给LLM写“指令”,让它输出结构化知识。

原理:LLM通过海量文本训练,已隐含“理解”实体、关系、事件的能力,只需用“提示词”(Prompt)引导它输出想要的格式。

优势:

- 无需标注数据(少样本/零样本学习);

- 泛化能力强(跨领域效果好);

- 支持复杂抽取(如多跳关系、长文本事件)。

Python代码示例(用ChatGPT API做关系抽取):

import openai

# 设置API密钥(需替换为你的密钥)

openai.api_key = "sk-xxx"

# 输入文本和提示词

text = "2003年,埃隆·马斯克与马丁·艾伯哈德共同创立了特斯拉,总部位于美国加州帕洛阿尔托。"

prompt = f"""

请从以下文本中提取所有实体(人名、机构名、地名、时间),并抽取实体间的关系(如创始人、成立时间、总部地点),用JSON格式输出:

文本:{text}

"""

# 调用ChatGPT API

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": prompt}]

)

# 输出结果

print(response.choices[0].message["content"])

输出结果(示例):

{

"实体": {

"时间": ["2003年"],

"人名": ["埃隆·马斯克", "马丁·艾伯哈德"],

"机构名": ["特斯拉"],

"地名": ["美国加州帕洛阿尔托"]

},

"关系": [

{"主体": "特斯拉", "关系": "创始人", "客体": "埃隆·马斯克"},

{"主体": "特斯拉", "关系": "创始人", "客体": "马丁·艾伯哈德"},

{"主体": "特斯拉", "关系": "成立时间", "客体": "2003年"},

{"主体": "特斯拉", "关系": "总部地点", "客体": "美国加州帕洛阿尔托"}

]

}

数学模型和公式 & 详细讲解 & 举例说明

传统方法的数学基础(以CRF为例)

CRF是一种“序列标注”模型,核心是“状态转移”和“状态特征”的加权和。

- 状态转移:前一个标签(如“B-PER”,表示人名开头)会影响当前标签的概率(如“B-PER”后更可能是“I-PER”,表示人名中间)。

- 状态特征:当前词的内容(如“马斯克”)会影响标签的概率(更可能是“PER”)。

举例:

文本:“埃隆·马斯克是特斯拉的CEO。”

分词后:[埃隆, ·, 马斯克, 是, 特斯拉, 的, CEO, 。]

标签序列(假设):[B-PER, I-PER, I-PER, O, B-ORG, O, O, O](B-PER=人名开头,I-PER=人名中间,O=无标签,B-ORG=机构名开头)。

CRF通过学习训练数据中的“标签转移频率”和“词-标签关联频率”,计算最优标签序列。

大模型方法的数学基础(以Transformer为例)

大模型(如GPT)基于Transformer架构,核心是自注意力机制(Self-Attention),公式为:

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left( \frac{QK^T}{\sqrt{d_k}} \right) V Attention(Q,K,V)=softmax(dkQKT)V

其中, Q Q Q(查询)、 K K K(键)、 V V V(值)是输入的线性变换,模型通过“注意力分数”( Q K T QK^T QKT)判断哪些词对当前词更重要(例如,“特斯拉”出现时,模型会关注前后的“创始人”“成立”等词)。

举例:

当LLM处理“特斯拉创始人是埃隆·马斯克”时,注意力机制会让“特斯拉”和“埃隆·马斯克”的向量与“创始人”的向量强关联,从而学会抽取“特斯拉-创始人-埃隆·马斯克”的三元组。

项目实战:代码实际案例和详细解释说明

开发环境搭建

我们以“从新闻中抽取公司-创始人关系”为例,使用Python和Hugging Face的transformers库(基于BERT微调的关系抽取模型)。

步骤1:安装依赖

pip install torch transformers pandas

步骤2:准备数据(示例数据train.csv)

| 文本 | 实体1 | 实体2 | 关系 |

|---|---|---|---|

| 马云创立了阿里巴巴 | 马云 | 阿里巴巴 | 创始人 |

| 马化腾是腾讯的主要创始人 | 马化腾 | 腾讯 | 创始人 |

源代码详细实现和代码解读

from transformers import BertTokenizer, BertForSequenceClassification

import torch

import pandas as pd

# 加载预训练模型和分词器

model_name = "bert-base-chinese"

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertForSequenceClassification.from_pretrained(

model_name,

num_labels=2 # 二分类:是否为“创始人”关系

)

# 预处理数据(将文本转为模型输入)

def preprocess_data(texts, entities1, entities2, labels):

inputs = []

for text, e1, e2, label in zip(texts, entities1, entities2, labels):

# 构造输入:[CLS] 文本 [SEP] 实体1 实体2 [SEP]

input_text = f"{text} [SEP] {e1} {e2}"

encoded = tokenizer(

input_text,

padding="max_length",

truncation=True,

max_length=128,

return_tensors="pt"

)

inputs.append({

"input_ids": encoded["input_ids"],

"attention_mask": encoded["attention_mask"],

"labels": torch.tensor([label])

})

return inputs

# 加载训练数据

data = pd.read_csv("train.csv")

train_inputs = preprocess_data(

data["文本"].tolist(),

data["实体1"].tolist(),

data["实体2"].tolist(),

data["关系"].map({"创始人": 1, "其他": 0}).tolist() # 标签转换

)

# 训练模型(简化版)

optimizer = torch.optim.AdamW(model.parameters(), lr=5e-5)

for epoch in range(3):

for batch in train_inputs:

outputs = model(

input_ids=batch["input_ids"],

attention_mask=batch["attention_mask"],

labels=batch["labels"]

)

loss = outputs.loss

loss.backward()

optimizer.step()

optimizer.zero_grad()

# 测试模型(抽取“张一鸣-字节跳动”的关系)

test_text = "张一鸣于2012年创立了字节跳动"

e1 = "张一鸣"

e2 = "字节跳动"

input_text = f"{test_text} [SEP] {e1} {e2}"

encoded = tokenizer(input_text, return_tensors="pt")

with torch.no_grad():

outputs = model(**encoded)

pred_label = torch.argmax(outputs.logits).item()

print(f"预测关系:{'创始人' if pred_label == 1 else '其他'}") # 输出:创始人

代码解读与分析

- 数据预处理:将文本、实体对拼接成模型能理解的格式(

[CLS]文本[SEP]实体1 实体2[SEP]),通过分词器转为词向量。 - 模型训练:使用BERT预训练模型(已学习中文语义),在自定义数据上微调,学习“判断实体对是否为创始人关系”。

- 预测:输入新文本和实体对,模型输出概率最高的标签(1表示“创始人”,0表示“其他”)。

实际应用场景

1. 智能客服:自动提取用户需求

某电商平台的智能客服需要处理用户提问:“我买的iPhone15还没到,订单号123456,什么时候能送到?”

知识抽取可提取:

- 实体:iPhone15(商品)、123456(订单号)

- 事件:用户反馈“未收到商品”,需求是“查询送达时间”。

客服系统根据这些知识,自动路由到物流查询模块,快速回复用户。

2. 医疗知识图谱:辅助医生诊断

医疗文献中提到:“奥司他韦对甲型流感病毒的有效率为85%,需在症状出现后48小时内服用。”

知识抽取可提取:

- 实体:奥司他韦(药物)、甲型流感病毒(疾病)

- 关系:有效率-85%、用药时间窗-48小时内。

这些知识被存入医疗知识图谱,医生诊断时可快速查询“甲型流感的推荐药物及用药条件”。

3. 金融风控:识别关联交易

某银行需要监控“关联交易”(如A公司和B公司的实际控制人是同一人)。

知识抽取从企业公告中提取:

- 实体:A公司、B公司、张三(人名)

- 关系:A公司-实际控制人-张三、B公司-实际控制人-张三。

系统检测到“同一控制人”关系后,标记为高风险,触发进一步核查。

工具和资源推荐

开源工具(适合开发者)

- spaCy:支持多语言实体识别,提供预训练模型(如

en_core_web_sm),适合快速搭建基础抽取系统(官网)。 - Stanford CoreNLP:斯坦福大学的NLP工具包,支持实体识别、关系抽取,适合学术研究(官网)。

- OpenIE:华盛顿大学的开放信息抽取工具,能自动提取“实体-关系-实体”三元组(无需预定义关系类型)(官网)。

大模型工具(适合低代码/零代码)

- ChatGPT/Claude:通过提示词直接抽取知识,适合快速验证需求(如用

“请从以下文本中提取所有公司及其创始人,用JSON输出”)。 - 文心一言/通义千问:国内大模型,支持中文领域(如法律、医疗)的知识抽取(百度文心)。

企业级平台(适合工业化部署)

未来发展趋势与挑战

趋势1:多模态知识抽取

未来的知识抽取将不仅处理文本,还能从图片(如海报)、视频(如发布会)中提取知识。例如,从“某手机发布会视频”中,提取“手机型号-发布时间-价格”等信息。

趋势2:低资源场景的突破

目前知识抽取在医疗、法律等专业领域依赖大量标注数据,未来大模型的“小样本学习”能力将降低标注成本(如仅用100条数据就能训练出可用模型)。

挑战1:大模型的“幻觉”问题

LLM可能生成错误知识(如“特斯拉创始人是比尔·盖茨”),如何通过“可解释性技术”(如注意力可视化)和“知识验证”(对接权威知识库)减少错误,是关键挑战。

挑战2:隐私与合规

知识抽取可能涉及用户隐私(如医疗记录中的“患者姓名-疾病”),如何在“提取知识”和“保护隐私”间平衡(如匿名化处理、联邦学习),是工业化落地的必答题。

总结:学到了什么?

核心概念回顾

- 实体识别:从文本中找“关键角色”(如人名、公司名);

- 关系抽取:找“角色间的联系”(如“创始人”“成立时间”);

- 事件抽取:找“关键剧情”(如“某公司发布某产品”)。

概念关系回顾

三者是“从点到线到面”的递进:先找实体(点),再连关系(线),最后拼事件(面),共同构成结构化知识,为AI原生应用提供“大脑所需的信息”。

思考题:动动小脑筋

- 假设你要开发一个“电影知识助手”,需要从电影评论中提取“电影名-导演-主演-评分”,你会如何设计知识抽取的步骤?

- 大模型(如ChatGPT)做知识抽取时,有时会“编造”不存在的关系(如“某小说的作者是张三”但实际是李四),你有什么方法减少这种错误?

附录:常见问题与解答

Q:知识抽取和信息提取(Information Extraction)有什么区别?

A:知识抽取是信息提取的子集。信息提取更广泛(包括命名实体识别、关系抽取、事件抽取等),而知识抽取更聚焦于“构建结构化知识”(如知识图谱中的三元组)。

Q:大模型会完全替代传统知识抽取算法吗?

A:不会。传统算法(如CRF)在小数据、强规则场景(如法律条款)中更可靠;大模型适合大数据、泛化场景(如通用新闻抽取)。两者是“互补”关系。

Q:知识抽取需要多少标注数据?

A:传统算法(如CRF)需要数千条标注数据;大模型(如LLM提示学习)可能只需几十条甚至零样本,但精度可能下降(需根据需求权衡)。

扩展阅读 & 参考资料

- 《自然语言处理入门》(何晗):适合NLP初学者,讲解实体识别、关系抽取的基础算法。

- 《知识图谱:方法、实践与应用》(王昊奋):深入讲解知识抽取在知识图谱构建中的作用。

- 论文《Deep Learning for Named Entity Recognition in Clinical Text》:医疗领域实体识别的经典研究。

- Hugging Face文档(https://huggingface.co/docs):学习大模型微调的最佳资源。

更多推荐

已为社区贡献105条内容

已为社区贡献105条内容

所有评论(0)