AI原生应用领域行为分析:洞察市场需求

我们的目的是深入了解AI原生应用领域中用户的行为,从而洞察市场需求。这里的范围涵盖了各种基于AI技术开发的原生应用,包括但不限于智能助手、图像识别应用、智能推荐系统等。通过分析这些应用中用户的行为,我们可以发现用户的喜好、需求以及市场的潜在机会。首先,我们会介绍一些相关的术语和概念,让大家对本文涉及的内容有一个基本的认识。然后,通过一个有趣的故事引入核心概念,并详细解释这些概念以及它们之间的关系,

AI原生应用领域行为分析:洞察市场需求

关键词:AI原生应用、行为分析、市场需求、数据洞察、应用趋势

摘要:本文聚焦于AI原生应用领域的行为分析,旨在通过详细剖析来洞察市场需求。我们会先介绍相关背景知识,然后解释核心概念及其关系,接着阐述核心算法原理和操作步骤,结合数学模型举例说明,再通过项目实战进行代码实现和解读,探讨实际应用场景,推荐相关工具和资源,分析未来发展趋势与挑战。最后进行总结并提出思考题,帮助读者更好地理解和应用相关知识。

背景介绍

目的和范围

我们的目的是深入了解AI原生应用领域中用户的行为,从而洞察市场需求。这里的范围涵盖了各种基于AI技术开发的原生应用,包括但不限于智能助手、图像识别应用、智能推荐系统等。通过分析这些应用中用户的行为,我们可以发现用户的喜好、需求以及市场的潜在机会。

预期读者

本文适合对AI原生应用感兴趣的初学者、从事AI相关工作的开发者、市场调研人员以及想要了解市场动态的企业管理者。无论你是刚刚接触AI领域,还是已经有一定经验的专业人士,都能从本文中获得有价值的信息。

文档结构概述

首先,我们会介绍一些相关的术语和概念,让大家对本文涉及的内容有一个基本的认识。然后,通过一个有趣的故事引入核心概念,并详细解释这些概念以及它们之间的关系,还会给出原理和架构的示意图及流程图。接着,我们会阐述核心算法原理和具体操作步骤,结合数学模型进行举例说明。之后,通过项目实战展示代码的实现和解读。再探讨实际应用场景,推荐相关工具和资源,分析未来发展趋势与挑战。最后进行总结,提出思考题,并提供常见问题解答和扩展阅读资料。

术语表

核心术语定义

- AI原生应用:指从设计之初就深度融入AI技术,以AI能力为核心驱动力来实现其主要功能的应用程序。例如,一些智能写作工具,它利用AI的自然语言处理能力来帮助用户生成文章。

- 行为分析:对用户在应用中的各种行为进行收集、整理、分析和解释的过程。比如分析用户在电商应用中点击商品、加入购物车、下单等行为。

- 市场需求:市场中消费者对某种产品或服务的欲望和需求,它受到多种因素的影响,如消费者的喜好、经济状况等。

相关概念解释

- 数据洞察:通过对大量数据的分析和挖掘,发现其中隐藏的信息和规律,从而为决策提供支持。就像从一堆沙子中找出闪闪发光的金子一样,从海量数据中找到有价值的信息。

- 应用趋势:指AI原生应用在未来一段时间内的发展方向和变化趋势,例如可能会朝着更加个性化、智能化的方向发展。

缩略词列表

- AI:Artificial Intelligence,人工智能

- NLP:Natural Language Processing,自然语言处理

- CV:Computer Vision,计算机视觉

核心概念与联系

故事引入

想象一下,你开了一家神奇的糖果店。店里有各种各样口味、形状和颜色的糖果。每天都有很多小朋友来店里买糖果。你发现有些小朋友总是喜欢买巧克力口味的糖果,有些则偏爱水果口味。还有些小朋友会根据糖果的包装来选择,比如喜欢卡通形象包装的糖果。

为了让更多小朋友喜欢上你的糖果店,你开始仔细观察小朋友们的行为。你记录下每个小朋友每次来买的糖果种类、数量,以及他们在店里停留的时间。通过分析这些记录,你发现了一些规律。比如周末的时候,小朋友们更喜欢买大包装的糖果;而平时,小包装的糖果更受欢迎。你还发现那些喜欢卡通形象包装的小朋友,对新推出的带有热门卡通角色包装的糖果特别感兴趣。

这就好比在AI原生应用领域,我们就像糖果店老板,应用就是我们的糖果店,用户就是小朋友。我们通过分析用户在应用中的行为,来了解他们的需求,从而让我们的应用更受欢迎。

核心概念解释(像给小学生讲故事一样)

- 核心概念一:AI原生应用

AI原生应用就像一个超级智能的小伙伴。它从一出生就带着聪明的大脑,这个大脑就是AI技术。比如说智能语音助手,它就像一个会说话的小秘书。你可以跟它聊天,让它帮你查资料、设置提醒,它都能轻松完成。这是因为它里面有很多AI的本领,能听懂你说的话,还能理解你的意思,然后给你合适的回答。 - 核心概念二:行为分析

行为分析就像一个大侦探在破案。我们在应用里会留下很多痕迹,比如我们点击了哪些按钮,看了哪些内容,停留了多长时间。行为分析就是把这些痕迹收集起来,然后仔细研究。就像侦探通过收集现场的线索,来了解事情的真相一样。我们通过行为分析,就能知道用户在应用里喜欢做什么,不喜欢做什么。 - 核心概念三:市场需求

市场需求就像大家的愿望清单。在市场这个大舞台上,有很多人都有自己想要的东西。比如在手机应用市场,有些人希望有一个能快速找到附近美食的应用,有些人想要一个能轻松编辑照片的应用。这些就是市场需求,我们了解了这些需求,就能开发出更符合大家心意的应用。

核心概念之间的关系(用小学生能理解的比喻)

- 概念一和概念二的关系

AI原生应用和行为分析就像一对好朋友。AI原生应用是一个好玩的游乐场,里面有很多好玩的项目。行为分析就像游乐场的管理员,他会观察游客在游乐场里的行为。比如游客在哪个项目前停留的时间最长,玩哪个项目的次数最多。通过这些观察,管理员就能知道哪些项目受欢迎,哪些项目需要改进。这样,游乐场就能变得越来越好,吸引更多的游客。同样,通过对AI原生应用中用户行为的分析,我们可以让应用变得更智能、更贴心。 - 概念二和概念三的关系

行为分析和市场需求就像两个小侦探一起合作。行为分析能发现用户在应用里的行为规律,就像小侦探找到了一些线索。而市场需求就像案件的真相。通过对用户行为的分析,我们可以找到市场需求的蛛丝马迹。比如我们发现很多用户在一个购物应用里总是搜索某一类商品,这就可能意味着市场对这类商品有很大的需求。我们可以根据这些线索,开发出更符合市场需求的应用或功能。 - 概念一和概念三的关系

AI原生应用和市场需求就像设计师和顾客。市场需求是顾客的要求,顾客希望有一款能满足他们特定需求的应用。AI原生应用就是设计师设计出来的作品。设计师要根据顾客的要求,运用AI技术,设计出符合市场需求的应用。比如市场上很多人希望有一个能自动识别植物的应用,设计师就可以利用AI的图像识别技术,开发出这样的AI原生应用。

核心概念原理和架构的文本示意图(专业定义)

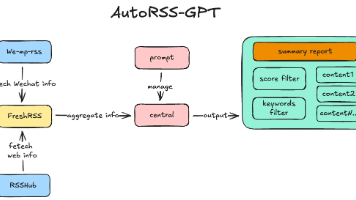

- AI原生应用:以AI算法为核心,通过数据采集层收集用户的各种行为数据,如点击事件、浏览记录等。这些数据传输到数据处理层,经过清洗、整理和存储。然后,数据分析层利用机器学习、深度学习等算法对数据进行分析,挖掘用户的行为模式和需求。最后,将分析结果反馈到应用的交互层,实现个性化推荐、智能客服等功能。

- 行为分析:首先从数据源(如应用日志、数据库等)获取用户行为数据。然后对数据进行预处理,包括去除噪声、缺失值处理等。接着运用统计分析、机器学习等方法对数据进行分析,提取有价值的信息,如用户的活跃度、留存率等。最后将分析结果以可视化的方式展示出来,方便决策者查看。

- 市场需求:通过对市场调研数据、行业报告、用户反馈等信息的收集和分析,了解市场的趋势、用户的痛点和需求。结合行为分析的结果,进一步细化市场需求,为AI原生应用的开发和优化提供方向。

Mermaid 流程图

核心算法原理 & 具体操作步骤

在行为分析中,常用的算法有聚类算法和关联规则挖掘算法。下面我们以Python为例,详细阐述这些算法的原理和操作步骤。

聚类算法(K-Means)

- 原理:K-Means算法是一种无监督学习算法,它的目标是将数据分成K个不同的簇,使得同一簇内的数据点相似度较高,不同簇之间的数据点相似度较低。就像把一群小朋友按照他们的身高分成不同的小组,身高相近的小朋友会被分到同一个小组。

- 操作步骤

- 选择K个初始质心,质心就是每个簇的中心点。

- 将每个数据点分配到距离最近的质心所在的簇。

- 重新计算每个簇的质心。

- 重复步骤2和3,直到质心不再发生变化或达到最大迭代次数。

import numpy as np

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt

# 生成一些示例数据

X = np.array([[1, 2], [1, 4], [1, 0],

[4, 2], [4, 4], [4, 0]])

# 创建K-Means模型,设置簇的数量为2

kmeans = KMeans(n_clusters=2, random_state=0).fit(X)

# 获取每个数据点所属的簇

labels = kmeans.labels_

# 获取簇的质心

centroids = kmeans.cluster_centers_

# 可视化结果

plt.scatter(X[:, 0], X[:, 1], c=labels, cmap='viridis')

plt.scatter(centroids[:, 0], centroids[:, 1], marker='X', s=200, c='red')

plt.show()

关联规则挖掘算法(Apriori)

- 原理:Apriori算法用于发现数据集中的频繁项集和关联规则。频繁项集是指在数据集中频繁出现的项的集合,关联规则则描述了项之间的关联关系。比如在超市购物数据中,发现买面包的人经常也会买牛奶,这就是一个关联规则。

- 操作步骤

- 生成所有的单个项集,并计算它们的支持度(即出现的频率)。

- 筛选出支持度大于等于最小支持度的项集,作为频繁1-项集。

- 由频繁1-项集生成频繁2-项集,重复这个过程,直到不能生成更大的频繁项集为止。

- 从频繁项集中生成关联规则,并计算它们的置信度(即规则成立的概率)。

- 筛选出置信度大于等于最小置信度的关联规则。

from mlxtend.preprocessing import TransactionEncoder

from mlxtend.frequent_patterns import apriori, association_rules

import pandas as pd

# 示例数据

dataset = [['Milk', 'Onion', 'Nutmeg', 'Kidney Beans', 'Eggs', 'Yogurt'],

['Dill', 'Onion', 'Nutmeg', 'Kidney Beans', 'Eggs', 'Yogurt'],

['Milk', 'Apple', 'Kidney Beans', 'Eggs'],

['Milk', 'Unicorn', 'Corn', 'Kidney Beans', 'Yogurt'],

['Corn', 'Onion', 'Onion', 'Kidney Beans', 'Ice cream', 'Eggs']]

# 数据预处理

te = TransactionEncoder()

te_ary = te.fit(dataset).transform(dataset)

df = pd.DataFrame(te_ary, columns=te.columns_)

# 生成频繁项集

frequent_itemsets = apriori(df, min_support=0.6, use_colnames=True)

# 生成关联规则

rules = association_rules(frequent_itemsets, metric="confidence", min_threshold=0.7)

print(rules)

数学模型和公式 & 详细讲解 & 举例说明

聚类算法(K-Means)

-

目标函数

K-Means算法的目标是最小化所有数据点到其所属簇质心的距离之和。数学公式表示为:

J=∑i=1n∑j=1krij∥xi−μj∥2 J = \sum_{i=1}^{n} \sum_{j=1}^{k} r_{ij} \left\| x_i - \mu_j \right\|^2 J=i=1∑nj=1∑krij∥xi−μj∥2

其中,nnn 是数据点的数量,kkk 是簇的数量,rijr_{ij}rij 是一个指示变量,如果数据点 xix_ixi 属于簇 jjj,则 rij=1r_{ij} = 1rij=1,否则 rij=0r_{ij} = 0rij=0,μj\mu_jμj 是簇 jjj 的质心。 -

举例说明

假设有三个数据点 x1=[1,2]x_1 = [1, 2]x1=[1,2],x2=[2,3]x_2 = [2, 3]x2=[2,3],x3=[8,9]x_3 = [8, 9]x3=[8,9],我们要将它们分成两个簇。初始质心 μ1=[1,1]\mu_1 = [1, 1]μ1=[1,1],μ2=[8,8]\mu_2 = [8, 8]μ2=[8,8]。- 计算数据点到质心的距离:

- 对于 x1x_1x1,到 μ1\mu_1μ1 的距离为 ∥[1,2]−[1,1]∥2=1\left\| [1, 2] - [1, 1] \right\|^2 = 1∥[1,2]−[1,1]∥2=1,到 μ2\mu_2μ2 的距离为 ∥[1,2]−[8,8]∥2=85\left\| [1, 2] - [8, 8] \right\|^2 = 85∥[1,2]−[8,8]∥2=85,所以 x1x_1x1 属于簇 1。

- 对于 x2x_2x2,到 μ1\mu_1μ1 的距离为 ∥[2,3]−[1,1]∥2=5\left\| [2, 3] - [1, 1] \right\|^2 = 5∥[2,3]−[1,1]∥2=5,到 μ2\mu_2μ2 的距离为 ∥[2,3]−[8,8]∥2=61\left\| [2, 3] - [8, 8] \right\|^2 = 61∥[2,3]−[8,8]∥2=61,所以 x2x_2x2 属于簇 1。

- 对于 x3x_3x3,到 μ1\mu_1μ1 的距离为 ∥[8,9]−[1,1]∥2=113\left\| [8, 9] - [1, 1] \right\|^2 = 113∥[8,9]−[1,1]∥2=113,到 μ2\mu_2μ2 的距离为 ∥[8,9]−[8,8]∥2=1\left\| [8, 9] - [8, 8] \right\|^2 = 1∥[8,9]−[8,8]∥2=1,所以 x3x_3x3 属于簇 2。

- 重新计算质心:

- 簇 1 的质心 μ1=[1,2]+[2,3]2=[1.5,2.5]\mu_1 = \frac{[1, 2] + [2, 3]}{2} = [1.5, 2.5]μ1=2[1,2]+[2,3]=[1.5,2.5]。

- 簇 2 的质心 μ2=[8,9]\mu_2 = [8, 9]μ2=[8,9]。

- 重复上述步骤,直到质心不再变化。

- 计算数据点到质心的距离:

关联规则挖掘算法(Apriori)

-

支持度

支持度表示项集在数据集中出现的频率。对于项集 XXX,其支持度定义为:

Support(X)=Number of transactions containing XTotal number of transactions \text{Support}(X) = \frac{\text{Number of transactions containing } X}{\text{Total number of transactions}} Support(X)=Total number of transactionsNumber of transactions containing X

例如,在一个包含 100 个交易记录的数据集中,项集 {牛奶,面包}\{牛奶, 面包\}{牛奶,面包} 出现在 20 个交易记录中,则其支持度为 20100=0.2\frac{20}{100} = 0.210020=0.2。 -

置信度

置信度表示在包含项集 XXX 的交易记录中,同时包含项集 YYY 的比例。对于关联规则 X→YX \rightarrow YX→Y,其置信度定义为:

Confidence(X→Y)=Support(X∪Y)Support(X) \text{Confidence}(X \rightarrow Y) = \frac{\text{Support}(X \cup Y)}{\text{Support}(X)} Confidence(X→Y)=Support(X)Support(X∪Y)

例如,项集 {牛奶}\{牛奶\}{牛奶} 的支持度为 0.3,项集 {牛奶,面包}\{牛奶, 面包\}{牛奶,面包} 的支持度为 0.2,则关联规则 {牛奶}→{面包}\{牛奶\} \rightarrow \{面包\}{牛奶}→{面包} 的置信度为 0.20.3≈0.67\frac{0.2}{0.3} \approx 0.670.30.2≈0.67。

项目实战:代码实际案例和详细解释说明

开发环境搭建

- 安装Python:从Python官方网站(https://www.python.org/downloads/)下载并安装Python 3.x版本。

- 安装必要的库:使用以下命令安装所需的库:

pip install numpy pandas matplotlib scikit-learn mlxtend

源代码详细实现和代码解读

我们以一个简单的电商用户行为分析为例,假设我们有一个包含用户购买记录的数据集,我们要分析用户的购买行为,找出频繁项集和关联规则。

import pandas as pd

from mlxtend.preprocessing import TransactionEncoder

from mlxtend.frequent_patterns import apriori, association_rules

# 示例数据

data = [

['手机', '充电器', '手机壳'],

['电脑', '鼠标', '键盘'],

['手机', '耳机'],

['电脑', '显示器'],

['手机', '充电器', '耳机']

]

# 数据预处理

te = TransactionEncoder()

te_ary = te.fit(data).transform(data)

df = pd.DataFrame(te_ary, columns=te.columns_)

# 生成频繁项集

frequent_itemsets = apriori(df, min_support=0.2, use_colnames=True)

# 生成关联规则

rules = association_rules(frequent_itemsets, metric="confidence", min_threshold=0.7)

print("频繁项集:")

print(frequent_itemsets)

print("关联规则:")

print(rules)

代码解读与分析

- 数据预处理:使用

TransactionEncoder将数据转换为适合Apriori算法处理的格式。 - 生成频繁项集:使用

apriori函数生成频繁项集,设置最小支持度为 0.2。 - 生成关联规则:使用

association_rules函数从频繁项集中生成关联规则,设置最小置信度为 0.7。 - 结果输出:打印频繁项集和关联规则,通过分析这些结果,我们可以了解用户的购买行为模式,例如哪些商品经常一起购买。

实际应用场景

电商领域

- 商品推荐:通过分析用户的浏览和购买行为,为用户推荐相关的商品。例如,如果用户购买了手机,系统可以推荐手机壳、充电器等配件。

- 库存管理:根据用户的购买频率和趋势,合理安排库存。如果某种商品的购买频率较高,可以适当增加库存。

金融领域

- 风险评估:分析客户的交易行为、信用记录等,评估客户的风险等级。例如,如果客户经常进行大额交易且还款记录良好,风险等级可能较低。

- 个性化服务:根据客户的投资偏好和风险承受能力,为客户提供个性化的投资建议。

医疗领域

- 疾病预测:分析患者的病历、症状、检查结果等数据,预测患者可能患有的疾病。例如,通过分析患者的基因数据和生活习惯,预测患癌症的风险。

- 医疗资源分配:根据患者的病情和需求,合理分配医疗资源。例如,将有限的床位优先分配给病情较重的患者。

工具和资源推荐

数据分析工具

- Python:是一种功能强大的编程语言,拥有丰富的数据分析库,如

numpy、pandas、scikit-learn等。 - R语言:专门用于统计分析和数据可视化的编程语言,有很多优秀的数据分析包。

- Tableau:一款强大的数据可视化工具,可以将分析结果以直观的图表形式展示出来。

数据挖掘算法库

- Scikit-learn:提供了丰富的机器学习算法,包括聚类、分类、回归等。

- TensorFlow:一个开源的机器学习框架,可用于深度学习模型的开发和训练。

- PyTorch:另一个流行的深度学习框架,具有动态图的优势,易于使用和调试。

数据集

- Kaggle:一个数据科学竞赛平台,提供了大量的公开数据集,涵盖了各种领域。

- UCI Machine Learning Repository:一个经典的机器学习数据集仓库,包含了许多常用的数据集。

未来发展趋势与挑战

发展趋势

- 更加智能化:AI原生应用将越来越智能,能够自动学习和适应用户的行为和需求。例如,智能助手可以根据用户的使用习惯,提供更加个性化的服务。

- 多模态融合:结合多种数据模态,如文本、图像、音频等,提供更加丰富和全面的用户体验。例如,一个智能客服可以同时处理用户的语音和文字咨询。

- 边缘计算:将AI计算能力下沉到边缘设备,减少数据传输延迟,提高应用的响应速度。例如,智能摄像头可以在本地进行图像识别,而不需要将数据上传到云端。

挑战

- 数据隐私和安全:随着AI原生应用的发展,需要处理大量的用户数据,数据隐私和安全问题变得尤为重要。如何保护用户的隐私,防止数据泄露和滥用,是一个亟待解决的问题。

- 算法可解释性:一些复杂的AI算法,如深度学习算法,往往是黑盒模型,难以解释其决策过程。在一些关键领域,如医疗、金融等,算法的可解释性至关重要。

- 人才短缺:AI领域的发展需要大量的专业人才,包括算法工程师、数据科学家等。目前,人才短缺是制约AI原生应用发展的一个重要因素。

总结:学到了什么?

核心概念回顾

- AI原生应用:是一种从设计之初就深度融入AI技术的应用程序,具有智能、高效等特点。

- 行为分析:通过收集和分析用户在应用中的行为数据,发现用户的行为模式和需求。

- 市场需求:市场中消费者对某种产品或服务的欲望和需求,是应用开发的重要依据。

概念关系回顾

- AI原生应用通过行为分析了解用户需求,从而进行优化和改进,以更好地满足市场需求。

- 行为分析为市场需求的洞察提供数据支持,帮助企业了解用户的喜好和痛点。

- 市场需求引导AI原生应用的开发方向,促使开发者开发出更符合用户需求的应用。

思考题:动动小脑筋

思考题一

你能想到生活中还有哪些地方用到了AI原生应用的行为分析吗?比如在社交媒体、在线教育等领域。

思考题二

如果你是一个AI原生应用的开发者,你会如何利用行为分析来提高应用的用户满意度?

思考题三

随着技术的发展,未来AI原生应用的行为分析可能会面临哪些新的挑战和机遇?

附录:常见问题与解答

问题一:什么是AI原生应用和传统应用的区别?

答:AI原生应用从设计之初就深度融入AI技术,以AI能力为核心驱动力来实现其主要功能。而传统应用可能只是在后期添加了一些AI功能,或者没有使用AI技术。例如,一个传统的电商应用可能只是提供商品展示和交易功能,而一个AI原生的电商应用可能会利用AI技术进行个性化推荐、智能客服等。

问题二:行为分析需要收集哪些数据?

答:行为分析需要收集用户在应用中的各种行为数据,包括但不限于点击事件、浏览记录、停留时间、购买记录等。这些数据可以帮助我们了解用户的行为模式和需求。

问题三:如何选择合适的算法进行行为分析?

答:选择合适的算法需要考虑数据的特点、分析的目标和应用场景。例如,如果要对用户进行分类,可以选择聚类算法;如果要发现项之间的关联关系,可以选择关联规则挖掘算法。同时,还需要考虑算法的复杂度、可解释性等因素。

扩展阅读 & 参考资料

- 《Python数据分析实战》

- 《机器学习》(周志华著)

- 《深度学习》(Ian Goodfellow等著)

- Kaggle官方网站(https://www.kaggle.com/)

- Scikit-learn官方文档(https://scikit-learn.org/stable/)

更多推荐

已为社区贡献105条内容

已为社区贡献105条内容

所有评论(0)