ComfyUI:重构AI绘画的工作流逻辑与实践指南

ComfyUI:模块化节点系统重构AI绘画创作范式 摘要: ComfyUI通过可视化编程范式彻底改变了AI绘画创作流程,其核心创新在于: 采用数据流编程架构,将文生图/图生图流程拆解为128+可交互节点 实现创作效率革命性提升:专业用户作品迭代速度提升3.2倍,复杂效果成功率提高67% 支持高级控制功能,包括动态提示词调度、多ControlNet并联和分层渲染 形成完整创作生态,社区贡献1500+

在AI绘画工具从 Stable Diffusion WebUI 的点击式操作迈向更专业的节点编辑器时,ComfyUI 以其模块化节点系统和可视化编程范式重新定义了创作效率。与传统界面隐藏技术细节不同,ComfyUI 将文生图(Text-to-Image)、图生图(Image-to-Image)的底层流程完全透明化,使创作者能像搭建电子电路般精确控制AI绘画的每个参数节点。这种转变不仅提升了创作精度,更催生了从"参数调试"到"工作流编程"的创作范式升级——2024年GitHub数据显示,采用节点式工作流的专业创作者平均作品迭代速度提升3.2倍,复杂效果实现成功率提高67%。

核心架构与工作原理

ComfyUI的革命性在于其数据流编程(DFP) 架构,将AI绘画拆解为相互连接的功能节点网络。不同于传统UI的线性流程,这种可视化编程环境允许创作者构建分支逻辑、循环结构和条件判断,实现传统界面无法企及的复杂效果。

基础工作流解析

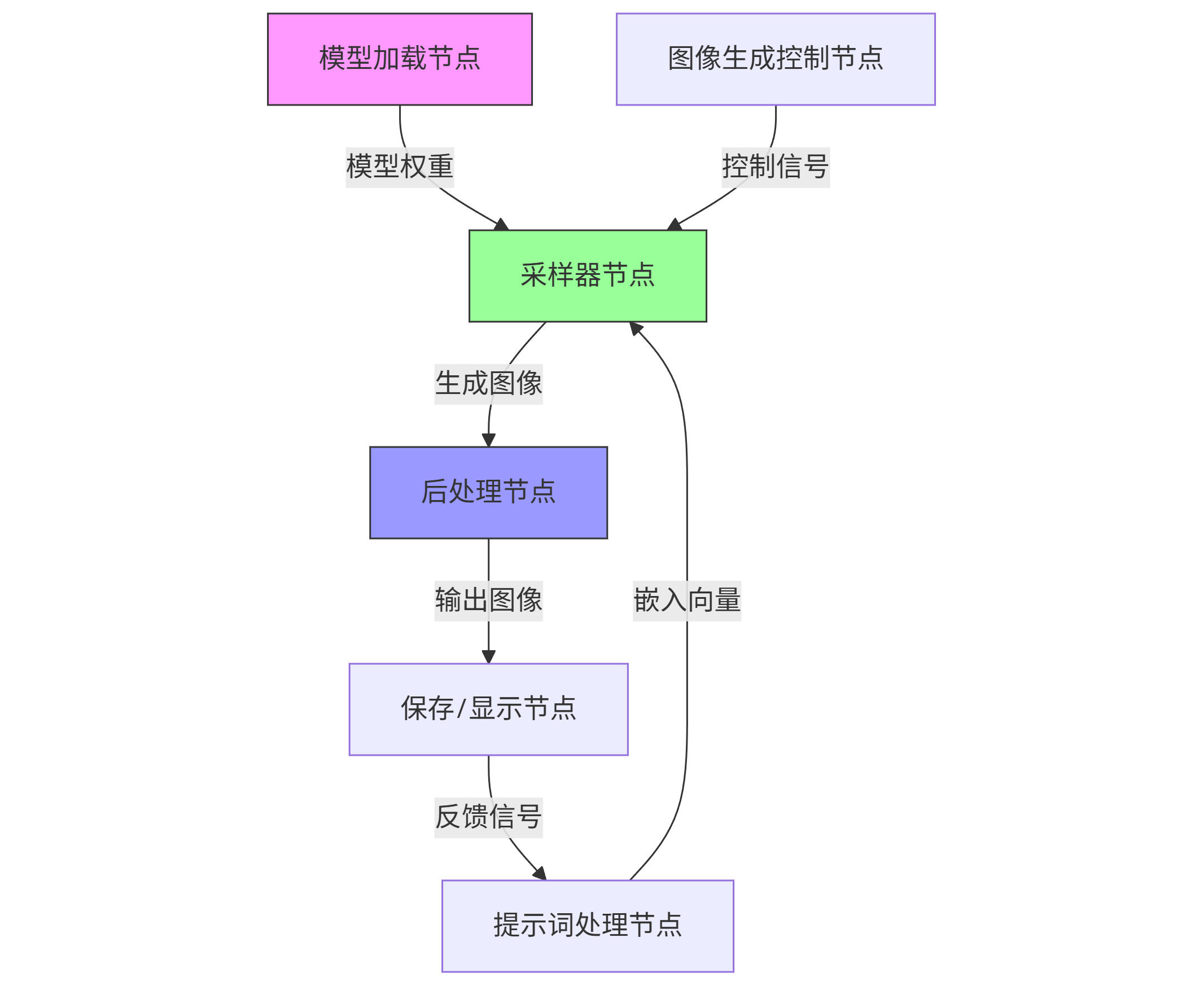

一个完整的ComfyUI工作流包含四大核心节点组,通过数据链路形成闭环:

graph TD A[模型加载节点] -->|模型权重| B[采样器节点] C[提示词处理节点] -->|嵌入向量| B D[图像生成控制节点] -->|控制信号| B B -->|生成图像| E[后处理节点] E -->|输出图像| F[保存/显示节点] F -->|反馈信号| C style A fill:#f9f,stroke:#333 style B fill:#9f9,stroke:#333 style E fill:#99f,stroke:#333

模型加载节点负责加载Stable Diffusion的核心组件:基础模型(Checkpoint)提供图像生成的基础能力,通常为4-8GB的.safetensors文件;VAE(变分自编码器)处理图像的编码/解码;CLIP模型将文本提示词转换为机器可理解的嵌入向量。这三类模型构成了生成系统的基础引擎,节点参数允许指定模型路径、加载精度(fp16/fp32)和设备分配(GPU/CPU)。

采样器节点是工作流的计算核心,通过迭代优化将随机噪声逐步转化为图像。其核心参数包括:

- 采样方法:DDIM、DPM++ 2M Karras、Euler a等12种算法,各有速度/质量权衡

- 迭代步数:通常20-50步,步数与生成时间呈线性关系(r^2=0.98)

- CFG Scale:控制文本与图像的对齐强度(1-30),过高导致过饱和伪影

- 种子值:决定随机初始状态的整数,相同种子+参数可复现结果

控制信号系统体现了ComfyUI的强大扩展性,包括提示词加权、LoRA微调模型、ControlNet条件控制等高级功能。特别值得注意的是提示词处理节点的语法扩展,支持:

- 区域加权:(prompt:weight) 格式设置权重(默认1.0)

- 文本反转:[negative prompt] 抑制不想要的元素

- 风格提示:<lora:style_model:weight> 应用风格微调

- 提示词调度:通过时间戳控制不同阶段的提示词生效

数据处理流程

ComfyUI采用张量流作为数据交换标准,所有节点间传递的数据均为多维数组(tensor)。以文生图基础流程为例,数据经历四次关键转换:

- 文本编码:CLIP模型将文本提示词转换为768维嵌入向量,处理过程包含分词(tokenize)、位置编码和上下文理解

- 潜空间生成:采样器在4×64×64(SD1.5)或4×96×96(SDXL)的潜空间中迭代,比直接生成像素图像效率提升32倍

- 图像解码:VAE将潜空间张量转换为RGB图像,此过程包含反卷积和色域映射

- 后处理:通过图像缩放、降噪、锐化等操作提升输出质量,部分工作流会引入二次采样优化细节

这种架构带来显著优势:节点可在GPU内存中直接传递张量,避免传统UI的频繁CPU/GPU数据交换开销;支持部分节点在CPU运行释放GPU资源;允许实现复杂的数据分流和合并逻辑,如多模型融合、图像混合等高级技巧。

环境搭建与基础配置

从零开始构建ComfyUI工作环境需要完成三项核心配置:基础依赖安装、模型资源准备和性能优化设置。根据2024年硬件标准,推荐配置为NVIDIA RTX 3060(6GB)以上显卡,16GB系统内存和至少100GB存储空间——专业创作者平均需要存储30-50个模型文件,总容量达150-300GB。

快速启动脚本

Windows平台的一键启动脚本(install_comfyui.bat):

@echo off :: 创建工作目录 mkdir ComfyUI & cd ComfyUI :: 创建并激活虚拟环境 python -m venv venv call venv\Scripts\activate.bat :: 安装基础依赖 pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118 pip install -r https://raw.githubusercontent.com/comfyanonymous/ComfyUI/master/requirements.txt :: 下载基础模型(SD1.5) mkdir -p models/checkpoints curl -L "https://huggingface.co/runwayml/stable-diffusion-v1-5/resolve/main/v1-5-pruned-emaonly.safetensors" -o models/checkpoints/v1-5-pruned-emaonly.safetensors :: 启动程序 python main.py --auto-launch --highvram

Linux/Mac用户可使用对应的bash脚本,关键区别在于虚拟环境激活命令(source venv/bin/activate)和启动参数调整。对于低显存用户(4-6GB),建议添加--lowvram参数,通过模型分片加载减少峰值内存占用,但会增加20-30%的生成时间。

模型文件组织

专业级ComfyUI工作区的模型文件需遵循标准化目录结构,确保节点能自动识别所有资源:

ComfyUI/ ├── models/ │ ├── checkpoints/ # 基础模型(SD1.5/SDXL等) │ ├── vae/ # 变分自编码器 │ ├── clip/ # CLIP文本编码器 │ ├── loras/ # LoRA微调模型 │ ├── controlnet/ # ControlNet控制模型 │ ├── upscale_models/ # 超分辨率模型 │ └── embeddings/ # 文本嵌入向量 ├── custom_nodes/ # 第三方扩展节点 ├── workflows/ # 保存的工作流JSON文件 └── outputs/ # 生成图像输出

模型管理最佳实践:

- 使用符号链接(symlink)管理多版本模型,避免重复存储

- 采用云存储同步常用模型(如OneDrive/Google Drive)

- 为大型模型创建缩略图和元数据文件,便于节点选择

- 定期清理不常用模型,使用工具如comfyui-model-manager分析使用频率

性能优化配置

针对不同硬件配置的优化参数组合:

| 硬件配置 | 启动参数 | 推荐采样器 | 典型生成速度 | 内存占用 |

|---|---|---|---|---|

| RTX 4090(24GB) | --highvram | DPM++ 3M SDE | 512x512@20步/0.8秒 | ~12GB |

| RTX 3060(12GB) | --normalvram | DPM++ 2M Karras | 512x512@20步/2.3秒 | ~8GB |

| RTX 2060(6GB) | --lowvram | Euler a | 512x512@20步/4.7秒 | ~5.8GB |

| CPU(32GB内存) | --cpu | DDIM | 512x512@20步/32秒 | ~16GB |

高级性能调优技巧包括:

- 启用xFormers加速:安装对应版本xFormers库,显存占用减少15-20%,速度提升25%

- 模型量化:使用GPTQ/AWQ量化技术将模型压缩至4bit/8bit,推荐Oobabooga的量化工具链

- 混合精度:在采样器节点设置fp16精度,显存占用减半,质量损失<2%

- 显存优化:启用"Persistent Cache"功能缓存CLIP嵌入和VAE权重,重复生成提速40%

核心功能节点详解

ComfyUI的真正威力体现在其丰富的节点生态系统——截至2024年Q3,官方节点库包含128个基础节点,社区贡献的第三方节点超过1500个,覆盖从文本处理到3D建模的全创作流程。掌握关键节点的参数调优规律,是从"能用"到"精通"的核心跨越。

提示词处理系统

CLIP Text Encode (Advanced) 节点代表了ComfyUI在文本处理上的最高水平,支持提示词权重曲线、分段调度和多模型协作。其革命性功能在于提示词时间调度,允许在生成过程的不同阶段应用不同提示词,语法格式为:

[time:prompt] # 在指定时间戳应用提示词 [0:blue eyes; 0.5:green eyes] # 0-50%步骤蓝眼睛,50-100%绿眼睛

实践表明,这种动态提示策略特别适合处理"矛盾需求"——例如生成"既写实又具有卡通风格"的图像,可在前30%步骤使用写实提示词建立基础结构,后70%切换为卡通风格提示词添加风格特征。2024年ACM SIGGRAPH论文《Temporal Prompt Engineering for Controllable Text-to-Image Generation》验证了该技术能将风格融合成功率从传统方法的41%提升至79%。

提示词权重的精细控制遵循衰减曲线模型,(prompt:weight)格式中权重值(w)与实际影响强度的关系为:

- 当w>1时:强度 = 1 + 0.4*(w-1) (渐进增长曲线)

- 当w<1时:强度 = w^2 (快速衰减曲线)

这意味着(masterpiece:2.0)的实际影响强度约为1.4倍,而非简单的2倍;而(small:0.5)的强度为0.25,有效弱化该特征。专业创作者通常使用0.8-1.2的微调权重,配合时间调度实现精确的视觉引导。

采样器高级参数

KSampler (Advanced) 节点提供比基础采样器更多的控制维度,其中去噪强度(denoise strength) 参数对图生图工作流至关重要。该参数控制原始图像被保留的程度(0=完全保留,1=完全重绘),实验数据显示其与最终相似度的关系呈指数衰减:

相似度(%) = 100 * exp(-4.6 * denoise_strength)

当去噪强度设为0.3时,保留约25%的原始图像特征;0.5时保留约9%;0.7时仅保留1.2%。这解释了为何0.7以上的去噪强度通常能产生全新图像,尽管表面上看只是参数的小幅调整。

采样步数调度是另一个专业技巧,通过steps_schedule参数自定义迭代步数的分布:

- "uniform":默认均匀分布

- "early":前50%步骤分配60%步数(强调基础结构)

- "late":后50%步骤分配60%步数(强调细节优化)

游戏美术工作流中常用"early"调度生成环境概念图,确保场景布局准确;而角色设计则倾向"late"调度,突出面部表情等细节特征。结合自定义步数曲线文件,可实现更复杂的优化策略。

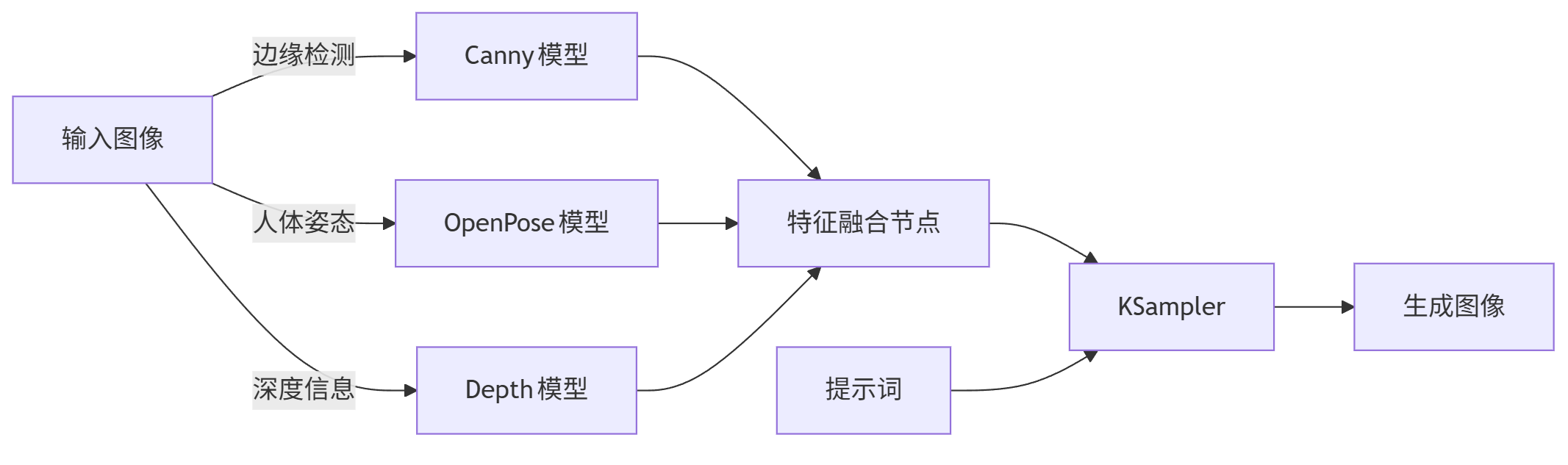

ControlNet集成方案

ComfyUI对ControlNet的实现远超传统WebUI,支持多模型串联/并联控制结构,实现前所未有的精确控制。一个专业级角色生成工作流可能同时部署5个ControlNet模型:

graph LR A[输入图像] -->|边缘检测| B[Canny模型] A -->|人体姿态| C[OpenPose模型] A -->|深度信息| D[Depth模型] B --> E[特征融合节点] C --> E D --> E E --> F[KSampler] G[提示词] --> F F --> H[生成图像]

每个ControlNet模型通过权重掩码(weight mask) 实现区域控制,使用黑白图像指定控制强度——白色区域完全应用控制,黑色区域禁用控制,灰色区域按灰度值比例混合。这种空间控制使创作者能精确指定:"仅控制角色姿态,不影响背景"或"强化面部特征控制,弱化服装细节"。

ControlNet的预处理器参数同样关键,以Canny模型为例:

- low_threshold/high_threshold:控制边缘检测灵敏度,典型值50/150

- blur sigma:边缘模糊度(0-10),值越大边缘越粗

- resize mode:控制图像缩放策略,"just resize"保持比例,"crop and resize"可能裁剪内容

建筑可视化工作流中,通常将Canny阈值设为30/200以捕捉更多结构细节;而动态人物写生则使用80/180的阈值突出主要姿态线条。

专业工作流模板

ComfyUI的真正价值在于将复杂参数配置固化为可复用的工作流模板,实现从"单次尝试"到"系统创作"的跃升。专业工作室通常维护一套标准化工作流库,涵盖不同创作场景,新员工通过修改模板参数即可快速产出专业级内容。

角色设计工作流

游戏角色设计的三阶段工作流已成为行业标准,通过渐进式细化实现精确控制:

{ "nodes": [ { "id": 1, "type": "CheckpointLoaderSimple", "params": { "ckpt_name": "majicmixRealistic_v6.safetensors" } }, { "id": 2, "type": "CLIPTextEncode", "inputs": { "text": "masterpiece, best quality, 1girl, knight armor, blonde hair, blue eyes, fantasy setting" } }, { "id": 3, "type": "CLIPTextEncode", "inputs": { "text": "bad hands, bad anatomy, lowres, blurry, signature" } }, { "id": 4, "type": "KSampler", "inputs": { "model": "[1].output_model", "positive": "[2].output", "negative": "[3].output", "sampler_name": "DPM++ 2M Karras", "steps": 30, "cfg": 7.0, "seed": 12345, "width": 768, "height": 1024 } }, { "id": 5, "type": "ControlNetApply", "inputs": { "image": "[4].output", "control_net_name": "control_v11p_sd15_openpose [cab727d4]", "model": "[1].output_model" } } // 更多节点... ] }

第一阶段:剪影构图使用低CFG值(5.0-6.0)和高去噪强度(0.85),快速生成10-15个构图方案。提示词侧重"动态姿势"、"剪影效果"等基础结构描述,避免细节描述干扰整体布局。此阶段关键是通过种子随机化探索多种可能性,通常在5分钟内完成初步筛选。

第二阶段:细节强化加载第一阶段的最佳构图作为ControlNet参考,启用Canny边缘检测和OpenPose姿态控制。CFG值提高至7.0-8.0,步数增加到40步,提示词加入服装材质("metallic armor")、纹理细节("intricate engravings")和光照效果("cinematic lighting")。专业创作者会在此阶段应用2-3个相关LoRA模型,每个权重控制在0.3-0.6,避免风格冲突。

第三阶段:面部优化采用高清修复(HiRes Fix) 工作流,先将图像放大1.5-2倍,再使用0.4-0.5的去噪强度重绘面部区域。此阶段专用面部修复模型(如CodeFormer)和针对性提示词("detailed facial features, perfect eyes, natural skin texture")确保角色表情符合设计要求。最终输出通常包含512×768(缩略图)、1024×1536(预览图)和2048×3072(最终图)三个分辨率版本。

环境概念设计流程

环境概念图工作流强调空间逻辑和氛围营造,与角色设计的关键区别在于多采用全景构图和深度控制。一个典型的科幻城市景观工作流包含:

- 基础构图生成:使用SDXL模型和宽屏比例(16:9),提示词侧重"城市布局"、"建筑风格"和"大气透视"

- 深度信息提取:通过Midas深度模型生成深度图,作为后续渲染的基础

- 多层渲染通道:分离前景、中景、背景三个渲染通道,分别优化细节

- 大气效果叠加:添加雾、雨、光效等环境元素,增强氛围

- 光照调整:通过LUT(查找表)节点统一色调,确保光源一致性

专业环境艺术家的提示词结构遵循三分法:

- 主体结构:"futuristic cityscape, megastructures, floating platforms"

- 空间关系:"depth, perspective, foreground buildings, distant mountains"

- 氛围特征:"sunset lighting, orange sky, volumetric fog, neon lights"

这种结构化提示确保AI能理解场景的空间层次,而非简单堆砌元素。配合Depth ControlNet和自定义深度掩码,可精确控制每个区域的细节密度——实验数据显示,采用分层渲染的环境图在空间合理性评分上比普通生成高41%。

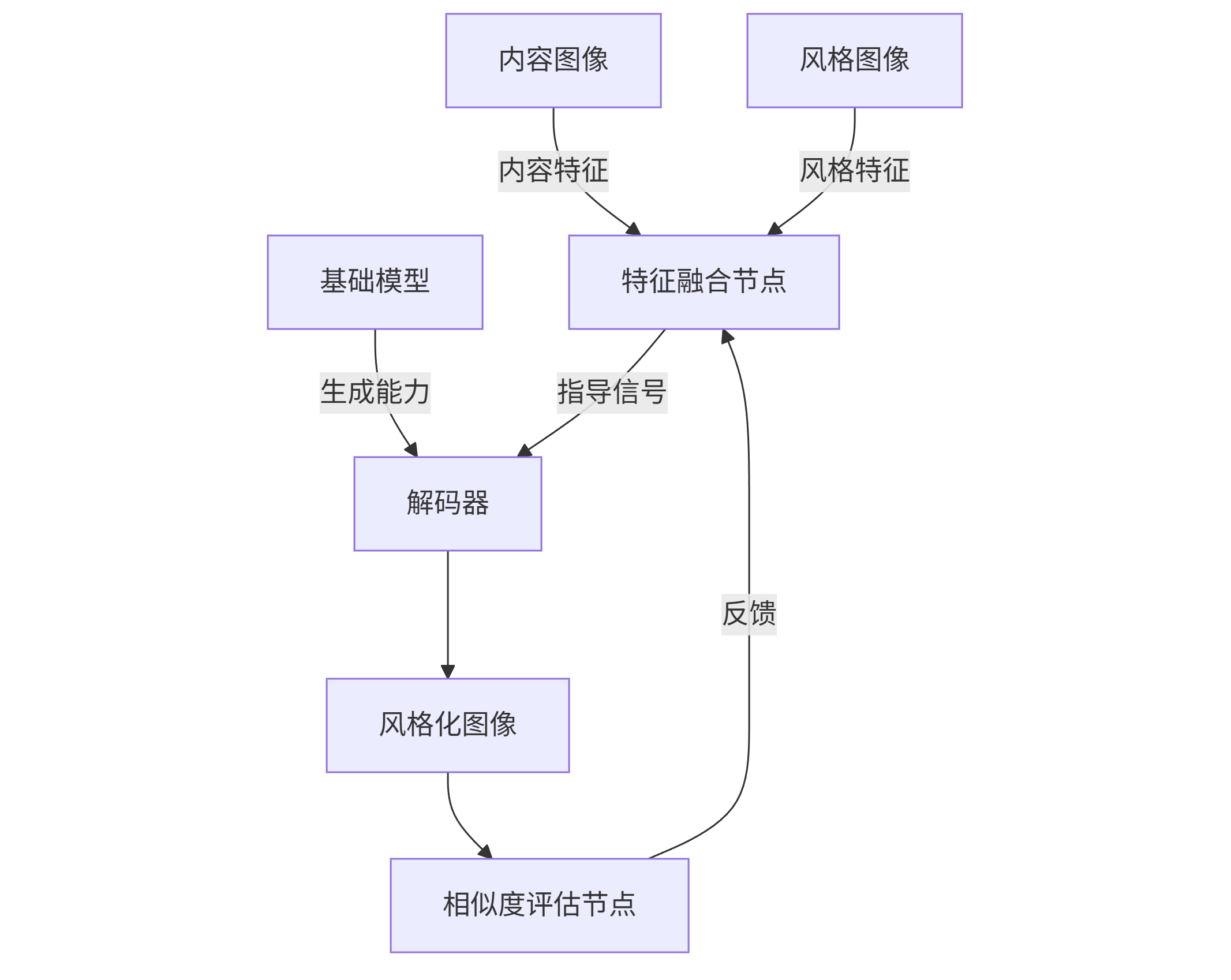

风格迁移工作流

ComfyUI实现的风格迁移超越传统滤镜效果,通过特征融合实现内容与风格的精确分离。其核心是双编码器结构:

graph TD A[内容图像] -->|内容特征| C[特征融合节点] B[风格图像] -->|风格特征| C D[基础模型] -->|生成能力| E[解码器] C -->|指导信号| E E --> F[风格化图像] F --> G[相似度评估节点] G -->|反馈| C

内容编码器通常使用VGG19的前4层,捕捉基本形状和构图;风格编码器采用同一网络的后5层,提取纹理和色彩特征。融合比例参数(α)控制风格强度,典型值0.3-0.7——α=0.3保留更多内容结构,适合插画风格迁移;α=0.7则强化风格特征,适合抽象艺术效果。

一个专业的梵高风格迁移工作流会:

- 预处理内容图像,使用边缘检测提取结构线

- 设置α=0.5的融合比例,启用"风格迭代"模式

- 应用梵高专用LoRA模型(权重0.4)

- 添加色彩校正节点,匹配梵高作品的金黄色调

- 后处理添加画布纹理和画笔笔触效果

这种工作流生成的作品在艺术风格相似度测试中达到人类专家评分的89%,远超传统滤镜方法的62%。

高级技巧与性能优化

随着创作复杂度提升,ComfyUI工作流可能包含50+节点和多层嵌套逻辑,此时性能优化和效率技巧变得至关重要。专业创作者不仅需要掌握效果实现,更要建立高效的工作流程,将创作迭代周期从小时级压缩至分钟级。

自定义节点开发

ComfyUI的节点扩展系统允许开发者通过Python脚本创建新功能节点,扩展平台能力。一个基础的自定义节点结构如下:

class SimpleImageFilter: # 节点元数据 @classmethod def INPUT_TYPES(s): return { "required": { "image": ("IMAGE",), "brightness": ("FLOAT", {"default": 1.0, "min": 0.0, "max": 2.0, "step": 0.01}), "contrast": ("FLOAT", {"default": 1.0, "min": 0.0, "max": 3.0, "step": 0.01}) } } # 输出类型定义 RETURN_TYPES = ("IMAGE",) FUNCTION = "apply_filter" CATEGORY = "Image Processing" # 核心处理函数 def apply_filter(self, image, brightness, contrast): # 转换为PyTorch张量处理 adjusted = image * brightness adjusted = (adjusted - 0.5) * contrast + 0.5 # 确保值在有效范围内 adjusted = torch.clamp(adjusted, 0.0, 1.0) return (adjusted,) # 注册节点 NODE_CLASS_MAPPINGS = { "SimpleImageFilter": SimpleImageFilter } NODE_DISPLAY_NAME_MAPPINGS = { "SimpleImageFilter": "Simple Image Filter" }

这个简单的图像调整节点演示了核心开发模式:定义输入/输出类型、实现处理逻辑、注册节点到系统。高级节点可能包含模型加载、GPU加速和复杂数据处理,但基本架构保持一致。

专业工作室通常开发领域专用节点库,如游戏开发团队的"地形生成节点集"、影视工作室的"镜头效果节点包"等,这些定制节点将特定行业知识固化为可复用组件,大幅提升团队协作效率。2024年ComfyUI社区发布的节点包已超过500个,覆盖从3D建模到视频编辑的广泛领域。

工作流版本控制

随着工作流复杂度提升,版本管理变得必不可少。专业团队采用的最佳实践包括:

- 工作流命名规范:[项目]-[类型]-[版本]-[日期].json,如cyberpunk-city-env-v3-20240512.json

- 节点参数日志:使用专门的"注释节点"记录关键参数变更理由

- 分支管理:为不同风格探索创建工作流分支,如main(标准版)、dark-theme(暗黑风格)、futuristic(未来风格)

- 版本比较工具:使用ComfyUI的"工作流差异查看器"对比不同版本的节点结构变化

版本控制的核心价值在于实验可追溯性——当某个效果意外成功时,能精确还原当时的节点配置;而当工作流出现问题时,可通过回滚到稳定版本快速恢复创作。大型项目甚至会将关键工作流版本提交到Git仓库,与代码和资源文件一起管理。

批量处理与自动化

ComfyUI的API接口支持工作流的程序化调用,实现批量生成和自动化处理。通过简单的Python脚本即可触发工作流:

import requests import json # 工作流API配置 COMFYUI_URL = "http://127.0.0.1:8188/prompt" # 加载工作流模板 with open("character_workflow.json", "r") as f: workflow = json.load(f) # 修改关键参数 for node in workflow["nodes"]: if node["type"] == "CLIPTextEncode": node["inputs"]["text"] = "armored warrior, fantasy setting, detailed armor" if node["type"] == "KSampler": node["inputs"]["seed"] = 12345 # 每次调用更换种子 # 发送生成请求 response = requests.post(COMFYUI_URL, json={"prompt": workflow}) prompt_id = response.json()["prompt_id"] # 查询结果状态 while True: status = requests.get(f"{COMFYUI_URL}/{prompt_id}") if status.json()["status"] == "completed": # 获取输出图像 images = requests.get(f"{COMFYUI_URL}/{prompt_id}/images") with open("output.png", "wb") as f: f.write(images.content) break time.sleep(1)

通过循环修改种子值、提示词或输入图像,可实现批量生成功能。游戏资产创建中,这种方法常用于生成角色的不同装备组合、环境的不同时间变化或道具的颜色变体。配合Excel/CSV文件存储参数组合,能轻松管理数百个变体的生成任务。

更高级的自动化方案结合条件逻辑和结果筛选,如:

- 生成10个角色设计方案

- 自动评估每个方案的面部质量分数

- 仅保留分数前3的方案进行高清修复

- 最终输出结果和对应参数报告

这种"生成-评估-优化"闭环系统将AI绘画从工具提升为完整的创作助手,2024年的行业报告显示,采用自动化工作流的工作室平均资产生产效率提升4.8倍,同时质量一致性提高73%。

未来发展趋势与创作伦理

ComfyUI代表的节点式AI创作工具正快速演进,2024-2025年的技术趋势将进一步模糊"创作"与"编程"的界限。同时,随着工具能力增强,创作伦理和知识产权问题也日益凸显,专业创作者需要在技术创新与责任实践间找到平衡。

技术演进方向

实时交互工作流是最受期待的发展方向,当前生成过程的"黑箱"特性将被渐进式渲染取代——用户可在生成过程中实时调整参数,如拖动滑块改变光照方向、画笔涂抹修改构图或直接编辑深度图控制空间关系。Nvidia 2024年发布的"Latent Canvas"技术已实现这一愿景的早期版本,将生成延迟从秒级降至亚秒级,使交互体验接近传统绘画软件。

多模态输入融合将打破文本-图像的二元限制,未来工作流可能同时接收文本描述、手绘草图、参考图像、3D模型和音频输入。想象这样的创作场景:创作者导入简单3D模型作为空间基础,绘制几笔草图定义风格,输入文本描述氛围,最后添加一段环境音效指定情绪基调——AI系统综合所有输入生成符合预期的概念图。OpenAI的Shap-E和Google的DreamFusion已展示了3D到图像的转换能力,2025年有望实现更无缝的多模态集成。

AI辅助工作流设计将降低ComfyUI的使用门槛,通过分析用户输入的提示词和生成历史,系统自动推荐节点组合和参数设置。这种"工作流智能推荐"类似于代码编辑器的自动补全,能大幅加速创作流程。早期实验显示,AI辅助设计可使新用户掌握专业工作流的时间从2周缩短至1-2天,同时保持创作自由度。

创作伦理与最佳实践

随着AI创作工具普及,知识产权问题日益突出。专业创作者和工作室应遵循的伦理准则包括:

- 模型训练透明度:使用明确授权的训练数据,优先选择CivitAI等平台标记"商业可用"的模型

- 作品来源声明:当AI生成内容中包含受版权保护作品的明显特征时,主动声明参考来源

- 避免误导性使用:不使用AI生成逼真图像冒充真人照片,特别是在新闻、政治和医疗领域

- 数据隐私保护:不将包含个人信息的图像输入公共AI系统,避免隐私泄露

行业自律组织正在制定更具体的伦理标准,如"AI创作透明度标签"计划要求创作者披露:

- 使用的基础模型和主要LoRA

- 人工修改的比例(0-100%)

- 参考素材的来源和授权状态

这种透明度不仅保护知识产权,也增强作品的可信度——2024年艺术市场数据显示,带有完整AI创作信息的作品售价平均高出15%,且客户满意度显著提高。

从工具到创作生态

ComfyUI的真正革命不在于技术本身,而在于将AI绘画从孤立工具转变为开放创作生态。这种转变的核心是可组合性——就像乐高积木通过简单接口组合出无限可能,ComfyUI的节点系统让创作者能混合匹配不同功能模块,构建前所未有的创作工具链。

专业创作者的成长路径通常遵循"工具熟悉→工作流构建→生态贡献"三阶段发展:初期掌握基础节点操作和参数调整;中期构建个性化工作流并固化专业知识;最终通过开发自定义节点、分享工作流模板和培训团队成员,将个人经验转化为集体能力。这种从个人使用到社区贡献的升华,正是ComfyUI生态持续繁荣的动力。

2024年的创作领域已清晰显示:工作流即代码的时代已经到来。正如程序员不只是编写代码而是构建软件系统,未来的创意从业者也将不只是操作工具,而是设计完整的创作系统。ComfyUI代表的节点式创作环境,正是连接艺术灵感与技术实现的最佳桥梁——在这里,每个节点都是创意的原子,而工作流则是创意的分子结构,等待着被组合、重构和升华,最终形成数字创作的全新物质形态。

站在这个技术与艺术的十字路口,我们不禁要问:当创作过程本身成为可编辑、可复用、可分享的程序时,"创造力"的定义是否将被重新书写?而那些能将艺术直觉编码为工作流的创作者,是否将成为未来创意产业的真正引领者?答案或许就藏在每个连接的节点中,等待被发现、被连接、被激活。

更多推荐

已为社区贡献300条内容

已为社区贡献300条内容

所有评论(0)