分布式系统的“断案专家”:深度解析 MCP 哨兵机制并实战跨库一致性智能监控台

通过 MCP 协议构建分布式事务 AI 哨兵,我们实际上是为复杂的微服务系统安装了一个**“具备业务常识的监控头”**。它打破了各个数据库之间的物理隔离,将原本沉没在海量日志中的一致性风险,通过语义化的Tools和实时感知的Resources展现在开发者面前。这种从“死后尸检”到“实时哨兵”的范式转变,不仅能极大地降低 SRE 的排查压力,更能通过 AI 的逻辑推理能力,提前发现那些由于系统设计漏

🛡️ 分布式系统的“断案专家”:深度解析 MCP 哨兵机制并实战跨库一致性智能监控台

💡 内容摘要 (Abstract)

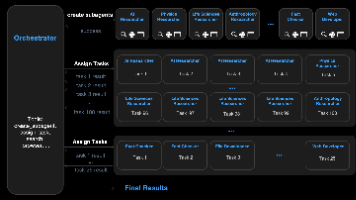

分布式系统的 CAP 定理告诉我们,在分区容错面前,强一致性往往需要牺牲可用性。在追求“最终一致性”的现代工程实践中,数据漂移(Data Drift)成了不可避免的隐患。本文深度探讨了如何利用 Model Context Protocol (MCP) 协议构建一套事务感知的智能控制台。我们将通过 MCP 的 Resources 机制实时汇聚来自异构数据库(如 MySQL、Postgres)的事务日志与消息队列状态,并利用 Tools 封装复杂的跨库对账逻辑。实战部分将展示如何构建一个具备异常事务自动捕获、Saga 补偿链路分析以及数据自愈建议功能的 AI 哨兵 Server。最后,我们将从专家视角出发,深度思考在分布式环境下如何平衡“监控开销”与“数据实时性”,为企业级微服务治理提供一套高可信的 AI 巡检范式。

一、 ⚖️ 混沌中的平衡:为什么分布式事务需要 AI 级别的“动态观测”?

在分布式环境下,事务不再是一个简单的 BEGIN 和 COMMIT。

1.1 最终一致性的“灰度地带”:数据不一致的根源

- 网络分区 (Network Partition):第一阶段提交成功,第二阶段由于网络断开导致部分节点未收到指令。

- 补偿失效 (Compensated Failure):在 TCC 或 Saga 模式中,撤销操作(Cancel/Compensate)本身由于下游服务故障而执行失败。

- 消息积压与丢失:作为事务驱动的消息队列如果出现延迟,会导致不同库之间的数据在数分钟内处于不一致状态。

1.2 传统监控的局限与 MCP 的“降维打击”

传统的监控工具(如 SkyWalking 或 Prometheus)侧重于“性能指标”,而无法感知“业务逻辑一致性”。

| 维度 | 传统分布式监控 | MCP AI 哨兵模式 |

|---|---|---|

| 观测深度 | 关注 QPS、延迟、状态码 | 关注数据记录间的逻辑关联(跨库对账) |

| 异常定义 | 预设阈值报错 | 基于语义的逻辑冲突识别(如余额 > 资产总和) |

| 修复能力 | 需要人工介入写脚本 | AI 自动生成补偿指令并预演结果 |

| 接入成本 | 需要侵入代码埋点 | 通过 MCP 标准接口实现非侵入式“旁路观察” |

1.3 专家视点:从“事后审计”到“实时哨兵”

传统的对账往往是 T+1(第二天执行)。利用 MCP 协议,我们可以将对账逻辑下沉到 AI 交互层。AI 作为一个哨兵,可以在用户执行关键业务操作时,后台自动触发一次 validate_cross_db_state 的 Resource 读取,实现毫秒级的异常捕捉。

二 :🛠️ 深度实战:构建具备“事务感知”能力的跨库 AI 哨兵 Server

我们将模拟一个经典的“电商下单”场景:涉及订单库(Order DB)和库存库(Inventory DB)。我们要实现一个 Server,让 AI 能同时看穿这两个库的状态。

2.1 基础设施:多源数据库连接与环境配置

我们需要安装支持多数据库访问的 MCP 框架。

mkdir mcp-transaction-sentinel && cd mcp-transaction-sentinel

npm init -y

npm install @modelcontextprotocol/sdk sqlite3

npm install -D typescript @types/node @types/sqlite3

npx tsc --init

2.2 核心代码实现:跨库对账工具与状态 Resource

一个专业的哨兵 Server 必须能够执行“联合查询”,即使底层库是物理隔离的。

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";

import { ListToolsRequestSchema, CallToolRequestSchema, ListResourcesRequestSchema, ReadResourceRequestSchema } from "@modelcontextprotocol/sdk/types.js";

import sqlite3 from "sqlite3";

import { open } from "sqlite";

// 🚀 初始化分布式事务哨兵 Server

const server = new Server(

{ name: "distributed-tx-sentinel", version: "1.0.0" },

{ capabilities: { tools: {}, resources: {} } }

);

// 📡 连接模拟的订单库与库存库

async function getOrderDb() { return open({ filename: './orders.db', driver: sqlite3.Database }); }

async function getStockDb() { return open({ filename: './stocks.db', driver: sqlite3.Database }); }

// 📖 1. 注册资源:暴露异常事务流水

server.setRequestHandler(ListResourcesRequestSchema, async () => ({

resources: [{

uri: "tx://anomalies/pending",

name: "待处理异常事务清单",

description: "实时列出那些在多个数据库中状态不一致的业务流水号",

mimeType: "application/json"

}]

}));

// 🛠️ 2. 定义对账与修复工具

server.setRequestHandler(ListToolsRequestSchema, async () => ({

tools: [

{

name: "cross_check_inventory",

description: "执行跨库核对:比对订单库状态与库存扣减记录。识别潜在的数据丢失风险。",

inputSchema: {

type: "object",

properties: {

order_id: { type: "string", description: "待核查的订单编号" }

},

required: ["order_id"]

}

},

{

name: "suggest_compensating_action",

description: "针对发现的事务异常,由 AI 分析并生成补偿操作(回滚或重试)的建议方案。",

inputSchema: {

type: "object",

properties: {

error_context: { type: "string", description: "异常的详细描述" }

}

}

}

]

}));

// ⚙️ 3. 处理执行逻辑:跨库关联分析

server.setRequestHandler(CallToolRequestSchema, async (request) => {

const { name, arguments: args } = request.params;

if (name === "cross_check_inventory") {

const orderDb = await getOrderDb();

const stockDb = await getStockDb();

const orderId = args?.order_id;

// 💡 专家思考:模拟复杂的跨库关联查询

const order = await orderDb.get("SELECT * FROM orders WHERE id = ?", orderId);

const stockLog = await stockDb.get("SELECT * FROM stock_logs WHERE business_id = ?", orderId);

if (!order || !stockLog) {

return { content: [{ type: "text", text: `⚠️ 警告:订单 [${orderId}] 存在严重的数据完整性风险:库中缺失对应的关联记录。` }] };

}

// 逻辑对账:订单已支付但库存未锁定

if (order.status === 'PAID' && stockLog.status !== 'LOCKED') {

return {

content: [{ type: "text", text: `❌ 发现一致性冲突:订单已支付,但库存处于 [${stockLog.status}] 状态。需要立即介入!` }]

};

}

return { content: [{ type: "text", text: `✅ 事务核对通过:订单 [${orderId}] 的跨库状态一致。` }] };

}

throw new Error("Tool not found");

});

const transport = new StdioServerTransport();

await server.connect(transport);

三、 🧠 专业思考:分布式环境下 AI 治理深度权衡

作为 MCP 专家,在设计“事务哨兵”时,我们不仅要看懂代码,更要理解分布式治理的底座逻辑。

3.1 解决“假阳性”问题:如何区分“处理中”与“不一致”?

- 挑战:在最终一致性架构下,数据在几百毫秒内的不一致是正常的(由于网络延迟或消息积压)。如果 AI 哨兵在这个瞬间发出警报,就会产生大量的误报(False Positive)。

- 专家方案:引入“冷静期(Grace Period)”机制。

- 在读取

tx://anomalies/pending时,Server 应当只返回那些更新时间超过 30 秒但状态依然不一致的记录。 - 语义判定:AI 应当在 Prompt 中被告知,仅当业务流水的

updated_at已经远超服务超时阈值时,才启动修复建议。

- 在读取

3.2 修复权力的边界:AI 能直接写库吗?

- 风险:如果让 AI 直接执行修复脚本,可能会造成二次破坏。

| 维度 | 实践准则 | 专家建议 |

| :— | :— | :— |

| 只读观察 | 默认权限仅限 SELECT。 | AI 负责发现问题,不负责物理修改。 |

| 影子演练 | 修复建议必须在 Resource 中模拟执行。 | 让 AI 先在“预发布”环境或 Resource 快照中演示修复后的数据状态。 |

| 二次确认 | 执行敏感修复必须结合“人工审核流”。 | 通过 MCP 发送卡片到飞书或钉钉,管理员点击后才真正下发 DML 指令。 |

3.3 可观测性的“性能损耗”控制

- 思考:跨库查询是非常昂贵的。

- 优化策略:

- 基于 Binlog 的异步推送:哨兵 Server 并不轮询数据库,而是监听 Binlog 或消息队列的死信通道(DLQ)。当发现异常信号时,才主动推送 Resource 更新给 AI。

- 语义采样:不要让 AI 检查每一个事务。应当对高金额、高风险等级的事务执行 100% 巡检,对低风险事务执行抽样巡检。

四、 🌟 总结:迈向自愈式分布式架构

通过 MCP 协议构建分布式事务 AI 哨兵,我们实际上是为复杂的微服务系统安装了一个**“具备业务常识的监控头”**。

它打破了各个数据库之间的物理隔离,将原本沉没在海量日志中的一致性风险,通过语义化的 Tools 和实时感知的 Resources 展现在开发者面前。这种从“死后尸检”到“实时哨兵”的范式转变,不仅能极大地降低 SRE 的排查压力,更能通过 AI 的逻辑推理能力,提前发现那些由于系统设计漏洞导致的隐性数据漂移。

在 AGI 赋能运维的征途中,这种具备事务感知能力的智能控制台,将是企业构建健壮、可靠、可自愈分布式系统的核心基础设施。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)