拒绝“大海捞针”:如何在大规模知识库下保持RAG系统的尖端性能?

你需要准备至少 100 个基于真实文档的问题,并手动标出对应它们的“标准答案”所在的文档页码。支持搜索的“规模陷阱”提醒我们:大模型时代的竞争,下半场将聚焦于高精度的数据治理。从目前的发展趋势来看,大模型能力正在逐渐从“通用模型”走向“场景化模型”。等待一个做什么做的超级模型,不如根据具体需求,对模型进行定向定制。像**这样的平台,本质上就是在帮助更多的个人和小团队,参与到这条趋势里来,让“定制模

博主前言:很多开发者在构建 RAG(搜索增强生成)系统时,往往陷入一个误区:认为只要把数千个文档整体脑塞进提供数据库,AI 就能成为“全知全能”的专家。然而现实很骨感。你是否发现,当知识库从几页增加到几万页时,模型的回答开始变得模糊、张冠李戴,甚至间隙出现“幻觉”?这背后的罪魁祸首,是被大多数人忽视的“规模陷阱”。今天,我们就来拆解这个硬核问题。

一、引言:为什么“博学”的RAG反而变弱了?

在 RAG 的世界里,开发者们普遍追求更全、更大的知识库。但数据科学家 Daniel Warfield 与前 IBM Watson 高级工程师 Benjamin Fletcher 博士的最新研究让这种狂热降了温。

他们通过实验发现:搜索的准确率会随着数据量的增加而显着下降。 当文档量达到10000页时,性能开始出现裂痕;而一旦覆盖100000页大关,搜索准确率的损失竟然高达12% 。

这意味着,你的RAG系统可能正处在一个“大海捞针”的困境中——随着海水的上涨(数据增加),针(相关信息)不但没有变多,反而被泥沙(无关背景)彻底掩埋了。

二、技术原理:拆解支持搜索的“规模陷阱”

要解决问题,首先要搞清楚基础逻辑。为什么在小规模表现出色的支撑搜索,在大规模场景下会失效?

2.1 高维空间的“人口爆炸”

支撑搜索的本质洞察文本转化为高维空间中的坐标。理论上,1536维的支撑空间(如OpenAI的text-embedding-3-small)可以承载比宇宙原子还多的信息点。

但在实际应用中,编码器(编码器)的表达能力是有天花板的。当10万页文档挤进同一个疏导空间时,空间会变得严重的“杂乱”。许多在语义上有微弱关联的段落,在疏导坐标上可能因距离极近而形成“噪音簇”。基于余弦相似面部距离或欧氏距离的搜索策略,在这种“爆炸人口”时,很难在毫厘之间分辨出谁才是真正的相关项。

2.2 简单的距离与复杂的语义关系

大多数支持数据库(如 Pinecone、Milvus)依赖简单的几何距离来达到相似性。

- 1,000分钟时:空间宽敞,语义差异被放大,搜索精准。

- 10万分钟时:空间重叠严重。由于模型难以将海量异质信息完全“有意义地”组织起来,究竟清晰的边界变得模糊,导致基于距离的搜索效果呈现线性下降。

2.3 组织效率的“负担论”

这就像一个团队:

- 一个团队(小规模) :共享背景越多,决策越快。

- 巨大的企业(大规模) :信息泛滥(Overload)会导致沟通成本飙升。对于RAG来说也是如此,过多的相关上下文(Context)会变成巨大的信息负载,干扰LLM的最终决定。

三、实践步骤:四步走,构建高可靠的大规模RAG

规模带来的挑战,我们不能坐以待毙。以下是优化大规模RAG系统的实战路径:

3.1 实施混合搜索(Hybrid Search)

不要把所有鸡蛋放在“正在寻找”的篮子里。

- 关键词搜索(BM25) :精准精准匹配(人名、术语、特定编号)。

- 支持搜索(Vector) :负责关联关联。

- 融合策略:利用倒排索引与提供索引的互补特性,可以有效调整单一维度在规模扩大时的精度损失。

3.2 引入“上下文检索”(Contextual Retrieval)

这是人类最近极力推荐的方案。在文档切片(分块)阶段,不仅仅是机械切割,而是为每个分块附加背景摘要。

- 优势:显着增强了分块的语义独特性,使得Embedding模型在将其推入思考空间时,能够赋予更精准的坐标。

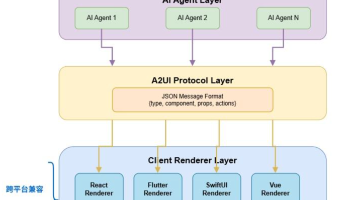

3.3 建立“选表/路由”模型(Router)

针对TB级的知识库,不要指望在一个大索引里解决问题。

- 方案:先用一个轻量级模型判定问题所属的领域(比如是“技术手册”还是“行政规定”),然后将搜索范围锁定在对应的子库中。

3.4 模型配置:让AI真正读懂你的业务

在实际实践中,如果仅仅停留在“了解大模型原理”,其实很难真正实现模型能力的差异。

我个人比较推荐直接上手做一次模型,比如用LLaMA-Factory Online这种低负债大模型偏差平台,把自己的数据真正“喂”进模型里,生产出属于自己的专属模型。即使没有代码基础,也能轻松跑完模型流程,在实践中明白怎么让模型“其实你想要的样子”。如果你的知识库包含大量专业术语或独特的业务逻辑,通用的嵌入模型可能无法提供足够的区分度。推荐尝试LLaMA-Factory Online,它提供了开箱即用的湿度环境,助你快速提升模型在特定领域的认知能力。

四、效果评估:如何科学验证你的RAG性能?

优化完成后,必须通过严谨的测试来验证效果,而不是“拍脑袋”觉得变准了。

4.1定义真值测试集(Ground Truth)

你需要准备至少 100 个基于真实文档的问题,并手动标出对应它们的“标准答案”所在的文档页码。

4.2 运行规模压力测试

复刻研究团队的方案,创建四个不同的迷你的集合文档:

- 基线:1,000页(核心答案文档)。

- 压力测试A:10,000页。

- 压力测试B:50,000页。

- 压力测试C:100,000页。

4.3 关键指标监控

- Recall@K:前 K 个召回结果中包含正确答案的比例。

- MRR(平均倒数排名) :正确答案排在第几位?排名越靠前,投票分数。

- 答案正确性:最终生成的答案与真值的拟合一致性。

4.4 调试与代码展示

在处理特定的控制命令或异常反馈时,建议使用重构的数据格式。例如,当搜索结果与指令冲突时的处理逻辑:

JSON

python

体验AI代码助手

代码解读

复制代码

{ "instruction": "查询 2024 年产品销量并对比 2023 年", "input": "知识库当前仅有 2023 年数据", "output": "{"error": "INCOMPLETE_CONTEXT", "message": "知识库缺失 2024 年核心文档", "suggestion": "请补充上传 2024 年度财务报表后重试"}" }

五、总结与展望:从“通用”走向“场景化”

支持搜索的“规模陷阱”提醒我们:大模型时代的竞争,下半场将聚焦于高精度的数据治理。

从目前的发展趋势来看,大模型能力正在逐渐从“通用模型”走向“场景化模型”。等待一个做什么做的超级模型,不如根据具体需求,对模型进行定向定制。

像**LLaMA-Factory Online这样的平台,本质上就是在帮助更多的个人和小团队,参与到这条趋势里来,让“定制模型”不再只是大厂独有。想要真正拉开差距?关键训练存在没有稳定、高性能的环境。LLaMA-Factory Online将GPU资源与训练流程深度整合,让你能够把精力完全放在数据策略上,快速迭代出最适合你业务的RAG基础。

博主寄语:RAG不是简单的拼图游戏,而是一场关于精度与效率的博弈。通过混合搜索、数据清理与定向倾斜,你可以跨越那12%的性能鸿沟,打造出真正可商业落地的AI应用。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)