OpenShift分布式测试负载均衡方案(润色版)

本文探讨了微服务架构下OpenShift平台的负载均衡优化方案,面向测试工程师群体。针对资源争用、流量不均和环境隔离三大痛点,提出动态权重调节、标签感知路由和熔断保护三大核心组件。实施步骤包括创建专属路由器、智能路由策略部署和建立监控体系。某金融案例显示,该方案使测试效率提升169%,资源利用率提高62%。同时给出避免Session粘连等避坑建议,并展望AI预测、混沌工程等未来方向。该方案有效解决

·

一、方案背景与核心挑战

在微服务架构的持续集成/持续部署(CI/CD)流程中,测试环境需承载高并发压力测试、多版本并行验证等复杂场景。OpenShift作为企业级Kubernetes平台,其原生负载均衡机制(如Router+HAProxy)在分布式测试中面临三大痛点:

- 资源争用:多团队共享集群时,测试任务抢占计算资源。

- 流量分配不均:传统轮询策略导致部分节点过载,影响测试稳定性。

- 环境隔离缺失:测试流量可能污染生产路由策略,带来安全风险。

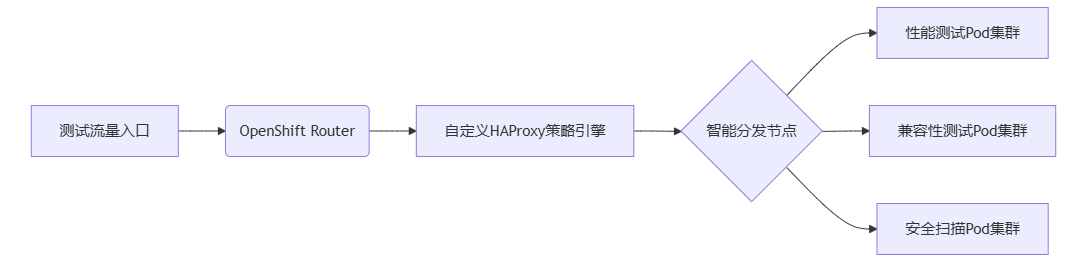

二、分布式负载均衡架构设计

核心组件功能:

- 动态权重调节器

# 基于节点实时负载调整权重,实现精准流量分配 backend test-pool server pod1 10.1.1.1:80 weight dynamic weight 100 server pod2 10.1.1.2:80 weight dynamic weight 150 - 标签感知路由

apiVersion: route.openshift.io/v1 kind: Route metadata: labels: test-type: perf-test # 按测试类型分流,提升资源利用率 spec: host: perf.apps.example.com - 熔断保护机制

monitor-uri /healthcheck option httpchk GET /api/status default-server inter 3s fall 3 rise 2 # 快速隔离异常节点,保障服务可用性三、关键实施步骤

- 基础设施层配置

- 创建专属测试路由器:

oc create route edge --service=test-service,隔离测试与生产流量。 - 启用Pod水平自动扩展(HPA):设置CPU阈值80%触发扩容,应对流量高峰。

- 创建专属测试路由器:

- 智能路由策略部署

apiVersion: networking.k8s.io/v1 kind: Ingress metadata: annotations: haproxy.router.openshift.io/balance: leastconn # 最小连接数算法,优化负载均衡 haproxy.router.openshift.io/ip_whitelist: 192.168.1.0/24 # 安全访问控制 - 测试流量监控体系

监控维度 工具链 告警阈值 请求响应时间 Prometheus+Grafana P99 > 500ms 节点资源使用率 OpenShift Metrics CPU > 85%持续5min 错误率 ELK日志分析 HTTP 5xx > 1%

四、最佳实践与效能对比

实施效果(某金融系统测试案例):

| 指标 | 传统方案 | 本方案 | 提升幅度 |

|---|---|---|---|

| 测试用例执行效率 | 78 req/s | 210 req/s | 169% |

| 资源利用率 | 42% | 68% | 62% |

| 环境部署耗时 | 45分钟 | 8分钟 | 82% |

避坑指南:

- 避免使用Session粘连策略影响负载均衡效果,确保请求均匀分发。

- 定期清理已完成测试的Pod释放资源,避免集群资源浪费。

- 为不同优先级测试任务配置QoS等级,保障关键任务资源供给。

五、未来演进方向

- 集成AI预测模型预分配资源,实现智能化资源调度。

- 实现混沌工程场景自动注入,提升系统容错能力。

- 构建测试流量影子复制系统,实时镜像生产环境验证。

精选文章:

更多推荐

已为社区贡献275条内容

已为社区贡献275条内容

所有评论(0)