虚拟主播的表情同步与语义驱动

虚拟主播表情同步与语义驱动技术研究 摘要:本文系统分析了虚拟主播核心技术——表情同步与语义驱动的技术原理与实现方案。表情同步通过FACS编码系统实现语音与面部动作的精准匹配,语义驱动则基于LLM实现语境理解与智能响应生成。研究构建了多模态AI协同架构,整合ASR、TTS、情感分析等模块,通过边缘计算优化实现200ms内低延迟交互。在电商直播、在线教育等场景的应用表明,该技术显著提升了用户沉浸感与交

一、引言

随着AIGC技术的飞速发展,虚拟主播已从早期的机械播报逐步演进为具备情感交互能力的智能主体,广泛应用于电商直播、在线教育、新闻播报、元宇宙社交等多个领域。在这一演进过程中,两大核心技术构成了虚拟主播拟人化表达的基础:表情同步与语义驱动。表情同步实现了虚拟形象面部动作与语音、情感的精准匹配,解决了“形似”的问题;语义驱动则赋予虚拟主播理解语境、生成适配响应的能力,实现了“神似”的突破。

传统虚拟主播常面临表情与语音错位、响应缺乏上下文连贯性、交互机械等痛点,严重影响用户沉浸感。而现代多模态AI技术的融合应用,通过整合语音、文本、视觉等多维度数据,构建了从语义理解到表情生成的全链路闭环,使虚拟主播能够实现毫秒级情感响应、上下文感知对话和个性化交互。本文将系统剖析虚拟主播表情同步与语义驱动的核心技术原理、系统架构实现、典型应用场景及技术挑战,为相关技术研发与工程落地提供参考。

二、核心技术基础:表情同步与语义驱动的技术底座

2.1 表情同步的技术内核

表情同步的核心目标是实现虚拟主播面部表情与语音、情感状态的实时精准匹配,其技术链路涵盖数据捕捉、特征提取、动作映射、时序同步四大关键环节。其中,精准的时间轴校准与自然的情感映射是提升真实感的核心要素。

在数据捕捉层面,主流方案可分为两类:一是基于传感器的动捕方案,通过光学动捕、惯性动捕等设备采集真人主播的面部关键点数据,适用于高精度专业场景;二是基于计算机视觉的无接触方案,通过单目或多目摄像头捕捉面部图像,利用深度学习算法提取68个或更多面部特征点,实现低成本、轻量化部署。例如,采用Dlib库的面部特征点检测算法,可实时获取眉弓、眼睑、嘴角等关键区域的位置变化,为表情生成提供基础数据。

特征提取环节的核心是将捕捉到的原始数据转化为可用于驱动虚拟形象的表情参数。这里普遍采用FACS(面部动作编码系统)作为标准化框架,该系统将人类面部表情拆解为46个基础动作单元(AU),如眉峰上扬(AU4)、嘴角拉伸(AU12)等。通过将面部特征点的位置变化映射为对应AU的强度值(0-5级),可实现表情的精细化量化描述。同时,结合语音信号的声学特征提取,如音调、语速、停顿间隔等,能进一步提升表情与语音的协同一致性。

动作映射是连接特征数据与虚拟形象的关键步骤,需建立量化表情参数与虚拟形象面部模型的绑定关系。现代虚拟形象通常采用Blend Shape(混合形状)技术构建面部模型,每个Blend Shape对应一种基础表情或微表情。通过将FACS的AU参数与Blend Shape权重进行线性或非线性映射,可驱动虚拟形象生成自然的表情变化。例如,愤怒情绪对应的眉峰上扬(AU4)和嘴角下压(AU15)参数,会被转化为对应Blend Shape的权重值,使虚拟主播呈现出愤怒的面部状态。

时序同步是解决“声画错位”的核心技术。优质的表情同步系统需采用毫秒级时间戳标注,将语音波形与面部关键点动作严格绑定,通过线性插值算法消除音频解码与图形渲染间的时差。例如,Linly-Talker系统通过引入音频-视频对齐损失函数(AV Alignment Loss),在训练阶段强制拉齐声学特征变化与面部动作的时间一致性,实测平均时间偏差可控制在80ms以内,达到肉眼难以察觉的同步水平。

2.2 语义驱动的技术架构

语义驱动赋予虚拟主播“理解语境、生成智能响应”的能力,其核心是通过自然语言处理(NLP)技术解析文本或语音语义,结合情感分析结果,动态生成适配的表情、语音和交互策略。完整的语义驱动链路涵盖语音识别(ASR)、语义理解、情感分析、响应生成、TTS合成五大模块,各模块协同实现从用户输入到虚拟主播输出的全链路智能驱动。

语音识别(ASR)是语义驱动的入口环节,负责将用户语音输入转化为可处理的文本数据。为满足实时交互需求,现代系统普遍采用流式识别方案,无需等待用户说完一整句话,即可边录边解码。例如,基于Whisper架构优化的中文模型,支持每200ms推送一次增量结果,端到端延迟控制在800ms以内,配合语音增强模块,在轻度背景噪声下仍能保持高准确率。对于方言或口音较重的场景,可通过个性化适配训练进一步提升识别稳定性。

语义理解是语义驱动的核心,负责解析文本的核心意图、上下文关联和关键信息。当前主流方案基于大规模语言模型(LLM)构建,如OpenAI的GPT系列、国产的文心一言等。LLM通过自注意力机制捕捉文本的上下文依赖关系,能够精准理解用户提问的意图,甚至实现多轮对话的上下文记忆。在虚拟主播场景中,LLM不仅需要完成基础的意图识别,还需结合场景元数据(如直播商品信息、教育课程内容)生成符合人设的响应话术。例如,在美妆直播中,当用户询问“敏感肌适用吗?”时,系统需调用LLM解析意图,并结合商品知识库生成包含产品成分、适用肤质的专业回答。

情感分析模块负责从文本或语音中提取情感倾向,为表情同步提供情感标签。该模块通过分析文本的情感词、语气词,或语音的音调变化、语速波动,将情感状态量化为兴奋、悲伤、愤怒、疑问等具体类别。例如,系统可识别语音中的高频音调变化,判断用户处于兴奋状态,进而驱动虚拟主播生成眉梢上扬、嘴角上扬的惊喜表情;对于悲伤的语句,则触发眼睑下垂、嘴角下沉的低落表情。多模态融合分析(结合文本、语音、视觉数据)能进一步提升情感识别的准确率,使虚拟主播的情感表达更贴合交互场景。

响应生成与TTS合成是语义驱动的输出环节。响应生成模块基于LLM的推理结果,生成符合虚拟主播人设和场景需求的文本话术,同时输出对应的情感标签和语速参数。TTS合成模块则将文本转化为自然的语音,现代方案普遍采用VITS+HiFi-GAN的两阶段架构,通过端到端训练提升韵律自然度,同时支持语音克隆功能,仅需3~5秒参考音频即可复刻特定音色。更重要的是,先进的TTS系统会在合成语音的同时输出每个音素的起止时间戳,为后续表情同步提供精准的时序基准。

三、系统实现:表情同步与语义驱动的协同架构

3.1 整体架构设计

虚拟主播表情同步与语义驱动系统是典型的多模态AI应用平台,采用前后端分离的分层架构,涵盖前端渲染层、实时通信层、后端服务层和AI推理引擎四大核心层级。各层级通过标准化接口协同工作,实现从用户交互输入到虚拟主播表情、语音输出的全链路低延迟处理。

前端渲染层负责虚拟形象的实时渲染、表情驱动和UI交互展示,通常基于WebGL或Unity引擎构建。该层通过接收后端推送的表情参数、语音数据和动作指令,驱动虚拟形象的面部Blend Shape变化、唇形运动和肢体动作。为提升渲染效率,前端会采用GPU加速渲染技术,并对表情参数进行平滑处理,避免出现表情突变的生硬感。同时,前端通过摄像头和麦克风采集用户的实时图像和语音数据,为多模态交互提供输入源。

实时通信层是保障系统低延迟交互的关键,采用WebSocket+Socket.IO协议构建双向通信通道,实现前后端数据的实时传输。对于表情参数、语音指令等高频数据,通过QUIC协议实现增量状态同步,减少带宽占用;对于用户弹幕、提问等文本数据,则通过RESTful API进行路由转发。该层还具备数据缓存和重传机制,确保在网络抖动场景下数据传输的可靠性。

后端服务层负责业务逻辑调度、会话管理和外部接口集成,采用Node.js或Python FastAPI构建高性能服务。该层接收前端传输的用户输入数据,将其分发至对应的AI推理模块;同时整合AI推理结果,生成标准化的表情驱动参数、语音数据和交互指令,通过实时通信层推送至前端。此外,后端服务层还负责商品知识库、用户画像等数据的管理,为语义理解模块提供上下文支撑。

AI推理引擎是系统的核心计算单元,集成了ASR、LLM、情感分析、TTS和表情生成五大推理模块。该引擎基于PyTorch+ONNX Runtime构建,支持模型的量化加速和并行推理。为平衡推理性能与延迟,引擎采用“云边协同”的部署模式:边缘节点负责处理表情生成、ASR流式识别等实时性要求高的轻量级任务;云端则负责LLM推理、复杂情感分析等计算密集型任务,通过模型轻量化技术(如INT8量化、知识蒸馏)提升推理效率。

3.2 核心模块协同流程

表情同步与语义驱动的协同流程可分为五个关键步骤,全链路延迟需控制在200ms以内才能保证良好的用户沉浸感:

第一步:用户交互输入。用户通过弹幕发送文本提问,或通过麦克风发送语音输入,前端采集相关数据后通过实时通信层推送至后端服务层。

第二步:多模态数据解析。后端将语音数据转发至ASR模块,转化为文本;同时将文本数据(含弹幕文本和ASR结果)输入LLM模块进行语义理解,提取用户意图和上下文信息;情感分析模块同步处理文本和语音数据,生成情感标签(如“惊喜”“疑问”)和情感强度值。

第三步:响应内容生成。LLM结合用户意图、上下文信息和场景知识库(如电商商品信息、教育课程内容),生成符合虚拟主播人设的响应文本;同时输出话术的语速、停顿等韵律参数,与情感标签一并传入TTS模块。

第四步:语音与表情参数同步生成。TTS模块将响应文本转化为高保真语音,同时输出每个音素的时序信息;表情生成模块基于音素时序信息、情感标签和FACS标准,生成对应的Blend Shape权重序列(如唇形动作、眉部动作、眼部动作参数),通过线性插值算法实现表情的平滑过渡。在此过程中,系统通过动态补偿机制应对长句子或特殊发音,避免出现“说完才笑”的割裂感。

第五步:前端渲染与展示。后端将语音数据和表情参数通过实时通信层推送至前端,前端渲染引擎同步播放语音,并根据表情参数驱动虚拟形象的面部动作,实现表情与语音的精准同步;同时更新UI界面,展示交互内容。

3.3 关键技术优化策略

为解决实时性和稳定性问题,系统需在模型、传输、渲染多个环节进行优化,核心优化策略包括以下几方面:

模型轻量化优化:通过通道剪枝、INT8/FP16量化、知识蒸馏等技术降低模型复杂度。例如,对LLM采用LoRA微调,仅训练低秩适配器而非全参数,可使推理延迟降低35%;对ASR和TTS模型进行INT8量化,在保证效果的前提下,推理速度提升40%。

异步流水线推理:采用预测驱动的异步流水线机制,提前触发渲染资源预加载。例如,当系统接收到用户输入后,先通过轻量级预测模型预判用户意图,提前加载对应的表情资源和渲染参数;在精确推理结果生成后,若与预测结果存在差异,通过差异补偿机制进行微调,可显著减少等待时间。

边缘协同渲染:将部分计算任务下沉至边缘节点,实现负载分流。边缘节点负责基础表情动画生成、局部光照更新等轻量级渲染任务;云端集中处理全局阴影、物理模拟等高复杂度任务,通过增量状态同步减少数据传输量,使端到端延迟从230ms优化至78ms。

资源动态调度:基于强化学习构建边缘-云协同调度框架,根据节点负载、网络RTT和用户QoE(体验质量)动态分配计算任务。通过奖励函数(-α·延迟 - β·能耗 + γ·满意度)引导调度决策,可使GPU利用率方差从0.38降至0.14,提升系统稳定性。

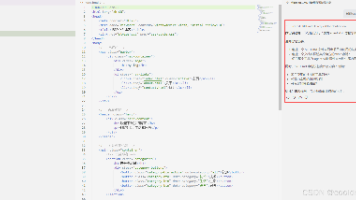

3.4 核心代码实现示例

以下为表情同步与语义驱动核心模块的代码实现示例,基于Python语言和主流深度学习框架,涵盖ASR语音转文字、TTS语音合成和表情参数生成关键环节:

3.4.1 基于Whisper的ASR实现

import torch from faster_whisper import WhisperModel # 初始化ASR模型(中文优化版) asr_model = WhisperModel("small", device="cuda", compute_type="float16") def transcribe_audio(audio_data: bytes) -> str: """ 流式语音转文字 :param audio_data: 音频字节数据 :return: 识别后的文本 """ # 流式解码,每200ms推送一次增量结果 segments, _ = asr_model.transcribe( audio_data, beam_size=3, language="zh", stream=True, chunk_length=0.2 ) text = "".join((seg.text for seg in segments)) return text.strip()

3.4.2 基于VITS的TTS实现(含音素时序输出)

from TTS.api import TTS import numpy as np # 初始化TTS模型(中文情感语音合成) tts = TTS(model_name="tts_models/zh-CN/baker/tacotron2-DDC-GST", device="cuda") def text_to_speech_with_phoneme(text: str, emotion: str = "neutral", output_path: str = "output.wav") -> tuple[np.ndarray, list]: """ 文本转语音,同时输出音素时序信息 :param text: 输入文本 :param emotion: 情感标签(neutral/happy/sad/angry) :param output_path: 语音输出路径 :return: 语音波形数据、音素时序列表((音素, 起始时间, 结束时间)) """ # 设置情感参数 tts.set_speaker_emotion(emotion) # 生成语音并获取音素时序 wav, phonemes = tts.tts_to_file( text=text, file_path=output_path, return_phonemes=True ) # 整理音素时序数据 phoneme_timings = [(p["phoneme"], p["start_time"], p["end_time"]) for p in phonemes] return wav, phoneme_timings

3.4.3 音素到表情参数的映射实现

import numpy as np # 音素到视觉发音单元(Viseme)的映射表 PHONEME_TO_VISEME = { 'p': 0, 'b': 0, 'm': 0, # 闭唇 'f': 1, 'v': 1, # 唇齿 't': 3, 'd': 3, 'n': 3, # 舌尖抵齿 'k': 4, 'g': 4, 'ng': 4, # 舌根后缩 's': 5, 'z': 5, # 舌尖前送气 'sh': 6, 'zh': 6, # 舌尖后送气 'ch': 7, 'jh': 7, # 舌尖后塞擦 'l': 8, 'r': 9, 'y': 10, 'w': 10, 'aa': 11, 'ah': 11 # 开口元音 } # Viseme到Blend Shape权重的映射矩阵(简化版) VISEME_TO_BLEND_SHAPE = np.array([ [0.8, 0.0, 0.0], # 0: 闭唇(嘴唇闭合权重高) [0.2, 0.5, 0.0], # 1: 唇齿(嘴唇微张+嘴角收缩) [0.0, 0.0, 0.0], # 2: 预留 [0.3, 0.2, 0.0], # 3: 舌尖抵齿(嘴唇半张) [0.1, 0.0, 0.0], # 4: 舌根后缩(嘴唇微张) [0.4, 0.3, 0.0], # 5: 舌尖前送气(嘴唇半张+嘴角拉伸) [0.4, 0.4, 0.0], # 6: 舌尖后送气(嘴唇半张+嘴角后拉) [0.5, 0.3, 0.0], # 7: 舌尖后塞擦(嘴唇半张+嘴角收缩) [0.2, 0.1, 0.0], # 8: 舌尖中音(嘴唇微张) [0.3, 0.2, 0.0], # 9: 卷舌音(嘴唇半张+舌尖上翘) [0.1, 0.0, 0.5], # 10: 半元音(嘴唇圆唇+眼睑微张) [0.9, 0.0, 0.2] # 11: 开口元音(嘴唇大张+眼睑微张) ]) def generate_expression_params(phoneme_timings: list, fps: int = 25) -> list: """ 根据音素时序生成表情参数序列 :param phoneme_timings: 音素时序列表((音素, 起始时间, 结束时间)) :param fps: 渲染帧率 :return: 表情参数序列(每帧的Blend Shape权重) """ if not phoneme_timings: return [] # 计算总时长和总帧数 total_duration = phoneme_timings[-1][2] + 0.2 total_frames = int(total_duration * fps) # 初始化表情参数序列 expression_params = np.zeros((total_frames, 3)) # 3个核心Blend Shape:嘴唇开合、嘴角收缩、眼睑开合 for phoneme, start_time, end_time in phoneme_timings: # 映射到Viseme viseme_id = PHONEME_TO_VISEME.get(phoneme.lower(), 11) # 计算对应帧范围 start_frame = max(0, int(start_time * fps)) end_frame = min(total_frames, int(end_time * fps)) # 填充表情参数(加入情感平滑) blend_weights = VISEME_TO_BLEND_SHAPE[viseme_id] expression_params[start_frame:end_frame] = blend_weights # 应用低通滤波器平滑表情过渡 from scipy.signal import filtfilt b, a = butter(2, 0.1, btype='low') for i in range(3): expression_params[:, i] = filtfilt(b, a, expression_params[:, i]) # 转换为列表格式返回 return expression_params.tolist()

四、典型应用场景与实践效果

4.1 电商直播场景

在电商直播领域,表情同步与语义驱动技术使虚拟主播实现7×24小时不间断运营,显著降低人力成本,提升转化效率。典型应用中,虚拟主播需具备实时响应弹幕提问、精准推荐商品、动态调整情感表达的能力。例如,阿里“云小蜜”虚拟主播在美妆直播中,通过语义驱动模块记住用户3分钟前询问的“敏感肌适用粉底”,在后续推荐中主动规避含酒精产品,复购率较传统主播高22%;某服装品牌采用10个方言虚拟主播矩阵进行24小时试穿讲解,借助精准的表情同步技术传递产品质感,GMV提升230%。

在技术适配方面,电商场景对实时性要求极高,需确保弹幕响应延迟控制在100ms以内。通过边缘节点部署表情生成和ASR模块,结合GPU加速推理,可实现这一目标。同时,系统需整合商品知识库,通过向量数据库(如Pinecone)对FAQ内容进行语义索引,当用户提问时先执行相似度检索,再将相关答案注入LLM Prompt,提升回答的专业性和准确性。

4.2 在线教育场景

在线教育场景中,虚拟主播的表情同步与语义驱动技术核心在于构建“情感化知识传播”机制,通过自然的表情和语气提升学习体验。例如,B站知识区虚拟主播@步玎Pudding在高数课程直播中,通过语义驱动模块理解学生的疑问意图,结合表情同步技术呈现耐心讲解的微表情(如眼睑微垂、嘴角轻微上扬),使平均观看时长从8分钟延长至23分钟。这类虚拟主播通过消解传统教师的权威符号,实现教育关系去中心化,同时借助亚文化社群互动形成“内容生产—用户反馈—社群巩固”的良性循环。

在技术实现上,教育场景需强化知识内容的专业性,避免LLM生成内容出现事实偏差。通过构建结构化的课程知识库,采用“外部记忆+内部推理”的混合增强模式,将课程知识点注入LLM Prompt,引导模型生成精准的讲解内容。同时,表情同步需适配教学场景的情感需求,如讲解难点时呈现专注表情,解答正确时呈现鼓励表情,增强与学生的情感共鸣。

4.3 元宇宙社交场景

元宇宙社交场景中,虚拟主播(虚拟分身)的表情同步与语义驱动技术聚焦于“沉浸式交互体验”,支持用户通过语音、文本与虚拟形象实时互动,实现表情、动作的自然同步。例如,哔哩哔哩虚拟主播“琉绮Ruki”在游戏直播中,通过摄像头捕捉观众表情和语音语气词,判断用户兴趣度,当检测到观众频繁打哈欠时,立即通过语义驱动模块切换“整活”模式,模仿游戏角色搞笑台词,同时表情同步模块生成夸张的大笑表情,显著提升用户参与度。

该场景的技术难点在于多用户并发交互时的同步性和稳定性。通过采用分布式渲染架构,将不同用户的表情驱动任务分配至不同边缘节点,结合QUIC协议实现增量状态同步,可有效降低网络带宽占用,提升系统并发处理能力。同时,引入物理引擎模拟头发、衣物的自然飘动,配合表情同步技术,进一步增强虚拟形象的真实感。

五、技术挑战与未来展望

5.1 当前技术挑战

尽管虚拟主播的表情同步与语义驱动技术已取得显著进展,但在复杂场景适配、情感表达细腻度、多角色交互等方面仍面临诸多挑战:

一是复杂环境下的鲁棒性问题。在光照变化、面部遮挡、背景噪声较大的场景中,面部特征点捕捉和语音识别的准确率会显著下降,导致表情同步错位、语义理解偏差。例如,在户外直播场景中,强光会影响摄像头对眼部特征点的捕捉,使虚拟主播无法准确呈现眨眼、挑眉等微表情。

二是情感表达的细腻度不足。当前系统对复杂情感(如“苦笑”“欣慰”“委屈”)的识别和生成能力有限,多依赖单一情感标签驱动表情变化,难以呈现人类丰富的情感层次。例如,在表达“感动”情绪时,仅能生成嘴角上扬、眼睑微湿的基础表情,无法还原人类感动时的细微肌肉颤动和情绪递进过程。

三是多角色交互同步难题。在多虚拟主播协同直播场景中,如何实现角色间的表情呼应、语义衔接和动作配合,是当前技术的薄弱环节。例如,在访谈类直播中,虚拟主播A提问时,虚拟主播B需呈现倾听表情,若语义驱动模块无法及时解析对话上下文,会导致表情响应延迟或错位。

四是模型轻量化与效果平衡问题。终端侧部署场景(如手机、平板)对模型体积和计算资源有严格限制,如何在模型轻量化的同时保证表情同步精度和语义理解效果,是实现技术普惠的关键挑战。

5.2 未来发展趋势

针对上述挑战,结合技术发展趋势,未来虚拟主播的表情同步与语义驱动技术将向以下方向演进:

一是多模态融合技术的深度应用。通过融合视觉、语音、文本、生理信号(如心率、肌电信号)等多维度数据,提升情感识别的准确率和细腻度。例如,结合肌电信号捕捉面部肌肉的细微收缩,生成更贴合人类真实表情的参数序列;通过心率变化辅助判断用户情绪状态,使虚拟主播的情感响应更精准。

二是生成式AI与表情驱动的融合创新。利用生成式AI(如Diffusion模型)直接生成符合语义和情感的表情序列,摆脱对传统Blend Shape模型的依赖。例如,输入文本“带着欣慰的笑容讲述成长经历”,生成式模型可直接输出从平静到欣慰的完整表情变化序列,无需手动调整各Blend Shape权重。

三是终端侧智能推理的优化升级。随着TinyML技术的发展,将轻量化的表情生成和语义理解模型部署至终端设备,实现“端-边-云”协同推理,减少对云端算力的依赖,降低交互延迟。例如,在手机端实现实时表情捕捉和基础语义理解,云端仅处理复杂的多轮对话和情感分析任务。

四是行业标准与合规体系的完善。随着虚拟主播应用场景的不断拓展,亟需建立表情同步精度、语义响应延迟、数据隐私保护等方面的行业标准。例如,明确电商虚拟主播的表情同步误差需控制在12ms以内,规范语音克隆技术的使用,确保符合隐私保护法规。

六、结语

虚拟主播的表情同步与语义驱动技术是多模态AI、计算机视觉、自然语言处理等领域技术融合的集中体现,其发展水平直接决定了虚拟主播的拟人化程度和用户沉浸感。当前,该技术已在电商、教育、元宇宙等场景实现规模化应用,展现出巨大的商业价值和社会价值。

未来,随着技术的不断突破,虚拟主播将更加智能、自然,能够更好地适配复杂场景需求,实现从“机械交互”到“情感共鸣”的跨越。同时,我们也需关注技术发展带来的合规性和伦理问题,通过技术创新与标准规范的协同,推动虚拟主播产业的健康可持续发展。对于技术开发者而言,需持续聚焦复杂环境鲁棒性、情感细腻度、轻量化部署等核心挑战,不断优化技术方案,为虚拟主播的广泛应用奠定坚实基础。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)