AI Agent的强化学习在智能电网管理中的应用

随着全球能源需求的不断增长和对可持续能源的追求,智能电网作为一种新型的电力系统,正逐渐成为未来电力发展的方向。智能电网管理涉及到发电、输电、配电和用电等多个环节的优化和协调,以提高电力系统的效率、可靠性和稳定性。AI Agent的强化学习作为一种强大的人工智能技术,能够在复杂的环境中通过与环境的交互不断学习和优化决策,为智能电网管理提供了新的解决方案。

AI Agent的强化学习在智能电网管理中的应用

关键词:AI Agent、强化学习、智能电网管理、电力系统优化、能源调度

摘要:本文深入探讨了AI Agent的强化学习在智能电网管理中的应用。首先介绍了研究的背景、目的、预期读者和文档结构,明确了相关术语。接着阐述了AI Agent和强化学习的核心概念及其联系,给出了原理和架构的文本示意图与Mermaid流程图。详细讲解了核心算法原理,并通过Python源代码进行阐述。分析了相关的数学模型和公式,结合实际例子说明。通过项目实战,展示了代码的实际案例并进行详细解释。探讨了该技术在智能电网管理中的实际应用场景,推荐了学习资源、开发工具框架和相关论文著作。最后总结了未来发展趋势与挑战,提供了常见问题解答和扩展阅读参考资料,旨在为智能电网管理领域的研究者和从业者提供全面而深入的技术指导。

1. 背景介绍

1.1 目的和范围

随着全球能源需求的不断增长和对可持续能源的追求,智能电网作为一种新型的电力系统,正逐渐成为未来电力发展的方向。智能电网管理涉及到发电、输电、配电和用电等多个环节的优化和协调,以提高电力系统的效率、可靠性和稳定性。AI Agent的强化学习作为一种强大的人工智能技术,能够在复杂的环境中通过与环境的交互不断学习和优化决策,为智能电网管理提供了新的解决方案。

本文的目的是深入探讨AI Agent的强化学习在智能电网管理中的应用,包括核心概念、算法原理、数学模型、实际案例等方面,为相关领域的研究者和从业者提供全面的技术参考。

1.2 预期读者

本文预期读者包括电力系统领域的工程师、研究人员,人工智能领域的学者和开发者,以及对智能电网管理和强化学习感兴趣的相关人员。

1.3 文档结构概述

本文将按照以下结构进行组织:

- 核心概念与联系:介绍AI Agent和强化学习的基本概念及其在智能电网管理中的联系。

- 核心算法原理 & 具体操作步骤:详细讲解强化学习的核心算法原理,并给出Python源代码实现。

- 数学模型和公式 & 详细讲解 & 举例说明:分析强化学习在智能电网管理中的数学模型和公式,并结合实际例子进行说明。

- 项目实战:代码实际案例和详细解释说明:通过一个具体的项目实战,展示AI Agent的强化学习在智能电网管理中的应用。

- 实际应用场景:探讨AI Agent的强化学习在智能电网管理中的实际应用场景。

- 工具和资源推荐:推荐相关的学习资源、开发工具框架和论文著作。

- 总结:未来发展趋势与挑战:总结AI Agent的强化学习在智能电网管理中的未来发展趋势和面临的挑战。

- 附录:常见问题与解答:提供常见问题的解答。

- 扩展阅读 & 参考资料:提供相关的扩展阅读和参考资料。

1.4 术语表

1.4.1 核心术语定义

- AI Agent:人工智能代理,是一种能够感知环境、做出决策并采取行动的智能实体。

- 强化学习:一种机器学习方法,通过智能体与环境的交互,根据环境反馈的奖励信号来学习最优策略。

- 智能电网:将先进的信息技术、通信技术和控制技术应用于传统电网,实现电力系统的智能化管理和运行。

- 状态(State):智能体在环境中的当前情况描述。

- 动作(Action):智能体在某个状态下可以采取的操作。

- 奖励(Reward):环境根据智能体的动作给予的反馈信号,用于指导智能体的学习。

- 策略(Policy):智能体根据当前状态选择动作的规则。

1.4.2 相关概念解释

- 马尔可夫决策过程(MDP):强化学习的数学基础,描述了智能体在环境中的决策过程,具有马尔可夫性,即未来状态只依赖于当前状态和动作。

- Q - 学习:一种无模型的强化学习算法,通过学习动作价值函数Q来找到最优策略。

- 深度强化学习:将深度学习与强化学习相结合,利用深度神经网络来近似动作价值函数或策略。

1.4.3 缩略词列表

- MDP:Markov Decision Process(马尔可夫决策过程)

- Q - learning:Q - 学习

- DQN:Deep Q - Network(深度Q网络)

2. 核心概念与联系

核心概念原理

AI Agent

AI Agent是一种具有感知、决策和行动能力的智能实体。在智能电网管理中,AI Agent可以感知电网的各种状态信息,如发电功率、负荷需求、电压、频率等,然后根据这些信息做出决策,如调整发电设备的出力、控制储能装置的充放电等。AI Agent的决策过程通常基于一定的策略,该策略可以通过学习不断优化。

强化学习

强化学习是一种机器学习方法,它通过智能体与环境的交互来学习最优策略。在强化学习中,智能体处于一个环境中,它可以在每个时间步观察到环境的状态 sts_tst,并根据当前策略选择一个动作 ata_tat 执行。环境在智能体执行动作后会转移到下一个状态 st+1s_{t + 1}st+1,并给予智能体一个奖励 rtr_trt。智能体的目标是最大化长期累积奖励。

强化学习的核心是学习一个策略 π\piπ,它定义了在每个状态下选择动作的概率分布,即 π(a∣s)=P(A=a∣S=s)\pi(a|s)=P(A = a|S = s)π(a∣s)=P(A=a∣S=s)。常用的强化学习算法包括Q - 学习、策略梯度算法等。

智能电网管理

智能电网管理涉及到电力系统的多个方面,包括发电、输电、配电和用电。其目标是实现电力系统的高效、可靠和稳定运行。在智能电网中,存在着大量的不确定性和动态变化,如可再生能源的间歇性、负荷需求的波动等。因此,需要一种能够实时适应这些变化的智能管理方法。

核心概念联系

AI Agent的强化学习在智能电网管理中的应用可以看作是一个智能体在电力系统环境中的学习和决策过程。AI Agent作为智能体,通过传感器感知智能电网的状态,然后根据强化学习算法选择合适的动作来调整电网的运行。智能电网作为环境,根据AI Agent的动作更新状态,并给予相应的奖励。通过不断的交互和学习,AI Agent可以学习到最优的策略,从而实现智能电网的优化管理。

文本示意图

智能电网环境

|

|-- 状态信息(发电功率、负荷需求等)

|

|-- AI Agent

| |

| |-- 感知状态

| |

| |-- 强化学习算法(Q - 学习、DQN等)

| |

| |-- 选择动作(调整发电、控制储能等)

|

|-- 奖励反馈(系统效率、稳定性等)

Mermaid流程图

3. 核心算法原理 & 具体操作步骤

强化学习算法原理

Q - 学习算法

Q - 学习是一种无模型的强化学习算法,它通过学习动作价值函数 Q(s,a)Q(s,a)Q(s,a) 来找到最优策略。动作价值函数 Q(s,a)Q(s,a)Q(s,a) 表示在状态 sss 下执行动作 aaa 后,遵循最优策略所能获得的期望累积奖励。

Q - 学习的更新公式为:

Q(st,at)←Q(st,at)+α[rt+γmaxaQ(st+1,a)−Q(st,at)]Q(s_t,a_t) \leftarrow Q(s_t,a_t)+\alpha\left[r_t + \gamma\max_{a}Q(s_{t + 1},a)-Q(s_t,a_t)\right]Q(st,at)←Q(st,at)+α[rt+γamaxQ(st+1,a)−Q(st,at)]

其中,α\alphaα 是学习率,控制每次更新的步长;γ\gammaγ 是折扣因子,用于权衡即时奖励和未来奖励;rtr_trt 是在状态 sts_tst 执行动作 ata_tat 后获得的奖励;st+1s_{t + 1}st+1 是下一个状态。

具体操作步骤

- 初始化:初始化动作价值函数 Q(s,a)Q(s,a)Q(s,a) 为任意值,通常初始化为0。

- 循环执行以下步骤:

- 观察当前状态 sts_tst。

- 根据当前的 QQQ 值选择一个动作 ata_tat,可以使用 ϵ\epsilonϵ - 贪心策略,以 ϵ\epsilonϵ 的概率随机选择动作,以 1−ϵ1-\epsilon1−ϵ 的概率选择 QQQ 值最大的动作。

- 执行动作 ata_tat,观察环境反馈的奖励 rtr_trt 和下一个状态 st+1s_{t + 1}st+1。

- 根据Q - 学习更新公式更新 Q(st,at)Q(s_t,a_t)Q(st,at)。

- 如果达到终止条件(如达到最大步数或达到目标状态),则结束循环。

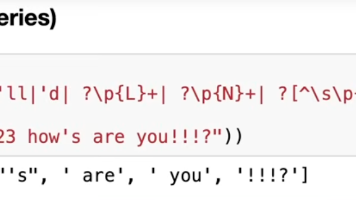

Python源代码实现

import numpy as np

# 定义Q - 学习类

class QLearningAgent:

def __init__(self, state_size, action_size, learning_rate=0.1, discount_factor=0.9, epsilon=0.1):

self.state_size = state_size

self.action_size = action_size

self.learning_rate = learning_rate

self.discount_factor = discount_factor

self.epsilon = epsilon

# 初始化Q表

self.q_table = np.zeros((state_size, action_size))

def choose_action(self, state):

if np.random.uniform(0, 1) < self.epsilon:

# 随机选择动作

action = np.random.choice(self.action_size)

else:

# 选择Q值最大的动作

action = np.argmax(self.q_table[state, :])

return action

def update_q_table(self, state, action, reward, next_state):

# Q - 学习更新公式

target = reward + self.discount_factor * np.max(self.q_table[next_state, :])

self.q_table[state, action] = (1 - self.learning_rate) * self.q_table[state, action] + self.learning_rate * target

代码解释

__init__方法:初始化Q - 学习代理,包括状态空间大小、动作空间大小、学习率、折扣因子和探索率 ϵ\epsilonϵ,并初始化Q表。choose_action方法:根据 ϵ\epsilonϵ - 贪心策略选择动作。update_q_table方法:根据Q - 学习更新公式更新Q表。

4. 数学模型和公式 & 详细讲解 & 举例说明

马尔可夫决策过程(MDP)

马尔可夫决策过程是强化学习的数学基础,它可以用一个五元组 (S,A,P,R,γ)(S,A,P,R,\gamma)(S,A,P,R,γ) 来表示:

- SSS:状态空间,是所有可能状态的集合。

- AAA:动作空间,是所有可能动作的集合。

- P(st+1∣st,at)P(s_{t + 1}|s_t,a_t)P(st+1∣st,at):状态转移概率,表示在状态 sts_tst 执行动作 ata_tat 后转移到状态 st+1s_{t + 1}st+1 的概率。

- R(st,at)R(s_t,a_t)R(st,at):奖励函数,表示在状态 sts_tst 执行动作 ata_tat 后获得的即时奖励。

- γ\gammaγ:折扣因子,取值范围为 [0,1][0,1][0,1],用于权衡即时奖励和未来奖励。

价值函数

状态价值函数 Vπ(s)V^\pi(s)Vπ(s)

状态价值函数 Vπ(s)V^\pi(s)Vπ(s) 表示在策略 π\piπ 下,从状态 sss 开始所能获得的期望累积奖励,定义为:

Vπ(s)=E[∑t=0∞γtR(st,at)∣s0=s,π]V^\pi(s)=E\left[\sum_{t = 0}^{\infty}\gamma^tR(s_t,a_t)|s_0 = s,\pi\right]Vπ(s)=E[t=0∑∞γtR(st,at)∣s0=s,π]

动作价值函数 Qπ(s,a)Q^\pi(s,a)Qπ(s,a)

动作价值函数 Qπ(s,a)Q^\pi(s,a)Qπ(s,a) 表示在策略 π\piπ 下,从状态 sss 执行动作 aaa 后所能获得的期望累积奖励,定义为:

Qπ(s,a)=E[∑t=0∞γtR(st,at)∣s0=s,a0=a,π]Q^\pi(s,a)=E\left[\sum_{t = 0}^{\infty}\gamma^tR(s_t,a_t)|s_0 = s,a_0 = a,\pi\right]Qπ(s,a)=E[t=0∑∞γtR(st,at)∣s0=s,a0=a,π]

最优价值函数

最优状态价值函数 V∗(s)V^*(s)V∗(s)

最优状态价值函数 V∗(s)V^*(s)V∗(s) 表示在所有可能策略下,从状态 sss 开始所能获得的最大期望累积奖励,即:

V∗(s)=maxπVπ(s)V^*(s)=\max_{\pi}V^\pi(s)V∗(s)=πmaxVπ(s)

最优动作价值函数 Q∗(s,a)Q^*(s,a)Q∗(s,a)

最优动作价值函数 Q∗(s,a)Q^*(s,a)Q∗(s,a) 表示在所有可能策略下,从状态 sss 执行动作 aaa 后所能获得的最大期望累积奖励,即:

Q∗(s,a)=maxπQπ(s,a)Q^*(s,a)=\max_{\pi}Q^\pi(s,a)Q∗(s,a)=πmaxQπ(s,a)

贝尔曼方程

状态价值函数的贝尔曼方程

对于状态价值函数 Vπ(s)V^\pi(s)Vπ(s),有贝尔曼方程:

Vπ(s)=∑a∈Aπ(a∣s)∑s′∈SP(s′∣s,a)[R(s,a)+γVπ(s′)]V^\pi(s)=\sum_{a\in A}\pi(a|s)\sum_{s'\in S}P(s'|s,a)\left[R(s,a)+\gamma V^\pi(s')\right]Vπ(s)=a∈A∑π(a∣s)s′∈S∑P(s′∣s,a)[R(s,a)+γVπ(s′)]

动作价值函数的贝尔曼方程

对于动作价值函数 Qπ(s,a)Q^\pi(s,a)Qπ(s,a),有贝尔曼方程:

Qπ(s,a)=∑s′∈SP(s′∣s,a)[R(s,a)+γ∑a′∈Aπ(a′∣s′)Qπ(s′,a′)]Q^\pi(s,a)=\sum_{s'\in S}P(s'|s,a)\left[R(s,a)+\gamma\sum_{a'\in A}\pi(a'|s')Q^\pi(s',a')\right]Qπ(s,a)=s′∈S∑P(s′∣s,a)[R(s,a)+γa′∈A∑π(a′∣s′)Qπ(s′,a′)]

最优动作价值函数的贝尔曼方程

对于最优动作价值函数 Q∗(s,a)Q^*(s,a)Q∗(s,a),有贝尔曼最优方程:

Q∗(s,a)=∑s′∈SP(s′∣s,a)[R(s,a)+γmaxa′Q∗(s′,a′)]Q^*(s,a)=\sum_{s'\in S}P(s'|s,a)\left[R(s,a)+\gamma\max_{a'}Q^*(s',a')\right]Q∗(s,a)=s′∈S∑P(s′∣s,a)[R(s,a)+γa′maxQ∗(s′,a′)]

举例说明

考虑一个简单的智能电网场景,假设有一个小型微电网,包含一个风力发电机和一个储能装置。状态 sss 可以表示为风力发电机的发电功率和储能装置的剩余电量,动作 aaa 可以表示为储能装置的充放电状态(充电、放电、不操作)。

- 状态空间:S={(Pw,SOC)∣Pw∈[0,Pwmax],SOC∈[0,1]}S=\{(P_w,SOC)|P_w\in[0,P_{w\max}],SOC\in[0,1]\}S={(Pw,SOC)∣Pw∈[0,Pwmax],SOC∈[0,1]},其中 PwP_wPw 是风力发电功率,SOCSOCSOC 是储能装置的荷电状态。

- 动作空间:A={−1,0,1}A=\{-1,0,1\}A={−1,0,1},其中 −1-1−1 表示放电,000 表示不操作,111 表示充电。

- 奖励函数:R(s,a)R(s,a)R(s,a) 可以设计为与系统的稳定性和经济性相关,例如,如果储能装置的充放电操作有助于平衡负荷和发电功率,减少电网的波动,则给予正奖励;如果操作导致电网不稳定或增加成本,则给予负奖励。

假设当前状态 st=(Pw,t,SOCt)s_t=(P_{w,t},SOC_t)st=(Pw,t,SOCt),选择动作 at=1a_t = 1at=1(充电),执行动作后转移到下一个状态 st+1=(Pw,t+1,SOCt+1)s_{t + 1}=(P_{w,t + 1},SOC_{t + 1})st+1=(Pw,t+1,SOCt+1),并获得奖励 rtr_trt。根据Q - 学习更新公式:

Q(st,at)←Q(st,at)+α[rt+γmaxaQ(st+1,a)−Q(st,at)]Q(s_t,a_t) \leftarrow Q(s_t,a_t)+\alpha\left[r_t + \gamma\max_{a}Q(s_{t + 1},a)-Q(s_t,a_t)\right]Q(st,at)←Q(st,at)+α[rt+γamaxQ(st+1,a)−Q(st,at)]

可以不断更新Q表,从而学习到最优策略。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

- Python环境:建议使用Python 3.7及以上版本,可以通过Anaconda或官方网站下载安装。

- 依赖库:需要安装

numpy、matplotlib等库,可以使用以下命令进行安装:

pip install numpy matplotlib

5.2 源代码详细实现和代码解读

import numpy as np

import matplotlib.pyplot as plt

# 定义智能电网环境类

class SmartGridEnv:

def __init__(self):

# 状态空间大小

self.state_size = 10

# 动作空间大小

self.action_size = 3

# 初始化状态

self.state = np.random.randint(0, self.state_size)

# 终止状态

self.goal_state = 9

def reset(self):

# 重置环境

self.state = np.random.randint(0, self.state_size)

return self.state

def step(self, action):

# 状态转移

if action == 0: # 向左移动

self.state = max(0, self.state - 1)

elif action == 1: # 不移动

self.state = self.state

elif action == 2: # 向右移动

self.state = min(self.state_size - 1, self.state + 1)

# 奖励设置

if self.state == self.goal_state:

reward = 10

done = True

else:

reward = -1

done = False

return self.state, reward, done

# 定义Q - 学习类

class QLearningAgent:

def __init__(self, state_size, action_size, learning_rate=0.1, discount_factor=0.9, epsilon=0.1):

self.state_size = state_size

self.action_size = action_size

self.learning_rate = learning_rate

self.discount_factor = discount_factor

self.epsilon = epsilon

# 初始化Q表

self.q_table = np.zeros((state_size, action_size))

def choose_action(self, state):

if np.random.uniform(0, 1) < self.epsilon:

# 随机选择动作

action = np.random.choice(self.action_size)

else:

# 选择Q值最大的动作

action = np.argmax(self.q_table[state, :])

return action

def update_q_table(self, state, action, reward, next_state):

# Q - 学习更新公式

target = reward + self.discount_factor * np.max(self.q_table[next_state, :])

self.q_table[state, action] = (1 - self.learning_rate) * self.q_table[state, action] + self.learning_rate * target

# 主函数

def main():

# 创建智能电网环境

env = SmartGridEnv()

# 创建Q - 学习代理

agent = QLearningAgent(env.state_size, env.action_size)

# 训练参数

num_episodes = 1000

rewards = []

for episode in range(num_episodes):

state = env.reset()

total_reward = 0

done = False

while not done:

# 选择动作

action = agent.choose_action(state)

# 执行动作

next_state, reward, done = env.step(action)

# 更新Q表

agent.update_q_table(state, action, reward, next_state)

# 更新状态

state = next_state

total_reward += reward

rewards.append(total_reward)

if episode % 100 == 0:

print(f"Episode {episode}: Total Reward = {total_reward}")

# 绘制奖励曲线

plt.plot(rewards)

plt.xlabel('Episode')

plt.ylabel('Total Reward')

plt.title('Q - Learning in Smart Grid Management')

plt.show()

if __name__ == "__main__":

main()

5.3 代码解读与分析

- SmartGridEnv类:模拟智能电网环境,包括状态空间、动作空间、状态转移和奖励设置。

reset方法用于重置环境状态,step方法用于执行动作并返回下一个状态、奖励和是否终止的信息。 - QLearningAgent类:实现Q - 学习算法,包括选择动作和更新Q表的方法。

- main函数:主函数,创建智能电网环境和Q - 学习代理,进行训练,并绘制奖励曲线。

通过训练,Q - 学习代理可以学习到在不同状态下选择最优动作的策略,从而最大化累积奖励。从奖励曲线可以观察到,随着训练的进行,代理获得的总奖励逐渐增加,说明代理在不断学习和优化策略。

6. 实际应用场景

发电调度

在智能电网中,存在多种发电方式,如火力发电、水力发电、风力发电和太阳能发电等。不同发电方式的成本、效率和可靠性不同,且可再生能源发电具有间歇性和不确定性。AI Agent的强化学习可以根据实时的发电功率、负荷需求、电价等信息,动态调整发电设备的出力,实现发电资源的最优分配,降低发电成本,提高能源利用效率。

储能管理

储能装置在智能电网中起着重要的作用,它可以平衡发电和负荷之间的差异,提高电网的稳定性。AI Agent的强化学习可以根据储能装置的荷电状态、预测的发电和负荷情况,决定储能装置的充放电策略,以最大化储能装置的使用寿命和经济效益。

需求响应

需求响应是指通过激励用户调整用电行为,以实现电网的供需平衡。AI Agent的强化学习可以根据实时电价、用户的用电习惯和设备状态,向用户推荐合适的用电策略,如调整用电时间、降低用电功率等,从而减少电网的峰谷差,提高电网的运行效率。

电网故障诊断与恢复

当电网发生故障时,需要快速准确地诊断故障位置和类型,并采取相应的恢复措施。AI Agent的强化学习可以通过学习历史故障数据和电网的实时状态,快速做出故障诊断和恢复决策,减少故障对电网的影响,提高电网的可靠性。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《Reinforcement Learning: An Introduction》(《强化学习:原理与Python实现》):由Richard S. Sutton和Andrew G. Barto所著,是强化学习领域的经典教材,全面介绍了强化学习的基本概念、算法和应用。

- 《Deep Reinforcement Learning Hands-On》(《深度强化学习实战》):由Max Lapan所著,结合实际案例详细介绍了深度强化学习的算法和实现,适合有一定编程基础的读者。

- 《Power System Analysis and Design》(《电力系统分析与设计》):由J. Duncan Glover、Mulukutla S. Sarma和Thomas J. Overbye所著,是电力系统领域的经典教材,介绍了电力系统的基本原理、分析方法和设计技术。

7.1.2 在线课程

- Coursera上的“Reinforcement Learning Specialization”:由University of Alberta提供,系统地介绍了强化学习的理论和实践。

- edX上的“Artificial Intelligence for Robotics”:由UC Berkeley提供,结合机器人领域介绍了强化学习的应用。

- 中国大学MOOC上的“电力系统分析”:由多所高校联合提供,介绍了电力系统的基本概念、分析方法和运行控制。

7.1.3 技术博客和网站

- OpenAI官方博客:提供了强化学习领域的最新研究成果和应用案例。

- Towards Data Science:发布了大量关于机器学习和强化学习的技术文章。

- IEEE Xplore:包含了电力系统和人工智能领域的大量学术论文和研究报告。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:一款专业的Python集成开发环境,提供了丰富的代码编辑、调试和部署功能。

- Jupyter Notebook:一种交互式的编程环境,适合进行数据探索、模型训练和可视化。

- Visual Studio Code:一款轻量级的代码编辑器,支持多种编程语言和插件扩展。

7.2.2 调试和性能分析工具

- TensorBoard:TensorFlow提供的可视化工具,可以用于监控模型的训练过程和性能指标。

- PyTorch Profiler:PyTorch提供的性能分析工具,可以帮助用户找出代码中的性能瓶颈。

- cProfile:Python标准库中的性能分析模块,可以分析代码的执行时间和调用关系。

7.2.3 相关框架和库

- OpenAI Gym:一个用于开发和比较强化学习算法的工具包,提供了多种环境和基准测试。

- Stable Baselines:基于OpenAI Gym的强化学习库,提供了多种预训练的强化学习算法和模型。

- TensorFlow和PyTorch:深度学习框架,可用于实现深度强化学习算法。

7.3 相关论文著作推荐

7.3.1 经典论文

- “Playing Atari with Deep Reinforcement Learning”:由DeepMind团队发表,提出了深度Q网络(DQN)算法,开启了深度强化学习的时代。

- “Policy Gradient Methods for Reinforcement Learning with Function Approximation”:由Richard S. Sutton等人发表,介绍了策略梯度算法的基本原理和应用。

- “Model Predictive Control for Power Systems: A Tutorial”:介绍了模型预测控制在电力系统中的应用,为智能电网管理提供了一种有效的方法。

7.3.2 最新研究成果

- 关注IEEE Transactions on Power Systems、IEEE Transactions on Smart Grid等顶级期刊,了解AI Agent的强化学习在智能电网管理中的最新研究进展。

- 参加国际会议,如Power Systems Computation Conference (PSCC)、IEEE Power & Energy Society General Meeting等,获取最新的学术成果和行业动态。

7.3.3 应用案例分析

- 研究一些实际的智能电网项目案例,了解AI Agent的强化学习在发电调度、储能管理、需求响应等方面的具体应用和效果。可以通过查阅相关的技术报告、行业白皮书和学术论文来获取这些案例信息。

8. 总结:未来发展趋势与挑战

未来发展趋势

- 多智能体强化学习:在智能电网中,存在多个不同的智能体,如发电企业、电网运营商、用户等。多智能体强化学习可以实现多个智能体之间的协作和竞争,从而更好地优化电网的运行。

- 深度强化学习与其他技术的融合:将深度强化学习与深度学习、优化理论、控制理论等技术相结合,可以提高智能电网管理的性能和效率。例如,结合深度学习的图像识别技术,可以实现对电网设备的故障诊断和预测。

- 边缘计算与强化学习:随着边缘计算技术的发展,将强化学习算法部署在边缘设备上,可以实现实时的决策和控制,减少数据传输延迟,提高电网的响应速度和可靠性。

- 与能源互联网的融合:能源互联网是未来能源发展的方向,将AI Agent的强化学习应用于能源互联网中,可以实现能源的跨区域、跨行业的优化配置和协同运行。

挑战

- 数据质量和安全:智能电网中产生的大量数据是强化学习的基础,但数据的质量和安全问题可能会影响算法的性能和可靠性。例如,数据的缺失、错误和噪声可能会导致模型的训练不准确,而数据的泄露和篡改可能会威胁到电网的安全运行。

- 模型可解释性:深度强化学习模型通常是黑盒模型,其决策过程难以解释。在智能电网管理中,需要对模型的决策进行解释和验证,以确保决策的合理性和安全性。

- 计算资源和时间成本:深度强化学习算法通常需要大量的计算资源和时间来进行训练。在实际应用中,需要考虑如何在有限的计算资源和时间内实现高效的训练和决策。

- 环境不确定性:智能电网的环境具有高度的不确定性,如可再生能源的间歇性、负荷需求的波动等。如何使强化学习算法能够适应这种不确定性,是一个亟待解决的问题。

9. 附录:常见问题与解答

1. 什么是AI Agent的强化学习?

AI Agent的强化学习是一种人工智能技术,通过智能体与环境的交互,根据环境反馈的奖励信号来学习最优策略。智能体在每个时间步观察环境的状态,选择一个动作执行,环境根据动作更新状态并给予奖励,智能体的目标是最大化长期累积奖励。

2. 强化学习在智能电网管理中有哪些优势?

强化学习在智能电网管理中的优势包括:

- 能够适应电网环境的动态变化,实时做出优化决策。

- 可以处理复杂的多目标优化问题,如发电成本最小化、电网稳定性最大化等。

- 无需精确的数学模型,通过与环境的交互自动学习最优策略。

3. 如何选择合适的强化学习算法?

选择合适的强化学习算法需要考虑以下因素:

- 问题的复杂度:如果问题比较简单,可以选择传统的强化学习算法,如Q - 学习;如果问题比较复杂,可以考虑使用深度强化学习算法,如DQN、A2C等。

- 数据的可用性:如果有大量的数据,可以使用基于模型的强化学习算法;如果数据有限,可以使用无模型的强化学习算法。

- 计算资源:深度强化学习算法通常需要大量的计算资源,如果计算资源有限,可以选择简单的算法。

4. 强化学习在智能电网管理中的应用面临哪些挑战?

强化学习在智能电网管理中的应用面临的挑战包括数据质量和安全、模型可解释性、计算资源和时间成本、环境不确定性等问题。

5. 如何评估强化学习算法在智能电网管理中的性能?

可以从以下几个方面评估强化学习算法在智能电网管理中的性能:

- 累积奖励:衡量智能体在整个训练过程中获得的总奖励,累积奖励越高,说明算法的性能越好。

- 收敛速度:算法收敛到最优策略的速度,收敛速度越快,说明算法的效率越高。

- 稳定性:算法在不同环境和条件下的稳定性,稳定性越好,说明算法的可靠性越高。

10. 扩展阅读 & 参考资料

扩展阅读

- 《Artificial Intelligence: A Modern Approach》(《人工智能:一种现代的方法》):全面介绍了人工智能的各个领域,包括强化学习、机器学习、自然语言处理等。

- 《Power System Operation and Control》(《电力系统运行与控制》):深入介绍了电力系统的运行和控制原理,包括发电调度、负荷频率控制、电压控制等。

- 《Deep Learning》(《深度学习》):由Ian Goodfellow、Yoshua Bengio和Aaron Courville所著,是深度学习领域的经典教材,介绍了深度学习的基本原理、算法和应用。

参考资料

- Sutton, R. S., & Barto, A. G. (2018). Reinforcement Learning: An Introduction. MIT Press.

- Lapan, M. (2018). Deep Reinforcement Learning Hands-On. Packt Publishing.

- Glover, J. D., Sarma, M. S., & Overbye, T. J. (2012). Power System Analysis and Design. Cengage Learning.

- Mnih, V., Kavukcuoglu, K., Silver, D., et al. (2013). Playing Atari with Deep Reinforcement Learning. arXiv preprint arXiv:1312.5602.

- Sutton, R. S., McAllester, D. A., Singh, S. P., & Mansour, Y. (2000). Policy Gradient Methods for Reinforcement Learning with Function Approximation. Advances in neural information processing systems.

- Rawlings, J. B., & Mayne, D. Q. (2009). Model Predictive Control: Theory and Design. Nob Hill Publishing.

更多推荐

已为社区贡献64条内容

已为社区贡献64条内容

所有评论(0)