Chapter3:语言模型基础 Part 8:动手实战——本地部署开源大模型

本文介绍了如何在本地私有化部署开源大语言模型,重点讲解了使用Hugging Face Transformers库加载和运行Qwen1.5-0.5B-Chat模型的方法。内容包括环境配置、模型加载、对话输入准备以及生成回答的全流程。此外,文章还分析了模型选型的8个关键考量因素,对比了主流闭源模型(如GPT、Gemini、Claude)和开源模型(如Llama、Mistral、Qwen)的特点和适用场

基于Datawhale的hello-agent开源项目做的一些笔记,内容仅供参考,原PDF以及代码可以去github仓库获取https://datawhalechina.github.io/hello-agents

在上一篇中,我们深入了解了分词器是如何将文本转化为数字的。

到现在为止,我们已经掌握了理论,也通过 API 体验了云端大模型。但在处理敏感数据、需要离线运行或精细控制成本的场景下,将大模型私有化部署到本地电脑是 Agent 开发者的必备技能。

本篇将带你动手,使用 Hugging Face 库在自己的电脑上运行一个真实的开源大模型。

3.2.3 调用开源大语言模型

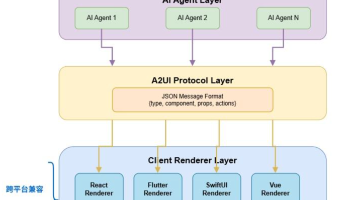

在第一章中,我们通过 API 来驱动智能体。这是一种快速、便捷的方式,但并非唯一。对于许多企业级应用,将大语言模型直接部署在本地就显得至关重要 。

我们将使用 Hugging Face Transformers,这是一个强大的开源库,提供了标准化的接口来加载和使用数以万计的预训练模型 。

1. 环境配置与模型选择

为了让大多数读者都能在个人电脑上顺利运行,我们特意选择了一个小规模但功能强大的模型:Qwen/Qwen1.5-0.5B-Chat。

- 出品方:阿里巴巴达摩院

- 参数量:约 5 亿 (0.5B)

- 特点:体积小、性能优异,非常适合入门学习和本地部署 。

首先,请确保你已经安装了必要的库 :

pip install transformers torch

2. 加载模型与分词器

在 transformers 库中,我们通常使用两个核心类 :

AutoModelForCausalLM:自动加载与模型匹配的因果语言模型权重。AutoTokenizer:自动加载对应的分词器。

以下代码会自动从 Hugging Face Hub 下载所需文件(取决于网速,可能需要一些时间):

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

# 指定模型 ID

model_id = "Qwen/Qwen1.5-0.5B-Chat"

# 设置设备,优先使用 GPU (CUDA),否则使用 CPU

device = "cuda" if torch.cuda.is_available() else "cpu"

print(f"Using device: {device}")

# 加载分词器

tokenizer = AutoTokenizer.from_pretrained(model_id)

# 加载模型,并将其移动到指定设备

model = AutoModelForCausalLM.from_pretrained(model_id).to(device)

print("模型和分词器加载完成!")

3. 准备对话输入

Qwen1.5-Chat 模型遵循特定的对话模板。我们需要构建一个包含 system(系统设定)和 user(用户指令)的消息列表,然后使用分词器的 apply_chat_template 方法将其格式化。

# 准备对话输入

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "你好,请介绍你自己。"}

]

# 使用分词器的模板格式化输入

# tokenize=False 表示我们先只获取格式化后的文本字符串,方便观察

# add_generation_prompt=True 表示添加模型开始生成的引导符

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

# 编码输入文本,转换为 Tensor 并移动到设备

model_inputs = tokenizer([text], return_tensors="pt").to(device)

print("编码后的输入文本 (Token IDs):")

print(model_inputs)

💡 注解:

apply_chat_template是 Hugging Face 新版极其重要的功能。不同模型(Llama, Qwen, Mistral)对对话格式的要求(如[INST],<|im_start|>等特殊标记)各不相同。这个函数能自动适配,帮你省去了手动拼接字符串的繁琐和易错风险。

4. 生成与解码

现在,我们可以调用模型的 generate() 方法来生成回答了。最后,使用 batch_decode 将生成的数字 ID 翻译回人类可读的文本。

# 使用模型生成回答

# max_new_tokens 控制了模型最多能生成多少个新的 Token

generated_ids = model.generate(

model_inputs.input_ids,

max_new_tokens=512

)

# 将生成的 Token ID 截取掉输入部分

# 这样我们只解码模型新生成的部分,不包含我们发给它的问题

generated_ids = [

output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)

]

# 解码生成的 Token ID

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

print("\n模型的回答:")

print(response)

预期输出(示例):

我叫通义千问,是由阿里云研发的预训练语言模型…

恭喜!你已经成功在本地运行了一个大模型。这意味着你拥有了一个完全受控、隐私安全且无 API 调用成本的智能大脑。

现在又引出了一个关键问题:市面上有成百上千个模型(GPT-4, Llama 3, Claude 3…),我们该如何为自己的智能体选择最合适的那一个?

3.2.4 模型的选择

选择语言模型并非简单地追求“最大、最强”,而是一个在性能、成本、速度和部署方式之间进行权衡的决策过程。

3.2.4.1 模型选型的 8 个关键考量

在做决定时,请对着这份清单进行评估 :

- 性能与能力:最核心的考量。擅长逻辑推理?还是创意写作?参考公开榜单(如 LMSys Chatbot Arena)。

- 成本:

- 闭源:API 调用费(按 Token 计)。

- 开源:硬件成本(GPU 显存)和运维成本。

- 速度 (延迟):实时交互(如游戏 NPC、语音助手)需要极低的延迟。轻量级模型(如 Claude 3.5 Sonnet, GPT-3.5)通常表现更优。

- 上下文窗口:处理长文档或代码库需要大窗口(如 128K Token)。

- 部署方式:API 简单但涉及数据隐私;本地部署安全但技术门槛高。

- 生态与工具链:流行模型(如 Llama)拥有更丰富的微调工具和社区支持(LangChain, Hugging Face)。

- 可微调性:开源模型允许你使用私有数据进行定制化训练,这对特定领域任务至关重要。

- 安全性与伦理:面向公众的应用需考虑模型的偏见、毒性和幻觉风险。

3.2.4.2 闭源模型概览

闭源模型通常代表业界最强性能,提供“开箱即用”的 API 服务 。

-

OpenAI GPT 系列:

-

GPT-4/5:行业标杆,多模态能力最强,适合复杂推理任务。

-

Google Gemini 系列:

-

原生多模态:统一处理文本、代码、音视频。

-

Gemini 1.5/2.5 Pro:以超长上下文(1M+ Token)和处理海量信息见长。

-

Anthropic Claude 系列:

-

特点:主打AI 安全和长文档处理,减少有害输出,深受企业青睐。

-

型号:Opus(最强)、Sonnet(平衡)、Haiku(极速)。

-

国内主流:百度文心一言、腾讯混元、华为盘古、月之暗面 (Moonshot) 等,中文能力具备天然优势。

3.2.4.3 开源模型概览

开源模型赋予开发者最高程度的灵活性、透明度和自主权 。

-

Meta Llama 系列:开源界的基石。

-

Llama 4 (2025年4月发布):首批采用混合专家 (MoE) 架构。包含 Scout (移动端)、Maverick (多模态/编码)、Behemoth (超强 STEM 能力) 三个版本。

-

Mistral AI 系列:法国团队,主打“小尺寸、高性能”。

-

Mistral Medium 3.1 (2025年8月发布):原生多模态,内置“语调适配层”,基准测试表现优异。

-

国内开源力量:

-

Qwen (通义千问):阿里巴巴开源,中文能力极强,社区活跃。

-

ChatGLM:清华 & 智谱 AI,早期开源领跑者,适合消费级显卡部署。

💡 选型总结:

- 闭源模型提供了开箱即用的便捷,适合快速验证和追求极致性能。

- 开源模型赋予了随心所欲的定制自由,适合数据敏感、成本控制或需要深度改造的场景。

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)