Chapter3: 大语言模型基础 Part 9:能力的边界——缩放法则与模型幻觉

大语言模型的发展揭示了模型性能与参数量、数据量和计算资源之间的幂律关系(缩放法则)。研究发现模型规模达到阈值后会出现能力涌现现象,但也面临幻觉问题(生成错误或矛盾内容)。为解决这一问题,可采用检索增强生成(RAG)、多步推理验证和外部工具调用等方法。这些理论为智能体设计奠定了基础,下一阶段将转向实践应用。

本文是基于Datawhale的hello-agent开源项目做的一些笔记,内容仅供参考,原PDF以及代码可以去github仓库获取https://datawhalechina.github.io/hello-agents

在掌握了模型的原理、交互、分词和部署后,我们终于来到了理论层面的最后一站。

为什么现在的模型越来越大?为什么它们有时候会突然“开窍”学会推理,有时候又会一本正经地胡说八道?本篇将深入探讨支配大模型能力的缩放法则 (Scaling Laws) 以及它们目前最大的软肋——幻觉 (Hallucination)。

3.3 大语言模型的缩放法则与局限性

大语言模型 (LLMs) 在近年来取得了令人瞩目的进展。这些成就的背后,离不开对模型规模、数据量和计算资源之间关系的深刻理解。

3.3.1 缩放法则 (Scaling Laws)

缩放法则是近年来 LLM 领域最重要的发现之一。它揭示了模型性能与三个核心要素之间存在着可预测的幂律关系 (Power Law) :

- 模型参数量 (Parameters)

- 训练数据量 (Data)

- 计算资源 (Compute)

简单来说,只要我们持续、按比例地增加这三个要素,模型的性能(通常用 Loss 衡量)就会平滑地提升,而不会出现明显的瓶颈 。

关键修正:Chinchilla 定律

早期的研究盲目追求“越大越好”(增加参数量)。但 DeepMind 在 2022 年提出的 Chinchilla 定律 纠正了这一认知 。

该定律指出,在给定的计算预算下,为了达到最优性能,模型参数量和训练数据量之间存在一个最优配比。

- 结论:最优的模型应该比之前认为的要小,但需要用多得多的数据进行训练。

- 影响:这一发现指导了后来的 Llama 等模型的设计——使用相对较小的参数量(如 7B, 70B)配合海量的高质量数据(Trillions of tokens),从而实现更高效的推理。

能力的涌现 (Emergent Abilities)

缩放法则最令人惊奇的产物是“能力的涌现”。

所谓涌现,是指当模型规模达到一定阈值(通常是数百亿参数)后,会突然展现出在小规模模型中完全不存在或表现不佳的全新能力 。

- 例子:链式思考 (CoT)、指令遵循 (Instruction Following)、多步推理、代码生成。

💡 注解:

对于智能体开发者而言,涌现意味着选择一个足够大规模的模型(通常至少 7B 或 13B 以上),是实现复杂自主决策和规划能力的前提。小模型可能能聊得很好,但在逻辑规划上往往力不从心。

3.3.2 模型幻觉 (Model Hallucination)

尽管模型越来越强,但它有一个致命的缺陷:幻觉。

模型幻觉通常指的是大语言模型生成的内容与客观事实、用户输入或上下文不一致,简而言之,就是一本正经地胡说八道 。

幻觉的类型

- 事实性幻觉 (Factual Hallucinations):生成与现实世界事实不符的信息。

- 例:告诉你是爱因斯坦发明了互联网 。

- 忠实性幻觉 (Faithfulness Hallucinations):在摘要或翻译时,未忠实反映源文本。

- 内在幻觉 (Intrinsic Hallucinations):生成的内容与前面的输入直接矛盾 。

为什么会产生幻觉?

幻觉的本质是模型过度自信地“编造”了概率最高的词,而非准确地检索。

- 数据源头:训练数据本身包含错误或偏见。

- 机制缺陷:自回归生成机制只预测下一个词,没有内置的“事实核查”模块。

- 知识过时:模型的知识截止于训练数据收集的那一天,无法回答最新的问题 。

解决方案:如何缓解幻觉?

为了构建可靠的智能体,我们需要通过外部手段来弥补模型的不足 :

- 检索增强生成 (RAG):

- 这是目前最有效的方法。在生成回答前,先从外部知识库检索相关信息,作为上下文喂给模型。

- 作用:让模型“开卷考试”,基于事实回答。

- 多步推理与验证:

- 引导模型进行 CoT 推理,并要求它在每一步进行自我检查。

- 引入外部工具:

- 允许模型调用搜索引擎(获取实时信息)、计算器(精确计算)或代码解释器。

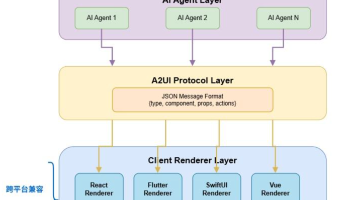

- 作用:这就是 Agent 的核心思想——用工具弥补模型能力的短板。

3.4 本章小结

本章介绍了构建智能体所需的基础知识,重点围绕作为其核心组件的大语言模型 (LLM) 展开。

核心知识点回顾

- 模型演进:

- 从 N-gram 统计模型到词嵌入。

- 从 RNN/LSTM 的循环记忆到 Transformer 的并行注意力机制。

- 详细拆解了 Transformer 的 Encoder-Decoder 架构及 Decoder-Only (GPT) 范式。

- 交互与实践:

- 提示工程:掌握了 Zero-shot, Few-shot, CoT 等激发模型潜能的技巧。

- 分词 (Tokenization):理解了 BPE 算法及 Token 对上下文窗口和成本的影响。

- 本地部署:利用 Hugging Face 在本地运行了开源模型 Qwen。

- 生态与局限:

- 模型选型:对比了闭源 (GPT-4, Claude 3) 与开源 (Llama, Mistral) 模型的优劣。

- 缩放与幻觉:理解了数据与计算量的缩放法则,并认识到通过 RAG 和工具调用来解决幻觉问题的必要性。

下一步:从 LLM 到 Agent

这一章的学习主要是为了帮助大家更好地理解“大脑”是如何运作的。我们明白了:

- 为什么需要 Prompt Engineering? -> 因为模型本质是概率预测,需要引导。

- 为什么 Agent 需要工具? -> 因为模型有幻觉,且无法获取实时信息。

- 为什么 Agent 需要记忆? -> 因为模型的上下文窗口有限,且没有长期记忆能力。

现在,我们已经准备好从理论转向实践。在下一章,我们将正式探索 智能体经典范式构建,将本章所学的知识应用于实际的智能体设计之中 。

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)