大模型训练成本太高?MoE技术揭秘,小团队也能轻松玩转大模型!

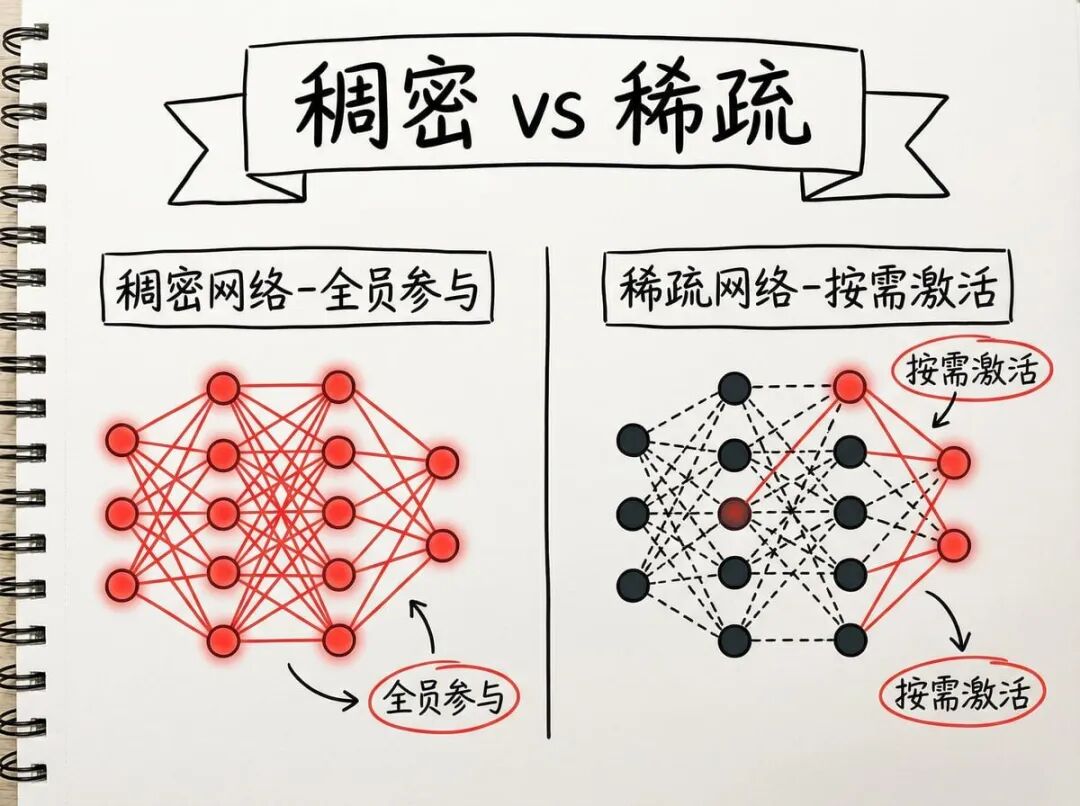

MoE(混合专家模型)技术通过将模型切分为多个"专家"网络,实现稀疏激活和按需计算,大幅降低大模型训练成本。相比传统稠密网络全员参与的低效模式,MoE的路由器机制只激活最相关的专家处理特定任务,避免了资源浪费。尽管面临马太效应、显存需求等挑战,MoE仍代表着AI行业降低研究门槛、让小团队参与大模型研发的重要方向,是未来最具潜力的技术路线之一。

简介

MoE(混合专家模型)技术通过将模型切分为多个"专家"网络,实现稀疏激活和按需计算,大幅降低大模型训练成本。相比传统稠密网络全员参与的低效模式,MoE的路由器机制只激活最相关的专家处理特定任务,避免了资源浪费。尽管面临马太效应、显存需求等挑战,MoE仍代表着AI行业降低研究门槛、让小团队参与大模型研发的重要方向,是未来最具潜力的技术路线之一。

当大模型训练成本高到让人绝望,这个技术悄悄改变了游戏规则

2025年的AI圈,有一个扎心的事实:训练一个大模型,可能需要上亿美元的成本。海量的参数、天文数字般的训练数据、成千上万张高端显卡……这些门槛,让无数小团队只能望"模"兴叹。

但如果我告诉你,有一种技术能让模型在保持强大性能的同时,大幅降低计算成本,你会不会觉得这是天方夜谭?

这就是我们今天要聊的MoE(Mixture of Experts,混合专家模型)——一个正在重塑AI行业的关键技术。从DeepSeek V3到Switch Transformer,几乎所有最新的顶级模型都在用它。

稠密网络的困境:全员加班的低效组织

要理解MoE的革命性,我们得先搞清楚传统模型是怎么工作的。

想象一家公司,无论接到什么业务——修电脑、写文案、设计海报——所有员工都必须参与讨论,哪怕你是个修电脑的,也得对海报设计发表意见。这种"全员参与"的模式,就是稠密网络的工作方式。

在GPT-3、Llama 2这类传统大模型中,每当输入一个词(token),模型的所有神经元都会被激活,参与计算。你输入一个简单的"你好",1750亿个参数全部运转;你输入一段复杂代码,还是这1750亿个参数在干活。

这种模式的问题显而易见:资源浪费严重,算力成本居高不下。就像开会时,明明只需要技术部门解决问题,却非要拉上财务、行政、后勤一起讨论。

MoE的智慧:把专业的事交给专业的人

MoE提出了一个颠覆性的思路:既然不是所有神经元都需要参与每次计算,为什么不按需分配?

这就是稀疏激活的核心理念。MoE把模型切分成多个"专家"(Experts),每个专家本质上就是一个独立的小型神经网络。当数据进来时,系统只激活最相关的几个专家,其他专家保持休眠状态,不消耗算力。

回到公司的比喻:现在你接到修电脑的需求,系统会自动把任务分配给IT部门的两个技术专家,其他部门该干嘛干嘛。效率提升,成本下降,皆大欢喜。

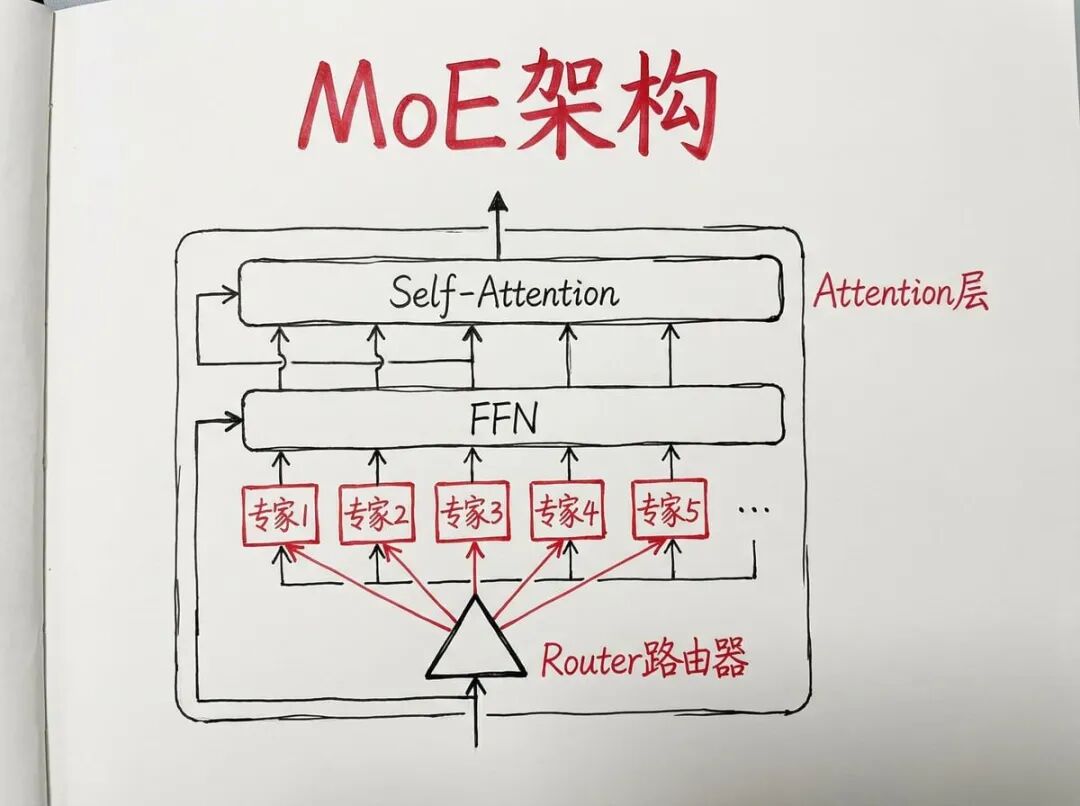

有意思的是,MoE并没有对Transformer的注意力机制(Attention)做任何改动,而是专门替换了前馈神经网络(FFN)部分。原本单一的FFN层,被拆分成多个并行的"专家FFN",每个专家各司其职。

路由器:模型的"交通指挥官"

那么问题来了:谁来决定激活哪些专家?

这就需要**路由器(Router)**出场了。它就像一个交通指挥官,负责分析每个输入的token,计算它与各个专家的"匹配度",然后选出最合适的几位专家来处理。

这个选择过程使用的是Top-K策略。假设模型有8个专家,路由器会计算token与每个专家的匹配分数(通常是Softmax输出),然后挑选分数最高的K个专家(比如K=2),让这两个专家参与计算,其他6个专家的权重直接归零。

最终的输出结果,是这K个被激活的专家输出的加权组合——权重越高的专家,对最终结果的影响越大。

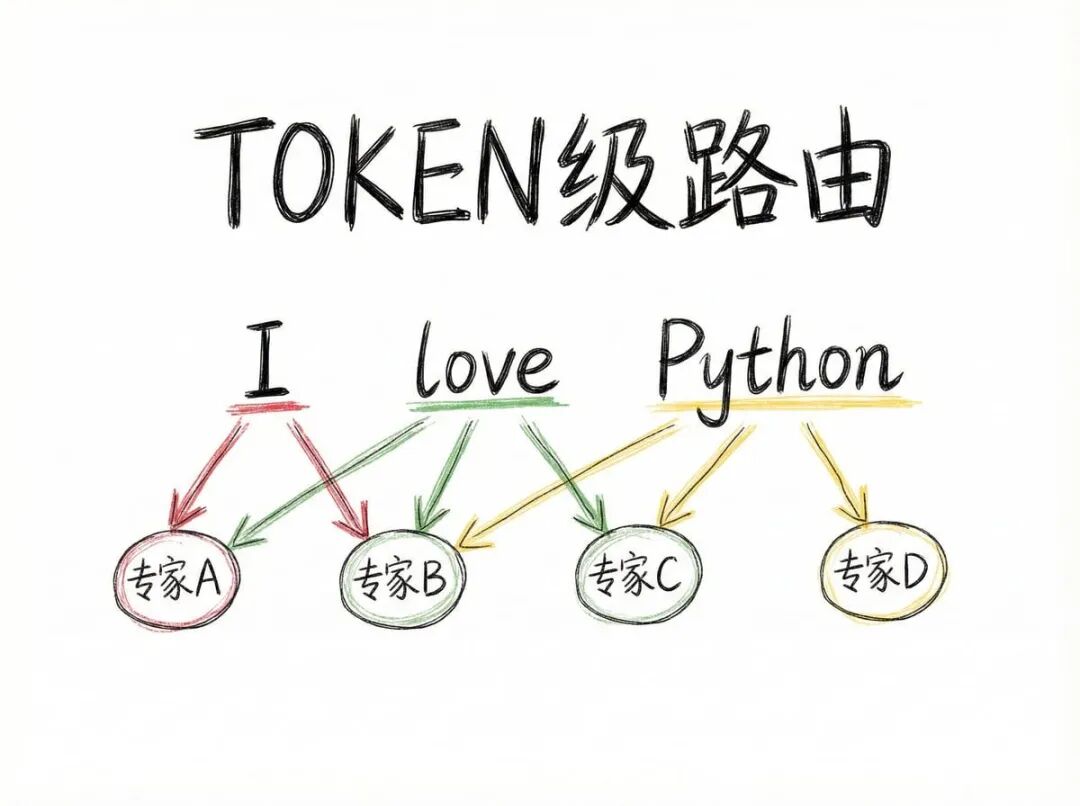

Token级路由:颠覆你对"专家"的认知

这里有个容易被误解的关键点:MoE的"专家"并不是按领域划分的。

你可能会想:专家A负责代码,专家B负责文学创作,专家C负责多语言翻译……但实际上,MoE的路由是在token级别进行的,而不是句子级别,更不是领域级别。

举个例子:当你输入"I love Python"这句话时:

- "I"可能被分配给专家A和B

- "love"可能被分配给专家B和C

- "Python"可能被分配给专家C和D

同一个句子的不同token,可能会激活完全不同的专家组合。这种设计赋予了模型极高的灵活性,让不同专家可以在生成同一句话的过程中无缝协作。

这就像一个交响乐团,不同乐器(专家)在不同的小节(token)发挥作用,最终合奏出美妙的乐章。

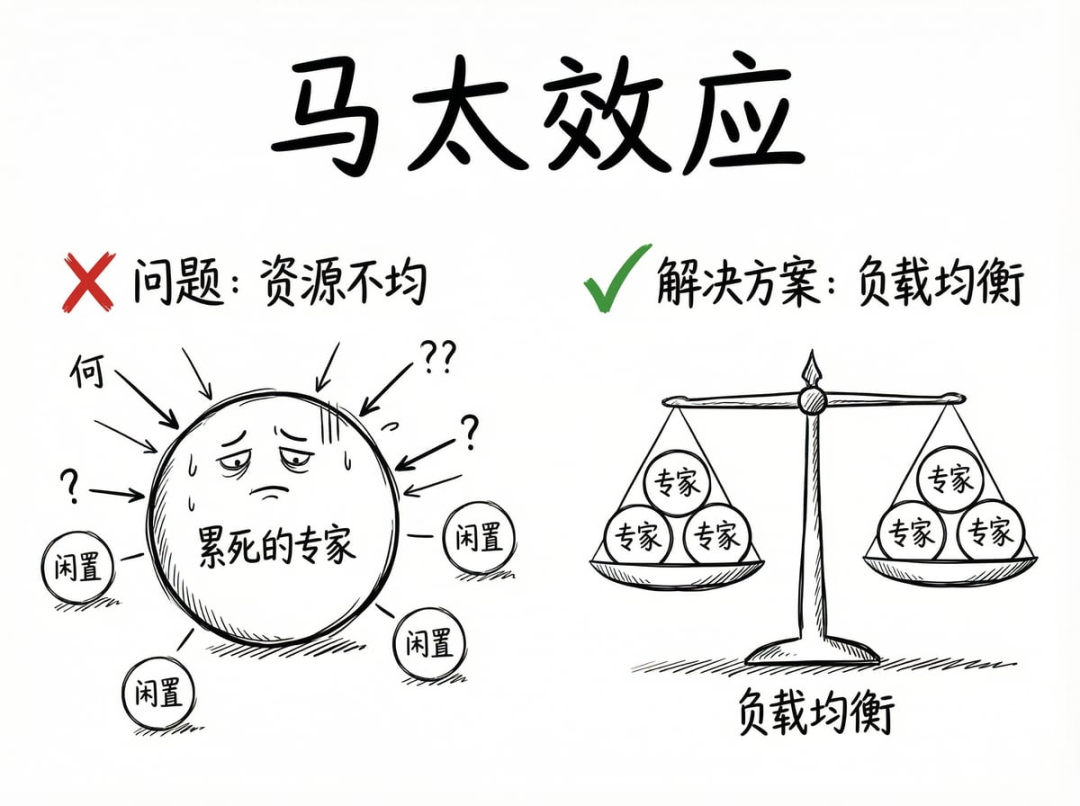

训练陷阱:当"马太效应"遇上AI

理论上,MoE的设计堪称完美。但现实总是比理想骨感——在实际训练中,研究人员很快发现了一个致命问题:马太效应。

什么意思?在训练初期,所有专家的参数都是随机初始化的。某个专家可能因为运气好,处理了几个数据后权重更新得稍微好一点点。路由器发现这个专家"靠谱"(激活它后loss下降更快),就会把后续更多的任务分配给它。

这个专家接收到的数据越多,训练越充分,表现就越好;表现越好,路由器就越偏爱它……形成正向反馈循环。

最终结果是:一个专家累死,其他专家闲死。模型退化成了一个小型稠密网络,MoE的优势荡然无存。

解决方案是引入负载均衡损失函数。简单说,就是在训练时增加一个惩罚项:如果路由器给某些专家分配的任务过多,模型的总损失就会增加,迫使路由器"雨露均沾",给每个专家大致相同的任务量(理想情况是每个专家分到1/N的任务)。

这就像公司管理:虽然某个员工能力强,但不能让他一个人干所有活,否则其他人永远成长不起来,团队最终会失去竞争力。

MoE的现实挑战:不是所有问题都解决了

尽管MoE在理论上大幅降低了计算成本,但工程实践中仍有几个硬骨头:

1. 显存容量的巨大需求

虽然推理时只激活部分专家(比如13B参数),但所有专家(比如47B参数)都必须加载到显存中。这意味着MoE模型对显卡的显存容量要求极高,普通显卡根本跑不动。

2. 多GPU通信开销

在多卡训练或推理时,不同专家通常分布在不同显卡上。如果一个token在GPU 1上,但路由器把它分配给了GPU 2上的专家,就需要跨卡数据传输,带来额外延迟。

3. Token丢弃问题

如果某个专家的"任务队列"满了,新来的token可能会被直接丢弃,导致性能下降。设计无丢弃的路由算法,是当前研究的重要方向。

未来在哪:MoE的进化方向

尽管存在挑战,MoE依然是最具潜力的技术路线之一。业界正在几个方向上探索突破:

细粒度专家:传统MoE可能只有8个大专家,而DeepSeek V3将专家数量扩展到64甚至128个,让知识切分更精细,专业度更高,组合更灵活。

**共享专家模式:**像语法、基础逻辑这类通用知识,每个专家都学一遍太浪费参数。DeepSeek提出设置一个"共享专家",总是被激活处理通用知识,其他路由专家只负责特定领域。这就像教育体系:大家都要学义务教育阶段的通识课程,到了大学研究生阶段再分专业深造。

**更智能的路由算法:**如何避免token丢弃?如何让专家动态调整负载?如何优化跨GPU通信?这些都是未来的优化空间。

写在最后:这是小团队的春天

MoE技术的意义,远不止是一个架构创新。它真正的价值在于:降低了AI研究的门槛,让更多小团队有机会参与到大模型的研发中。

当训练成本不再是天文数字,当算力不再是唯一的护城河,创意、算法创新、工程优化将变得更加重要。这对整个AI行业来说,是一件好事。

如果你是研究者,MoE的每个优化方向都值得深入探索;如果你是工程师,理解MoE的底层逻辑会让你更好地使用这些模型;如果你是创业者,MoE降低的成本可能就是你的机会窗口。

2025年才刚开始,MoE的故事还远未结束。下一个突破,或许就在你手中。

最后唠两句

为什么AI大模型成为越来越多程序员转行就业、升职加薪的首选

很简单,这些岗位缺人且高薪

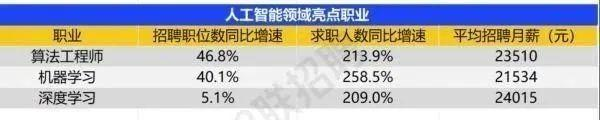

智联招聘的最新数据给出了最直观的印证:2025年2月,AI领域求职人数同比增幅突破200% ,远超其他行业平均水平;整个人工智能行业的求职增速达到33.4%,位居各行业榜首,其中人工智能工程师岗位的求职热度更是飙升69.6%。

AI产业的快速扩张,也让人才供需矛盾愈发突出。麦肯锡报告明确预测,到2030年中国AI专业人才需求将达600万人,人才缺口可能高达400万人,这一缺口不仅存在于核心技术领域,更蔓延至产业应用的各个环节。

那0基础普通人如何学习大模型 ?

深耕科技一线十二载,亲历技术浪潮变迁。我见证那些率先拥抱AI的同行,如何建立起效率与薪资的代际优势。如今,我将积累的大模型面试真题、独家资料、技术报告与实战路线系统整理,分享于此,为你扫清学习困惑,共赴AI时代新程。

我整理出这套 AI 大模型突围资料包【允许白嫖】:

-

✅从入门到精通的全套视频教程

-

✅AI大模型学习路线图(0基础到项目实战仅需90天)

-

✅大模型书籍与技术文档PDF

-

✅各大厂大模型面试题目详解

-

✅640套AI大模型报告合集

-

✅大模型入门实战训练

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

①从入门到精通的全套视频教程

包含提示词工程、RAG、Agent等技术点

② AI大模型学习路线图(0基础到项目实战仅需90天)

全过程AI大模型学习路线

③学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

④各大厂大模型面试题目详解

⑤640套AI大模型报告合集

⑥大模型入门实战训练

如果说你是以下人群中的其中一类,都可以来智泊AI学习人工智能,找到高薪工作,一次小小的“投资”换来的是终身受益!

应届毕业生:无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型:非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能 突破瓶颈:传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

👉获取方式:

有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献424条内容

已为社区贡献424条内容

所有评论(0)