AI 芯片参数表里的 7 个坑

AI 芯片不是“买参数”,是“买确定性”。

·

🔥 AI 芯片参数表里的 7 个坑

——你以为在选算力,其实是在赌工程命运

“这颗 AI 芯片参数这么猛,TOPS、TFLOPS、INT8 全都有,

怎么一上板、一上车、一跑模型就开始翻车?”

🎯 不是你不会选,是参数表“故意不告诉你真相”。

今天这篇,直接把 AI 芯片参数表里最容易误导工程师的 7 个坑一次性掀开。

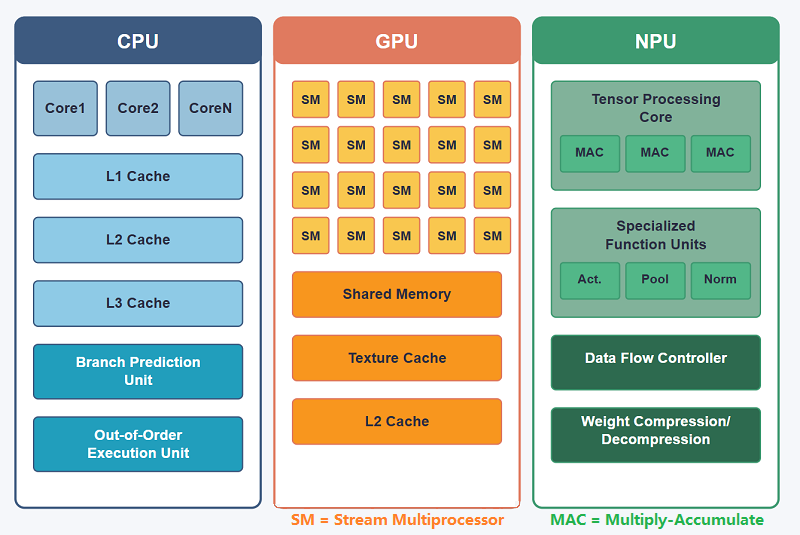

🧨 坑一:TOPS 很大,但你用不到

参数表最醒目的永远是:

“XX TOPS(INT8)”

但真实工程里,TOPS 是在极端理想条件下算的:

- 连续矩阵乘

- 所有 MAC 满负载

- 没有访存等待

🚨 而你的模型,从来不满足这些条件。

工程真相

- YOLO / BEV 算子复杂

- 一半算子不在 NPU

- NPU 在等内存

👉 10 TOPS → 3~4 TOPS 是常态

一句话记住

TOPS 是“峰值”,不是“可用值”

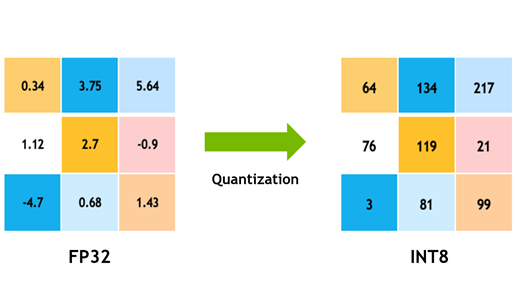

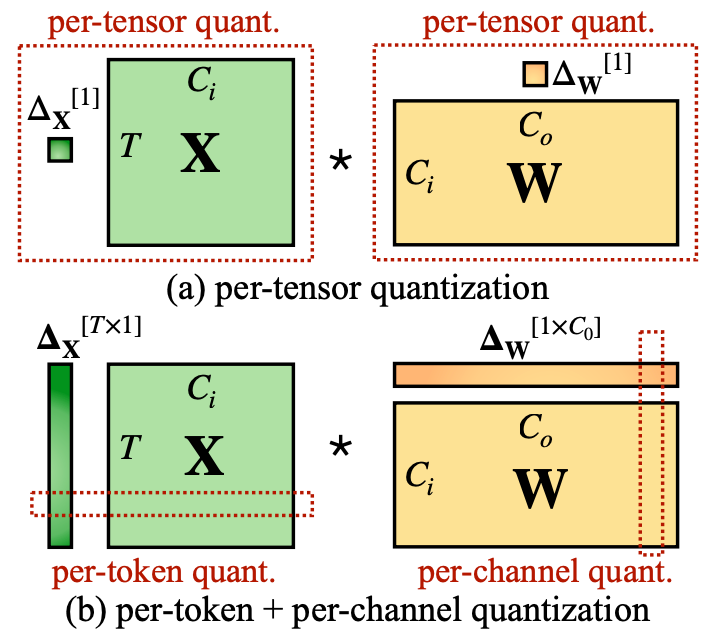

🧩 坑二:支持 INT8 ≠ INT8 能量产

参数表只写一句:

“支持 INT8 推理”

但它不会告诉你👇

INT8 的隐藏问题

- 是 对称 还是 非对称

- 支不支持 Per-Channel

- 量化误差能不能收敛

🔥 现实里经常发生:

INT8 能跑,但精度直接崩

工程结局

- 模型回退 FP16

- NPU 吃不满

- 功耗飙升

一句话记住

能跑不等于能用,能用才叫工程

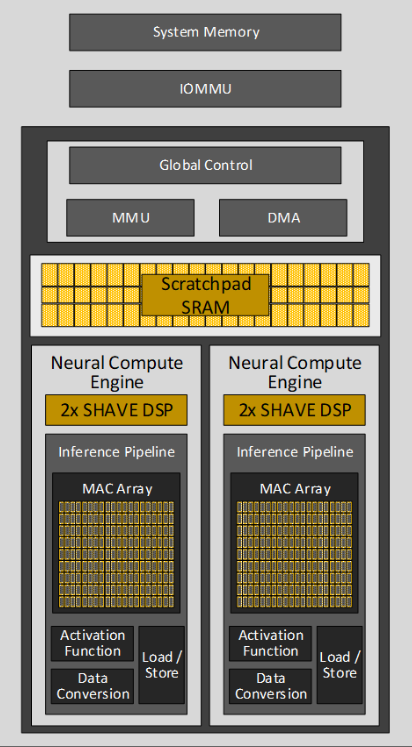

🚰 坑三:算力够,但“饿死在内存”

AI 芯片参数表几乎不强调:

- SRAM 多大

- Tile 怎么切

- DDR 带宽够不够

但工程里最常见的现象是👇

🚨 NPU 在干嘛?

- 不是在算

- 是在 等数据

尤其是:

- 高分辨率

- 多分支网络

- BEV / Transformer

👉 算力越大,等得越惨

一句话记住

AI 是“搬数据的艺术”,不是纯算数

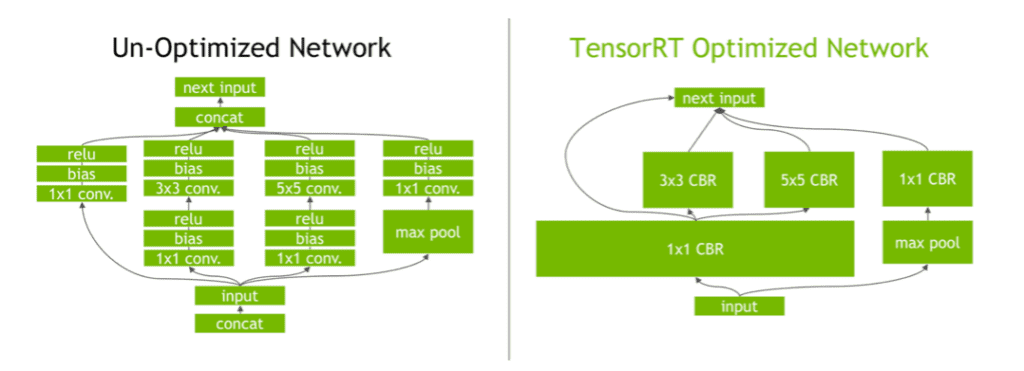

🧠 坑四:算子“支持” ≠ 算子“高效支持”

参数表常见说法:

“支持 Conv / Pool / GEMM / Attention”

但工程师最怕的是👇

支持 ≠ 好用

- 不支持算子融合

- 被拆成十几个小算子

- 中间频繁访存

🔥 理论支持,工程灾难

真实后果

- NPU 利用率低

- CPU / GPU 频繁介入

- 延迟飙升

一句话记住

算子效率,比算子数量更重要

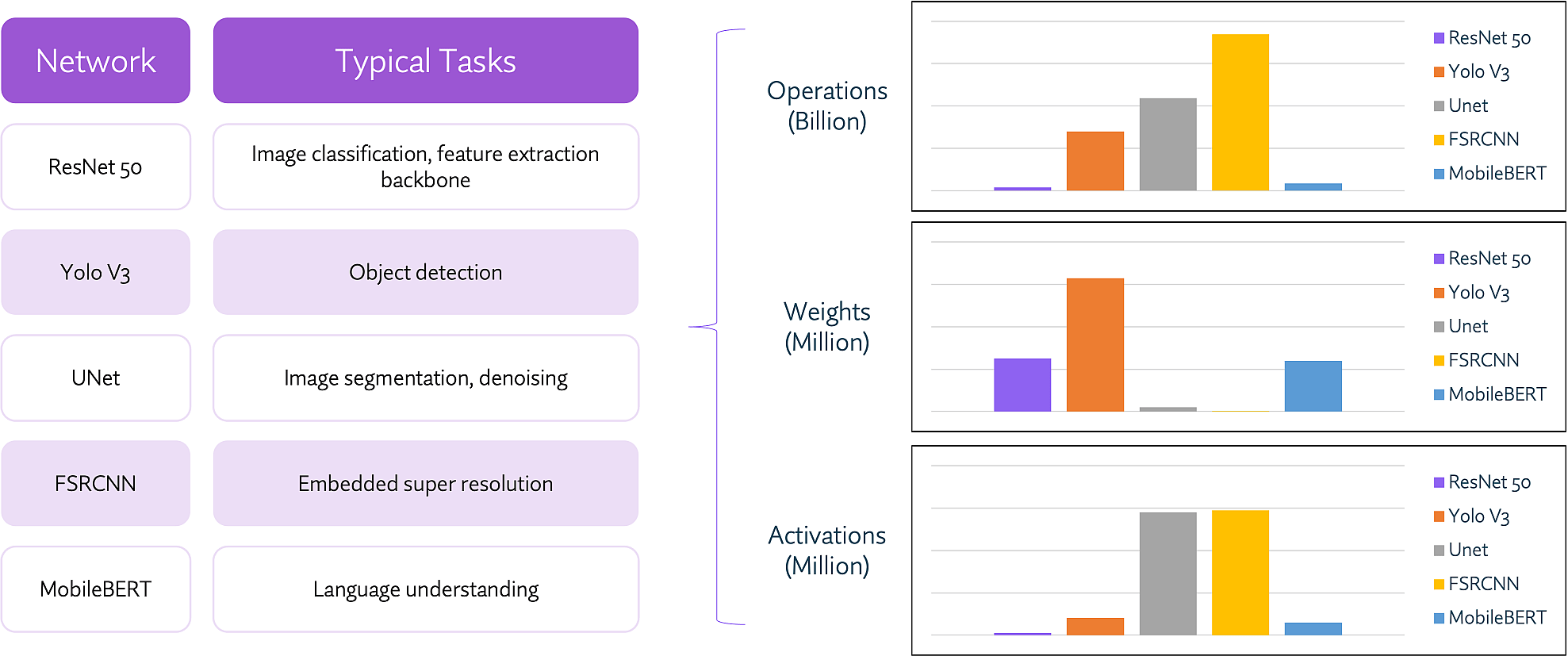

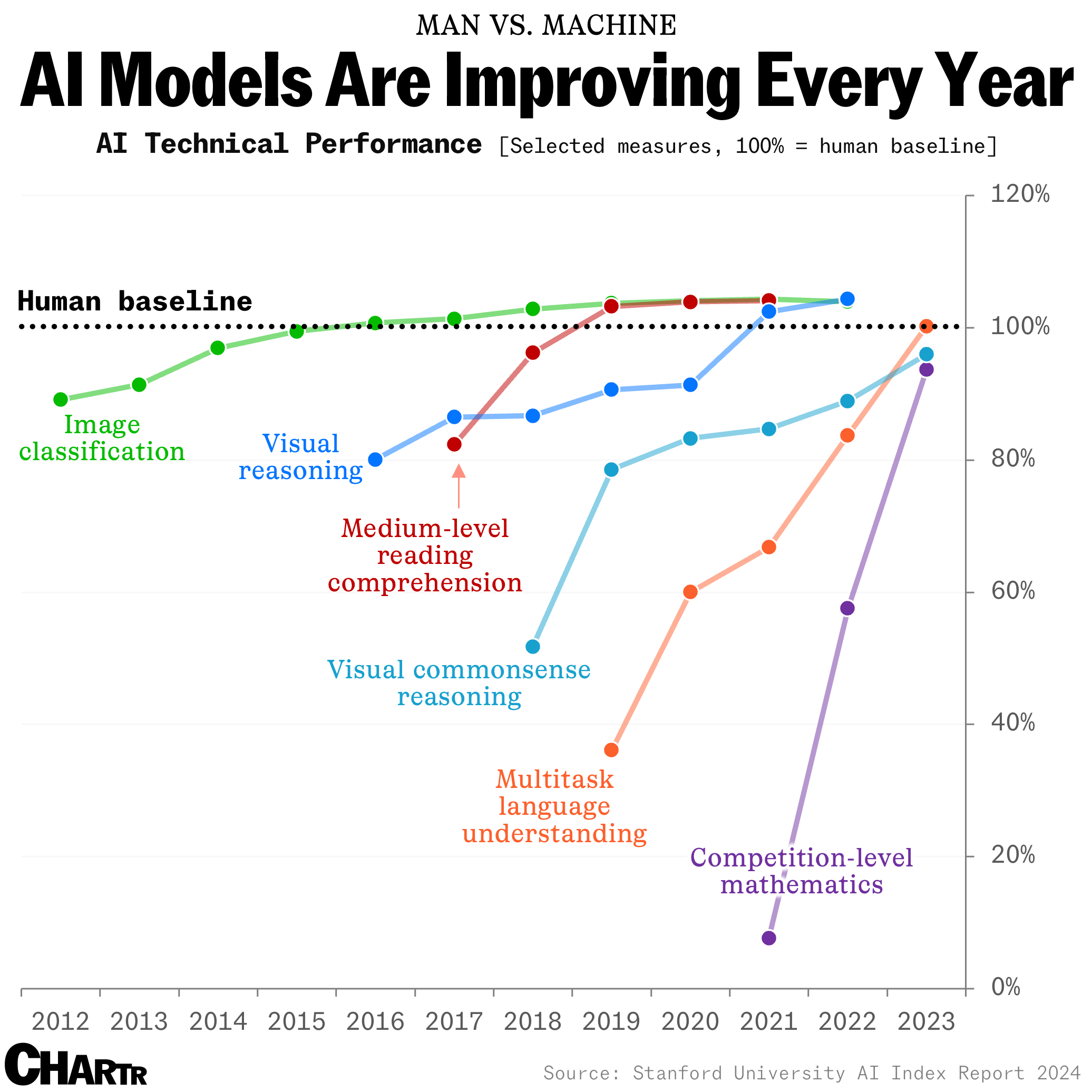

🧪 坑五:Benchmark 很漂亮,但不是你的模型

参数表常见:

- MLPerf

- ResNet

- MobileNet

但你跑的是👇

- YOLO

- BEV

- 自定义多头网络

🎯 Benchmark 赢,不代表你赢

工程现实

- Benchmark:全是矩阵乘

- 实际模型:碎算子一堆

一句话记住

跑你模型的 FPS,才是真性能

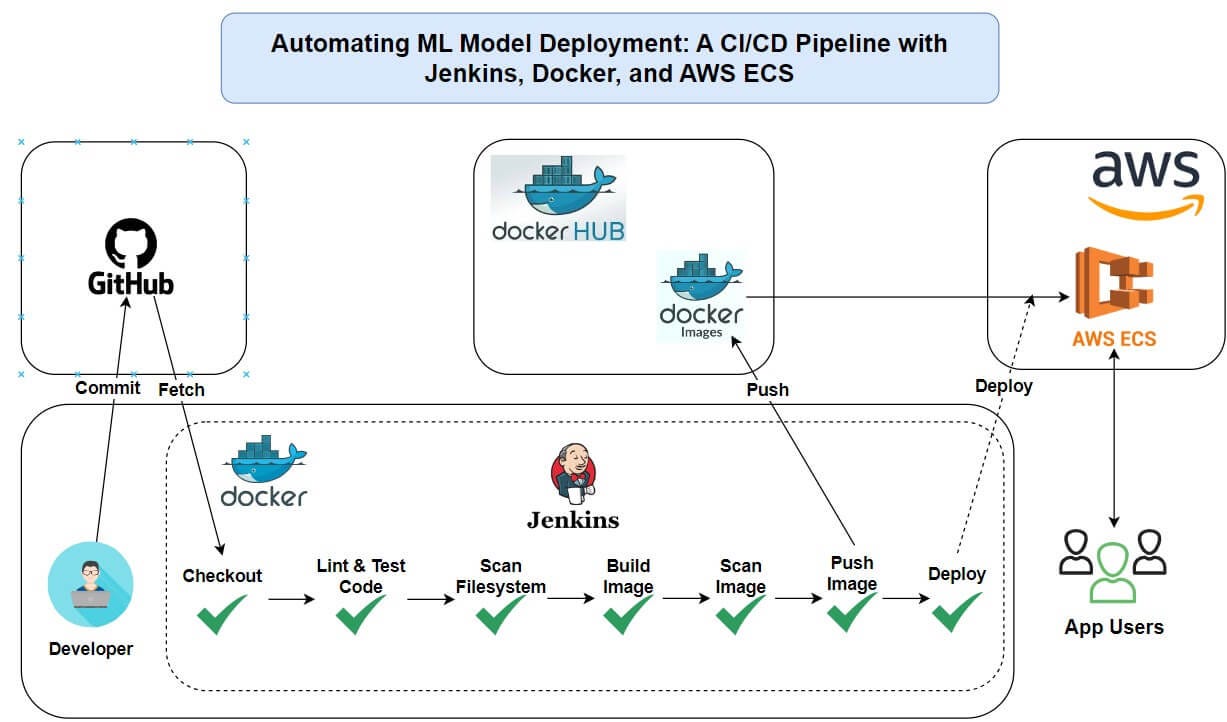

🧰 坑六:软件栈成熟度,被严重低估

这是最容易被忽略、

也是最容易拖死项目的一坑。

常见工程噩梦

- 编译器不稳定

- 算子莫名失败

- Debug 靠猜

- 文档跟不上版本

🔥 硬件 8 分,软件 3 分

结果是什么?

- 调模型 3 个月

- 改架构 1 周

- 项目延期

一句话记住

AI 芯片,50% 是软件

🔥 坑七:功耗参数是“实验室浪漫主义”

参数表最爱写:

“AI 功耗 3W / 5W”

但条件往往是👇

- 单模型

- 常温

- 降频

一上实际系统

- 多任务并发

- 高温

- 被动散热

🔥 直接撞功耗墙 → 降频 → 掉帧

一句话记住

你买的是“持续性能”,不是“瞬时性能”

🧾 工程师版「反参数表」7 问清单

选 AI 芯片前,一定要问:

- 我的模型算子命中率多少?

- INT8 精度能不能量产?

- SRAM 多大?DDR 会不会卡?

- 算子是不是高效支持?

- 有没有跑我模型的真实 FPS?

- 软件栈成熟吗?谁来背锅?

- 满温满载能持续跑多久?

🔥 最后一句送你

AI 芯片不是“买参数”,

是“买确定性”。

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)