揭秘:不用 Conda,Python “光杆司令“ 是如何指挥 GPU 跑大模型的?

揭秘:不用 Conda,Python "光杆司令" 是如何指挥 GPU 跑大模型的?

写在前面的话

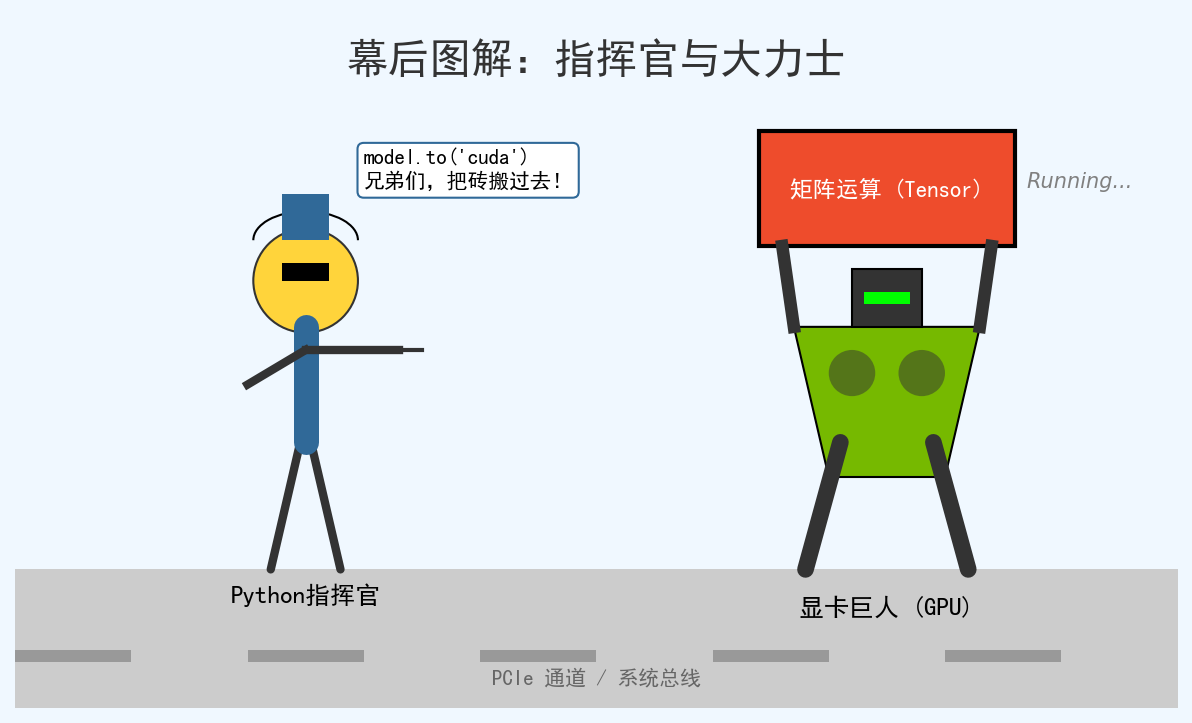

很多刚接触大模型的朋友会有这样的困惑:“我看教程都说要装 Conda,配置虚拟环境。但我直接在系统里的 Python 运行脚本,大模型好像也跑起来了?这时候 Python 到底是怎么跨过 Conda,直接调动我的显卡(GPU)资源的呢?”别急,今天我们就用最通俗易懂的大白话,配合生动的比喻,带你钻进计算机的“幕后”,看看这神奇的“借刀杀人”之术。

🏗️ 误区打破:Python 其实是个“只会动嘴的包工头”

首先,我们要建立一个核心认知:Python 语言本身,是不会直接操作 GPU 硬件的。

你可以把 Python 想象成一个建筑工地的 “总指挥”。他西装革履,拿着对讲机,负责发号施令。

- 他说:“把这堆砖头(数据)搬到楼顶!”

- 他说:“把这面墙(模型矩阵运算)砌好!”

但他自己动手吗?不,他搬不动,也没那个技术。真正干重活的,通过层层传达,最终是你的 GPU(显卡),也就是我们说的显卡巨人。

🔗 幕后传话链:从代码到硬件的“四级跳”

当你输入 python main.py 运行大模型时,虽然你没有启动 Conda 环境,但只要你的电脑配置正确,指令就会像接力棒一样传递下去。

这个过程就像是一个精密的传话游戏:

第一棒:Python 代码(你写的圣旨)

你在代码里写下这一句:

model.to('cuda') # 意思是:把模型搬到 GPU 上去!

这时候,Python 就像发出了圣旨。

第二棒:深度学习框架(PyTorch/TensorFlow —— 大管家)

Python 把圣旨交给了 PyTorch(或者 TensorFlow)。

PyTorch 是个非常懂行的大管家。他知道 Python 想要用 GPU,但他不管是 Conda 环境还是原生环境,他只关心一点:“哪里有能用的 CUDA?”

第三棒:CUDA(NVIDIA 的翻译官)

这是最关键的一环!

- 什么是 CUDA? 它是 NVIDIA(英伟达)专门为显卡设计的一套“语言库”。显卡听不懂 Python 话,显卡只懂二进制的电信号。

- 翻译过程:PyTorch 拿着 Python 的指令,去调用底层的 CUDA 库。CUDA 就像一个翻译官,把“矩阵乘法”这种高级指令,翻译成显卡能听懂的底层指令。

第四棒:显卡驱动 (Driver) 与 GPU (苦力巨人)

CUDA 把翻译好的指令交给显卡的驱动程序(Driver),驱动程序最终控制 GPU 硬件开始疯狂计算。

🤔 既然这样,那 Conda 是干嘛的?

你可能会问:“既然 Python -> PyTorch -> CUDA -> GPU 这条路是通的,那大家为什么老叫我装 Conda?”

打个比方:装修房子。

-

场景 A(使用 Conda):

Conda 就像是一个**“全屋定制大礼包”**。你安装一个 Conda 环境,它经常会非常贴心地把你需要的 Python、PyTorch,甚至匹配的 CUDA 工具包 都打包好给你放在一个独立的盒子里。- 好处:拎包入住,不用担心版本冲突。

- 坏处:盒子有点大,占地方。

-

场景 B(直接用 Python,你的情况):

你直接用系统的 Python,就像是**“毛坯房自己装修”。

当你用pip install torch安装 PyTorch 时,现在的 PyTorch 安装包非常智能,它往往自带了运行所需的 CUDA 运行时库**(Runtime)。所以,即使你没有显式地通过 Conda 安装 CUDA,只要你下载的 PyTorch 版本是对的(带有 cu118/cu121 等后缀),它自己就随身带着“翻译官”(CUDA 库)。

结论:Python 调用 GPU,靠的是 PyTorch 和 CUDA 库的配合,跟是否使用 Conda 管理器没有本质关系。Conda 只是让“找翻译官”这件事变得更容易管理而已。

⚡ 实战演示:一段代码看懂过程

让我们来看看,在代码层面发生了什么:

import torch

# 1. Python 问大管家 PyTorch:我也没用 Conda,你能找到显卡吗?

if torch.cuda.is_available():

print("PyTorch: 报告老板,找到显卡了!翻译官(CUDA)就位!")

# 2. 创建一个张量(数据),一开始它是在 CPU 内存里的(内存是慢速仓库)

x = torch.tensor([1.0, 2.0])

# 3. 关键一步:数据搬运

# Python 发令 -> PyTorch 调用 CUDA API -> 数据通过 PCIE 通道 -> 存入显存

x_gpu = x.to('cuda')

print(f"数据现在躺在:{x_gpu.device},准备起飞!")

else:

print("PyTorch: 坏了,没找到翻译官,只能用 CPU 慢慢算了。")

流程图解(Mermaid)

📚 总结

回到你的问题:“没有 Conda,Python 怎么调用的 GPU?”

答案是:Python 从来不靠 Conda 调 GPU,它靠的是 PyTorch 库里内置的(或系统安装的)CUDA 接口。

- Python 是发令员。

- 没有 Conda,只是意味着你没有用那个“全屋定制”的盒子,但只要你的 PyTorch 包里有 CUDA 库(现在

pip install的通常都有),或者你系统里装了 CUDA,发令员的电话线就是通的。 - GPU 接到电话,就开始干活了!

希望这个解释能帮你彻底搞懂它们的关系!🚀

更多推荐

已为社区贡献30条内容

已为社区贡献30条内容

所有评论(0)