增量学习:持续更新AI Agent的知识库

增量学习是机器学习领域的一个重要研究方向,它使AI系统能够在不遗忘已有知识的情况下,持续吸收新知识。系统介绍增量学习的基本原理和技术实现分析增量学习在AI Agent知识更新中的关键作用提供可落地的技术方案和代码实现探讨该领域的最新进展和未来方向本文涵盖从基础理论到工程实践的完整知识链,适合希望构建持续学习系统的技术人员阅读。首先介绍增量学习的基本概念然后深入其核心算法和数学模型接着通过实际代码展

增量学习:持续更新AI Agent的知识库

关键词:增量学习、AI Agent、知识库更新、持续学习、机器学习、神经网络、在线学习

摘要:本文深入探讨了增量学习(Incremental Learning)技术在AI Agent知识库持续更新中的应用。我们将从基础概念出发,详细分析增量学习的核心原理、数学模型和实现方法,并通过Python代码示例展示如何构建一个能够持续学习的AI系统。文章还将探讨实际应用场景、工具资源以及未来发展趋势,为读者提供全面的增量学习技术指南。

1. 背景介绍

1.1 目的和范围

增量学习是机器学习领域的一个重要研究方向,它使AI系统能够在不遗忘已有知识的情况下,持续吸收新知识。本文旨在:

- 系统介绍增量学习的基本原理和技术实现

- 分析增量学习在AI Agent知识更新中的关键作用

- 提供可落地的技术方案和代码实现

- 探讨该领域的最新进展和未来方向

本文涵盖从基础理论到工程实践的完整知识链,适合希望构建持续学习系统的技术人员阅读。

1.2 预期读者

本文主要面向以下读者群体:

- AI工程师和研究人员

- 机器学习算法开发者

- 数据科学家

- 对持续学习系统感兴趣的技术决策者

- 计算机科学相关专业的学生

1.3 文档结构概述

本文采用由浅入深的结构:

- 首先介绍增量学习的基本概念

- 然后深入其核心算法和数学模型

- 接着通过实际代码展示实现细节

- 最后探讨应用场景和未来趋势

1.4 术语表

1.4.1 核心术语定义

- 增量学习(Incremental Learning):一种机器学习范式,模型能够在不重新训练的情况下,持续从新数据中学习

- 灾难性遗忘(Catastrophic Forgetting):神经网络在学习新任务时,对先前学习知识的快速遗忘现象

- 知识蒸馏(Knowledge Distillation):将大型模型的知识转移到小型模型的技术

- 弹性权重巩固(EWC):一种减轻灾难性遗忘的算法

1.4.2 相关概念解释

- 在线学习(Online Learning):数据以流式方式到达,模型逐步更新的学习方式

- 迁移学习(Transfer Learning):将在一个任务上学到的知识应用到另一个相关任务上

- 元学习(Meta Learning):学习如何学习的方法

1.4.3 缩略词列表

- IL:增量学习(Incremental Learning)

- EWC:弹性权重巩固(Elastic Weight Consolidation)

- KD:知识蒸馏(Knowledge Distillation)

- CL:持续学习(Continual Learning)

2. 核心概念与联系

增量学习的核心在于解决"稳定性-可塑性困境":如何在保持已有知识(稳定性)的同时,适应新知识(可塑性)。

增量学习系统通常包含以下关键组件:

- 新数据接收模块:处理输入的数据流

- 知识评估模块:判断新知识的重要性和相关性

- 记忆管理模块:协调长期和短期记忆

- 知识整合模块:将新知识安全地融入现有知识库

- 遗忘控制机制:防止重要知识被覆盖

与传统批量学习相比,增量学习具有以下优势:

| 特性 | 增量学习 | 批量学习 |

|---|---|---|

| 数据需求 | 流式数据 | 完整数据集 |

| 计算资源 | 逐步消耗 | 一次性大量需求 |

| 模型更新 | 持续更新 | 完全重新训练 |

| 存储需求 | 较低 | 较高 |

| 实时性 | 支持实时学习 | 延迟较高 |

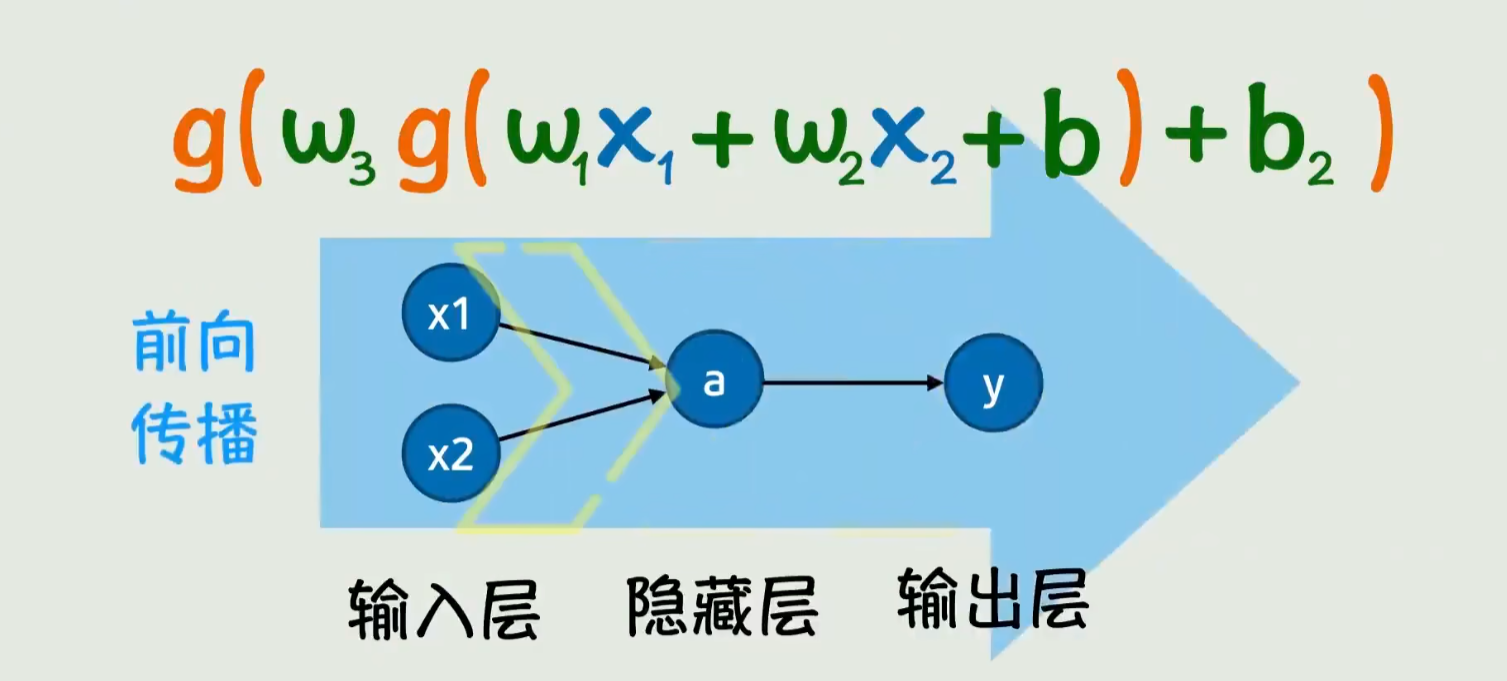

3. 核心算法原理 & 具体操作步骤

增量学习的核心算法可以分为三类:基于正则化的方法、基于架构的方法和基于记忆的方法。下面我们重点介绍基于弹性权重巩固(EWC)的算法实现。

3.1 弹性权重巩固(EWC)算法

EWC通过计算参数的重要性,对重要参数施加更强的约束,防止其在后续学习中被大幅修改。

import numpy as np

import torch

import torch.nn as nn

import torch.optim as optim

class EWCModel(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(EWCModel, self).__init__()

self.fc1 = nn.Linear(input_size, hidden_size)

self.fc2 = nn.Linear(hidden_size, output_size)

self.importance = {}

self.old_params = {}

def forward(self, x):

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

def compute_importance(self, dataset, criterion, samples=100):

# 计算参数重要性(Fisher信息矩阵对角线)

self.importance = {n: torch.zeros_like(p) for n, p in self.named_parameters()}

self.old_params = {n: p.clone().detach() for n, p in self.named_parameters()}

for _ in range(samples):

# 随机采样数据

idx = np.random.randint(0, len(dataset))

x, y = dataset[idx]

# 计算梯度

self.zero_grad()

output = self(x)

loss = criterion(output, y)

loss.backward()

# 累积梯度平方(Fisher信息近似)

for n, p in self.named_parameters():

if p.grad is not None:

self.importance[n] += p.grad.data ** 2

# 平均重要性

for n in self.importance:

self.importance[n] /= samples

def ewc_loss(self, lam=1.0):

# 计算EWC正则项

loss = 0

for n, p in self.named_parameters():

if n in self.old_params:

loss += (self.importance[n] * (p - self.old_params[n]) ** 2).sum()

return lam * loss

3.2 增量学习训练步骤

-

初始训练阶段:

# 初始化模型和优化器 model = EWCModel(input_size=784, hidden_size=256, output_size=10) optimizer = optim.Adam(model.parameters(), lr=0.001) criterion = nn.CrossEntropyLoss() # 在初始任务上训练 for epoch in range(10): for x, y in initial_loader: optimizer.zero_grad() output = model(x) loss = criterion(output, y) loss.backward() optimizer.step() # 计算参数重要性 model.compute_importance(initial_dataset, criterion) -

增量学习阶段:

# 遇到新任务时 for epoch in range(5): # 通常增量学习epoch较少 for x, y in new_task_loader: optimizer.zero_grad() output = model(x) # 标准交叉熵损失 + EWC正则项 ce_loss = criterion(output, y) total_loss = ce_loss + model.ewc_loss(lam=0.5) total_loss.backward() optimizer.step() # 更新重要性(可选) model.compute_importance(combined_dataset, criterion)

4. 数学模型和公式 & 详细讲解

增量学习的核心数学问题是优化目标的重新定义。传统的机器学习优化目标为:

minθE(x,y)∼D[L(fθ(x),y)]\min_\theta \mathbb{E}_{(x,y)\sim D}[L(f_\theta(x), y)]θminE(x,y)∼D[L(fθ(x),y)]

其中LLL是损失函数,fθf_\thetafθ是参数为θ\thetaθ的模型,DDD是数据分布。

在增量学习中,我们需要考虑多个任务序列D1,D2,...,DTD_1, D_2, ..., D_TD1,D2,...,DT,目标是:

minθ∑t=1TE(x,y)∼Dt[L(fθ(x),y)]\min_\theta \sum_{t=1}^T \mathbb{E}_{(x,y)\sim D_t}[L(f_\theta(x), y)]θmint=1∑TE(x,y)∼Dt[L(fθ(x),y)]

但直接优化会导致灾难性遗忘。EWC通过引入正则项解决:

minθE(x,y)∼Dt[L(fθ(x),y)]+λ∑iFi(θi−θi,old∗)2\min_\theta \mathbb{E}_{(x,y)\sim D_t}[L(f_\theta(x), y)] + \lambda \sum_i F_i (\theta_i - \theta_{i,old}^*)^2θminE(x,y)∼Dt[L(fθ(x),y)]+λi∑Fi(θi−θi,old∗)2

其中:

- FiF_iFi是参数θi\theta_iθi的Fisher信息矩阵对角线元素

- θi,old∗\theta_{i,old}^*θi,old∗是在旧任务上学习到的最优参数

- λ\lambdaλ控制正则化强度

Fisher信息矩阵衡量了参数对模型预测的重要性:

Fi=E(x,y)∼Dold[(∂logpθ(y∣x)∂θi)2]F_i = \mathbb{E}_{(x,y)\sim D_{old}} \left[ \left( \frac{\partial \log p_\theta(y|x)}{\partial \theta_i} \right)^2 \right]Fi=E(x,y)∼Dold[(∂θi∂logpθ(y∣x))2]

推导过程:

- 假设旧任务数据DoldD_{old}Dold的损失函数在θ∗\theta^*θ∗处达到极小值

- 使用二阶泰勒展开近似旧任务的损失:

Lold(θ)≈Lold(θ∗)+12(θ−θ∗)TH(θ−θ∗)L_{old}(\theta) \approx L_{old}(\theta^*) + \frac{1}{2}(\theta-\theta^*)^T H(\theta-\theta^*)Lold(θ)≈Lold(θ∗)+21(θ−θ∗)TH(θ−θ∗)

- 其中HHH是Hessian矩阵,可以用Fisher信息矩阵近似

- 因此保持Lold(θ)L_{old}(\theta)Lold(θ)小等价于保持(θ−θ∗)TF(θ−θ∗)(\theta-\theta^*)^T F(\theta-\theta^*)(θ−θ∗)TF(θ−θ∗)小

示例计算:

假设一个简单线性模型y=wx+by=wx+by=wx+b,在第一个任务上学习到w∗=1.0w^*=1.0w∗=1.0, b∗=0.5b^*=0.5b∗=0.5,Fisher信息为Fw=0.8F_w=0.8Fw=0.8, Fb=0.2F_b=0.2Fb=0.2。

当学习第二个任务时,损失函数变为:

Lnew(w,b)+0.5⋅[0.8(w−1.0)2+0.2(b−0.5)2]L_{new}(w,b) + 0.5 \cdot [0.8(w-1.0)^2 + 0.2(b-0.5)^2]Lnew(w,b)+0.5⋅[0.8(w−1.0)2+0.2(b−0.5)2]

这将阻止www和bbb偏离原有值太远,除非新任务有很强的证据需要改变。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

推荐使用以下环境进行增量学习实验:

# 创建conda环境

conda create -n incremental python=3.8

conda activate incremental

# 安装核心包

pip install torch torchvision numpy matplotlib

# 可选:安装GPU支持

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu113

5.2 源代码详细实现和代码解读

我们实现一个完整的增量学习系统,处理MNIST数据集的顺序学习:

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader, Subset

import numpy as np

import matplotlib.pyplot as plt

class IncrementalLearner:

def __init__(self, input_size=784, hidden_size=256, output_size=10):

self.model = EWCModel(input_size, hidden_size, output_size)

self.optimizer = optim.Adam(self.model.parameters(), lr=0.001)

self.criterion = nn.CrossEntropyLoss()

# 数据预处理

self.transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.1307,), (0.3081,))

])

def load_dataset(self):

# 加载完整MNIST

train_set = datasets.MNIST('./data', train=True, download=True, transform=self.transform)

test_set = datasets.MNIST('./data', train=False, transform=self.transform)

# 创建5个任务,每个任务2个数字

self.tasks = []

for i in range(5):

idx = (train_set.targets >= i*2) & (train_set.targets < (i+1)*2)

task_data = Subset(train_set, torch.where(idx)[0])

self.tasks.append(task_data)

self.test_loader = DataLoader(test_set, batch_size=64, shuffle=True)

def train_task(self, task_idx, epochs=5, lam=0.5):

task_loader = DataLoader(self.tasks[task_idx], batch_size=64, shuffle=True)

for epoch in range(epochs):

self.model.train()

for x, y in task_loader:

x, y = x.view(x.size(0), -1), y

self.optimizer.zero_grad()

output = self.model(x)

# 计算损失

ce_loss = self.criterion(output, y)

total_loss = ce_loss + self.model.ewc_loss(lam)

total_loss.backward()

self.optimizer.step()

# 打印训练进度

acc = self.evaluate(task_idx)

print(f'Task {task_idx}, Epoch {epoch+1}/{epochs}, Acc: {acc:.2f}')

# 更新重要性

self.model.compute_importance(self.tasks[task_idx], self.criterion)

def evaluate(self, task_idx=None):

self.model.eval()

correct = 0

total = 0

with torch.no_grad():

for x, y in self.test_loader:

x = x.view(x.size(0), -1)

output = self.model(x)

if task_idx is not None:

# 只计算当前任务类别的准确率

mask = (y >= task_idx*2) & (y < (task_idx+1)*2)

x, y = x[mask], y[mask]

if len(y) == 0:

continue

_, predicted = torch.max(output.data, 1)

total += y.size(0)

correct += (predicted == y).sum().item()

return 100 * correct / total if total > 0 else 0

def run_experiment(self):

self.load_dataset()

# 初始训练

print("Training initial task...")

self.train_task(0, epochs=10, lam=0)

# 增量学习

for i in range(1, 5):

print(f"\nLearning task {i}...")

self.train_task(i)

# 评估所有已学任务

print("\nCurrent performance:")

for j in range(i+1):

acc = self.evaluate(j)

print(f'Task {j} accuracy: {acc:.2f}%')

# 最终评估

print("\nFinal evaluation:")

overall_acc = self.evaluate()

print(f'Overall accuracy: {overall_acc:.2f}%')

if __name__ == '__main__':

learner = IncrementalLearner()

learner.run_experiment()

5.3 代码解读与分析

-

数据准备:

- 将MNIST数据集划分为5个任务,每个任务包含2个数字类别

- 使用Subset创建任务特定的数据集

-

训练流程:

- 初始任务使用标准训练(lam=0)

- 后续任务加入EWC正则项

- 每个任务训练后计算参数重要性

-

评估机制:

- 可以评估特定任务或整体性能

- 测试时考虑所有已学类别

-

关键设计:

- EWCModel管理参数重要性和旧参数

- 正则项强度λ控制新旧知识平衡

- Fisher信息矩阵近似计算

实验预期结果:

- 不使用增量学习(lam=0)会导致严重的灾难性遗忘

- 适当λ值(如0.5)能保持旧任务性能

- λ过大可能导致新任务学习困难

6. 实际应用场景

增量学习在以下场景中具有重要应用价值:

-

个性化推荐系统:

- 用户兴趣随时间变化

- 系统需要在不丢失已有用户画像的情况下适应新趋势

- 案例:电商平台根据季节性和突发时间调整推荐策略

-

智能客服系统:

- 产品和服务持续更新

- 新问题类型不断出现

- 案例:银行客服系统适应新金融产品的问答

-

工业设备预测性维护:

- 设备随时间老化,性能变化

- 新增传感器和监测指标

- 案例:风力发电机故障预测模型随设备运行时间自适应

-

医疗诊断系统:

- 医学知识持续更新

- 新疾病和治疗方法出现

- 案例:医学影像诊断系统适应新发现的病理特征

-

自动驾驶系统:

- 遇到新的交通场景

- 法规和道路标志更新

- 案例:自动驾驶汽车适应不同城市和气候条件

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- “Continual Learning with Deep Architectures” by Davide Maltoni

- “Neural Networks: Tricks of the Trade” (增量学习相关章节)

- “Lifelong Machine Learning” by Zhiyuan Chen and Bing Liu

7.1.2 在线课程

- Coursera “Advanced Deep Learning with TensorFlow 2” (增量学习模块)

- Udemy “Continual Learning for Deep Neural Networks”

- DeepMind的增量学习专题研讨会视频

7.1.3 技术博客和网站

- ContinualAI官方博客

- Towards Data Science增量学习专题

- arXiv上的最新增量学习论文

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm Professional (支持远程开发和调试)

- VS Code with Python/Jupyter插件

- Google Colab Pro (云端实验环境)

7.2.2 调试和性能分析工具

- PyTorch Profiler

- Weights & Biases (实验跟踪)

- TensorBoard (可视化)

7.2.3 相关框架和库

- Avalanche: 端到端增量学习库

- PyTorch Lightning + Lightning Bolts

- Keras的增量学习扩展

7.3 相关论文著作推荐

7.3.1 经典论文

- “Overcoming catastrophic forgetting in neural networks” (EWC原始论文)

- “Gradient Episodic Memory for Continual Learning”

- “Continual Learning Through Synaptic Intelligence”

7.3.2 最新研究成果

- “Online Continual Learning with Maximally Interfered Retrieval”

- “Continual Learning with Bayesian Neural Networks”

- “Meta-Experience Replay for Continual Learning”

7.3.3 应用案例分析

- 增量学习在医疗影像中的应用研究

- 自动驾驶场景下的持续学习

- 工业4.0中的增量学习案例

8. 总结:未来发展趋势与挑战

增量学习作为AI持续适应能力的核心技术,未来发展呈现以下趋势:

-

算法创新方向:

- 更高效的记忆机制

- 基于神经科学的启发式方法

- 与元学习的结合

-

硬件支持需求:

- 专用加速器设计

- 内存计算架构

- 边缘设备上的增量学习

-

理论突破方向:

- 增量学习的可解释性

- 稳定性-可塑性的理论边界

- 灾难性遗忘的数学本质

-

应用扩展挑战:

- 大规模分布式增量学习

- 多模态增量学习

- 安全性和鲁棒性保障

-

评估标准体系:

- 统一的增量学习基准

- 更全面的评估指标

- 真实场景测试平台

未来5-10年,我们预期增量学习将成为AI系统的标配能力,使AI Agent能够真正实现终身学习,持续适应复杂多变的环境。

9. 附录:常见问题与解答

Q1: 增量学习与迁移学习有什么区别?

A1: 迁移学习关注将源任务知识应用于目标任务,通常是一次性过程;而增量学习强调持续、顺序地学习多个任务,同时保持之前学到的知识。

Q2: 如何选择EWC中的λ参数?

A2: λ通常通过交叉验证确定,一般范围在0.1-1.0之间。实践中可以从较小值开始,逐步增加直到旧任务性能不再显著下降。

Q3: 增量学习需要存储所有历史数据吗?

A3: 不一定。基于正则化的方法(如EWC)只需要存储参数重要性;基于记忆的方法需要存储部分样本;而基于架构的方法通常不需要存储历史数据。

Q4: 如何处理类别增量学习中的新类别?

A4: 常见方法包括:1)扩展输出层;2)使用动态架构;3)基于原型或度量学习的方法。关键是要保持对旧类别的判别能力。

Q5: 增量学习在工业落地中的主要障碍是什么?

A5: 主要挑战包括:1)性能稳定性保障;2)计算资源限制;3)评估难度;4)与现有系统的集成。需要针对具体场景进行定制化解决方案。

10. 扩展阅读 & 参考资料

-

Parisi, G.I., et al. (2019). Continual lifelong learning with neural networks: A review. Neural Networks.

-

De Lange, M., et al. (2021). A continual learning survey: Defying forgetting in classification tasks. IEEE TPAMI.

-

增量学习开源库Avalanche官方文档

-

NeurIPS/ICML/IJCAI等顶会近年增量学习相关论文

-

各行业应用白皮书:医疗、金融、制造等领域的增量学习实践报告

更多推荐

已为社区贡献132条内容

已为社区贡献132条内容

所有评论(0)