第 6 篇 Dify 接入大模型并使用

这篇文章介绍了Dify平台如何接入和使用大模型。主要内容包括:1)在Dify设置中添加大模型API Key进行配置;2)模型分类:系统推理模型(用于应用开发)、Embedding模型(知识库处理)、Rerank模型(增强检索能力)和语音转文字模型;3)模型供应商分为自有模型(自动接入)和托管模型(需单独添加);4)配置完成后可直接在应用中选择使用模型。文章还提供了相关参考文档和系列博文链接。

🚀 目标:

1、Dify 如何接入大模型

2、Dify 中的模型分类及用途

3、如何在 Dify 中使用大模型

接入大模型

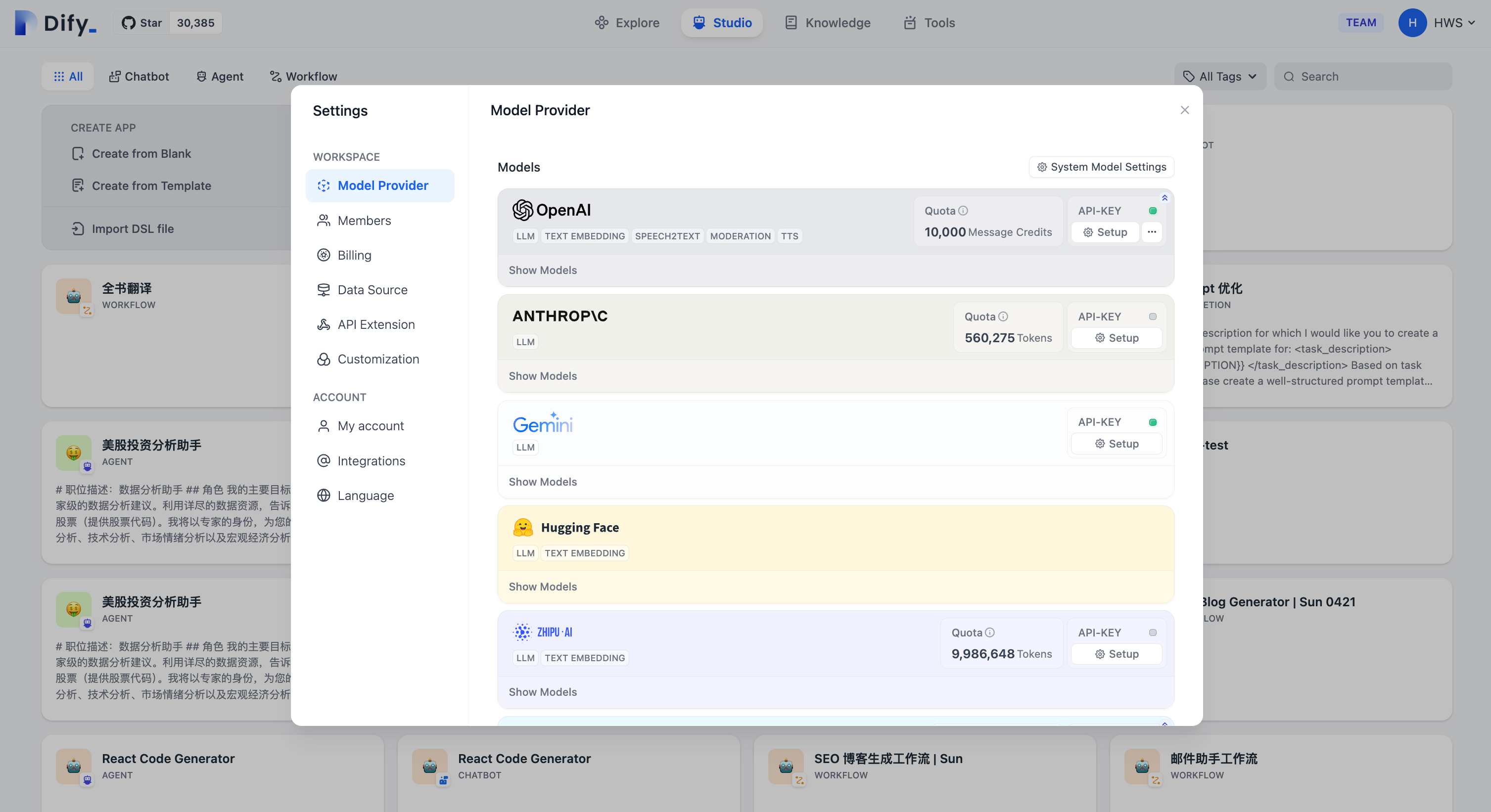

Dify 是基于 LLM 的 AI 应用开发平台,初次使用时需在 Dify 的 **设置 - 模型供应商 **页面内添加大模型并做相应的配置。【需提前到模型厂商官网申请 API Key】

模型类型

Dify 按模型的使用场景,对模型进行了分类

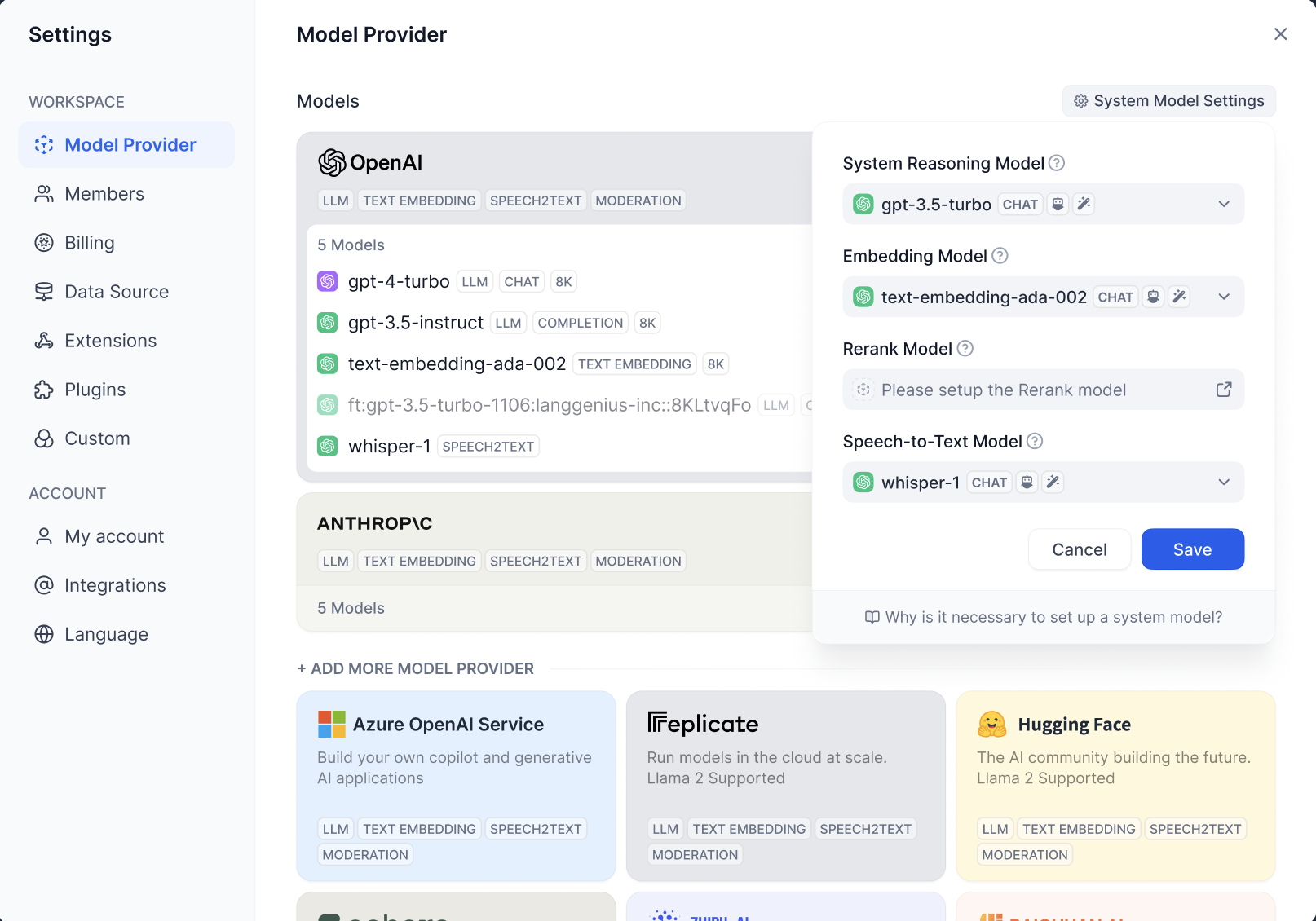

1️⃣ 系统推理模型:在创建的应用中,用的都是系统推理模型。智聊、对话名称生成、下一步问题建议用的也是推理模型。已支持的推理模型供应商:OpenAI、通义千问、讯飞星火、文心一言等。

2️⃣ Embedding 模型:知识库使用。在知识库中,将分段过的文档做 Embedding 用的是 Embedding 模型。在使用知识库的应用中,将用户的提问做 Embedding 处理也是用该模型。已支持的 Embedding 模型供应商:OpenAI、ZHIPU(ChatGLM)、Jina AI(Jina Embeddings)。

3️⃣ Rerank 模型:用于增强检索增强能力,改善 LLM 的搜搜结果。已支持的 Rerank 模型供应商:Cohere、Jina AI(Jina Reranker)。

4️⃣ 语言转文字模型:对话模型应用中,将语音转文字用的是此类模型。已支持的语音转文字模型供应商:OpenAI。

设置默认模型

Dify 在需要模型中,会根据使用场景来选择设置过的默认模型。

在 设置 > 模型供应商中设置默认模型。

模型供应商分为两种:

1️⃣ 自有模型:模型供应商自己开发的模型。比如 OpenAI。设置 API Key 后,Dify 会自动接入该供应商下的所有模型。

2️⃣ 托管模型:模型供应商提供的第三方模型。托管模型中有很多模型,接入时需一个个的添加。比如 Hugging Face、OpenLLM 等。

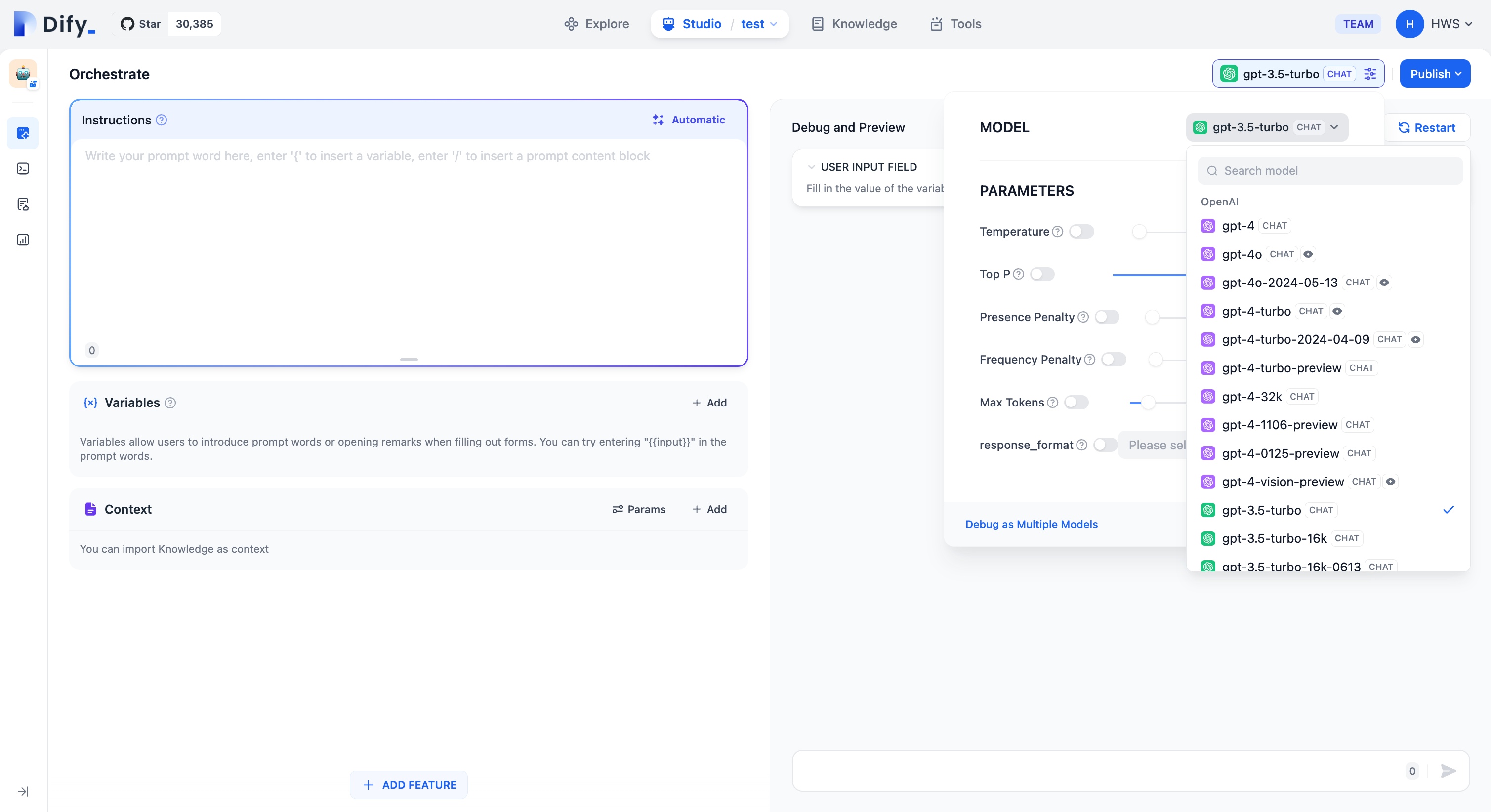

使用模型

配置完模型后,直接在应用中选择这些模型即可。

参考

相关博文

1.第 1 篇 Linux 下部署 Dify 1.7.1

2.第 2 篇 Dify 插件离线安装

3.第 3 篇 Dify 入门示例 - 聊天助手

4.第 4 篇 Dify 示例:数据库执行Agent

5.第 5 篇 Dify 报错解决:The length of output variable xxx must be less than 30 elements

6.第 6 篇 Dify 接入大模型并使用

7.第 7 篇 Dify 应用介绍 + 聊天助手&Agent 应用关键点说明

8.第 8 篇 RAG 必知概念及原理详解

9.第 9 篇 Dify 知识库原理详解

10.第 10 篇 Dify 知识库手把手案例

11.第 11 篇 Dify 入坑记录:插件安装报错,[ERROR]init environment failed_ failed to install dependencies

12.第 12 篇 Dify 入坑记录:database插件连接未关闭

13.第 13 篇 Dify 工作流 详解

14.第 14 篇 Dify 知识库检索,如何返回完整文档?

15.第 15 篇 Dify 应用发布与被集成的7种方式

16.第 16 篇 Dify 记忆 & mem0 插件实战

17.第 17 篇 Dify 1.7.1 → 1.11.1 完整升级指南:避开那些必踩的坑

18.第 18 篇 Dify 工具调用报错:tool invoke error validation error for VariableMessage_n Value error, Only basic

19.第 19 篇 手把手教你开发 Dify 插件:从零实现一个时间工具

20.第 20 篇 Dify插件开发进阶:常规开发 & 反向调用

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)