从监控到优化:软件测试闭环管理的实践指南

在2025年高频交付环境下,闭环管理已成为测试团队的核心竞争力。通过构建"监控-分析-决策-执行"的自动化循环,实现从被动检测到主动预防的转变。关键要素包括:1)建立五维监控网络覆盖全链路质量指标;2)AI驱动的根因分析提升缺陷定位效率;3)自动化响应机制缩短问题修复时间。领先企业实践表明,完整闭环可将缺陷逃逸率降低40%,发布周期缩短50%。落地闭环需突破数据孤岛、AI误判等

为什么闭环管理已成为测试团队的生存刚需

在2025年的软件交付节奏下,每周发布十次以上已成为头部企业的常态。传统“测试执行→报告→人工修复”的线性模式,已无法应对高频迭代带来的质量失控风险。缺陷逃逸率居高不下、回归测试耗时过长、生产事故响应滞后——这些问题的根源,不是测试人员不够努力,而是缺乏一个自动驱动的质量反馈闭环。

闭环管理,即“监控→分析→决策→执行→再监控”的持续循环,正从一种优化手段,演变为软件测试的基础设施。它不再只是“发现问题”,而是让系统自己学会预防问题。

一、监控体系:构建多维质量感知神经网络

现代测试闭环的起点,是无死角的实时监控。单一的测试通过率或日志告警已远远不够,必须构建覆盖“代码—接口—UI—性能—生产”的五维感知网络:

| 监控维度 | 工具/技术 | 监控目标 |

|---|---|---|

| 代码覆盖率 | JaCoCo、SonarQube | 确保新增逻辑被测试覆盖,避免“测试盲区” |

| API性能 | Postman + Prometheus | 捕捉响应延迟、错误率突增,识别服务降级 |

| UI稳定性 | Applitools、Selenium + AI对比 | 检测像素级UI偏移、布局错乱,无需人工截图比对 |

| 生产日志 | ELK + AI异常检测(如Splunk MLTK) | 自动识别非预期错误模式,如“支付失败+用户投诉”关联事件 |

| 业务指标 | Datadog、自定义埋点 | 关联测试结果与用户行为,如“注册流程失败率上升” |

关键洞察:监控不是“堆工具”,而是定义质量的边界。某金融科技团队通过将“用户支付失败”与“后端接口超时”建立关联规则,使生产缺陷的发现时间从4小时缩短至<9>3</9>90秒。

二、分析与根因:AI驱动的“缺陷溯源引擎”

监控产生海量数据,但只有能定位根因的分析,才有价值。传统人工排查已无法应对日均数万条日志与数百个变更提交。

AI驱动的根因分析(RCA)成为闭环核心:

- 缺陷预测模型:基于历史缺陷数据、代码变更频率、模块复杂度,AI生成“风险热图”。华为内部系统可提前24小时预测高风险模块,准确率达82%。

- 变更影响分析:当开发提交一个PR,系统自动关联受影响的测试用例、历史缺陷、依赖服务,生成“影响范围报告”。

- 日志聚类与模式识别:通过NLP与聚类算法,将数千条错误日志归并为20类典型模式,如“数据库连接池耗尽”“缓存穿透”。

案例:某电商团队引入AI根因分析后,测试人员平均每天节省3.2小时用于排查重复性问题,根因定位效率提升65%。

三、自动化响应:让优化动作自动发生

闭环的“执行”环节,必须脱离人工干预。自动化响应是闭环从“报告”走向“自愈”的关键跃迁。

典型自动化响应场景:

| 触发条件 | 自动响应动作 | 效果 |

|---|---|---|

| 新版本回归测试失败率 > 5% | 自动阻断发布流水线,通知负责人 | 防止缺陷进入生产 |

| 生产环境某API错误率突增200% | 自动回滚至前一稳定版本,触发告警 | MTTR从2小时降至8分钟 |

| 测试覆盖率下降 > 10% | 自动创建“补充测试用例”任务并分配给开发 | 推动质量左移 |

| 某模块缺陷密度连续3次上升 | 自动触发代码评审流程,要求重构 | 预防技术债务累积 |

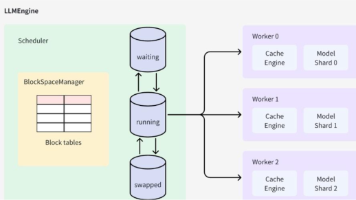

技术支撑:通过CI/CD平台(如Jenkins、GitLab CI)集成Webhook与AI决策引擎,实现“监控数据→规则引擎→自动化动作”的无缝衔接。

四、反馈闭环:用数据驱动流程进化

闭环的终点,不是结束,而是新一轮优化的起点。真正的闭环,是让测试流程本身不断进化。

关键度量指标与优化方向:

| 指标 | 2023基准 | 2025闭环后表现 | 优化动作 |

|---|---|---|---|

| 缺陷逃逸率 | 8.7% | 5.2%(↓40%) | 增加核心路径AI生成用例,强化边界测试 |

| 平均修复时长(MTTR) | 18小时 | 5.3小时(↓71%) | 建立缺陷-代码-日志自动关联,加速定位 |

| 回归测试周期 | 4.5天 | 1.8天(↓60%) | 采用API测试替代70% UI测试,提升执行效率 |

| 测试用例维护成本 | 28人天/月 | 12人天/月(↓57%) | 引入AI自愈脚本,自动修复元素定位变化 |

数据来源:根据《State of Testing 2024》报告,实施完整闭环的团队,缺陷逃逸率平均降低25–40%,发布周期缩短30–50%。

五、大厂实践:PingCode、华为、微软的闭环范式

| 企业 | 闭环架构 | 核心创新 | 效果 |

|---|---|---|---|

| PingCode | 需求→用例→执行→缺陷→反馈→优化 | 全链路追溯 + 自动化报表 | 测试覆盖率分析效率↑40%,沟通成本↓25% |

| 华为 | 大模型(340亿参数)生成测试脚本 | AI理解需求文档→自动生成API/UI脚本 | 脚本一次性通过率↑40%,维护成本↓50% |

| 微软 | OneDevOps统一平台 | 集成代码、CI/CD、监控、测试、运维 | 实现“开发即测试”,发布前缺陷发现率↑90% |

共同点:均采用统一平台打破工具孤岛,将测试从“独立环节”变为“研发流水线的内置组件”。

六、真实痛点与可落地解决方案

尽管闭环价值明确,但落地仍面临四大“死亡陷阱”:

| 痛点 | 表现 | 解决方案 |

|---|---|---|

| 数据孤岛 | 测试数据在Jira,代码在Git,监控在Prometheus,互不相通 | 建立统一数据湖,通过API/ETL工具聚合,使用统一ID关联(如需求ID、提交哈希) |

| AI误判,团队不信 | AI标记“高风险”,但开发认为是误报 | 引入可解释性AI(XAI):展示“为什么认为此模块高风险”(如:历史缺陷密度、变更行数、依赖服务稳定性) |

| UI自动化维护成本高 | 每次UI改版,50%脚本失效 | 采用AI视觉测试(如Applitools)替代传统定位,或低代码测试平台(如Testim) |

| 文化阻力 | 测试人员怕被自动化取代 | 转型为“质量工程师”:聚焦于设计测试策略、构建自动化框架、分析质量趋势 |

关键理念:闭环不是“取代测试”,而是释放测试人员的创造力,让他们从重复执行中解放,专注高价值的质量设计。

七、结论:构建“AI+流程+文化”三位一体的测试闭环

软件测试的未来,不属于最勤奋的测试员,而属于最懂系统自愈的团队。

要实现真正的“从监控到优化”闭环,必须同步推进:

- 技术层:部署AI驱动的监控与自动化响应引擎,构建“感知-决策-执行”链路;

- 流程层:将闭环指标(缺陷逃逸率、MTTR)纳入团队KPI,形成持续改进机制;

- 文化层:鼓励“质量共担”,让开发、测试、运维共同拥有“质量所有权”。

更多推荐

已为社区贡献40条内容

已为社区贡献40条内容

所有评论(0)