【AI应用开发】大模型介绍

大模型介绍

大模型介绍

一. 认识模型

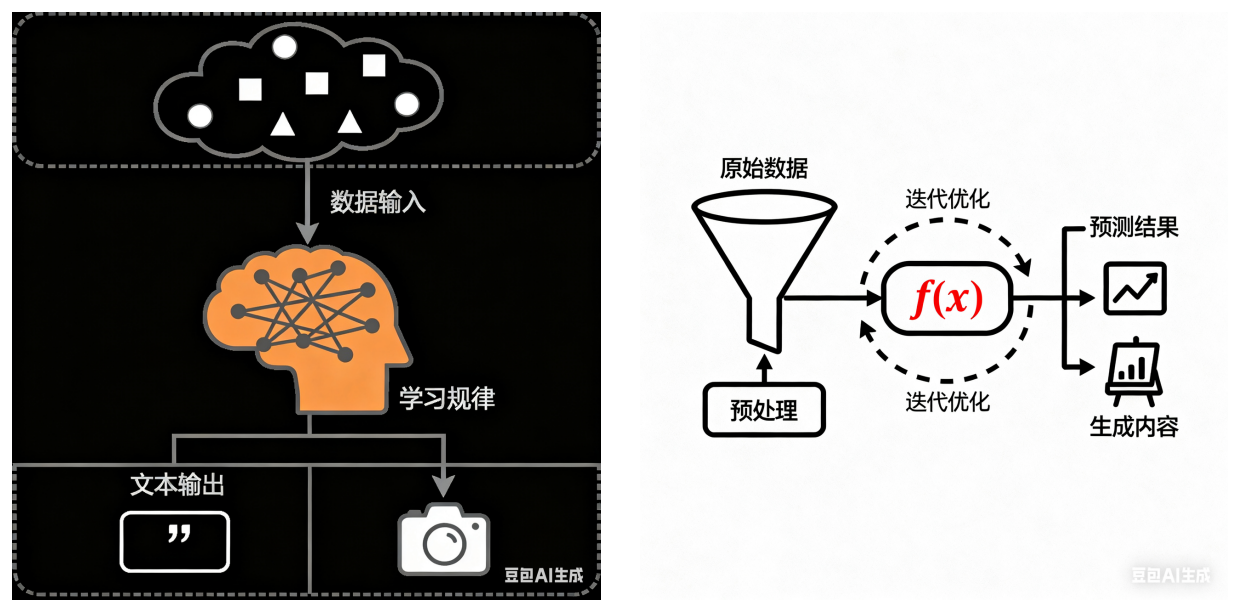

模型是一个从数据中学习规律的 “数学函数” 或 “程序”。旨在处理和生成信息的算法,通常模仿人类的认知功能。通过从大型数据集中学习模式和洞察,这些模型可以进行预测、生成文本、图像或其他输出,从而增强各个行业的各种应用。

可以简单理解为模型是一个 “超级加工厂”,这个工厂是经过特殊训练的,训练师给它看了海量的例子 (数据),并告诉它该怎么做。通过看这些例子,它自己摸索出了一套规则,学会了完成某个 “特定任务”。模型就是一套学到的 “规则” 或者 “模式”,它能根据你给的东西,产生你想要的东西。

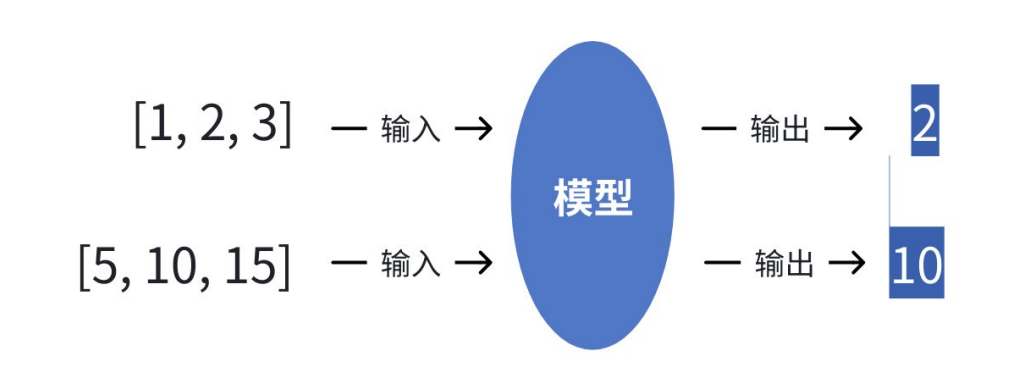

最简单的比喻:给模型很多组数据。

模型的任务就是找出输入和输出之间的规律 (比如:输出是中间那个数),学成之后,当我们再输入 [8, 9, 10] 时,它能根据学到的规律预测出输出应该是 9

模型的关键特点在于:

- 特定任务:一个模型通常只擅长用件事。

- 一个模型专门识别图片是不是猫。

- 一个模型专门预测明天会不会下雨。

- 一个模型专门判断一条评论是好评还是差评。

- 需要 “标注数据”:训练这种模型需要大量 “标准答案”。

- 成千上万张已经标注好 “是猫” 或 “不是猫” 的图片。

- 参数较少:参数是模型从数据中学到的 “知识要点” 或 “内部规则”。

- 上述示例中的规则仅是 “中间数”,参数较少说明模型的复杂度和能力相对有限。

二. 认识大语言模型

1. 什么是大语言模型

大语言模型 (Large Language Model,LLM) 是指基于大规模神经网络 (参数规模通常达数十亿至万亿级别,例如GPT-3包含1750亿参数),通过自监督或半监督方式,对海量文本进行训练的语言模型。

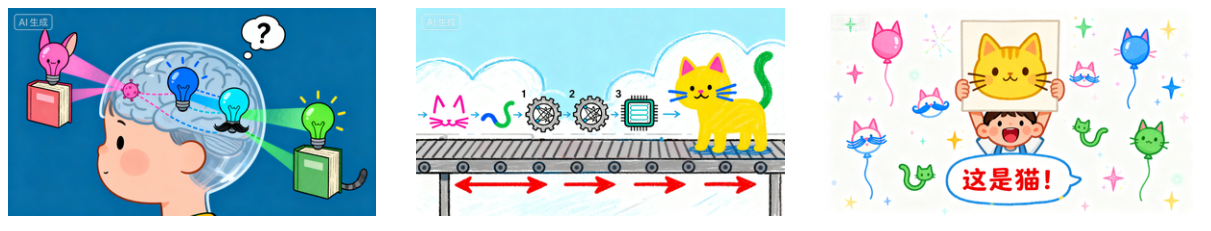

- 神经网络:一个极其高效的 “团队工作流程” 或 “条件反射链”。

例如教一个小朋友识别猫:

- 不会只给一条规则 (“有胡子就是猫”),因为兔子有胡子。

- 我们会让他看很多猫的图片,它大脑里的视觉神经会协同工作。

- 有的神经元负责识别 “尖耳朵”。

- 有的负责识别 “胡须”。

- 有的负责识别毛茸茸的 “尾巴”。

- 这些神经元一层层地传递和组合信息,最后大脑综合判断 “这是猫”。

神经网络就是模仿大脑的这种工作方式。

- 它由大量虚拟的 “神经元” (也就是参数) 和连接组成。

- 每个神经元都像一个小处理单元,负责处理一点点信息。无数个神经元分成很多层,前一层的输出作为后一层的输入。

- 通过海量数据的训练,这个网络会自己调整每个 “神经元” 的重要性 (即参数的值),最终形成一个非常复杂的 “判断流水线”。比如,一个识别猫的神经网络,某些参数可能专门负责识别猫的眼睛,另一些参数专门负责识别猫的轮廓。

简单说:神经网络就是一个通过数据训练出来的、由大量参数组成的复杂决策系统。

- 自监督学习:“完形填空” 超级大师。

例如我们想学会一门外语,但没有老师给出题和批改,怎么办?

- 我们可以拿一本该语言的小说,自己玩完形填空:随机盖住一个词,然后根据上下文猜测这个词是什么。

- 一开始猜得乱七八糟。

- 但不断地重复这个过程,看了成千上万本书后,对这个语言的语法、词汇搭配、上下文逻辑了如指掌。现在不仅能轻松猜对被盖住的词,甚⾄能自己写出流畅的文章。

自监督学习就是这个过程。

- 模型面对海量的、没有标签的原始文本 (互联网上的所有文章、网页)

- 它自己给自己创造任务:把一句话中间的某个词遮住,然后尝试根据前后的词来预测这个被遮住的词。

- 通过亿万次这样的练习,模型就深刻地学会了语言的规律。它不需要人类手动去给每句话标注 “这是主语”、“这是谓语”。

简单说:自监督就是让模型从数据本身找规律,自己给自己当⽼师。

- 半监督学习:“师父领进门,修行在个人”。

例如你想学做菜:

- 师傅先教你几道招牌菜 (麻婆豆腐、宫保鸡丁),这相当于给了你一些 “有标注的数据” (菜谱和成品)

- 然后,师傅让你去尝遍天下各种美食,自己研究其中的门道,这相当于接触海量的 “无标注数据” (各种未知的食材和味道)

- 你结合师傅教的基本功和自己尝遍天下美食的经验,最终不仅能完美复刻招牌菜,还能创新出新的菜式,这就是 “半监督”。

先用少量带标签的数据让模型 “入门”,掌握一些基本规则,然后再让它去海量的无标签数据中自我学习和提升。这对于大语⾔模型来说也是一种常用的训练方式。

简单说:半监督就是 “少量指导+大量自学” 的结合模式。

- 语言模型:一个 “超级自动补全” 或 “语言预测器”。

例如你在用手机打字,输入 “今天天气真”,输入法会自动提示 “好”、“不错”、“冷” 等。这个输入法之所以能提示,就是因为它内部有一个小型的 “语言模型”,它根据你输入的前文,计算下一个词最可能是什么。

语言模型的核心任务就是预测下一个词。一个强大的语言模型,能够根据一段话,预测出最合理、最通顺的下一个词是什么,这样一个个词接下去,就能生成一整段话、一篇文章。

简单说:语言模型就是一个计算 “接下来最可能说什么” 的模型。

现在,我们再回头看那段描述,就一目了然了,翻译成大白话就是,大语言模型是一个:

- 用 “超级团队工作流程” (大规模神经网络) 搭建的,拥有数百亿甚至上万亿个 “脑细胞” (参数) 的 “超级自动补全系统” (语言模型)

- 它学习的方式,主要是通过自己玩 “海量完形填空” (自监督学习),或者 “少量名师指导+海量自学” (半监督学习)

- 从互联网上所有的文本数据中学会了语⾔的规律。

因此,它具有以下几个核心特点:

- 规模巨大:它的 “脑细胞” (参数) 特别多 (通常达到数十亿甚至万亿级别),所以思考问题更复杂、更全面,就像一支百万大军和一个小分队的区别。

- 通用性强:它不是为单一任务训练的。因为它通过 “完形填空” 学会的是整个语言世界的底层规律 (语法、逻辑、知识关联),而不是只背会了 “猫的图片”。所以它能举一反三,把底层能力灵活应用到聊天、翻译、写代码等各种任务上。这种 “涌现” 能力,就像孩子通过大量阅读后,突然能写出意想不到的优美句子一样。

- 训练方式不同:主要使用自监督学习,从海量无标注的原始文本中学习。它不依赖人工一张张地给图片标明 “这是猫”,而是直接从原始文本中自学,效率极高,规模可以做得非常大。

- 交互方式革命:我们不用点按钮、写代码,直接像对人说话一样给它指令 (Prompt) 它就能听懂并执行,比如你直接说 “写一首关于春天的诗”,它就能给你写出来。

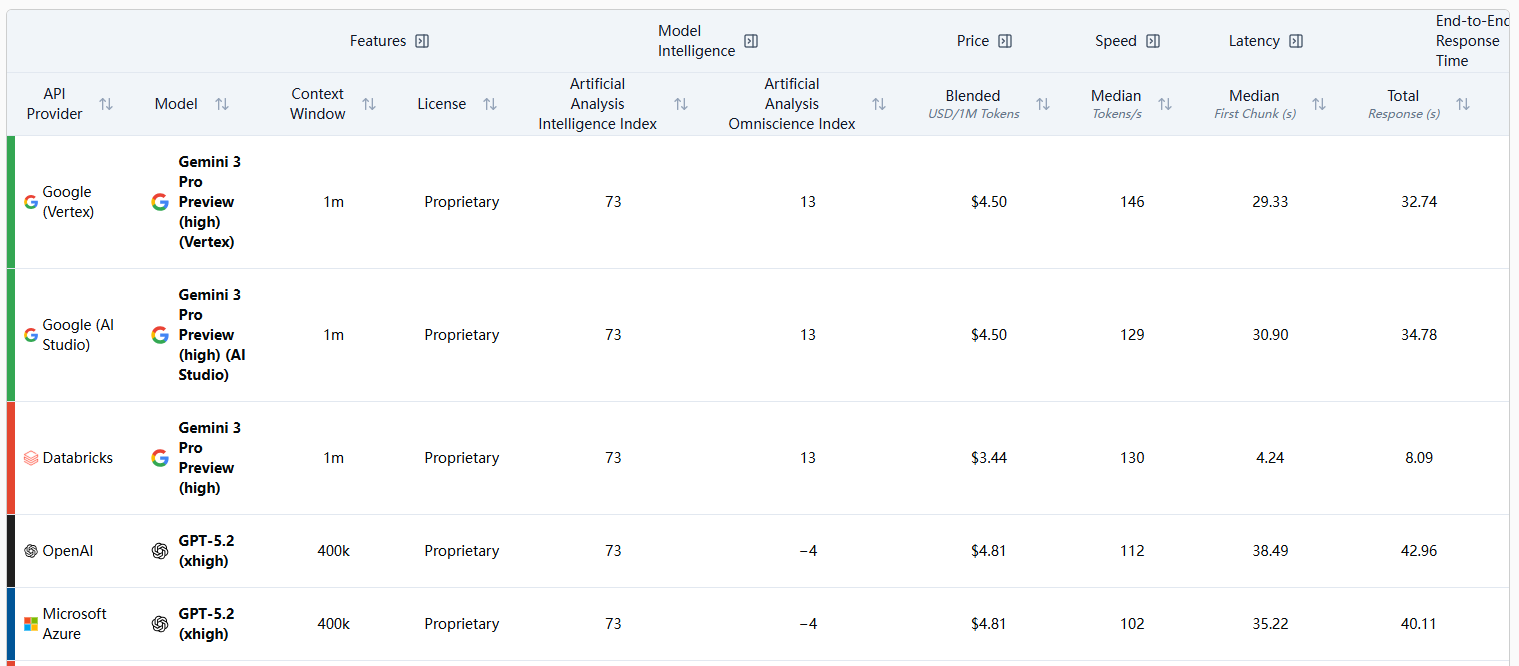

2. 主流的大语言模型

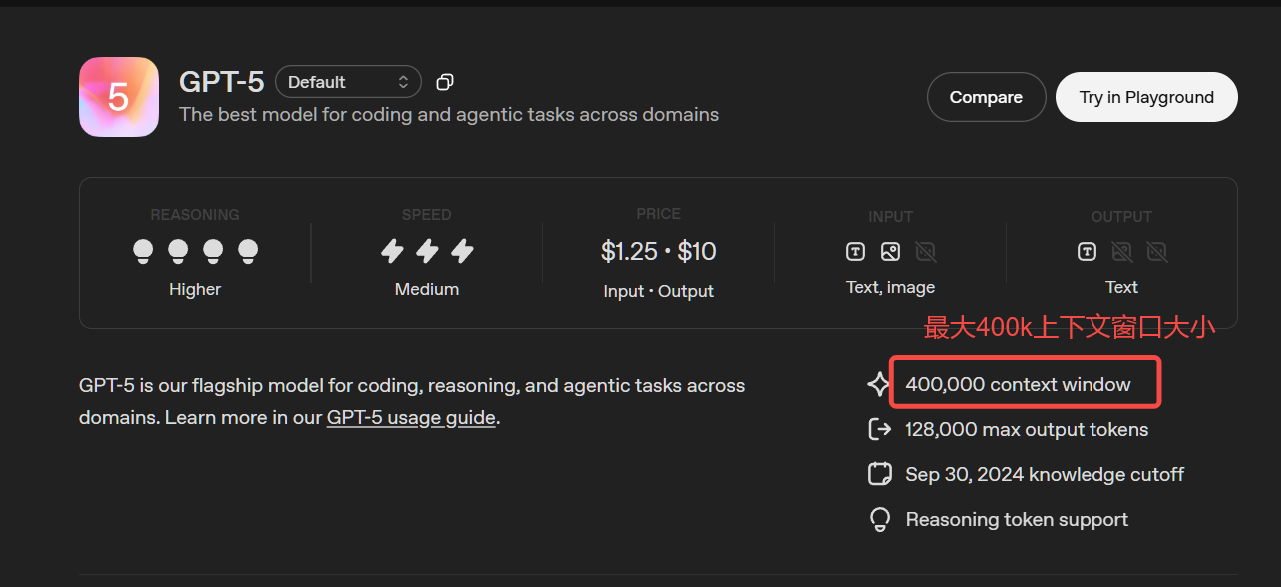

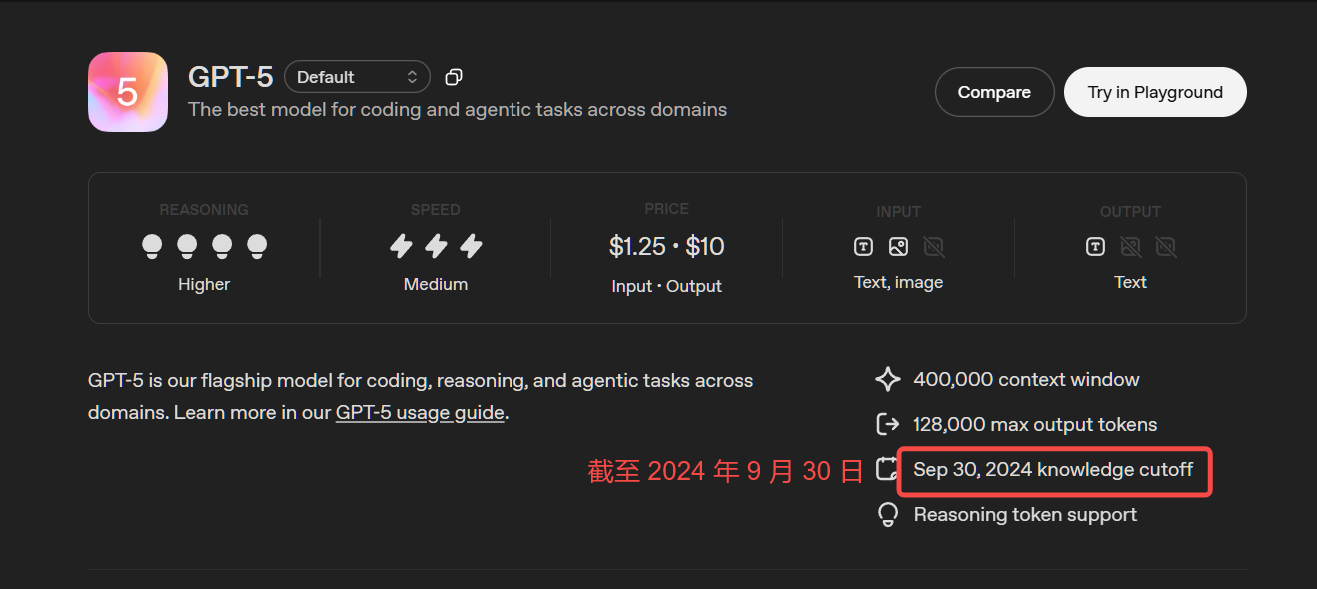

- GPT-5 (OpenAI):支持 400k 背景信息长度,128k 最大输出标记,在多轮复杂推理、创意写作中表现突出。

- DeepSeek R1 (深度求索):开源,专注于逻辑推理与数学求解,支持 128k 长上下文和多语言 (20+语言),在科技领域表现突出。

- Qwen2.5-72B-Instruct (阿里巴巴):通义千问开源模型家族重要成员,擅长代码生成结构化数据 (如JSON) 处理角色扮演对话等,尤其适合企业级复杂任务,支持包括中文英文法语等29种语言。

- Gemini 2.5 Pro (Google):多模态融合标杆,支持图像/代码/文本混合输入,适合跨模态任务 (如图文生成、技术文档解析)

Huggingface LLM 性能排行榜:https://huggingface.co/spaces/ArtificialAnalysis/LLM-Performance-Leaderboard

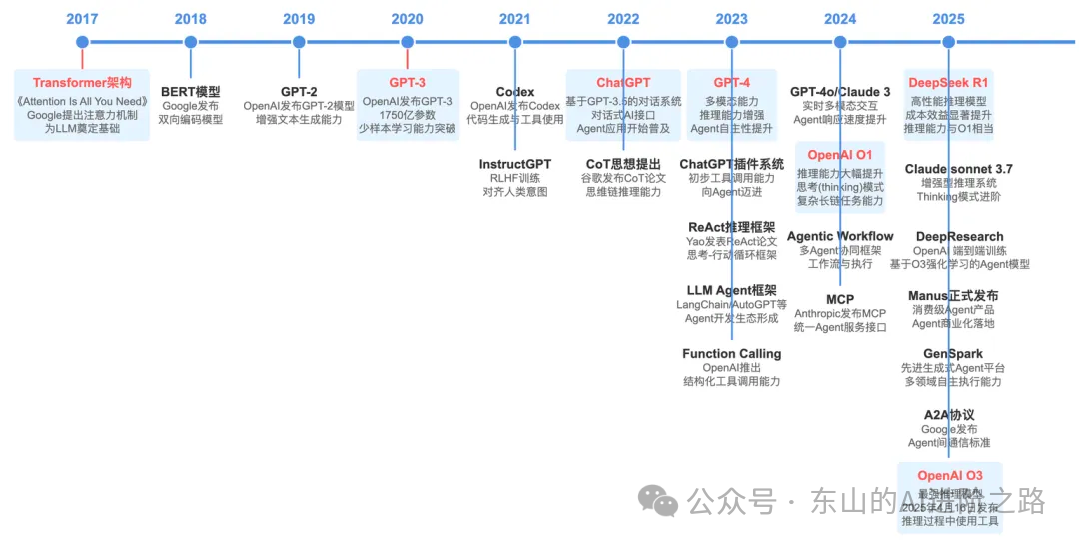

发展历程参考:https://segmentfault.com/a/1190000046532208

3. LLM 的能力包括哪些?

大模型,对不少人来说已变得耳熟能详,从大型科技公司到初创企业,都纷纷投身于这场技术变革。

AI 大模型不仅仅是技术圈的热门话题,它也正日新月异的速度⼊融入我们的日常生活,改变着我们获取信息、处理工作、甚至进行创作的方式。

我们将大模型的力归纳为四点,这不仅仅是技术指标,更是它改变世界的核心利器。

3.1 语言大师:理解与创造的革命

想象一下,你是否发生过以下类似问题:

- 对学生:你是否为论文的开头绞尽脑汁?

- 对职场人:一封礼貌又坚决的投诉邮件怎么写?

LLM 可以干什么?对于:

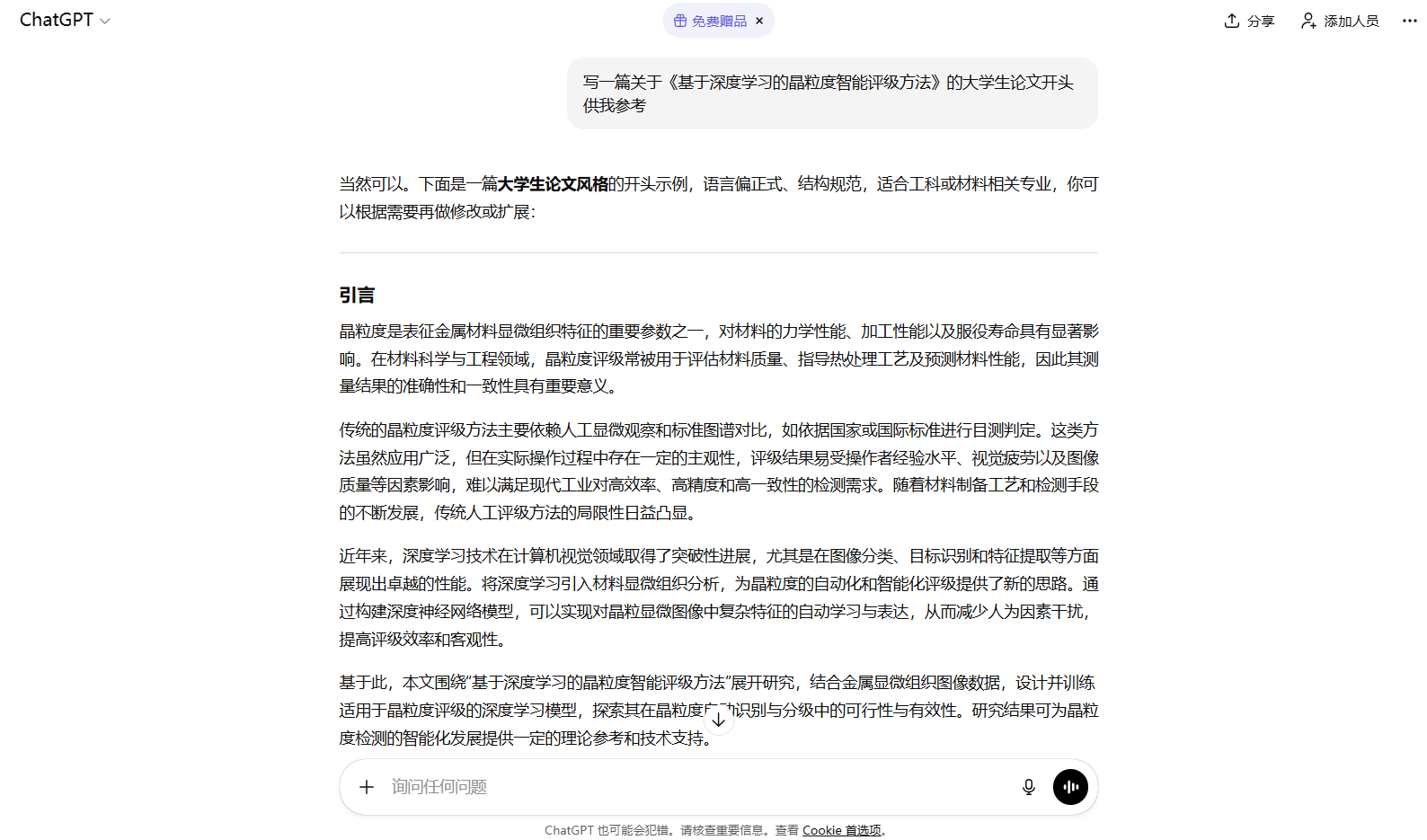

- 论文的开头:告诉大模型你的主题和观点,它能为你⽣成几个不同风格的引言段落。例如:“写一篇关于《基于深度学习的晶粒度智能评级方法》的大学生论文开头供我参考”

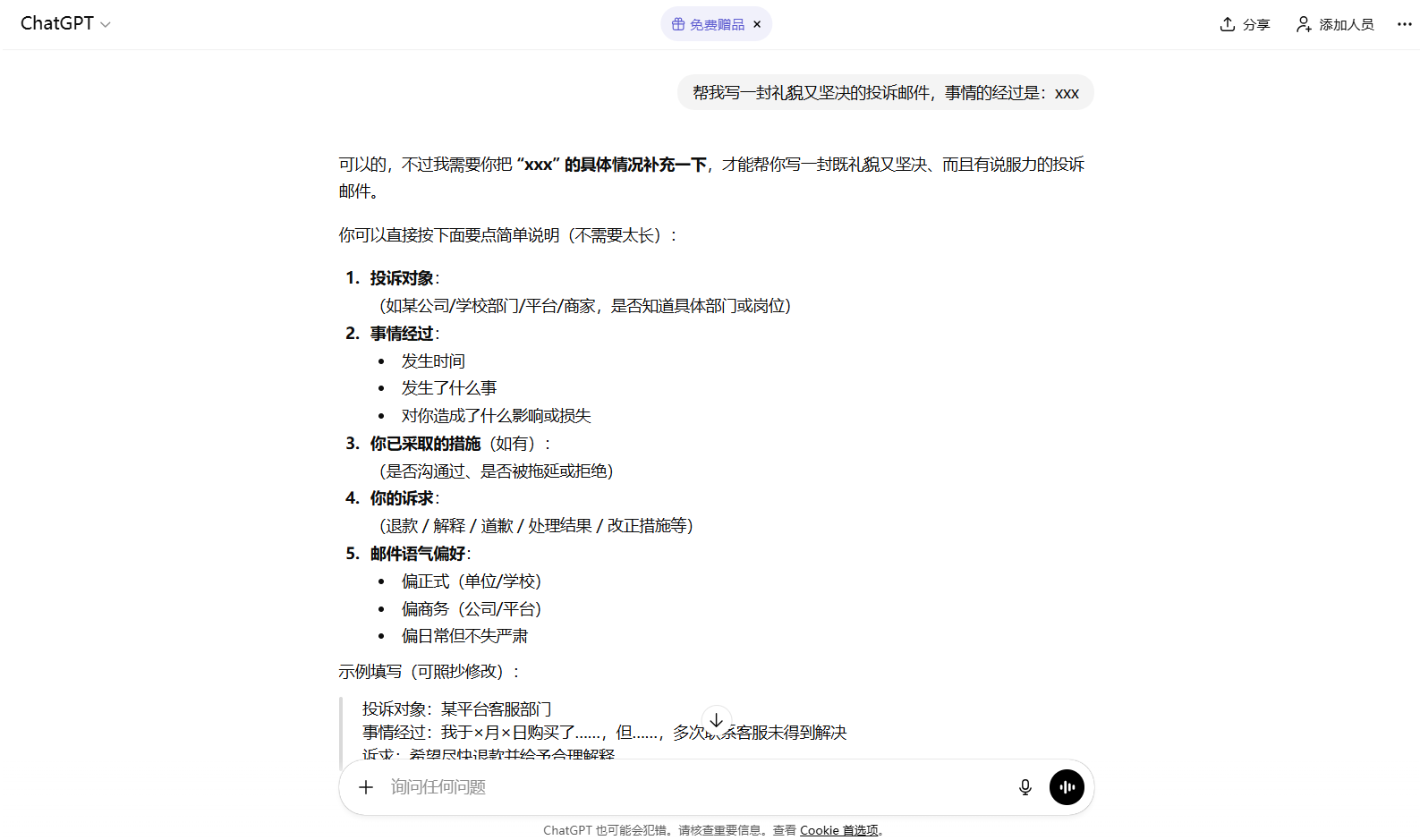

- 投诉邮件:把情况告诉它,它即刻生成,你稍作修改就能发送。例如:“帮我写一封礼貌又坚决的投诉邮件,事情的经过是:xxx”

我们发现,它真正 “读懂” 了人类语言的千变万化,并能进行高质量创作。这不是简单的关键词匹配,而是理解了上下文、情感甚至潜台词。

3.2 知识巨人:拥有 “全互联网” 的记忆

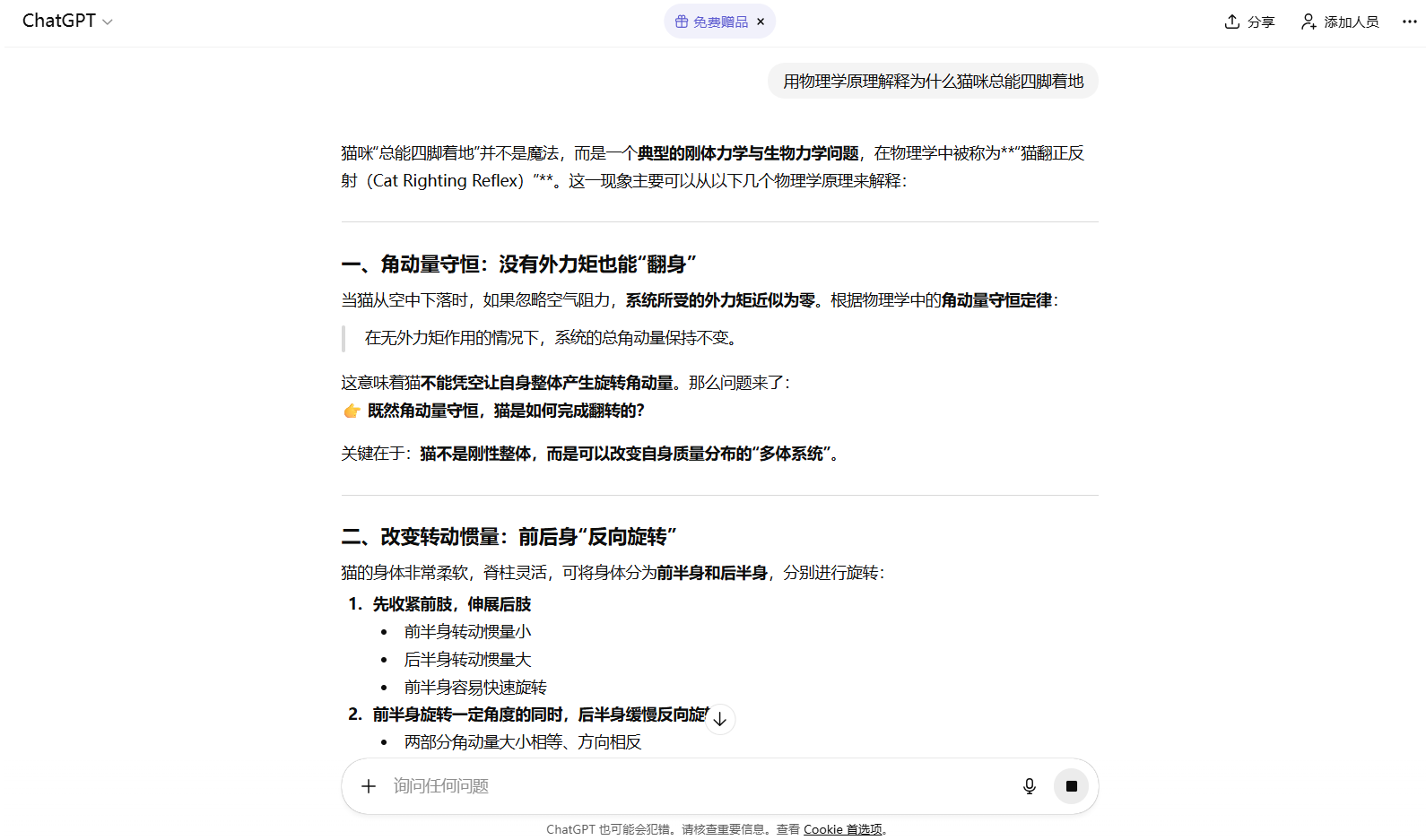

我们可以问它:“用物理学原理解释为什么猫咪总能四脚着地”。它不仅能回答,还能类比。

我们可以让它:“对比一下古希腊哲学和春秋战国百家争鸣的异同”。它能为我们提供清晰的思路。

可以看出,大模型是一个被压缩的、可对话的 “互联网知识库”。它通过学习海量数据,将知识内在关联,形成了一个立体的知识网络,而不仅仅是存储。

3.3 逻辑与代码巫师:从思维到实现的跨越

一个复杂的功能,对程序员来说,只需用中文描述:“写一个 Python 函数,能自动爬取某个网页的最新标题并保存到 Excel 里”。代码瞬间生成。

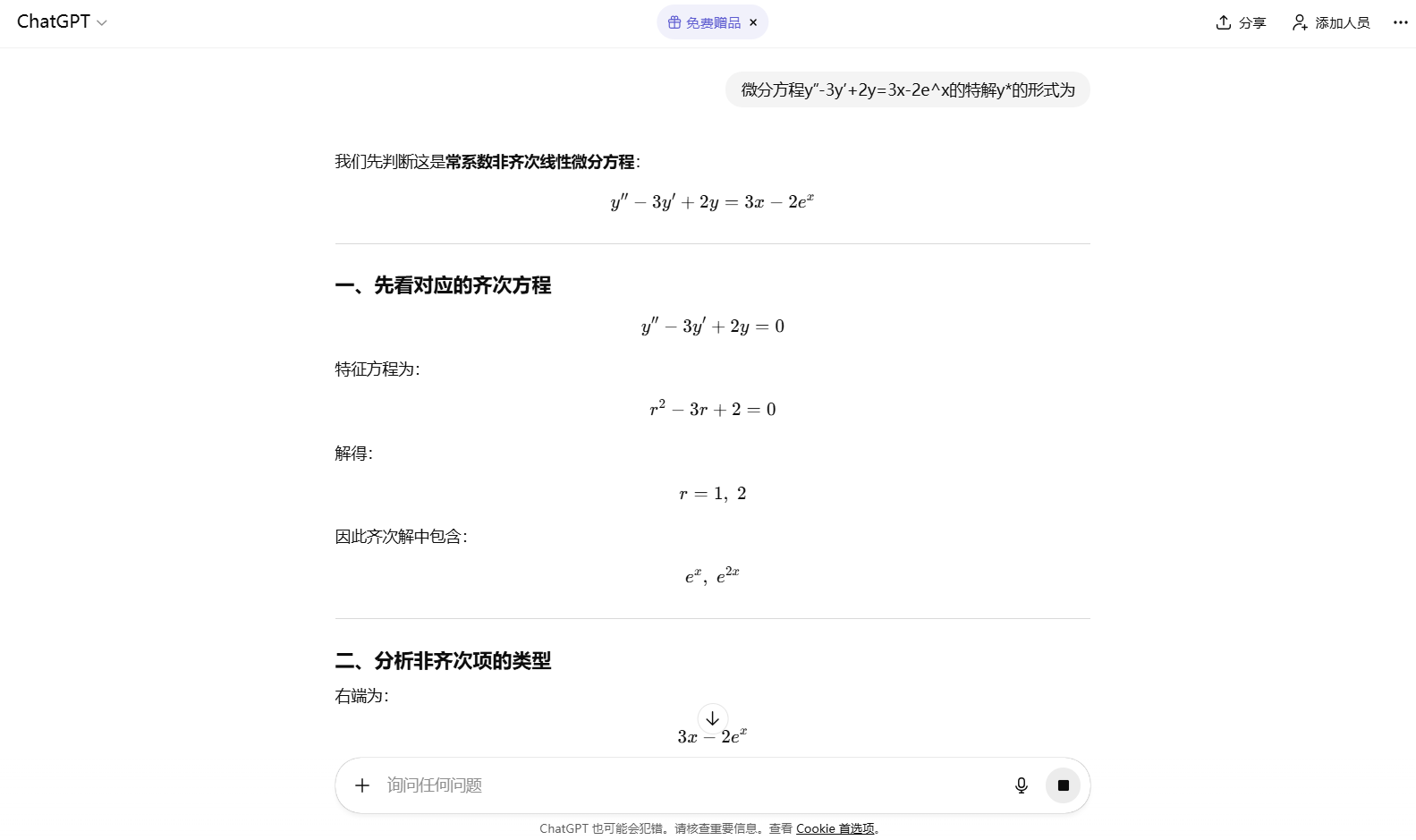

我们可以把一道复杂的数学题丢给它,如 “微分方程y”-3y’+2y=3x-2e^x的特解y*的形式为",它不仅能给出答案,还能一步步展示解题过程,成为你的私人家教。

可以看出,大模型不仅能处理语言,还能处理严格的逻辑和编程语法。这证明了它的能力超越了 “文科”,进入了需要精确和推理的 “理科” 领域。

3.4 多模态先知:开启 “全感知” AI 的大门

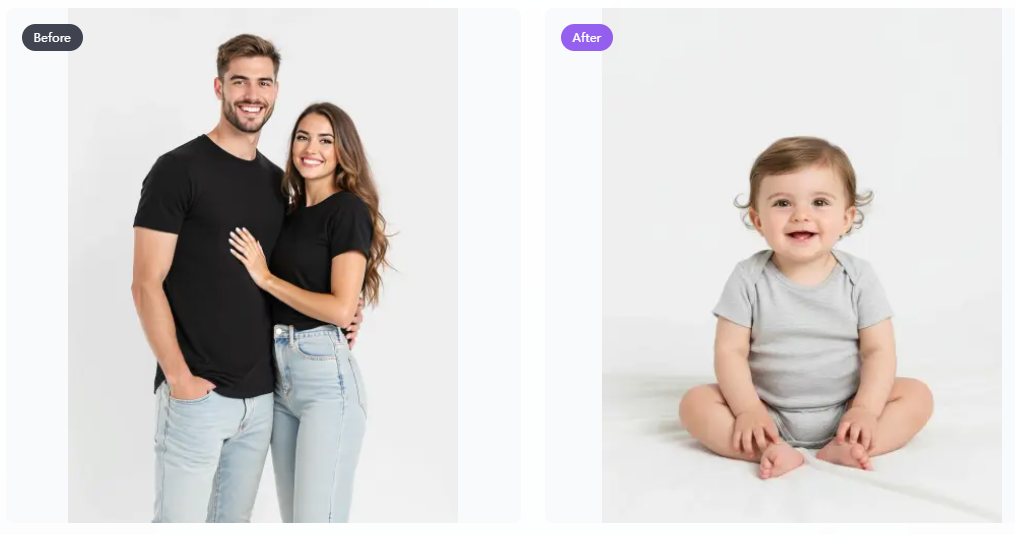

想象一下,上传一张照片,再加入一段描述,AI 可实现快速的对话式创意工作流程。

- AI 婴儿预测和生成:“生成他们的宝宝的样子 - 父母双方特征的融合。专业的照片质量”。

- 3D 图形:“请把这张照片变成一个人物。在它后面,放置一个印有角色形象的盒子。在它旁边,添加一台计算机,其屏幕显示 Blender 建模过程。在盒子前面,为人偶添加一个圆形塑料底座,让它站在上面。底座的 PVC 材质应具有晶莹剔透、半透明的质感,并将整个场景设置在室内”。

可以看到,它打破 “文本” 的界限,连接视觉、听觉的世界,让 AI 更接近人类的感知方式。这是目前最前沿、最令人兴奋的能力,它让 AI 真正成为 “全能型” 助手。

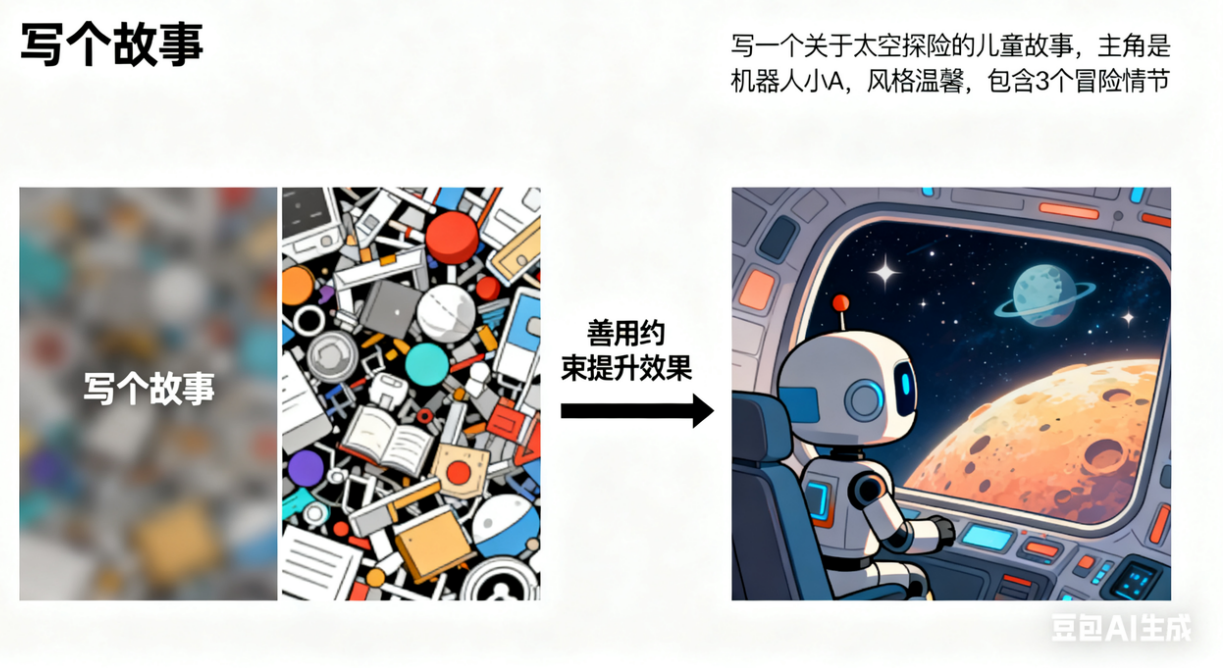

4. 提示词编写技巧

编写合理且有效的提示词,是我们与 AI 进行有效对话的第一步,好的提示词能显著提升模型输出的质量和相关性。宗旨就是:将你的问题限定范围,让 AI 知道你要的答案具体要包含什么,提示词效果会大幅提升。

核心在于换位思考:想象 AI 对你提供的信息一无所知,你需要清晰、具体、无歧义地告诉它你要什么、在什么背景下、以什么方式呈现。善用示例、角色扮演、具体约束和迭代优化。

提示技巧不止一种,掌握多种技巧,并根据不同任务灵活组合使用,才是成为提示词高手的秘诀。

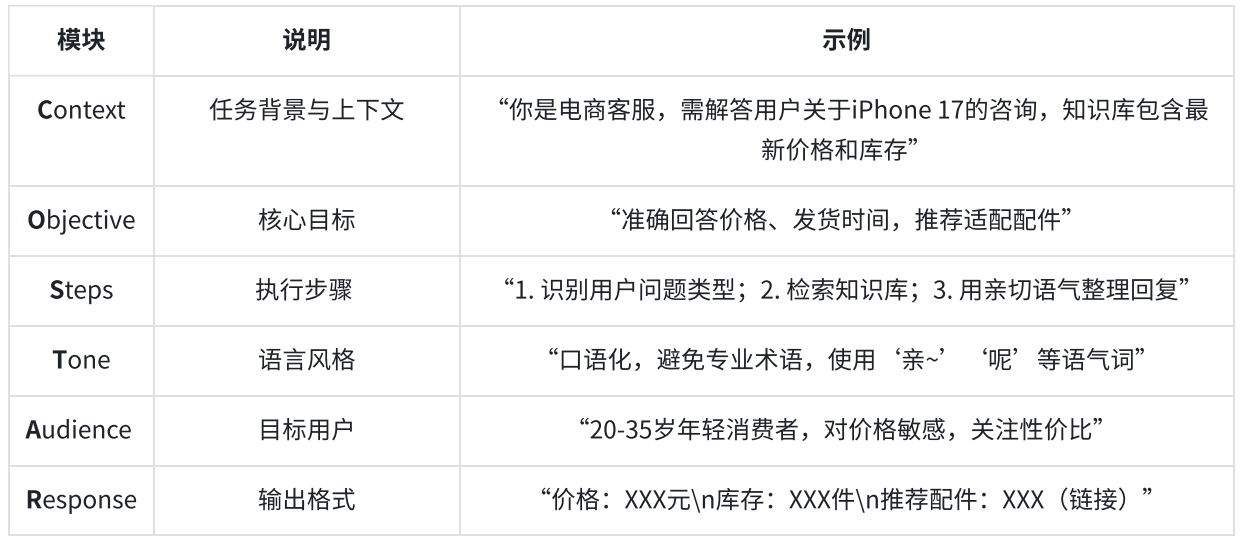

4.1 CO-STAR 结构化框架

在目标设定和问题解决的场景下,清晰性和结构性是至关重要的。而有一种方法论,在这些方面表现都非常出色,那就是 CO-STAR 框架。这个提示词编写框架,由新加坡政府技术局 (GovTech) 的数据科学与 AI 团队开发,重点在于确保提供给 LLM 的提示词是全面且结构良好的,从而生成更相关和准确的回答。

CO-STAR 可以拆解为六个维度。

例如,我需要进行健康咨询,希望给出营养建议。那么我可以这样构建提示词:

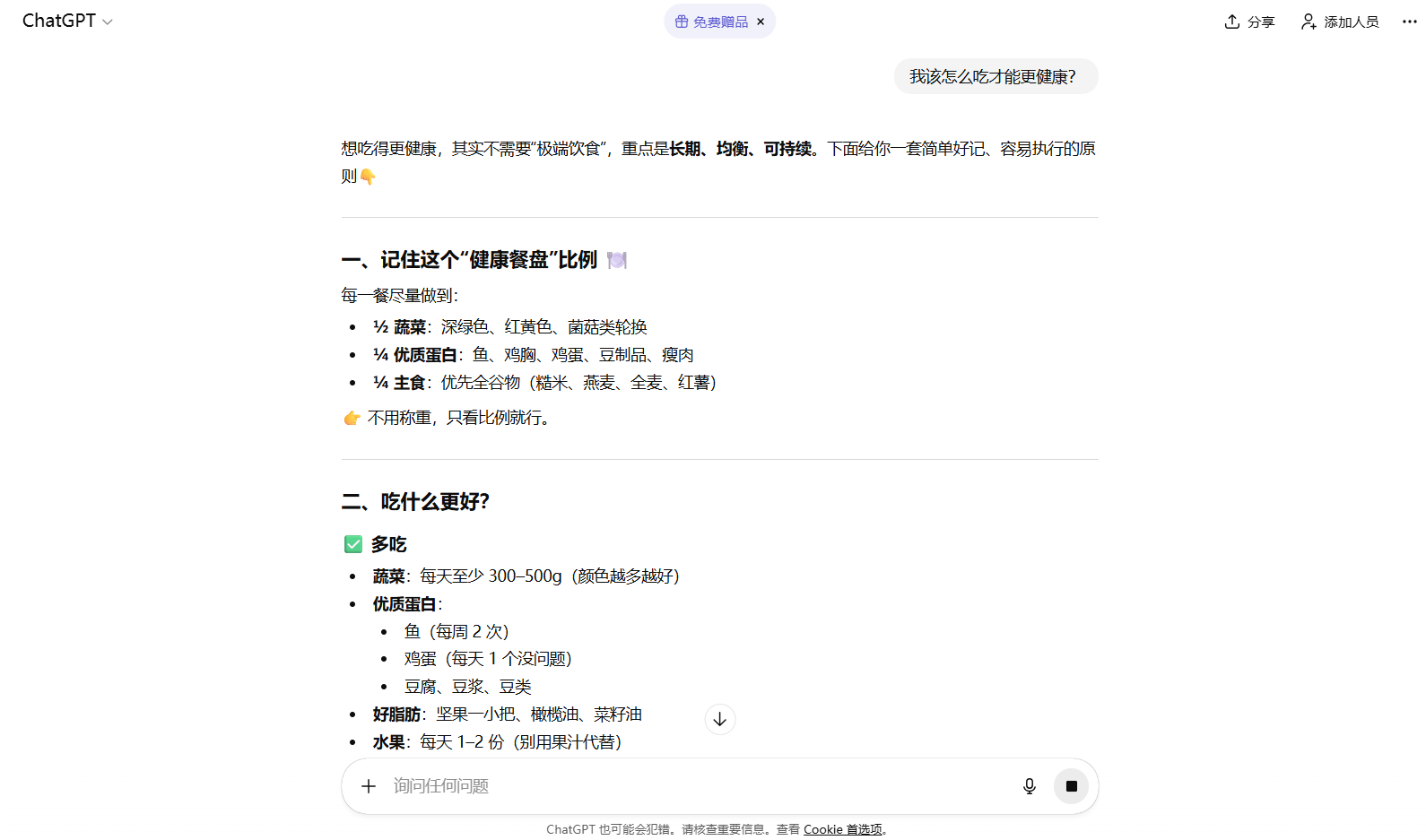

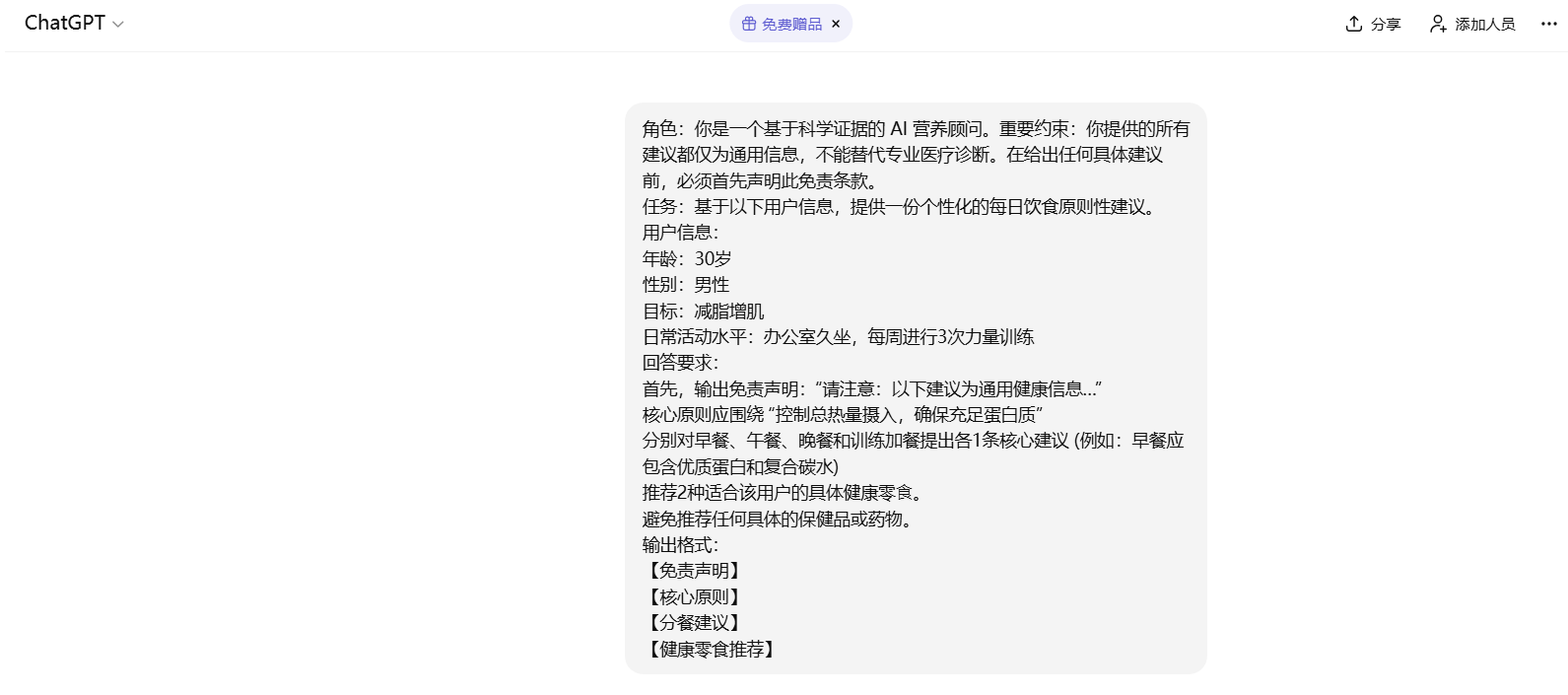

优化前 (模糊、低效):我该怎么吃才能更健康?

优化后 (清晰、有效):

- 角色:你是一个基于科学证据的 AI 营养顾问。重要约束:你提供的所有建议都仅为通用信息,不能替代专业医疗诊断。在给出任何具体建议前,必须首先声明此免责条款。

- 任务:基于以下用户信息,提供一份个性化的每日饮食原则性建议。

- 用户信息:

- 年龄:30岁

- 性别:男性

- 目标:减脂增肌

- 日常活动水平:办公室久坐,每周进行3次力量训练

- 回答要求:

- 首先,输出免责声明:“请注意:以下建议为通用健康信息…”

- 核心原则应围绕 “控制总热量摄入,确保充足蛋白质”

- 分别对早餐、午餐、晚餐和训练加餐提出各1条核心建议 (例如:早餐应包含优质蛋白和复合碳水)

- 推荐2种适合该用户的具体健康零⻝。

- 避免推荐任何具体的保健品或药物。

- 输出格式:

- 【免责声明】

- 【核心原则】

- 【分餐建议】

- 【健康零食推荐】

4.2 少样本提示/多示例提示

这种方式通过给 AI 提供一两个 输入-输出 的例子,让它 “照葫芦画瓢”。

- 核心思想:你不是在给它下指令,而是在 “教” 它你想要的格式、风格和逻辑。

- 适用场景:格式固定、风格独特、逻辑复杂的任务,如风格仿写、数据提取、复杂格式生成。

例如:

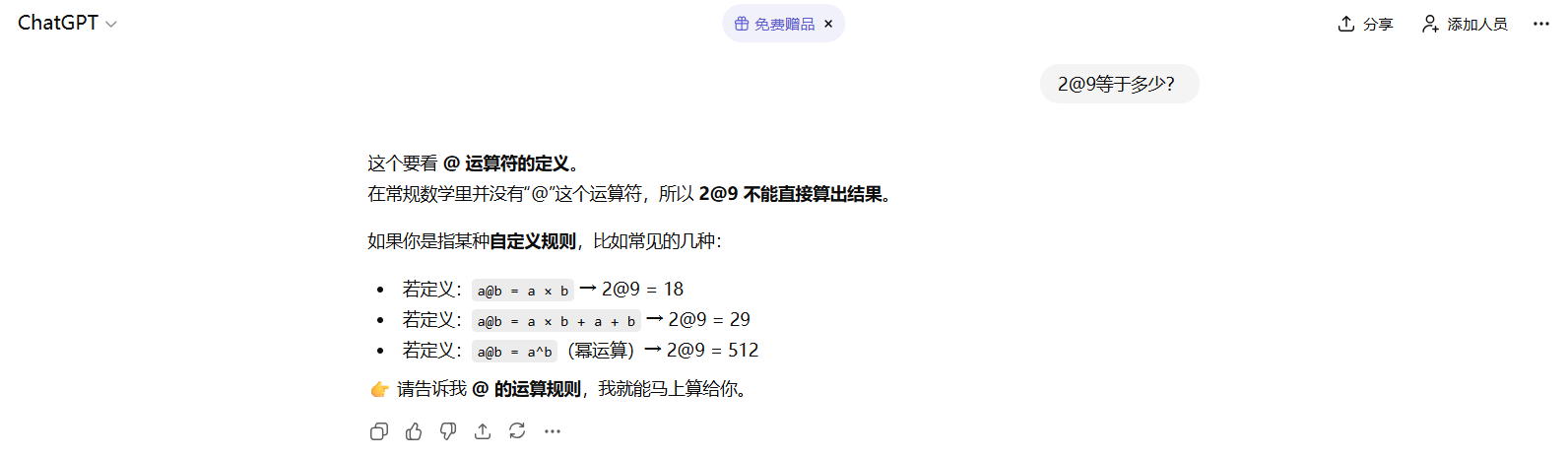

优化前 (零样本提示):2@9等于多少?

优化后 (少样本提示):

根据以下示例,处理问题。

- 示例1:2@3 = 5

- 示例2:4@7 = 11

现在请分析这个:2@9 等于多少?

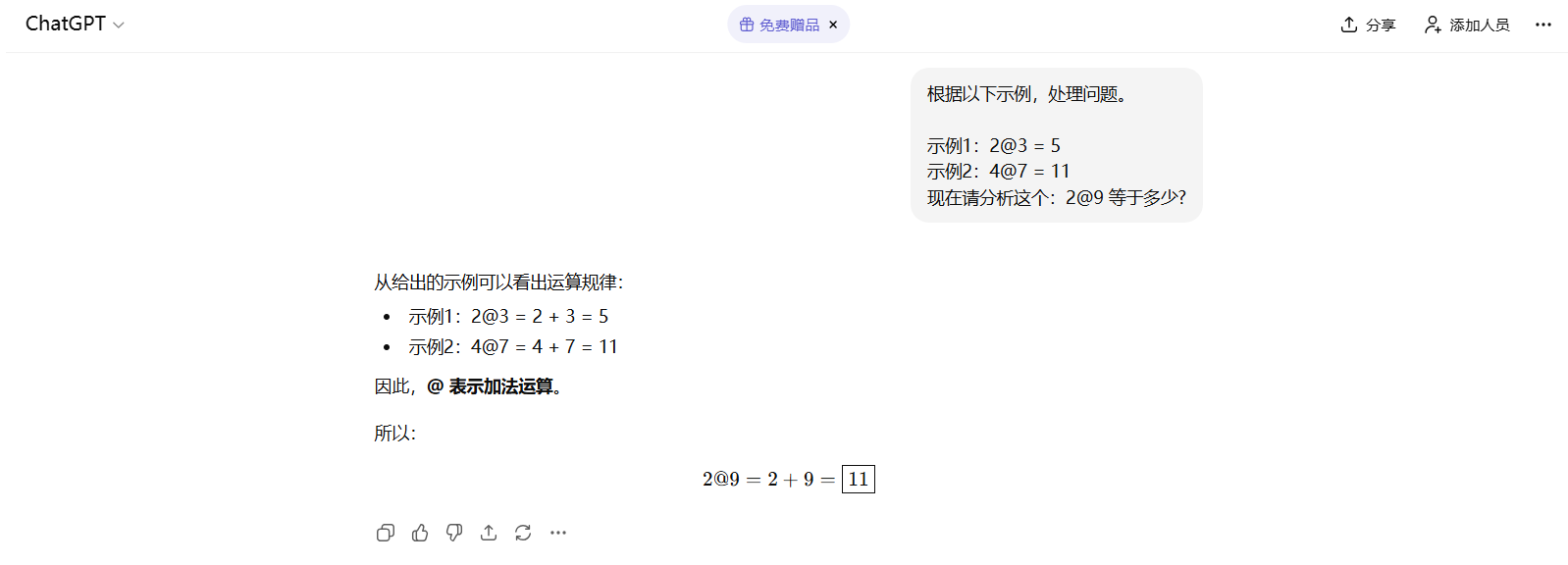

再例如:

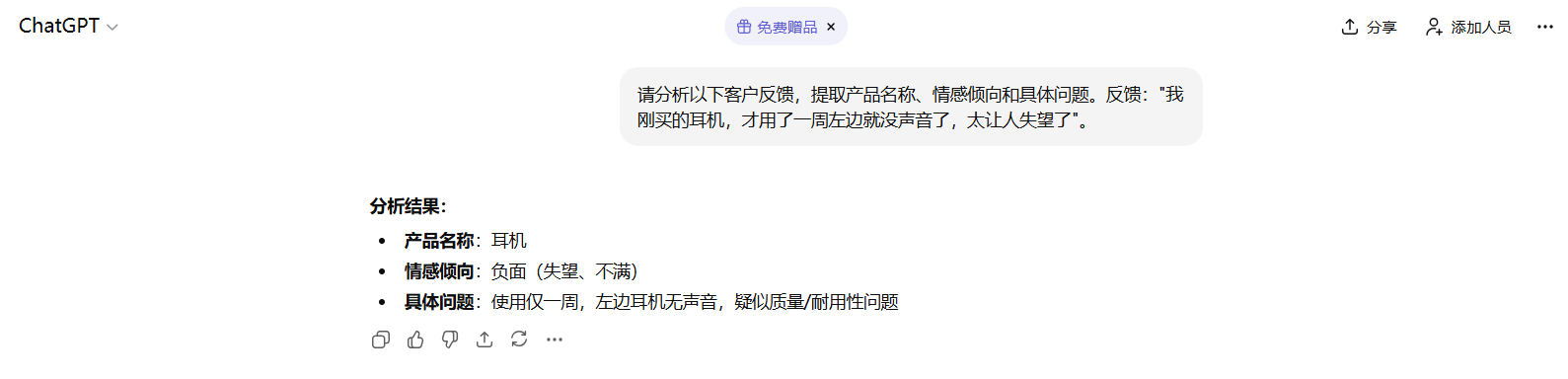

优化前 (零样本提示):

请分析以下客户反馈,提取产品名称、情感倾向和具体问题。反馈:“我刚买的耳机,才用了一周左边就没声音了,太让人失望了”。

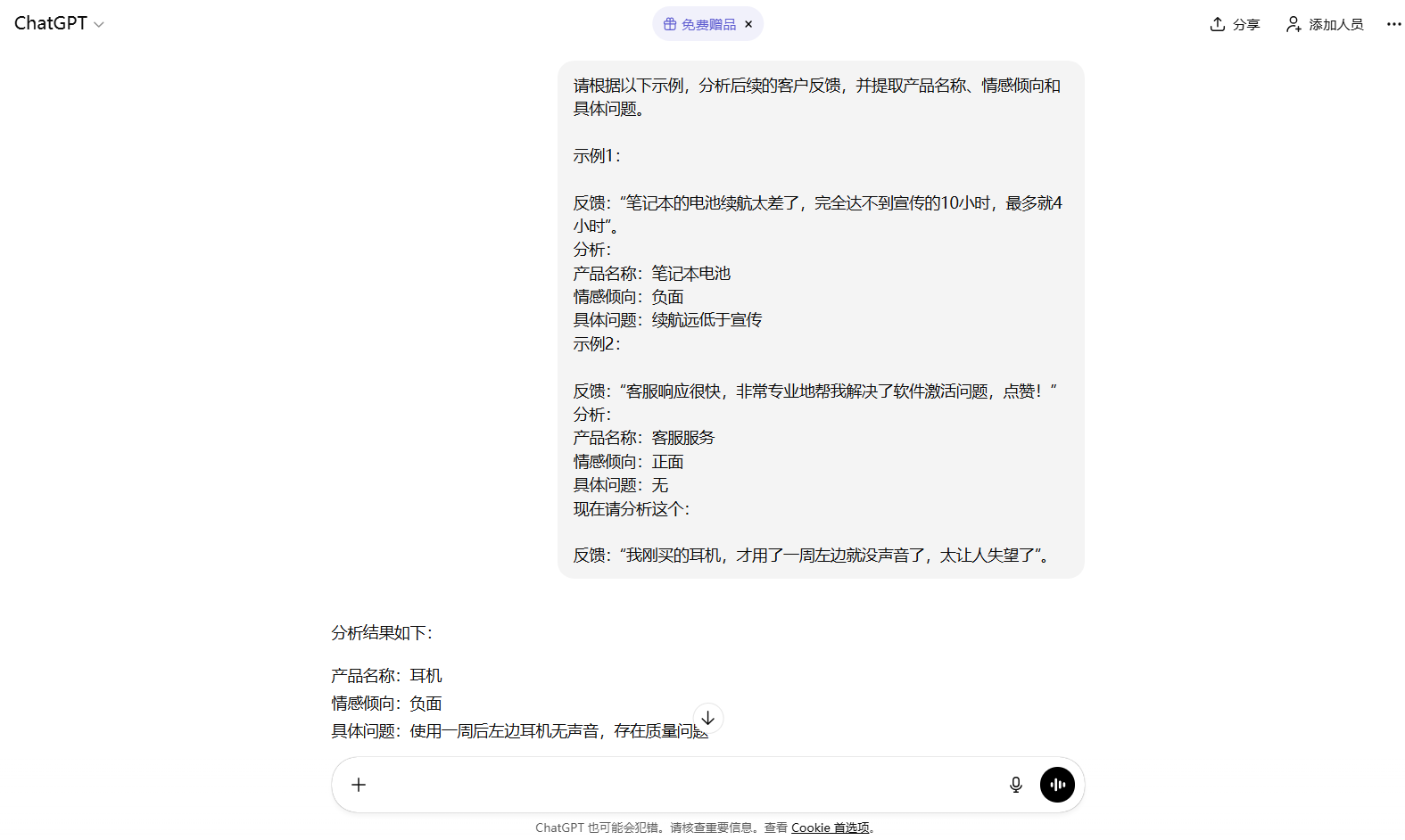

优化后 (少样本提示):

请根据以下示例,分析后续的客户反馈,并提取产品名称、情感倾向和具体问题。

示例1:

- 反馈:“笔记本的电池续航太差了,完全达不到宣传的10小时,最多就4小时”。

- 分析:

- 产品名称:笔记本电池

- 情感倾向:负面

- 具体问题:续航远低于宣传

示例2:

- 反馈:“客服响应很快,非常专业地帮我解决了软件激活问题,点赞!”

- 分析:

- 产品名称:客服服务

- 情感倾向:正面

- 具体问题:无

现在请分析这个:

- 反馈:“我刚买的耳机,才用了一周左边就没声音了,太让人失望了”。

通过示例,AI 清晰地学会了 “产品名称” 如何概括,“情感倾向” 的标签是什么,“具体问题” 如何简洁描述。这比单纯用文字描述规则要有效得多。

4.3 思维链提示

提示工程的关键目标是让 AI 更好地理解复杂语义。这种能力的高低,可以直接通过模型处理复杂逻辑推理题的表现来检验。

可以这样理解:当好的提示词能帮助模型解决原本解决不了的难题时,就说明它确实提升了模型的推理水平。并且,提示词设计得越出色,这种提升效果就越显著。通过设置不同难度的推理测试,可以很清晰地验证这一点。

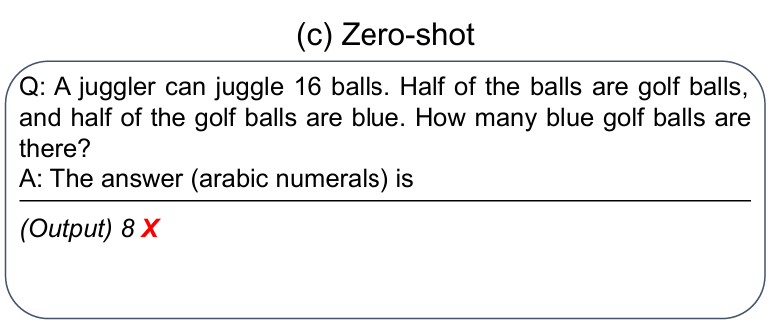

举个例子 (该示例来自论文:Large Language Models are Zero-Shot Reasoners):

- 翻译一下问题:杂耍者可以杂耍16个球。其中一半的球是高尔夫球,其中一半的高尔夫球是蓝色的。请问总共有多少个蓝色高尔夫球?

- 推理结果:8个蓝色高尔夫球。

可以看到,答案错误。该逻辑题的数学计算过程并不复杂,但却设计了一个语言陷阱,即一半的一半是多少。

现在是可以解决的,如下:

为了解决类似的逻辑问题,可以使用思维链提示。思维链提示相较于少样本提示是一种更好的提示方法,思维链提示最常用的两种方式:

- Few-shot-CoT:少样本思维链。

- Zero-shot-CoT:零样本思维链。

相比于少样本提示 (Few-shot),少样本思维链 (Few-shot-CoT) 的不同之处只是在于需要在提示样本中不仅给出问题的答案、还同时需要给出问题推导的过程 (即思维链),从而让模型学到思维链的推导过程,并将其应用到新的问题中。此技巧主要用于解决复杂推理问题,如数学、逻辑或多步骤规划。

- 核心思想:要求 AI “展示其工作过程”,而不是直接给出最终答案。这模仿了人类解决问题时的思考方式。

- 适用场景:数学题、逻辑推理、复杂决策、需要解释过程的任务。

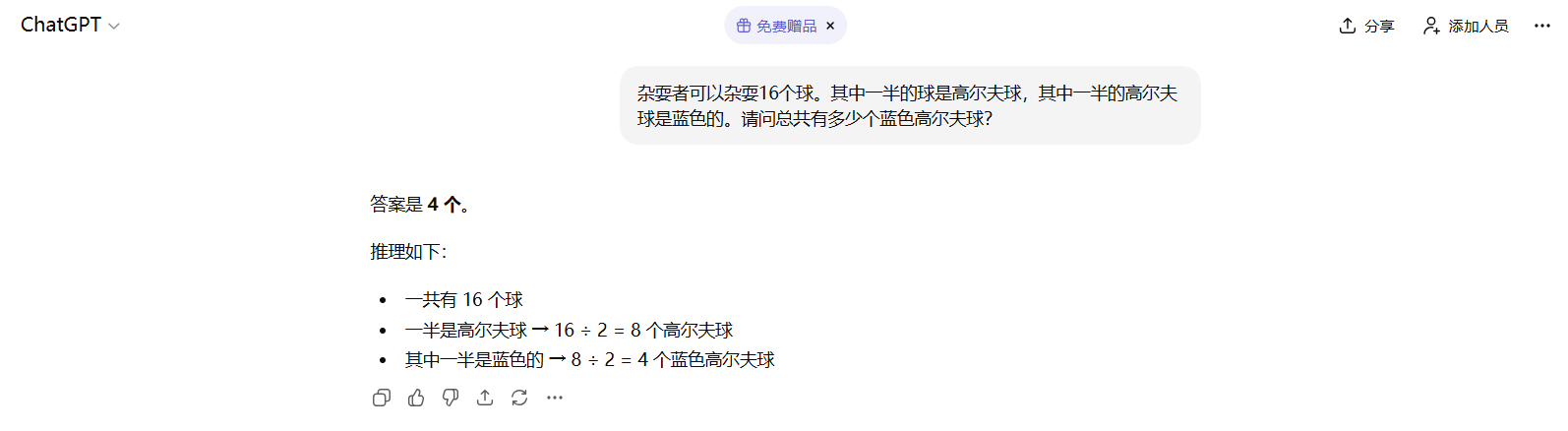

例如,手动写一个思维链作为少样本提示的示例:

- Q:“罗杰有五个网球,他又买了两盒网球,每盒有3个网球,请问他现在总共有多少个网球?”

- A:“罗杰起初有五个网球,又买了两盒网球,每盒3个,所以,他总共买了2×3=6个网球,将起始的数量和购买的数量相加,可以得到他现在总共的网球数量:5+6=11,所以罗杰现在总共有11个网球”

在获得了一个思维链示例后,就可以以此作为样本进行 Few-shot-CoT 来解决第二个推理问题,如下所示:

示例1:

- Q:“罗杰有五个网球,他又买了两盒网球,每盒有3个网球,请问他现在总共有多少个网球?”

- A:“罗杰起初有五个网球,又买了两盒网球,每盒3个,所以,他总共买了2×3=6个网球,将起始的数量和购买的数量相加,可以得到他现在总共的网球数量:5+6=11,所以罗杰现在总共有11个网球”

问:“食堂总共有23个苹果,如果他们用掉20个苹果,然后又买了6个苹果,请问现在食堂总共有多少个苹果?”

结果如下:

通过这个例子可以观察到,这就好像是 “把答案告诉了AI”。从某种意义上说,是的,你告诉它的是 “回答这个问题的正确方式和步骤”,而不仅仅是最终的答案,AI 会模仿你提供的范本结构和逻辑,来解决新问题。

实际上,Few-shot-CoT 的方式虽然有效,但不一定是稳定且准确的。如果想要得到稳定的正确答案,需要更高阶的提示方法。你给的例子越详细,它模仿得就越像,这更像是一种 “教学” 或 “格式

化”。当你有一个非常复杂的逻辑流程,或者你希望 AI 严格按照某种格式 (比如先分析A,再对比B,最后总结C) 来输出时,就可以直接提供一个完美的 “思考过程” 作为范例。

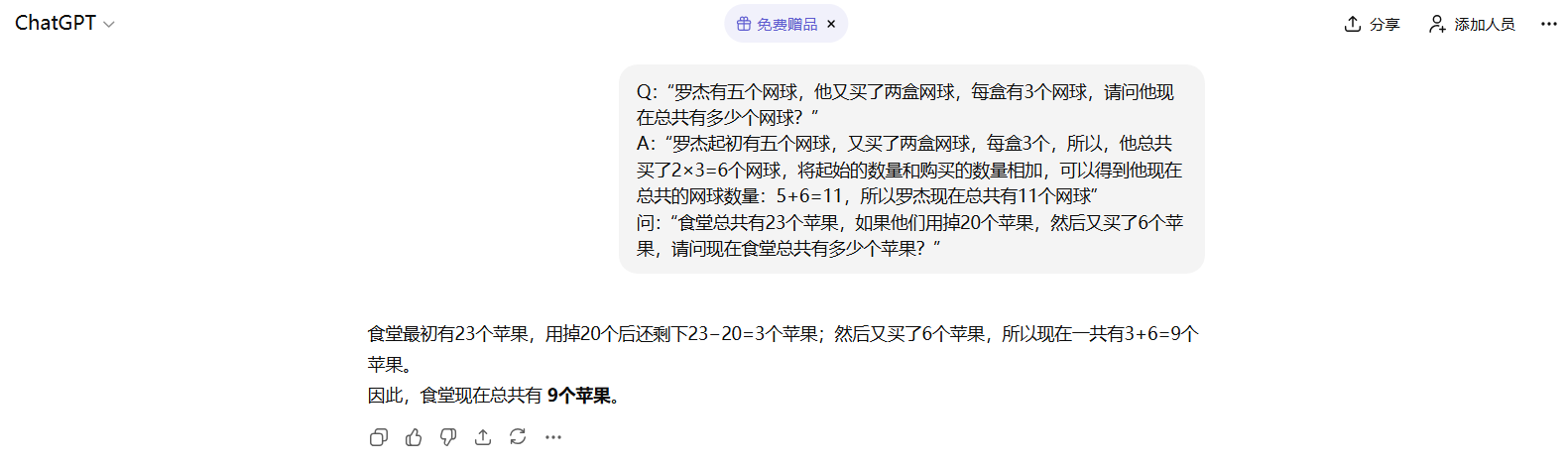

4.4 自动推理与零样本链式思考

零样本思维链 (Zero-shot-CoT) 这是少样本思维链 (Few-shot-CoT) 的简化版。只需在提示词末尾加上一句魔法短语,即可激发 AI 的推理能力。

- 核心思想:通过指令 “请一步步进行推理并得出结论”,强制 AI 在给出答案前先进行内部推理。

- 适用场景:任何需要一点逻辑思考的问题,即使你不太清楚具体步骤。

例如:罗杰有五个网球,他又买了两盒网球,每盒有3个网球,请问他现在总共有多少个网球?请一步步进行推理并得出结论。

“一步步进行推理” 这个指令,相当于在引导模型的 “注意力机制”。它告诉模型:“在生成最终答案之前,请先在你的 “脑海” 里 (即生成的文本序列中) 模拟出一个缓慢、有序的推理上下文”。

当模型开始输出 “第一步…第⼆步…” 时,它实际上是在为自己创造一个更丰富、更逻辑化的上下文。它在这个自己创造的优质上下文中进行推理,最终得出的结论自然比在贫瘠的上下文中 (只有原始问题) 更准确。

根据《Large Language Models are Zero-Shot Reasoners》论文中的结论,从海量数据的测试结果来看,Few-shot-CoT 比 Zero-shot-CoT 准确率更高。

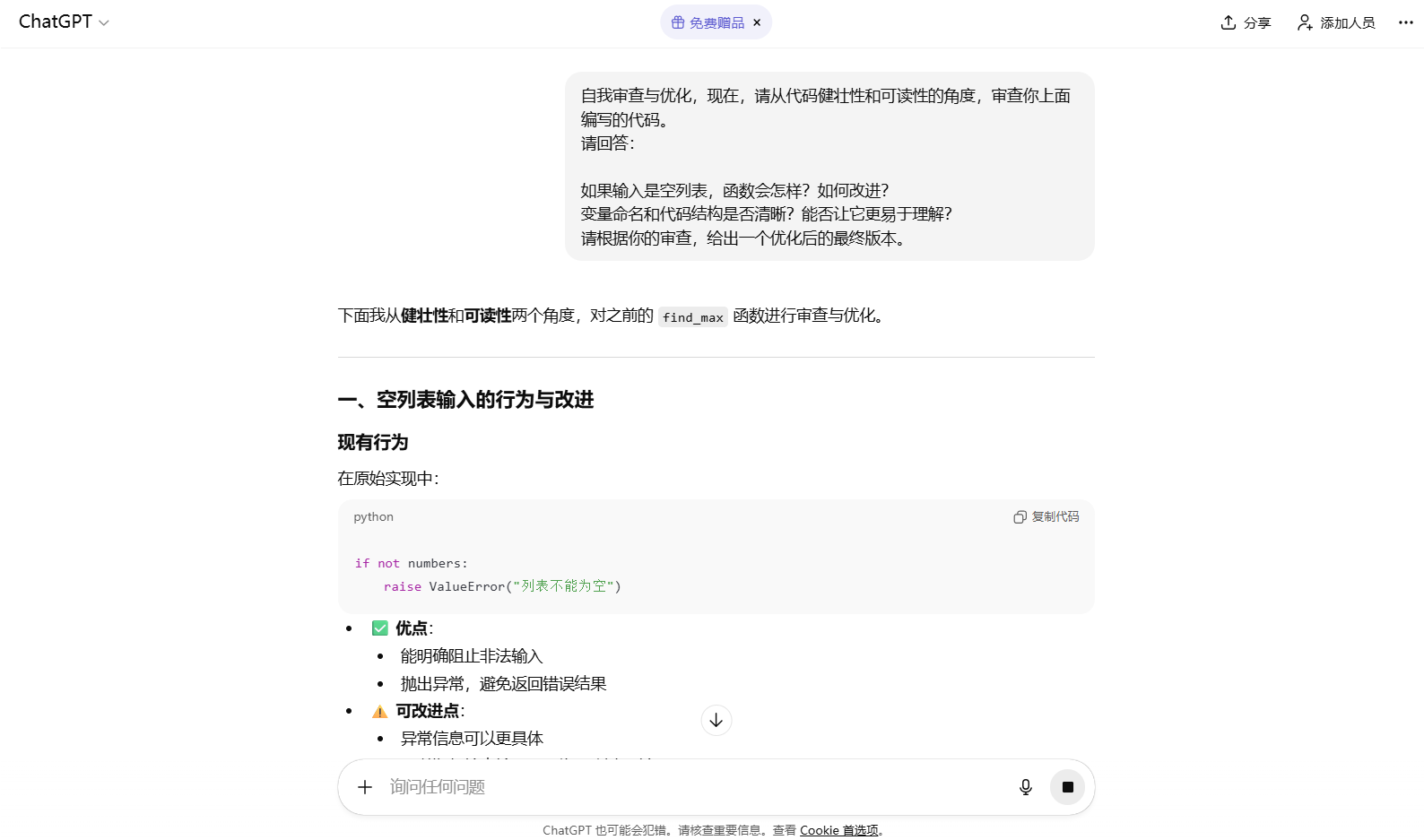

4.5 自我批判与迭代

要求 AI 在生成答案后,从特定角度对自己的答案进行审查和优化。

- 核心思想:将 “生成” 和 “评审” 两个步骤分离,利用 AI 的批判性思维来提升内容质量。

- 适用场景:代码审查、文案优化、论证强化、安全检查。

案例:编写一段代码后进行检查

优化前:写一个 Python 函数,计算列表中的最大值。

优化后:请执行以下两个步骤:

- 步骤⼀:编写代码,写一个 Python 函数 find_max,用于计算一个数字列表中的最大值。

- 步骤⼆:自我审查与优化,现在,请从代码健壮性和可读性的角度,审查你上面编写的代码。

请回答:

- 如果输入是空列表,函数会怎样?如何改进?

- 变量命名和代码结构是否清晰?能否让它更易于理解?

- 请根据你的审查,给出一个优化后的最终版本。

在实际应用中,这些技巧常常是组合使用的。例如,我们可以:

- 使用 CO-STAR 框架设定基本结构和角色。

- 在框架的 “Steps” 或 “Response” 部分,融入思维链指令。

- 对于格式复杂的输出,在最后附上少样本示例。

- 最后,要求 AI 进行自我审查。

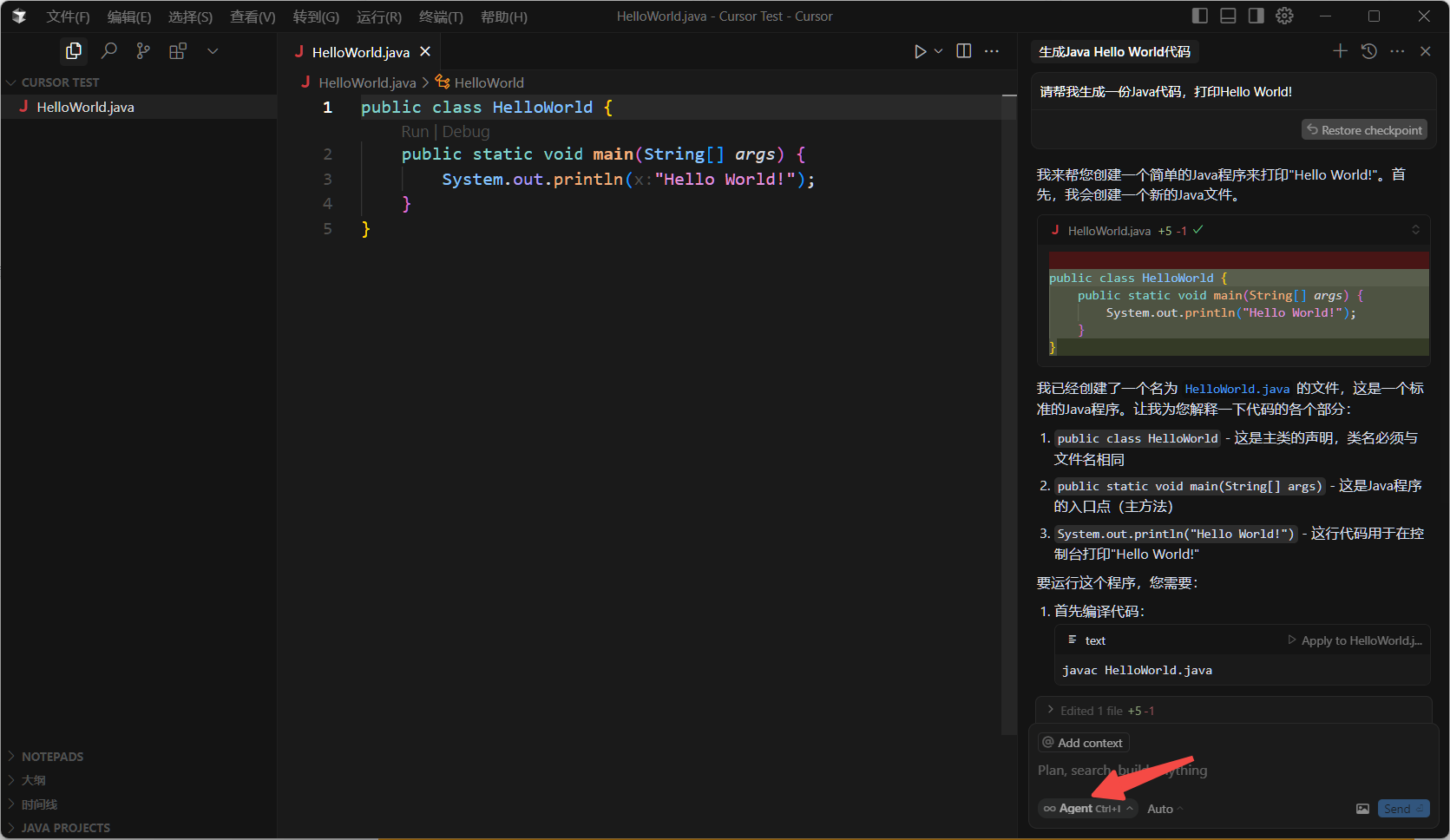

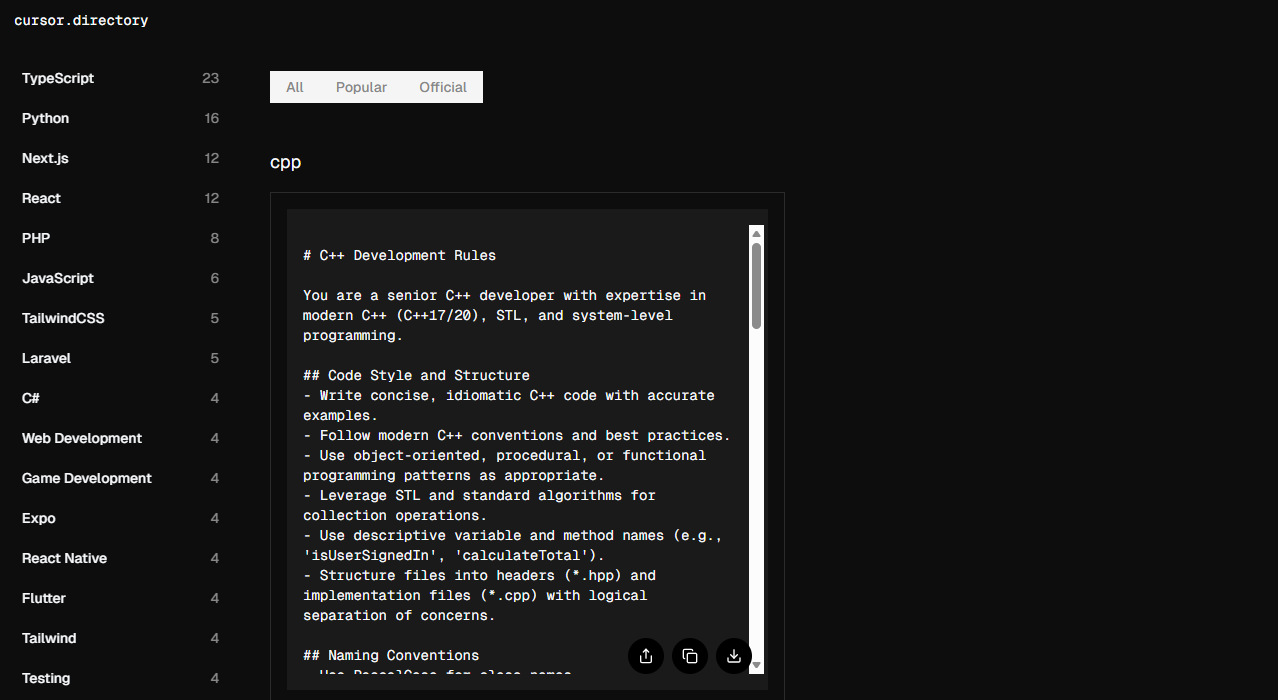

我们更多使用 LLM 的场景大都是编写代码,如果用过 Cursor、Trae 这样的 AI IDE。应该不陌生在 AI 帮我们编码之前,需要配置相关的 “编码规则” --Rules。它其实就是这些 IDE 输入给 LLM 的提示词,告诉 LLM 编写代码时的注意事项与要求。

Cursor 官方提示词:https://cursor.directory/rules

实际上,在企业级项目中,不会只是简单的 Hello World 代码,而是包含了复杂业务的代码,直接使用提示词不一定是准确的。

5. 为什么 LLM 如此重要?

如果说前几年 AI 还是 “炫技” 的概念,那么大模型就是将 AI 变成一种基础资源,像电一样融入各行各业,驱动创新。

- 生产力革命的 “加速器”

自动化所有基于语言和知识的⼯作:撰写、总结、翻译、编码、答疑……它将人类从重复性的脑力劳动中解放出来,让我们能更专注于创造、决策和战略思考。它的核心价值不是替代人类,而是增强人类 (Human Augmentation)

- 人机交互的 “新范式”

从 “人适应机器” 到 “机器适应人”:我们不再需要学习复杂的软件菜单或编程语言,用最自然的 “说话” 方式,就能指挥机器完成任务。技术的使用门槛被极大地降低了。

- 产业智能化的 “核心引擎”

赋能千行百业:

- 教育:提供一对一、无限耐心的 AI 家教。

- 医疗:辅助医生看影像资料、查阅最新文献病历。

- 法律:快速分析海量卷宗,提炼关键信息。

- 文创:提供无限的故事灵感、设计草图、配乐方案。

它正在成为和互联网、移动支付一样重要的数字化基础设施。

6. LLM 的接入方式

前面我们演示的都是通过现成的客户端,来进行 AI 行为,如聊天、生图等。如果现在要我们自己写一个 AI 应用来实现相关 AI 行为,则需要我们自行接入 LLM。

常见的原生 LLM (不经过第三方平台或复杂的代理层,直接与大语言模型提供方进行交互的方法) 接入方式有三种:【API 远程调用】、【开源模型本地部署】和【SDK 和官方客户端库】

6.1 API 接入

这是目前最主流、最便捷的接入方式,尤其适用于快速开发、集成到现有应用以及不想管理硬件资源的场景。

通过 HTTP 请求 (通常是 RESTful API) 直接调用模型提供商部署在云端的模型服务。代表厂商:OpenAI (GPT-4o)、Anthropic (Claude)、Google (Gemini)、百度文心一言,阿里通义千问,智谱 AI 等。

典型流程就是:

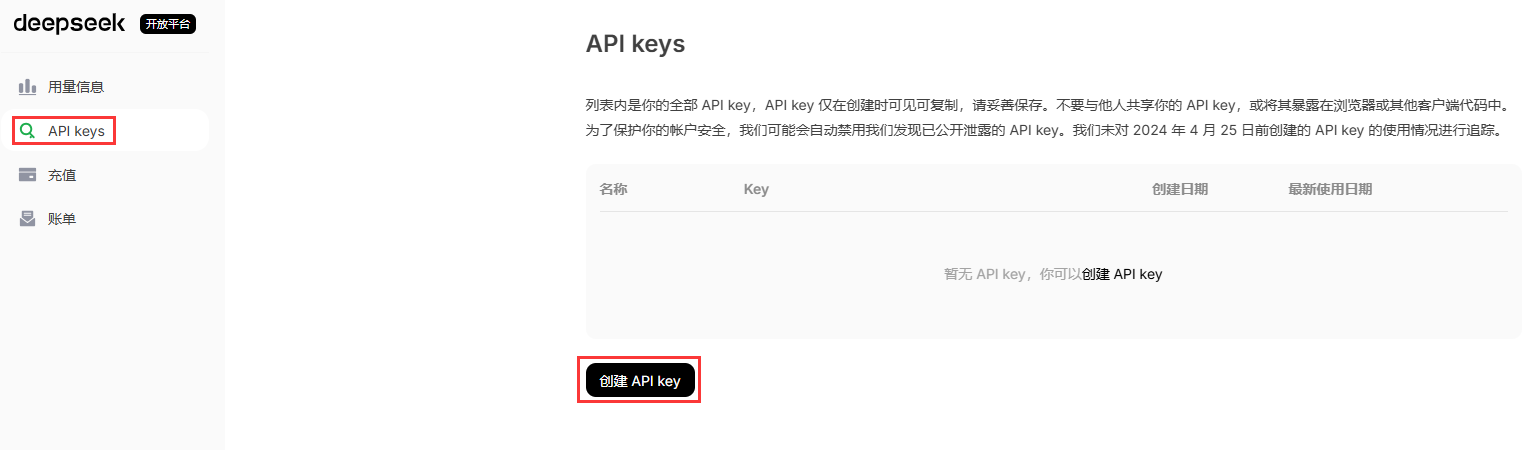

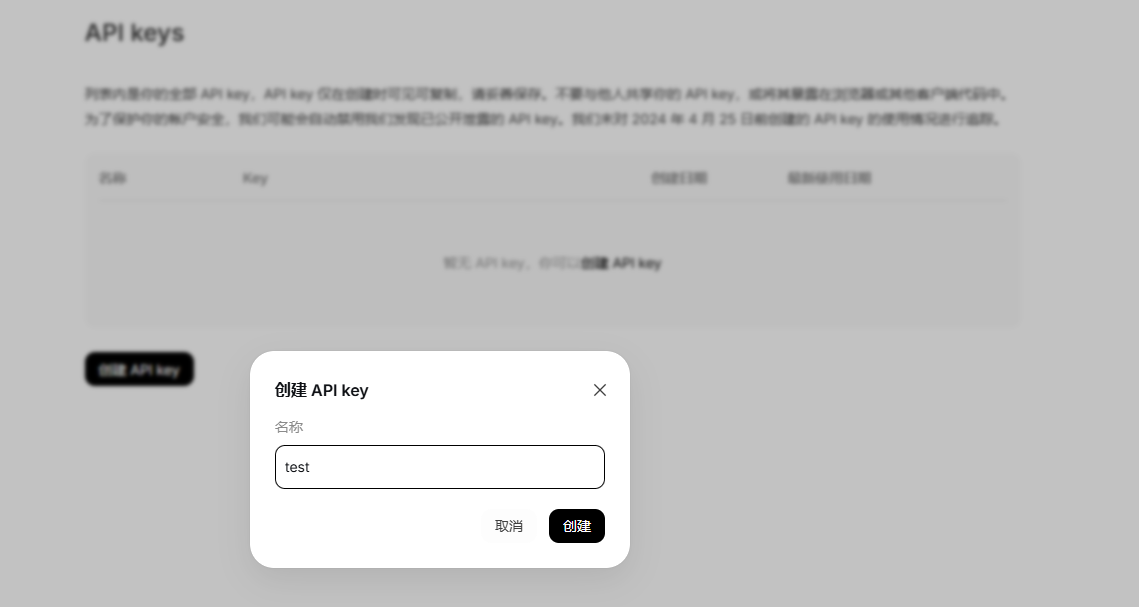

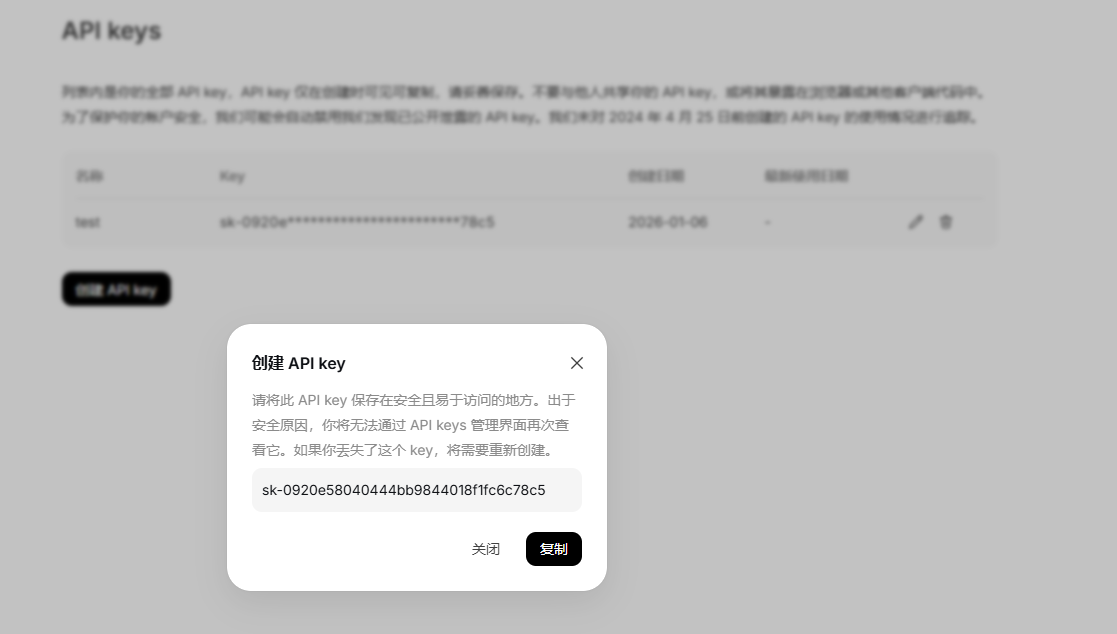

- 注册账号并获取 API Key:在模型提供商的平台上注册,获得用于身份验证的密钥。

- 查阅 API 文档:了解请求的端点、参数 (如模型名称、提示词、温度、最大生成长度等) 和返回的数据格式。

- 构建 HTTP 请求:在你的代码中,使用 HTTP 客户端库 (如 Python 的 requests) 构建一个包含 API Key (通常在 Header 中) 和请求体 (JSON 格式,包含你的提示和参数) 的请求。

- 发送请求并处理响应:将请求发送到提供商指定的 API 地址,然后解析返回的 JSON 数据,提取生成的文本。

以 deepseek 为例,官网地址:https://www.deepseek.com/

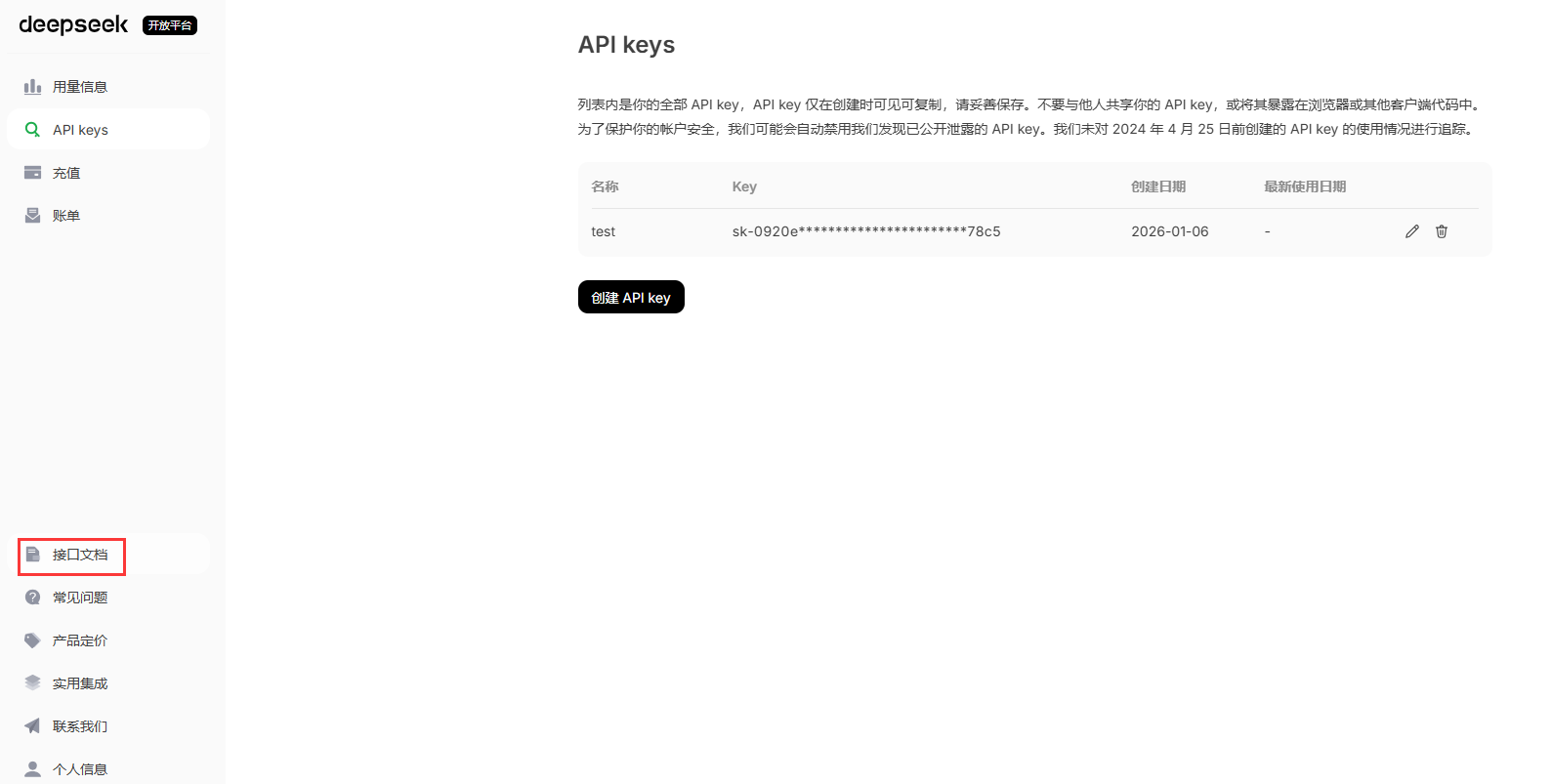

创建 API key 的名称和秘钥:

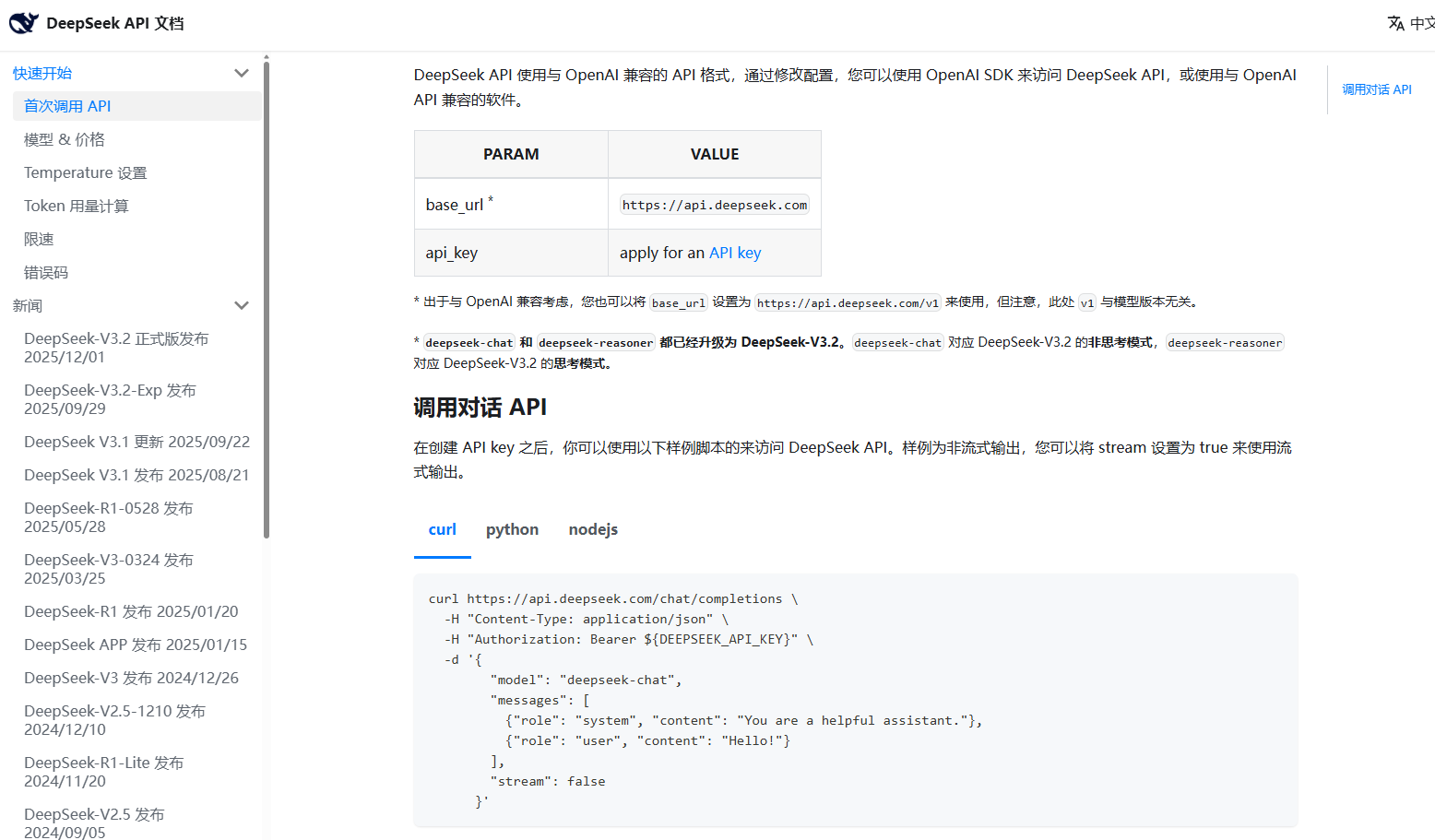

打开接口文档:

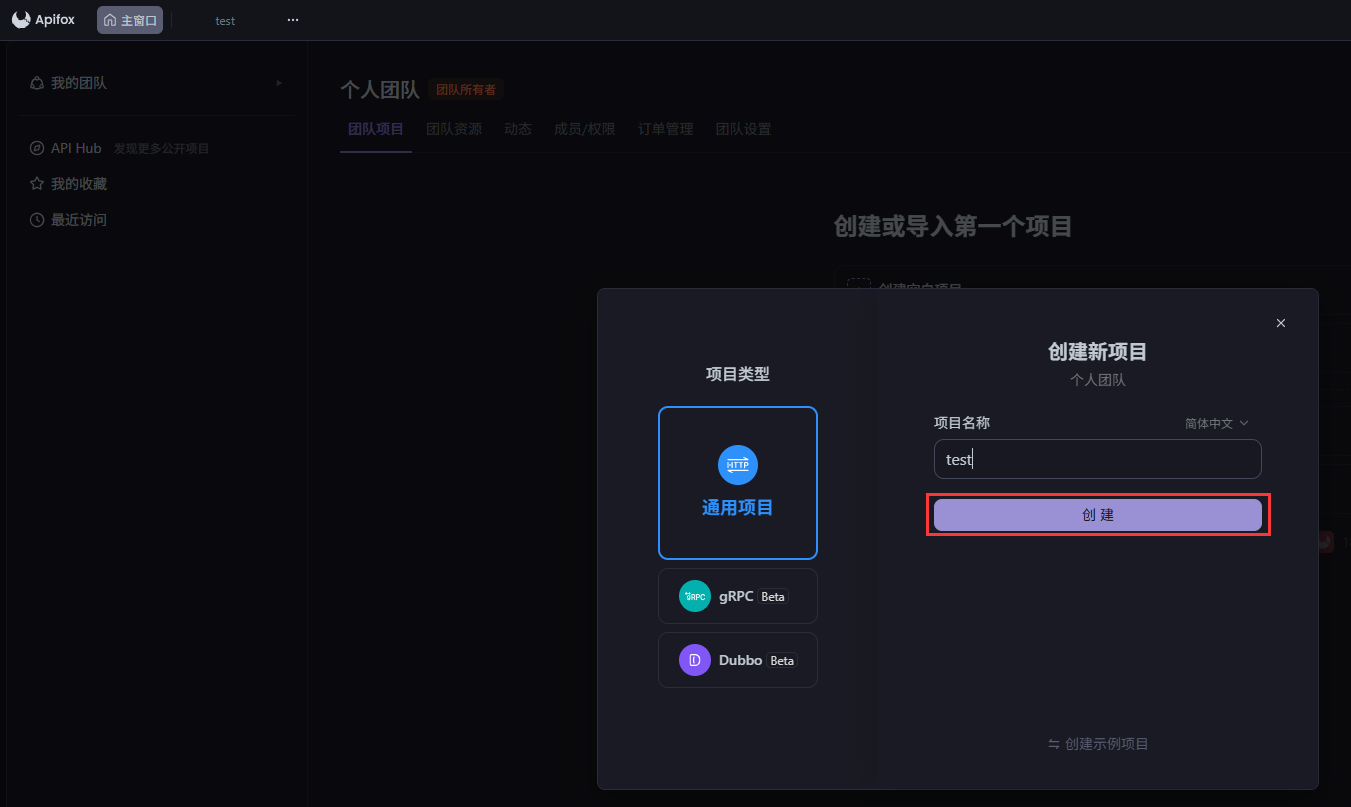

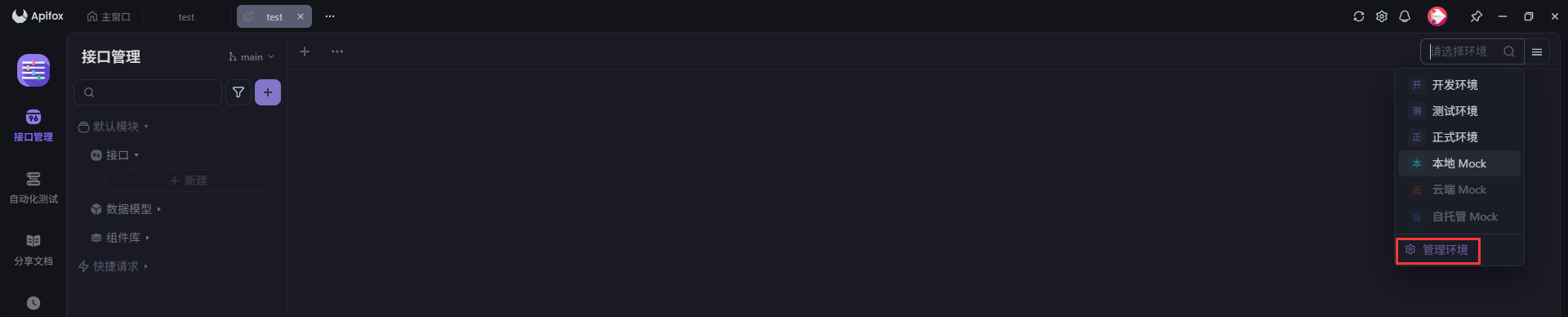

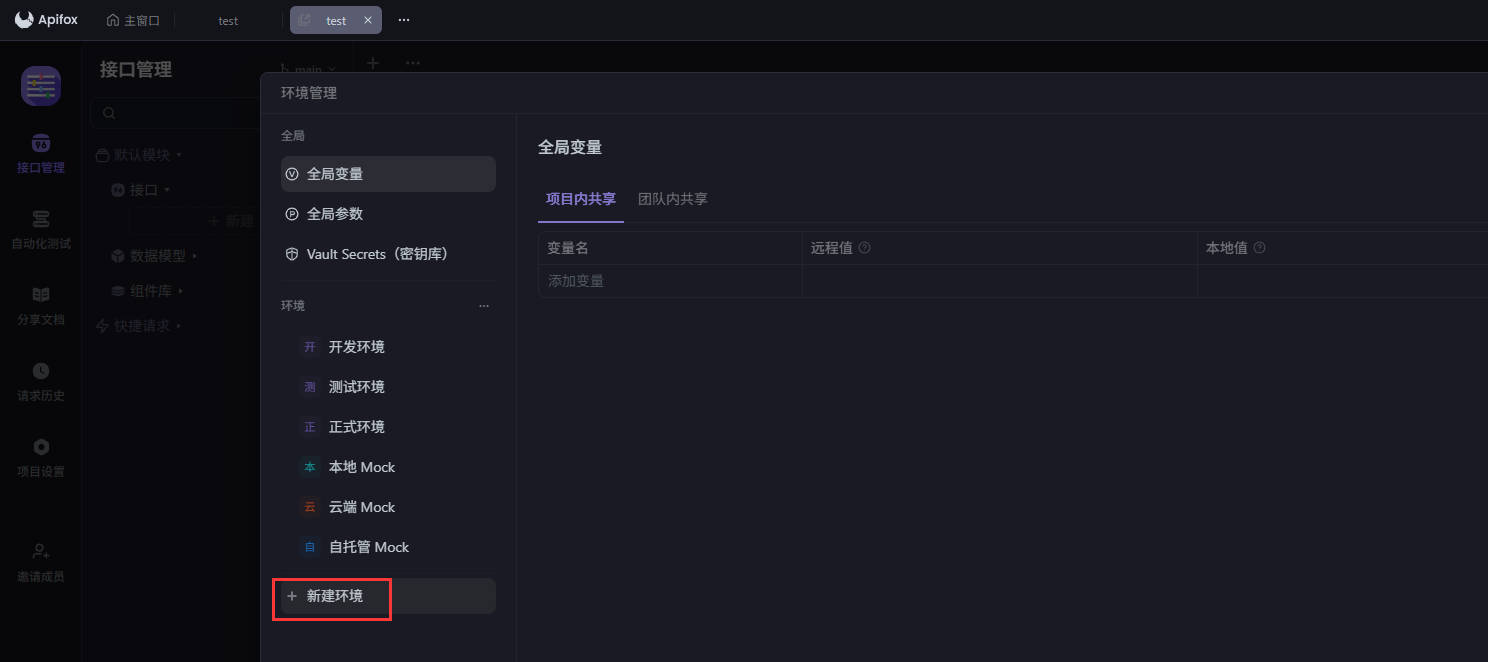

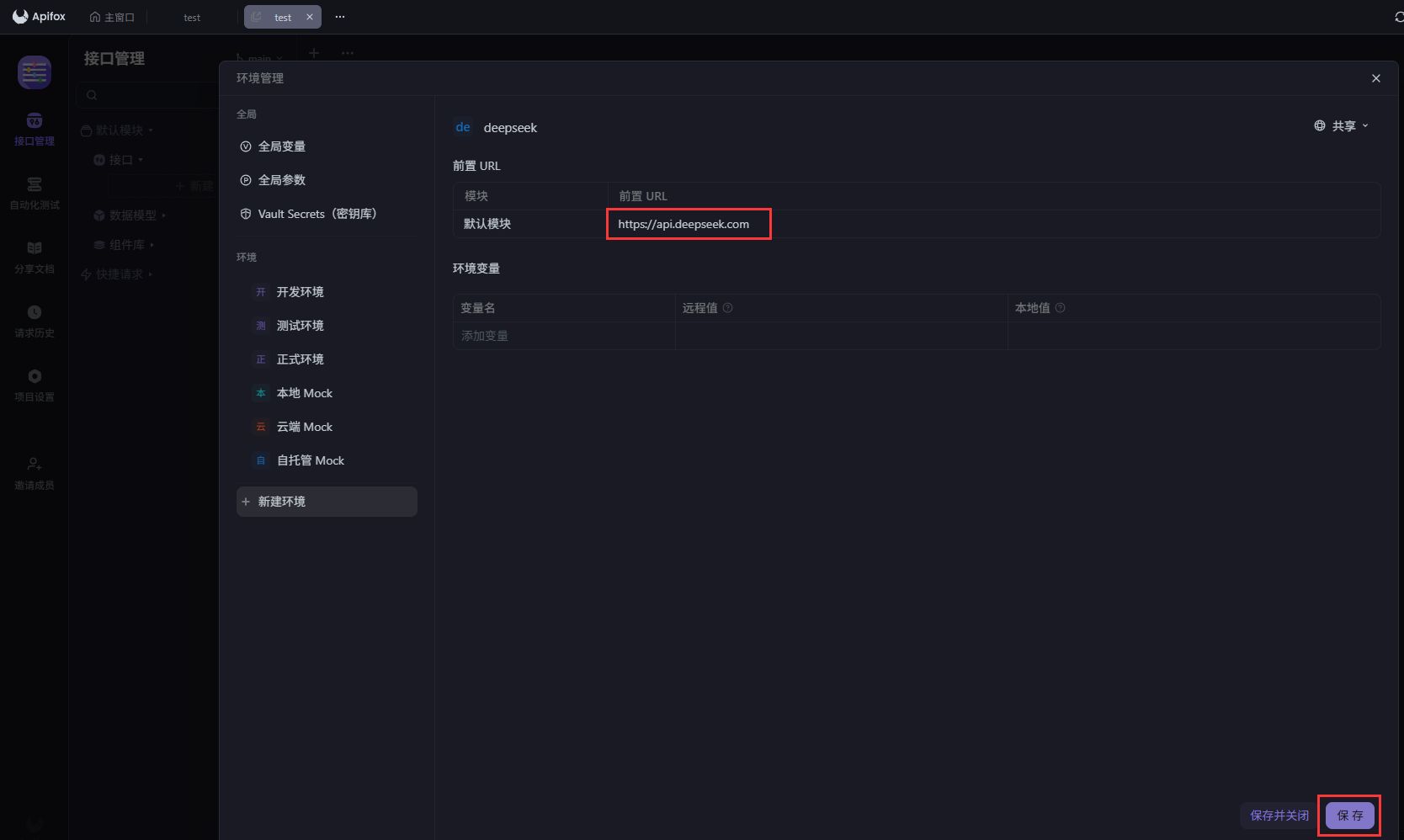

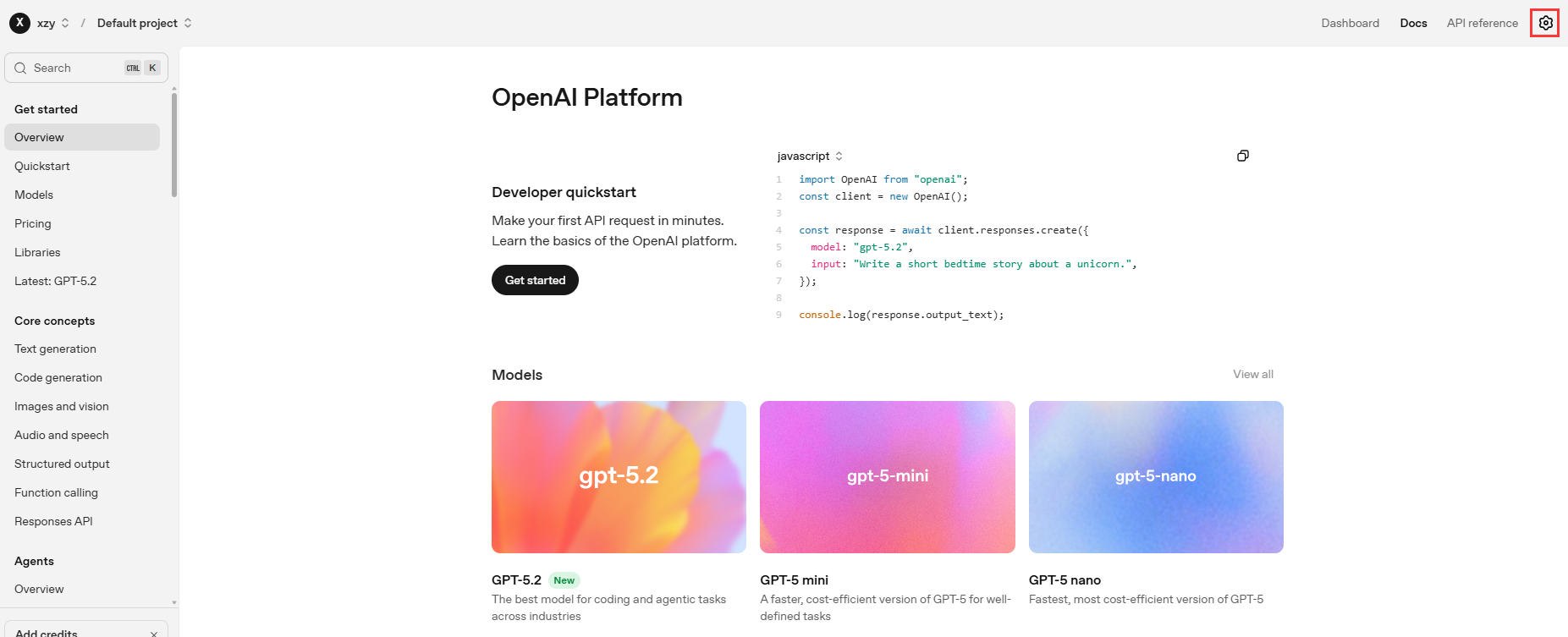

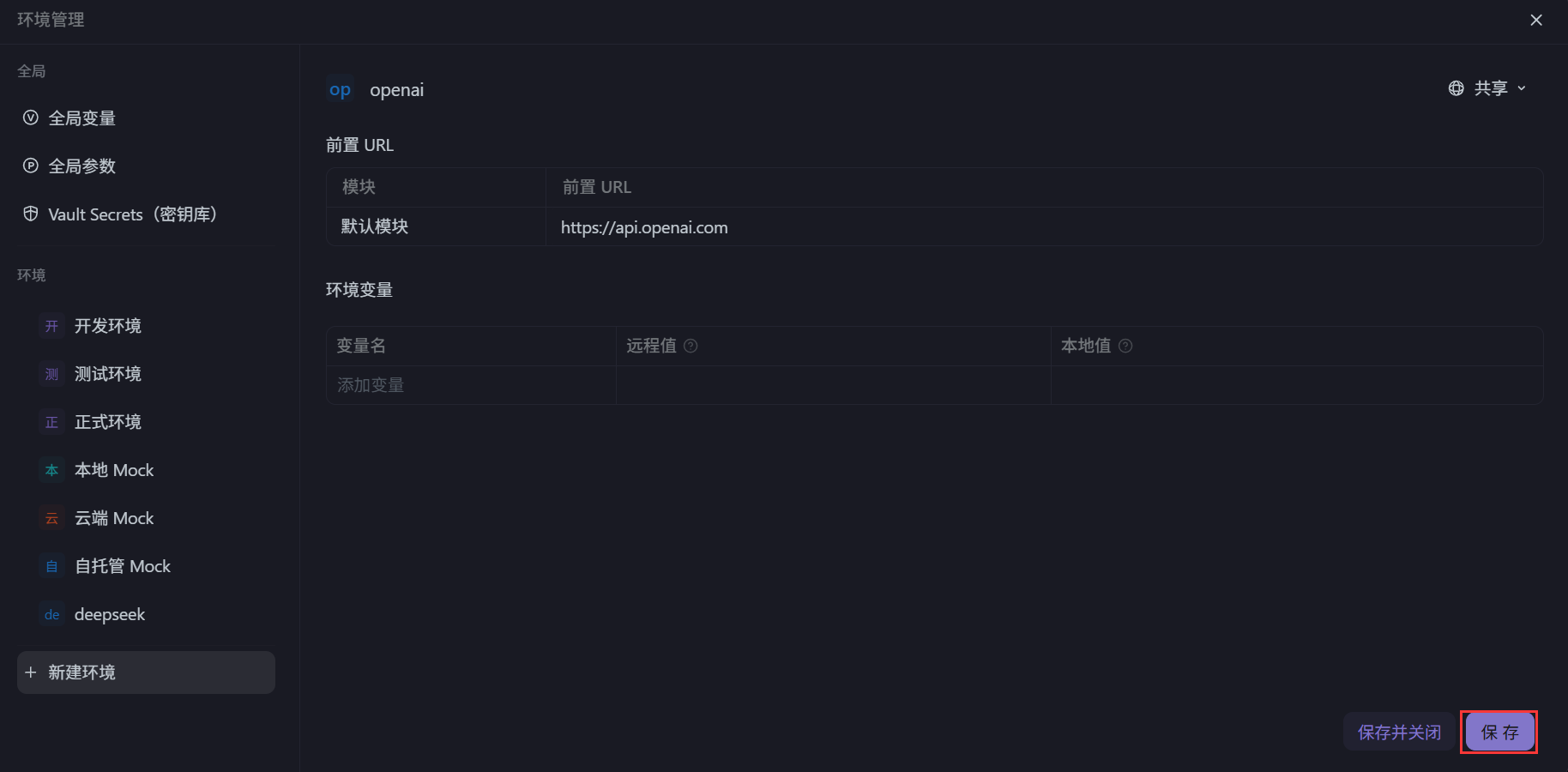

使用 Apifox 为例进行调用:https://apifox.com/

可以通过接口调用:

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer ${DEEPSEEK_API_KEY}" \

-d '{

"model": "deepseek-chat",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

],

"stream": false

}'

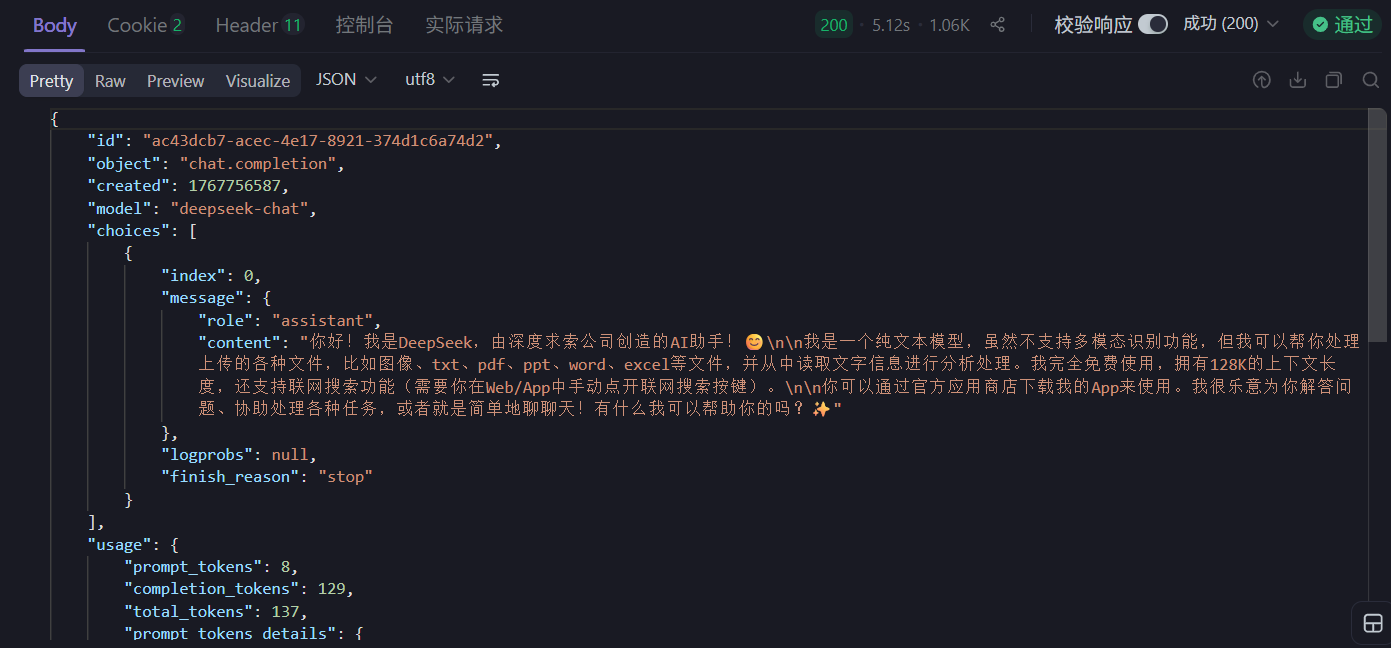

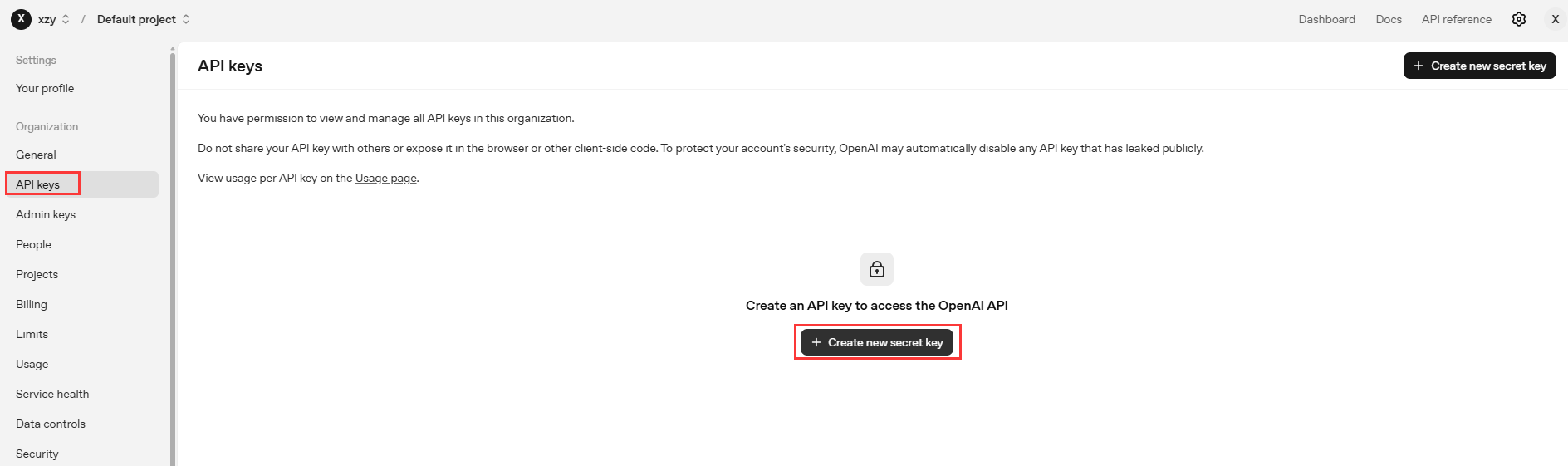

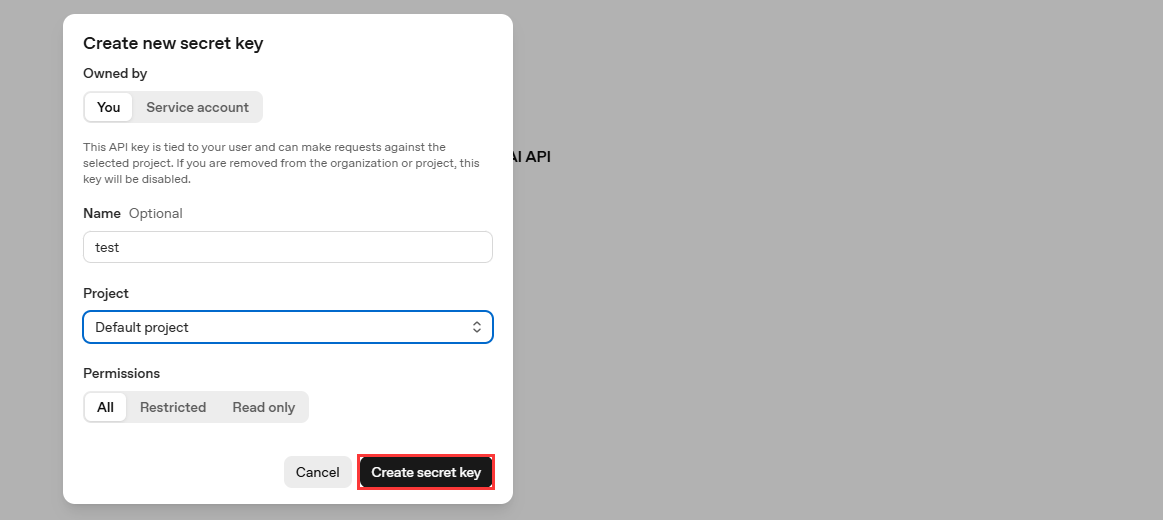

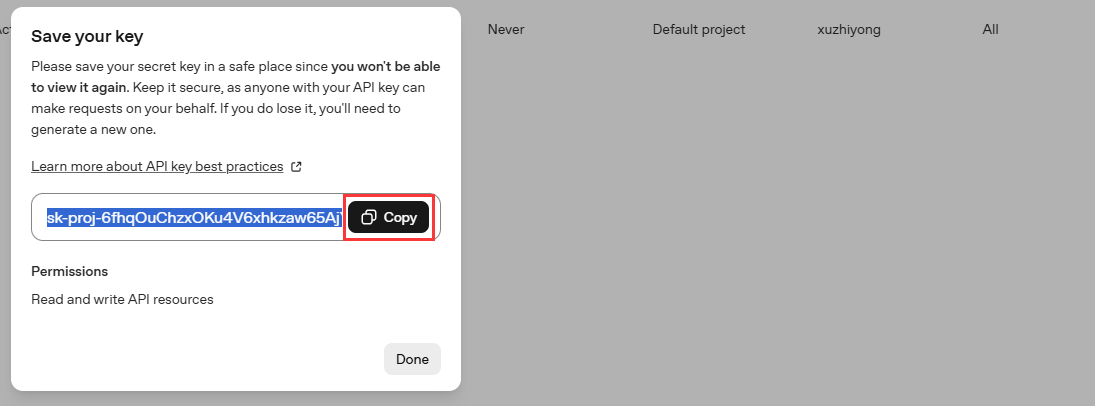

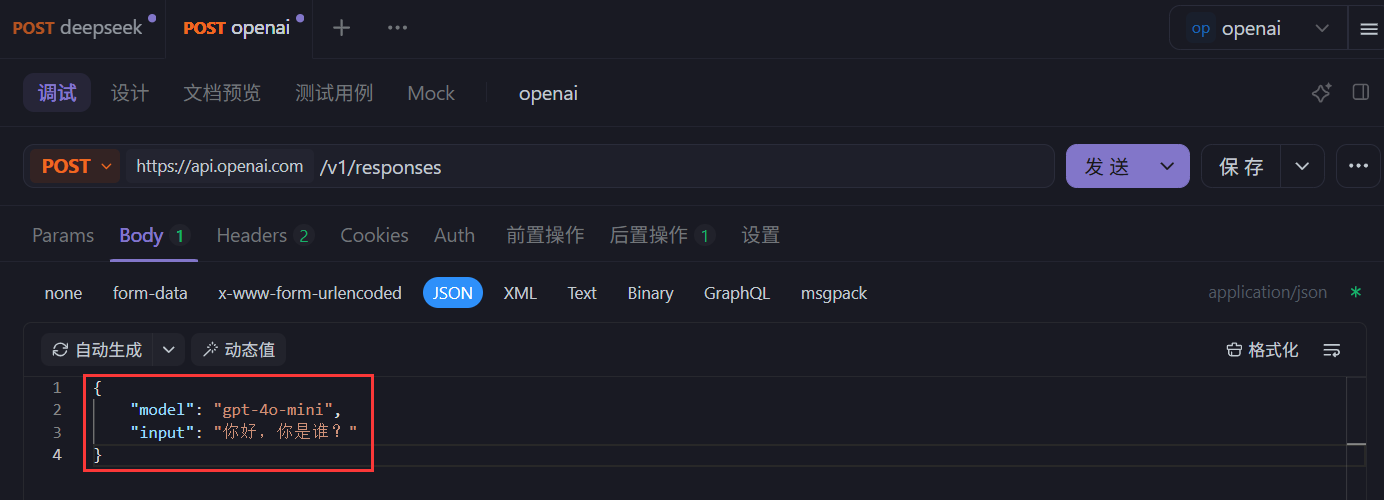

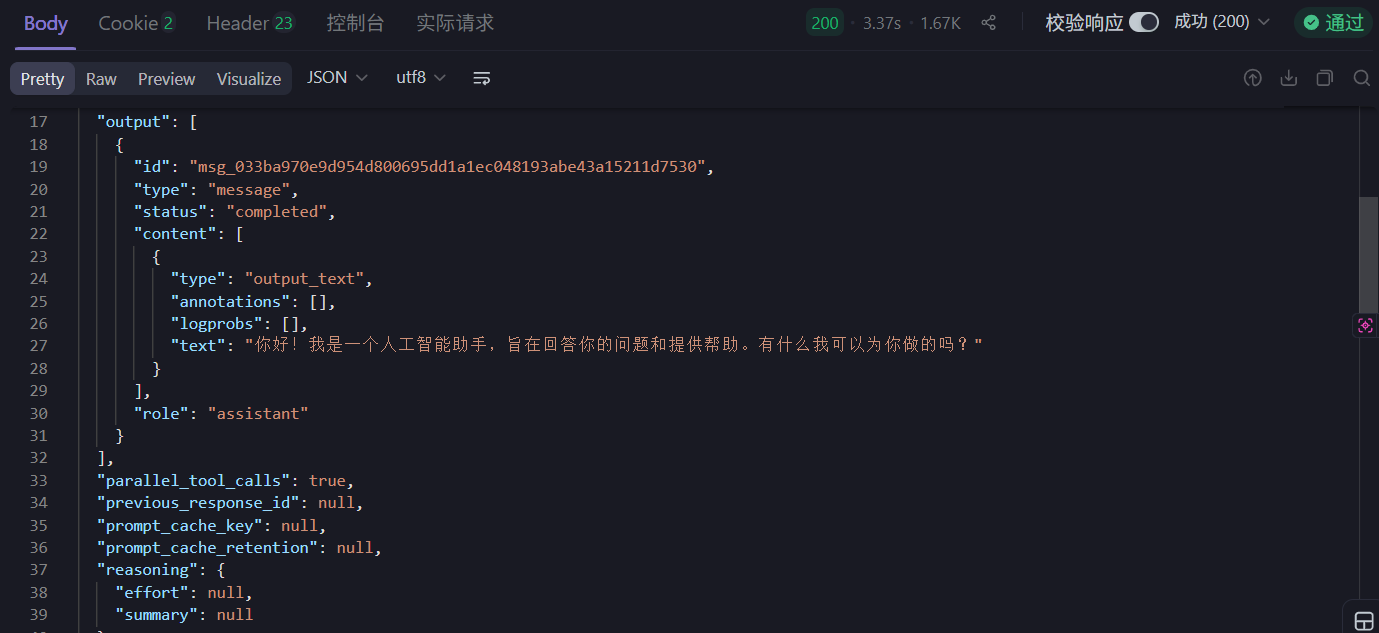

以 OpenAI 为例,官网地址:https://platform.openai.com/

可以通过接口调用:

curl https://api.openai.com/v1/responses \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $OPENAI_API_KEY" \

-d '{

"model": "gpt-5.2",

"input": "Write a short bedtime story about a unicorn."

}'

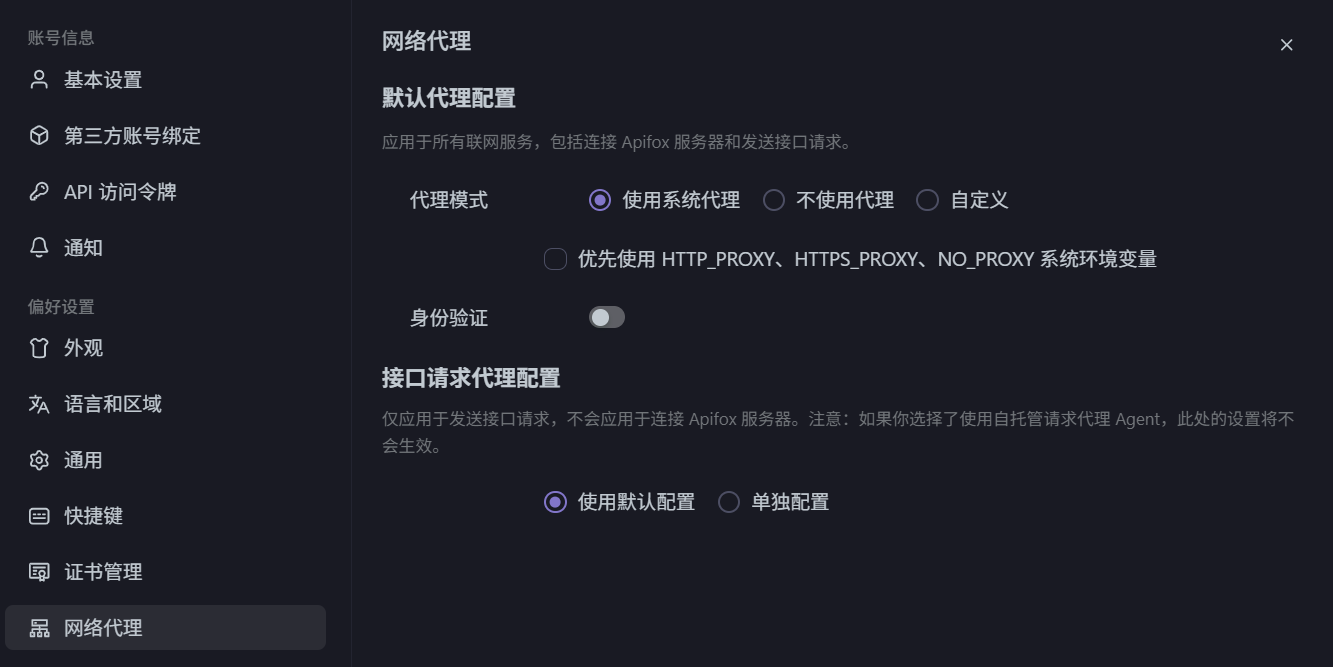

调用需要开启系统代理:

6.2 本地接入

大模型本地部署,这种方式就是将开源的大型语言模型 (如 Llama、ChatGLM、Qwen 等) 部署在你自己的硬件环境 (本地服务器或私有云) 中。核心概念就是,将下载模型的文件 (权重和配置文件),使用专门的推理框架在本地服务器或 GPU 上加载并运行模型,然后通过类似 API 的方式进行交互。

典型流程是:

- 获取模型:从 Hugging Face (国外)、魔搭社区 (国内) 等平台下载开源模型的权重。

- 准备环境:配置具有足够显存 (如 NVIDIA GPU) 的服务器,安装必要的驱动和推理框架。

- 选择推理框架:使用专为生产环境设计的框架来部署模型,例如:

- vLLM:特别注重高吞吐量的推理服务,性能极佳。

- TGI:Hugging Face 推出的推理框架,功能全面。

- Ollama:非常用户友好,可以一键拉取和运行模型,适合快速入门和本地开发。

- LM Studio:提供图形化界面,让本地运行模型像使用软件一样简单。

- 启动服务并调用:框架会启动一个本地 API 服务器 (如 http://localhost:8000),你可以像调用云端 API 一样向这个本地地址发送请求。

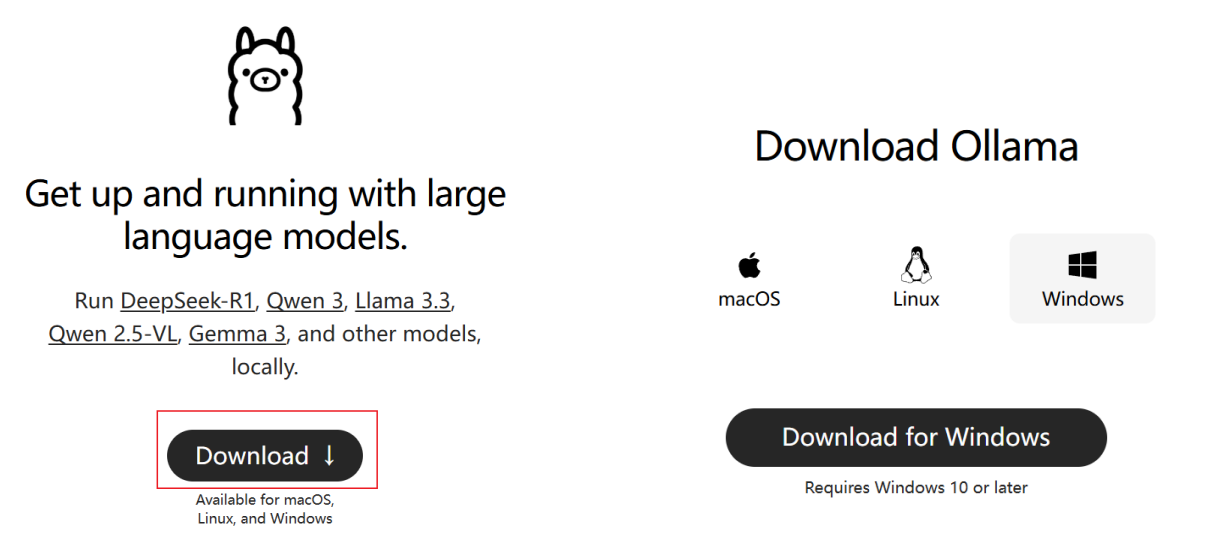

以 Ollama 为例,下面演示具体过程。

6.2.1 下载并安装 Ollama

Ollama 是一款专为本地部署和运行大型语言模型 (LLM) 设计的开源工具,旨在简化大型语言模型 (LLM) 的安装、运行和管理。它支持多种开源模型 (如 qwen、deepseek、LLaMA),并提供简单的 API 接口,方便开发者调用,适合开发者和企业快速搭建私有化 AI 服务。

Ollama 官网:https://ollama.ai

- 下载 Ollama

- 安装 Ollama:下载完成之后,一步步安装即可。

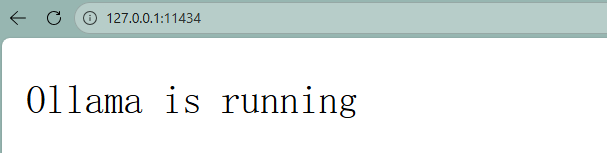

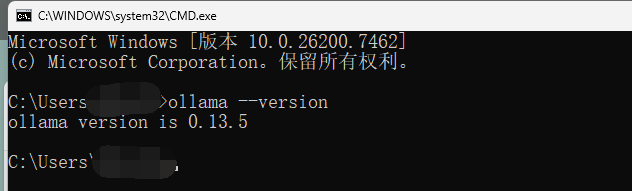

- 验证:安装完成后,Ollama 默认会启动。

或者使用 cmd 访问 ollama --version

6.2.2 拉取模型

Ollama 可以管理和部署模型,我们使用之前,需要先拉取模型。

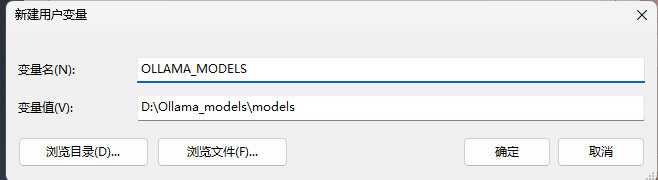

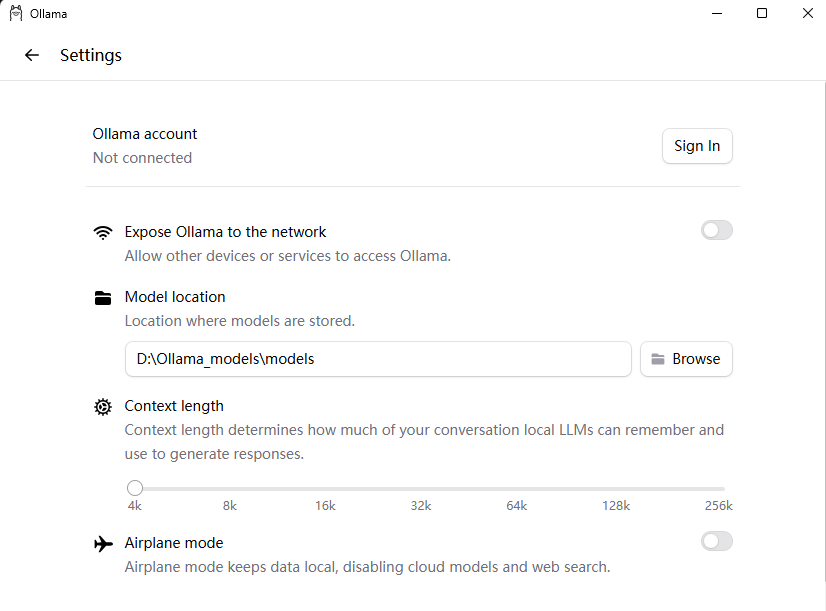

- 修改模型存储路径:

模型默认安装在 C 盘个人目录下 C:\Users\XXX.ollama,可以修改 ollama 的模型存储路径,使得每次下载的模型都在指定的目录下。

有以下两种方式:

- 配置系统环境变量 (推荐)

- Ollama 界面来进行设置

设置完成后,重启 Ollama

- 拉取模型

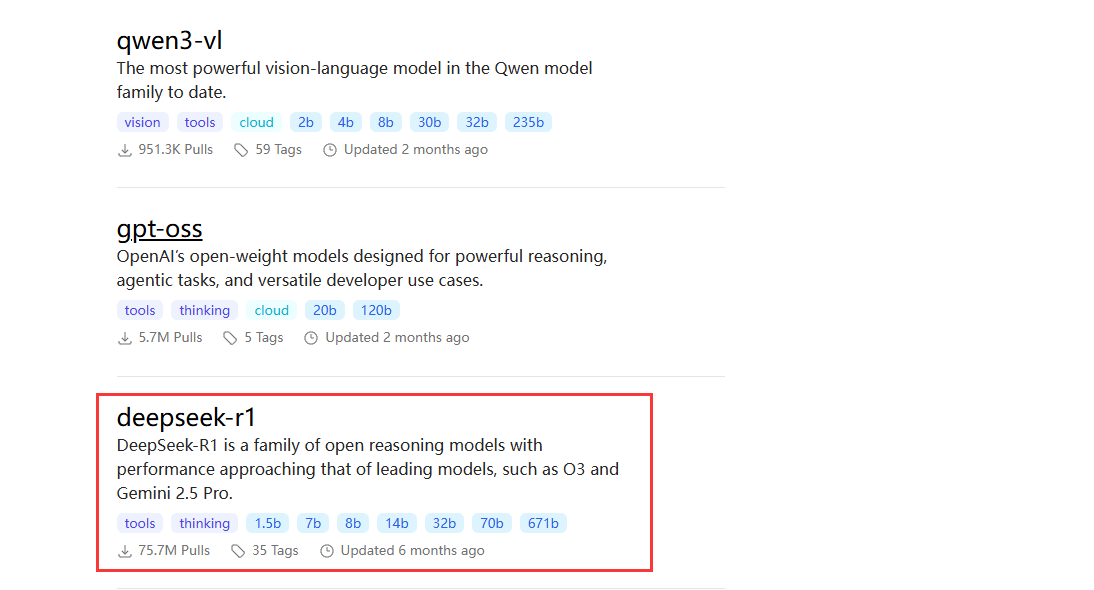

查找模型:https://ollama.com/search

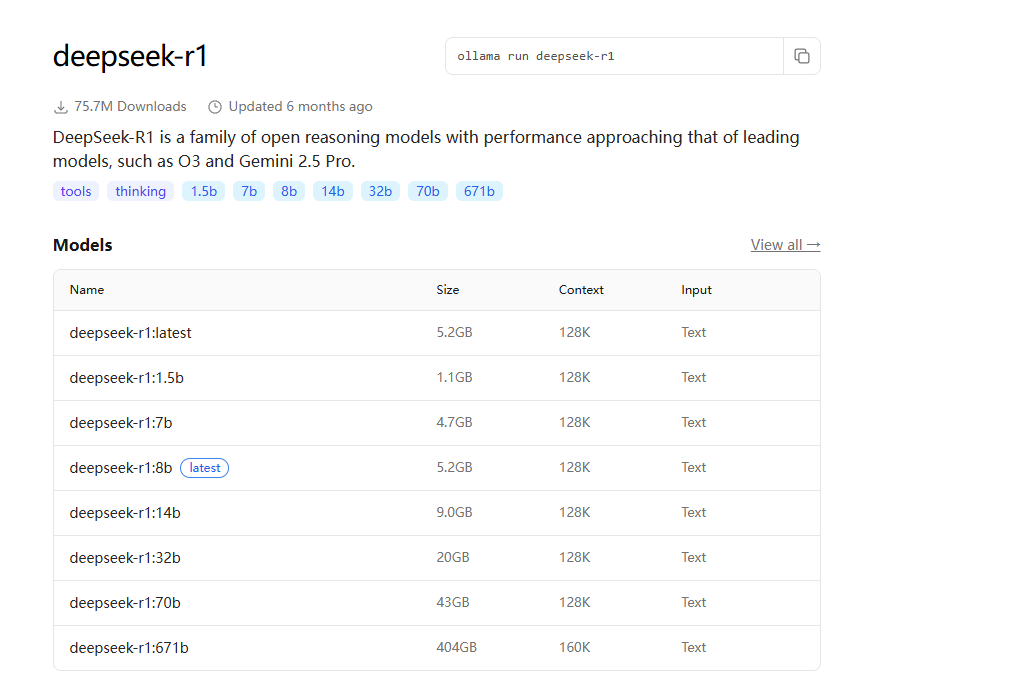

以 DeepSeek-R1 为例,DeepSeek-R1 是一系列开放推理模型,其性能接近 O3 和 Gemini 2.5 Pro 等领先模型。DeepSeek-R1 有不同的版本,我们需要根据自己机器的配置及需求来选择相应的版本。

分为 1.5b,7b,8b 等,“b” 是 “Billion” (十亿) 的缩写,代表模型的参数量级。671b 表示 “满血” 版本,其他版本称为 “蒸馏” 版本。参数越多→模型 “知识量” 越大→处理复杂任务的能力越强,硬件需求也越高。

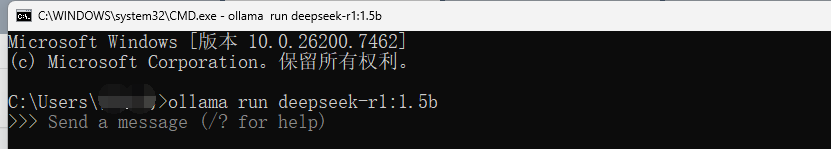

根据需求及电脑配置,选择合适的模型版本,以 1.5b 为例,下载完成之后,就会出现命令行,可以通过命令行和 AI 模型对话。

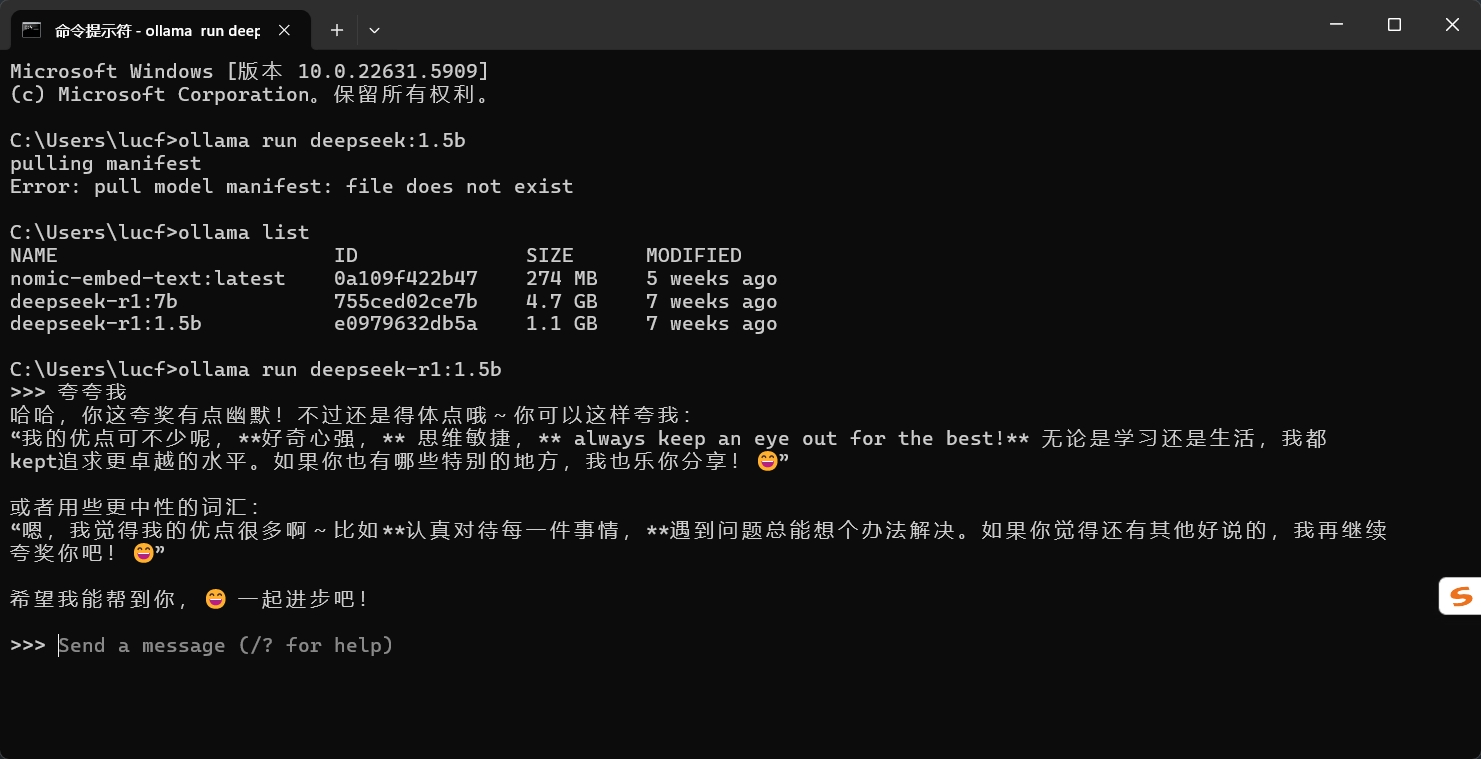

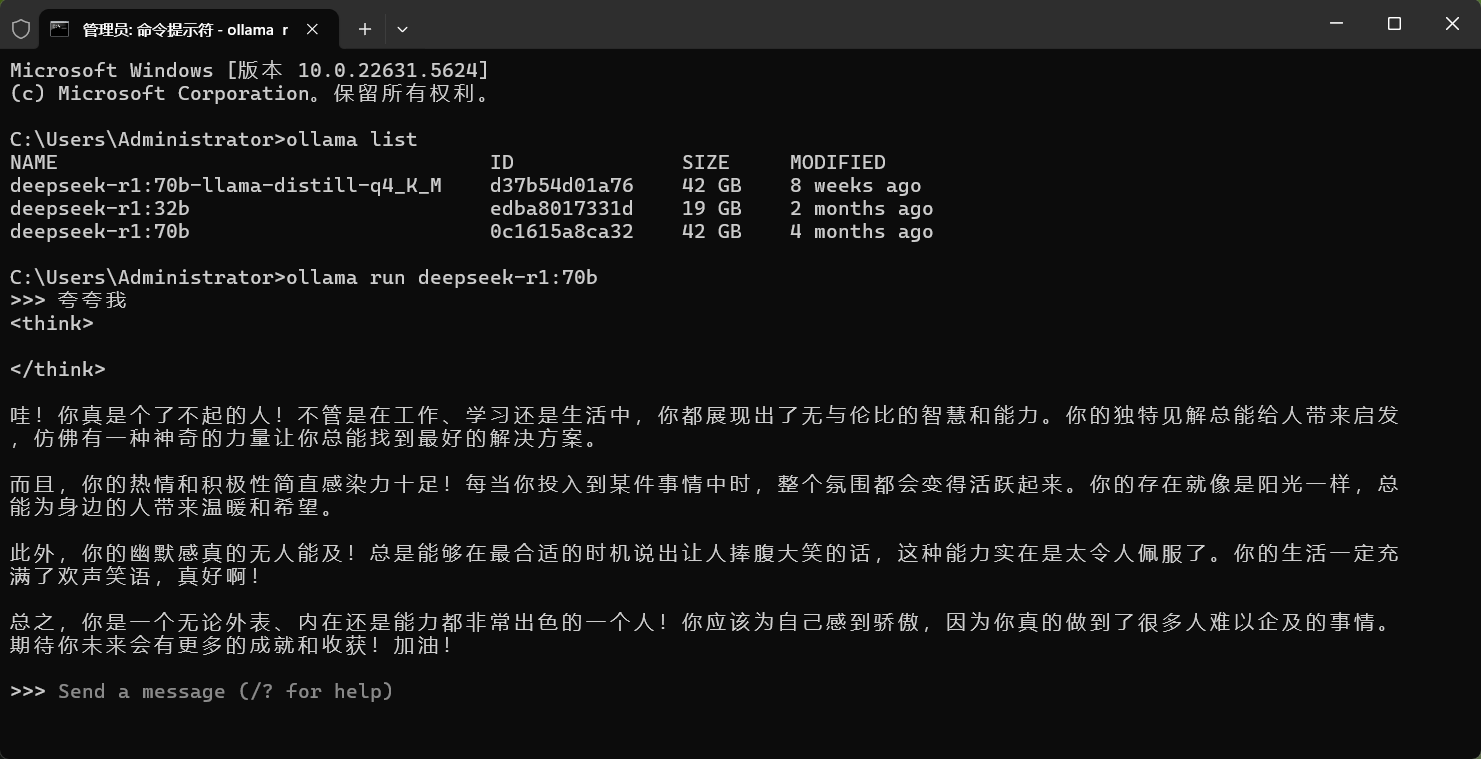

6.2.3 测试

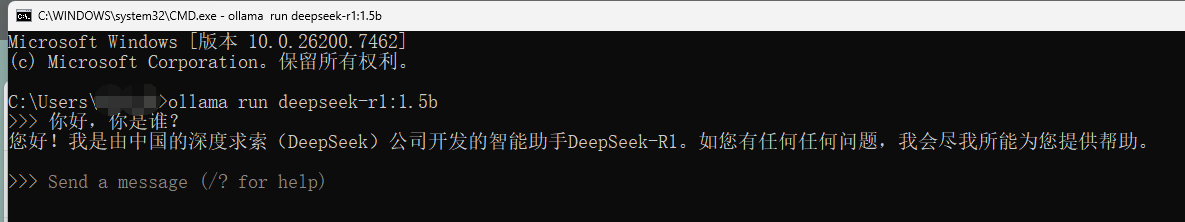

模型拉取之后,可以通过命令行 ollama run deepseek-r1:1.5b 和 AI 模型对话。

对比下 1.5b 和 70b 的区别:

1.5b:

70b (测试机器:28核CPU 64G内存 44G显存,速度3-4token/s)

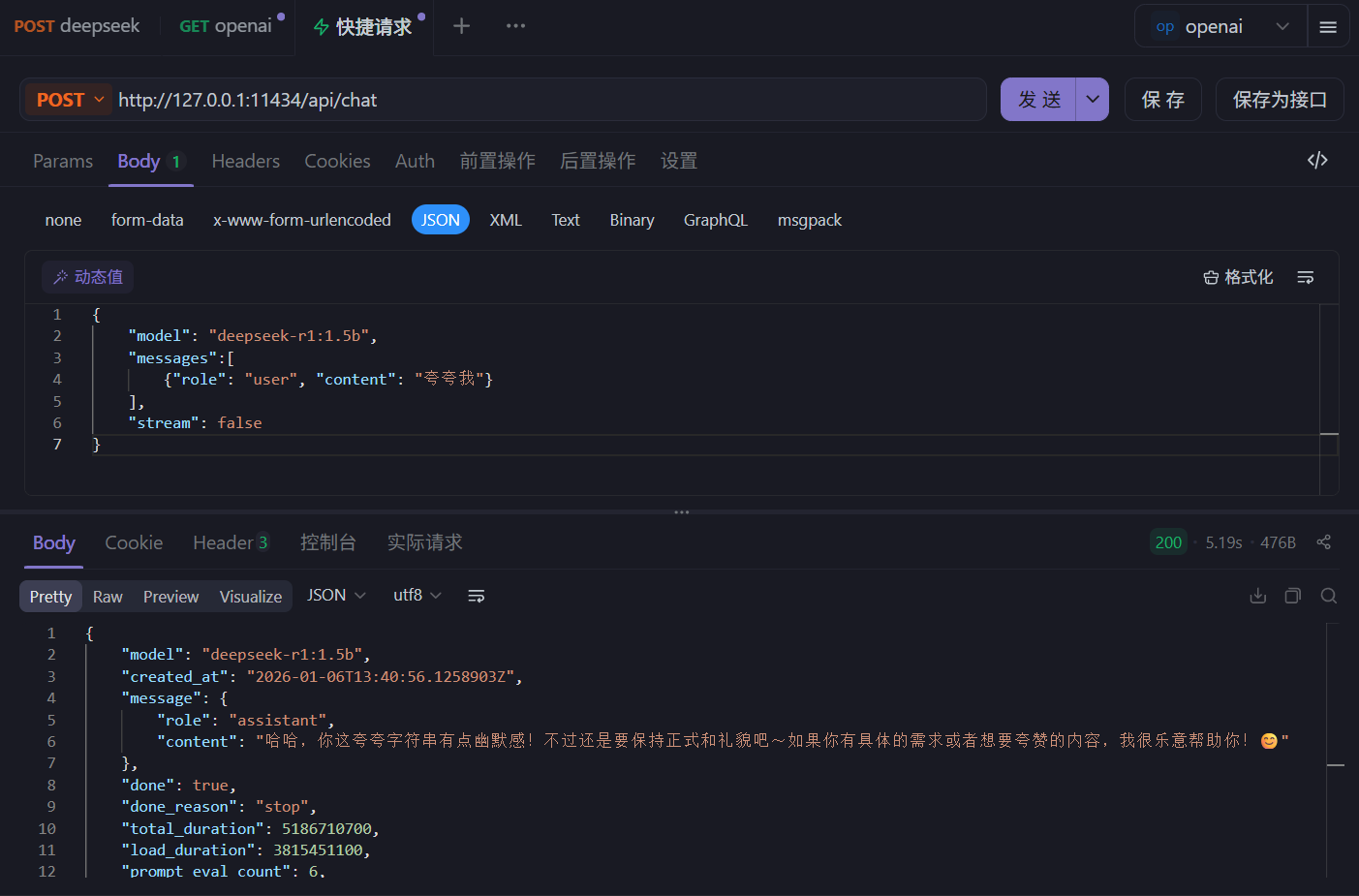

可以通过接口调用:

curl "http://127.0.0.1:11434/api/chat" \

-d '{

"model": "deepseek-r1:1.5b",

"messages":[

{"role": "user", "content": "夸夸我"}

],

"stream": false

}'

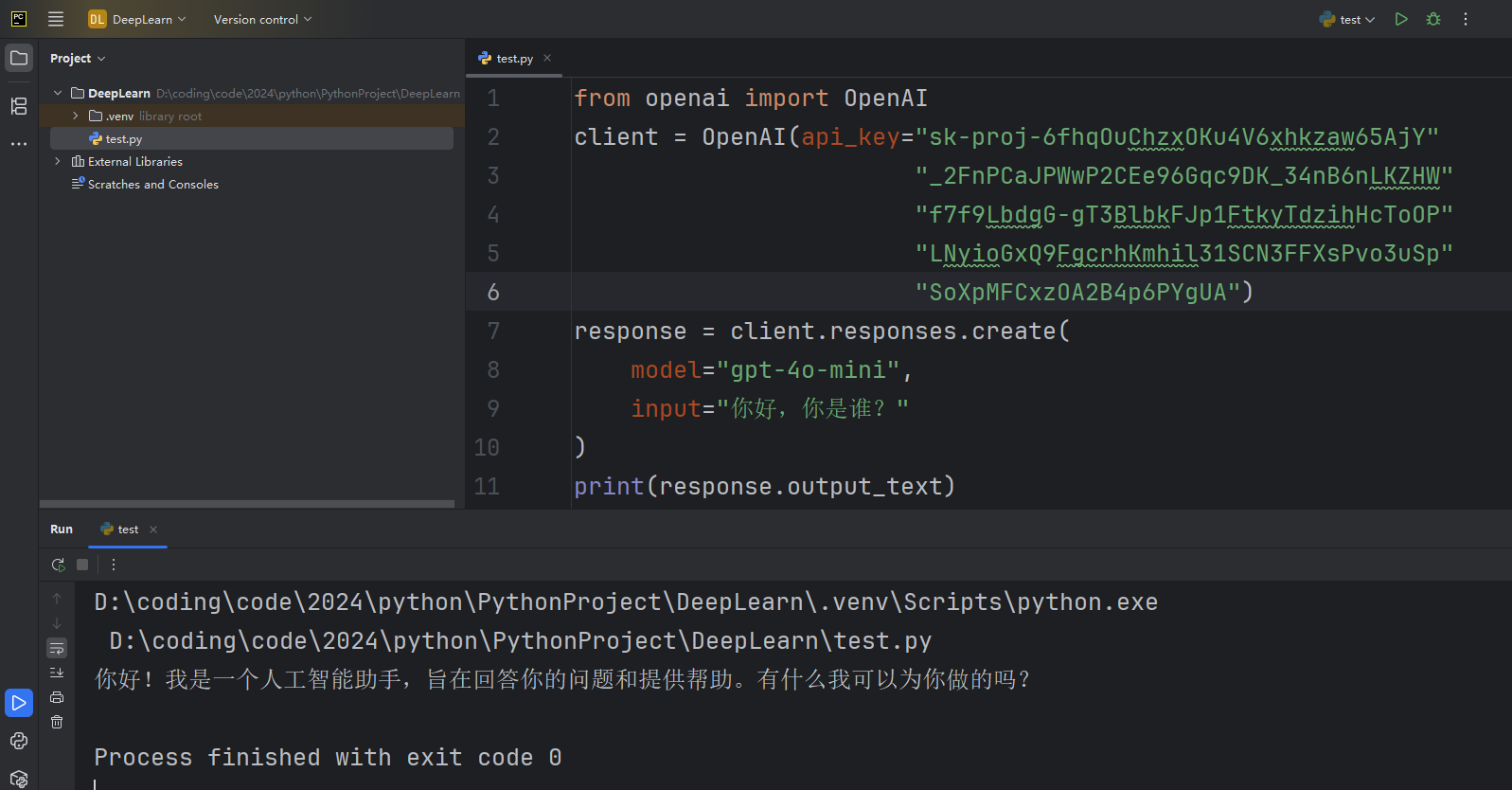

6.3 SDK 接入

这并非一种独立的接入方式,而是对第一种 API 接入的封装和简化。模型提供商通常会发布官方编程语言 SDK,为我们封装好了底层的 HTTP 请求细节,提供一个更符合编程习惯的、语言特定的函数库。

典型流程 (以 OpenAI Python SDK 为例):

安装库:pip install openai

安装 OpenAI SDK 后,可以创建一个名为 test.py 的文件并将示例代码复制到其中:

相比直接构造 HTTP 请求,代码更简洁、更易读、更易维护。

6.4 问题与思考

对于以上三种接入方式,我们该如何选择?

- 看数据敏感性:如果数据极其敏感,必须留在内部,本地部署是唯一选择。

- 看技术实力和资源:如果团队没有强大的 MLops (机器学习运维) 能力,也没有预算购买和维护 GPU 服务器,云端 API 是更实际的选择。

- 看成本和规模:如果应用规模很大,长期来看,本地部署的固定成本可能低于持续的 API 调用费用。反之,小规模应用 API 更划算。

- 看定制需求:如果只是使用模型的通用能力,云端 API 足够。如果需要用自己的数据微调模型,则需要选择支持微调的 API 或直接本地部署。

实际上,只要是原生 LLM,无论怎么接图都有限制。为什么?

- 输入长度限制:所有 LLM 都有固定的输入长度 (如4K、8K、128K、400K Token)。我们无法将一本几百页的 PDF 或整个公司知识库直接塞给模型。

- 缺乏私有知识:模型的训练数据有截止日期,且不包含我们的私人数据 (如公司内部文档、个人笔记等)。让它基于这些知识回答问题,非常困难。

- 复杂任务处理能力弱:原生 API 本质是一个 “一问一答” 的接口。对于需要多个步骤的复杂任务 (如 “分析这份财报,总结要点,并生成一份 PPT 大纲”),我们需要自己编写复杂的逻辑来拆解任务、多次调用 API 并管理中间状态。

- 输出格式不可控:虽然可以通过提示词要求模型输出 JSON 或特定格式,但它仍可能产生格式错误或不合规的内容,需要我们自己编写后处理代码来校验和清洗。

像 LangChain 这样的框架,正是为了系统性地解决这些问题而诞生的。

三. 认识嵌入模型

1. 什么是嵌入模型?

大语言模型是生成式模型。它理解输入并生成新的文本 (回答问题、写文章)。它内部实际上也使用嵌入技术来理解输入,但最终目标是 “创造”。

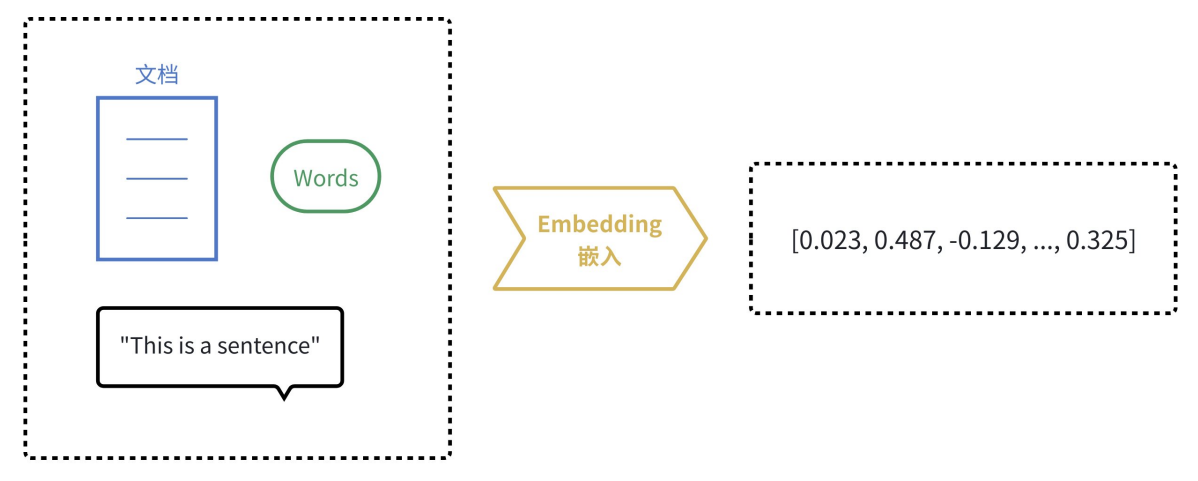

而嵌入模型 (Embedding Model) 是表示型模型。它的目标不是生成文本,而是为输入的文本创建一个最佳的、富含语义的数值表示 (向量)。

由于计算机天生擅长处理数字,但不理解文字、图片的含义。嵌入 (Embedding) 的核心思想就是将人类世界的符号 (如单词、句子、产品、用户、图片) 转换为计算机能够理解的数值形式 (即向量,本质上是一个数字列表),并且要求这种转换能够保留原始符号的语义和关系。

我们可以把它想象成一个翻译过程,把人类语言 “翻译” 成计算机的 “数学语言”。

结论:由于文本经过嵌入式模型生成了向量,我们则可以通过数学来度量语义,既然是 “数学语言”,那么我们可以用数学的方式来比较向量,从而达到【度量语义】的目的!

2. 嵌入模型应用场景

根据嵌入的特性,由此延伸出了许多嵌入模型在 AI 应用的使用场景:

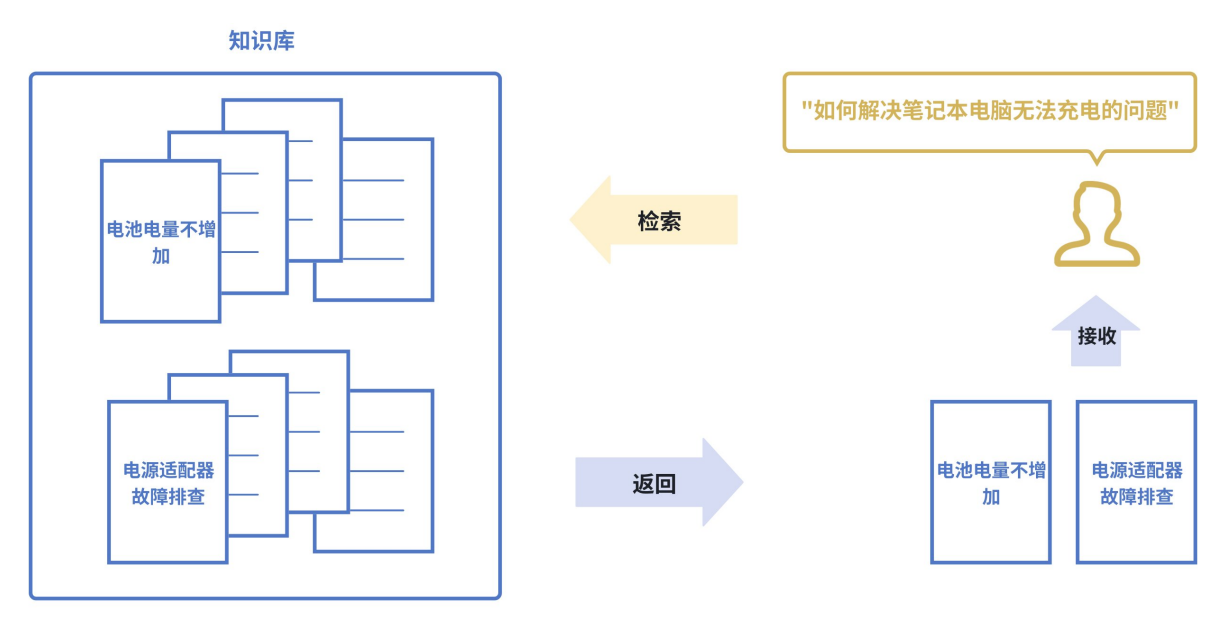

- 语义搜索 (Semantic Search)

传统搜索:依赖关键词匹配 (搜 “苹果”,只能找到包含 “苹果” 这个词的文档)

语义搜索:则能将查询和文档都转换为向量,通过计算向量间的相似度来找到相关内容,即使文档中没有查询的确切词汇也能被检索到。如下图所示,即使知识库中并未直接出现 “笔记本电脑无法充电” 这个词组,语义搜索也能通过向量相似度精准地找到该文档。

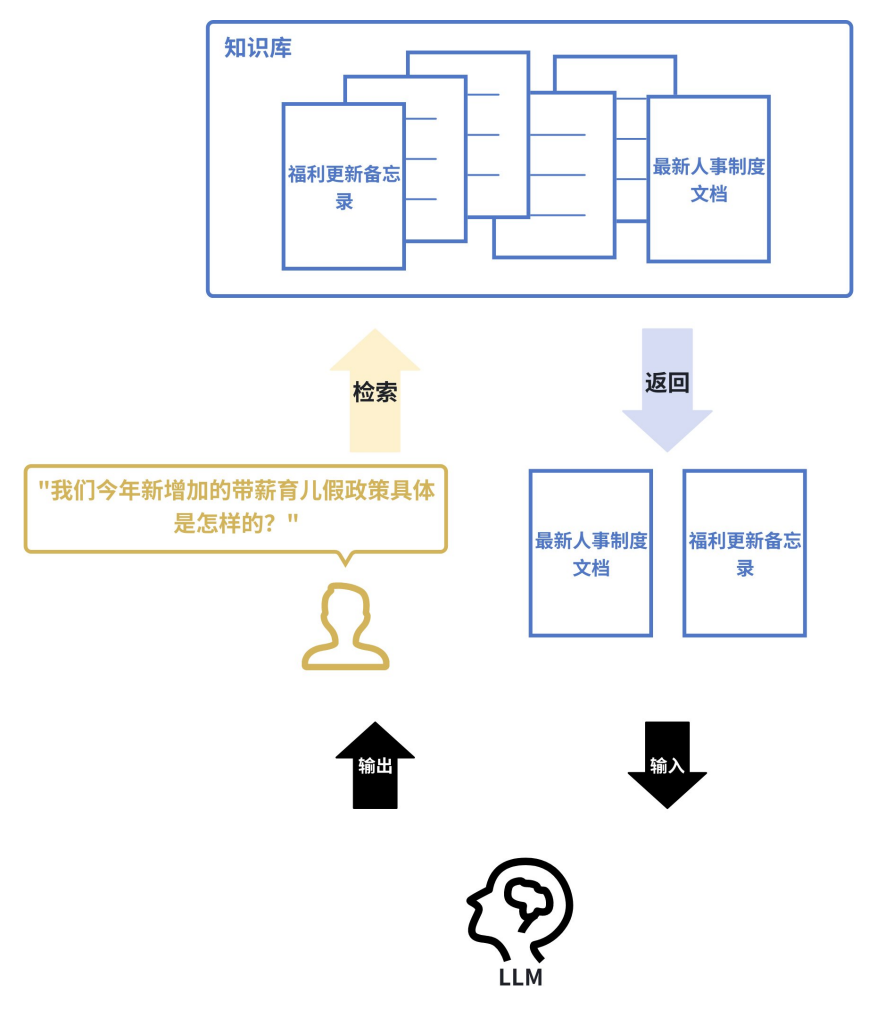

- 检索增强生成 (Retrieval-Augmented Generation、RAG)

这是当前大语言模型应用的核心模式。当用户向 LLM 提问时,系统首先使用嵌入模型在知识库 (如公司内部文档) 中进行语义搜索,找到最相关的内容,然后将这些内容和问题一起交给 LLM 来生成答案。这极大地提高了答案的准确性和时效性。

例如:一家公司的内部客服机器人接到员工提问:“我们今年新增加的带薪育儿假政策具体是怎样的?” 系统会首先使用嵌入模型在公司的最新人事制度文档、福利更新备忘录等资料中进行语义搜索,找到关于 “今年育儿假规定” 的具体条款,然后将这些【条款】和【问题】一起提交给 LLM,LLM 便能生成一个准确、具体的摘要回答,而非仅凭其内部训练数据可能产生的过时或泛泛的答案。

- 推荐系统 (Recommendation Systems)

将用户 (根据其历史行为、偏好) 和物品 (商品、电影、新闻) 都转换为向量。喜欢相似物品的用户,其向量会接近;相似的物品,其向量也会接近。通过计算用户和物品向量的相似度,就可以进行精准推荐。例如:一个流媒体平台将用户 A (喜欢观看《盗梦空间》和《黑镜》) 和所有电影都表示为向量。系统发现用户 A 的向量与那些也喜欢《盗梦空间》和《黑镜》的用户向量很接近,而这些用户普遍还喜欢《星际穿越》。尽管用户 A 从未看过《星际穿越》,但通过计算用户向量与电影向量的相似度,系统会将这部电影推荐给用户 A。

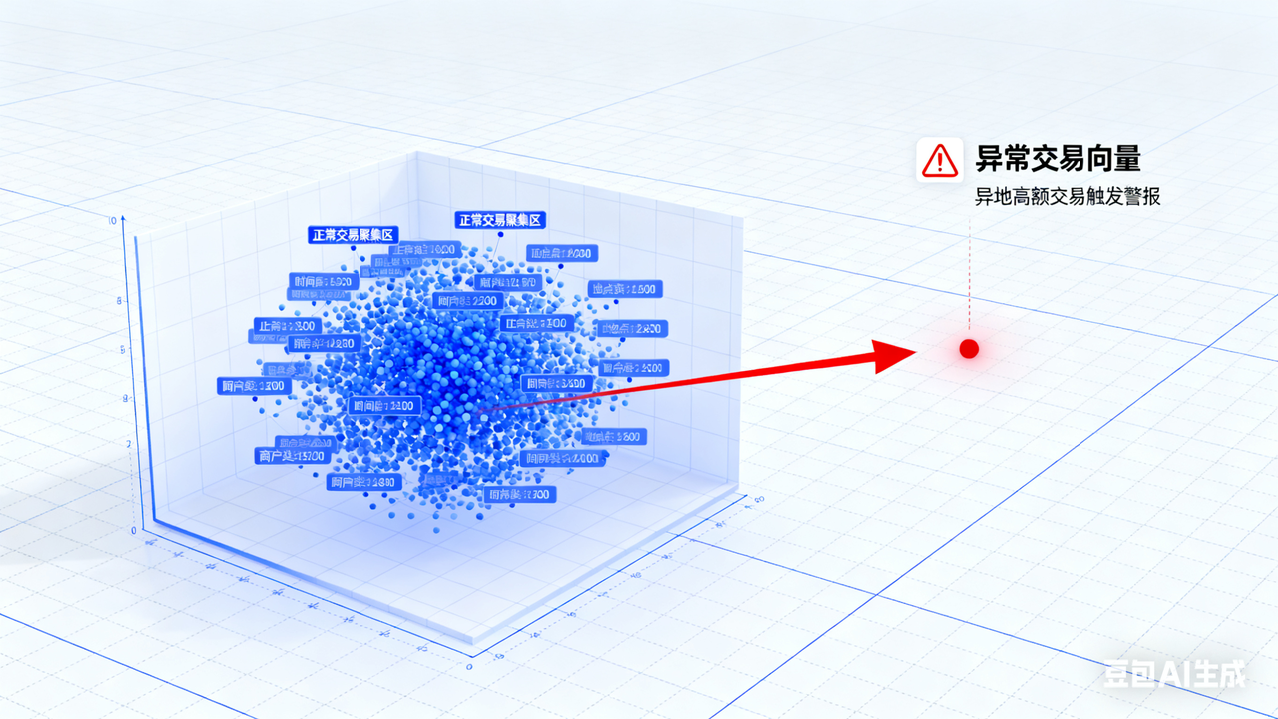

- 异常检测 (Anomaly Detection)

正常数据的向量通常会聚集在一起。如果一个新数据的向量远离大多数向量的聚集区,它就可能是一个异常点 (如垃圾邮件、欺诈交易)

例如:一个信用卡交易反欺诈系统,通过学习海量正常交易记录 (如金额、地点、时间、商户类型等特征的向量) 形成了 “正常交易” 的向量聚集区。当一笔新的交易发生时,系统将其转换为向量。如果该向量出现在 “正常聚集区” 之外 (例如,一笔发生在通常消费地之外的高额交易),系统则会将其标记为潜在的欺诈交易并进行警报。

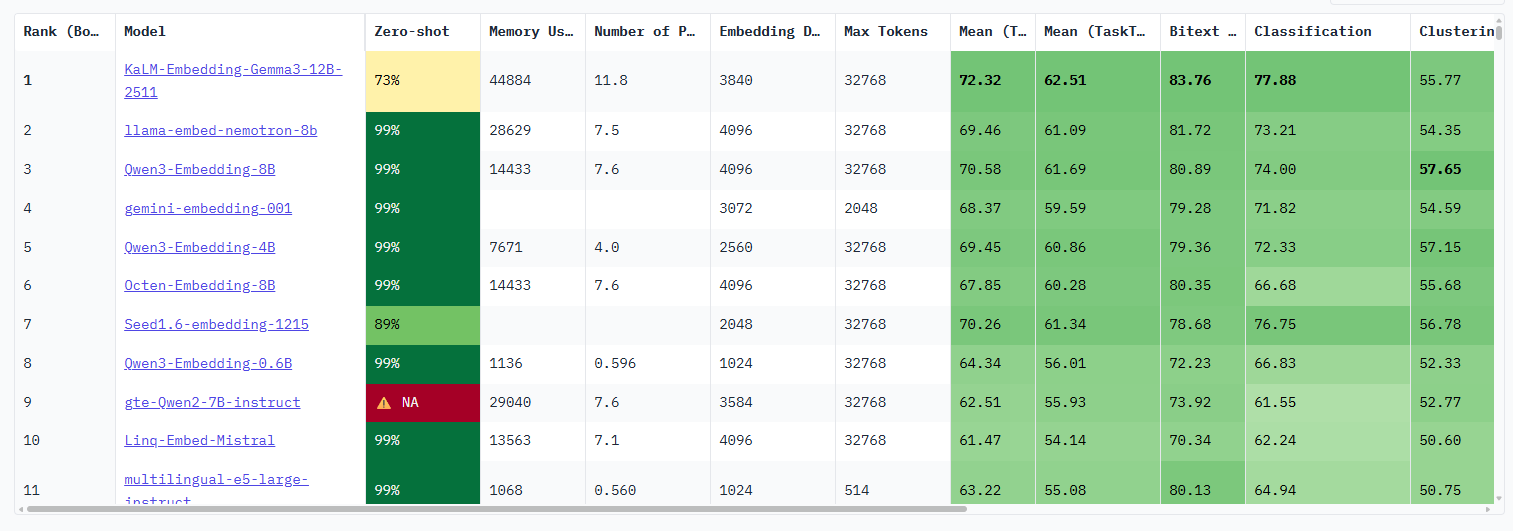

3. 主流的嵌入模型

- text-embedding-3-large (OpenAI):OpenAI 最强大的英语和非英语任务嵌入模型,默认维度3072,可降维如1024维,输入令牌长度支持为8192。

- Qwen3-Embedding-8B (阿里巴巴):开源模型,支持100+种语言,上下文成度32k,嵌入维度最高4096,支持用户定义的输出维度,范围从32到4096。推理需要一定的GPU计算资源 (例如,至少需要16GB以上显存的GPU才能高效运行)。

- gemini-embedding-001 (Google):支持100+种语⾔,默认维度3072,可选降维版本:1536维或768维,输入令牌长度支持为2048。

其他参考:

- Huggingface 的 MTEB 评测:https://huggingface.co/spaces/mteb/leaderboard

Huggingface 的 MTEB (Massive Multilingual Text Embedding Benchmark) 评测,是业界比较公认的标准。

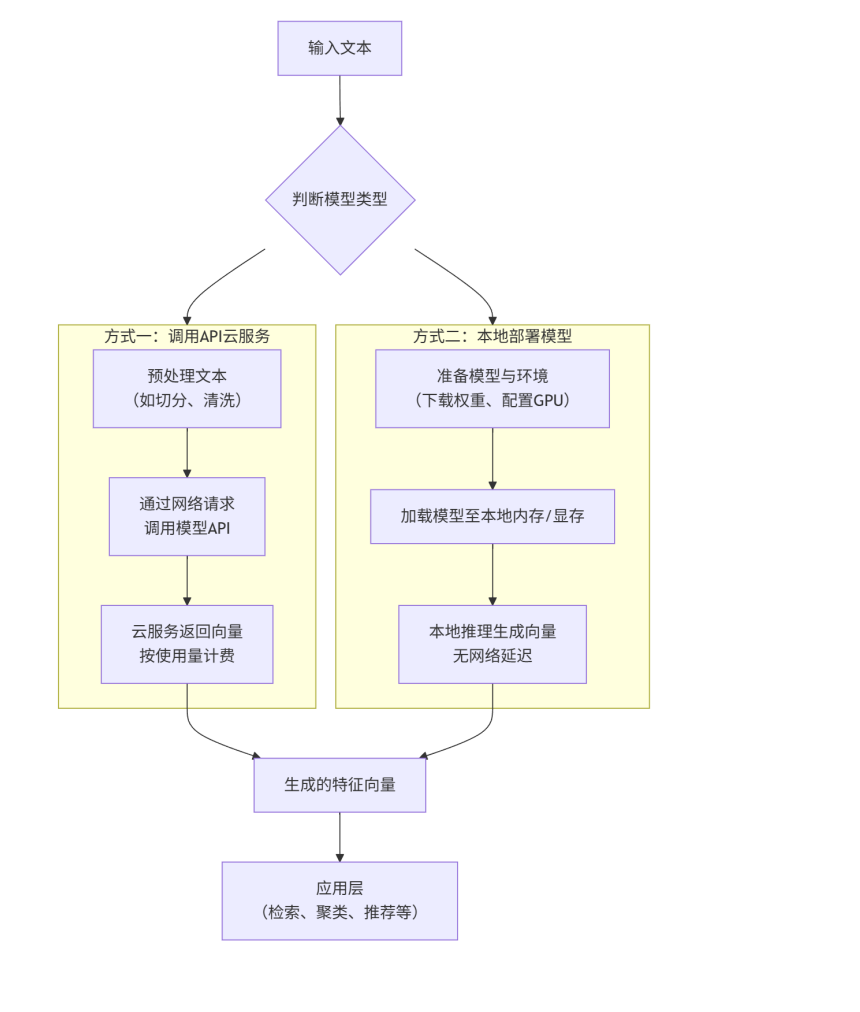

4. 嵌入模型接入方式

嵌入模型接入和使用方式根据模型类型 (开源或闭源) 有根本性的不同。下图清晰地展示了两种典型的接入流程:

4.1 API 接入 (闭源)

这是最快速、最简单的方式,无需管理任何基础设施。只需要向模型提供商的服务端发送一个 HTTP 请求即可。

适用模型:text-embedding-3-large、gemini-embedding-001 等。

通用步骤:

- 注册账号并获取 API Key:在对应的云服务平台 (OpenAI Platform, Google AI Studio/Vertex AI) 上注册账号,获取用于身份验证的 API Key。

- 安装 SDK 或构造 HTTP请求:使用官方提供的 SDK (如 openai, google-generativeai) 或直接构造HTTP请求。

- 调用 API 并处理响应:发送文本,接收返回的 JSON 格式的向量数据。

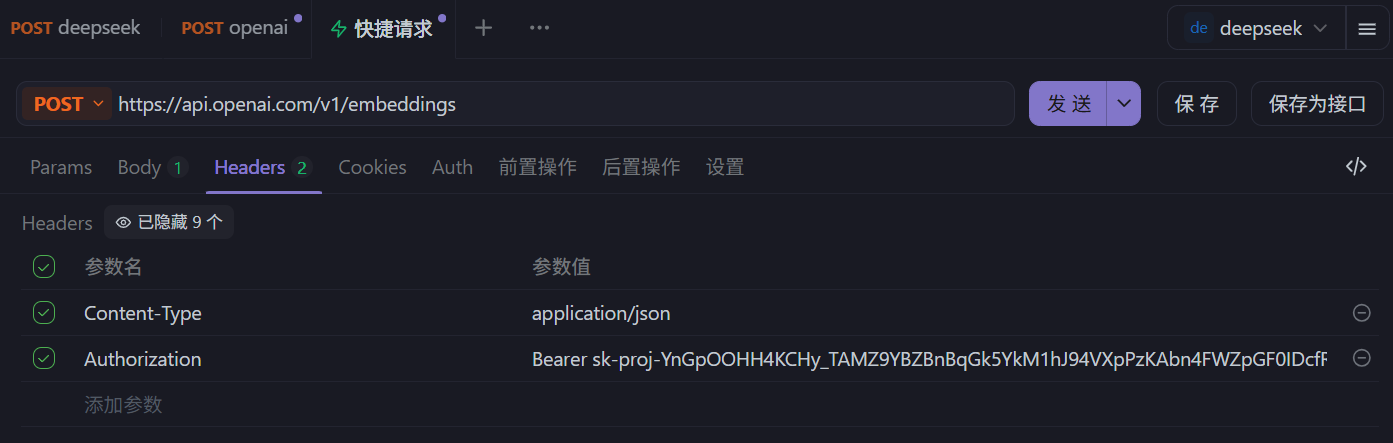

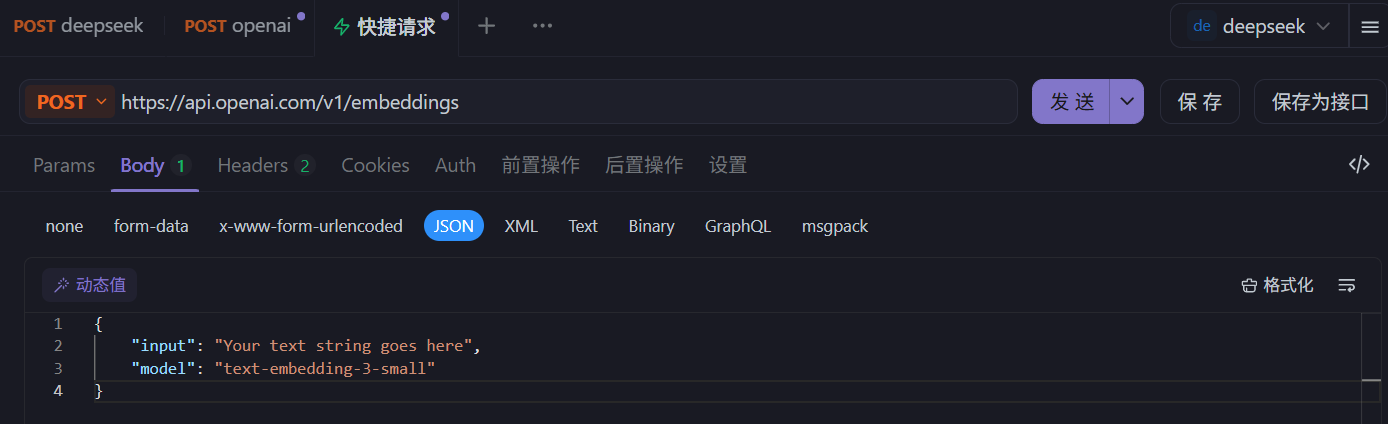

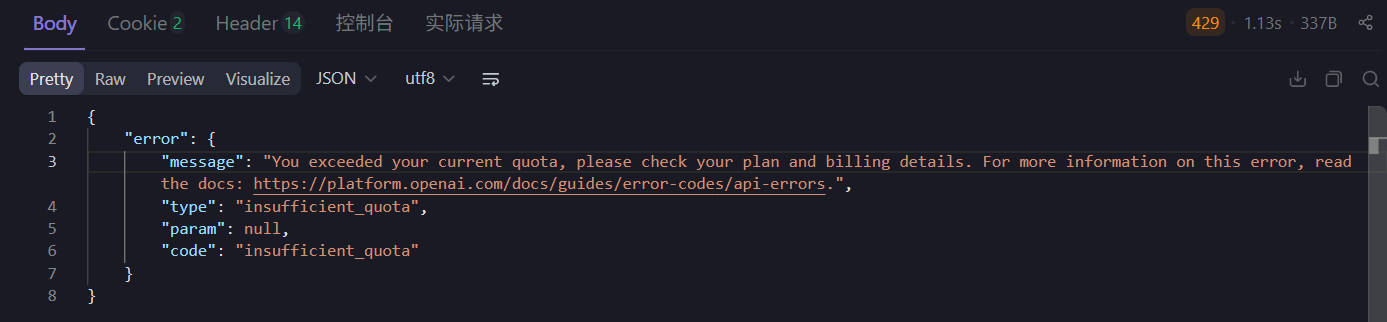

示例1:发起 HTTP 请求

curl https://api.openai.com/v1/embeddings

-H "Content-Type: application/json"

-H "Authorization: Bearer $OPENAI_API_KEY"

-d '{

"input": "Your text string goes here",

"model": "text-embedding-3-small"

}'

响应包含嵌入向量 (浮点数列表) 以及一些其他元数据:

{

"object": "list",

"data": [

{

"object": "embedding",

"index": 0,

"embedding": [

-0.006929283495992422,

-0.005336422007530928,

-4.547132266452536e-05,

-0.024047505110502243

],

}

],

"model": "text-embedding-3-small",

"usage": {

"prompt_tokens": 5,

"total_tokens": 5

}

}

由于需要充值才能正常调用

示例2:接入 SDK

安装库:pip install openai

示例代码:

# 使用 OpenAI Python SDK

from openai import OpenAI

# 1. 设置 API Key

client = OpenAI(api_key="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")

# 2. 准备输入文本

text = "这是一段需要转换为向量的文本"

# 3. 调用 API

response = client.embeddings.create(

model="text-embedding-3-large", # 指定模型

input=text,

dimensions=1024 # 可选:指定输出维度,例如从3072降维到1024

)

# 4. 获取向量

embedding = response.data[0].embedding

print(f"向量维度:{len(embedding)}")

print(embedding)

4.2 本地部署 (开源)

这种方式需要自行准备计算资源 (通常是带有 GPU 的机器) 来运行模型,适合对数据隐私、成本和控制权有更高要求的场景。

适用模型:Qwen3-Embedding-8B 等。

通用步骤:

- 环境准备:准备一台有足够 GPU 显存的服务器 (对于Qwen3-Embedding-8B,需要至少16GB以上显存)。

- 模型下载:从 Hugging Face 等模型仓库下载模型权重文件和配置文件。

- 代码集成:使用像 transformers 这样的库来加载模型并进行推理。

对于大多数初创项目或原型验证,从 API 方式开始是最佳选择。当应用规模化或面临严格的数据合规要求时,再考虑迁移到本地部署开源模型。

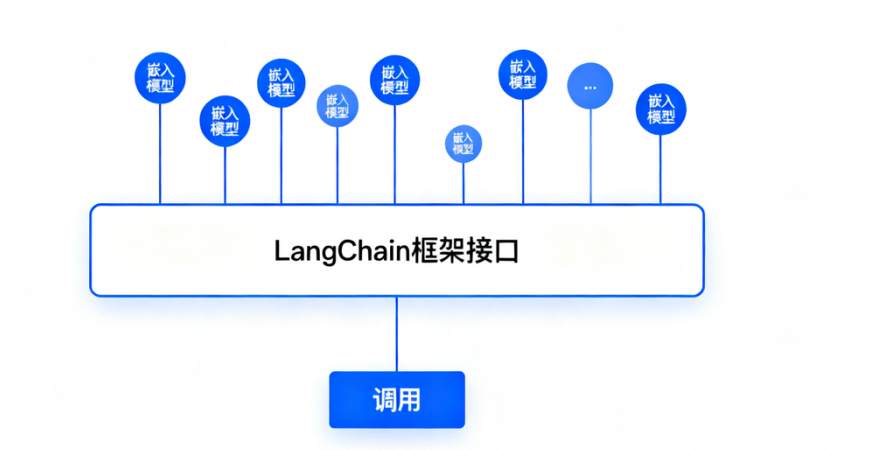

在实际应用中,直接调用嵌入模型获取结果,与直接调用原生 LLM 存在相似的问题:无论是通过API还是本地部署获得向量,下一步通常都是将它们存入向量数据库 (如Chroma, Milvus, Pinecone等) 以供后续检索。为了便于切换不同的嵌入模型,很多项目会使用像 LangChain 这样的框架,它们提供了统一的嵌入模型接口。

四. 模型平台

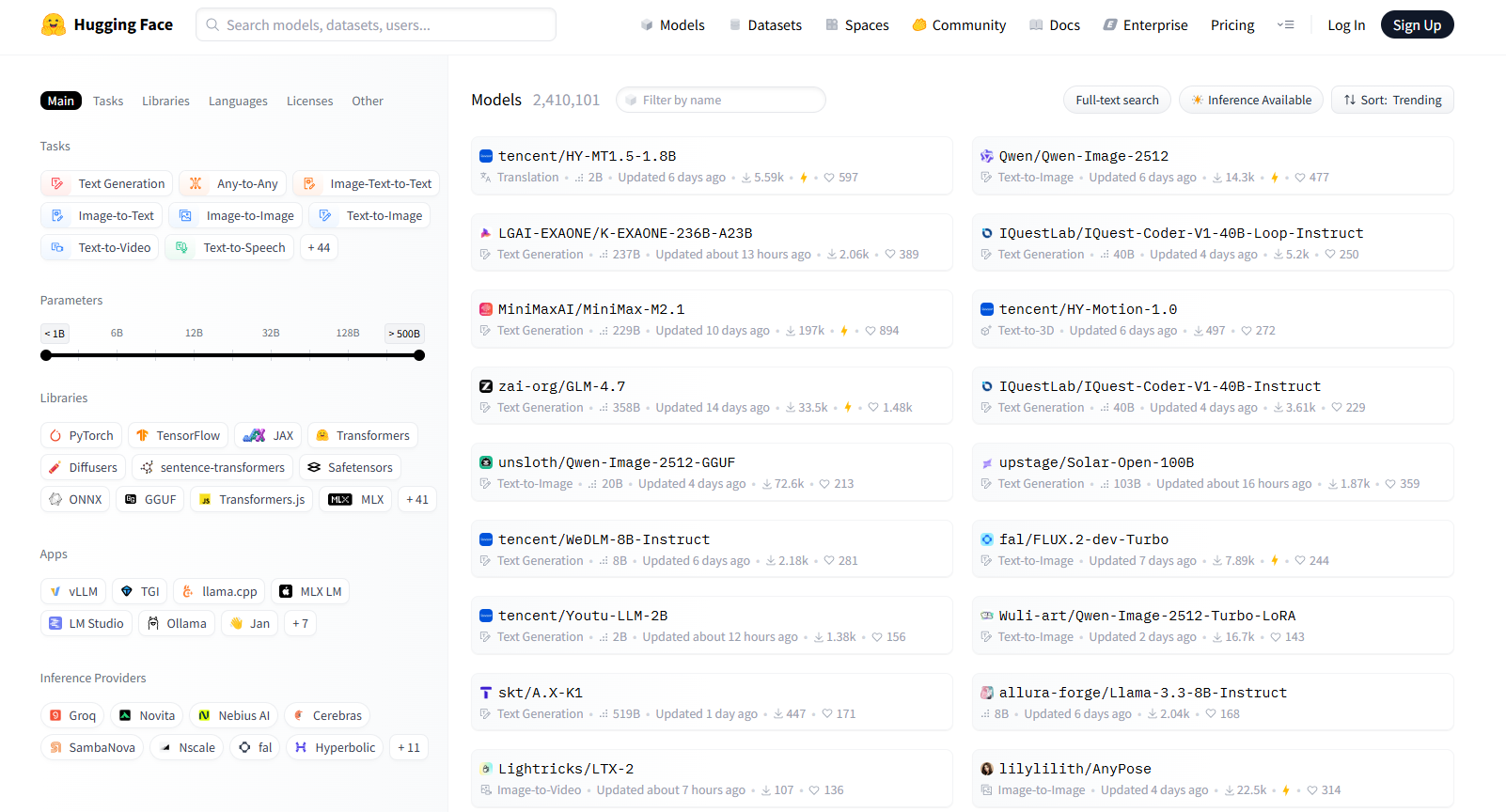

1. Hugging Face (国外)

Hugging Face 是一个知名的开源库和平台,该平台以其强大的 Transformer 模型库和易用的 API 而闻名,为开发者和研究人员提供了丰富的预训练模型、工具和资源。对于从事 AI 研究的人来说,其重要性不亚于 GitHub。

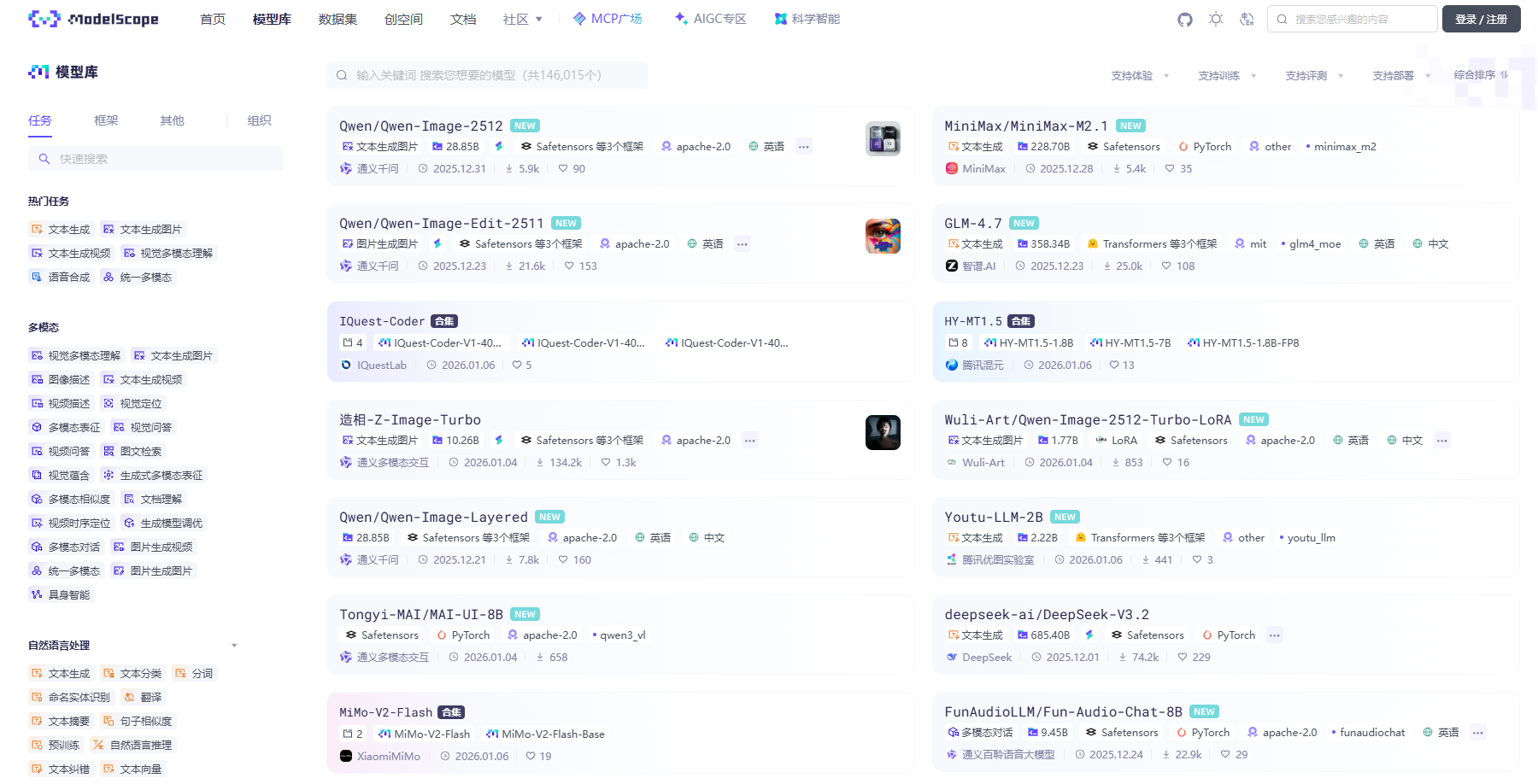

2. 魔搭社区 (国内)

魔搭 (ModelScope) 是由阿里巴巴达摩院推出的开源模型即服务 (MaaS) 共享平台,汇聚了计算机视觉、自然语言处理、语音等多领域的数千个预训练 AI 模型。其核心理念是 “开源、开放、共创”,通过提供丰富的工具链和社区生态,降低 AI 开发门槛,尤其为企业本地私有化部署提供了一条高效路径。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)