小白如何在本地部署大模型

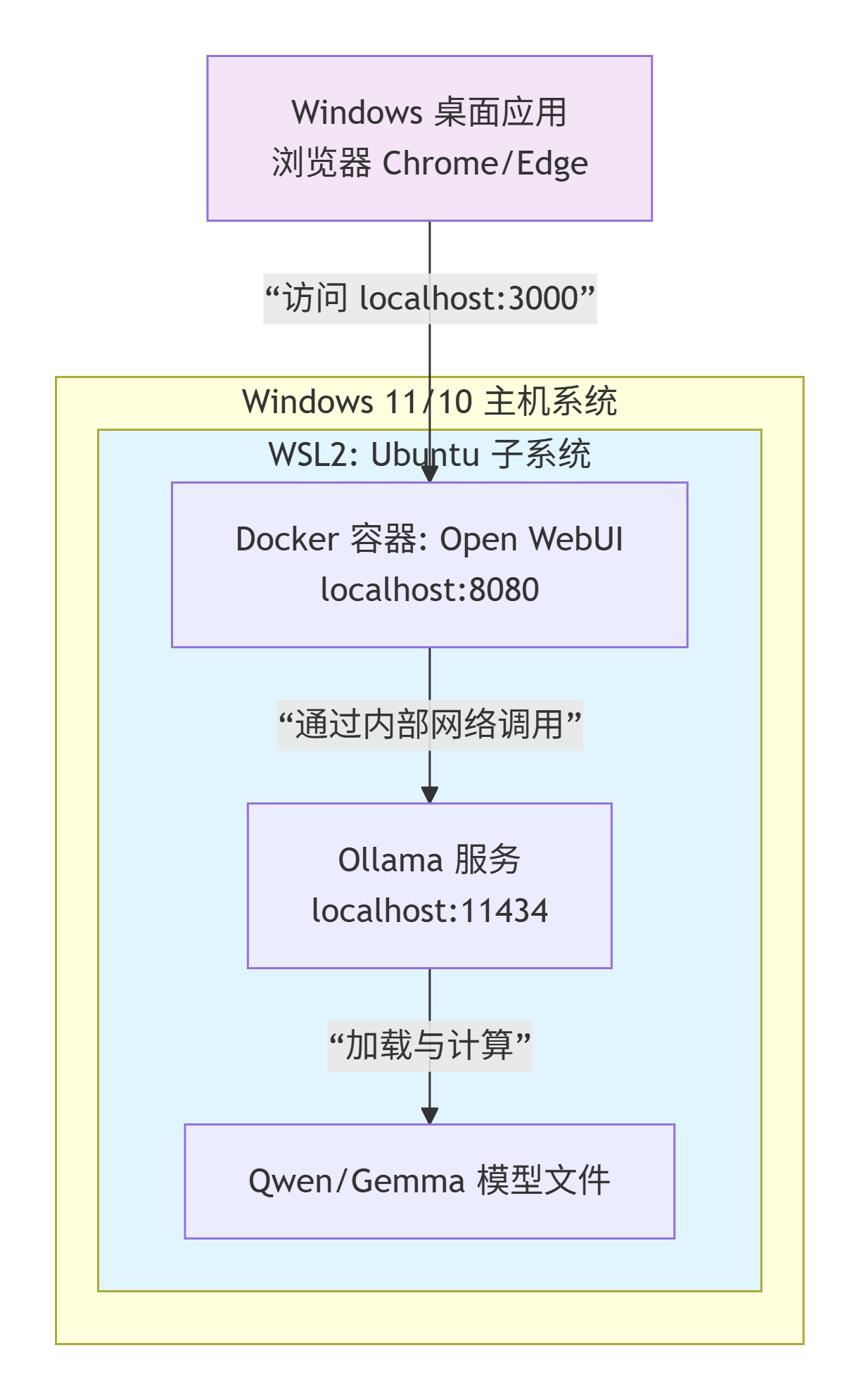

本文详细介绍了在Windows11系统上本地部署通义千问qwen2.5:7b大模型的完整流程。通过Docker Desktop和Ollama引擎,配合WSL2子系统,用户可以在无独立显卡的普通电脑(如AMDRyzen5+16GB内存)上搭建完全本地化的AI对话环境。教程涵盖环境配置检查、Docker安装、WSL2设置、Ollama部署、模型下载及OpenWebUI连接等关键步骤,并提供了常见问题的

文档概述

本文档详细记录电脑小白了在Windows 11系统上,如何部署qwen2.5:7b(通义千问)大模型。全程靠ai指引完成。

最终成果:

- 在个人电脑上搭建一个完全本地化、免费、保护隐私的AI对话环境,可流畅运行如

qwen2.5:7b(通义千问)、gemma2:2b(谷歌Gemma)等主流开源大模型。 - 可以自由选择、切换甚至微调不同的开源模型,打造最适合自己需求的助手。

最终状态:打开浏览器,访问 http://localhost:3000,与你专属的、安全的、强大的本地AI进行对话。

整体步骤概览:(做中学,遇到不明白的名词另开对话框问ai)

- 查看电脑配置

- 安装 Docker Desktop

- 安装 Ollama(本地模型引擎)

- 拉模型+启动 Open WebUI

- 在 WebUI 里绑定 Ollama

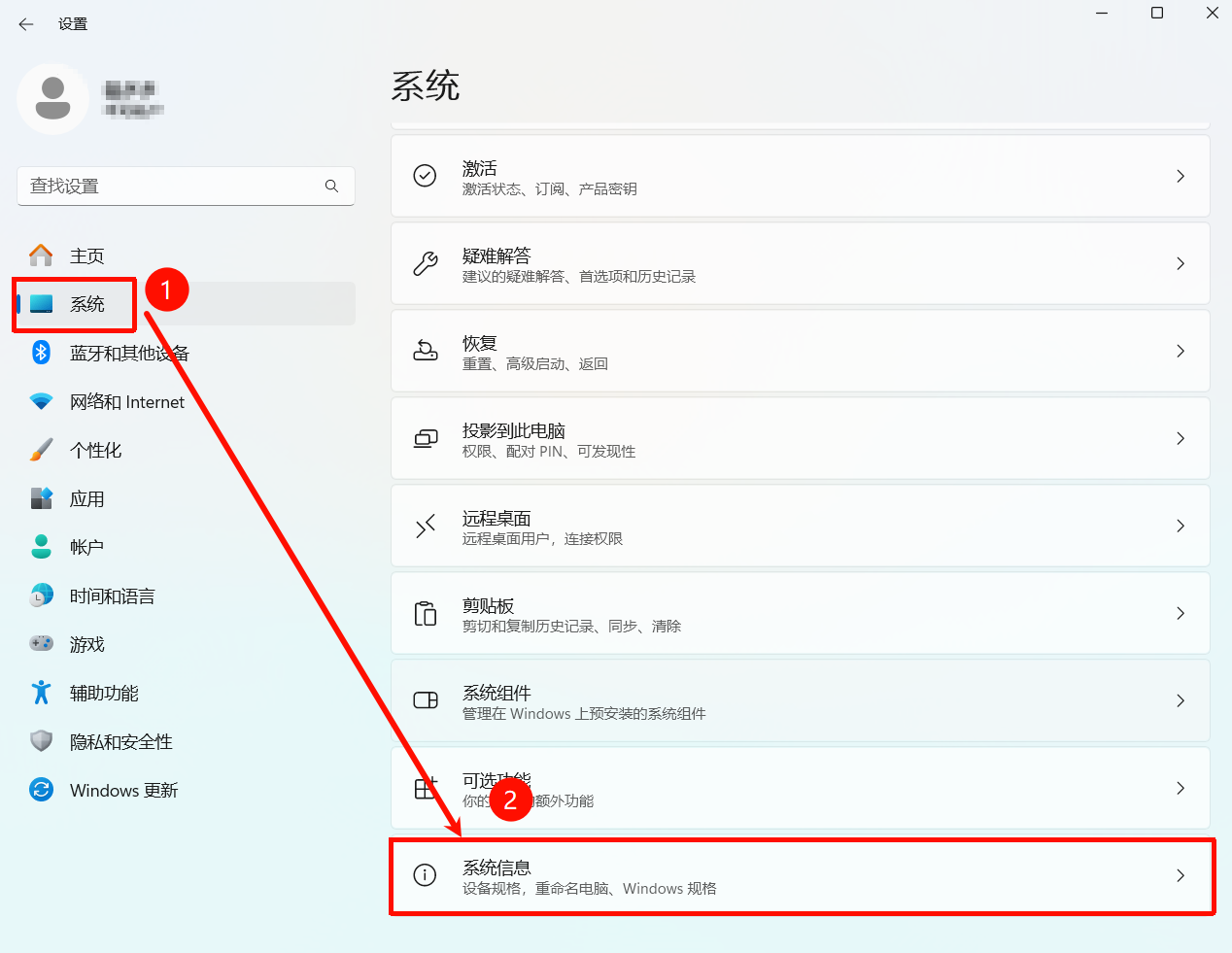

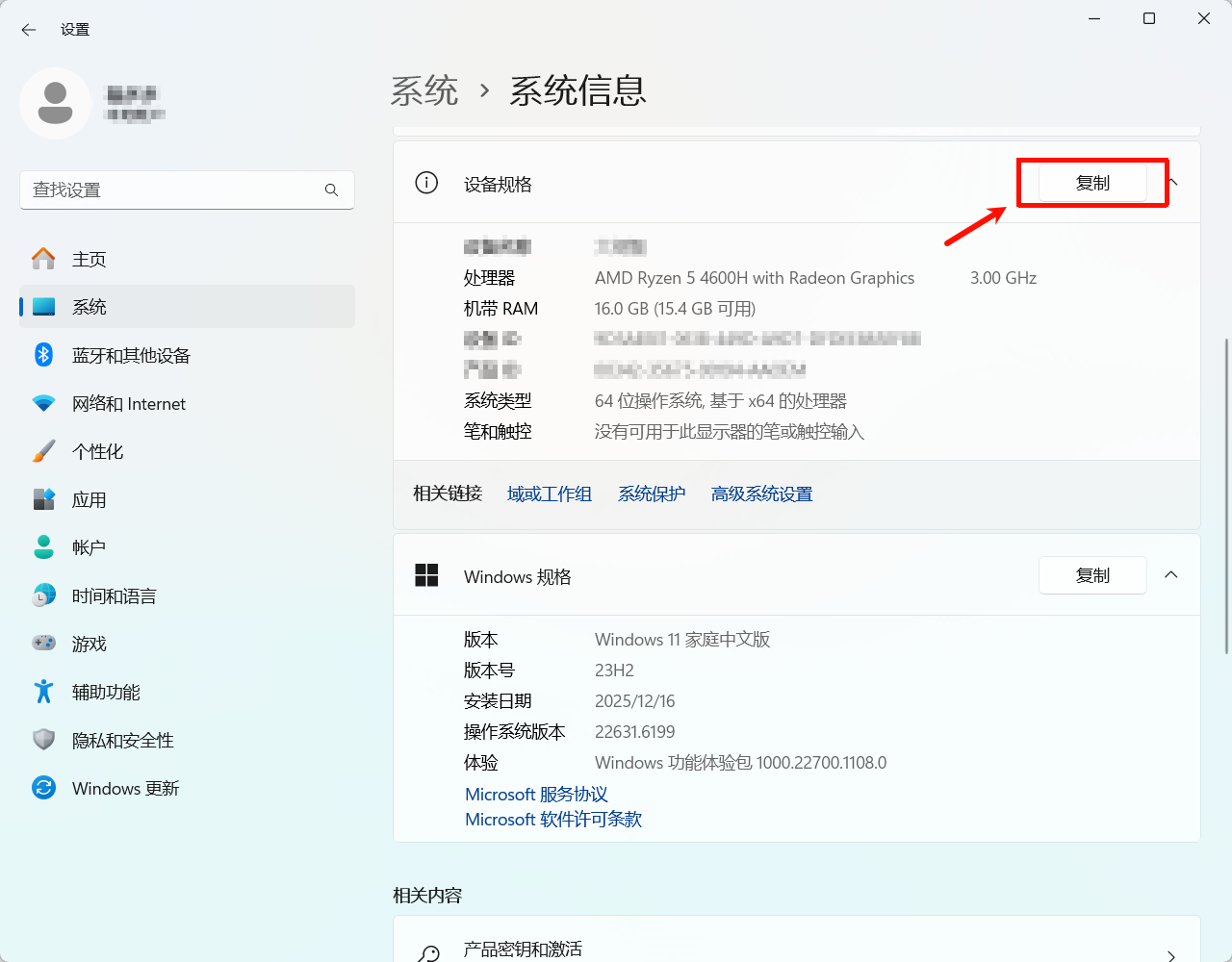

一、查看电脑配置

电脑配置如下

- 处理器:AMD Ryzen 5 4600H with Radeon Graphics

- 内存:16.0 GB

- 系统:64位 Windows 10/11,基于 x64 的处理器

- 关键点:无NVIDIA独立显卡,因此所有AI计算将依赖CPU和内存。

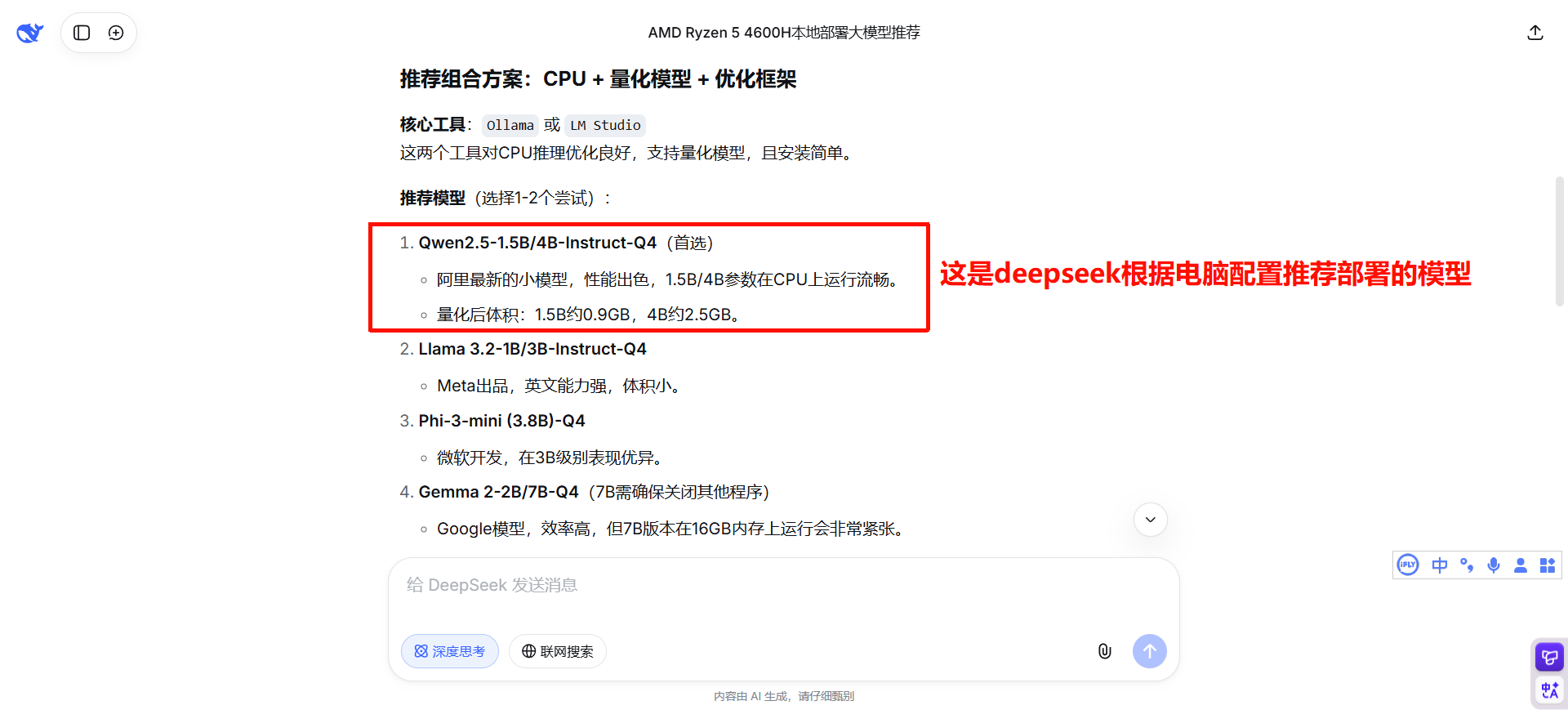

这里演示的是gpt推荐的:Open WebUI + Ollama(本地) + 偶尔用云模型 + 本地部署的模型为qwen2.5:7b

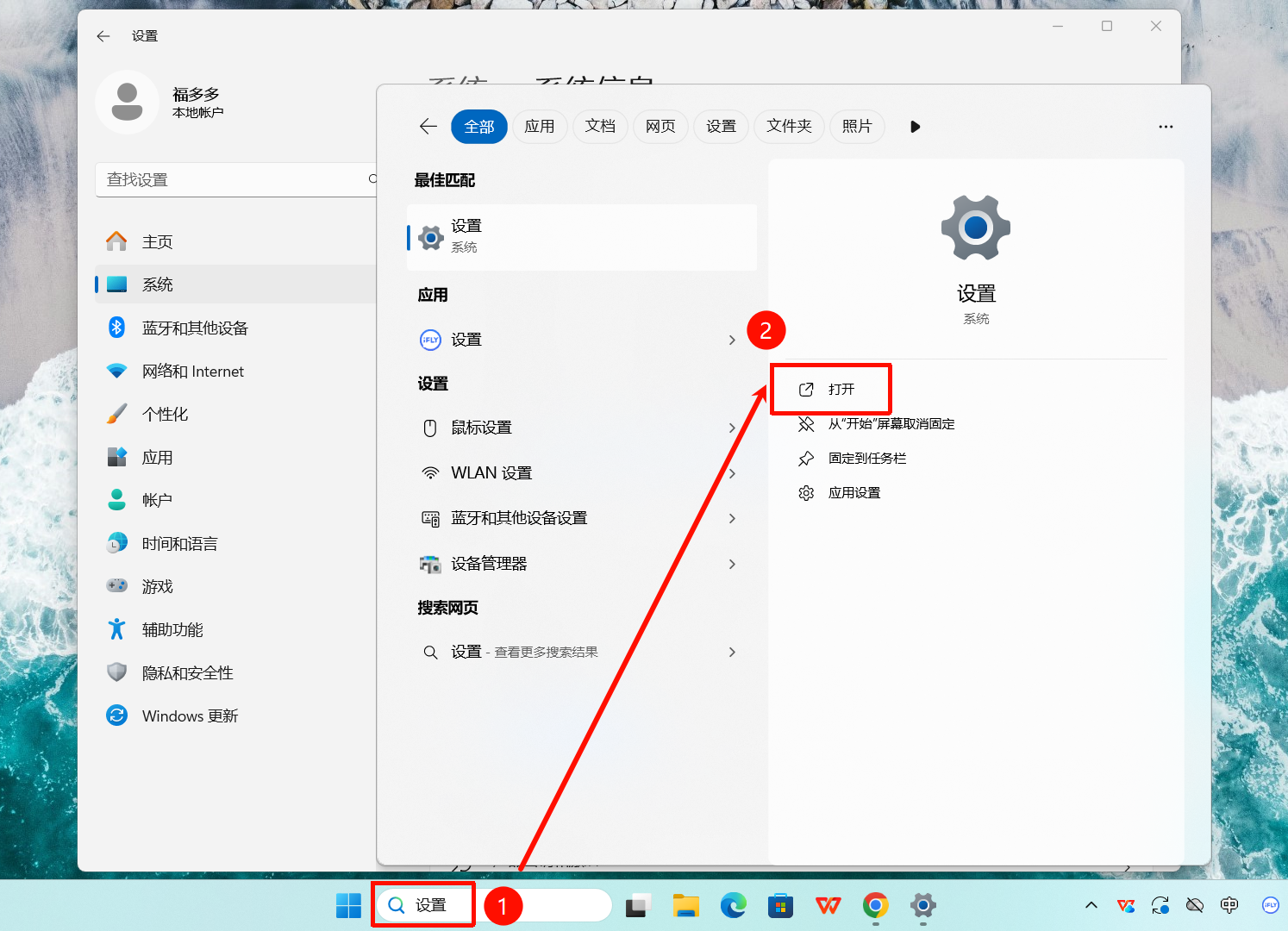

chatgpt/deepseek判断电脑配置是否能部署及部署哪一档次

提示词:电脑配置: 处理器 AMD Ryzen 5 4600H with Radeon Graphics 3.00 GHz 机带 RAM 16.0 GB (15.4 GB 可用) 系统类型 64 位操作系统, 基于 x64 的处理器。是否适合在本地部署大模型,适合的话推荐哪种组合,并且一步步引导我操作

二、 安装 Docker Desktop

1. 下载 。 下载 Windows 版(x64)。

安装教程:https://www.runoob.com/docker/windows-docker-install.html

安装地址:https://docs.docker.com/desktop/setup/install/windows-install/

2. 安装时注意这两点

安装过程中如果看到选项:

- ✅ Use WSL 2 → 一定要勾选

- 如果提示安装 WSL → 同意

装完后 重启电脑(这一步别省)

3. 验证是否成功

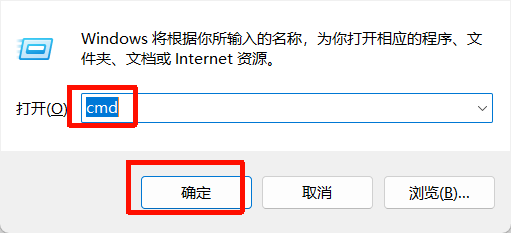

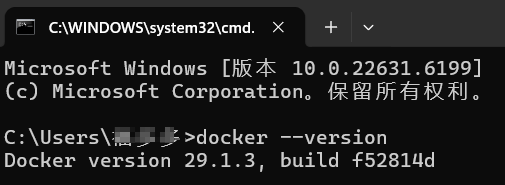

打开 PowerShell 或 CMD:

docker --version如:Win+r输入cmd

能显示版本号即可。

三、安装 Ollama(本地模型引擎)

1. 下载。 官网直接搜: Ollama Windows

网址:https://ollama.com/download/windows

2. 验证

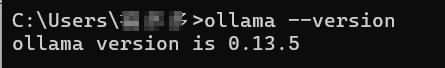

ollama --version

能显示版本号即可。

四、拉模型

1.检查WSL是否安装成功(如果安装docker时未安装成功wsl直接下载模型会失败)

Ollama依赖WSL2运行,请按顺序检查:

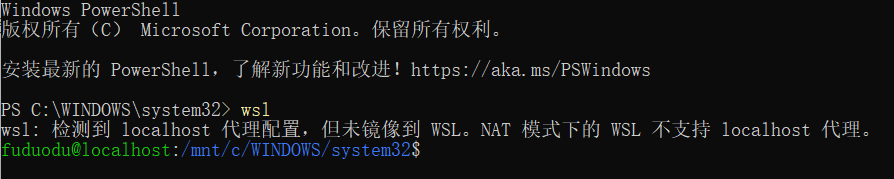

Step1:以管理员身份打开终端(PowerShell),运行以下命令测试:

# 以管理员身份打开PowerShell,检查WSL状态

wsl --status

# 如果未安装,执行安装命令

wsl --install

# 设置WSL2为默认版本

wsl --set-default-version 2如果显示 “默认版本:2”,即表示成功。

wsl --status 命令没有任何返回结果,说明WSL核心组件(包括Linux内核)完全没有安装成功,可按照以下步骤操作。

步骤一:启用Windows功能(必需的基础)

在PowerShell中执行:

- powershell

dism.exe /online /enable-feature /featurename:Microsoft-Windows-Subsystem-Linux /all /norestart

dism.exe /online /enable-feature /featurename:VirtualMachinePlatform /all /norestart- 必须重启计算机。

步骤二:手动下载并安装WSL2 Linux内核更新包(关键一步)

这是卡住大多数人的环节,请离线安装:

- 下载:直接点击链接下载:https://wslstorestorage.blob.core.windows.net/wslblob/wsl_update_x64.msi

- 安装:双击运行下载的

wsl_update_x64.msi文件,全部点击“下一步”完成安装。 - 验证:重启后打开PowerShell,运行

wsl --status。现在应该能看到详细的版本信息,并显示“默认版本:2”。如果依然没输出,重复本步骤。

步骤三:手动下载并安装Ubuntu发行版(离线安装)

同样放弃在线安装,改为离线:

- 下载:访问 https://aka.ms/wslubuntu2204 下载

Ubuntu.appx包。 - 安装:

-

- 将文件后缀

.appx改为.zip。 - 解压到任意文件夹(如

C:\WSL\Ubuntu)。 - 进入文件夹,运行

ubuntu.exe或ubuntu2204.exe。

- 将文件后缀

- 设置:首次运行会打开终端,等待初始化完成,然后设置Linux用户名和密码(务必记住)。

步骤四:最终验证与设置

- 在PowerShell中,现在

wsl --status和wsl -l -v都应该有正确输出。 - 输入

wsl命令,应能直接进入刚才安装的Ubuntu系统。

Step2:安装WSL后还需要安装一个Linux发行版:

# 查看可用发行版

wsl --list --online

# 安装Ubuntu(推荐)

wsl --install -d Ubuntu

# 或从Microsoft Store安装Ubuntu安装适用于 Linux 的 Windows 子系统

如果网络不好,觉得下载得很慢,可以通过该链接下载:https://wslstorestorage.blob.core.windows.net/wslblob/wsl_update_x64.msi

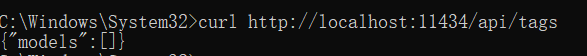

2.打开终端(PowerShell),运行以下命令测试与Ollama服务器的连接:

curl http://localhost:11434/api/tags- 正常:会返回已下载模型的列表(可能是空的JSON

{})。 - 失败:提示连接被拒绝,说明Ollama服务未启动。

3.在PowerShell(管理员)终端中输入命令

Step1:进入WSL并安装Ollama.每一步都要以“管理员”身份打开进行

wsl

注:看到类似 yourusername@DESKTOP-XXXXX:~$ 的提示符,这说明你已经进入了Linux子系统。

Step2:在WSL命令行中,执行官方的Ollama安装命令(也可以直接在ubuntu终端执行命令)

curl -fsSL https://ollama.com/install.sh | sh安装过程会需要你输入密码(就是你安装WSL时设置的Linux密码),输入时屏幕不会显示字符,输完直接按回车即可。安装完成后,运行 ollama --version,如果显示版本号即成功。

Step3:启动Ollama服务

安装完成后,Ollama服务应该会自动启动。为确保它已启动,可以运行:

ollama serve这个命令会启动服务并保持在前台运行。注意:只要这个命令行窗口不关闭,Ollama服务就会一直运行。

Step4:验证与运行模型(新开窗口)

- 保持上面

ollama serve的窗口不要关闭。 - 另外新开一个PowerShell窗口(同样以管理员身份),再次进入WSL:

wsl- 在新开的WSL命令行里,就可以正常拉取和运行模型了,直接进入Ubuntu终端就不用像powershell先输入wsl。例如:

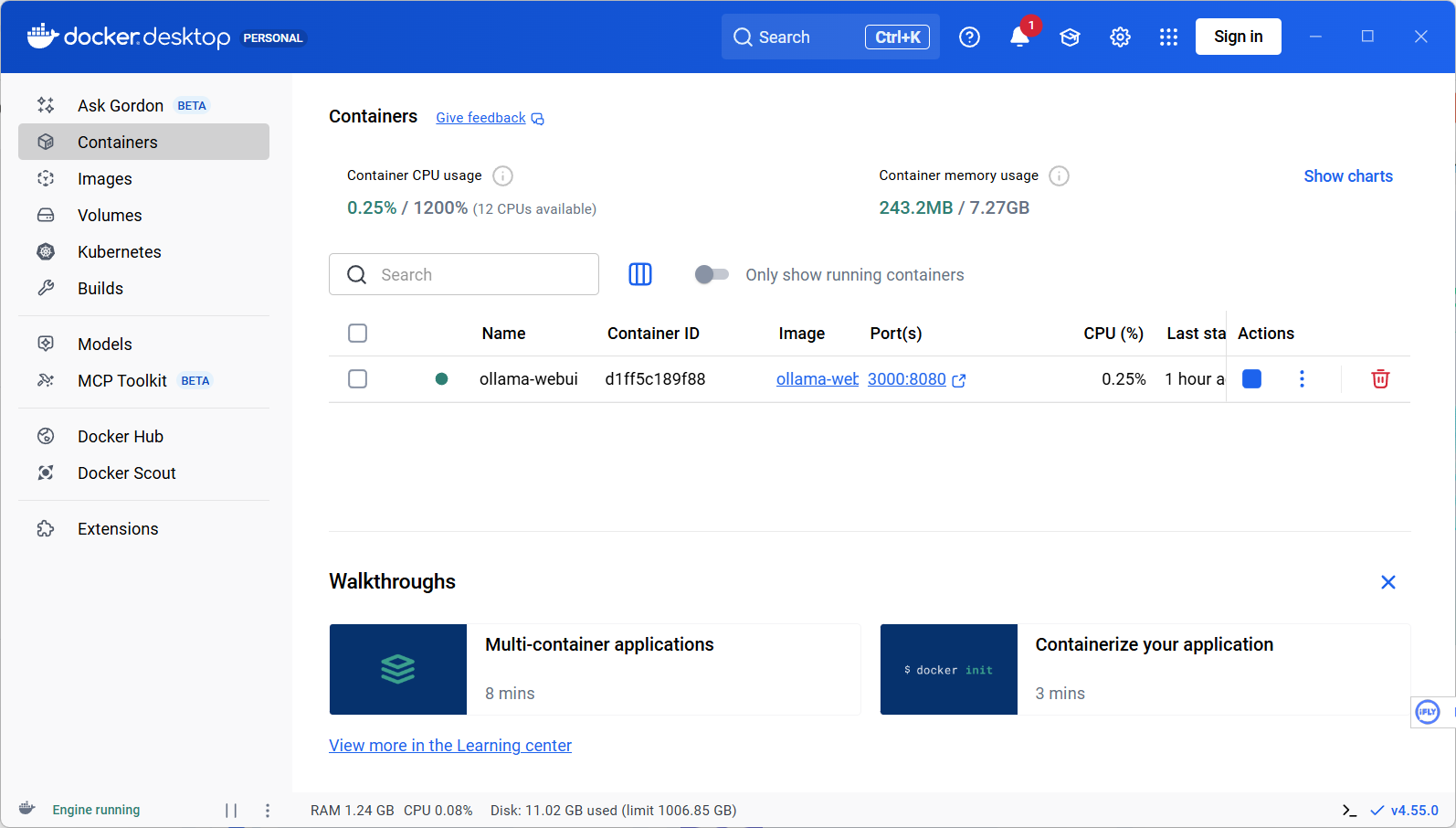

ollama run qwen2.5:7b4.在ubuntu终端执行以下一行命令即可启动Open WebUI

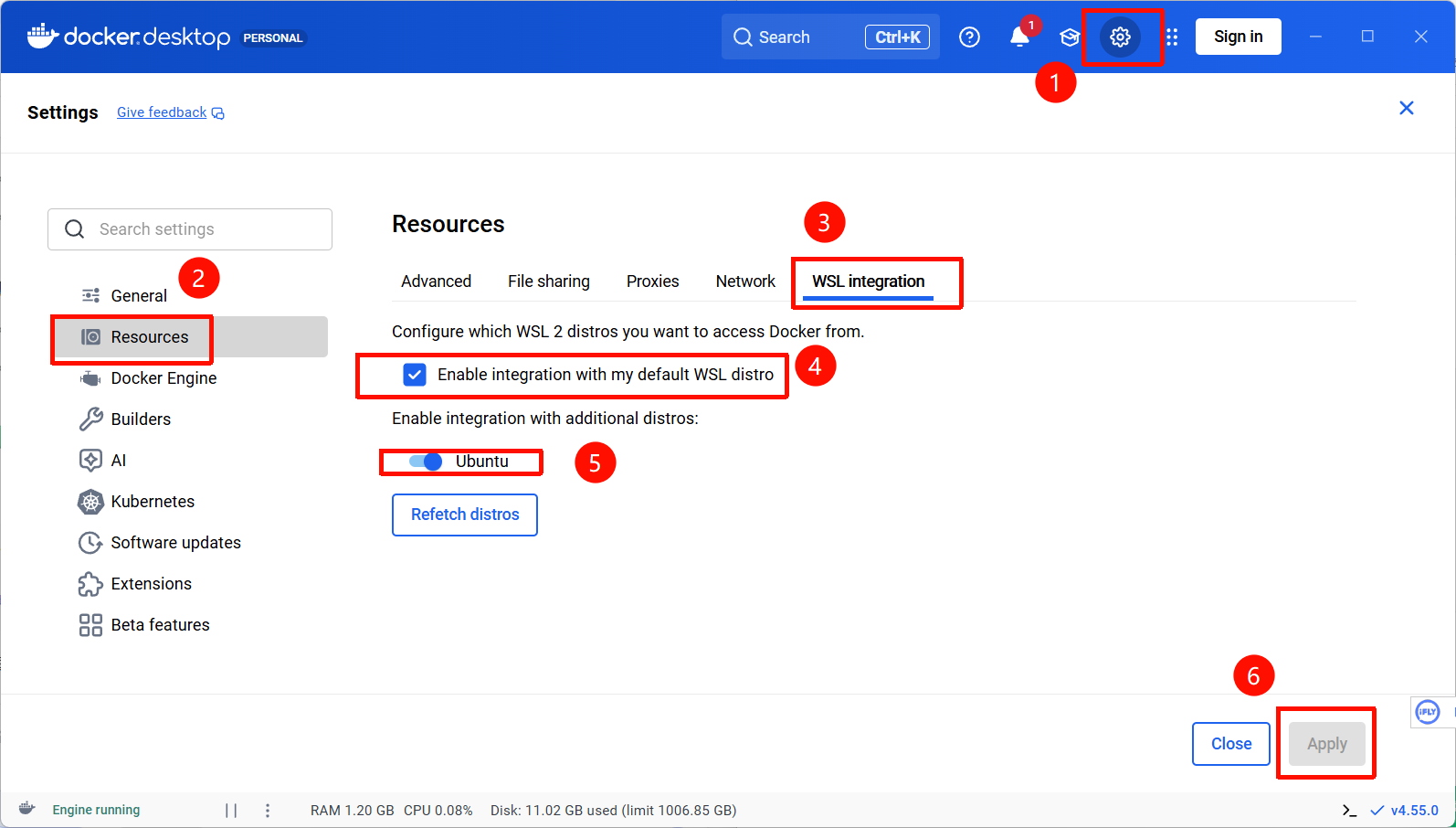

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main执行该命令后如果提示错误1:

xxx@localhost:~$ docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghrc.io/open-webui/open-webui:main

The command 'docker' could not be found in this WSL 2 distro.

We recommend to activate the WSL integration in Docker Desktop settings.

For details about using Docker Desktop with WSL 2, visit:

https://docs.docker.com/go/wsl2/解决方案:在docker desktop中按图设置

执行该命令后如果提示错误2:

xxx@localhost:~$ docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghrc.io/open-webui/open-webui:main

permission denied while trying to connect to the docker API at unix:///var/run/docker.sock这个错误是因为你的Ubuntu用户(fuduodu)没有权限访问Docker服务。需要将你的用户添加到 docker 用户组中。这是一个标准的Linux权限配置步骤。

解决方案:

# 1. 将当前用户添加到名为“docker”的用户组中(需要输入你的Ubuntu密码)

sudo usermod -aG docker $USER

# 2. 应用新的组权限(关键!必须执行这一步)

newgrp docker

# 3. 测试权限是否已修复

docker ps

# 如果状态是 “Up”,并且端口映射显示 0.0.0.0:3000->8080/tcp,就说明服务已经就绪。如果显示空列表(CONTAINER ID IMAGE ...)而没有错误,说明权限配置成功。启动等待约1分钟后,在浏览器访问 http://localhost:3000,注册账号后即可使用。在界面中,你可以直接选择已通过Ollama下载好的模型进行对话。

可能遇到的问题1:输入网址后如果提示“This page isn’t working localhost didn’t send any data.”

这个错误提示通常意味着 Docker 容器内的应用尚未启动完成,或者端口映射/网络连接存在问题。

解决方案:

Step1:检查容器状态(最关键)

docker ps -a- 正常情况:应看到

open-webui容器的 STATUS 显示为Up,并且 PORTS 列显示0.0.0.0:3000->8080/tcp。 - 如果状态是

Exited:说明容器启动失败了,直接跳到第3步查看日志。

Step2. 检查端口监听

如果容器状态是 Up,检查端口是否正常监听:

bash

# 在 WSL 内部检查

curl -s -o /dev/null -w "%{http_code}" http://localhost:8080- 如果返回

200或302:说明容器内的服务(端口8080)已就绪,问题出在从Windows到WSL的端口转发。请尝试在Windows浏览器中访问:http://127.0.0.1:3000或http://<你的WSL IP>:3000(在Ubuntu终端用hostname -I查看IP)。 - 如果返回

000或其他错误:说明容器内服务未响应,继续第3步。

Step3. 查看容器启动日志(定位问题根源)

docker logs -f open-webui- 仔细观察最后几行日志,常见情况有:

-

- 成功:看到

Application startup complete.或Uvicorn running on...,说明应用已启动,请稍等30秒再刷新浏览器。 - 错误:

- 成功:看到

-

-

- 端口被占用:

address already in use。需要先停止冲突的服务或更改端口(例如将-p 3000:8080改为-p 3001:8080)。 - 权限不足:

permission denied。可能需要检查数据卷权限。 - 数据库连接/依赖问题:会有具体的报错堆栈信息。

- 端口被占用:

-

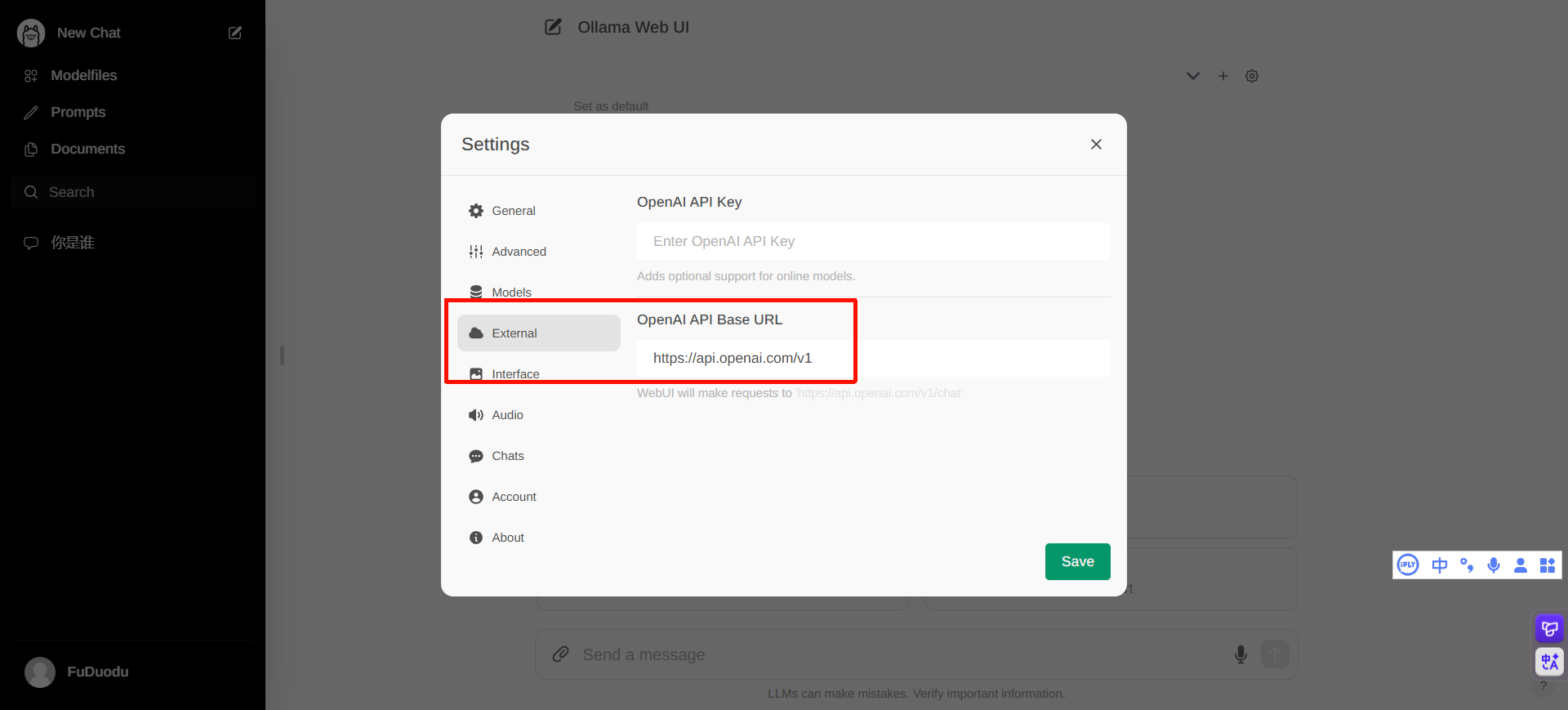

5.WebUI页面打开后,模型列表为空怎么办?

-

- 根本原因:WebUI无法连接到Ollama服务。

- 排查步骤:

-

-

- 确认

ollama serve服务正在运行。 - 最佳实践:不要使用

host.docker.internal,而是直接使用 WSL2的IP地址,可以绕过复杂的Docker网络解析问题。

- 确认

-

最后:

问题1:为什么要在linux ubuntu里面配置部署?

AI模型的核心引擎是“Linux原生应用”,Ubuntu (WSL) 在这里扮演的不是“另一台电脑”,而是Windows系统里一个完全原生、高性能的Linux兼容层(或称为“子系统”),专门用来运行那些为Linux生态打造的关键软件。

|

层面 |

原因说明 |

类比 |

|

技术生态 |

Ollama的引擎、AI模型框架(如llama.cpp)、以及大多数开源AI工具链,都是为Linux环境开发和优化的。它们依赖Linux内核的特定功能和高效的资源管理方式。 |

就像许多专业的视频剪辑、3D渲染软件最初只为macOS开发一样,有特定的“水土”。 |

|

性能与兼容性 |

在WSL2中运行Linux二进制文件的性能,远超在Windows上通过模拟或转换层运行。WSL2提供了一个完整的Linux内核,保证了与上游开源项目100%的兼容性。 |

在专业的赛车引擎(Linux内核)上跑,比把赛车引擎改装到家用轿车(Windows)上要稳定、快得多。 |

|

开发与部署一致性 |

全球的AI开发者和研究者几乎都在Linux/macOS环境下工作。通过WSL,你获得了一个与他们完全一致的命令行环境,可以无障碍地运行所有教程和社区中的命令。 |

使用全球通用的“标准电源插头”(Linux),而不是需要“转换插头”的特殊接口。 |

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)