AI原生应用领域联邦学习的法律合规问题探讨

联邦学习代表了AI发展的一个关键方向——在保护数据隐私的同时释放AI的变革潜力。然而,这一旅程充满了法律合规的挑战与机遇。成功驾驭联邦学习合规迷宫的组织将获得双重回报:不仅能够规避日益严格的监管风险,还能在数据隐私日益重要的时代建立竞争优势。正如航海者需要同时理解星辰与海洋,未来的AI领导者必须同时精通技术创新与法律合规。联邦学习的法律合规之路不是一条限制创新的狭窄小径,而是通往负责任AI未来的必

AI原生应用领域联邦学习的法律合规迷宫:从迷雾到清晰的导航图

1. 引入与连接:当AI的"智慧拼图"遇上法律的"边界线"

想象一下:一家医院想要利用AI预测疾病风险,但不能分享患者的敏感数据;一家银行希望提高欺诈检测能力,但受限于严格的金融数据隐私法规;一家科技公司渴望改进语音识别技术,但用户数据散布在数百万台设备上。

这就像一群盲人想要共同描绘一头大象,每个人只能触摸到一部分,却需要合作完成整幅图景。联邦学习正是解决这一困境的创新方案——它让AI模型能够在数据不离开原始位置的情况下共同学习和改进。

为什么法律合规至关重要? 在这个数据驱动的AI时代,联邦学习犹如在悬崖边行走的技术创新:一边是突破AI能力边界的巨大机遇,另一边是数据隐私与安全的万丈深渊。根据IBM安全研究所的数据,2022年全球数据泄露平均成本达到435万美元,较2020年增长了12.7%。法律合规不再是可有可无的"附加题",而是决定企业生死存亡的"必答题"。

在本次探索中,我们将共同穿越联邦学习的法律合规迷宫,从基础概念到复杂挑战,从地区差异到实践策略,最终掌握在AI原生应用中驾驭联邦学习的合规之道。

2. 概念地图:联邦学习法律合规的知识全景

核心概念图谱

联邦学习法律合规

├── 技术基础

│ ├── 联邦学习架构(横向/纵向/联邦迁移学习)

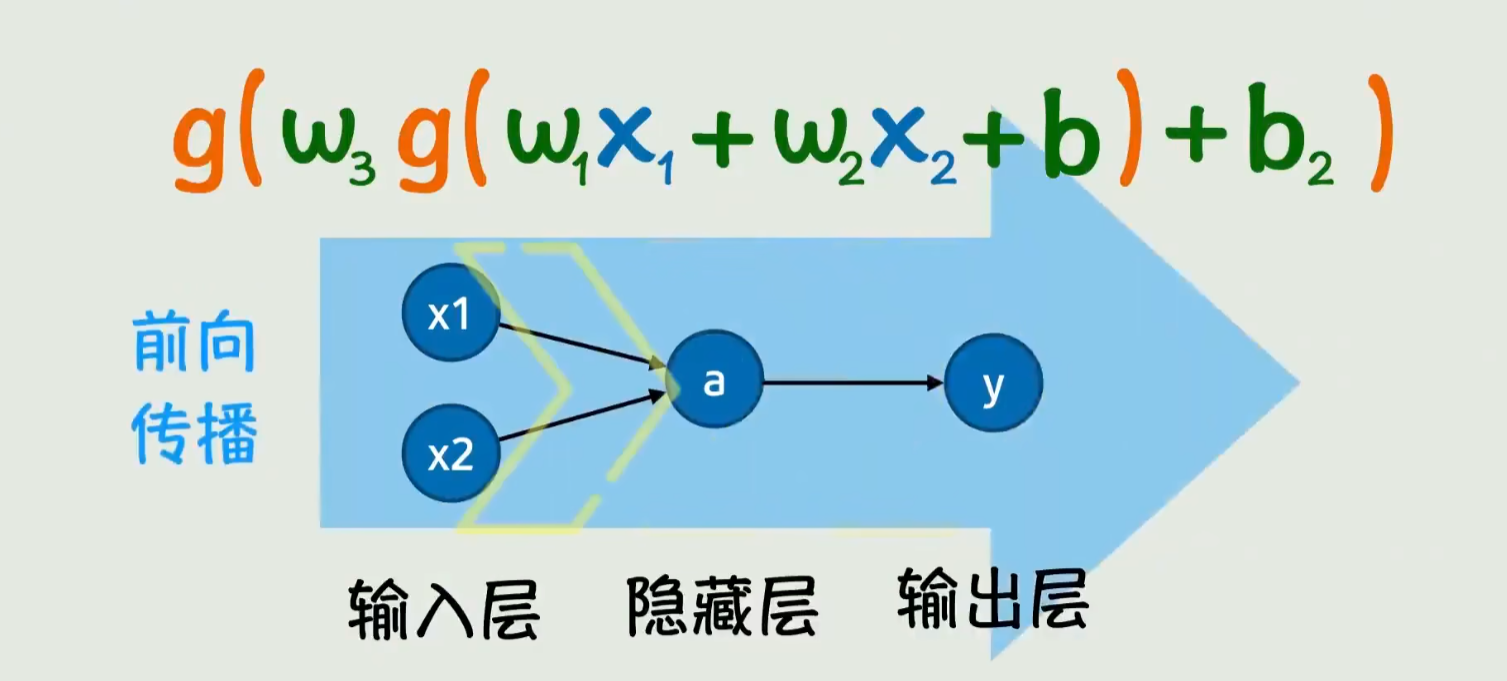

│ ├── 模型训练流程(本地训练→参数共享→全局聚合)

│ ├── 关键技术组件(加密算法、安全聚合、差分隐私)

│ └── AI原生应用特性(分布式、智能化、数据驱动)

├── 法律框架

│ ├── 数据隐私法规(GDPR、CCPA、个人信息保护法等)

│ ├── 数据安全法规(网络安全法、数据安全法等)

│ ├── AI特定法规(AI法案、算法问责法案等)

│ └── 行业特定规范(医疗HIPAA、金融GLBA等)

└── 合规维度

├── 数据收集与处理合规

├── 模型训练过程合规

├── 结果与决策合规

└── 跨境数据流动合规

关键术语解析

- 联邦学习(Federated Learning):一种分布式机器学习方法,允许模型在多个分散的设备或服务器上训练,而不将原始数据集中存储或传输

- AI原生应用(AI-Native Applications):从设计之初就以AI为核心驱动力的应用程序,而非事后集成AI功能

- 数据最小化原则:仅收集和使用实现特定目的所必需的最小量数据

- 知情同意:数据主体明确、具体地同意其数据被用于特定目的

- 差分隐私:通过在数据中添加适量噪声,确保无法从结果中识别出个体信息

- 安全多方计算:一种加密技术,允许多方在不泄露各自私有数据的情况下协同计算

3. 基础理解:联邦学习合规的"ABC"

联邦学习的"邻里互助"类比

想象你住在一个社区,邻居们都想共同提高园艺技能,但每个人都不想让别人看到自己花园的全部。联邦学习就像是:

- 每个邻居(本地设备/机构)在自己的花园里尝试种植方法(本地训练)

- 大家只分享自己的"种植心得摘要"(模型参数更新),而不是分享种子或土壤样本(原始数据)

- 一位社区园艺顾问(中央服务器)汇总所有人的心得,形成一本社区最佳实践指南(全局模型)

- 每位邻居再根据这本指南改进自己的种植方法(模型更新)

这个过程中,原始数据(花园细节)从未离开各自的财产,但整个社区的园艺水平却共同提高了。

法律合规的"三道防线"

联邦学习虽然减少了数据集中存储的风险,但并非"法外之地"。法律合规需要建立三道防线:

- 数据防线:确保参与联邦学习的原始数据收集合法

- 过程防线:保障模型训练和参数交换过程的安全性

- 结果防线:验证最终模型的决策是否公平、透明且可解释

常见合规误区澄清

❌ 误区1:联邦学习不需要数据合规,因为数据没有移动

✅ 真相:即使数据不移动,初始数据收集仍需符合隐私法规要求

❌ 误区2:联邦学习完全符合"数据本地化"要求

✅ 真相:模型参数在传输过程中仍可能泄露敏感信息,需要额外保护

❌ 误区3:一旦采用联邦学习,就无需担心跨境数据流动问题

✅ 真相:参数更新的跨境传输可能仍被视为数据流动,受相关法规约束

4. 层层深入:联邦学习合规的复杂挑战

第一层:数据合规基础挑战

数据所有权与控制权

- 多方参与联邦学习时,谁真正拥有联合训练出的模型?

- 数据提供方是否保留对其数据贡献的控制权?

- 模型更新后的数据价值如何分配?

知情同意的特殊性

传统的"一揽子"同意机制难以满足联邦学习的动态特性:

- 如何向用户解释复杂的联邦学习过程?

- 当参与方或模型用途发生变化时,是否需要重新获取同意?

- 如何实现"动态同意"机制,允许用户随时调整参与程度?

第二层:地域差异与合规冲突

全球三大监管体系比较

| 维度 | 欧盟(GDPR) | 中国(个人信息保护法) | 美国(多州立法) |

|---|---|---|---|

| 核心原则 | 数据隐私权作为基本权利 | 个人信息权益保护与数据安全并重 | 市场驱动,侧重特定风险 |

| 同意要求 | 明确、具体、可撤销 | 明示同意,敏感信息需单独同意 | 因州而异,通常要求明示同意 |

| 数据本地化 | 特定数据要求本地化 | 重要数据和核心数据需本地化 | 无统一要求,特定行业除外 |

| 跨境传输 | 严格限制,需充分保障 | 安全评估或标准合同 | 相对宽松,受特定行业限制 |

| 惩罚力度 | 最高可达全球年收入4% | 最高可达5000万元人民币 | 因州而异,CCPA最高7500美元/消费者 |

合规冲突与"最严格标准"困境

当一个联邦学习系统跨越多个司法管辖区时,企业常常面临"合规悖论":

- 欧盟要求的"被遗忘权"可能与美国的数据保留要求冲突

- 中国的重要数据本地化规定可能限制全球联邦学习的参与

- 不同地区对"敏感数据"的定义差异导致合规标准难以统一

第三层:技术特性带来的法律模糊地带

模型参数的法律性质

- 模型参数是否构成"个人信息"或"数据"?

- 参数传输是否属于"数据处理"或"数据传输"?

- 模型反向工程风险是否构成数据保护义务?

责任划分难题

联邦学习的分布式特性使责任划分变得极其复杂:

- 当模型产生歧视性结果时,谁应承担责任?(发起方/参与方/技术提供方)

- 数据提供方是否对其数据质量导致的模型偏差负责?

- 中央协调方如何确保所有参与方遵守合规要求?

第四层:AI原生应用特有的前沿问题

持续学习的合规挑战

AI原生应用通常具备持续学习能力,带来独特合规问题:

- 模型在持续学习过程中如何保持合规性?

- 长期运行的联邦学习系统如何定期验证合规状态?

- 当新的监管要求出台时,如何更新已部署的联邦学习系统?

边缘设备参与的合规边界

随着物联网设备加入联邦学习网络:

- 资源受限的边缘设备如何执行必要的合规检查?

- 个人设备参与联邦学习是否需要特殊的保护措施?

- 设备所有者与服务提供商之间的责任如何划分?

5. 多维透视:联邦学习合规的全景视角

历史视角:从数据集中到数据分散的监管演变

数据监管的历史犹如一场"猫鼠游戏",技术创新不断挑战现有法规框架:

1990s-2000s:集中式数据时代

- 监管重点:数据中心安全、访问控制

- 代表法规:HIPAA(1996)、GLBA(1999)

- 合规模式:"堡垒式"安全,保护集中存储的数据

2010s:云计算时代

- 监管重点:数据跨境流动、云服务商责任

- 代表法规:GDPR(2018)、中国网络安全法(2017)

- 合规模式:“合同+审计”,明确云服务商与客户责任边界

2020s至今:分布式AI时代

- 监管重点:数据使用而非存储、算法透明度

- 代表法规:AI法案(拟议)、中国AI治理指南

- 合规模式:“设计合规”,将合规要求嵌入技术架构

联邦学习正是这一演变的产物,代表了技术主动适应监管要求的创新方向。

实践视角:企业合规策略与实施路径

金融服务案例:全球银行反欺诈系统

某国际银行采用联邦学习构建跨地区反欺诈模型,其合规策略包括:

- 建立"合规沙盒",在封闭环境中验证联邦学习方案

- 针对不同地区设计模块化合规组件,如欧盟模块强化数据最小化

- 实施参数加密传输与安全聚合,确保符合各国数据传输要求

- 开发专用审计工具,记录模型训练全过程,满足监管报告需求

医疗健康案例:多中心临床研究

某医疗联盟利用联邦学习分析分散的患者数据,其合规策略包括:

- 获得伦理委员会批准,设计特殊的患者知情同意流程

- 实施严格的数据脱敏预处理,去除直接标识符

- 采用联邦迁移学习,减少各中心所需提供的数据量

- 建立联合治理委员会,共同监督数据使用与模型开发

批判视角:现有法律框架的局限性

"数据位置"为中心的监管与联邦学习不匹配

现有法规大多基于"数据在哪里"来确定管辖权和合规要求,但联邦学习中:

- 数据位置明确但不集中

- 有价值的洞见产生于参数聚合而非原始数据

- 模型可以在不同司法管辖区间流动和更新

"目的限制"原则的挑战

传统数据保护法规要求数据使用限于特定声明目的,但AI原生应用的联邦学习:

- 模型可能被用于未预见的新场景

- 持续学习意味着数据目的随时间变化

- 跨领域知识迁移模糊了目的边界

合规证明的"黑箱"困境

监管机构越来越要求算法可解释性和合规证明,但联邦学习:

- 分布式训练过程难以全面审计

- 模型复杂性与可解释性存在内在矛盾

- 多方参与增加了合规证明的难度

未来视角:法律与技术的协同进化

监管科技(RegTech)的兴起

联邦学习合规将催生新一代监管科技解决方案:

- 嵌入式合规引擎,自动监测联邦学习过程

- 智能合约管理数据使用权限与目的限制

- 实时合规仪表盘,提供监管机构可见性

"以数据为中心"到"以模型为中心"的监管转变

未来监管可能更关注模型输出和影响,而非数据本身:

- 模型公平性与偏见检测成为合规核心

- 结果导向的监管框架,评估实际影响而非过程

- 联邦学习特定的合规标准与认证机制

国际协调与互认机制

面对联邦学习的跨境特性,国际合作将变得更加重要:

- 建立联邦学习合规的"护照"制度

- 制定全球公认的最低合规标准

- 建立监管沙盒网络,支持跨境联邦学习试验

6. 实践转化:联邦学习合规实施路线图

合规实施框架:FL-COMPLY模型

F - Foundation (基础构建)

- 进行全面的法律合规评估,识别相关法规要求

- 建立跨职能合规团队(法律、技术、业务)

- 制定联邦学习合规章程与原则

- 评估参与方的合规成熟度

L - Legal (法律适配)

- 设计符合地区和行业法规的数据策略

- 制定灵活的知情同意机制

- 准备数据处理协议与参与方合同

- 建立合规审查与批准流程

C - Controls (控制措施)

- 实施数据分类与敏感度评估

- 部署技术保障措施(加密、差分隐私等)

- 建立访问控制与权限管理

- 设计参数传输安全机制

O - Operations (运营管理)

- 开发联邦学习合规操作手册

- 实施持续监控与异常检测

- 建立事件响应与上报流程

- 开展定期合规审计与评估

M - Monitoring (监控评估)

- 监控模型性能与公平性指标

- 跟踪合规要求的变化与更新

- 评估技术措施的有效性

- 收集利益相关方反馈

P - Proof (证据留存)

- 建立完整的审计跟踪系统

- 文档化合规决策与理由

- 保存参数更新与模型版本记录

- 准备监管报告与证明材料

L - Learning (学习改进)

- 分析合规事件与near-miss案例

- 定期开展合规培训与意识提升

- 收集跨项目的合规经验教训

- 持续改进合规框架与实践

关键合规检查点与验证方法

数据准备阶段

- ✅ 数据收集是否获得有效同意?

- ✅ 数据是否经过适当脱敏处理?

- ✅ 是否进行了数据最小化评估?

- ✅ 数据质量与合规状态是否验证?

模型设计阶段

- ✅ 算法选择是否考虑了可解释性要求?

- ✅ 是否纳入公平性与偏见缓解机制?

- ✅ 技术保障措施是否与风险匹配?

- ✅ 是否设计了合规监控点?

训练实施阶段

- ✅ 参与方是否符合预定义的合规标准?

- ✅ 参数传输是否安全且可审计?

- ✅ 聚合过程是否保护了个体贡献?

- ✅ 是否监控异常行为与潜在风险?

部署应用阶段

- ✅ 模型是否通过了合规性测试?

- ✅ 用户是否被告知模型决策的依据?

- ✅ 是否建立了申诉与人工干预机制?

- ✅ 是否制定了模型更新与退役流程?

常见风险与缓解策略

| 风险类型 | 具体风险 | 缓解策略 |

|---|---|---|

| 法律风险 | 跨境数据传输违规 | • 实施充分的安全保障措施 • 采用标准合同条款 • 进行数据保护影响评估 |

| 技术风险 | 参数反推攻击导致数据泄露 | • 实施差分隐私保护 • 采用安全聚合技术 • 监控异常的参数模式 |

| 运营风险 | 参与方不合规行为 | • 严格的参与方准入审查 • 持续监控与审计 • 明确的退出机制 |

| 声誉风险 | 模型偏见导致歧视指控 | • 多样化的训练数据来源 • 定期偏见检测与缓解 • 透明的模型评估结果 |

| 商业风险 | 合规成本过高 | • 采用模块化合规设计 • 自动化合规检查 • 早期融入合规考量 |

案例分析:成功与失败的经验教训

成功案例:苹果Siri的联邦学习部署

苹果公司在Siri语音识别中采用联邦学习,其合规成功因素包括:

- 设计"差分隐私"默认开启,自动添加保护

- 明确向用户传达联邦学习的工作方式

- 本地数据处理优先,减少数据传输需求

- 建立严格的安全聚合机制,无法追踪个体贡献

失败教训:某医疗AI项目的合规挫折

某国际医疗AI联盟因合规问题被迫终止联邦学习项目:

- 未充分考虑各国对生物识别数据的不同定义

- 采用了统一的同意机制,未适应地区差异

- 未建立有效的跨境数据传输合规框架

- 缺乏足够的透明度,引发监管机构担忧

7. 整合提升:构建联邦学习合规能力体系

核心合规原则回顾

1. 设计合规原则

将合规要求融入联邦学习系统的设计阶段,而非事后添加。这包括技术架构选择、参与方协议设计和操作流程制定。

2. 风险分层原则

根据数据敏感度、模型影响范围和监管要求,对联邦学习项目进行风险分层,匹配相应的合规措施强度。

3. 透明度原则

在技术可行范围内,向监管机构、数据主体和其他利益相关方透明化联邦学习过程,特别是数据使用和模型决策机制。

4. 责任共担原则

明确联邦学习生态系统中各方的合规责任,建立清晰的责任划分框架和争议解决机制。

5. 动态适应原则

建立能够适应法规变化、技术演进和业务需求的灵活合规框架,定期审查和更新合规措施。

联邦学习合规知识体系构建

知识维度扩展

要在组织内构建联邦学习合规能力,需要整合以下知识领域:

- 数据保护与隐私法规知识

- 联邦学习技术原理与架构

- AI伦理与负责任创新实践

- 行业特定合规要求

- 跨境监管协调机制

能力成熟度模型

联邦学习合规能力成熟度

Level 1: 被动合规 - 应对明确的合规要求

Level 2: 主动合规 - 预见潜在合规问题并采取措施

Level 3: 系统性合规 - 建立全面的合规框架与流程

Level 4: 优化合规 - 持续改进并将合规转化为竞争优势

Level 5: 引领合规 - 参与标准制定并推动行业最佳实践

思考问题与未来研究方向

战略思考问题

- 如何平衡联邦学习的创新潜力与合规要求?

- 组织应如何构建联邦学习合规的竞争优势?

- 不同规模的企业应采取何种联邦学习合规策略?

- 联邦学习能否成为数据主权与全球协作的桥梁?

前沿研究方向

- 联邦学习中的可解释性技术与合规证明

- 自动化合规监控与自适应合规系统

- 联邦学习特定的法律责任框架

- 跨国联邦学习的监管协调机制

- 去中心化身份在联邦学习中的应用

学习资源与工具推荐

核心参考资料

- 《联邦学习:隐私与激励》(学术著作)

- OECD《联邦学习与数据保护指南》

- IEEE《联邦学习系统标准》(P3652.1)

- 世界经济论坛《负责任的联邦学习实践框架》

实用工具

- OpenMined: 开源隐私计算框架

- TensorFlow Federated: 联邦学习平台

- Privitar: 数据隐私保护工具集

- FATE (Federated AI Technology Enabler): 微众银行开源联邦学习平台

- OneTrust: 隐私管理与合规平台

行业社区

- 国际联邦学习研究联盟(IFCA)

- 全球隐私技术论坛(GPTF)

- 国际数据保护与隐私专员会议(ICDPPC)

- IEEE人工智能与机器学习伦理委员会

结语:在合规与创新的平衡中前行

联邦学习代表了AI发展的一个关键方向——在保护数据隐私的同时释放AI的变革潜力。然而,这一旅程充满了法律合规的挑战与机遇。

成功驾驭联邦学习合规迷宫的组织将获得双重回报:不仅能够规避日益严格的监管风险,还能在数据隐私日益重要的时代建立竞争优势。正如航海者需要同时理解星辰与海洋,未来的AI领导者必须同时精通技术创新与法律合规。

联邦学习的法律合规之路不是一条限制创新的狭窄小径,而是通往负责任AI未来的必经之道。通过持续学习、跨界协作和前瞻性思维,我们能够构建一个既保护隐私又促进创新的数字生态系统。

在这个数据驱动的AI时代,联邦学习合规能力将成为区分领先者与跟随者的关键标志。现在就开始构建你的合规能力体系,在迷雾重重的法律迷宫中,找到通往创新彼岸的清晰航线。

更多推荐

已为社区贡献132条内容

已为社区贡献132条内容

所有评论(0)