面试必杀:对比 LangChain 与 AutoGPT/BabyAGI 的本质差异——为什么工业界更倾向于‘可控图(Graph)’?

模块化与可复用性: 每个组件都是独立的,可以单独测试、重用和替换。这大大提高了开发效率和代码质量。可预测性与可控性: 显式的链和图结构意味着执行流程是明确的。开发者可以准确地知道数据如何流动,哪一步会发生什么。这对于调试、性能优化和安全审计至关重要。调试与可观测性: 当出现问题时,可以轻松地追踪数据流,定位是哪个环节出了问题(是提示词不好?是LLM理解错误?是工具返回了错误?是检索器没找到相关信息

各位同仁,各位对大语言模型(LLM)充满热情的开发者们:

欢迎来到今天的讲座。在过去几年里,大语言模型以惊人的速度颠覆了我们对人工智能的认知。从生成文本到编写代码,它们展现出了前所未有的能力。然而,将这些强大的模型从实验室原型转化为可靠、可控、可扩展的工业级应用,却是一个充满挑战的过程。

今天,我们将深入探讨两种截然不同,但都试图解决这一挑战的范式:以LangChain为代表的“可控图(Graph)”或“组合式”框架,以及以AutoGPT和BabyAGI为代表的“自主代理(Autonomous Agent)”模式。我们的核心问题是:它们之间到底存在哪些本质差异?为什么在实际的工业应用中,我们更倾向于选择LangChain这种“可控图”的范式?

大语言模型应用开发的两种范式

在探讨具体框架之前,我们先宏观地理解一下这两种范式的核心思想。

第一种范式:组合式(Compositional)与编排(Orchestration)

这种范式认为,构建复杂LLM应用的最佳方式是将不同的功能模块(如LLM调用、工具使用、数据检索、记忆管理等)像乐高积木一样组合起来,并明确定义它们之间的执行顺序和数据流。LangChain是这种范式的典型代表。它的核心思想是通过链(Chains)、代理(Agents)和工具(Tools)等抽象,构建一个清晰、可控的执行图(Graph)。

第二种范式:自主代理(Autonomous Agent)与涌现(Emergence)

这种范式追求的是让LLM本身具备更高级的推理和规划能力,使其能够设定目标、生成任务、执行任务、反思并迭代,直至达成最终目标,而无需人类在每一步进行干预。AutoGPT和BabyAGI是这种范式在早期阶段的代表,它们试图通过一个递归的自我提示(self-prompting)循环来实现高度的自主性。

现在,让我们分别深入剖析这两种范式。

LangChain:构建可控的LLM应用图谱

LangChain是一个用于开发由语言模型驱动的应用程序的框架。它提供了一系列抽象,使得开发者可以轻松地将LLM与其他计算资源(如API、数据库、文件系统、矢量数据库等)结合起来,构建出复杂的应用逻辑。LangChain的核心优势在于其模块化和可组合性,它鼓励开发者以清晰、结构化的方式定义LLM应用的执行流程,形成一个可控的“图”。

LangChain的核心组件

LangChain通过以下核心抽象来构建其“图”:

- 模型(Models): 封装了不同类型的语言模型(LLM, ChatModel, Embeddings)。

- 提示词(Prompts): 管理和优化与LLM交互的提示词模板。

- 链(Chains): 将多个组件(如LLM、提示词、其他链)链接在一起,形成一个执行序列。

- 代理(Agents): LLM作为控制器,根据用户输入和可用工具决定下一步行动。代理是动态链的一种形式。

- 工具(Tools): 代理可以调用的外部函数或服务,用于执行特定任务(如搜索、计算、代码执行)。

- 记忆(Memory): 存储和管理对话历史,使LLM能够在多轮对话中保持上下文。

- 检索器(Retrievers): 从外部知识库中检索相关信息,通常与矢量数据库结合使用(RAG)。

LangChain的“图”概念

在LangChain中,“图”并非指一个显式的图形化界面,而是指其内部组件之间逻辑上的连接和数据流。每一个链、工具调用、记忆操作或检索步骤都可以被看作图中的一个节点,而它们之间的执行顺序和数据传递则构成了图的边。这个图通常是一个有向无环图(DAG),意味着执行流程是可预测、可追溯的。

让我们通过一些代码示例来感受LangChain的组合性。

示例1:基础LLM调用与提示词模板

from langchain_openai import ChatOpenAI

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.output_parsers import StrOutputParser

# 1. 初始化模型

llm = ChatOpenAI(model="gpt-4", temperature=0)

# 2. 定义提示词模板

prompt = ChatPromptTemplate.from_messages([

("system", "你是一个专业的Python编程助手。"),

("user", "{question}")

])

# 3. 创建一个简单的链

# 使用LCEL (LangChain Expression Language)

chain = prompt | llm | StrOutputParser()

# 4. 调用链

response = chain.invoke({"question": "用Python实现一个快速排序算法。"})

print(response)在这个例子中,我们看到了一个最简单的链:prompt -> llm -> parser。数据流是清晰的,每一步的输入和输出都明确定义。

示例2:序列链(Sequential Chain)

更复杂的任务可以通过将多个链串联起来完成。

from langchain.chains import LLMChain, SimpleSequentialChain

from langchain_core.prompts import PromptTemplate

from langchain_openai import ChatOpenAI

llm = ChatOpenAI(model="gpt-4", temperature=0)

# 第一个链:生成产品名称

template_product_name = """你是一家创新型科技公司的营销专家。

请为以下产品概念生成5个吸引人的产品名称。

产品概念:{product_concept}

产品名称:"""

prompt_product_name = PromptTemplate.from_template(template_product_name)

chain_product_name = LLMChain(llm=llm, prompt=prompt_product_name, output_key="product_names")

# 第二个链:为每个产品名称生成营销口号

template_slogan = """你是一家顶级的广告代理机构的创意总监。

请为以下产品名称生成一个简洁有力的营销口号。

产品名称:{product_name}

营销口号:"""

prompt_slogan = PromptTemplate.from_template(template_slogan)

chain_slogan = LLMChain(llm=llm, prompt=prompt_slogan, output_key="slogan")

# 组合成一个简单的序列链

# 注意:SimpleSequentialChain 的输入是第一个链的输入,输出是最后一个链的输出

# 如果需要中间结果,需要使用更高级的SequentialChain

overall_chain = SimpleSequentialChain(

chains=[chain_product_name, chain_slogan],

input_variables=["product_concept"],

verbose=True # 打印详细执行过程

)

# 调用整体链

# 这里为了演示,我们假设第一个链生成的产品名称只有一个,并将其作为第二个链的输入

# 实际应用中,需要更复杂的逻辑来处理多个名称

product_concept = "一个能通过AI分析用户情绪并推荐个性化音乐的智能耳机"

response = overall_chain.invoke({"product_concept": product_concept})

print(response)

# 实际运行中,SimpleSequentialChain 可能会把第一个链的所有输出作为第二个链的输入,导致问题。

# 为了正确处理列表,我们需要更复杂的LCEL或自定义链。

# 这里只是为了说明序列组合的概念。这个例子展示了如何将两个独立的LLMChain连接起来,形成一个两步的流程。数据从第一个链流向第二个链,每一步的职责明确。

示例3:结合检索(RAG)的链

这是工业界最常见的应用模式之一,用于解决LLM的知识盲区和幻觉问题。

from langchain_openai import ChatOpenAI, OpenAIEmbeddings

from langchain_community.vectorstores import FAISS

from langchain_core.output_parsers import StrOutputParser

from langchain_core.runnables import RunnablePassthrough

from langchain_core.prompts import ChatPromptTemplate

from langchain_community.document_loaders import TextLoader

from langchain.text_splitter import CharacterTextSplitter

# 1. 准备文档数据 (为了演示,我们创建一个虚拟的文档)

with open("state_of_the_union.txt", "w") as f:

f.write("The State of the Union address is an annual message delivered by the President of the United States to a joint session of Congress. The address traditionally includes a report on the nation's condition, along with the President's legislative agenda and national priorities for the coming year. It is typically delivered in January or February.")

# 2. 加载和分割文档

loader = TextLoader("state_of_the_union.txt")

documents = loader.load()

text_splitter = CharacterTextSplitter(chunk_size=1000, chunk_overlap=0)

docs = text_splitter.split_documents(documents)

# 3. 创建嵌入模型和矢量存储

embeddings = OpenAIEmbeddings()

vectorstore = FAISS.from_documents(docs, embeddings)

retriever = vectorstore.as_retriever()

# 4. 定义LLM

llm = ChatOpenAI(model="gpt-4", temperature=0)

# 5. 定义RAG提示词模板

template = """根据以下上下文回答问题:

{context}

问题:{question}

"""

prompt = ChatPromptTemplate.from_template(template)

# 6. 构建RAG链 (使用LCEL)

# RunnablePassthrough 允许输入直接通过,同时将检索结果添加到上下文中

rag_chain = (

{"context": retriever, "question": RunnablePassthrough()}

| prompt

| llm

| StrOutputParser()

)

# 7. 调用链

question = "什么是国情咨文?"

response = rag_chain.invoke(question)

print(response)在这个RAG链中,我们清晰地定义了数据流:用户问题首先通过retriever获取相关上下文,然后将上下文和问题一起送入prompt,接着由llm处理,最后通过StrOutputParser格式化输出。这个“图”的每个节点都扮演着明确的角色。

示例4:LangChain代理(Agents)—— 可控的动态图

LangChain的代理是其框架中一个更高级的抽象,它引入了动态决策的能力,但这种决策仍然是在一个可控的框架内进行的。代理由一个LLM(作为推理引擎)、一组工具(LLM可以使用的函数)和一个执行器(AgentExecutor)组成。LLM根据用户输入和可用的工具,动态地规划并执行一系列步骤,以达成目标。

from langchain_openai import ChatOpenAI

from langchain.agents import AgentExecutor, create_react_agent

from langchain import hub

from langchain_community.tools import WikipediaQueryRun

from langchain_community.utilities import WikipediaAPIWrapper

# 1. 初始化LLM

llm = ChatOpenAI(model="gpt-4", temperature=0)

# 2. 定义工具

wikipedia = WikipediaQueryRun(api_wrapper=WikipediaAPIWrapper())

tools = [wikipedia]

# 3. 获取ReAct代理的提示词模板

prompt = hub.pull("hwchase17/react")

# 4. 创建ReAct代理

agent = create_react_agent(llm, tools, prompt)

# 5. 创建代理执行器

agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True)

# 6. 调用代理

response = agent_executor.invoke({"input": "谁是阿尔伯特·爱因斯坦?他有什么重要的科学发现?"})

print(response["output"])在这个例子中,AgentExecutor会根据LLM的推理(基于ReAct模式),动态决定是否调用WikipediaQueryRun工具,以及如何使用其结果来回答用户问题。虽然这里有动态决策,但工具集是预定义的,LLM的思考过程(Thought, Action, Action Input)是可观察的,整个过程仍然在一个可控的“图”中执行。

LangChain方法论的优势:为什么是“可控图”?

- 模块化与可复用性: 每个组件都是独立的,可以单独测试、重用和替换。这大大提高了开发效率和代码质量。

- 可预测性与可控性: 显式的链和图结构意味着执行流程是明确的。开发者可以准确地知道数据如何流动,哪一步会发生什么。这对于调试、性能优化和安全审计至关重要。

- 调试与可观测性: 当出现问题时,可以轻松地追踪数据流,定位是哪个环节出了问题(是提示词不好?是LLM理解错误?是工具返回了错误?是检索器没找到相关信息?)。LangSmith等工具进一步增强了这种可观测性。

- 性能优化: 由于流程已知,可以针对性地优化每个节点。例如,对LLM调用进行缓存、并行执行独立的链段、对检索过程进行性能调优等。

- 集成与扩展性: LangChain为集成各种外部服务(数据库、API、消息队列)提供了标准接口,使得LLM应用能够无缝融入现有企业IT架构。

- 安全与合规: 清晰的数据流使得数据隐私、访问控制和合规性审计变得可行。可以更容易地在特定节点添加审查或过滤机制。

- 迭代与灰度发布: 由于模块化和可控性,可以对应用的不同部分进行小范围的修改和测试,逐步迭代,而不会引入全局性的不可预测风险。

AutoGPT/BabyAGI:追求极致的自主代理

与LangChain的组合式方法形成鲜明对比的是AutoGPT和BabyAGI所代表的自主代理范式。它们的核心目标是让LLM在给定一个高层目标后,能够完全自主地进行规划、执行、反思和迭代,直到达成目标。它们试图模拟一个具备高级认知能力的智能体,能够独立地思考并采取行动。

AutoGPT/BabyAGI的核心机制

虽然它们是不同的项目,但其核心思想和循环非常相似:

- 设定目标(Goal Definition): 用户提供一个高层次的最终目标。

- 任务生成(Task Generation): LLM根据当前目标和已完成任务的结果,生成一系列新的、具体的子任务。

- 任务执行(Task Execution): LLM选择一个任务,并决定使用哪些工具(如搜索引擎、文件操作、代码解释器)来完成该任务。

- 结果分析与反思(Result Analysis & Reflection): LLM评估任务执行的结果,判断是否成功,是否需要修正,或者是否需要生成新的任务。

- 循环迭代(Loop Iteration): 重复步骤2-4,直到最终目标达成或满足某种停止条件。

这个循环的关键在于LLM的“自我提示”(Self-Prompting)能力:LLM不断地问自己“我下一步该做什么?”,“我如何达成这个目标?”,“我刚才做了什么?结果如何?”,并据此调整行动。

AutoGPT/BabyAGI的简化伪代码

为了更好地理解其工作原理,我们可以用伪代码来表示其核心循环:

# 假设我们有一个名为 'llm_agent' 的函数,它能够根据提示词进行推理和生成

# 假设我们有一组 'tools',LLM可以通过特定指令调用这些工具

def run_autonomous_agent(initial_goal, llm_agent, tools):

current_goal = initial_goal

task_list = []

completed_tasks = []

while True:

# 1. 任务生成/规划阶段

# LLM根据当前目标和已完成任务,生成或更新任务列表

# 提示词可能类似:"你当前的目标是'{current_goal}'。已完成任务:{completed_tasks}。请生成下一个要执行的任务,或更新现有任务列表。"

new_tasks_or_plan = llm_agent.invoke(

f"Given the goal: '{current_goal}'. "

f"Completed tasks: {completed_tasks}. "

f"What are the next essential steps or tasks to achieve this goal? "

f"Generate a concise list of tasks."

)

# 假设llm_agent返回一个任务列表

task_list.extend(parse_tasks(new_tasks_or_plan)) # 解析LLM生成的任务

if not task_list:

print("No more tasks to generate. Goal might be achieved or agent is stuck.")

break

# 2. 任务选择阶段 (通常选择优先级最高的任务)

current_task = select_next_task(task_list)

if not current_task:

print("No pending tasks. Exiting.")

break

print(f"Executing Task: {current_task}")

# 3. 任务执行阶段

# LLM决定如何执行当前任务,可能需要使用工具

# 提示词可能类似:"你正在执行任务'{current_task}',目标是'{current_goal}'。你可以使用的工具有{tools_description}。请决定如何执行此任务,并返回你的行动和行动输入。"

action_plan = llm_agent.invoke(

f"You are working on task: '{current_task}'. "

f"Your overall goal is: '{current_goal}'. "

f"Available tools: {list(tools.keys())}. "

f"Describe your thought process and then specify an 'Action' and 'Action Input' to complete this task. "

f"If no tool is needed, state 'Action: None'."

)

# 解析LLM的行动计划

action, action_input = parse_action_plan(action_plan)

task_result = None

if action and action in tools:

print(f"Agent decided to use tool: {action} with input: {action_input}")

try:

tool_function = tools[action]

task_result = tool_function(action_input)

print(f"Tool output: {task_result}")

except Exception as e:

task_result = f"Error executing tool '{action}': {e}"

print(task_result)

else:

# 如果没有工具,或者LLM决定不使用工具,直接返回LLM的生成结果

# 这部分通常是LLM直接回答或生成内容

task_result = llm_agent.invoke(f"Based on task '{current_task}' and goal '{current_goal}', what is the direct output?")

print(f"LLM direct output: {task_result}")

# 4. 结果反思与更新阶段

# LLM评估任务结果,更新状态,并可能影响后续任务生成

# 提示词可能类似:"任务'{current_task}'已完成,结果是'{task_result}'。请反思这个结果对达成总目标'{current_goal}'的影响,并决定下一步。是否需要调整任务列表?"

reflection_and_update = llm_agent.invoke(

f"Task '{current_task}' finished with result: '{task_result}'. "

f"Reflect on this result in context of the overall goal: '{current_goal}'. "

f"What should be the next step? Update the task list if necessary. "

f"Indicate if the overall goal seems achieved."

)

completed_tasks.append({"task": current_task, "result": task_result})

task_list.remove(current_task) # 从待办任务中移除

if "overall goal achieved" in reflection_and_update.lower():

print("Overall goal appears to be achieved!")

break

# 辅助函数 (需要根据实际LLM输出格式实现)

def parse_tasks(llm_output):

# 模拟解析LLM生成的任务列表

return [task.strip() for task in llm_output.split('n') if task.strip()]

def parse_action_plan(llm_output):

# 模拟解析LLM生成的行动计划,提取Action和Action Input

# 这是一个简化版本,实际需要更健壮的解析

action_match = re.search(r"Action:s*(.*)", llm_output)

action_input_match = re.search(r"Action Input:s*(.*)", llm_output)

action = action_match.group(1).strip() if action_match else None

action_input = action_input_match.group(1).strip() if action_input_match else None

return action, action_input

# 假设的工具

def search_internet(query):

return f"Search results for '{query}': ... (simulated search result)"

def write_file(filename, content):

return f"Content written to {filename}."

# 示例调用

# tools_available = {"search_internet": search_internet, "write_file": write_file}

# run_autonomous_agent("研究最新的AI趋势并总结成报告", llm_agent_instance, tools_available)这个伪代码展示了AutoGPT/BabyAGI的核心递归循环:LLM不断地思考、行动、反思。它的强大之处在于,它不需要预先定义一个固定的执行图,而是动态地生成和调整。

自主代理方法的挑战与劣势

尽管自主代理的愿景令人激动,但在工业实践中,它们面临着巨大的挑战,这也是为什么它们目前更多地停留在研究和概念验证阶段:

- 不可控性与不可预测性: 这是最大的问题。LLM在自我提示和决策过程中可能会“幻觉”,生成错误的任务、选择不恰当的工具、陷入循环或偏离目标。由于缺乏明确的控制流,很难预测其最终行为。

- 高昂的成本: 每次任务生成、执行、反思都需要调用LLM,这可能导致大量的API调用,从而产生高昂的费用。而且,由于其不确定性,可能会在无效的循环中消耗大量资源。

- 调试困难: 当代理的行为不符合预期时,很难追踪问题出在哪里。它的“思维链”可能非常复杂,而且每次运行都可能不同,使得重现和调试变得极其困难。

- 可靠性与鲁棒性差: 代理容易在复杂或模糊的任务中失败。它们可能会卡住、崩溃或产生不相关的输出。在需要高可靠性的生产环境中,这种不稳定性是无法接受的。

- 安全与伦理风险: 如果代理被赋予了访问真实世界系统(如金融交易、数据修改)的权限,其不可预测的行为可能导致严重的后果,包括数据泄露、系统损坏甚至经济损失。

- 性能低下: 由于每一步都需要LLM进行决策和生成,整个过程通常比预定义链条要慢得多。

- 难以集成与扩展: 由于其黑盒和不确定性,很难将其作为更大系统的一部分进行集成。对外部系统的依赖和副作用也难以管理。

本质差异:图与涌现,控制与自由

现在,让我们把两种范式放在一起,进行深入的对比。它们的本质差异在于对“控制”和“自由”的取舍,以及对“可预测性”和“涌现性”的追求。

LangChain(可控图)的核心是“编排”和“组合”:它提供了一个蓝图,让开发者能够精确地定义各个组件如何协同工作,数据如何流动。它像一个经验丰富的项目经理,为每个任务分配给合适的专家(LLM、工具、检索器),并严格监控流程。

AutoGPT/BabyAGI(自主代理)的核心是“涌现”和“自主”:它希望LLM像一个独立的思考者,能够从高层目标出发,自主地规划并执行所有步骤。它像一个被赋予了高度自主权的通用型AI,在没有明确指导的情况下,试图自我驱动地解决问题。

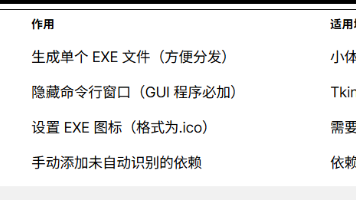

| 特性 | LangChain (可控图) | AutoGPT/BabyAGI (自主代理) |

|---|---|---|

| 核心范式 | 组合式、编排、工作流驱动 | 代理式、自组织、目标驱动 |

| 控制程度 | 高,显式定义数据流和执行顺序 | 低,行为由LLM动态生成和决策,难以预测 |

| 预测性 | 高,给定相同输入通常产生相同或可预测的输出 | 低,非确定性,容易偏离目标或陷入循环 |

| 调试难度 | 相对容易,可追踪每一步的输入、输出和决策 | 极其困难,决策过程复杂且不透明,难以复现 |

| 成本 | 可预测,可优化LLM调用,通常较低 | 不可预测,可能因无限循环或无效尝试而极高 |

| 安全性 | 容易实施安全措施和数据流审计,可设置明确的守卫 | 难以控制行为,可能产生意想不到的副作用和安全风险 |

| 可靠性 | 高,通过模块化和测试确保各部分功能稳定 | 低,容易失败、卡顿或产生不相关输出 |

| 性能 | 相对较高,可优化链条和并行执行 | 相对较低,每一步都涉及LLM推理,串行执行多 |

| 集成性 | 良好,提供标准接口与现有系统无缝集成 | 差,行为不可预测,难以作为更大系统的一部分 |

| 核心优势 | 稳定、可控、可维护、可扩展 | 潜在的通用性、探索性、解决新颖问题的能力 |

| 主要应用场景 | RAG、智能客服、数据提取、自动化工作流、API封装 | 概念验证、探索性研究、高度抽象且对容错率要求不高的任务 |

| 工业适用性 | 高,满足生产系统对可靠性、成本和安全的要求 | 低,目前阶段不适合生产环境 |

为什么工业界更倾向于“可控图”?

理解了上述本质差异,工业界为何偏爱LangChain这类“可控图”范式的原因就水落石出了。工业级应用对可靠性、可预测性、成本和安全性有着极高的要求。

-

稳定性与可靠性是基石:

在生产环境中,一个应用程序必须是稳定的、可靠的。用户需要知道,当他们输入相同的问题时,系统会给出一致或预期范围内的答案。一个可能随时“发疯”、陷入循环或偏离主题的自主代理是无法接受的。LangChain通过其明确的链式结构,确保了行为的可预测性,使得开发者可以构建出更加可靠的系统。 -

成本控制至关重要:

LLM API调用是有成本的。一个无限循环的自主代理,在短时间内消耗数千甚至数万美元的API费用并非天方夜谭。企业需要对运营成本有清晰的预期和控制。LangChain的图结构使得开发者可以精准地控制LLM的调用次数和时机,从而有效管理成本。 -

调试与维护的必要性:

任何复杂的软件系统都不可避免地会出现问题。当问题发生时,能够快速定位并修复是至关重要的。LangChain的模块化设计和可观测性使得调试变得相对容易。你可以清晰地看到数据流经的每一个节点,检查每个节点的输入和输出,从而迅速找到错误的源头。而自主代理的黑盒特性使得调试成为一场噩梦,你甚至无法重现一个错误。 -

安全与合规性要求:

在许多行业(如金融、医疗),数据安全和隐私是不可逾越的红线。应用程序必须能够证明其如何处理敏感数据,数据流向何处,以及采取了哪些安全措施。自主代理的不可控行为可能导致数据泄露、不当访问或违反合规性规定。LangChain允许开发者在图的特定节点实施严格的审查、过滤和审计机制,确保符合安全和合规要求。 -

与现有系统集成:

企业已经拥有庞大的IT基础设施和各种业务系统。新的LLM应用需要能够无缝地与这些系统集成,而不是作为一个独立的“黑盒”存在。LangChain的工具抽象和链式连接机制,使得与数据库、CRM、ERP、内部API等现有系统的集成变得相对容易和可控。 -

人机协作的需求:

在许多业务流程中,LLM并非要完全取代人类,而是作为人类的助手,提供信息、建议或自动化部分任务。这意味着需要“人机协作”的环节。LangChain的图结构可以轻松地在特定节点暂停,引入人类审查、修改或批准,然后再继续执行,实现优雅的“人机在环”(Human-in-the-Loop)工作流。 -

迭代与渐进式开发:

工业级软件的开发是一个持续迭代的过程。LangChain的模块化使得开发者可以从一个简单的LLM功能开始,逐步增加复杂性,例如先实现RAG,再加入工具使用,最后引入记忆。每一次迭代都是增量的,风险可控的。而自主代理试图一步到位解决所有问题,其不确定性使得渐进式开发变得困难。

未来展望:可控自治与边界内的智能

这是否意味着自主代理一无是处呢?绝非如此。

自主代理的愿景——即一个能够真正理解高层目标并自主行动的AI——无疑是令人兴奋的。在某些特定场景下,例如:

- 高度受限的沙盒环境:如在模拟环境中进行代码生成和测试,或者在严格隔离的环境中进行探索性数据分析。

- 需要创造性和发散性思维的初期探索阶段:例如产品概念的头脑风暴,或者初期研究方向的探索,此时对结果的准确性和可控性要求不高。

- 低风险、可容忍错误的内部工具:例如个人助理,即使偶尔出错也不会造成严重后果。

在这些场景中,自主代理的“涌现”能力可能带来意想不到的惊喜和效率。

然而,我们更可能看到的是两种范式的融合,或者说,将“自主性”限制在“可控图”的边界之内。LangChain本身也在不断发展,其AgentExecutor就是这种融合的体现:它允许LLM在一个预定义的工具集和可观测的思考链中进行动态决策,从而在一定程度上实现了“有边界的自治”。

未来可能会出现更高级的“编排器”,它们能够管理多个“受控代理”——每个代理都在其预定义的职责和工具范围内拥有一定的自主决策能力,但整体的执行流程和关键决策点仍然由一个更高层次的“可控图”来协调和监督。这就像一个企业中的各个部门,每个部门都有自己的自主权和职能,但都必须服从于公司的整体战略和管理框架。

LLM应用开发的旅程才刚刚开始。LangChain和AutoGPT/BabyAGI代表了当前两条主要的技术路线。尽管自主代理的愿景充满魅力,但在当前的技术成熟度下,对于需要高可靠性、可预测性、成本效益和安全性的工业级应用而言,以LangChain为代表的“可控图”范式无疑是更稳健、更负责任的选择。它提供了一套行之有效的方法论,帮助我们将大语言模型的强大能力,转化为稳定可靠的生产力。

更多推荐

已为社区贡献122条内容

已为社区贡献122条内容

所有评论(0)