AI原生应用中的性别偏见:检测与缓解方案

性别偏见在AI原生应用中表现为模型输出对性别属性的非预期依赖数据层:训练数据中性别分布失衡(如医疗数据中女性样本不足)或刻板印象(如职业关联);模型层:特征学习过程中隐性捕捉性别相关噪声(如语音助手对女性声音的识别误差);应用层:输出结果对不同性别群体产生不公平影响(如信用评分中女性被错误拒贷)。

AI原生应用中的性别偏见:检测与缓解方案

元数据框架

- 标题:AI原生应用性别偏见的全生命周期管理:从检测到缓解的技术体系与实践指南

- 关键词:AI原生应用、性别偏见检测、公平性算法、数据去偏、伦理AI

- 摘要:本报告系统解析AI原生应用中性别偏见的形成机制,构建"检测-诊断-缓解-验证"的全流程技术框架。通过第一性原理推导揭示偏见的数学本质,结合统计方法、因果推断与对抗学习等前沿技术,提供从数据采集到模型部署的多层次解决方案。涵盖推荐系统、智能招聘、医疗诊断等典型场景,融合技术实现细节与伦理考量,为企业构建公平AI系统提供可操作的方法论。

1. 概念基础

1.1 领域背景化

AI原生应用(AI-Native Applications)指以AI为核心驱动力,通过数据自动迭代优化功能的软件系统(如ChatGPT、Stable Diffusion、亚马逊推荐引擎)。区别于传统"AI增强型"应用(仅局部使用AI模块),其核心特征是决策逻辑由模型自主生成,数据-模型-用户反馈形成闭环。这种特性使性别偏见可能通过"数据偏差→模型固化→用户反馈强化"的循环持续放大。

1.2 历史轨迹

- 萌芽期(2010年前):早期机器学习应用(如垃圾邮件分类)因数据规模小,性别偏见未被广泛关注;

- 显现期(2010-2018):随着深度学习兴起,NLP任务(如词向量)暴露显著性别关联(如"医生→男性,护士→女性");

- 爆发期(2018至今):生成式AI(如GPT系列)、智能决策系统(如招聘AI)因高影响力场景中的偏见事件(如亚马逊招聘算法歧视女性)引发全球监管关注。

1.3 问题空间定义

性别偏见在AI原生应用中表现为模型输出对性别属性的非预期依赖,具体维度包括:

- 数据层:训练数据中性别分布失衡(如医疗数据中女性样本不足)或刻板印象(如职业关联);

- 模型层:特征学习过程中隐性捕捉性别相关噪声(如语音助手对女性声音的识别误差);

- 应用层:输出结果对不同性别群体产生不公平影响(如信用评分中女性被错误拒贷)。

1.4 术语精确性

- 人口统计平等(Demographic Parity):模型对不同性别群体的正类预测率相等(P(Y^=1∣G=female)=P(Y^=1∣G=male)P(\hat{Y}=1|G=female) = P(\hat{Y}=1|G=male)P(Y^=1∣G=female)=P(Y^=1∣G=male));

- 机会平等(Equal Opportunity):在真实正类中,不同性别群体的正类预测率相等(P(Y^=1∣G=g,Y=1)=P(Y^=1∣G=h,Y=1)P(\hat{Y}=1|G=g, Y=1) = P(\hat{Y}=1|G=h, Y=1)P(Y^=1∣G=g,Y=1)=P(Y^=1∣G=h,Y=1));

- 去偏(Debiasing):通过技术手段减少模型对性别属性的不当依赖,非消除所有性别关联(如医疗模型需合理利用性别生理差异)。

2. 理论框架

2.1 第一性原理推导

从机器学习的基本假设出发,模型f(x)f(\mathbf{x})f(x)的预测可分解为:

y^=f(x)=wTx+ϵ\hat{y} = f(\mathbf{x}) = w^T\mathbf{x} + \epsilony^=f(x)=wTx+ϵ

其中x\mathbf{x}x包含显式特征(如年龄、职业)与隐式特征(如文本中的性别代词)。性别偏见本质是参数www对性别相关特征的非因果性加权:

- 因果性关联:医疗模型中"女性→乳腺癌风险"是合理的(生理因果);

- 非因果性关联:招聘模型中"女性→离职率高"是偏见(基于历史歧视数据的统计关联)。

2.2 数学形式化

2.2.1 偏见检测指标

-

差异影响比(Disparate Impact Ratio, DIR):

DIR=P(Y^=1∣G=female)P(Y^=1∣G=male)DIR = \frac{P(\hat{Y}=1|G=female)}{P(\hat{Y}=1|G=male)}DIR=P(Y^=1∣G=male)P(Y^=1∣G=female)

理想值为1,若DIR<0.8DIR<0.8DIR<0.8或>1.25>1.25>1.25(EEOC标准),视为存在显著偏见。 -

平均绝对误差差(Mean Absolute Error Disparity, MAED):

MAED=∣E[∣Y^−Y∣∣G=female]−E[∣Y^−Y∣∣G=male]∣MAED = |E[|\hat{Y}-Y||G=female] - E[|\hat{Y}-Y||G=male]|MAED=∣E[∣Y^−Y∣∣G=female]−E[∣Y^−Y∣∣G=male]∣

衡量不同性别群体的预测误差不均衡性。

2.2.2 偏见生成模型

假设训练数据存在刻板印象偏差,标签YYY与性别GGG的关系可表示为:

Y=αG+βX+ϵY = \alpha G + \beta X + \epsilonY=αG+βX+ϵ

其中α\alphaα为偏见系数(α>0\alpha>0α>0表示对某性别群体的系统性高估)。模型学习到的参数会隐含α\alphaα的影响,导致预测偏离真实因果关系。

2.3 理论局限性

- 公平性-准确性权衡(Fairness-Accuracy Tradeoff):强制满足人口统计平等可能降低模型对真实特征的捕捉能力(如忽略与性别相关的合理预测因素);

- 交叉偏见(Intersectional Bias):现有理论多关注单一性别维度,难以处理"女性+少数族裔"等交叉群体的复合偏见;

- 动态性:用户反馈可能改变数据分布(如女性用户减少使用导致数据进一步失衡),静态公平性指标无法捕捉演化偏见。

2.4 竞争范式分析

| 范式 | 核心思想 | 代表方法 | 优势 | 劣势 |

|---|---|---|---|---|

| 统计公平 | 消除输出分布差异 | 重采样、阈值调整 | 实现简单,计算高效 | 可能忽略因果关系 |

| 因果公平 | 消除非因果性关联 | 后门调整、工具变量法 | 理论严谨,可解释性强 | 依赖因果图构建 |

| 对抗公平 | 强制模型忽略敏感属性 | 对抗去偏网络(ADN) | 端到端学习,适应性强 | 训练稳定性差 |

3. 架构设计

3.1 系统分解

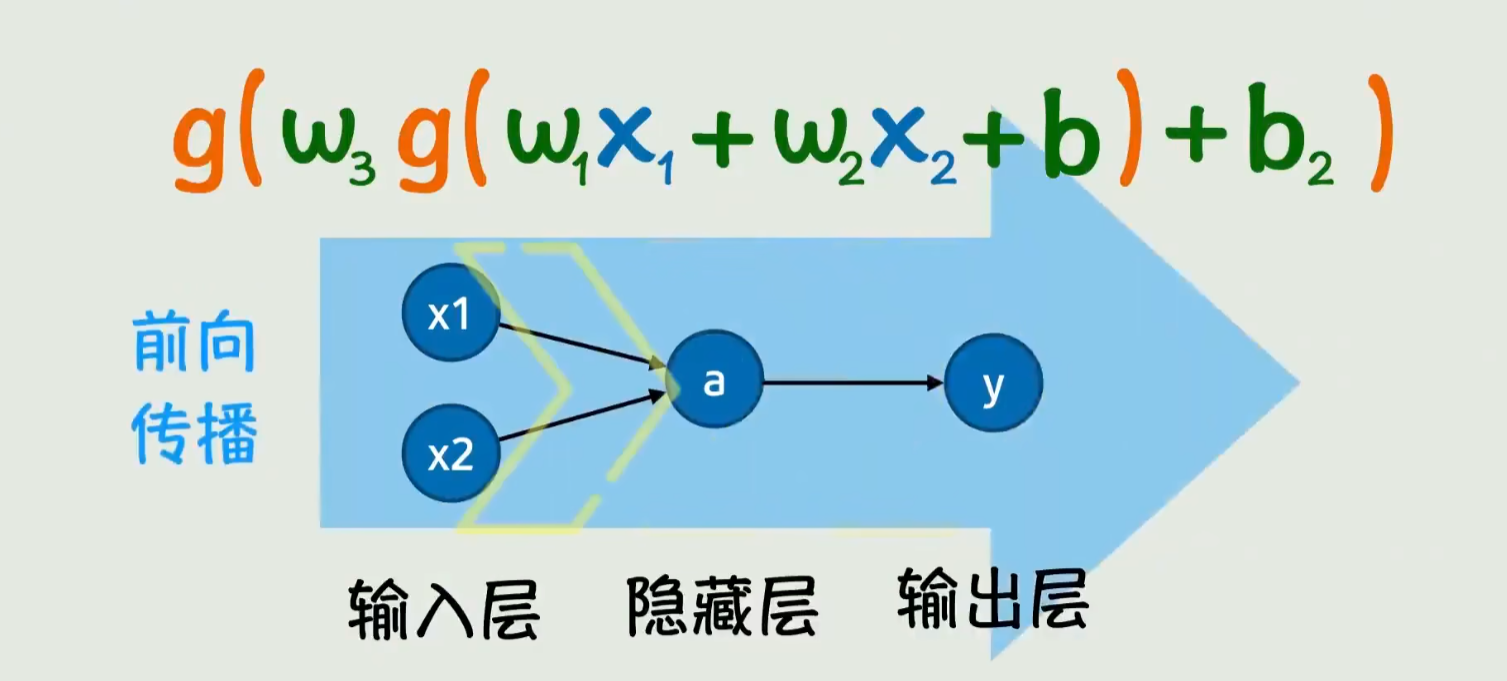

AI原生应用的性别偏见管理系统可分解为四大模块(图1):

图1:性别偏见管理系统架构

3.2 组件交互模型

- 数据采集模块:需标注性别属性(显式或通过命名实体识别隐式提取),并记录数据来源(如用户画像、社交媒体);

- 偏见检测模块:集成统计检验(如卡方检验)、模型无关方法(如SHAP值分析性别特征贡献度);

- 偏见诊断模块:通过因果推断(如Do-Calculus)区分因果性与非因果性关联;

- 偏见缓解模块:根据诊断结果选择数据层(重加权)、模型层(公平正则化)或后处理(分群体阈值)方法。

3.3 可视化表示

图2:推荐系统中的性别偏见传播路径

3.4 设计模式应用

- 观察者模式:在数据流水线中插入"偏见监测器",实时监听数据分布变化;

- 策略模式:根据应用场景(如招聘/医疗)动态切换偏见缓解策略(医疗允许合理性别关联,招聘需严格去偏);

- 责任链模式:构建"数据→模型→输出"的多级过滤链,确保每个环节的偏见被逐层控制。

4. 实现机制

4.1 算法复杂度分析

以对抗去偏网络(ADN)为例,其训练过程包含主模型fff和对抗模型ddd的交替优化:

- 主模型损失:Lf=−E[logf(x)]L_f = -\mathbb{E}[\log f(\mathbf{x})]Lf=−E[logf(x)](分类任务)

- 对抗模型损失:Ld=−E[logd(x)+log(1−d(f(x)))]L_d = -\mathbb{E}[\log d(\mathbf{x}) + \log(1-d(f(\mathbf{x})))]Ld=−E[logd(x)+log(1−d(f(x)))]

- 总损失:L=Lf−λLdL = L_f - \lambda L_dL=Lf−λLd(λ\lambdaλ为平衡超参数)

时间复杂度为O(T⋅(Nf+Nd))O(T \cdot (N_f + N_d))O(T⋅(Nf+Nd)),其中TTT为训练轮次,Nf/NdN_f/N_dNf/Nd为主/对抗模型参数量。相比标准模型,ADN的计算开销增加约30%-50%(依赖λ\lambdaλ取值)。

4.2 优化代码实现(Python示例)

以下为基于PyTorch的对抗去偏模型核心代码:

import torch

import torch.nn as nn

import torch.optim as optim

class MainModel(nn.Module):

def __init__(self, input_dim, hidden_dim):

super().__init__()

self.layers = nn.Sequential(

nn.Linear(input_dim, hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim, 1) # 二分类输出

)

def forward(self, x):

return self.layers(x)

class Adversary(nn.Module):

def __init__(self, hidden_dim):

super().__init__()

self.layers = nn.Sequential(

nn.Linear(1, hidden_dim), # 输入为主模型输出

nn.ReLU(),

nn.Linear(hidden_dim, 1) # 预测性别(0/1)

)

def forward(self, x):

return self.layers(x)

# 初始化模型与优化器

main_model = MainModel(input_dim=100, hidden_dim=64)

adversary = Adversary(hidden_dim=32)

opt_main = optim.Adam(main_model.parameters(), lr=1e-3)

opt_adv = optim.Adam(adversary.parameters(), lr=1e-4)

loss_fn = nn.BCEWithLogitsLoss()

# 训练循环(简化版)

for epoch in range(100):

for batch_x, batch_y, batch_g in dataloader: # batch_g为性别标签(0/1)

# 训练主模型(对抗模式)

main_out = main_model(batch_x)

adv_out = adversary(main_out.detach()) # 主模型输出不更新对抗模型

loss_adv = loss_fn(adv_out, batch_g.unsqueeze(1).float())

opt_adv.zero_grad()

loss_adv.backward()

opt_adv.step()

# 训练主模型(去偏模式)

main_out = main_model(batch_x)

adv_out = adversary(main_out)

loss_main = loss_fn(main_out, batch_y.unsqueeze(1).float())

loss_adv_rev = -loss_fn(adv_out, batch_g.unsqueeze(1).float()) # 反向梯度

total_loss = loss_main + 0.1 * loss_adv_rev # λ=0.1

opt_main.zero_grad()

total_loss.backward()

opt_main.step()

代码说明:通过主模型与对抗模型的博弈,主模型被迫学习与性别无关的特征,同时保持对目标任务的预测能力。λ\lambdaλ需根据具体任务调优(如招聘场景取较大值,医疗场景取较小值)。

4.3 边缘情况处理

- 稀疏数据:少数性别群体(如跨性别)样本不足时,采用合成数据生成(如GAN)或迁移学习(利用相似群体数据);

- 隐性偏见:文本中未显式提及性别时(如"坚强"被关联到男性),通过词嵌入分析(如WEAT测试)检测语义偏见;

- 动态偏见:部署后使用在线学习(Online Learning)更新模型,结合漂移检测(如KS检验)实时调整去偏策略。

4.4 性能考量

- 计算资源:对抗去偏需额外GPU内存(约增加20%),可通过模型蒸馏(Distillation)压缩主模型;

- 延迟:实时应用(如对话系统)需优化检测模块,采用轻量级统计方法(如预计算群体均值差)替代复杂模型;

- 可解释性:通过LIME/SHAP可视化性别特征对预测的贡献,帮助开发者定位偏见来源。

5. 实际应用

5.1 实施策略

以智能招聘系统为例,实施步骤如下:

- 数据审计:分析历史招聘数据的性别分布(如男性申请者占比70%,录用率30%;女性占比30%,录用率25%);

- 偏见检测:计算DIR= (0.25/0.3)/(0.3/0.7)=0.64(<0.8,存在显著偏见);

- 诊断因果:通过因果图发现"女性→婚育状态→录用率"的非因果路径(企业因担心婚育成本拒绝女性);

- 缓解方案:

- 数据层:对女性样本重加权(权重=1/群体概率);

- 模型层:加入公平正则项(惩罚性别特征的梯度);

- 后处理:对女性申请者调整录用阈值(降低10%);

- 验证:A/B测试新模型,确保DIR提升至0.85以上,同时保持录用准确率下降不超过5%。

5.2 集成方法论

- 模块化集成:将偏见检测/缓解模块封装为API(如IBM AI Fairness 360),嵌入现有ML流水线(图3);

图3:模块化集成架构

5.3 部署考虑因素

- 隐私保护:性别属性属于敏感信息,需通过联邦学习(Federated Learning)在不共享原始数据的情况下检测偏见;

- 合规性:符合GDPR(欧盟)、CCPA(加州)等法规,确保偏见缓解措施可解释(如提供"拒绝原因为工作经验不足,而非性别"的说明);

- 可扩展性:支持多语言(如阿拉伯语中的性别代词隐式表达)、多文化(如不同地区对"职业性别化"的定义差异)场景。

5.4 运营管理

- 监控指标:定期(如每周)跟踪DIR、MAED、模型准确率的变化;

- 反馈机制:用户可举报不公平结果(如女性用户投诉"未收到高薪职位推荐"),触发人工审核与模型再训练;

- 文档记录:维护"偏见管理日志",记录每次检测到的偏见类型、缓解方法及效果,用于审计与知识传承。

6. 高级考量

6.1 扩展动态

- 多模态偏见:视频/语音应用中,性别偏见可能通过视觉(如女性多出现于家庭场景)或听觉(如语速被误判为能力指标)传播;

- 生成式AI偏见:LLM(如GPT-4)的性别偏见具有"创造性"(如生成"女科学家"时添加刻板印象描述),需结合提示工程(Prompt Engineering)与微调(Fine-tuning)双重缓解;

- 跨应用偏见迁移:同一企业的多个AI应用(如推荐+招聘)可能共享用户数据,导致偏见在系统间交叉放大。

6.2 安全影响

- 对抗攻击:恶意用户可通过构造特定输入(如"女性+高管"文本)触发模型的偏见响应,需通过鲁棒性训练(Adversarial Training)增强模型抗性;

- 数据投毒:向训练数据中注入虚假性别关联(如伪造"女性程序员代码质量低"的案例),需部署数据清洗(Data Cleaning)与异常检测(Anomaly Detection)机制。

6.3 伦理维度

- 家长式去偏:过度去偏可能抹除合理的性别差异(如女性专用医疗推荐),需定义"必要性别关联"的伦理边界;

- 责任归属:当偏见导致损害(如女性被错误拒绝贷款),需明确数据提供者、模型开发者、部署企业的责任划分(参考欧盟AI法案的"高风险AI系统"规定);

- 代表性缺失:跨性别、非二元性别群体常被排除在数据标注之外,需推动更包容的标注规范(如增加"其他/不愿透露"选项)。

6.4 未来演化向量

- 因果公平主导:结合因果推断(如反事实推理)开发更精准的去偏方法,区分"相关关系"与"因果关系";

- 自监督去偏:利用无标签数据自动学习性别无关特征(如通过对比学习最大化特征与性别标签的互信息);

- 用户参与式设计:让不同性别群体参与模型设计(如用户测试、反馈会议),避免"技术精英"主导的偏见定义。

7. 综合与拓展

7.1 跨领域应用

- 教育科技:智能辅导系统中,避免对女生数学能力的隐性低估(通过分析答题日志的性别差异);

- 医疗AI:平衡合理性别关联(如乳腺癌风险)与偏见(如女性疼痛报告被低估);

- 法律科技:合同审查AI需避免"女性→弱势方"的预设(通过法律文本的性别中性词训练)。

7.2 研究前沿

- 动态公平性(Dynamic Fairness):MIT CSAIL提出的"公平性时间序列模型",可预测偏见随用户行为演变的趋势;

- 交叉公平性(Intersectional Fairness):斯坦福Hazy Research实验室开发的"Fairness in Cross"框架,支持同时处理性别、种族、年龄等多维度偏见;

- 无监督偏见检测:CMU的"BlindSpot"算法,无需标注性别标签即可通过特征关联度自动发现偏见。

7.3 开放问题

- 多目标优化:如何同时优化准确性、公平性、鲁棒性等多个目标(当前多采用加权求和,缺乏理论最优解);

- 小样本去偏:在少数性别群体样本不足时,如何避免去偏导致的过拟合(如跨性别群体的医疗数据);

- 实时性与精确性权衡:在线系统中,如何在低延迟(<100ms)下完成复杂的偏见检测与缓解(当前方法多为离线)。

7.4 战略建议

- 企业层面:建立"AI公平性委员会",由技术、法律、伦理专家共同制定偏见管理策略;

- 技术层面:采用"默认公平"设计(如数据采集时强制性别平衡,模型训练时默认加入公平正则项);

- 生态层面:推动行业联盟(如AI公平性倡议组织)共享去偏工具、标注规范与案例库,降低中小企业实施门槛。

教学元素补充

概念桥接(抽象→具体)

- 偏见检测:类比"水质检测",需先识别污染物(性别偏见)的类型(统计偏差/因果偏差)和浓度(DIR值);

- 对抗去偏:类比"卧底训练",主模型像警察需识别罪犯(预测目标),对抗模型像黑帮需识别警察身份(性别),警察通过隐藏身份(消除性别关联)更好完成任务。

思维模型

偏见冰山模型:

- 水面上(显性):可观测的输出差异(如录用率不同);

- 水面下(隐性):数据采集偏差、特征工程偏见、模型学习的非因果关联。

思想实验

假设一个完全无性别偏见的社会,其历史数据中"职业-性别"无关联。用该数据训练的AI模型,在性别平等的现实社会中是否会产生偏见?答案是否,但需注意:若现实社会仍存在未被数据捕捉的性别差异(如生理特征),模型可能因忽略合理关联导致新的不公平(如医疗模型遗漏女性特有疾病)。

案例研究(亚马逊招聘AI失败)

- 背景:2014年亚马逊开发的招聘AI对"男性"相关关键词(如"校队队长")赋予更高权重,导致女性申请者被系统性压低评分;

- 检测:人工审核发现前200名简历中仅10%为女性,触发偏见调查;

- 原因:训练数据为过去10年的内部简历,其中80%来自男性;

- 缓解尝试:移除"男性"关键词后,模型转向捕捉其他隐性关联(如"女子学院"被识别为负面信号);

- 教训:单纯移除性别关键词无法解决隐性偏见,需系统性的数据去偏与模型公平性约束。

参考资料:

- IBM. (2023). AI Fairness 360: An Extensible Toolkit for Detecting and Mitigating Bias.

- Mitchell, M., et al. (2018). Model Cards for Model Reporting. ACM Conference on Fairness, Accountability, and Transparency.

- Kusner, M. J., et al. (2017). Counterfactual Fairness. NeurIPS.

- 欧盟AI法案 (2023). Title III: Obligations for High-Risk AI Systems.

更多推荐

已为社区贡献132条内容

已为社区贡献132条内容

所有评论(0)