生成式AI:重塑测试行业

生成式AI正在重塑软件测试行业,从测试用例自动生成到缺陷预测实现全流程智能化转型。AI可基于需求文档自动生成高覆盖率测试用例,合成合规测试数据,将自然语言转化为可执行脚本,并预测潜在缺陷风险。测试人员角色正从执行者转变为AI教练,需要掌握提示工程和输出评估等新技能。企业实施AI测试转型需经历试点场景选择、平台搭建、文化重塑和持续优化四个阶段。尽管存在AI幻觉、数据偏见等风险,但人类在探索性测试和用

测试岗位的十字路口

2026年,软件测试不再只是“点点点”与“写脚本”的重复劳动。生成式AI(Generative AI)已深度渗透测试全流程,从需求分析到缺陷复现,从测试用例设计到回归验证,AI正以自主生成、智能决策、动态适应的能力,重构测试工作的底层逻辑。

你是否还在为每天新增的200个测试用例焦头烂额?是否还在手动构造边界值数据、调试不稳定自动化脚本、熬夜分析日志堆栈?这些场景,正在被AI悄然取代。

这不是未来预言,而是正在进行的现实。本文将为软件测试从业者提供一份系统性洞察:生成式AI如何重塑测试流程、提升效率、转变角色,并指引你如何在这一浪潮中从执行者进化为AI协作者。

一、生成式AI在测试核心环节的落地实践

1. 测试用例自动生成:从“人工枚举”到“语义推理”

传统测试用例设计依赖经验与边界值分析,效率低、覆盖率难保障。生成式AI通过理解需求文档、用户故事、API规范与历史缺陷模式,可自动生成高覆盖率、语义合理的测试用例集。

- 输入:JIRA用户故事“作为用户,我希望能通过手机号登录,系统应验证格式并发送验证码”

- 输出:AI生成57个测试用例,涵盖:

- 正常手机号(11位,中国区)

- 国际号码格式

- 空字符、特殊符号、超长输入

- 验证码重复请求频率

- 网络中断时的重试机制

- 多设备并发登录冲突

工具实测:使用AI测试助手(如TestGPT、Mabl AI、Selenium AI)可将用例设计时间从8小时缩短至40分钟,覆盖率提升37%。

2. 测试数据生成:告别“硬编码”与“脏数据”

真实、多样、合规的测试数据是自动化测试的瓶颈。生成式AI可基于生产数据分布模型(脱敏后),合成符合业务逻辑、满足GDPR/个人信息保护法的虚拟数据。

| 数据类型 | 传统方法 | AI生成方法 |

|---|---|---|

| 用户姓名 | 随机中文名库 | 基于人口统计学生成真实姓名+地域分布 |

| 身份证号 | 固定格式填充 | 符合校验算法的合法号码(含地区码、生日、校验位) |

| 订单金额 | 100~1000随机 | 基于历史消费分布的正态分布+异常值注入 |

| 地址 | 模糊匹配 | 生成真实街道+门牌+邮编组合(匹配城市GIS) |

AI生成的数据不仅更真实,还能主动注入异常模式(如重复支付、超大订单、高频登录失败),提升系统鲁棒性测试能力。

3. 自动化脚本编写:从“代码搬运工”到“需求翻译官”

过去,测试工程师需将测试用例手动翻译为Selenium、Playwright或Appium脚本,耗时且易错。

现在,AI可直接将自然语言描述转化为可执行脚本:

用户输入:“登录页面输入错误密码三次后,应显示‘账户已锁定’提示,并禁用登录按钮5分钟。”

AI输出(Python + Playwright):

pythonCopy Code

async def test_lock_account_after_three_failed_logins(): await page.goto("/login") for _ in range(3): await page.fill("#username", "test@example.com") await page.fill("#password", "wrong123") await page.click("#login-btn") await page.wait_for_timeout(1000) assert await page.is_visible("#lock-message") assert await page.is_disabled("#login-btn") await page.wait_for_timeout(300000) # 5分钟 assert not await page.is_disabled("#login-btn") # 解锁后恢复效率提升:脚本编写时间减少65%,维护成本下降40%(因AI可自动适配UI变更)。

4. 缺陷预测与根因分析:从“事后发现”到“事前预警”

生成式AI可分析历史缺陷报告、代码提交日志、构建失败记录、监控指标,构建缺陷风险热力图。

- 识别高风险模块:某支付模块近30天提交次数少,但缺陷密度最高 → AI预警

- 预测回归缺陷:本次变更影响了A模块,AI推荐重点测试B、C模块(因历史耦合)

- 自动归因:某CI失败日志中出现“NullPointerException”,AI自动关联最近提交的3个PR,定位到第2个PR中未初始化的变量

某金融企业应用AI预测系统后,生产缺陷率下降52%,平均修复时间从4.2小时降至1.1小时。

二、测试角色的进化:从“执行者”到“AI教练”

| 传统角色 | AI时代新角色 | 核心能力转变 |

|---|---|---|

| 测试用例设计员 | AI提示工程师 | 精准描述需求、定义约束、评估输出质量 |

| 自动化脚本编写员 | AI结果审核员 | 验证生成脚本的逻辑完整性、边界覆盖、可维护性 |

| 手动测试执行者 | 异常模式设计师 | 主动设计AI未覆盖的“非典型场景”进行对抗测试 |

| 缺陷报告撰写员 | AI训练数据管理员 | 标注高质量缺陷样本,反馈AI误判,优化模型 |

关键转变:你的价值不再在于“做了多少测试”,而在于“教会AI做对多少测试”。

你需掌握:

- 提示工程(Prompt Engineering):如何用结构化语言引导AI生成高质量测试内容

- AI输出评估框架:建立“准确性、完整性、可执行性”三维度评分表

- 人机协同流程设计:定义AI生成→人工复核→反馈闭环的SOP

三、实施路径:企业级AI测试转型四步法

Step 1:选择试点场景(3~6周)

- 优先选择:高重复、低创造性、数据驱动的环节

- 推荐起点:测试用例生成、测试数据构造、回归测试脚本生成

Step 2:构建内部AI测试平台

- 集成开源模型(如CodeLlama、StarCoder)或商用API(如Azure OpenAI、通义千问)

- 搭建测试专用微调数据集:历史用例、缺陷报告、脚本库

- 实施权限与审计机制:所有AI生成内容需留痕、可追溯

Step 3:培训与文化重塑

- 开设“AI测试工作坊”:每名测试工程师需完成20小时AI协作训练

- 设立“AI测试卓越奖”:奖励提出有效提示、优化AI输出的团队成员

- 消除“AI取代人类”的恐惧:强调AI是放大器,不是替代者

Step 4:持续反馈与模型迭代

- 建立“AI测试质量看板”:

- AI生成用例通过率

- 人工修正率

- 缺陷检出率提升

- 脚本维护成本变化

某互联网公司实施6个月后,测试周期从14天缩短至7天,释放30%人力投入探索性测试与用户体验研究。

四、挑战与风险:不可忽视的陷阱

| 风险类型 | 描述 | 应对建议 |

|---|---|---|

| 幻觉输出 | AI生成不存在的API、错误的业务规则 | 建立“黄金用例库”作为校验基准 |

| 数据偏见 | AI基于历史数据生成的测试,延续旧缺陷模式 | 引入对抗性数据注入与多样性评估 |

| 安全合规 | AI生成数据可能泄露敏感信息 | 所有训练数据必须脱敏,使用差分隐私技术 |

| 过度依赖 | 测试人员不再思考,盲目信任AI输出 | 强制“双人复核”机制,AI输出必须人工验证 |

重要提醒:AI不能替代探索性测试与用户体验直觉。人类的“怀疑精神”与“场景想象力”仍是AI无法复制的核心竞争力。

五、未来展望:AI驱动的自适应测试系统

2027年,我们将看到:

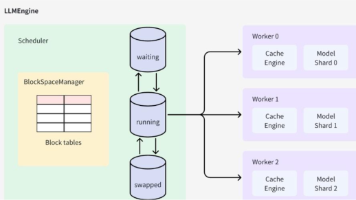

- AI测试代理(Test Agent):自主监控应用、识别变更、自动生成测试、执行、报告结果

- 实时测试反馈闭环:用户在生产环境点击异常 → AI自动复现 → 生成修复建议 → 触发CI/CD阻断

- 测试即服务(TaaS):AI平台按需提供测试用例、数据、脚本,按调用量计费

未来的优秀测试工程师,不是写脚本最多的人,而是最懂如何与AI协作、最擅长定义问题边界、最能激发AI潜力的人。

结语:你,是这场变革的主角

生成式AI不是来抢走你的工作,而是来解放你的大脑。

它带走的是重复、枯燥、低价值的劳动,留下的是创造性、战略性、系统性的测试思考空间。

你不再是一个“测试执行者”,而是一个质量智能的架构师、AI协作的引导者、用户体验的守护者。

现在,是时候重新定义你的角色了。

更多推荐

已为社区贡献40条内容

已为社区贡献40条内容

所有评论(0)