Agentic AI与RAG技术选型指南:从原理到实战,一文搞懂何时用、何时避

本文深入解析了Agentic AI与RAG两大AI技术的本质、适用场景及结合方式。Agentic AI的核心是自主决策循环,适合多步骤工作流;RAG虽强大但非万能,规模化后需Context Engineering优化。文章提供了清晰的技术选型决策树:静态知识库适合纯RAG,多步骤任务适合纯Agentic AI,而需要"查资料+推理决策"的复杂场景则适合Agentic RAG。同时,本地模型作为成本

本文深入解析了Agentic AI与RAG两大AI技术的本质、适用场景及结合方式。Agentic AI的核心是自主决策循环,适合多步骤工作流;RAG虽强大但非万能,规模化后需Context Engineering优化。文章提供了清晰的技术选型决策树:静态知识库适合纯RAG,多步骤任务适合纯Agentic AI,而需要"查资料+推理决策"的复杂场景则适合Agentic RAG。同时,本地模型作为成本优化方案也得到详细讨论,帮助开发者根据实际需求做出明智技术选择。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

如果你混AI圈,肯定最近被这些技术词汇刷屏:Agentic AI、RAG、智能体?

它们几乎成了 AI 圈的通行密码。但如果你问:"什么时候该用 RAG?什么时候不该用?"很多人会给你一个标准答案——“It depends”(视情况而定)。

这次,我想聊聊这个"depends"到底 depends 在哪些点上。不盲目追捧技术,也不全盘否定。

我们聊聊 Agentic AI 和 RAG 各自适合什么场景,何时该结合使用,何时又该避开。如果你正在规划 AI 应用架构,或者对这些技术名词一知半解,这篇文章应该能帮你理清思路。

PART 01 - 先破除两个常见误解

在深入技术细节之前,我们需要澄清两个流传甚广的误解:

误解一:Agentic AI 的主要用途就是写代码

很多人第一次接触 Agentic AI,是通过 GitHub Copilot、Cursor 这类代码助手。于是自然形成了这样的认知:“智能体 = 代码生成工具”。

但实际上,代码助手只是 Agentic AI 在开发者场景中的一个应用而已。在企业场景中,智能体正在做的事情包括:

- 自动处理客服工单,根据问题类型路由到不同的专业 Agent

- 处理 HR 请求,比如查询假期余额、提交报销申请

- 金融领域的风控审核,自主调用多个数据源进行决策

误解二:RAG 永远是为 LLM 补充知识的最佳方案

RAG(检索增强生成)确实是一个强大的技术,但它不是万能钥匙。当你的知识库规模很小(比如只有几份 PDF),或者需要的信息可以通过 Fine-tuning 固化到模型中时,RAG 反而会增加系统复杂度。

更关键的是,RAG 在规模化场景中会遇到一个反直觉的现象:检索更多文档并不总是带来更好的效果。当你检索的 tokens 数量超过某个临界点后,噪声和冗余信息会导致 LLM 的性能下降。

我们接下来会详细拆解这两个技术的本质,以及它们各自的适用边界。

PART 02 - Agentic AI 的本质:不只是"调用工具"

什么是 Agentic AI?

Agentic AI 的核心是一个自主决策循环。它不是简单的"输入-输出"模式,而是持续运行的四步循环:

Agentic AI 工作循环感知环境Perceive推理决策Reason执行动作Act观察反馈Observe最小化人工干预的自主决策循环

-

感知环境 (Perceive)

:Agent 观察当前状态——可能是用户的请求、系统的状态、或者外部 API 的返回结果

-

推理决策 (Reason)

:基于观察到的信息,Agent 调用 LLM 进行推理,决定下一步该做什么

-

执行动作 (Act)

:Agent 执行具体操作——可能是调用 API、修改文件、或者向用户返回信息

-

观察反馈 (Observe)

:Agent 检查动作的结果,然后进入下一轮循环

这个循环的关键在于:最小化人工干预。你不需要在每一步都告诉 Agent 该怎么做,它会根据目标自主决策。

一个典型案例:代码智能体团队

在软件开发场景中,多个 Agent 可以协同工作,模拟一个"迷你开发团队":

架构师 Agent

- 接收需求后,规划功能模块和技术方案

- 输出:架构设计文档、模块划分建议

实现者 Agent

- 根据架构方案,生成具体代码

- 直接将代码写入代码库

审查者 Agent

- 检查代码质量、安全漏洞、性能问题

- 如果发现问题,将反馈发送给实现者 Agent,形成循环

在这个流程中,人的角色更像是"乐队指挥",负责设定总目标和协调方向,而不是演奏每一个音符。

为什么需要 MCP 协议?

Agentic AI 要真正发挥作用,必须能够调用外部工具和数据源。但传统的 API 集成方式存在问题:

- 每个工具的接口都不同,Agent 需要为每个工具写定制化代码

- 缺乏标准化的工具发现机制,Agent 很难知道"有哪些工具可用"

MCP (Model Context Protocol) 是 Anthropic 在 2024 年底推出的开源标准,它解决了这个问题:

Host Application (Claude/GPT) ↓ MCP Client ↓ MCP Server (标准化接口) ↓External Tools (GitHub/Notion/Slack...)

MCP 的核心价值:

-

标准化工具发现

:Agent 可以通过 Schema 自动发现可用工具

-

状态管理

:支持长时间的多步骤工作流,保持上下文状态

-

跨系统协作

:不同的 Agent 可以通过 MCP 共享数据和工具

这让 Agentic AI 从"玩具原型"走向"生产级系统"。

PART 03 - RAG 的两阶段架构与规模化陷阱

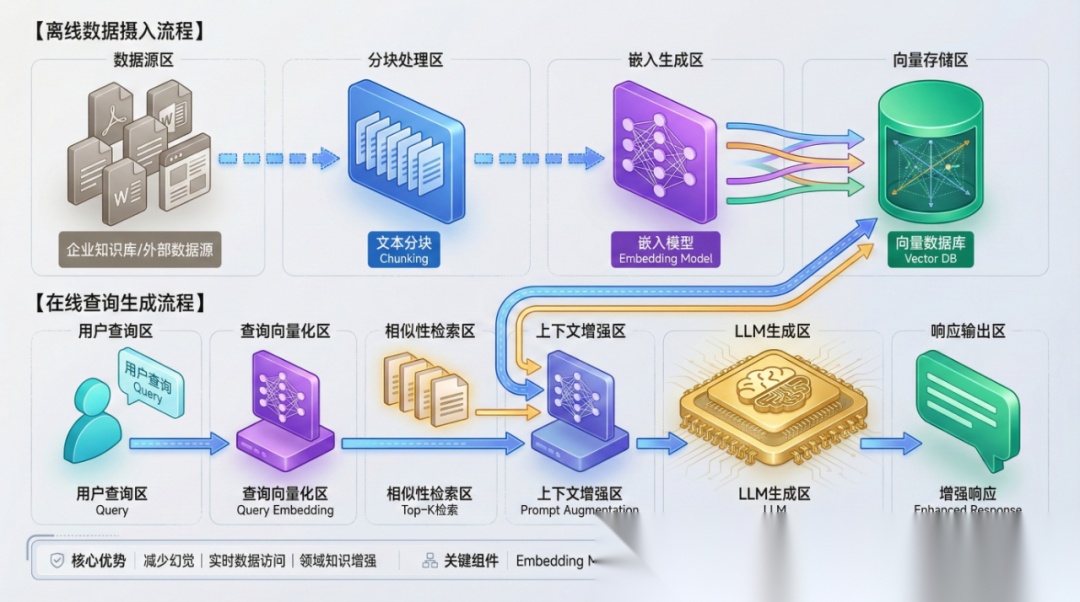

RAG 是如何工作的?

RAG 本质上是一个"外挂知识库"系统,让 LLM 能够访问训练数据之外的信息。它分为两个阶段:

离线阶段 (Offline)

-

文档分块

:将 PDF、Word 等文档切成小块(通常 500-1000 字)

-

向量嵌入

:使用 Embedding 模型将每个文本块转换为高维向量(如 384 维或 1536 维)

-

存入向量数据库

:这些向量被索引存储,方便快速检索

在线阶段 (Online)

-

查询嵌入

:用户的问题也被转换为向量

-

相似度检索

:在向量数据库中找到语义最相似的 Top K 个文档块(通常 3-5 个)

-

拼接上下文

:将检索到的文档块和用户问题一起喂给 LLM

-

生成答案

:LLM 基于这些上下文生成回答

规模化后的反直觉现象

当你的文档库从 100 份增长到 10,000 份时,会遇到一个反直觉的问题:

检索更多文档 ≠ 更准确的答案

如果我们画一条曲线,横轴是检索的 token 数量,纵轴是准确度:

准确度 ↑ │ ╱‾‾‾╲ │ ╱ ╲___ │ ╱ ╲___ │ ╱ ╲___ └────────────────────────→ 检索 tokens 数 增加 临界点 过量

原因很简单:

-

噪声增加

:检索的文档越多,不相关的内容也越多

-

冗余信息

:相似的内容重复出现,浪费 token 预算

-

注意力分散

:LLM 需要在大量信息中"找重点",反而容易遗漏关键内容

这就是为什么 RAG 系统需要"Context Engineering"(上下文工程)来优化检索质量。

PART 04 - Context Engineering:让 RAG 真正可用的优化策略

Context Engineering 的目标是:在不增加 token 消耗的前提下,提升检索内容的质量和相关性。它包括两个关键环节。

优化一:数据摄取阶段

传统的 RAG 系统只提取 PDF 中的纯文本,但这会丢失大量信息:

- 表格被转成乱七八糟的文字

- 图表完全丢失

- 页眉页脚等元数据被混入正文

Docling 这类工具解决了这个问题: 能力对比

| 功能 | 传统 PDF 解析 | Docling |

|---|---|---|

| 表格提取 | 文字混乱 | 保留表格结构 |

| 图表处理 | 丢失 | 转为描述性文字或保留图像 |

| 元数据 | 无 | 提取标题、作者、章节信息 |

| 输出格式 | 纯文本 | Markdown(LLM 友好) |

这样做的好处:

- LLM 可以更准确地理解文档结构

- 表格数据可以直接用于分析

- 元数据可以用于过滤和排序

优化二:检索阶段的三层优化

Context Engineering 优化流程用户查询混合检索 (Hybrid Search)BM25关键词匹配Vector语义搜索重排序 (Re-ranking)按相关性优先级排序块合并 (Chunk Combination)相关块合并成连贯上下文优化后上下文压缩 + 优先级排序 + 连贯优化效果✓ 更高准确度✓ 更快推理✓ 更低成本✓ 减少噪声✓ 消除冗余

第一层:混合检索 (Hybrid Search)

单纯的向量检索有个问题:它擅长语义理解,但不擅长精确匹配。

举个例子:

- 用户搜索:“PostgreSQL 数据库”

- 纯向量检索可能返回:“MySQL 教程”(因为语义相似)

- 但用户真正想要的是包含"PostgreSQL"这个关键词的文档

混合检索同时使用两种方法:

-

BM25(关键词匹配)

:擅长精确匹配,但不懂语义

-

Vector Search(语义搜索)

:擅长理解意图,但可能返回"相关但不准确"的结果

最后通过加权融合(如 BM25 占 60%,Vector 占 40%)得到最终结果。

第二层:重排序 (Re-ranking)

混合检索返回的 Top 10 个结果,并不一定按真实相关性排序。Re-ranking 使用一个专门的模型(通常是 BERT 类模型)重新评估每个文档与查询的相关性,重新排序。

这一步通常能将准确率提升 10-20%。

第三层:块合并 (Chunk Combination)

假设检索到了这两个文档块:

块 A:“GPT-4 的上下文窗口是 128K tokens…” 块 B:“…这使得它能够处理长文档任务。”

如果这两个块来自同一段落,分开喂给 LLM 会导致信息碎片化。块合并会检测相邻的块,并将它们拼接成完整段落,让 LLM 获得更连贯的上下文。

PART 05 - 本地模型:Agentic AI + RAG 的成本优化方案

云端 LLM API 的成本是一个绕不开的问题。如果你的 RAG 系统每天处理 10,000 次查询,每次消耗 2,000 tokens,按 GPT-4 的定价:

月度成本计算

| 项目 | 数值 |

|---|---|

| 每日查询量 | 10,000 次 |

| 每次 tokens | 2,000 |

| GPT-4 定价 | $0.03/1K tokens |

| 日成本 | $600 |

| 月成本 | $18,000 |

对于很多团队来说,这是无法承受的。

本地模型的两大优势

优势一:数据主权

使用云端 API 意味着你的数据会经过第三方服务器。对于医疗、金融等敏感行业,这是不可接受的。本地部署开源模型(如 Llama 3、Mistral)可以让数据完全留在自己的基础设施内。

优势二:成本可控

虽然本地部署需要 GPU 服务器(如 NVIDIA A100),但长期运行的成本远低于 API 调用:

成本对比

| 方案 | 初始成本 | 月运行成本 | 年总成本 |

|---|---|---|---|

| GPT-4 API | $0 | $18,000 | $216,000 |

| 本地 A100 | $15,000 | $500(电费) | $21,000 |

一年省下 $195,000,足够覆盖硬件投入和人力成本。

本地模型的关键优化:KV Cache

开源工具如 vLLM 和 Llama.cpp 通过 KV Cache 优化,大幅提升推理速度:

什么是 KV Cache?

LLM 生成文本时,每个 token 都需要"回顾"之前的所有 token。如果没有缓存,每次生成新 token 都要重新计算一遍之前的 Key-Value 矩阵。

KV Cache 将这些计算结果缓存起来,只计算新 token 的部分。这使得:

-

首 token 延迟

:500ms → 200ms(提速 60%)

-

吞吐量

:100 tokens/s → 300 tokens/s(提升 3 倍)

对于 RAG 系统来说,这意味着用户等待时间更短,系统容量更大。

PART 06 - Agentic RAG:两者结合的最佳实践

前面我们分别讨论了 Agentic AI 和 RAG,但实际场景中,它们常常需要协同工作。

为什么 Agent 需要 RAG?

Agentic AI 的决策依赖于信息。如果 Agent 只能依赖 LLM 的训练数据,它会面临两个问题:

-

知识过时

:LLM 的训练数据有截止日期(如 GPT-4 是 2023 年 4 月)

-

幻觉风险

:当 LLM 不知道答案时,它可能会"编造"一个看起来合理的答案

RAG 为 Agent 提供了"查阅资料"的能力,就像人类在做决策前会查阅文档一样。

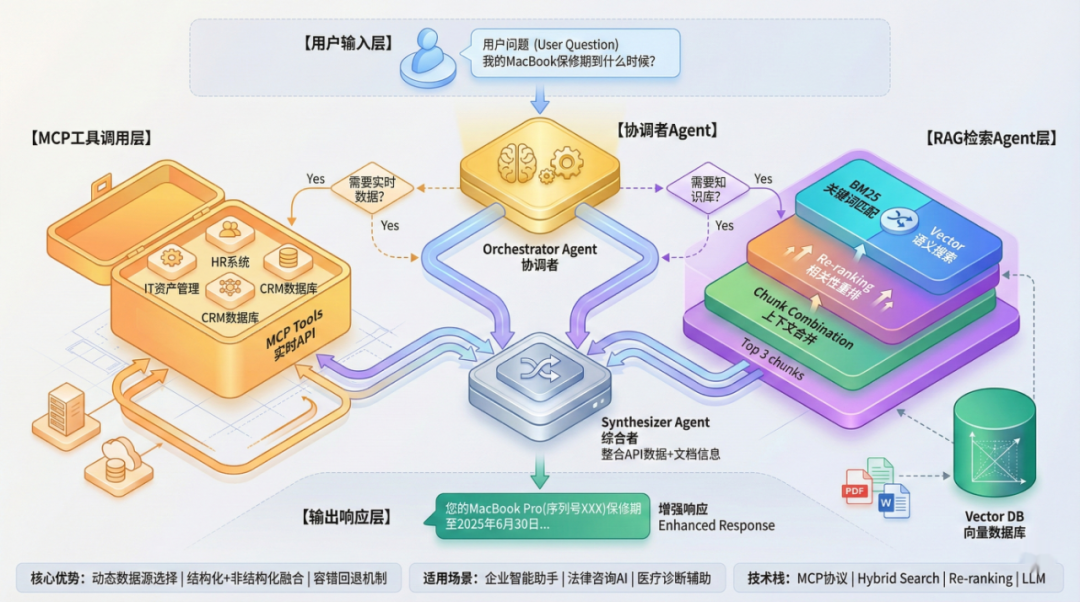

一个企业场景:智能客服系统

假设你在构建一个企业内部的智能客服系统:

场景:员工问:“我的 MacBook Pro 保修期到什么时候?” 传统 RAG 系统:

- 检索员工的设备信息文档

- 返回保修日期

Agentic RAG 系统:

-

Agent 判断

:这是一个需要查询结构化数据的问题

-

调用工具

:通过 MCP 调用 IT 资产管理 API

-

检索文档

(如果 API 没有数据):回退到 RAG 系统,搜索设备采购文档

-

综合答案

:将 API 数据和文档信息结合,生成完整回答:“您的 MacBook Pro(序列号 XXX)保修期至 2025 年 6 月 30 日。如需延保,请访问…”

这个流程的关键在于:Agent 根据问题类型,动态决定是调用 API 还是使用 RAG,而不是盲目地总是检索文档。

Agentic RAG 的技术架构

用户问题 ↓Orchestrator Agent(协调者) ├→ 判断:需要实时数据? │ ├→ Yes → 调用 MCP Tools(API) │ └→ No → 继续 ├→ 判断:需要知识库? │ ├→ Yes → RAG Retrieval Agent │ │ ├→ Hybrid Search │ │ ├→ Re-ranking │ │ └→ 返回 Top 3 chunks │ └→ No → 直接生成 └→ Synthesizer Agent(综合者) └→ 整合所有信息,生成最终答案

这种架构的优势:

-

更高准确性

:结合结构化数据和非结构化文档

-

更好的可控性

:Agent 可以解释"为什么选择这个数据源"

-

容错能力

:如果 API 失败,可以回退到 RAG

PART 07 - 技术选型决策树:什么时候该用什么?

经过前面的讨论,我们终于可以回答"It depends"的问题了。

纯 RAG 适用场景

✅ 使用 RAG:

- 知识库相对静态,且规模适中(1,000-100,000 文档)

- 主要处理非结构化文本(如技术文档、法律条款)

- 不需要复杂的多步骤推理

- 示例:企业知识库问答、文档搜索

❌ 不使用 RAG:

- 知识可以通过 Fine-tuning 固化(如特定领域的术语)

- 数据实时性要求高(如股票价格、天气信息)

- 文档数量极少(< 10 份)

纯 Agentic AI 适用场景

✅ 使用 Agentic AI:

- 需要多步骤工作流(如"帮我安排明天的会议并发送邀请")

- 需要调用多个外部工具(通过 MCP)

- 任务目标明确,但路径不固定(如代码审查)

- 示例:代码助手、自动化运维、流程审批

❌ 不使用 Agentic AI:

- 简单的单轮问答

- 任务流程完全固定(可以用传统工作流引擎)

- 对成本极其敏感(Agent 的多轮调用会增加 token 消耗)

Agentic RAG 适用场景

✅ 结合使用:

- 需要"查资料 + 推理决策"的复杂任务

- 知识来源多样(API + 文档 + 数据库)

- 需要动态选择信息源

- 示例:企业智能助手、法律咨询 AI、医疗诊断辅助

决策流程图:

开始 ↓ 是否需要外部知识? ├─────┴─────┐ 否 是 ↓ ↓ 直接用 LLM 是否需要多步骤推理? ├─────┴─────┐ 否 是 ↓ ↓ 纯 RAG Agentic RAG

结论

Agentic AI 和 RAG 不是非此即彼的关系,而是解决不同问题的工具。关键在于理解它们各自的边界: 核心要点:

-

Agentic AI

的价值在于"自主决策"和"多步骤协作",不是所有任务都需要 Agent

-

RAG

在规模化后会遇到"检索越多,效果越差"的问题,需要通过 Context Engineering 优化

-

Agentic RAG

的场景是"动态选择信息源 + 复杂推理",不要为了用技术而用技术

-

本地模型

在成本和数据主权上有优势,但需要投入 GPU 和运维成本

实践建议:

- 先用最简单的方案(直接调用 LLM),确认需求后再引入 RAG 或 Agent

- 如果要用 RAG,优先投入精力在数据质量和检索优化上,而不是盲目增加文档数量

- 如果要用 Agentic AI,先明确"什么任务真正需要自主决策",避免过度设计

- 评估长期成本时,认真考虑本地模型方案

技术选型没有银弹,但理解每个技术的适用边界,就能避开 90% 的坑。

参考资料

- Introducing the Model Context Protocol - Anthropic

- The 2025 Guide to Retrieval-Augmented Generation (RAG) - EdenAI

- Hybrid Search Explained - Weaviate

- GitHub - lastmile-ai/mcp-agent

- What is RAG? - AWS

- Model Context Protocol (MCP) in Agentic AI - Medium

- Hybrid Search: Combining BM25 and Semantic Search - LanceDB

- Deeper insights into retrieval augmented generation - Google Research

关于作者

MCP研究院专注于人工智能前沿技术解析,致力于将复杂的 AI 技术转化为易于理解的技术洞察。我们关注 LLM、AI Agent、RAG 等技术的实际应用场景,帮助开发者和技术决策者做出更明智的技术选型。

欢迎关注我们的公众号,获取更多 AI 技术深度解析。

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献227条内容

已为社区贡献227条内容

所有评论(0)