华人科学家沈俊潇再创突破,解决了AI的”失忆症“,AI从此有“大脑”了

如果说模型时代解决了AI的"大脑构建"问题,智能体时代赋予了AI"手脚能力",那么认知时代的核心命题,就是让AI拥有"长期记忆"与"连贯认知"——这不仅是对文本信息的记忆,更是对占人类信息总量80%以上的视频内容的深度理解与持久存储。"找出视频中穿红色衣服的人在会议室讨论的片段"、"提取所有包含产品演示的画面并按时间顺序排列",甚至可以进行更复杂的逻辑查询,如"找出2025年3月所有视频中,同时出

它解决了长期困扰行业的视频内容深度解析难题,彻底让AI有了脑子。

@数科星球原创

作者丨苑晶

编辑丨大兔

当GPT-4在2023年完成通用语言与推理能力的突破时,AI领域的有识之士已经开始思考下一个核心命题:如何让机器真正"理解"视觉世界,而非停留在文本交互的表层?

当RAG技术在2024年普及,让AI拥有了调用工具的"手脚"后,一个更根本的挑战浮出水面——视频作为人类信息传递的核心载体,其蕴含的视觉、音频、语境等多维信息,始终难以被AI有效记忆和检索。

正是在这个技术拐点上,沈俊潇带着他的Memories.ai闯入了大众视野。

这家专注于视频理解的AI公司,以"视频原生记忆"为核心,开创了LVMM(Large Video Memory Model)技术路线,不仅解决了长期困扰行业的视频内容深度解析难题,更在AI从"工具时代"迈向"认知时代"的进程中,搭建起关键的基础设施。

本次,数科星球DigitalPlanet找到了沈俊潇,并通过数小时的深度访谈解开了这家公司的奥秘。为什么说记忆才是大模型最值得期待的发展方向?

本文将详细解读。

01

AI为何需要"视频记忆"?

2025年的AI行业,正处在从"智能体时代"向"认知时代"跨越的关键期。

如果说模型时代解决了AI的"大脑构建"问题,智能体时代赋予了AI"手脚能力",那么认知时代的核心命题,就是让AI拥有"长期记忆"与"连贯认知"——这不仅是对文本信息的记忆,更是对占人类信息总量80%以上的视频内容的深度理解与持久存储。

沈俊潇在数科星球DigitalPlanet做了这样的比喻:"当前的AI就像患有'视频失忆症'的聪明人,能读懂文字、听懂语音,却看不懂视频里的故事。它们只能通过标题、标签等浅层元数据判断视频内容,就像仅凭书的封面猜测整本书的情节,这在视频成为主流信息载体的今天,显然已经行不通了。"

这一痛点背后,是视频数据的天然复杂性。

与结构化的文本不同,视频包含视觉画面、音频轨道、文字字幕、场景转换等多重维度,信息密度高、关联性强且具有时序性。

传统AI系统处理视频时,要么将其拆解为单帧图片逐一分析,丢失了时间维度的上下文;要么依赖人工标注的元数据进行检索,无法捕捉画面中的隐性信息。

更关键的是,这些系统缺乏"记忆能力"——每次分析视频都需要重新处理,既浪费计算资源,又无法形成跨视频的知识沉淀。

行业的迫切需求已经显现。

在媒体领域,电视台需要从海量历史素材中快速检索特定画面;在教育行业,在线课程平台希望实现视频内容的精准答疑;在工业场景中,企业需要通过监控视频分析生产流程中的问题;在个人用户层面,人们渴望能像搜索文字一样,在自己拍摄的生活视频中找到某个珍贵瞬间。

"这些需求的本质,是希望AI能像人类一样'观看'并'记住'视频——不仅能识别画面中的元素,还能理解场景的意义、人物的情感、事件的逻辑,并且在需要时快速提取这些记忆。"沈俊潇告诉数科星球DigitalPlanet,这正是Memories.ai的出发原点。

而从技术演进的角度看,视频记忆系统的出现是必然结果。

AI记忆系统已经历经工程化集成、结构化发展两个阶段,正在向认知架构阶段演进,其核心功能也从简单的信息存储,转向了多模态信息的整合与智能检索。

在十几种主流的Memory技术路线中,Memories.ai专注的视频级记忆(LVMM)被行业视为最具潜力的方向之一,因为它直击了多模态记忆的核心难点,也契合了信息载体视频化的趋势。

市场规模的增长则为这一赛道提供了现实支撑。

据Markets and Markets的数据,全球视频AI市场规模预计2027年将突破500亿美元,其中视频理解与检索相关技术的复合增长率超过40%。

而随着AI Agent的普及,对视频记忆能力的需求将进一步爆发——未来的智能体不仅需要处理文本任务,更需要能够"观看"视频、"记住"关键信息,并基于这些记忆完成复杂任务,这使得视频记忆系统成为AI基础设施的核心组成部分。

左一:founder Shawn

右一:Co-founder/CTO Ben Zhou

02

LVMM核心架构

面对视频记忆这一复杂难题,沈俊潇和他的团队选择了一条"难而正确"的道路——从零构建视频原生的记忆架构,而非在现有文本记忆系统上进行修补。

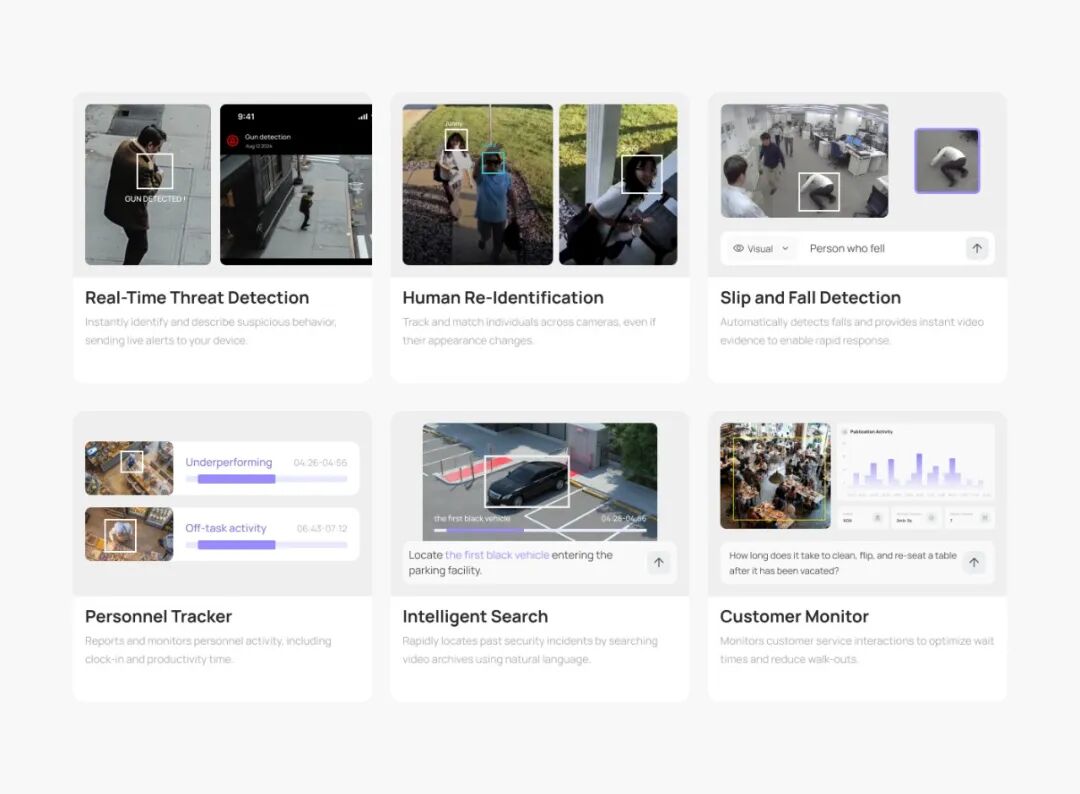

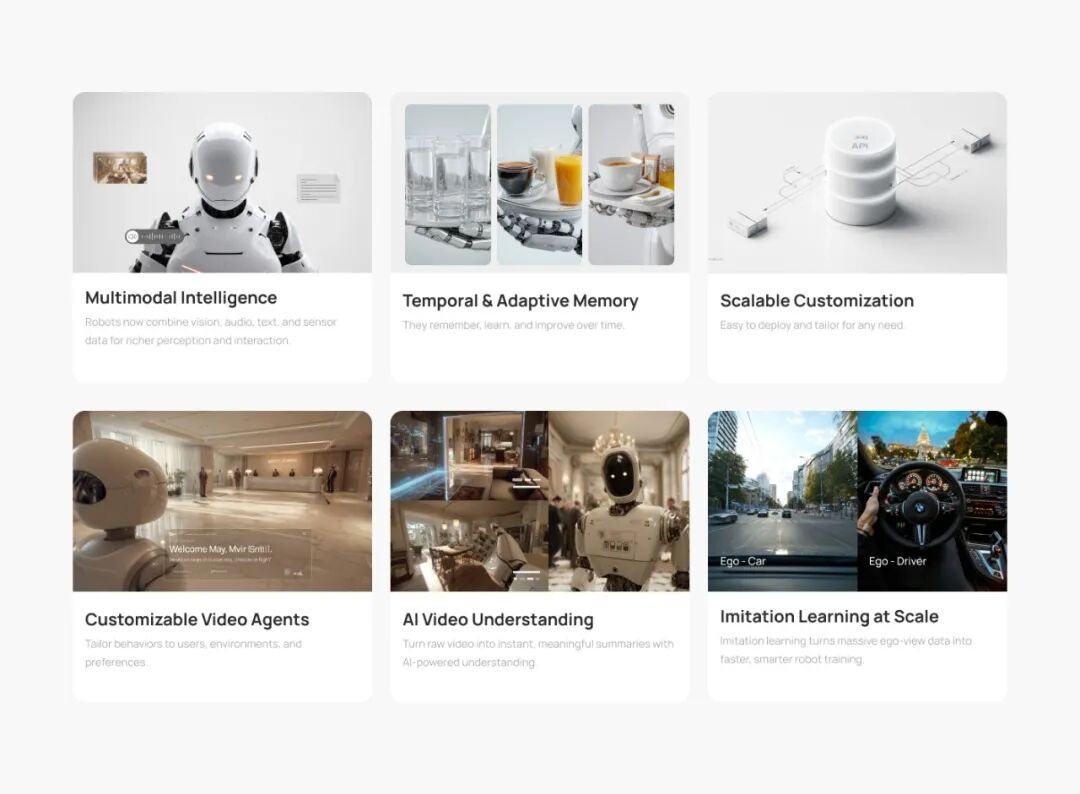

这一选择背后,是Memories.ai独创的LVMM技术体系,其核心可以概括为"多模态编码-记忆增强生成-高效检索"三大支柱。

-

这款大模型的第一个特点是具备了多模态编码能力。

它可让AI"看懂"视频的每一个细节。

沈俊潇认为,这源于该公司对视频数据的底层处理方式理解深刻。

传统视频AI系统通常采用单一模态的处理逻辑,比如仅分析视觉画面或仅转录音频内容,导致信息割裂。

而Memories.ai构建了一套融合视觉、音频、文本的多模态编码体系,能够对视频进行全方位、无死角的"解读"。

在视觉编码层面,团队没有采用传统的CNN(卷积神经网络)架构,而是基于Transformer模型开发了时序感知视觉编码器。

该编码器能够捕捉视频帧之间的动态关联,不仅能识别画面中的物体、人物、场景,还能理解动作的连贯性和场景的转换逻辑。

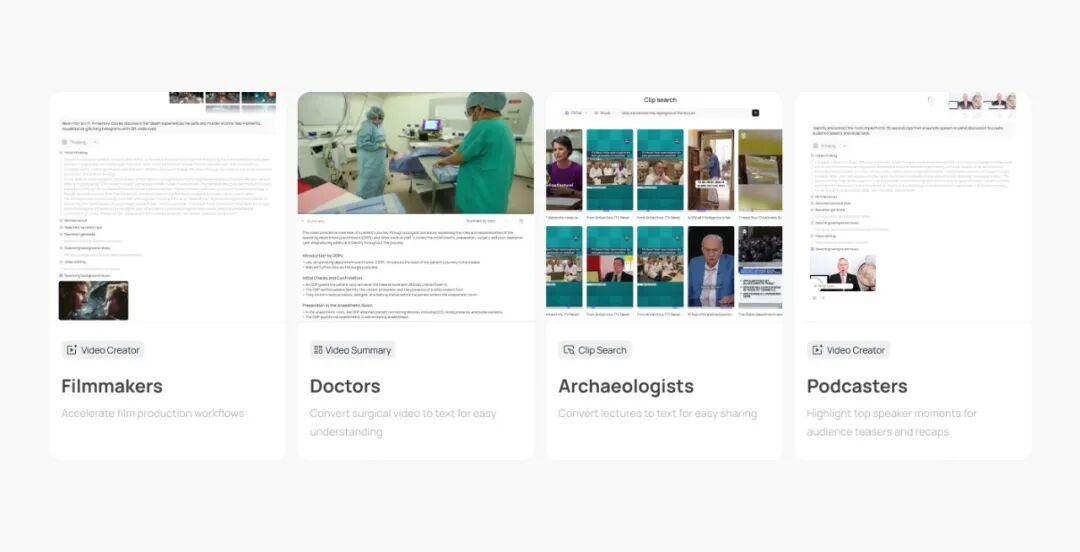

例如,在分析一段篮球比赛视频时,系统不仅能识别球员、篮球、篮筐等元素,还能理解"球员投篮"、"球进筐"等完整事件,以及事件发生的先后顺序。

-

音频编码则采用了结合语音识别与环境音分析的双轨模型。

一方面,通过微调的语音识别算法,实现高精度的实时转录,支持多种语言的口音适配;

另一方面,系统能识别背景音中的关键信息,如爆炸声、警报声、笑声等,并将其与视觉画面关联。

"在一段采访视频中,受访者的语气变化、背景中的掌声,这些信息和文字内容同样重要,它们共同构成了视频的完整意义。"沈俊潇解释道。

更具创新性的是,Memories.ai将文本信息的处理贯穿于整个编码过程——不仅包括视频中的字幕、文字标识,还包括通过视觉和音频信息推断出的隐性文本。

例如,系统能根据画面中的场景(如医院、学校)和人物动作(如医生问诊、老师讲课),自动生成描述性文本标签,从而实现多模态信息的深度融合。这种多模态编码的优势在于,它打破了不同信息维度之间的壁垒,让AI能够从整体上理解视频内容。

"我们的编码过程,就像人类观看视频时的认知过程——眼睛看画面、耳朵听声音、大脑整合信息,最终形成对视频的完整认知。"沈俊潇对数科星球DigitalPlanet这样描述。

-

该公司在记忆增强生成(MAG)上有着突破性进展,它能让AI"记住"并"活用"视频信息。

如果说多模态编码是让AI"看懂"视频,那么记忆增强生成(MAG)技术就是让AI"记住"这些信息,并能灵活运用。

这也是Memories.ai区别于传统视频处理系统的核心竞争力。

传统AI系统处理视频时,采用的是"一次性处理"模式——用户提出查询需求后,系统才开始分析视频,处理完成后即丢弃中间结果,下次查询需要重新计算。

这种模式不仅效率低下,而且无法形成跨查询、跨视频的知识沉淀。

Memories.ai提出的MAG技术,本质上是为AI构建了一个专门存储视频记忆的"大脑皮层"。

其核心逻辑是:通过一次视频索引,将多模态编码后的信息转化为结构化的记忆单元,存储在专门的向量数据库中,后续的所有查询、分析任务都可以直接调用这些记忆单元,无需重复处理视频源文件。

这种"一次索引,多次复用"的模式,带来了两大核心优势。

一是极致的效率提升——经过索引的视频,查询响应时间可以从分钟级缩短至毫秒级,即使是小时级的长视频,也能瞬间定位到关键片段。

二是成本的显著降低——用户无需为同一视频的多次分析支付重复的计算费用,这对于需要处理海量视频的企业用户来说,无疑具有极强的吸引力。

更重要的是,MAG技术支持"无限视觉记忆"的存储与检索。

记忆单元不仅包含视频的具体内容,还记录了内容之间的关联关系,形成了结构化的知识图谱。

例如,系统会自动记录同一人物在不同视频中的出现情况,同一事件的前后关联,从而实现跨视频的记忆整合。

当用户查询"某个人在2025年所有公开演讲中的产品介绍片段"时,系统能快速检索到相关的所有视频,并提取出对应的片段,这是传统系统无法实现的。

"记忆的价值不仅在于存储,更在于关联与复用。"沈俊潇强调,"我们的MAG技术,就是让AI能够像人类一样,将不同视频中的信息联系起来,形成更全面的认知,而不是孤立地看待每一段视频。"

-

另外,该公司还推出了自然语言交互+灵活模板,即让AI"听懂"需求并高效输出。

Memories.ai在技术落地层面,做了两项关键设计:自然语言查询和灵活模板系统,让复杂的视频处理技术变得人人可用。

自然语言查询功能,打破了技术门槛。

用户无需掌握任何专业的查询语法,只需用日常语言描述自己的需求,系统就能精准理解并检索相关内容。

例如,用户可以输入"找出视频中穿红色衣服的人在会议室讨论的片段"、"提取所有包含产品演示的画面并按时间顺序排列",甚至可以进行更复杂的逻辑查询,如"找出2025年3月所有视频中,同时出现产品A和客户反馈的片段"。

这一功能的实现,得益于Memories.ai将大语言模型(LLM)与视频记忆系统深度融合。

LLM负责理解用户的自然语言查询,并将其转化为系统可执行的检索指令;视频记忆系统则根据指令,从结构化的记忆单元中快速提取相关信息,再由LLM将结果整理为自然语言回答或视频片段集合。

更具创新性的是,系统支持多轮对话式查询——用户可以基于上一次的查询结果,进一步细化需求,就像与一个"看过所有视频"的助手聊天一样。

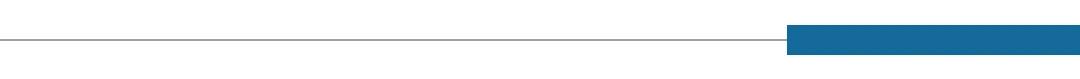

而灵活模板系统,则满足了不同场景的个性化需求。

Memories.ai提供了多种预设模板,涵盖了脚本生成、故事板制作、精彩片段提取、视频摘要生成等常见任务,用户可以根据自己的需求选择模板,并通过调整超参数进行个性化定制。

例如,媒体用户可以使用"新闻片段提取"模板,快速从现场视频中提取关键事件画面;教育用户可以利用"知识点标注"模板,自动识别课程视频中的重点内容并添加标签;企业用户则可以通过"会议纪要生成"模板,将会议视频转化为结构化的文字纪要,同时保留关键发言的视频片段。

"我们的目标是让每一个用户,无论技术背景如何,都能充分利用视频数据的价值。"沈俊潇表示,技术的复杂性应该由平台承担,用户感受到的,应该是简单、高效、精准的服务。

Memories.ai的技术突破,离不开创始人沈俊潇的行业积累与战略眼光。

这位深耕视频AI领域十年的工程师创业者,用自己的坚持与洞察,带领团队在这条小众但关键的赛道上走出了属于自己的道路。

沈俊潇的职业生涯,几乎与国内视频AI技术的发展历程同步。

"我们的第一个付费用户是一家纪录片制作公司,他们需要从几千小时的拍摄素材中寻找特定的自然场景画面。"沈俊潇回忆道,"传统方式下,他们需要安排专人逐帧观看,耗时耗力;而使用我们的系统后,只需要输入'清晨的森林'、'黄昏的湖面'等描述,就能在几分钟内找到所有相关片段,工作效率提升了几十倍。"

用户的认可给了团队极大的信心,也让Memories.ai在融资市场上获得了关注。2025年,公司完成了Pre-A轮融资,资金主要用于技术迭代和市场拓展。

对于公司的未来,沈俊潇有着清晰的规划:"短期目标是完善产品功能,拓展更多行业场景;长期来看,我们希望成为AI认知时代的视频记忆基础设施提供商,让每一个AI系统都具备'看懂'和'记住'视频的能力。"

03

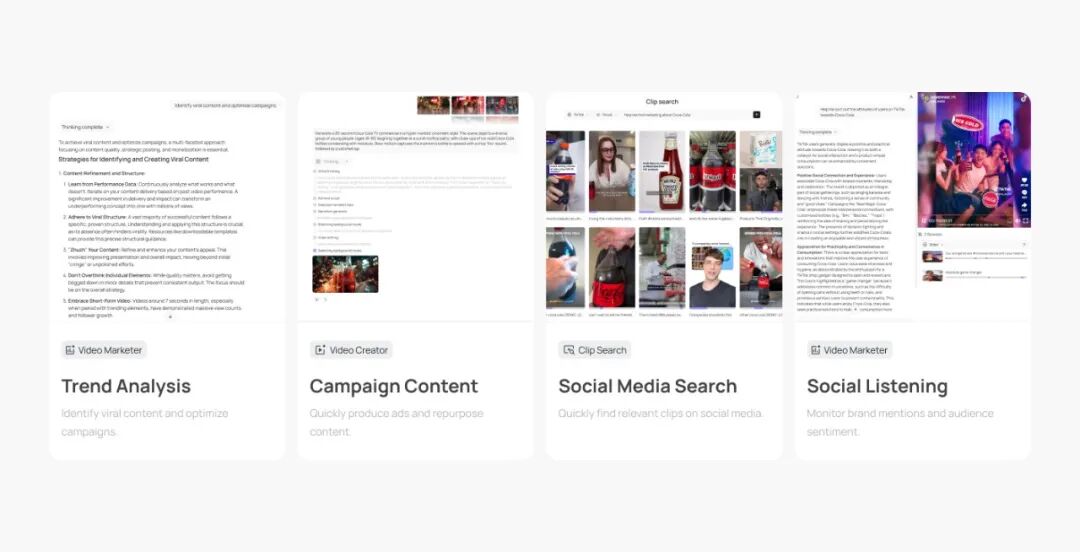

从B端赋能到C端渗透,重构视频价值链条

技术的终极意义在于应用。

Memories.ai的LVMM技术,正在多个行业场景中落地生根,重构视频数据的价值链条。从B端的企业服务到C端的个人应用,其产品已经形成了清晰的市场布局,展现出强大的商业潜力。

对于电视台、影视公司、短视频平台等机构来说,海量视频素材的管理与利用,是长期以来的痛点。

Memories.ai的解决方案,正在从根本上改变媒体行业的内容生产流程。

在内容检索层面,媒体用户可以通过自然语言快速定位所需素材。

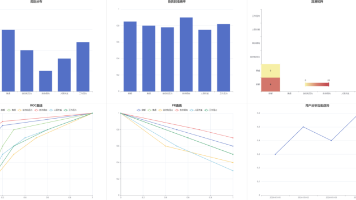

某省级电视台使用Memories.ai的系统后,历史素材的检索效率提升了70%——以前需要几天才能完成的素材筛选工作,现在只需几小时就能完成。

更重要的是,系统能捕捉到人工难以发现的隐性关联,帮助编导挖掘出更有价值的内容。

例如,在制作一档关于环保的纪录片时,系统通过分析历年新闻素材,自动关联了不同时期的环境污染事件与治理成果,为编导提供了全新的叙事思路。

在内容创作层面,Memories.ai的脚本生成和故事板制作模板,极大地提升了创作效率。

短视频创作者可以上传拍摄素材,输入"搞笑短视频脚本"模板,系统会自动提取精彩片段,生成带字幕、配乐建议的脚本;影视公司在前期策划时,可以通过故事板模板,将文字剧本转化为基于现有视频素材的可视化故事板,直观呈现拍摄效果,降低前期沟通成本。

此外,Memories.ai的视频摘要功能,还能帮助媒体机构快速生成新闻摘要、节目预告等内容。

系统不仅能提取关键画面,还能根据内容的重要性和趣味性进行排序,生成符合传播规律的短视频摘要,满足社交媒体传播的需求。

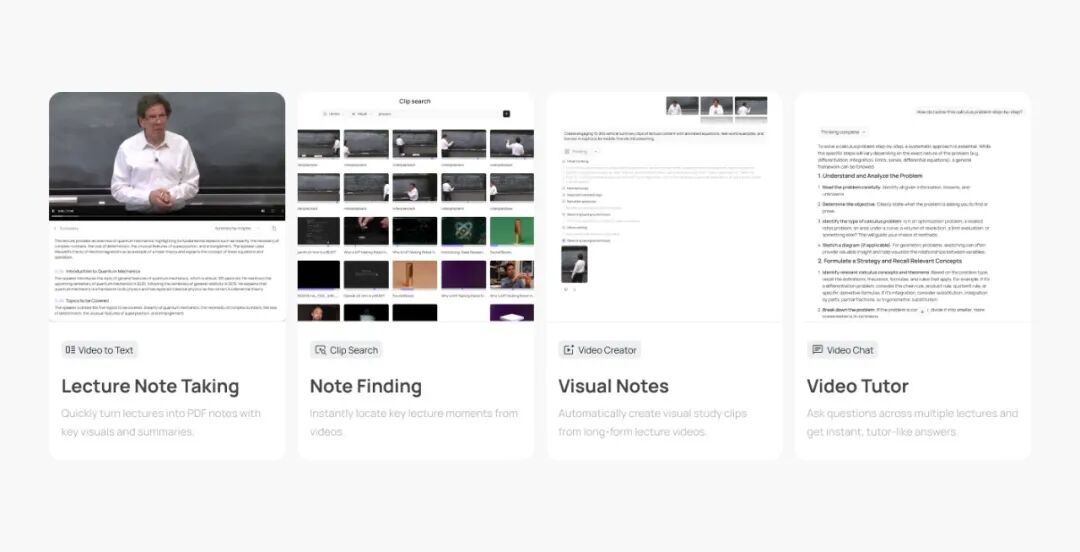

教育行业的视频化趋势,为Memories.ai提供了广阔的应用空间。

在线课程、教学录像、学术讲座等视频内容,正在成为教育资源的重要组成部分,但如何让学生高效利用这些资源,一直是行业痛点。

Memories.ai的技术,正在让视频学习变得更精准、更高效。

在K12教育场景中,Memories.ai与多家在线教育平台合作,推出了"视频课程智能答疑"功能。

学生在观看课程视频时,可以随时用自然语言提问,比如"这个数学公式的推导过程再讲一遍"、"刚才老师提到的历史事件发生在什么时候",系统会自动定位到视频中对应的讲解片段,并进行详细解答。

这一功能解决了传统视频课程"无法互动"的问题,让学生能够按需学习,提升学习效率。

在高等教育和职业培训领域,Memories.ai的知识点标注和笔记生成功能备受青睐。

教师上传教学视频后,系统会自动识别视频中的知识点,并生成结构化的课程大纲;学生观看视频时,系统能根据其观看行为,自动生成包含时间戳、关键画面截图、文字摘要的学习笔记,方便复习回顾。

某职业培训平台的数据显示,使用Memories.ai的系统后,学员的视频课程完成率提升了40%,知识点掌握程度提升了35%。

此外,学术研究领域的视频资源利用也在受益。科研人员可以通过Memories.ai的系统,快速检索学术会议录像、实验视频中的关键内容,提取实验数据、演讲要点等信息,节省文献调研时间。

系统支持的多视频分析功能,还能帮助科研人员对比不同实验视频中的数据差异,发现研究规律。

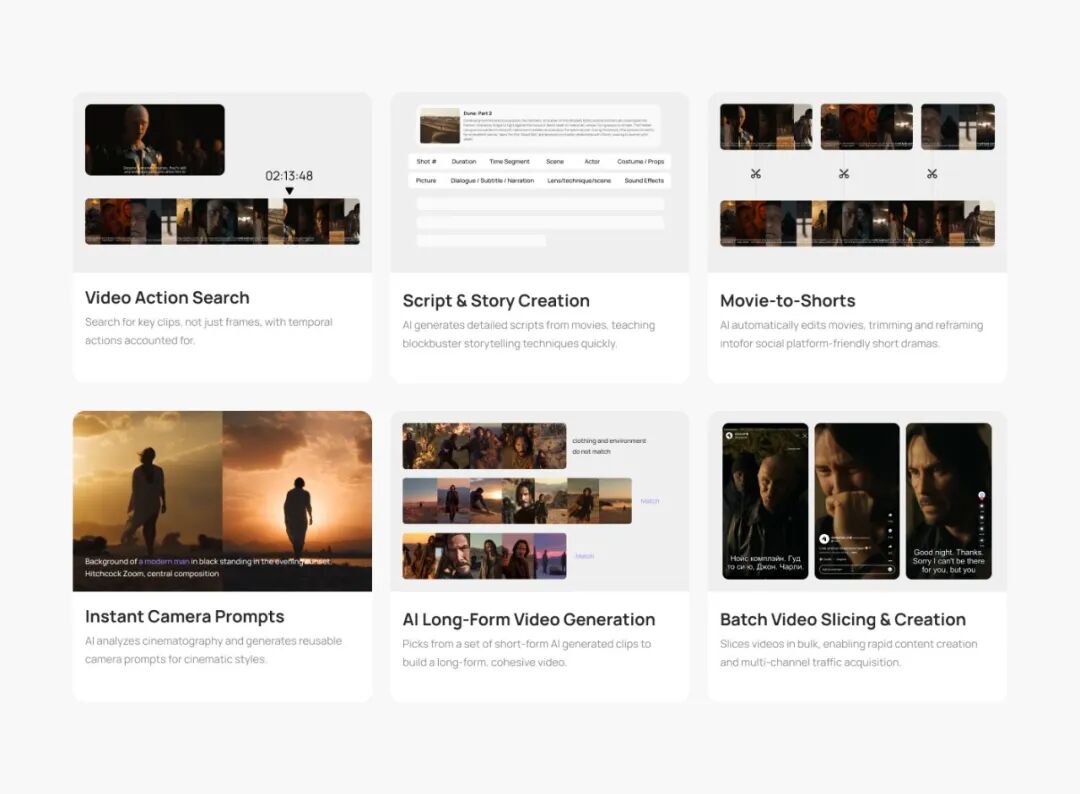

工业制造领域的视频应用,正从传统的安防监控向生产优化、质量控制等核心环节延伸。

Memories.ai的技术,让工业视频数据转化为可利用的生产知识,助力企业实现精益生产。

在生产流程优化方面,Memories.ai与多家制造企业合作,通过分析生产线的监控视频,识别生产过程中的低效环节。

系统能自动捕捉工人的操作动作、设备的运行状态,分析出流程中的瓶颈的问题。

例如,在汽车制造车间,系统通过分析装配线视频,发现某道工序的工人操作动作存在冗余,提出了优化建议,使该工序的生产效率提升了15%。

在质量控制领域,Memories.ai的视频分析技术能够精准识别产品缺陷。

与传统的机器视觉检测相比,其优势在于能够处理复杂的场景——不仅能识别表面可见的缺陷,还能通过分析生产过程中的视频,发现导致缺陷的根本原因。

例如,在电子产品制造中,系统通过分析焊接工序的视频,发现某类产品的焊接缺陷与焊接温度、操作速度的关联,帮助企业调整生产参数,缺陷率降低了20%。

此外,工业设备的维护保养也在借助Memories.ai的技术实现升级。

系统通过分析设备运行的监控视频,捕捉设备的异常状态,如异响、振动、温度异常等,并结合历史维护数据,预测设备的故障风险,提前发出维护预警。

某能源企业使用该系统后,设备的非计划停机时间减少了30%,维护成本降低了25%。

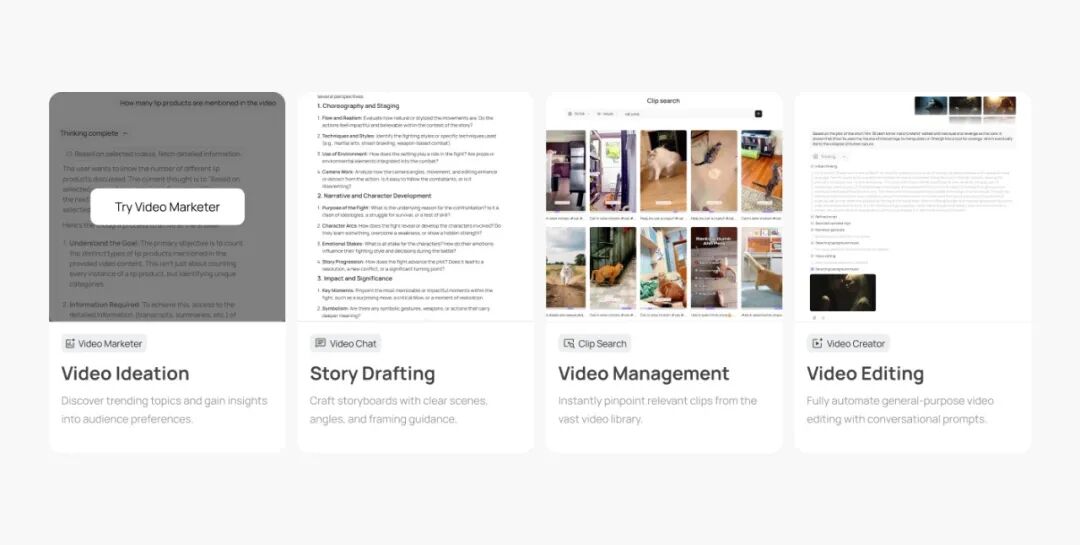

除了B端市场,Memories.ai也在布局C端个人市场,推出了面向个人用户的视频记忆管理工具。

随着智能手机的普及,每个人都积累了大量的生活视频,但这些视频往往被存储在硬盘或云端,难以检索和利用,逐渐成为"数字垃圾"。

Memories.ai的个人版产品,让用户能够轻松管理自己的生活视频。

用户上传视频后,系统会自动进行索引和分类,识别视频中的人物、场景、事件等信息。

用户可以通过自然语言查询,快速找到想要的视频片段,比如"2024年夏天在海边的视频"、"宝宝第一次走路的片段"。

系统还支持智能剪辑功能,自动提取视频中的精彩瞬间,生成个性化的视频集锦,满足用户的分享需求。

更具创新性的是,个人版产品支持"视频记忆对话"功能。

用户可以与系统聊自己的视频内容,比如"我去年生日视频里穿的那件蓝色裙子在哪里买的",系统会自动检索相关视频片段,并提取画面中的关键信息进行回答。

这一功能让生活视频不再是静态的存储,而是成为可交互的"数字记忆"。

"每个人的生活视频里,都藏着珍贵的回忆。我们希望通过技术,让这些回忆能够被轻松找到、被妥善保存、被重新唤醒。"沈俊潇表示,C端市场是公司未来的重要增长点,随着产品的不断迭代,将为个人用户提供更多个性化的视频记忆服务。

据不完全统计,2024-2025年全球涌现了十几种不同的Memory技术路线,包括自动抽取记忆(Mem0)、企业级MemoryServer(Zep)、结构化记忆树(MemU)、神经张量记忆(MemOS)等。

与这些覆盖通用场景的记忆系统不同,Memories.ai选择了"视频垂直赛道"作为切入点,形成了鲜明的差异化优势。

"我们不追求大而全,而是要做专而精。"沈俊潇表示,视频记忆是一个技术门槛极高的细分领域,需要同时掌握多模态编码、时序信息处理、大容量记忆存储等多项核心技术,这对新进入者形成了天然的壁垒。

Memories.ai通过三年多的深耕,已经在视频编码效率、记忆检索精度、自然语言交互流畅度等方面形成了技术优势——在行业权威的LoCoMo测试集上,其视频记忆检索准确率超过92%,远高于行业平均水平。

此外,Memories.ai的"一次索引,多次复用"技术,在成本控制上形成了显著优势。

与传统视频AI系统相比,其用户的计算成本降低了60%以上,这对于处理海量视频的企业用户来说,具有极强的吸引力。

某短视频平台的测试数据显示,使用Memories.ai的系统后,其视频内容的检索和分析成本降低了58%,同时处理效率提升了3倍。

在生态合作方面,Memories.ai采取了"开放API,赋能伙伴"的策略。

其平台提供了丰富的API接口,允许开发者将视频记忆功能集成到自己的产品中。

目前,公司已经与多家AI Agent开发商、视频平台、企业服务软件提供商建立了合作关系,形成了共赢的生态格局。

"我们希望成为视频记忆领域的'基础设施',让更多产品能够具备'看懂'和'记住'视频的能力。"沈俊潇说。

在技术层面,长视频处理和实时性是两大核心难点。

对于小时级的长视频,如何在保证编码精度的同时,控制索引时间和存储成本,是行业共同面临的问题。

Memories.ai目前正在研发分层编码技术,对视频中的关键片段进行高精度编码,对普通片段进行压缩编码,以实现精度与效率的平衡。

此外,在直播等实时场景中,如何实现视频的实时索引和检索,也是需要突破的技术瓶颈——公司计划在2026年推出实时视频记忆功能,将索引延迟控制在秒级。

在市场层面,用户教育和付费习惯培养是关键。

虽然视频记忆的价值显著,但很多企业用户仍然习惯于传统的视频处理方式,对新技术的接受需要时间。

Memories.ai采取了"免费试用+按需付费"的商业模式,新用户可以享受一定额度的免费存储和查询次数,体验后再根据需求付费。

同时,公司通过行业案例分享、线下演示等方式,不断提升市场认知度。

沈俊潇在一次行业峰会上曾预测:"未来五年,每一个AI系统都将具备视频记忆能力。就像今天的AI都具备文本处理能力一样,视频记忆将成为AI的基础功能。而我们的目标,是成为这个领域的标准制定者之一。"

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)