AI驱动的企业知识图谱:构建、维护与应用实践

企业知识图谱作为一种结构化的语义知识库,能够有效整合企业内外部的各类知识,为企业提供智能决策、知识发现等多方面的支持。本文的目的在于详细阐述如何利用AI技术构建、维护和应用企业知识图谱。范围涵盖了从知识图谱的基础概念到实际项目中的具体操作,包括核心算法、数学模型、代码实现以及实际应用场景等多个层面。本文首先介绍背景信息,让读者了解文章的目的和适用范围。接着阐述核心概念与联系,帮助读者建立知识图谱的

AI驱动的企业知识图谱:构建、维护与应用实践

关键词:AI、企业知识图谱、构建、维护、应用实践

摘要:本文围绕AI驱动的企业知识图谱展开,深入探讨了其构建、维护与应用实践。首先介绍了相关背景,包括目的、预期读者等内容。接着阐述了核心概念及联系,详细讲解了核心算法原理和具体操作步骤,同时给出了数学模型和公式。通过项目实战案例,展示了代码实现及解读。分析了实际应用场景,并推荐了相关工具和资源。最后总结了未来发展趋势与挑战,还设置了常见问题解答和扩展阅读参考资料,旨在为企业在知识图谱领域的实践提供全面且深入的指导。

1. 背景介绍

1.1 目的和范围

企业知识图谱作为一种结构化的语义知识库,能够有效整合企业内外部的各类知识,为企业提供智能决策、知识发现等多方面的支持。本文的目的在于详细阐述如何利用AI技术构建、维护和应用企业知识图谱。范围涵盖了从知识图谱的基础概念到实际项目中的具体操作,包括核心算法、数学模型、代码实现以及实际应用场景等多个层面。

1.2 预期读者

本文预期读者包括企业的技术人员,如数据科学家、软件开发工程师、AI研究员等,他们可以从文中获取知识图谱构建和开发的技术细节;企业管理者也可以通过本文了解知识图谱对企业的价值和应用场景,从而做出合理的决策;同时,对知识图谱和AI技术感兴趣的研究人员和学生也能从中获得有价值的信息。

1.3 文档结构概述

本文首先介绍背景信息,让读者了解文章的目的和适用范围。接着阐述核心概念与联系,帮助读者建立知识图谱的基本认知。然后详细讲解核心算法原理和具体操作步骤,结合数学模型和公式进行深入分析。通过项目实战案例展示代码实现和解读,使读者能够将理论知识应用到实际项目中。分析实际应用场景,为企业提供应用思路。推荐相关工具和资源,方便读者进一步学习和实践。最后总结未来发展趋势与挑战,并提供常见问题解答和扩展阅读参考资料。

1.4 术语表

1.4.1 核心术语定义

- 企业知识图谱:以企业为主体,将企业内外部的各种实体(如人员、产品、事件等)及其之间的关系进行结构化表示的语义网络。

- AI(人工智能):研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。

- 实体:知识图谱中的基本对象,可以是具体的事物(如员工、设备)或抽象的概念(如项目、流程)。

- 关系:实体之间的联系,如“隶属关系”“合作关系”等。

1.4.2 相关概念解释

- 语义网络:一种用图来表示知识的结构化方式,节点表示实体,边表示实体之间的关系。

- 本体:对概念和关系的形式化描述,用于定义知识图谱的结构和语义。

1.4.3 缩略词列表

- NLP(Natural Language Processing):自然语言处理,是AI的一个重要分支,用于处理和分析人类语言。

- KG(Knowledge Graph):知识图谱。

2. 核心概念与联系

核心概念原理

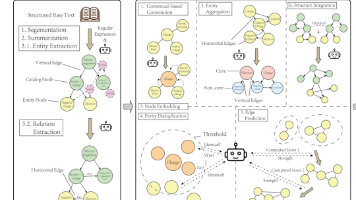

企业知识图谱的核心原理是将企业内外部的各种数据进行抽取、整合和表示,形成一个结构化的语义网络。它通过实体识别、关系抽取等技术,从文本、数据库等数据源中提取实体和关系信息,并将其存储在图数据库中。知识图谱中的实体和关系具有明确的语义,能够支持复杂的查询和推理。

架构的文本示意图

企业知识图谱的架构主要包括数据层、模型层和应用层。

- 数据层:包含企业内外部的各种数据源,如文档、数据库、网页等。这些数据源提供了构建知识图谱所需的原始数据。

- 模型层:负责对数据进行处理和转换,包括实体识别、关系抽取、知识融合等任务。常用的技术包括机器学习、深度学习等。

- 应用层:基于构建好的知识图谱,提供各种应用服务,如智能搜索、智能推荐、决策支持等。

Mermaid流程图

3. 核心算法原理 & 具体操作步骤

实体识别算法原理

实体识别是知识图谱构建的基础任务,其目的是从文本中识别出实体。常见的实体识别算法有基于规则的方法、基于机器学习的方法和基于深度学习的方法。

基于深度学习的实体识别算法(以BERT为例)

BERT(Bidirectional Encoder Representations from Transformers)是一种预训练的语言模型,能够学习到文本的上下文信息。在实体识别任务中,我们可以在BERT模型的基础上添加一个分类层,用于预测每个词的实体标签。

以下是使用Python和Hugging Face的Transformers库实现基于BERT的实体识别的示例代码:

import torch

from transformers import BertTokenizer, BertForTokenClassification

# 加载预训练的BERT模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

model = BertForTokenClassification.from_pretrained('bert-base-chinese', num_labels=5) # 假设共有5种实体标签

# 输入文本

text = "张三在华为公司工作"

tokens = tokenizer.tokenize(text)

input_ids = tokenizer.convert_tokens_to_ids(tokens)

input_ids = torch.tensor([input_ids])

# 进行预测

with torch.no_grad():

outputs = model(input_ids)

logits = outputs.logits

predicted_labels = torch.argmax(logits, dim=2).squeeze().tolist()

# 输出预测结果

for token, label in zip(tokens, predicted_labels):

print(f"Token: {token}, Label: {label}")

关系抽取算法原理

关系抽取的目的是识别实体之间的关系。常见的关系抽取算法有基于规则的方法、基于监督学习的方法和基于深度学习的方法。

基于深度学习的关系抽取算法(以BiLSTM+Attention为例)

BiLSTM(Bidirectional Long Short-Term Memory)是一种双向的循环神经网络,能够捕捉文本的前后文信息。Attention机制可以自动关注文本中的重要部分。在关系抽取任务中,我们可以使用BiLSTM+Attention模型对文本进行编码,然后通过一个全连接层进行关系分类。

以下是使用Python和PyTorch实现基于BiLSTM+Attention的关系抽取的示例代码:

import torch

import torch.nn as nn

import torch.nn.functional as F

class BiLSTM_Attention(nn.Module):

def __init__(self, input_size, hidden_size, num_classes):

super(BiLSTM_Attention, self).__init__()

self.lstm = nn.LSTM(input_size, hidden_size, bidirectional=True, batch_first=True)

self.fc = nn.Linear(hidden_size * 2, num_classes)

self.attention = nn.Linear(hidden_size * 2, 1)

def forward(self, x):

lstm_out, _ = self.lstm(x)

attention_scores = self.attention(lstm_out).squeeze(-1)

attention_weights = F.softmax(attention_scores, dim=1).unsqueeze(-1)

weighted_sum = torch.sum(lstm_out * attention_weights, dim=1)

output = self.fc(weighted_sum)

return output

# 示例使用

input_size = 100

hidden_size = 64

num_classes = 3

model = BiLSTM_Attention(input_size, hidden_size, num_classes)

input_tensor = torch.randn(16, 20, input_size) # 假设批量大小为16,序列长度为20

output = model(input_tensor)

print(output.shape)

具体操作步骤

- 数据收集:收集企业内外部的各种数据,包括文档、数据库、网页等。

- 数据预处理:对收集到的数据进行清洗、分词、标注等预处理操作,为后续的实体识别和关系抽取做准备。

- 实体识别:使用上述的实体识别算法从预处理后的数据中识别出实体。

- 关系抽取:使用关系抽取算法识别实体之间的关系。

- 知识融合:将识别出的实体和关系进行融合,去除重复和冲突的信息。

- 知识存储:将融合后的知识存储在图数据库中,构建知识图谱。

4. 数学模型和公式 & 详细讲解 & 举例说明

实体识别的数学模型

在基于深度学习的实体识别中,通常使用条件随机场(CRF)作为解码模型。CRF是一种概率图模型,用于对序列数据进行建模。

设输入序列为 X=(x1,x2,⋯ ,xn)X = (x_1, x_2, \cdots, x_n)X=(x1,x2,⋯,xn),输出序列为 Y=(y1,y2,⋯ ,yn)Y = (y_1, y_2, \cdots, y_n)Y=(y1,y2,⋯,yn),CRF的概率计算公式为:

P(Y∣X)=1Z(X)exp(∑i=1n∑k=1Kλktk(yi−1,yi,X,i)+∑i=1n∑l=1Lμlsl(yi,X,i))P(Y|X) = \frac{1}{Z(X)} \exp \left( \sum_{i=1}^{n} \sum_{k=1}^{K} \lambda_k t_k(y_{i - 1}, y_i, X, i) + \sum_{i=1}^{n} \sum_{l=1}^{L} \mu_l s_l(y_i, X, i) \right)P(Y∣X)=Z(X)1exp(i=1∑nk=1∑Kλktk(yi−1,yi,X,i)+i=1∑nl=1∑Lμlsl(yi,X,i))

其中,Z(X)Z(X)Z(X) 是归一化因子,tkt_ktk 是转移特征函数,sls_lsl 是状态特征函数,λk\lambda_kλk 和 μl\mu_lμl 是对应的权重。

关系抽取的数学模型

在基于深度学习的关系抽取中,通常使用交叉熵损失函数来训练模型。设模型的预测概率分布为 p(y∣x)p(y|x)p(y∣x),真实标签为 y∗y^*y∗,交叉熵损失函数的计算公式为:

L=−∑i=1Nlogp(yi∗∣xi)L = - \sum_{i=1}^{N} \log p(y_i^*|x_i)L=−i=1∑Nlogp(yi∗∣xi)

其中,NNN 是样本数量。

举例说明

假设我们有一个实体识别任务,输入文本为“张三在华为公司工作”,经过分词后得到“张三”“在”“华为公司”“工作”。我们使用BERT+CRF模型进行实体识别,模型的输出是每个词的实体标签。假设“张三”的标签为“人名”,“华为公司”的标签为“企业名”,通过CRF模型可以得到这些标签的概率分布,从而确定最终的标签。

在关系抽取任务中,假设我们要判断“张三”和“华为公司”之间的关系。我们使用BiLSTM+Attention模型对文本进行编码,然后通过全连接层得到关系分类的概率分布。假设模型预测“张三”和“华为公司”之间的关系为“工作于”,通过交叉熵损失函数可以衡量模型预测结果与真实标签之间的差异,从而进行模型训练。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

安装Python

首先,确保你已经安装了Python 3.6及以上版本。可以从Python官方网站(https://www.python.org/downloads/)下载并安装。

安装必要的库

使用以下命令安装项目所需的库:

pip install torch transformers numpy pandas py2neo

其中,torch 是深度学习框架,transformers 用于加载预训练的语言模型,numpy 和 pandas 用于数据处理,py2neo 用于与图数据库进行交互。

安装图数据库

推荐使用Neo4j作为图数据库。可以从Neo4j官方网站(https://neo4j.com/download/)下载并安装。安装完成后,启动Neo4j服务,并创建一个新的数据库。

5.2 源代码详细实现和代码解读

数据预处理

import pandas as pd

from transformers import BertTokenizer

# 加载数据

data = pd.read_csv('data.csv')

# 分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

# 对文本进行分词

data['tokens'] = data['text'].apply(lambda x: tokenizer.tokenize(x))

# 示例输出

print(data.head())

代码解读:首先使用 pandas 库加载数据,然后使用 BertTokenizer 对文本进行分词。最后将分词结果存储在新的列 tokens 中。

实体识别

import torch

from transformers import BertForTokenClassification

# 加载预训练的BERT模型

model = BertForTokenClassification.from_pretrained('bert-base-chinese', num_labels=5)

# 输入数据

input_ids = []

for tokens in data['tokens']:

input_ids.append(tokenizer.convert_tokens_to_ids(tokens))

input_ids = torch.tensor(input_ids)

# 进行预测

with torch.no_grad():

outputs = model(input_ids)

logits = outputs.logits

predicted_labels = torch.argmax(logits, dim=2).tolist()

# 示例输出

print(predicted_labels[:5])

代码解读:加载预训练的BERT模型,将分词后的文本转换为输入ID。使用模型进行预测,得到每个词的实体标签。

关系抽取

import torch

import torch.nn as nn

import torch.nn.functional as F

class BiLSTM_Attention(nn.Module):

def __init__(self, input_size, hidden_size, num_classes):

super(BiLSTM_Attention, self).__init__()

self.lstm = nn.LSTM(input_size, hidden_size, bidirectional=True, batch_first=True)

self.fc = nn.Linear(hidden_size * 2, num_classes)

self.attention = nn.Linear(hidden_size * 2, 1)

def forward(self, x):

lstm_out, _ = self.lstm(x)

attention_scores = self.attention(lstm_out).squeeze(-1)

attention_weights = F.softmax(attention_scores, dim=1).unsqueeze(-1)

weighted_sum = torch.sum(lstm_out * attention_weights, dim=1)

output = self.fc(weighted_sum)

return output

# 示例使用

input_size = 100

hidden_size = 64

num_classes = 3

model = BiLSTM_Attention(input_size, hidden_size, num_classes)

input_tensor = torch.randn(16, 20, input_size) # 假设批量大小为16,序列长度为20

output = model(input_tensor)

print(output.shape)

代码解读:定义了一个BiLSTM+Attention模型,对输入数据进行编码和关系分类。

知识存储

from py2neo import Graph, Node, Relationship

# 连接图数据库

graph = Graph("bolt://localhost:7687", auth=("neo4j", "password"))

# 创建实体节点和关系

for i in range(len(data)):

# 假设实体和关系已经识别出来

entity1 = Node("Person", name="张三")

entity2 = Node("Company", name="华为公司")

relationship = Relationship(entity1, "WORK_AT", entity2)

graph.create(entity1)

graph.create(entity2)

graph.create(relationship)

代码解读:使用 py2neo 库连接图数据库,创建实体节点和关系,并将其存储在图数据库中。

5.3 代码解读与分析

数据预处理部分

数据预处理是知识图谱构建的基础步骤,通过分词等操作将文本数据转换为模型可以处理的格式。使用 BertTokenizer 可以方便地将文本转换为输入ID,为后续的实体识别和关系抽取做准备。

实体识别部分

基于预训练的BERT模型进行实体识别,利用模型的强大语言理解能力,能够准确地识别出文本中的实体。通过 torch.argmax 函数可以得到每个词的实体标签。

关系抽取部分

BiLSTM+Attention模型结合了循环神经网络和注意力机制,能够有效地捕捉文本中的语义信息,从而准确地识别实体之间的关系。

知识存储部分

使用图数据库Neo4j存储知识图谱,通过创建实体节点和关系,可以将识别出的实体和关系持久化存储,方便后续的查询和应用。

6. 实际应用场景

智能搜索

企业知识图谱可以为智能搜索提供支持。用户可以通过自然语言进行查询,知识图谱能够理解查询的语义,从图谱中找到相关的信息并返回给用户。例如,用户查询“张三负责的项目有哪些”,知识图谱可以根据存储的实体和关系信息,快速定位到张三相关的项目信息并展示给用户。

智能推荐

在企业的业务场景中,知识图谱可以用于智能推荐。例如,根据员工的技能和兴趣,为其推荐相关的培训课程、项目机会等。通过分析知识图谱中员工、技能、课程、项目等实体之间的关系,推荐系统可以为员工提供个性化的推荐。

决策支持

企业在进行决策时,需要考虑各种因素和信息。知识图谱可以整合企业内外部的各种数据,为决策提供全面的支持。例如,在制定市场策略时,知识图谱可以提供市场趋势、竞争对手信息、客户需求等多方面的信息,帮助企业做出更明智的决策。

知识发现

知识图谱可以帮助企业发现隐藏在数据中的知识和关系。通过对知识图谱进行挖掘和分析,可以发现新的业务机会、潜在的风险等。例如,通过分析知识图谱中供应商、产品、客户之间的关系,企业可以发现新的供应链优化方案。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《知识图谱:方法、实践与应用》:全面介绍了知识图谱的基本概念、技术方法和应用案例,是学习知识图谱的经典书籍。

- 《深度学习》:由Ian Goodfellow、Yoshua Bengio和Aaron Courville合著,是深度学习领域的权威教材,对于理解知识图谱中的深度学习算法有很大帮助。

- 《自然语言处理入门》:帮助读者快速掌握自然语言处理的基本概念和技术,是学习实体识别、关系抽取等任务的重要参考书籍。

7.1.2 在线课程

- Coursera上的“Natural Language Processing Specialization”:由斯坦福大学教授授课,涵盖了自然语言处理的多个方面,包括实体识别、关系抽取等。

- edX上的“Deep Learning Specialization”:由Andrew Ng教授授课,深入介绍了深度学习的原理和应用,对于理解知识图谱中的深度学习模型有很大帮助。

- 中国大学MOOC上的“知识图谱技术与应用”:系统介绍了知识图谱的构建、维护和应用技术,适合初学者学习。

7.1.3 技术博客和网站

- 博客园:有很多技术博主分享知识图谱和AI相关的技术文章,包括算法原理、实践经验等。

- 知乎:在知乎上可以找到很多关于知识图谱的讨论和问答,了解行业动态和最新技术。

- 开源中国:提供了丰富的开源项目和技术文章,对于学习知识图谱的开源实现有很大帮助。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:是一款专门为Python开发设计的集成开发环境,具有代码自动补全、调试等功能,适合开发知识图谱项目。

- Jupyter Notebook:是一个交互式的开发环境,支持Python代码的编写和运行,方便进行数据探索和模型实验。

- Visual Studio Code:是一款轻量级的代码编辑器,支持多种编程语言和插件,适合快速开发和调试。

7.2.2 调试和性能分析工具

- PyTorch Profiler:可以对PyTorch模型进行性能分析,帮助开发者找出模型的性能瓶颈。

- TensorBoard:是TensorFlow的可视化工具,也可以用于PyTorch模型的可视化和调试。

- Memory Profiler:可以对Python代码的内存使用情况进行分析,帮助开发者优化代码的内存占用。

7.2.3 相关框架和库

- Transformers:由Hugging Face开发,提供了丰富的预训练语言模型,如BERT、GPT等,方便进行实体识别、关系抽取等任务。

- PyTorch:是一个开源的深度学习框架,具有高效的计算性能和灵活的模型构建能力,适合开发知识图谱中的深度学习模型。

- Neo4j:是一个流行的图数据库,提供了丰富的图数据处理和查询功能,适合存储和管理知识图谱。

7.3 相关论文著作推荐

7.3.1 经典论文

- “BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding”:介绍了BERT模型的原理和训练方法,是自然语言处理领域的经典论文。

- “Long Short-Term Memory”:介绍了LSTM模型的原理和应用,对于理解知识图谱中的循环神经网络有很大帮助。

- “Attention Is All You Need”:介绍了Transformer模型的原理和应用,是深度学习领域的重要论文。

7.3.2 最新研究成果

- 关注ACL(Association for Computational Linguistics)、NeurIPS(Conference on Neural Information Processing Systems)等顶级学术会议的论文,了解知识图谱和AI领域的最新研究成果。

- 关注知名学术期刊,如Journal of Artificial Intelligence Research(JAIR)、Artificial Intelligence等,获取最新的研究论文。

7.3.3 应用案例分析

- 一些企业和研究机构会发布知识图谱的应用案例,如谷歌、百度等公司的知识图谱应用。通过分析这些案例,可以了解知识图谱在实际应用中的具体实现和效果。

8. 总结:未来发展趋势与挑战

未来发展趋势

- 多模态融合:未来的企业知识图谱将不仅仅局限于文本数据,还会融合图像、音频、视频等多模态数据,从而提供更丰富的知识表示和应用。

- 与区块链结合:区块链技术可以为知识图谱提供更安全、可信的存储和共享方式。通过区块链,知识图谱的数据可以实现去中心化存储和管理,保证数据的真实性和完整性。

- 智能推理能力提升:知识图谱的智能推理能力将不断提升,能够进行更复杂的逻辑推理和知识发现。例如,通过推理可以预测企业的业务趋势、发现潜在的风险等。

- 行业定制化:不同行业对知识图谱的需求和应用场景有所不同,未来将出现更多针对特定行业的定制化知识图谱解决方案。

挑战

- 数据质量和数量:构建高质量的知识图谱需要大量的高质量数据。然而,企业内外部的数据往往存在质量参差不齐、数据缺失等问题,如何获取和处理这些数据是一个挑战。

- 算法复杂度和效率:随着知识图谱的规模不断增大,算法的复杂度和效率成为一个关键问题。如何设计高效的算法,在保证准确率的前提下提高处理速度,是需要解决的难题。

- 隐私和安全问题:知识图谱中包含了企业的大量敏感信息,如客户信息、业务数据等。如何保证这些信息的隐私和安全,防止数据泄露和滥用,是企业面临的重要挑战。

- 跨领域知识融合:企业知识图谱往往涉及多个领域的知识,如何将不同领域的知识进行有效的融合和统一表示,是一个具有挑战性的问题。

9. 附录:常见问题与解答

问题1:知识图谱和传统数据库有什么区别?

解答:传统数据库主要以表格形式存储数据,数据之间的关系是通过外键等方式建立的,难以表示复杂的语义关系。而知识图谱以图的形式存储数据,节点表示实体,边表示实体之间的关系,能够更自然地表示复杂的语义信息,支持复杂的查询和推理。

问题2:如何评估知识图谱的质量?

解答:可以从以下几个方面评估知识图谱的质量:

- 完整性:知识图谱中包含的实体和关系是否完整,是否覆盖了企业的主要业务信息。

- 准确性:实体和关系的识别是否准确,是否存在错误或歧义。

- 一致性:知识图谱中的信息是否一致,是否存在矛盾或冲突。

- 时效性:知识图谱中的信息是否及时更新,是否反映了企业的最新情况。

问题3:知识图谱的构建需要多长时间?

解答:知识图谱的构建时间取决于多个因素,如数据量的大小、数据的复杂度、算法的选择等。一般来说,小型的知识图谱可能需要几周或几个月的时间,而大型的企业知识图谱可能需要几个月甚至几年的时间。

问题4:如何保证知识图谱的可扩展性?

解答:可以从以下几个方面保证知识图谱的可扩展性:

- 数据模型设计:设计灵活的数据模型,能够方便地添加新的实体和关系类型。

- 算法选择:选择具有良好扩展性的算法,能够处理大规模的数据。

- 分布式存储:使用分布式图数据库,能够将知识图谱的数据分布在多个节点上,提高存储和处理能力。

10. 扩展阅读 & 参考资料

扩展阅读

- 《大数据时代》:介绍了大数据的概念、技术和应用,对于理解知识图谱的数据来源和应用场景有很大帮助。

- 《人工智能简史》:回顾了人工智能的发展历程,了解人工智能的发展趋势和技术演变。

- 《图数据库实战》:详细介绍了图数据库的原理和应用,对于深入理解知识图谱的存储和管理有很大帮助。

参考资料

- 知识图谱相关的学术论文和研究报告。

- 开源知识图谱项目的文档和代码,如DBpedia、Wikidata等。

- 企业知识图谱的应用案例和实践经验分享。

更多推荐

已为社区贡献54条内容

已为社区贡献54条内容

所有评论(0)