GMI Cloud 实践手册:AI 模型 API 调用指南,玩转千行百业全场景

首篇!

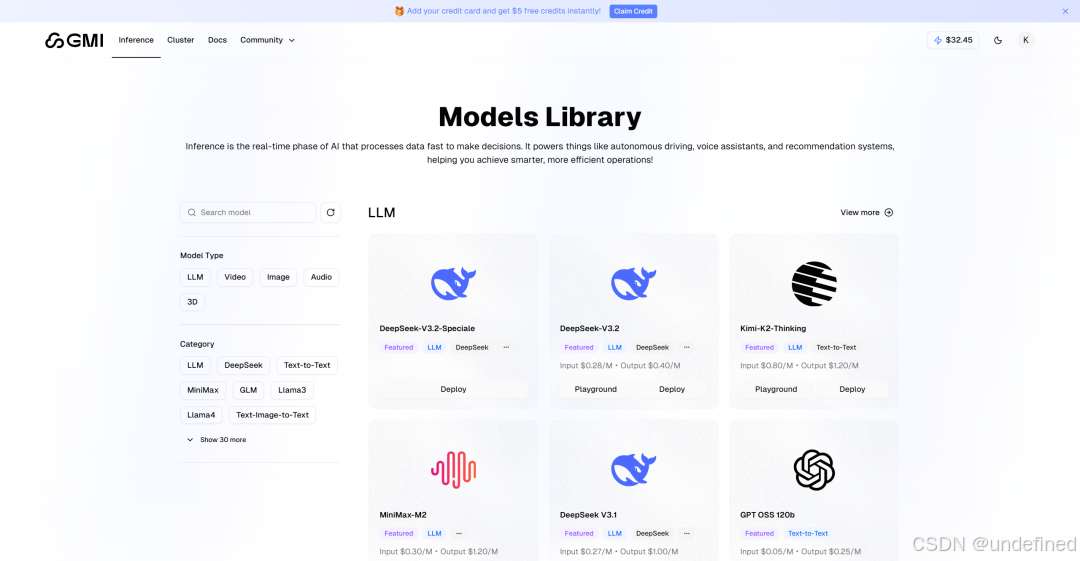

GMI Cloud Inference Engine 是全球 AI 模型统一接入与在线使用的“高性能推理引擎平台”,底层搭载 H100/H200 芯片,集成全球近百个最前沿的大语言模型和视频生成模型,如 Minimax、DeepSeek、GPT OSS、Qwen、Kling 等,为 AI 开发者与企业提供速度更快、质量更高的模型服务。

欢迎来到!🎉🎉🎉

GMI Cloud Inference Engine AI 场景实践案例集!

这是一个 AI 百花齐放的时代。每一天,都有评测性能更强的大模型发布、更高效的 AI 应用、更有趣的 AI 创意诞生。在我们的 Inference Engine 平台上,你可以选择在我们各个模型的 Playground 里面试用各种最新 AI 大模型,或者调用其 API,和其他应用结合进行自由探索。

但对于新手开发者和企业管理者而言,在探索中也存在一些复杂的挑战:

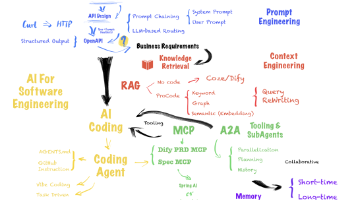

对于新手开发者而言,面对海量的模型 API,如何快速跑通第一个 Demo?如何在复杂的业务场景(如 RAG、Agent)中优雅地集成?对于企业决策者而言,AI 应用不仅仅是调用 API,更是一场关于成本、效率和数据安全的博弈。当业务起量后,如何从 API 切换到私有化部署?去哪里寻找高性价比的 GPU 算力来支撑业务的指数级增长?

这正是我们撰写这个系列的初衷,希望你能在这里找到问题的答案。

01

这个系列将包括什么?

What’s Coming in This Series?

本系列将跳出枯燥的参数说明,手把手教你如何将 GMI Cloud 的平台与你日常玩的 AI 应用结合起来,获得更方便、性价比更高、更灵活的生活和工作助手。我们将覆盖 LLM、图像、音视频等全模态场景:

精选实战场景预告🙌

-

开发工具篇:如何在 IDE 等开发工具中自定义大模型,开启高性价比、最适合的开发模型方案?

-

翻译工具篇:在沉浸式翻译等浏览器插件中一键配置 API,以极低成本实现网页、电子书与专业文档的毫秒级精准互译。

-

对话助手篇:零代码搭建安全、私密且支持多模型切换的专属桌面工作台。

-

效率工具篇:为飞书、Obsidian 等文档工具注入高效模型服务,让 AI 深度融入代码编写、笔记整理与办公自动化的每一个工作流。

-

多模态创意篇:结合文生图与视频模型 API,自动化生成营销短视频流。

…… 更多创意,GMI Cloud 等待和你一起探索

02

如果你第一次调用 API

可以看看这篇 [新手指南]

First Time with APIs? Start Here!

2.1 调用 API 需要填写什么?

你可以把一次调用 API 的过程想象成一个给某人送信的过程。

去哪连? (Endpoint URL) “那个人的地址”

谁在连? (API Key) "自报家门、出示证件"

用什么连? (Model ID) “哪个任务”

2.2 这些是什么、怎么用、使用时有什么注意要点?

1) API Endpoint (服务地址)

定义:服务器的“门牌号”。

你需要做的:直接复制粘贴。

2) API Key (授权密钥)

定义:一串加密的字符串,代表你的账户权限(类似身份证)。

你需要做的:在后台生成,并立刻复制粘贴(api 这显示生成时这一次)然后像保护密码一样保护它。

这是唯一能证明“你是你”的凭证。Key 泄露有钱被别人花掉的风险。

3) Model ID / Name (模型标识)

定义:指定具体使用哪个引擎来工作。

你需要做的:必须精准输入官方提供的模型代号。

模型与模型之间的特性有时差别很大, 甚至同一个系列的不同模型也应用于不同的情境,比如 deepseek 推理版和非推理版,才能够更好用最适合你的模型才能够更好。

03

想要精确地控制 API 或者解决连 API 时

遇到的问题:可以了解更多

Master APIs Like a Pro!

API 是一个标准的 HTTP 请求与响应(Request & Response) 的过程。

3.1 HTTP 交互基础

API 的本质是你的程序向模型服务器发送一个数据包(Request),服务器处理后返回一个数据包(Response)。

无状态性 (Statelessness):这是最重要的概念。模型本身不“记忆”之前的对话。每次你发送请求时,必须把之前的聊天记录(Context)打包一起发过去,模型才能联系上下文回答你。

3.2 Authentication

这是建立连接的第一步,用于身份验证。

1)API Key:通常是一个很长的字符串。

2)Header(请求头):在发送请求时,这个 Key 通常不写在内容里,而是放在 HTTP 协议的头部信息中。

格式通常为:Authorization: Bearer <你的API Key>

注意:Key 对应着你的账户余额和权限(如每分钟允许请求多少次 Rate Limit)。

3.3 Base URL 与 Endpoint

这二者是请求发送的目标地址。

1)Base URL:

基础路径。例如 DeepSeek官方的基础路径是

https://api.deepseek.com

2)Endpoint:

也叫端点,是具体功能的路径。最常用的端点是 Chat Completions(聊天补全),标准路径通常是 /v1/chat/completions。

当你使用支持“OpenAI 兼容”的工具(如 GMI Cloud Inference Engine )时,只需替换 Base URL,工具会自动在后面拼接 /v1/chat/completions。

3.4 请求载荷 (Payload):Messages 结构

这是你发送给模型的数据核心。它不是简单的“一句话”,而是一个结构化的列表(List/Array)。

列表中的每一项是一个消息对象(Object),包含两个关键字段:role(角色)和 content(内容)。

需要理解的三种 role 如下。

1)System (系统):

作用:设定 AI 的人设、行为准则或限制条件。

位置:通常放在列表的第一位。

示例:{"role": "system", "content": "你是一个专业的 Python 资深工程师,只回答代码相关问题。"}2)User (用户):

作用:代表你(或者你的终端用户)的提问。

示例:{"role": "user", "content": "帮我写一个贪吃蛇游戏。"}3)Assistant (助手):

作用:代表 AI 之前回答过的内容。

逻辑:为了实现多轮对话,你必须把 AI 之前的回复作为 input 再次发回给它。

3.5 推理参数(Inference Parameters)

这些参数控制模型生成文本的逻辑概率。

1)Temperature (温度):

定义:控制采样概率分布的平滑程度。

客观效果:数值越低(趋近 0),模型总是选择概率最高的词,输出确定性高、重复性高;数值越高(趋近 1 或 2),模型会选择概率较低的词,输出随机性大、多样性强。

2)Max Tokens (最大令牌数):

定义:限制模型生成的响应内容的长度。

注意:如果设得太短,输出会被强制截断(不完整)。

3)Stream (流式传输):

Boolean 值:true 或 false。

False:程序会等待模型完全生成完所有文字后,一次性收到整个 JSON 包(等待时间较长)。

True:模型每生成几个字符就推送到你的程序,实现类似打字机的实时效果(用户体验更好)。

3.6 Token (令牌) 与 上下文窗口 (Context Window)

1)Token:

大模型处理文本的最小算力单位。它不完全等于字符。

中文通常 1 个汉字对应 1.5 ~ 2 个 Token。

2)Context Window (上下文窗口):

这是模型一次请求能处理的数据总量上限(包含你发送的 System + User + Assistant 历史记录 + 模型即将生成的 Output)。

溢出风险:如果对话历史太长,超过了窗口限制(如 DeepSeek 的 128k context),必须采用“截断”或“总结”策略,丢弃最早的历史记录,否则 API 会报错。

3.7 最后:一个标准的 API 请求结构(JSON 示例)

JSON

{ // 1. 指定模型"model": "deepseek-chat", // 2. 构建对话历史 (Context)"messages": [ {"role": "system", "content": "你是一个翻译助手。"}, {"role": "user", "content": "把 Hello World 翻译成中文。"} ], // 3. 设定参数"temperature": 0.5, "stream": true}更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)