入门篇--知名企业-10-Hugging Face:不止是AI的GitHub,而是每个开发者的AI战友

OpenAI 限制 GPT-4 输出;Google Gemini 拒绝开源;亚马逊、苹果将 AI 锁进自家生态。而在这样的背景下,Hugging Face 像一座开放的公共图书馆——任何人都可以进来阅读、抄写、甚至添一本自己的书。它不承诺最强大的模型,但承诺最自由的探索。这让我想起理查德·斯托曼的话:“软件自由关乎用户控制软件的权利,而非价格。Hugging Face 正在将这一精神延伸至 AI

Hugging Face:开源AI的“联合国”,让每个人都能参与智能革命

作者:Weisian

科技观察者 · 开源社区践行者 · AIGC实践者 · 相信技术应该像空气一样自由流动

哈喽各位小伙伴!

最近后台收到超多留言——来自AI新手、开发者甚至科技爱好者都在问:

“想入门大模型开发,为什么大家都推荐先了解 Hugging Face?”

“Hugging Face 到底是个什么平台?只是个模型仓库吗?”

“除了找模型,它还有哪些实用功能?”

今天就为大家带来一期超全、超系统、超接地气的 Hugging Face 深度攻略!

无论你是刚接触 AI 的小白、想提升效率的开发者,还是关注 AI 生态的科技爱好者,这篇内容都能帮你把 Hugging Face 扒得明明白白。

全程无晦涩术语堆砌,全是干货 + 实操指南。耐心看完,你不仅能理解它的价值,还能立刻上手用起来!

一、初识 Hugging Face:不止是“模型仓库”,更是 AI 开发者的数字家园

提到 Hugging Face,很多人第一反应是:“哦,那个可以下载大模型的网站。”

但其实,它的定位远不止于此——它是一个集模型仓库、开发工具、社区交流于一体的 AI 生态平台,被业内誉为“AI 界的 GitHub”。

1.1 起源故事:从聊天机器人到开源基础设施

Hugging Face 成立于 2016 年,由三位法国年轻人——Clément Delangue(CEO)、Julien Chaumond(CTO)和 Thomas Wolf(前首席科学家)在旧金山一间小公寓里创办。

公司名字灵感来自任天堂《星之卡比》中那个张开双臂、热情拥抱的粉色小怪物。最初,他们真的做了一款面向青少年的情感陪伴聊天 App。

但这款 App 并未走红。

然而,在开发过程中积累的 NLP(自然语言处理)模型和工具却意外吸引了大量开发者关注。于是团队果断转型:放弃消费产品,全力投入开源 AI 基础设施建设。

如今,Hugging Face 已成为全球 AI 开发者不可或缺的“数字家园”:

- 托管 超 100 万个模型

- 收录 30 万个数据集

- 部署 20 万个演示应用(Spaces)

更关键的是,它始终坚持开源、开放、协作的理念,在 AI 日益封闭化的浪潮中,守护着一片公共知识的绿洲。

1.2 为什么人人都在用 Hugging Face?

它能成为 AI 开发者的“必备工具”,核心原因有三点:

- 全:覆盖 NLP、计算机视觉、语音识别、多模态等几乎所有 AI 领域;

- 易:提供如

Transformers这样的封装库,大幅降低开发门槛; - 活:拥有全球最活跃的 AI 社区,支持协作、分享与快速迭代。

即使你不写代码,也能在 Spaces 上直接体验 AI 应用,或下载数据集学习研究。

它的服务对象,是整个 AI 生态链上的每一个人。

二、谁创造了 Hugging Face?一群“理想主义工程师”的逆行

三位创始人背景各异,却志同道合:

- Clément Delangue:前 Facebook 产品经理,擅长产品与社区运营;

- Julien Chaumond:连续创业者,技术架构专家;

- Thomas Wolf:德国理论物理博士转 AI 研究员,Transformer 模型早期贡献者。

他们本可加入大厂拿高薪,却选择了一条更艰难的路:构建一个不属于任何公司的 AI 基础设施。

“我们相信,AI 不应该被锁在少数科技巨头的黑箱里。它属于全人类。”

—— Clément Delangue,2022 NeurIPS 大会

这种信念贯穿 Hugging Face 的每一步发展:

- 2018 年:开源

Transformers库,让 BERT、GPT 等前沿模型一键可用; - 2020 年:推出 Model Hub,允许任何人上传、分享、复用模型;

- 2021 年:上线 Spaces,让非程序员也能部署 AI 应用;

- 2023 年:发布 AutoTrain,实现“零代码微调模型”。

他们不追求用户增长或广告收入,而是专注降低 AI 使用门槛。这种“反商业”的初心,反而赢得了全球开发者的信任。

三、核心理念:不是卖工具,而是建“公共广场”

Hugging Face 的使命非常清晰:加速和民主化 AI 的普及(Accelerate and democratize AI)。

这不只是口号,而是体现在每一个产品设计中。

3.1 开源优先,透明为本

与 OpenAI、Anthropic 等封闭模型厂商不同,Hugging Face 默认一切可开源:

- 核心库(

Transformers、Datasets、Accelerate等)全部采用 MIT 许可; - 模型权重公开下载(除非作者选择私有);

- 训练代码、评估脚本、推理示例一应俱全。

| 维度 | 之前 | 之后 |

|---|---|---|

| 模型获取 | 需自己复现论文 | 一行代码下载预训练模型 |

| 接口统一 | 每个框架 API 不同 | 统一 Pipeline 接口 |

| 社区贡献 | 分散在个人 GitHub | 集中平台,有标准有质量 |

| 文档质量 | 基本靠猜 | 详细文档 + 示例 + 教程 |

这意味着你可以:

- 复现论文结果;

- 在已有模型上微调;

- 审查模型是否存在偏见或漏洞。

透明,是信任的第一块基石。

3.2 社区驱动,人人可贡献

Hugging Face 的生态由全球社区共建:

- 个人研究者上传实验模型;

- 企业(如 Meta、Google、Mistral)发布官方模型;

- 学生用 Spaces 搭建课程项目;

- 非营利组织分享医疗、环保领域的专用数据集。

真实案例:

我认识一个波兰的两人创业公司,他们用 Hugging Face:

- 基于 BERT 微调了波兰语情感分析模型;

- 部署为 API 服务当地企业;

- 月收入已超 5 万美元。

如果没有 Hugging Face:

需自己实现 Transformer;需大量算力预训练;起步成本可能超数十万美元。

而现在:他们用 Google Colab 完成微调,用 Spaces 免费部署演示。

平台设有 “Featured Models” 和 “Trending Spaces” 榜单,让优质内容自然浮现,而非由算法主导推荐。

更难得的是,Hugging Face 团队亲自参与社区讨论——你常能在 GitHub Issue 或论坛看到工程师直接回复问题,甚至采纳建议改进 API。

四、核心产品矩阵:从代码到应用的一站式生态

Hugging Face 的产品体系像一座金字塔:底层是开发者工具,顶层是普通用户入口。

4.1 Transformers:AI 界的“标准库”

这是 Hugging Face 最著名的开源库,支持:

- 超 200 种架构(BERT、GPT、T5、Llama、Claude、Stable Diffusion 等);

- 一键加载预训练模型;

- 统一 API,兼容 PyTorch 与 TensorFlow。

一句 from transformers import pipeline,就能让高中生跑起最先进的文本分类器。

截至 2025 年,Transformers 已被下载超 10 亿次,成为 NLP 领域的事实标准。

核心设计理念:一致性

from transformers import AutoModel, AutoTokenizer

# 自动识别模型类型

model = AutoModel.from_pretrained("bert-base-uncased")

tokenizer = AutoTokenizer.from_pretrained("bert-base-uncased")

inputs = tokenizer("Hello world!", return_tensors="pt")

outputs = model(**inputs)

支持领域包括:

- 文本:BERT、GPT、T5…

- 视觉:ViT、DETR、Swin…

- 多模态:CLIP、VisualBERT…

- 音频:Wav2Vec2、Whisper…

- 表格:TabNet…

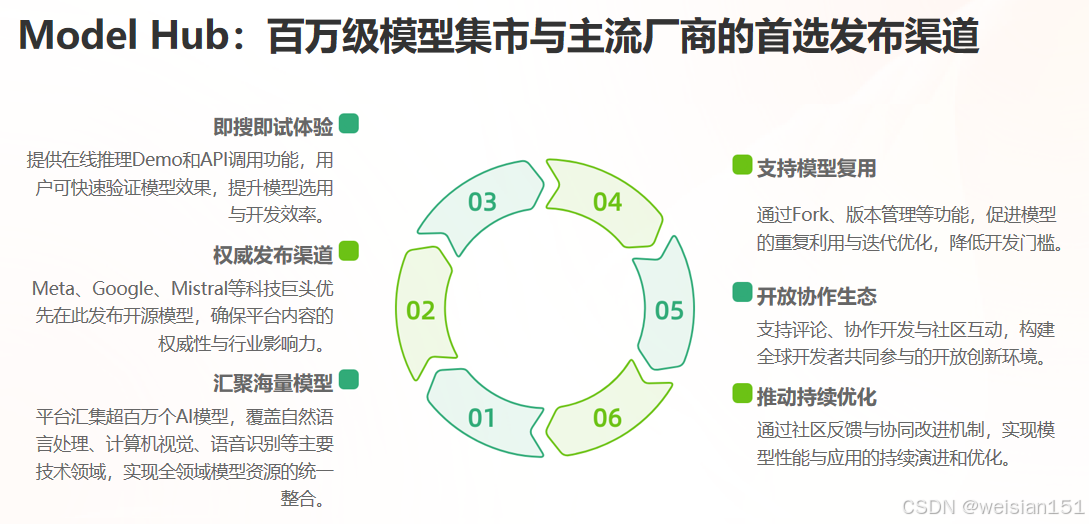

4.2 Model Hub:全球最大的 AI 模型集市

在这里,你可以:

- 搜索“中文情感分析”、“医学影像分割”、“语音合成”等模型;

- 查看 Model Card(模型卡片),了解训练数据、性能指标、伦理风险;

- 直接在线试用(Inference API);

- Fork 模型进行二次开发。

主流开源模型首选发布平台:

Meta 的 Llama 系列、Mistral 的 Mixtral、Google 的 Gemma 等,均将 Hugging Face 作为官方分发渠道。

我的使用习惯:

- 在 Model Hub 搜索相关任务;

- 按下载量 / Likes 排序;

- 查看模型卡和使用示例;

- 试用在线 Demo;

- 快速集成到项目中。

这个流程通常 30 分钟内就能让我启动一个新项目。

4.3 Datasets:AI 开发的“高效素材库”

传统数据处理有多痛苦?

格式杂乱(CSV、JSON、Parquet…)、内存管理困难、预处理代码重复。

Datasets 库的优雅解决方案:

from datasets import load_dataset

# 自动下载并缓存

dataset = load_dataset("glue", "mrpc")

# 流式处理大数据

dataset = load_dataset("c4", "en", streaming=True)

# 自动映射处理

dataset = dataset.map(lambda x: preprocess(x))

核心优势:

- 内存映射:处理比内存更大的数据集;

- 流式加载:无需下载完整数据;

- 指纹缓存:自动缓存处理结果;

- 丰富元信息:含许可证、语言、领域等。

目前平台收录 超 30 万个数据集,覆盖文本、图像、语音、科学等几乎所有领域。

4.4 Spaces:零代码部署 AI 应用

Spaces 允许用户用 Gradio 或 Streamlit 快速搭建 Web 界面,并免费托管。

解决了什么问题?

以前部署一个 AI Demo 需要:租服务器、配环境、写前端、处理并发、监控维护。

现在只需:写一个 Python 脚本 → 推送到 GitHub → 在 Spaces 创建应用 → 选择环境 → 完成!

真实案例:

- 学生上传“古诗生成器”,输入关键词即得七言绝句;

- 医生团队部署“皮肤病变识别工具”,供偏远诊所使用;

- 艺术家创建“AI 风格迁移画廊”,观众上传照片变梵高。

目前 Spaces 已托管 超 20 万个应用,涵盖教育、医疗、艺术、农业等场景。

4.5 企业级服务:开源免费 + 商业增值

为满足商业需求,Hugging Face 也提供付费服务:

- AutoTrain:图形化界面微调模型,无需写代码;

- Inference Endpoints:一键部署高可用 API,支持 GPU/TPU;

- Private Hub:企业内网私有化模型仓库,保障数据安全。

这种“开源免费 + 企业增值”模式,既维持社区活力,又实现商业可持续。

五、真实工作流:Hugging Face 如何改变我的日常

5.1 场景一:快速原型验证(电商评论分类)

传统流程(约 2 周):文献调研 → 框架选型 → 基线实现 → 数据预处理 → 训练调优

Hugging Face 流程(实际 2 天):

# Day 1: 探索 + 数据准备

from transformers import pipeline

classifier = pipeline("zero-shot-classification")

result = classifier("产品质量太差", ["产品质量", "客服服务"])

from datasets import Dataset

dataset = Dataset.from_pandas(pd.read_csv("reviews.csv"))

# Day 2: 微调 + 部署

from transformers import AutoModelForSequenceClassification, Trainer

model = AutoModelForSequenceClassification.from_pretrained("bert-base-chinese")

trainer = Trainer(model=model, train_dataset=dataset["train"], ...)

trainer.train()

# 用 Gradio 快速部署

import gradio as gr

interface = gr.Interface(fn=classify_text, inputs="text", outputs="label")

interface.launch()

效果:成本降 80%,周期缩 75%,准确率反超商业软件。

5.2 场景二:教育项目(中学 AI 教学工具)

挑战:预算有限、需多语言支持、操作简单

解决方案:

- 文本生成:GPT-2 小型版

- 图像分类:MobileNet(浏览器运行)

- 翻译:M2M100(支持 100 种语言)

- 语音识别:Whisper 小型版

成果:成本几乎为零(Spaces 免费托管),一人 3 周完成,学生反馈:“原来 AI 这么有趣!”

5.3 场景三:企业概念验证(客服工单分类)

Hugging Face 方案:

- 第 1 周:用现有模型创建演示

- 第 2 周:收集匿名客户数据

- 第 3 周:微调模型

- 第 4 周:部署测试版,收集反馈

结果:客户获得完全控制权,且准确率更高。

六、社区文化:在协作中生长的“AI 联合国”

Hugging Face 的社区氛围,可用三个词概括:开放、互助、多元。

6.1 全球协作,无国界

平台上活跃着来自 190+ 国家的用户:

- 尼日利亚开发者上传本地语言 ASR 模型;

- 印度学生用 Spaces 教村民识别农作物病害;

- 巴西研究者分享亚马逊雨林生物声学数据集。

官方积极推动多语言支持,界面覆盖 30+ 语种,模型库包含大量非英语资源。

6.2 教育普惠,从课堂开始

Hugging Face 与全球高校合作推出 Education Program:

- 提供教学模板与课程材料;

- 为学生项目提供免费计算资源;

- 举办 Hackathon 激发创新。

许多 AI 课程的第一堂课就是:“用 Hugging Face 跑一个情感分析模型”。

6.3 伦理先行,责任共担

面对 AI 滥用风险,Hugging Face 主动建立治理机制:

- 要求填写 Model Card,披露潜在偏见;

- 对生成模型标注“可能产生幻觉”;

- 设立 Ethics Review Board;

- 推出 Bias Evaluation Toolkit。

这种“技术 + 伦理”并重的态度,使其在监管趋严的环境中赢得先机。

七、商业与生态:如何在开源与盈利间走钢丝?

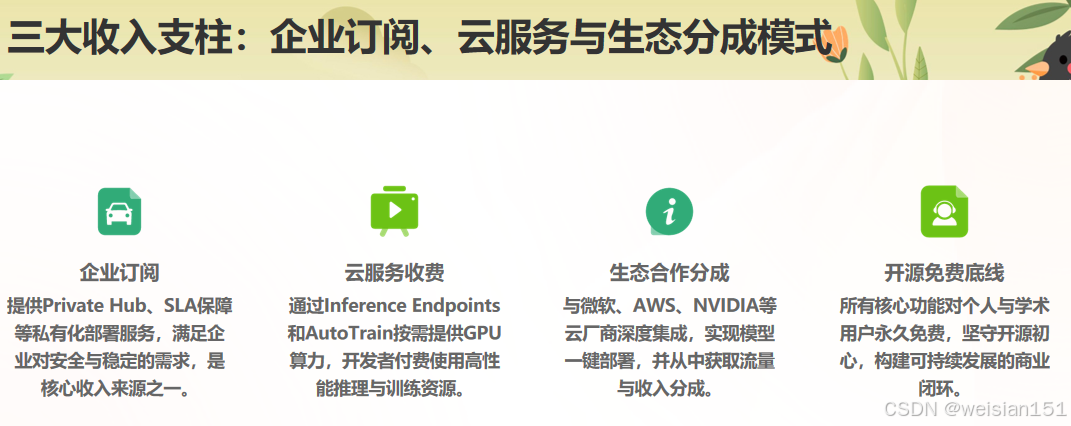

7.1 收入来源

- 企业订阅(Hugging Face Enterprise):私有部署、SLA 保障;

- 云服务(Inference & Training):按用量收费的 GPU 算力;

- 合作授权:与微软、AWS、NVIDIA 等云厂商分成。

据 2024 年财报,年收入已突破 2 亿美元,且保持盈利。

所有核心功能对个人和学术用户永久免费。

7.2 战略合作:不做孤岛,做桥梁

Hugging Face 深度融入全球 AI 生态:

- 与 NVIDIA 合作:优化 GPU 推理;

- 与 Amazon SageMaker 集成:一键部署到 AWS;

- 与 Google Cloud 共建:支持 Vertex AI 调用;

- 与 Intel、AMD 合作:适配 CPU/加速芯片。

它不试图“赢者通吃”,而是成为连接各方的基础设施。

八、争议与挑战:开源的边界在哪里?

尽管广受赞誉,Hugging Face 也面临现实困境。

❓“开源是否助长滥用?”

有人利用平台下载模型,用于深度伪造、垃圾信息生成。

应对措施:引入 Access Requests 机制——敏感模型需申请批准才能下载,并记录用途。

❓“大厂依赖是否危险?”

Meta、Google 等将 Hugging Face 作为分发渠道,一旦政策变化(如限制 Llama 商用),生态可能受冲击。

应对策略:推动去中心化模型注册(类似 IPFS),减少单点依赖。

❓“如何持续吸引顶尖人才?”

相比 OpenAI 动辄百万年薪,Hugging Face 薪酬并无优势。

但许多工程师坦言:

“在这里,我的代码每天被成千上万人使用,这比股票期权更让我自豪。”

九、未来展望:不止于模型,而要构建“AI 操作系统”

CEO Clément Delangue 在 2024 年表示:

“我们正在构建 AI 时代的操作系统——一个让模型、数据、应用、用户无缝协作的平台。”

未来方向包括:

- Agent Hub:托管可自主行动的 AI 智能体;

- Unified Evaluation:标准化模型评测,终结“刷榜”乱象;

- Decentralized Identity:让用户拥有模型使用权与数据主权;

- AI for Science:聚焦气候、生物、材料等科研领域。

更重要的是,Hugging Face 正推动 “开源 AI 联盟”(Open Source AI Alliance),联合 Mistral、EleutherAI 等组织,制定治理标准,对抗行业封闭化趋势。

十、给普通人的实操指南:10 分钟上手 Hugging Face

10.1 第一步:注册账号

访问 https://huggingface.co

点击 “Sign Up”,支持邮箱、GitHub、Google 登录

10.2 第二步:安装工具库

pip install transformers datasets torch

10.3 第三步:首次调用模型(情感分析)

from transformers import pipeline

classifier = pipeline("sentiment-analysis",

model="distilbert-base-uncased-finetuned-sst-2-english")

result = classifier("I love Hugging Face! It's so easy to use.")

print(result)

# 输出:[{'label': 'POSITIVE', 'score': 0.9998}]

第一次运行会自动下载模型,稍等几分钟即可。

10.4 第四步:探索更多

- 修改输入文本,测试不同情绪;

- 去 Model Hub 找翻译、摘要、图像生成模型;

- 去 Spaces 体验各种 AI 应用 demo。

十一、优质学习资源包(收藏备用)

- 官方文档:https://huggingface.co/docs

- 免费课程:https://huggingface.co/learn(含中文)

- 社区论坛:Discord 社区(全球开发者实时交流)

- 国内资源:B站、知乎搜索“Hugging Face 新手教程”

- 实战项目:GitHub 上大量开源项目可参考学习

十二、中国用户的特别指南:Hugging Face 在国内的高效使用方案

虽然 Hugging Face 是全球开源 AI 的核心枢纽,但受限于网络环境,国内开发者常面临“看得见、用不着”的窘境。别担心——社区和国内技术团队早已探索出多种稳定、合法、高效的替代路径。以下方案按使用场景分类,新手到高阶开发者都能找到适合自己的方式。

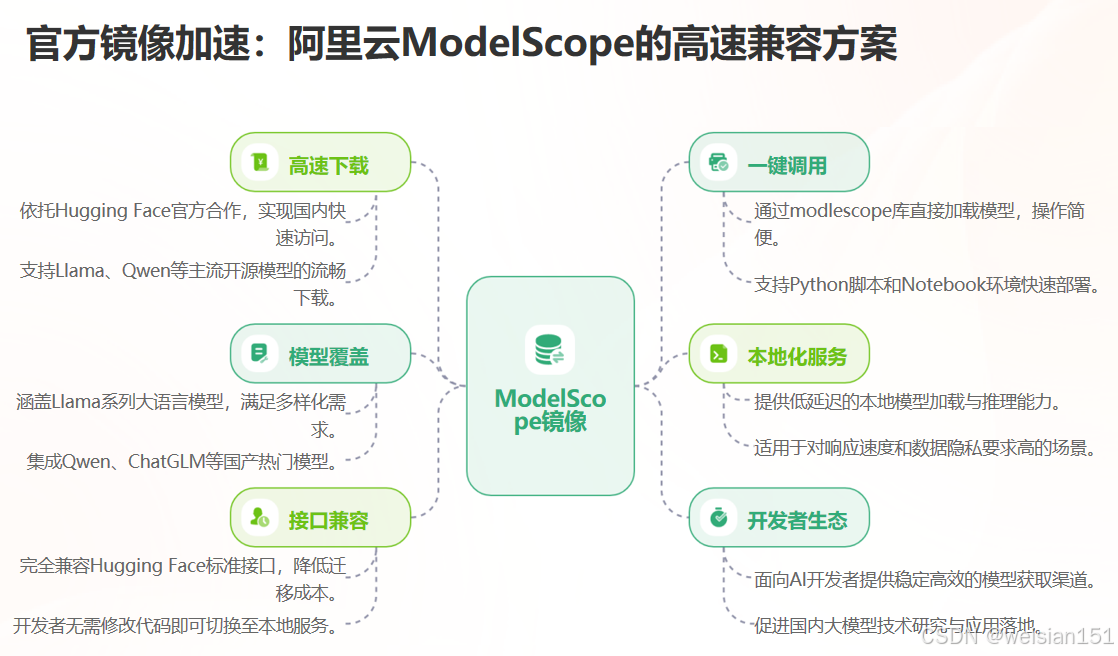

12.1 方案一:使用官方支持的镜像与加速服务(推荐优先尝试)

✅ Hugging Face 官方中国镜像(由阿里云 & ModelScope 联合支持)

2024 年起,Hugging Face 与阿里云达成战略合作,部分热门模型和数据集已同步至阿里云旗下的 ModelScope(魔搭)平台,并提供高速下载通道。

- 入口地址:https://modelscope.cn

- 覆盖内容:

- Llama 系列、Qwen、ChatGLM、Baichuan 等主流开源模型;

- Hugging Face 上高热度的英文/中文模型(如 BERT、Stable Diffusion、Whisper);

- 部分 Datasets 数据集(如 CLUE、THUCNews)。

- 优势:

- 国内 CDN 加速,下载速度可达 50MB/s+;

- 支持 pip 直接安装

modelscope库调用; - 与 Hugging Face API 高度兼容(部分模型可无缝切换)。

示例:用 ModelScope 替代 Hugging Face 调用 BERT

# 原 Hugging Face 方式(可能慢或失败) from transformers import AutoModel model = AutoModel.from_pretrained("bert-base-chinese") # 改用 ModelScope(国内高速) from modelscope.models.nlp import BertForSequenceClassification model = BertForSequenceClassification.from_pretrained('damo/nlp_bert_text-classification_chinese')💡 提示:在 ModelScope 搜索时,可输入 “Hugging Face 同款” 或原模型 ID(如 “bert-base-chinese”),系统会自动匹配对应镜像。

12.2 方案二:配置本地代理或缓存加速(适合有技术基础的用户)

如果你仍希望直接使用 Hugging Face 原站资源(如最新 Spaces 或未同步的冷门模型),可通过以下方式优化体验:

🔧 方法 1:设置 HF_ENDPOINT 环境变量(绕过主站 DNS)

Hugging Face 提供了备用 API 端点,国内部分区域可直连:

# Linux / macOS

export HF_ENDPOINT=https://hf-mirror.com

# Windows (PowerShell)

$env:HF_ENDPOINT="https://hf-mirror.com"

hf-mirror.com是由社区维护的非官方镜像站(非 Hugging Face 官方运营,但长期稳定),支持模型/数据集下载,不支持 Spaces 和登录功能。

🔧 方法 2:使用 huggingface-hub 的离线缓存机制

首次下载模型后,Hugging Face 会自动缓存到本地(默认路径:~/.cache/huggingface/hub)。你可以:

- 将缓存模型打包分享给团队;

- 在无网环境下复用已下载模型。

# 强制从本地加载(不联网)

model = AutoModel.from_pretrained("./local_model_path", local_files_only=True)

🔧 方法 3:搭配国内云服务器中转(企业级方案)

对于需要频繁拉取模型的企业用户,可:

- 在阿里云/腾讯云部署一台海外带宽充足的轻量应用服务器;

- 通过该服务器下载模型后,同步至私有 OSS/NAS;

- 内部开发机从私有存储加载模型。

此方案兼顾合规性与效率,适合金融、医疗等对数据安全要求高的场景。

12.3 方案三:国产平台作为 Hugging Face 的“功能替代品”

如果仅需完成特定任务(如文本生成、图像生成),以下国产平台提供了类似 Hugging Face Spaces 的零代码体验,且完全适配中文环境:

| 平台 | 特点 | 适用场景 |

|---|---|---|

| ModelScope(魔搭) | 阿里出品,集成千余模型,支持在线 Notebook 和 Web Demo | 科研、教学、企业 PoC |

| OpenXLab(上海人工智能实验室) | 聚焦大模型,提供 LLM 推理、微调、评测一站式服务 | 大模型开发者 |

| Baidu PaddleNLP / PaddleHub | 百度飞桨生态,中文 NLP 模型丰富,文档全中文 | 中文文本处理 |

| 智谱 AI 开放平台 | 提供 GLM 系列模型 API + 微调工具 | 商业应用快速落地 |

优势对比:

- 全中文界面,无语言障碍;

- 模型针对中文优化,效果更佳;

- 无需翻墙,访问稳定;

- 部分平台提供免费算力(如 ModelScope 的 NoteBook 实例)。

12.4 方案四:开发者协作技巧——如何在国内团队共享 Hugging Face 资源?

很多团队遇到“一人能下,全组卡顿”的问题。推荐以下协作模式:

📦 建立内部模型仓库(低成本版)

- 指定一名成员负责从 Hugging Face 下载模型;

- 将

~/.cache/huggingface/hub目录打包上传至公司内网 Git 或 NAS; - 其他成员通过

snapshot_download指向本地路径:

from huggingface_hub import snapshot_download

snapshot_download(

repo_id="meta-llama/Llama-3-8b",

local_dir="./models/llama3",

local_dir_use_symlinks=False

)

☁️ 使用 Hugging Face Private Hub + 国内代理(企业版)

若公司已订阅 Hugging Face Enterprise:

- 配置 Private Hub 为私有模型中心;

- 通过阿里云/腾讯云 VPC 内网代理访问;

- 结合 DLP(数据防泄漏)策略保障安全。

12.5 注意事项与合规提醒

-

版权与许可证:

即使通过镜像下载,也需遵守原模型的开源协议(如 Llama 系列禁止商用)。请务必查看 Model Card 中的license字段。 -

敏感模型访问限制:

部分涉及生成、语音克隆的模型在 hf-mirror.com 或 ModelScope 中可能被过滤,需通过正规渠道申请。 -

不要使用非法代理或破解工具:

建议优先选择官方合作渠道(如 ModelScope),避免法律与安全风险。

十三、结语:在围墙花园时代,守护一片公共绿地

今天的世界,AI 正变得越来越“封闭”:

- OpenAI 限制 GPT-4 输出;

- Google Gemini 拒绝开源;

- 亚马逊、苹果将 AI 锁进自家生态。

而在这样的背景下,Hugging Face 像一座开放的公共图书馆——

任何人都可以进来阅读、抄写、甚至添一本自己的书。

它不承诺最强大的模型,但承诺最自由的探索。

这让我想起理查德·斯托曼的话:

“软件自由关乎用户控制软件的权利,而非价格。”

Hugging Face 正在将这一精神延伸至 AI 时代。

也许未来的某一天,当人们回望这场 AI 革命,会发现真正改变世界的,

不是某个千亿参数的模型,

而是那个让千万人第一次亲手运行 AI 的开源平台。

因为技术终会迭代,

但共享、协作、透明的精神,

才是推动人类向前的永恒引擎。

延伸探索

- 官网:https://huggingface.co

- 免费课程:https://huggingface.co/learn

- Spaces 画廊:https://huggingface.co/spaces

作者后记

上周,我在 Hugging Face 上找到一个由肯尼亚学生训练的斯瓦希里语问答模型。

它并不完美,准确率只有 72%,

但评论区里满是本地教师的感谢:

“终于有工具能帮孩子用母语学习了。”

那一刻我忽然明白:

真正的技术普惠,不是让精英做得更好,而是让边缘者也能发声。

Hugging Face,正在让这件事发生。

国内资源速查表

- 魔搭 ModelScope:https://modelscope.cn

- OpenXLab:https://openxlab.org.cn

- 飞桨 PaddleHub:https://www.paddlepaddle.org.cn/hub

- 社区镜像 hf-mirror:https://hf-mirror.com(非官方,谨慎用于生产)

希望这份“中国特供版”指南,能帮你彻底打通 Hugging Face 的使用瓶颈!

更多推荐

已为社区贡献36条内容

已为社区贡献36条内容

所有评论(0)