大模型训练新突破:从底层开始优化,让你的模型推理能力提升3.43%!

本文介绍了一种名为"自底向上策略优化"(BuPO)的大模型新训练方法。研究发现Transformer的每一层都可视为独立的"内部策略",不同模型展现不同推理演化模式。BuPO先优化底层内部策略,再优化整体策略,在复杂推理任务上比标准GRPO提升3.43%,尤其在数学竞赛数据集上表现优异。这揭示了模型内部"潜意识"训练对提升整体推理能力的关键作用。

简介

本文介绍了一种名为"自底向上策略优化"(BuPO)的大模型新训练方法。研究发现Transformer的每一层都可视为独立的"内部策略",不同模型展现不同推理演化模式。BuPO先优化底层内部策略,再优化整体策略,在复杂推理任务上比标准GRPO提升3.43%,尤其在数学竞赛数据集上表现优异。这揭示了模型内部"潜意识"训练对提升整体推理能力的关键作用。

❝

一句话概括,别再只盯着 LLM 的最终输出做 RL 了,这篇论文告诉你模型每一层都在“偷偷做决策”,只要先把底层的“潜意识”训练好,整体推理能力直接起飞!(原论文题目见文末,点击阅读原文可直接跳转至原文链接, Published on arXiv on 22 Dec 2025, by Institute of Automation, Chinese Academy of Sciences)

第一阶段:识别核心概念

论文的 Motivation 分析

目前的强化学习方法(如 PPO, GRPO)通常把大语言模型(LLM)看作一个单一的黑盒策略。不管模型有多少层,我们只关注最后一层输出的 token 分布。但是,Transformer 结构是层层递进的。这种“一刀切”的视角忽略了模型内部的演化机制。如果能搞清楚策略是如何在每一层中逐渐形成的,就能进行更精细化的优化。这就像教学生解题,不能只看最后答案对不对,更要纠正他中间步骤的思路。

论文主要贡献点分析

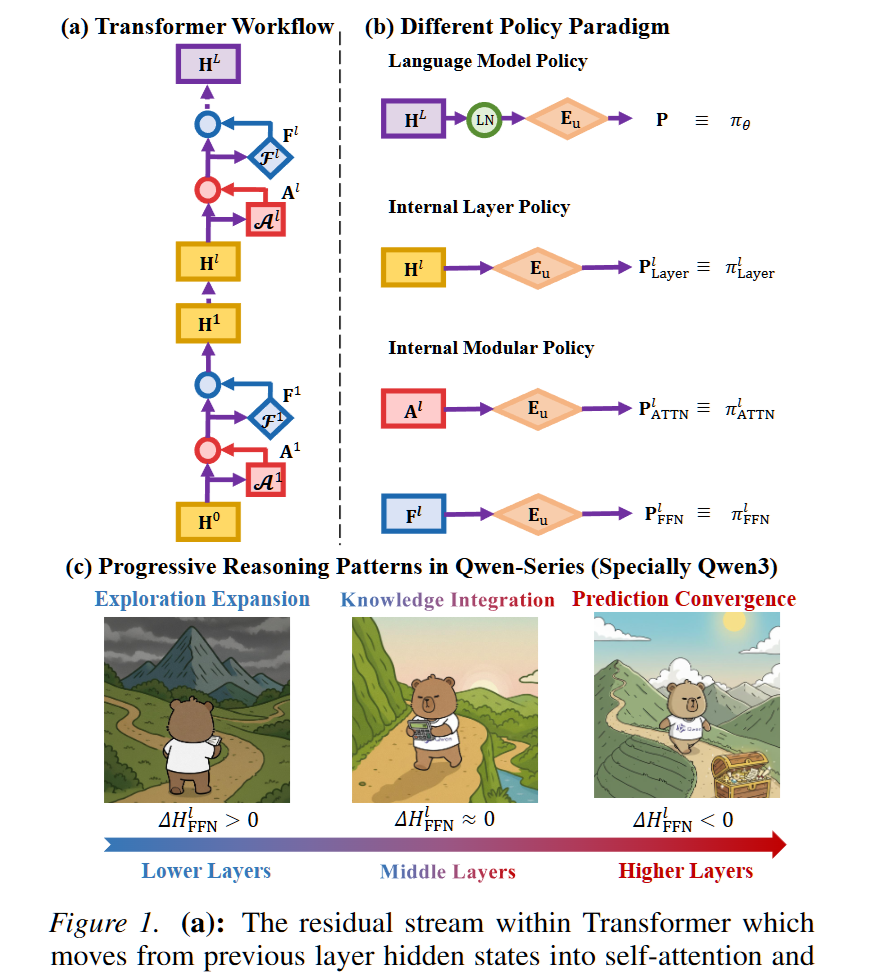

- 提出了“内部策略(Internal Policy)”的概念:作者通过数学推导和实验证明,Transformer 的每一层隐藏状态(Hidden State)其实都可以被视为一个独立的、可采样的策略。模型不只有一个“大脑”,而是由几十个层级递进的“子大脑”组成的。

- 发现了“逐层推理演化”的规律:作者发现了一个有趣的现象:Qwen 系列模型(特别是 Qwen3)展现出了非常类似人类的渐进式推理模式——底层进行发散探索(高熵),中层进行知识整合,高层进行收敛决策(低熵)。而 Llama 模型则倾向于在最后几层突然收敛。

- **提出了 Bottom-up Policy Optimization (BuPO)**:基于上述发现,作者提出了一种新的训练范式。在训练早期,先直接优化底层的“内部策略”,打好地基,再优化整体策略。这种方法在复杂推理任务上显著超越了标准的 GRPO。

理解难点识别

- 最具挑战性的概念:内部策略(Internal Policy)的物理意义。为什么中间层的向量(一堆数字)可以被看作是一个能说话的“策略”?这涉及到对 Transformer 残差流(Residual Stream)和解嵌入(Unembedding)矩阵本质的理解。

- 需要重点解释的核心:如何利用 Unembedding Matrix 将 Hidden State 转化为概率分布,以及这个分布的“熵”代表了什么。

概念依赖关系

要理解 BuPO,必须遵循以下逻辑链条:

- 残差流机制 -> 允许我们将每一层的输出视为对最终结果的“增量贡献”。

- 解嵌入映射 -> 允许我们将任意层的隐藏状态映射回词表空间,形成“内部策略”。

- 内部策略熵 -> 衡量每一层是在“犹豫探索”还是在“坚定决策”。

- BuPO 算法 -> 基于熵的变化规律,决定去优化哪一层。

第二阶段:深入解释核心概念

比喻:接力写书的编辑部

想象一个拥有 30 层楼的大型出版社编辑部,他们的任务是回答读者的提问(Prompt)。

- 1楼的实习生(底层):拿到读者的问题,脑洞大开,想到了无数种可能的回答方向,想法非常发散。

- 15楼的资深编辑(中层):接过底层的草稿,删掉不靠谱的想法,结合自己的专业知识,开始确定具体的写作逻辑。

- 30楼的主编(顶层/输出层):看着已经很成熟的稿子,做最后的润色,拍板决定最终要印在纸上的每一个字。

- 翻译官(Unembedding Matrix):每一层楼都配有一个神奇的翻译官,他能瞬间把该层编辑脑子里的抽象想法(向量),翻译成人类能听懂的候选词列表(概率分布)。

建立比喻与技术的对应关系

- 每一层的编辑:对应模型的 Transformer 层(Layer)。

- 编辑手里的草稿:对应隐藏状态(Hidden State, )。它是前面所有层累加的结果。

- 神奇的翻译官:对应解嵌入矩阵(Unembedding Matrix, )。它负责把隐藏状态映射到词汇表大小的向量上。

- 翻译官念出的候选词列表:对应内部策略(Internal Policy, )。即如果我们强行让第 层直接输出结果,它会说什么。

- 编辑的犹豫程度:对应熵(Entropy)。如果翻译官给出的列表中,每个词的概率都差不多,说明这层编辑很犹豫(高熵);如果某个词概率接近 100%,说明编辑很确定(低熵)。

深入技术细节

公式 1:残差流的累加性

在 Transformer 中,第 层的输出不仅仅是这一层的计算结果,而是包含了之前所有层的信息。

符号替换版:第 层最终的草稿内容 = 初始的输入内容 + 前面所有层注意力机制(Attention)的修改意见 + 前面所有层前馈网络(FFN)的修改意见。

公式 2:内部策略的定义

作者认为,任何一层的草稿 ,都可以直接交给“翻译官” 来生成一个概率分布。

符号替换版:第 层的内部策略 = 将第 层的隐藏状态与解嵌入矩阵相乘,然后进行 Softmax 归一化。 这步操作让原本深埋在模型内部的 变成了一个可以直接采样的分布 。这就是为什么说你的模型“秘密地包含了内部策略”。

公式 3:内部熵的变化

作者通过测量这个策略的熵来观察模型的思考过程。

符号替换版:熵的变化量 = 输出时的犹豫程度 - 输入时的犹豫程度。 如果 ,说明这一层在“发散思维”(探索);如果 ,说明这一层在“收敛思路”(确定答案)。

技术与比喻的映射总结

- Llama 的行为:就像 1 楼到 25 楼的编辑都在疯狂发散,直到最后几层主编突然拍板说“就这么定了”。这叫“突然收敛”。

- Qwen3 的行为:就像一个成熟的团队。1-5 楼发散想法(探索),6-20 楼利用知识库整合信息(整合),21-30 楼逐步剔除错误选项(收敛)。这是一种更类似人类思维的渐进式推理。

- BuPO 的核心思想:既然 Qwen3 这种渐进式结构更好,那我们在训练时,不要只盯着 30 楼的主编(最终输出)骂。我们应该专门跑到 6 楼或者 10 楼(中低层),直接告诉那里的编辑:“你们现在的草稿方向是对的,继续保持!”。这就是“自底向上的策略优化”。

第三阶段:详细说明流程步骤

整个流程分为两个阶段:阶段一(打地基)和阶段二(整体装修)。这是一个在训练循环中动态切换的过程。

1. 准备工作

- 输入:一个包含问题的数据集 (例如数学题)。

- 设定目标层:根据之前的熵分析,找到模型中负责“知识整合”的关键层(通常是熵开始下降前的那个层),记为层 。

- 设定阈值:设定一个步数阈值 ,在这个步数之前我们只训练内部策略。

2. 采样与数据收集

对于每一个训练步(Step):

- 接收输入:模型接收一个问题 。

- 生成回答:使用旧的策略 生成一组回答(Rollout),例如生成 8 个不同的解题过程。

- 计算奖励:检查这些回答是否正确,计算奖励值(Reward)和优势值(Advantage)。

3. 阶段性判断与优化

系统检查当前的训练步数 :

情形 A:如果在早期阶段 ()

执行 内部策略优化(Phase 1: Internal Policy Optimization)。

- 提取中间状态:我们将回答输入模型,但在前向传播到第 层时,截取其隐藏状态 。

- 构建内部策略:使用公式 计算该层对下一个 token 的预测概率。

- 计算重要性采样比率:解读:修正系数 = 当前优化中的第 层策略生成该 token 的概率 / 采样时旧的第 层策略生成该 token 的概率。

- 计算损失并更新:使用 GRPO 的目标函数,但只利用第 层的预测概率来计算损失。

- 梯度回传:关键点来了! 梯度只会回传到第 0 层到第 层以及解嵌入矩阵 。第 层之上的所有层( 到 )都不会被更新。

- 意图:这就像只针对性地培训 1-10 楼的编辑,让高层领导先歇着。这能强迫底层学会更高阶的推理能力。

情形 B:如果在后期阶段 ()

执行 语言模型整体优化(Phase 2: Language Model Policy Optimization)。

- 使用最终输出:使用模型最后一层 的输出概率 。

- 计算标准 GRPO 损失:计算基于最后一层的损失函数。

- 全局更新:梯度回传更新整个模型的所有参数。

通过这种“先局部、后整体”的训练方式,BuPO 成功地让模型在早期就建立起了稳固的推理特征。

第四阶段:实验设计与验证分析

主实验设计

- 核心主张:通过直接优化底层内部策略,可以重构模型的基础推理能力,从而提升整体性能。

- 数据集:选择了 MATH500, AMC23, AIME24, AIME25。这些都是极具挑战性的数学竞赛数据集,对推理能力要求极高。如果只能做简单的加减法,不需要复杂的内部策略演化,只有这种难题才能体现“推理链条”的重要性。

- 基线方法:对比了 PPO, Reinforce++, RLOO 以及目前最强的 GRPO。GRPO 是 DeepSeek-R1 背后的核心算法,代表了当前的 SOTA。

- 实验结果:

- 在 Qwen3-4B 模型上,BuPO 在 AIME24 上比 GRPO 提升了 **4.69%**,平均提升 **3.43%**。

- 结论:BuPO 在保持训练效率的同时,显著提升了模型处理复杂推理任务的能力。

消融实验分析

作者通过消融实验回答了两个关键问题:

- 应该优化哪一层?(Fix )

- 作者尝试了优化第 6 层、第 26 层和第 35 层。

- 结果:优化第 6 层(底层/探索层)效果最好,优化接近输出的第 35 层效果最差。

- 证明:这证实了“自底向上”的假设——过早地约束高层会限制模型的潜力,而优化底层能提供更好的特征基础。

- 应该优化多久?(Fix )

- 作者尝试了只优化前 30 步、50 步、70 步。

- 结果:优化 30 步效果最好,如果一直只优化内部层(比如 70 步),模型性能会崩溃(Collapse)。

- 证明:内部策略优化只能作为“热身”或“引导”,最终还是需要将高层逻辑与底层特征对齐。适度(Moderate)是关键。

深度/创新性实验剖析

- 内部熵动力学(Internal Entropy Dynamics)可视化:

- 设计:作者画出了不同模型(Llama vs Qwen)每一层的熵变化曲线。

- 发现:Qwen 系列展现出了清晰的“探索-整合-收敛”三段式结构,而 Llama 则是平平无奇的直到最后才收敛。

- 洞见:这揭示了为什么 Qwen 在推理任务上可能更有潜力——它的内部结构更像人类的思维过程。这也指导了 BuPO 应该选择哪一层进行优化(选那个“整合”开始的层)。

- 优化后的特征相似度分析:

- 设计:作者计算了优化后的第 6 层隐藏状态 与最终层隐藏状态 的余弦相似度。

- 结果:随着 BuPO 的进行,底层 与顶层 的相似度在增加。

- 结论:Feature Refinement(特征提炼)。BuPO 强迫底层提前学到了高层才有的推理特征。这就像让实习生提前学会了主编的思维方式,大大减轻了后续推理的负担。

如何学习AI大模型?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

想正式转到一些新兴的 AI 行业,不仅需要系统的学习AI大模型。同时也要跟已有的技能结合,辅助编程提效,或上手实操应用,增加自己的职场竞争力。

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高

那么针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

学习路线

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献175条内容

已为社区贡献175条内容

所有评论(0)