零门槛部署DeepSeek-R1:两种方法让大模型在本地跑起来

摘要: DeepSeek-R1大模型支持本地部署,提供两种方案: 自动部署(新手友好):使用DS本地化部署大师,三步完成模型下载、环境配置和参数优化,无需命令行操作,适合快速体验。 手动部署(开发者推荐):通过Ollama命令行工具灵活安装,支持模型版本选择,可搭配LMStudio或ChatboxAI增强可视化交互。

想要在自己的电脑上运行DeepSeek-R1大模型?现在有两种主流方式供你选择:适合小白的全自动一键部署,以及适合开发者的手动灵活部署。无论你的技术背景如何,都能找到最适合自己的方案。

方案一:自动部署(新手首选,5分钟搞定)

如果你希望用最简单的方式快速体验本地AI,DS本地化部署大师是你的最佳选择。

https://url20.ctfile.com/f/65806720-8577999149-78b361?p=6521

三步完成部署

第一步:下载安装

访问官方渠道获取DS本地化部署大师安装包,双击运行安装程序,按照向导提示完成安装。

https://url20.ctfile.com/f/65806720-8577999149-78b361?p=6521

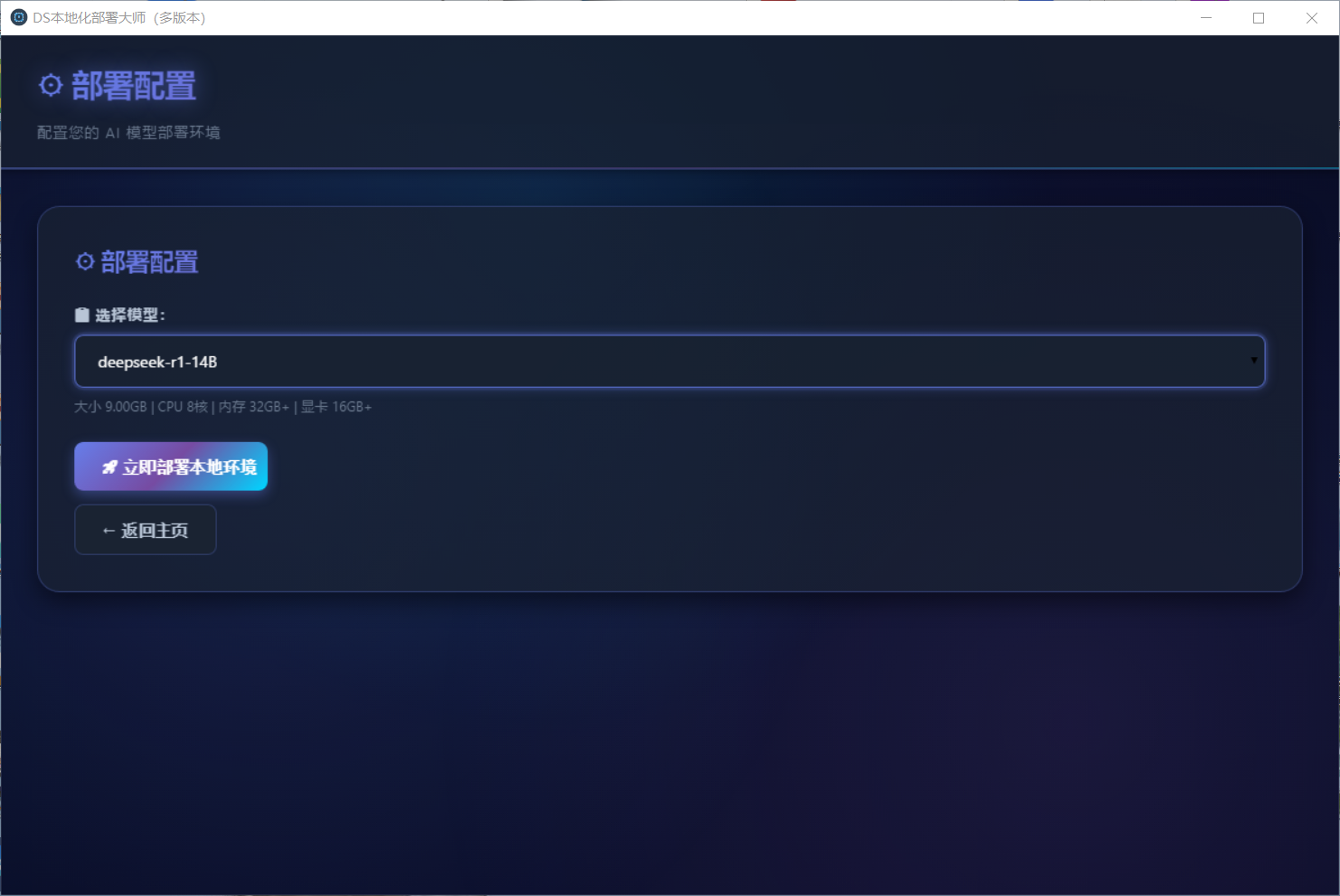

第二步:选择模型

打开软件后,界面会清晰展示DeepSeek-R1全系列模型选项(从1.5B到671B)。根据你的硬件配置和需求选择合适版本,软件会提供智能推荐。

-

模型文件下载

-

运行环境配置

-

依赖项安装

-

参数优化设置

部署完成后,直接进入对话界面开始使用,无需任何额外配置。

核心优势

-

自动处理所有技术细节和兼容性问题

-

支持多模型管理和快速切换

-

提供本地模式

方案二:手动部署(开发者推荐)

如果你需要更多控制权或希望集成到开发流程中,Ollama方案提供了灵活的手动部署选项。

详细部署步骤

1. 安装Ollama

访问Ollama官网(https://ollama.com/)下载对应系统版本:

-

Windows:运行.exe安装程序

-

macOS:拖拽.dmg到应用程序文件夹

-

Linux:执行官网提供的安装命令

2. 验证安装

安装完成后,打开浏览器访问 http://localhost:11434/,看到“Ollama is running”即表示安装成功。

3. 下载模型

在终端或命令提示符中输入:

bash

# 下载7B基础版本

ollama run deepseek-r1

# 或指定具体版本

ollama run deepseek-r1:32b4. 运行与交互

下载完成后,继续在终端中输入:

bash

ollama run deepseek-r1即可进入命令行对话模式。

可视化界面增强(可选)

如果你喜欢图形化界面但需要手动控制,可以考虑:

LM Studio(https://lmstudio.ai/):

-

搜索下载DeepSeek-R1量化版本

-

可视化调整温度、top-p等参数

-

提供模型管理和对话历史功能

Chatbox AI(https://chatboxai.app/zh):

-

连接本地Ollama服务(localhost:11434)

-

美观的聊天界面

-

支持对话导出和分享

硬件配置建议

最低要求(运行7B模型)

-

GPU:NVIDIA GTX 1080(8GB显存)

-

CPU:4核以上处理器

-

内存:16GB RAM

-

存储:20GB可用SSD空间

推荐配置(获得更好体验)

-

GPU:RTX 3060 12GB或更高

-

CPU:8核以上处理器

-

内存:32GB RAM

-

存储:NVMe SSD,50GB以上可用空间

高级配置(运行70B及以上模型)

-

GPU:RTX 4090 24GB或多卡配置

-

内存:64GB以上

-

存储:高速SSD,100GB以上空间

选择建议

选择自动部署如果:

-

你是AI入门用户

-

希望快速开始使用

-

不想处理技术细节

-

需要图形化操作界面

选择手动部署如果:

-

你是开发者或技术爱好者

-

需要深度定制和集成

-

习惯命令行操作

-

希望更灵活控制模型参数

开始你的本地AI之旅

无论选择哪种方案,本地部署DeepSeek-R1都能为你带来数据安全、响应快速、完全可控的AI体验。自动部署方案让技术门槛降至最低,手动部署则为技术用户提供了充分的灵活空间。

立即尝试,在你的电脑上建立专属的AI助手,享受完全私密、24小时可用的智能服务。

https://url20.ctfile.com/f/65806720-8577999149-78b361?p=6521

小贴士:首次部署建议从较小的模型(如7B版本)开始,确认运行正常后再根据需要升级到更大模型。记得确保有足够的存储空间,因为模型文件体积可能达到数十GB。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)