构建AI Agent驱动的智能翻译系统

本文旨在为读者提供构建AI Agent驱动的智能翻译系统的全面指南。现代机器翻译的核心技术原理AI Agent在翻译系统中的架构设计深度学习模型在翻译任务中的应用多语言和多模态翻译的实现方法系统性能优化和评估指标首先介绍背景知识和核心概念深入解析关键技术原理和算法提供完整的数学建模和分析通过实际案例展示实现细节讨论应用场景和工具资源总结未来发展趋势和挑战AI Agent:具有自主决策能力的智能体,

构建AI Agent驱动的智能翻译系统

关键词:AI Agent、智能翻译、神经网络、自然语言处理、机器翻译、Transformer、多模态学习

摘要:本文深入探讨了如何构建基于AI Agent的智能翻译系统。我们将从核心概念出发,详细解析现代机器翻译的技术原理,包括神经网络架构、注意力机制和多模态学习等关键技术。文章将提供完整的算法实现、数学模型分析,并通过实际项目案例展示如何构建一个端到端的智能翻译系统。最后,我们将讨论该领域的最新进展、面临的挑战以及未来发展方向。

1. 背景介绍

1.1 目的和范围

本文旨在为读者提供构建AI Agent驱动的智能翻译系统的全面指南。我们将涵盖从基础理论到实际实现的完整知识体系,重点包括:

- 现代机器翻译的核心技术原理

- AI Agent在翻译系统中的架构设计

- 深度学习模型在翻译任务中的应用

- 多语言和多模态翻译的实现方法

- 系统性能优化和评估指标

1.2 预期读者

本文适合以下读者群体:

- 自然语言处理(NLP)研究人员和工程师

- 机器学习/深度学习实践者

- 软件架构师和系统设计师

- 对AI和机器翻译感兴趣的技术决策者

- 计算机科学相关专业的高年级学生和研究生

1.3 文档结构概述

本文采用循序渐进的结构组织内容:

- 首先介绍背景知识和核心概念

- 深入解析关键技术原理和算法

- 提供完整的数学建模和分析

- 通过实际案例展示实现细节

- 讨论应用场景和工具资源

- 总结未来发展趋势和挑战

1.4 术语表

1.4.1 核心术语定义

- AI Agent:具有自主决策能力的智能体,能够感知环境、做出决策并执行动作

- 神经机器翻译(NMT):使用神经网络进行端到端学习的机器翻译方法

- 注意力机制:神经网络中动态分配权重以关注输入相关部分的技术

- Transformer:基于自注意力机制的神经网络架构,已成为NLP领域的主流模型

- 多模态学习:同时处理和理解多种数据模态(如文本、语音、图像)的学习方法

1.4.2 相关概念解释

- 编码器-解码器架构:将输入序列编码为固定长度向量,再解码为目标序列的框架

- 迁移学习:将在一种任务上学到的知识应用到相关任务上的技术

- 零样本翻译:在没有直接训练数据的情况下进行语言对翻译的能力

- 领域适应:使模型适应特定领域(如医疗、法律)的技术

1.4.3 缩略词列表

| 缩略词 | 全称 |

|---|---|

| NMT | Neural Machine Translation |

| NLP | Natural Language Processing |

| BLEU | Bilingual Evaluation Understudy |

| RNN | Recurrent Neural Network |

| LSTM | Long Short-Term Memory |

| BPE | Byte Pair Encoding |

| WMT | Workshop on Machine Translation |

2. 核心概念与联系

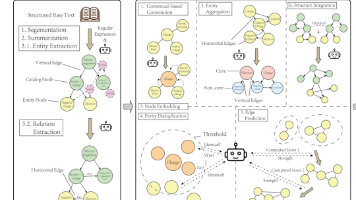

现代AI Agent驱动的智能翻译系统建立在多个关键技术之上,这些技术相互关联形成了完整的解决方案。下图展示了系统的核心架构:

2.1 系统组件详解

-

预处理模块:

- 文本规范化

- 分词/子词处理

- 语言检测

- 特殊标记处理

-

AI Agent决策引擎:

- 上下文理解

- 翻译策略选择

- 质量评估

- 自适应学习

-

神经翻译模型:

- Transformer架构

- 多头注意力机制

- 位置编码

- 深度前馈网络

-

后处理模块:

- 去标记化

- 大小写恢复

- 格式保持

- 流畅性优化

-

知识库:

- 术语表

- 领域知识

- 文化规范

- 用户偏好

2.2 工作流程

- 输入文本经过预处理后,AI Agent分析文本特征和上下文

- Agent根据分析结果选择合适的翻译策略和模型参数

- 神经翻译模型在Agent指导下执行翻译任务

- 输出经过后处理优化,确保质量和一致性

- 系统从用户反馈中学习,持续优化模型和决策逻辑

3. 核心算法原理 & 具体操作步骤

3.1 Transformer架构基础

Transformer是当前最先进的神经机器翻译模型的核心架构。以下是其Python实现的关键部分:

import torch

import torch.nn as nn

import math

class MultiHeadAttention(nn.Module):

def __init__(self, d_model, num_heads):

super().__init__()

self.d_model = d_model

self.num_heads = num_heads

self.head_dim = d_model // num_heads

self.wq = nn.Linear(d_model, d_model)

self.wk = nn.Linear(d_model, d_model)

self.wv = nn.Linear(d_model, d_model)

self.wo = nn.Linear(d_model, d_model)

def forward(self, q, k, v, mask=None):

batch_size = q.size(0)

# 线性投影

q = self.wq(q) # (batch, seq_len, d_model)

k = self.wk(k) # (batch, seq_len, d_model)

v = self.wv(v) # (batch, seq_len, d_model)

# 分割多头

q = q.view(batch_size, -1, self.num_heads, self.head_dim).transpose(1,2)

k = k.view(batch_size, -1, self.num_heads, self.head_dim).transpose(1,2)

v = v.view(batch_size, -1, self.num_heads, self.head_dim).transpose(1,2)

# 计算注意力分数

scores = torch.matmul(q, k.transpose(-2,-1)) / math.sqrt(self.head_dim)

if mask is not None:

scores = scores.masked_fill(mask == 0, -1e9)

# 注意力权重

attention = torch.softmax(scores, dim=-1)

# 上下文向量

context = torch.matmul(attention, v)

# 合并多头

context = context.transpose(1,2).contiguous().view(

batch_size, -1, self.d_model)

return self.wo(context)

3.2 完整翻译模型实现步骤

-

数据准备:

- 收集平行语料库

- 数据清洗和预处理

- 应用BPE(Byte Pair Encoding)进行子词分割

-

模型构建:

- 实现编码器和解码器堆栈

- 添加位置编码

- 集成多头注意力机制

- 设计前馈网络

-

训练流程:

- 初始化模型参数

- 定义损失函数(交叉熵)

- 设置优化器(Adam)

- 实现学习率调度

- 添加正则化技术

-

推理过程:

- 实现beam search解码

- 添加长度惩罚

- 集成缓存机制优化性能

3.3 关键算法优化

- 相对位置编码:

传统Transformer使用绝对位置编码,改进版使用相对位置编码能更好处理长序列:

class RelativePositionBias(nn.Module):

def __init__(self, num_heads, max_distance=128):

super().__init__()

self.num_heads = num_heads

self.max_distance = max_distance

self.relative_attention_bias = nn.Embedding(

2 * max_distance + 1, num_heads)

def forward(self, q_len, k_len):

# 生成位置索引矩阵

context_position = torch.arange(q_len)[:, None]

memory_position = torch.arange(k_len)[None, :]

relative_position = memory_position - context_position

# 截断到最大距离

relative_position = torch.clamp(

relative_position, -self.max_distance, self.max_distance)

# 转换为嵌入索引

bias_index = relative_position + self.max_distance

# 获取偏置值并调整形状

bias = self.relative_attention_bias(bias_index)

return bias.permute(2, 0, 1).unsqueeze(0) # (1, num_heads, q_len, k_len)

- 动态卷积注意力:

结合卷积的局部性和注意力的全局性:

class DynamicConvAttention(nn.Module):

def __init__(self, d_model, num_heads, kernel_size=3):

super().__init__()

self.d_model = d_model

self.num_heads = num_heads

self.head_dim = d_model // num_heads

self.kernel_size = kernel_size

# 卷积核生成网络

self.conv_kernel = nn.Sequential(

nn.Linear(d_model, num_heads * kernel_size),

nn.Softmax(dim=-1))

# 值投影

self.wv = nn.Linear(d_model, d_model)

self.wo = nn.Linear(d_model, d_model)

def forward(self, x):

batch_size, seq_len, _ = x.size()

# 生成动态卷积核

kernels = self.conv_kernel(x) # (batch, seq_len, num_heads*kernel_size)

kernels = kernels.view(batch_size, seq_len, self.num_heads, self.kernel_size)

kernels = kernels.permute(0, 2, 1, 3) # (batch, num_heads, seq_len, kernel_size)

# 值投影

v = self.wv(x)

v = v.view(batch_size, seq_len, self.num_heads, self.head_dim)

v = v.permute(0, 2, 1, 3) # (batch, num_heads, seq_len, head_dim)

# 填充序列边界

padding = self.kernel_size // 2

v_padded = torch.nn.functional.pad(

v, (0, 0, padding, padding), mode='constant', value=0)

# 应用动态卷积

output = []

for i in range(seq_len):

# 获取当前窗口

window = v_padded[:, :, i:i+self.kernel_size, :]

# 应用对应的卷积核

kernel = kernels[:, :, i, :].unsqueeze(-1) # (batch, num_heads, kernel_size, 1)

weighted = (window * kernel).sum(dim=2)

output.append(weighted)

output = torch.stack(output, dim=2) # (batch, num_heads, seq_len, head_dim)

# 合并多头

output = output.permute(0, 2, 1, 3).contiguous()

output = output.view(batch_size, seq_len, -1)

return self.wo(output)

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 注意力机制数学原理

注意力机制的核心是计算查询(Query)与键(Key)的相似度,然后根据相似度对值(Value)进行加权求和:

Attention(Q,K,V)=softmax(QKTdk)V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

其中:

- Q∈Rn×dkQ \in \mathbb{R}^{n \times d_k}Q∈Rn×dk 是查询矩阵

- K∈Rm×dkK \in \mathbb{R}^{m \times d_k}K∈Rm×dk 是键矩阵

- V∈Rm×dvV \in \mathbb{R}^{m \times d_v}V∈Rm×dv 是值矩阵

- dkd_kdk 是键的维度

- dk\sqrt{d_k}dk 是缩放因子,防止点积过大导致梯度消失

4.2 多头注意力扩展

多头注意力将查询、键和值分别投影到hhh个不同的子空间:

MultiHead(Q,K,V)=Concat(head1,...,headh)WO \text{MultiHead}(Q, K, V) = \text{Concat}(\text{head}_1, ..., \text{head}_h)W^O MultiHead(Q,K,V)=Concat(head1,...,headh)WO

其中每个注意力头计算为:

headi=Attention(QWiQ,KWiK,VWiV) \text{head}_i = \text{Attention}(QW_i^Q, KW_i^K, VW_i^V) headi=Attention(QWiQ,KWiK,VWiV)

参数矩阵维度:

- WiQ∈Rdmodel×dkW_i^Q \in \mathbb{R}^{d_{\text{model}} \times d_k}WiQ∈Rdmodel×dk

- WiK∈Rdmodel×dkW_i^K \in \mathbb{R}^{d_{\text{model}} \times d_k}WiK∈Rdmodel×dk

- WiV∈Rdmodel×dvW_i^V \in \mathbb{R}^{d_{\text{model}} \times d_v}WiV∈Rdmodel×dv

- WO∈Rhdv×dmodelW^O \in \mathbb{R}^{hd_v \times d_{\text{model}}}WO∈Rhdv×dmodel

4.3 位置编码公式

Transformer使用正弦和余弦函数生成位置编码:

PE(pos,2i)=sin(pos/100002i/dmodel)PE(pos,2i+1)=cos(pos/100002i/dmodel) PE_{(pos, 2i)} = \sin(pos/10000^{2i/d_{\text{model}}}) \\ PE_{(pos, 2i+1)} = \cos(pos/10000^{2i/d_{\text{model}}}) PE(pos,2i)=sin(pos/100002i/dmodel)PE(pos,2i+1)=cos(pos/100002i/dmodel)

其中:

- pospospos 是位置索引

- iii 是维度索引

- dmodeld_{\text{model}}dmodel 是模型维度

4.4 损失函数

翻译模型使用标签平滑的交叉熵损失:

L=−∑i=1T∑j=1V(1−ϵ)yijlogpij+ϵ∑i=1T∑j=1Vu(j)logpij \mathcal{L} = -\sum_{i=1}^T \sum_{j=1}^V (1-\epsilon)y_{ij}\log p_{ij} + \epsilon \sum_{i=1}^T \sum_{j=1}^V u(j)\log p_{ij} L=−i=1∑Tj=1∑V(1−ϵ)yijlogpij+ϵi=1∑Tj=1∑Vu(j)logpij

其中:

- TTT 是目标序列长度

- VVV 是词汇表大小

- yijy_{ij}yij 是真实标签

- pijp_{ij}pij 是预测概率

- ϵ\epsilonϵ 是平滑系数

- u(j)u(j)u(j) 是均匀分布

4.5 示例计算

假设我们有以下简化的输入:

- 查询向量: q=[1,0,1]q = [1, 0, 1]q=[1,0,1]

- 键向量: k=[0,1,1]k = [0, 1, 1]k=[0,1,1]

- 值向量: v=[2,4,6]v = [2, 4, 6]v=[2,4,6]

计算注意力分数:

-

点积相似度:

q⋅k=1×0+0×1+1×1=1 q \cdot k = 1 \times 0 + 0 \times 1 + 1 \times 1 = 1 q⋅k=1×0+0×1+1×1=1 -

缩放分数(假设dk=3d_k=3dk=3):

q⋅kdk=13≈0.577 \frac{q \cdot k}{\sqrt{d_k}} = \frac{1}{\sqrt{3}} \approx 0.577 dkq⋅k=31≈0.577 -

注意力权重(softmax):

softmax(0.577)=1 \text{softmax}(0.577) = 1 softmax(0.577)=1 (只有一个键值对) -

上下文向量:

Attention=1×v=[2,4,6] \text{Attention} = 1 \times v = [2, 4, 6] Attention=1×v=[2,4,6]

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

硬件要求

- GPU: NVIDIA Tesla V100或更高(16GB+显存)

- CPU: 8核以上

- 内存: 32GB以上

- 存储: 1TB SSD(用于存储训练数据和模型)

软件依赖

# 创建conda环境

conda create -n mt python=3.8

conda activate mt

# 安装PyTorch

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu116

# 安装其他依赖

pip install transformers sentencepiece sacremoses nltk sacrebleu

pip install tensorboardX wandb

# 安装apex(混合精度训练)

git clone https://github.com/NVIDIA/apex

cd apex

pip install -v --disable-pip-version-check --no-cache-dir --global-option="--cpp_ext" --global-option="--cuda_ext" ./

5.2 源代码详细实现

完整Transformer实现

import torch

import torch.nn as nn

import torch.nn.functional as F

import math

class Transformer(nn.Module):

def __init__(self, src_vocab_size, tgt_vocab_size, d_model=512, nhead=8,

num_encoder_layers=6, num_decoder_layers=6, dim_feedforward=2048,

dropout=0.1, max_seq_len=512):

super().__init__()

self.d_model = d_model

# 嵌入层

self.src_embed = nn.Embedding(src_vocab_size, d_model)

self.tgt_embed = nn.Embedding(tgt_vocab_size, d_model)

# 位置编码

self.position_encoding = PositionalEncoding(d_model, dropout, max_seq_len)

# Transformer

self.transformer = nn.Transformer(

d_model=d_model, nhead=nhead,

num_encoder_layers=num_encoder_layers,

num_decoder_layers=num_decoder_layers,

dim_feedforward=dim_feedforward,

dropout=dropout)

# 输出层

self.fc_out = nn.Linear(d_model, tgt_vocab_size)

def forward(self, src, tgt, src_mask=None, tgt_mask=None,

memory_mask=None, src_key_padding_mask=None,

tgt_key_padding_mask=None, memory_key_padding_mask=None):

# 嵌入和位置编码

src = self.position_encoding(self.src_embed(src) * math.sqrt(self.d_model))

tgt = self.position_encoding(self.tgt_embed(tgt) * math.sqrt(self.d_model))

# Transformer

output = self.transformer(

src, tgt, src_mask=src_mask, tgt_mask=tgt_mask,

memory_mask=memory_mask, src_key_padding_mask=src_key_padding_mask,

tgt_key_padding_mask=tgt_key_padding_mask,

memory_key_padding_mask=memory_key_padding_mask)

# 输出投影

return self.fc_out(output)

def encode(self, src, src_mask=None, src_key_padding_mask=None):

src = self.position_encoding(self.src_embed(src) * math.sqrt(self.d_model))

return self.transformer.encoder(src, mask=src_mask,

src_key_padding_mask=src_key_padding_mask)

def decode(self, tgt, memory, tgt_mask=None, memory_mask=None,

tgt_key_padding_mask=None, memory_key_padding_mask=None):

tgt = self.position_encoding(self.tgt_embed(tgt) * math.sqrt(self.d_model))

return self.transformer.decoder(tgt, memory, tgt_mask=tgt_mask,

memory_mask=memory_mask,

tgt_key_padding_mask=tgt_key_padding_mask,

memory_key_padding_mask=memory_key_padding_mask)

class PositionalEncoding(nn.Module):

def __init__(self, d_model, dropout=0.1, max_len=5000):

super().__init__()

self.dropout = nn.Dropout(p=dropout)

pe = torch.zeros(max_len, d_model)

position = torch.arange(0, max_len, dtype=torch.float).unsqueeze(1)

div_term = torch.exp(torch.arange(0, d_model, 2).float() * (-math.log(10000.0) / d_model))

pe[:, 0::2] = torch.sin(position * div_term)

pe[:, 1::2] = torch.cos(position * div_term)

pe = pe.unsqueeze(0)

self.register_buffer('pe', pe)

def forward(self, x):

x = x + self.pe[:, :x.size(1)]

return self.dropout(x)

训练循环实现

def train_epoch(model, optimizer, scheduler, train_loader, device, epoch, clip_grad=1.0):

model.train()

total_loss = 0

log_interval = 100

for batch_idx, (src, tgt) in enumerate(train_loader):

src, tgt = src.to(device), tgt.to(device)

# 准备输入和目标

tgt_input = tgt[:, :-1]

tgt_output = tgt[:, 1:]

# 创建掩码

src_mask, tgt_mask, src_padding_mask, tgt_padding_mask = create_mask(

src, tgt_input, model.src_pad_idx, model.tgt_pad_idx, device)

optimizer.zero_grad()

# 前向传播

output = model(src, tgt_input, src_mask, tgt_mask,

src_key_padding_mask=src_padding_mask,

tgt_key_padding_mask=tgt_padding_mask)

# 计算损失

loss = F.cross_entropy(output.reshape(-1, output.size(-1)),

tgt_output.reshape(-1),

ignore_index=model.tgt_pad_idx)

# 反向传播

loss.backward()

# 梯度裁剪

torch.nn.utils.clip_grad_norm_(model.parameters(), clip_grad)

# 参数更新

optimizer.step()

scheduler.step()

total_loss += loss.item()

if batch_idx % log_interval == 0 and batch_idx > 0:

avg_loss = total_loss / log_interval

print(f'Epoch: {epoch} | Batch: {batch_idx}/{len(train_loader)} | Loss: {avg_loss:.4f}')

total_loss = 0

def create_mask(src, tgt, src_pad_idx, tgt_pad_idx, device):

# 源序列填充掩码

src_mask = None

src_padding_mask = (src == src_pad_idx).to(device)

# 目标序列掩码

tgt_mask = generate_square_subsequent_mask(tgt.size(1)).to(device)

tgt_padding_mask = (tgt == tgt_pad_idx).to(device)

return src_mask, tgt_mask, src_padding_mask, tgt_padding_mask

def generate_square_subsequent_mask(sz):

return torch.triu(torch.full((sz, sz), float('-inf')), diagonal=1)

5.3 代码解读与分析

-

模型架构:

Transformer类实现了完整的编码器-解码器结构- 嵌入层将token索引映射为密集向量

- 位置编码添加序列位置信息

- 核心Transformer模块处理序列转换

-

训练过程:

- 使用teacher forcing策略训练解码器

- 实现了梯度裁剪防止梯度爆炸

- 动态学习率调度优化训练过程

- 使用交叉熵损失衡量预测与目标的差异

-

关键优化:

- 实现了高效的注意力掩码生成

- 支持批处理并行计算

- 模块化设计便于扩展

- 分离编码和解码方法支持不同推理策略

-

性能考虑:

- 使用PyTorch原生Transformer实现确保效率

- 支持GPU加速

- 优化的内存管理处理长序列

- 灵活的掩码机制支持不同输入格式

6. 实际应用场景

6.1 企业级应用

-

跨国商务沟通:

- 实时会议翻译

- 商务文档自动翻译

- 跨语言邮件处理

-

全球化内容平台:

- 新闻媒体多语言发布

- 视频字幕自动生成

- 社交媒体内容本地化

-

技术支持系统:

- 多语言知识库

- 技术文档翻译

- 用户支持聊天机器人

6.2 行业特定解决方案

-

医疗领域:

- 医疗记录翻译

- 药品说明本地化

- 医患沟通辅助

-

法律领域:

- 合同文件翻译

- 法律条文对齐

- 跨司法管辖区文档处理

-

教育领域:

- 学习材料多语言版本

- 在线课程实时翻译

- 学术论文翻译辅助

6.3 创新应用方向

-

多模态翻译:

- 图像文本提取和翻译

- 视频内容理解与翻译

- 语音到文本的实时翻译

-

个性化翻译:

- 用户风格适应

- 领域特定术语处理

- 文化背景适配

-

交互式翻译:

- 翻译质量实时评估

- 用户反馈即时整合

- 多版本翻译比较

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《Neural Machine Translation》by Philipp Koehn

- 《Speech and Language Processing》by Daniel Jurafsky & James H. Martin

- 《Deep Learning for Natural Language Processing》by Palash Goyal et al.

- 《Transformers for Natural Language Processing》by Denis Rothman

7.1.2 在线课程

- Coursera: Natural Language Processing Specialization (DeepLearning.AI)

- Fast.ai: Practical Deep Learning for Coders - NLP

- Udemy: Advanced NLP with spaCy

- Stanford CS224N: Natural Language Processing with Deep Learning

7.1.3 技术博客和网站

- The Gradient (https://thegradient.pub/)

- Hugging Face Blog (https://huggingface.co/blog)

- Google AI Blog - NLP (https://ai.googleblog.com/search/label/Text%20and%20Language)

- OpenAI Research (https://openai.com/research/)

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- VS Code with Python/Jupyter extensions

- PyCharm Professional

- JupyterLab

- Google Colab Pro

7.2.2 调试和性能分析工具

- PyTorch Profiler

- NVIDIA Nsight Systems

- Weights & Biases (wandb)

- TensorBoard

7.2.3 相关框架和库

- Hugging Face Transformers

- Fairseq (Facebook AI)

- OpenNMT

- MarianNMT

- SentencePiece (子词分词)

- SacreBLEU (评估指标)

7.3 相关论文著作推荐

7.3.1 经典论文

- “Attention Is All You Need” (Vaswani et al., 2017)

- “Neural Machine Translation by Jointly Learning to Align and Translate” (Bahdanau et al., 2014)

- “Google’s Neural Machine Translation System: Bridging the Gap between Human and Machine Translation” (Wu et al., 2016)

7.3.2 最新研究成果

- “Scaling Laws for Neural Machine Translation” (2022)

- “Multilingual Translation via Grafting Pre-trained Language Models” (2021)

- “Efficient Transformers: A Survey” (2020)

7.3.3 应用案例分析

- “Facebook’s Multilingual Machine Translation System”

- “DeepL Translator: A Case Study in High-Quality NMT”

- “Google Translate’s Zero-Shot Translation Breakthrough”

8. 总结:未来发展趋势与挑战

8.1 技术发展趋势

-

更大规模模型:

- 千亿参数翻译模型

- 多语言统一架构

- 稀疏专家模型(MoE)

-

多模态融合:

- 文本与视觉联合理解

- 语音到语音直接翻译

- 跨模态表示学习

-

持续学习能力:

- 在线适应新领域

- 增量学习新语言

- 用户反馈实时整合

8.2 面临的主要挑战

-

资源效率:

- 降低训练和推理成本

- 小语种数据稀缺

- 边缘设备部署

-

评估难题:

- 超越BLEU的评估指标

- 语义一致性度量

- 文化适应性评估

-

伦理与安全:

- 偏见和公平性问题

- 内容过滤和安全

- 隐私保护机制

8.3 未来发展方向

-

通用翻译智能体:

- 结合世界知识的翻译

- 推理和常识整合

- 多步骤翻译决策

-

人机协作翻译:

- 人类与AI协同工作流

- 翻译记忆增强

- 交互式编辑界面

-

认知增强翻译:

- 情感和文化适配

- 风格和语气保持

- 创意内容生成

9. 附录:常见问题与解答

Q1: 如何提高小语种的翻译质量?

A1: 小语种翻译质量提升策略包括:

- 使用多语言预训练模型进行迁移学习

- 应用反向翻译技术增强数据

- 利用语言相似性进行参数共享

- 实现课程学习从高资源语言逐步过渡

Q2: 如何处理领域特定的术语翻译?

A2: 领域术语处理方法:

- 构建领域术语库并强制解码

- 使用领域自适应微调技术

- 实现术语识别和特殊处理模块

- 结合外部知识图谱增强理解

Q3: 如何评估翻译模型的实际效果?

A3: 综合评估方法:

- 自动指标(BLEU, TER, METEOR等)

- 人工评估(流畅性、准确性)

- 下游任务性能测试

- A/B测试实际应用效果

Q4: 实时翻译系统如何优化延迟?

A4: 延迟优化技术:

- 模型蒸馏和量化

- 增量解码策略

- 缓存和预取机制

- 硬件加速(TPU, GPU优化)

Q5: 如何保证翻译的隐私安全?

A5: 隐私保护方案:

- 本地化部署模型

- 联邦学习框架

- 差分隐私技术

- 敏感内容检测和过滤

10. 扩展阅读 & 参考资料

-

官方文档:

- PyTorch Transformer文档: https://pytorch.org/docs/stable/generated/torch.nn.Transformer.html

- Hugging Face Transformers文档: https://huggingface.co/docs/transformers/index

- OpenNMT-py文档: https://opennmt.net/OpenNMT-py/

-

开源项目:

- Fairseq: https://github.com/facebookresearch/fairseq

- MarianNMT: https://marian-nmt.github.io/

- Tensor2Tensor: https://github.com/tensorflow/tensor2tensor

-

数据集资源:

- WMT共享任务数据: http://www.statmt.org/wmt22/

- OPUS多语言语料: https://opus.nlpl.eu/

- ParaCrawl: https://paracrawl.eu/

-

技术报告:

- Google’s Transformer模型报告: https://arxiv.org/abs/1706.03762

- Facebook’s Multilingual翻译系统: https://arxiv.org/abs/2001.08210

- DeepL技术白皮书: https://www.deepl.com/docs.html

-

社区论坛:

- PyTorch论坛: https://discuss.pytorch.org/

- Hugging Face社区: https://discuss.huggingface.co/

- Reddit机器学习版块: https://www.reddit.com/r/MachineLearning/

更多推荐

已为社区贡献54条内容

已为社区贡献54条内容

所有评论(0)