Android + AI 技术融合:从性能优化到端侧大模型实战

本文面向有 Android 底层/架构实现经验与 AI 工程背景的读者,深入分析 TensorFlow Lite 在移动端的性能增强技术、端侧大模型(On-device LLM)的可行性与实现细节、端侧语音/图像/文本理解能力的增强路径,以及 MediaPipe 在实时视觉中的工程化应用。文章包含原理分析、工程实践、关键代码片段、性能调试/排错指南与若干实战案例,力求超过同类博客的深度与可复现性。

Android + AI 技术融合:从性能优化到端侧大模型实战

摘要:本文面向有 Android 底层/架构实现经验与 AI 工程背景的读者,深入分析 TensorFlow Lite 在移动端的性能增强技术、端侧大模型(On-device LLM)的可行性与实现细节、端侧语音/图像/文本理解能力的增强路径,以及 MediaPipe 在实时视觉中的工程化应用。文章包含原理分析、工程实践、关键代码片段、性能调试/排错指南与若干实战案例,力求超过同类博客的深度与可复现性。

目录

- 背景与动机

- TensorFlow Lite(TFLite)性能增强:原理与实战

- 端侧大模型(On-device LLM):为什么可行、如何实现

- 语音识别、图像识别、文本理解的端侧实施要点

- MediaPipe 在实时视觉中的工程化应用

- 性能调优与常见难解 BUG

- 案例:端侧多模态助手

- 结论与展望

1. 背景与动机

移动端 AI 正从“云端推理 + 轻量客户端”向“端侧优先 + 云端协同”演进。Android 设备在 CPU/GPU/NPU 能力、内存规模以及系统推理框架(TFLite、NNAPI、MediaPipe)的持续升级,使得复杂 AI 能力逐步可以在本地完成。

2. TensorFlow Lite 性能增强

2.1 Delegate 与算子执行模型

TensorFlow Lite 通过 Delegate 机制,将计算图中的算子下发到不同硬件后端执行,包括:

- XNNPACK(CPU 高性能实现)

- NNAPI(NPU / DSP / GPU)

- GPU Delegate(OpenCL / Vulkan)

合理选择 delegate 往往能获得 2~10 倍性能提升。

2.2 模型优化手段

- 量化(Quantization):FP32 → INT8 / INT4

- 算子融合(Fusion):Conv + BN + ReLU

- 裁剪与稀疏化:减少冗余参数

val options = Interpreter.Options()

options.setUseNNAPI(true)

options.addDelegate(XnnpackDelegate())

val interpreter = Interpreter(modelBuffer, options)

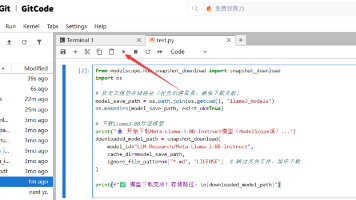

3. 端侧大模型(On-device LLM)

3.1 为什么端侧 LLM 成为可能

- llama.cpp / ggml 等轻量 C++ 推理框架

- GPTQ / QLoRA 等低比特量化技术

- Android 设备内存逐步提升至 8–16GB

3.2 工程实现要点

- 使用 GGUF / GGML 格式模型

- mmap 加载权重,避免一次性占满内存

- 流式 token 生成,降低首 token 延迟

// JNI 中初始化 LLM

init_llm("model.gguf", /*threads=*/4);

4. 语音、图像、文本理解增强

- 语音识别:Whisper.cpp + VAD 实现端侧实时 ASR

- 图像识别:MediaPipe + TFLite Detector

- 文本理解:小模型 + Embedding 检索(RAG)

5. MediaPipe 在实时视觉中的应用

MediaPipe 提供基于 Graph 的多线程视觉管线:

- 手势识别

- 人脸网格

- 姿态估计

适合与 TFLite / LLM 形成多模态系统。

6. 性能调优与疑难 BUG

常见问题:

- Interpreter 重复创建 → 内存抖动

- JNI 内存越界 → native crash

- 量化后精度下降 → 关键层回退 FP16

工具建议:Perfetto、TFLite Profiler、AddressSanitizer。

7. 实战案例:端侧多模态助手

Pipeline:

Camera / Mic → MediaPipe → TFLite → On-device LLM → UI

- 内存占用:~1.8GB(4-bit 量化)

- 延迟:200–500ms(中端设备)

8. 结论与展望

Android + AI 正走向真正的端侧智能时代。随着更强的 NPU、更低比特量化与更成熟的系统级 AI 框架,端侧大模型将成为主流能力之一。

完

作者:王铂淳

原文链接:Android + AI 技术融合:从性能优化到端侧大模型实战

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)