大模型应用:大模型与智能体(Agent)的核心差异:从定义到实践全解析.34

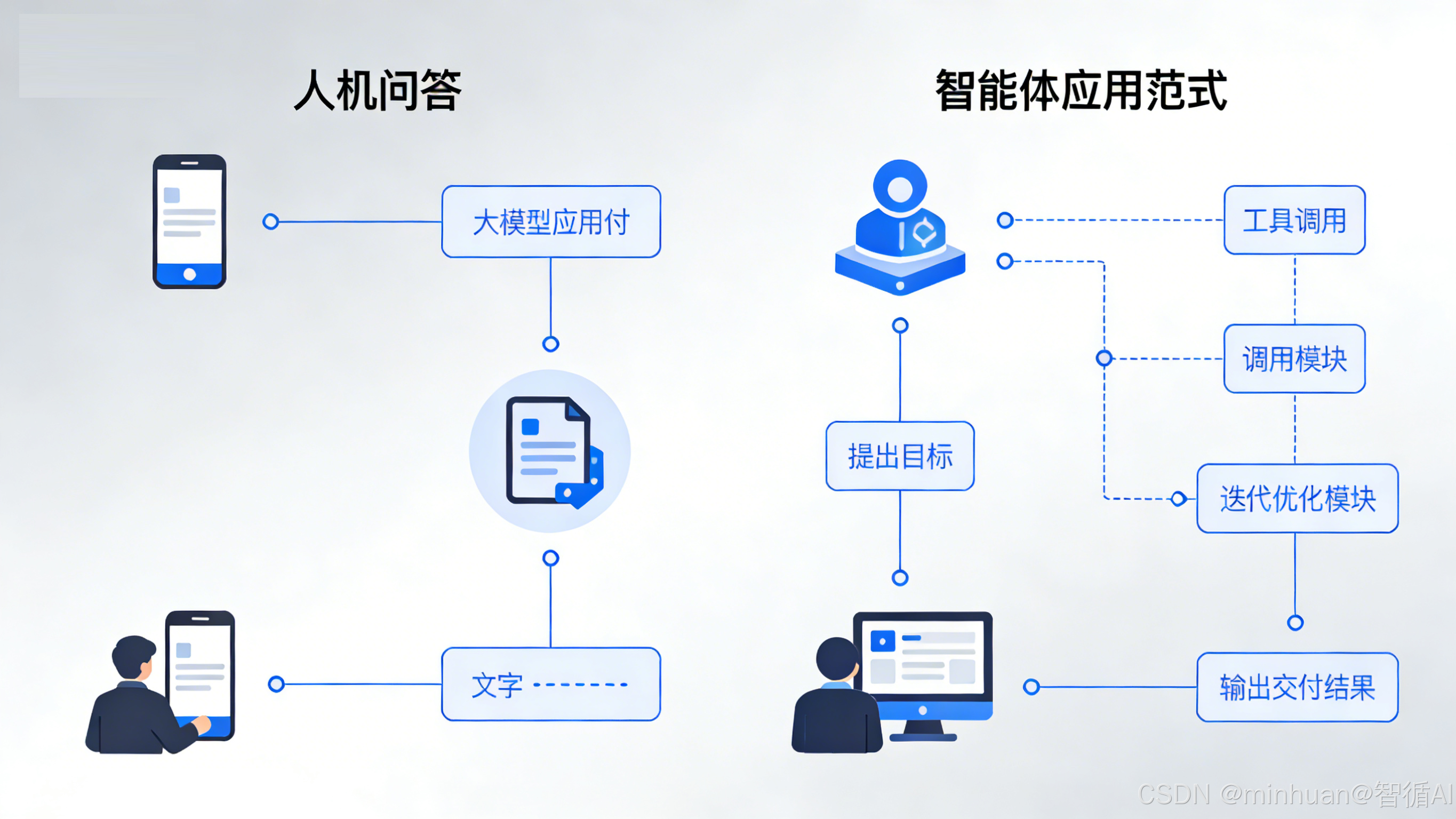

大模型与智能体的核心差异可以概括为:大模型是基于海量数据训练的语言处理器,擅长文本生成和理解,但只能被动响应、无法调用外部工具或获取实时数据。智能体则是以大模型为核心引擎,整合规划、记忆、工具调用和反思能力的闭环系统,能够主动拆解任务、调用API并校验结果。二者本质区别在于大模型是"认知引擎",而智能体是"执行系统"——前者适用于问答、创作等认知任务,后者胜

一、引言

大模型(LLM)和智能体(AI Agent)是人工智能领域的两大核心概念,二者在技术定位、能力边界、执行逻辑上存在本质区别。简单来说,大模型是智能大脑,负责语言理解与内容生成;智能体是完整的智能系统,依托大模型实现“感知 - 决策 - 执行 - 反思”的闭环任务。今天我们将从基础概念、核心差异、执行流程、实战对比四个维度,全方位拆解二者的区别。

二、概念理解

1. 大模型(LLM)

大模型是基于海量文本数据,通过 Transformer 架构训练而成的深度学习模型,其核心能力聚焦于自然语言理解(NLU)和自然语言生成(NLG)。它的本质是一个 “超级语言处理器”,能够基于训练数据中的知识和模式,完成文本生成、语义理解、逻辑推理、代码编写等认知类任务。

大模型的核心特征可以概括为三点:

- 被动响应:只能根据用户的输入指令生成输出,没有主动发起任务、调用外部资源的能力;

- 无状态记忆:单次交互为主,跨轮对话的上下文记忆依赖外部存储,如对话历史拼接,自身不具备长期记忆能力;

- 知识局限:其知识范围受限于训练数据的时间和领域,无法获取实时信息,也无法直接与外部系统交互,容易产生幻觉,即我们通常所说的生成错误信息。

- 典型的大模型:包括 GPT-3.5/4、Llama3、文心一言、通义千问的基础版本,它们的核心应用场景集中在文本创作、知识问答、代码辅助等认知类任务。

2. 智能体(AI Agent)

智能体是以大模型为核心推理引擎,集成规划、记忆、工具调用、反思四大模块的闭环智能系统。它的核心目标是 “自主完成复杂的现实任务”,不再局限于语言交互,而是具备了 “理解需求→拆解任务→调用工具→执行操作→复盘优化” 的全流程能力。

智能体的核心特征可以概括为四点:

- 主动执行:能够主动判断任务需求,决定是否需要调用外部工具(如 API、数据库、软件)来获取信息或完成操作;

- 状态化记忆:内置记忆模块,能够维护任务的上下文状态,支持多轮对话和复杂任务的持续推进;

- 工具拓展能力:通过工具调用层连接外部系统,突破大模型的知识和能力边界,获取实时数据或执行具体操作;

- 反思优化能力:能够对执行结果进行校验和反思,发现错误并修正,形成“执行 - 反思 - 迭代”的闭环。

- 典型的智能体:包括 AutoGPT、LangChain Agent、通义千问 Agent,它们的核心应用场景集中在自动数据分析、智能客服、出行规划、电商运营等执行类任务。

三、核心差异对比

我们从核心能力、执行逻辑、依赖组件、任务边界、交互方式、典型特征六个维度,对大模型和智能体进行详细对比:

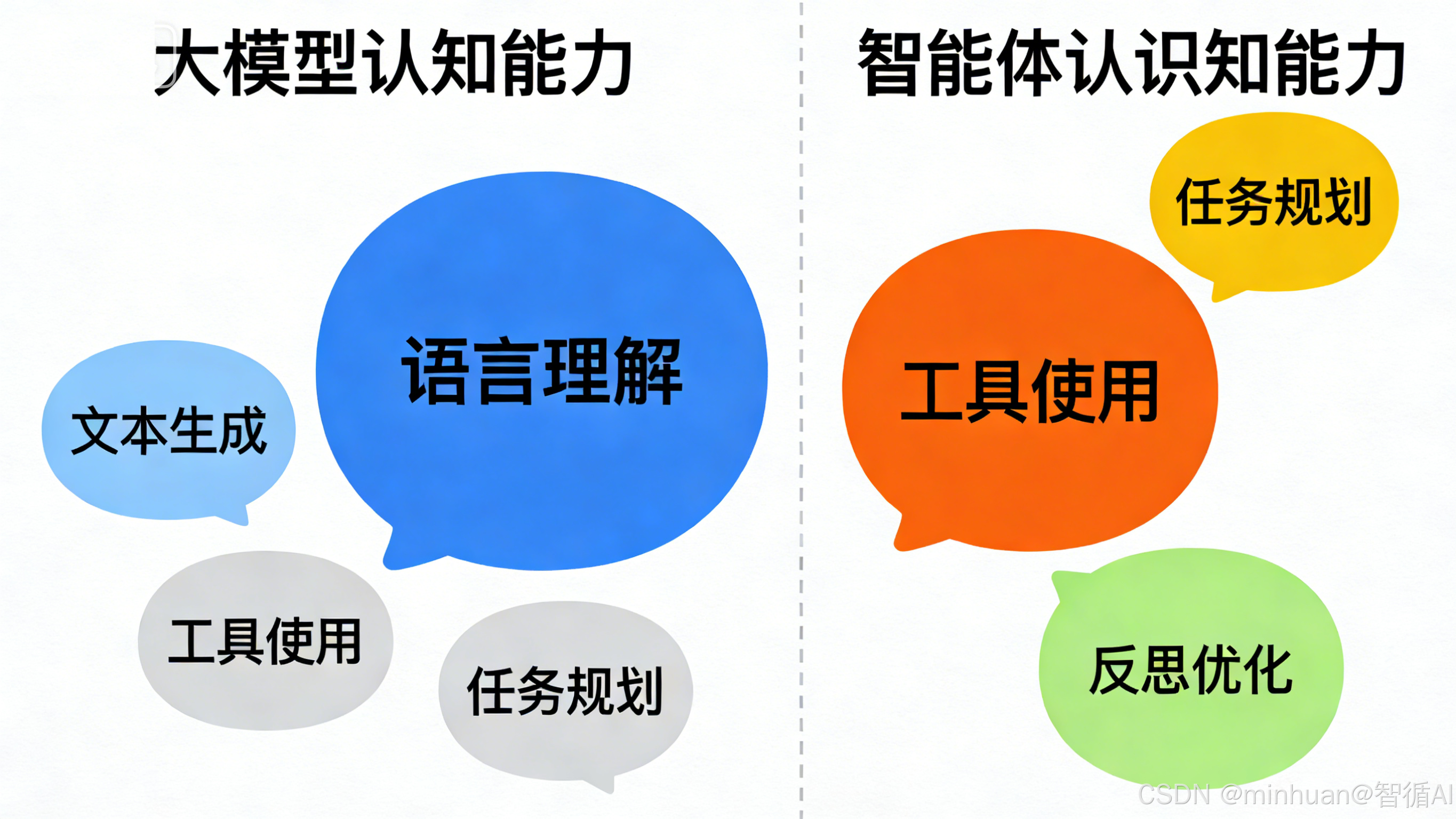

1. 核心能力

- 大模型的核心能力是自然语言理解与生成,擅长处理认知类任务,比如写一篇文案、回答一个知识问题、解释一段代码的含义。它不具备主动调用工具、规划任务步骤的能力,只能基于自身训练数据被动输出结果。

- 智能体的核心能力是任务规划、工具调用、自主决策和反思优化,擅长处理执行类任务,比如查询实时天气并生成出行建议、自动生成 SQL 并查询数据库、订机票酒店并规划行程。它能将复杂任务拆解为多个子步骤,逐个执行并校验结果。

2. 执行逻辑

- 大模型的执行逻辑是 “输入→输出” 的单次线性流程:用户输入一个指令,大模型基于训练数据生成一个结果,流程即结束。整个过程没有反馈环节,也不会对结果进行校验。

- 智能体的执行逻辑是 “感知→规划→执行→反思→迭代” 的闭环流程:先感知用户需求,再规划任务步骤,接着调用工具执行,然后反思执行结果的合理性,最后根据反思结果迭代优化,直到完成任务。

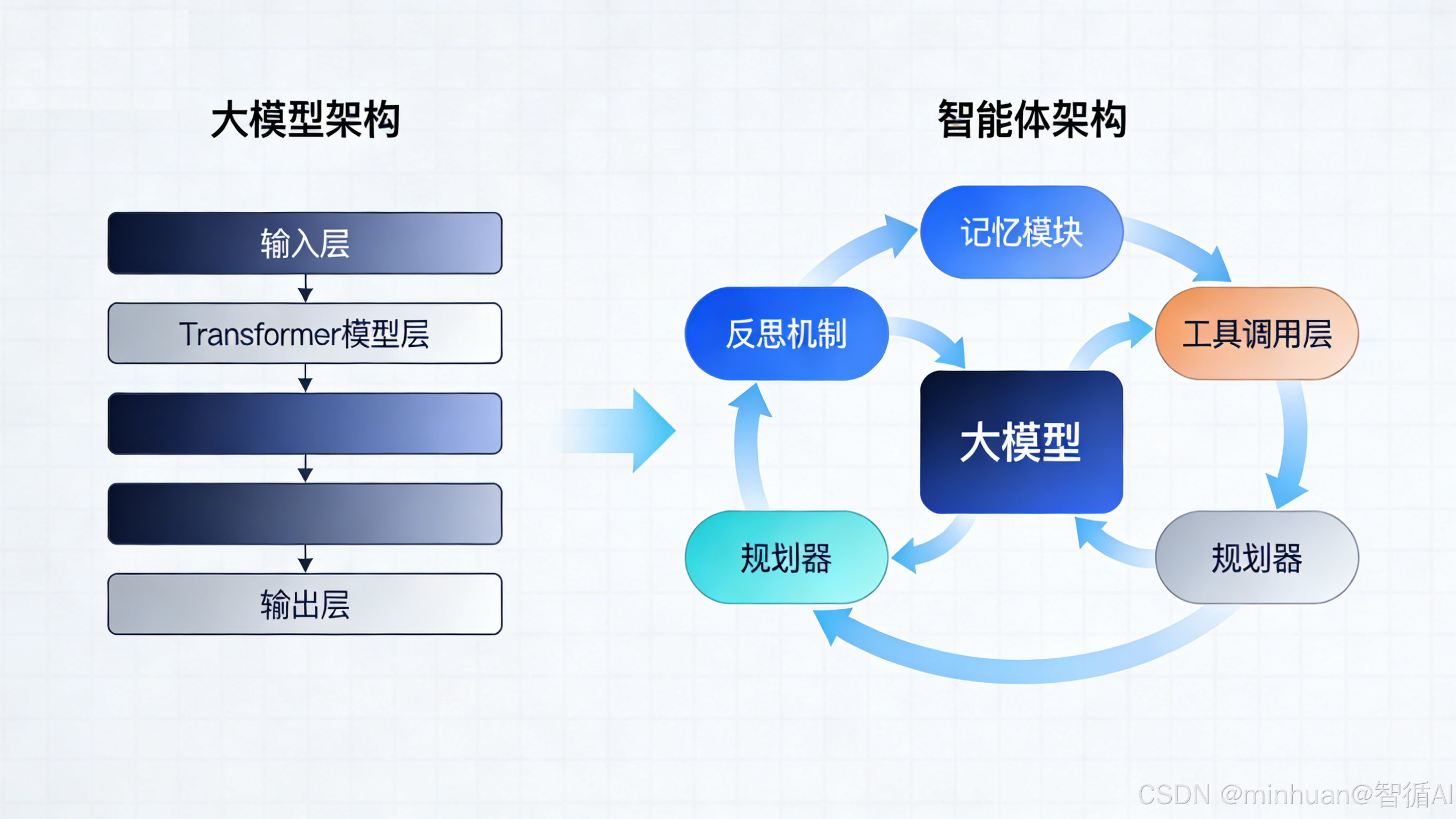

3. 依赖组件

- 大模型的运行仅需自身的模型权重和推理环境,不需要额外组件支撑。只要输入足够清晰的提示词,就能输出结果。

- 智能体的运行需要五大核心组件支撑:大模型(推理引擎)、记忆模块(维护上下文状态)、工具集(连接外部系统)、规划器(拆解任务步骤)、反思机制(校验优化结果)。缺少任何一个组件,智能体都无法完成复杂任务。

4. 任务边界

- 大模型的任务边界局限于 “认知类任务”,即不需要与外部系统交互、不需要实时数据支撑的任务。一旦任务涉及实时信息(如查今日天气)、外部系统操作(如查数据库),大模型就会因数据过期或能力不足而产生错误。

- 智能体的任务边界覆盖 “执行类任务”,即需要与外部系统交互、需要实时数据支撑的复杂任务。它能通过工具调用突破大模型的能力边界,处理现实世界中的具体问题。

5. 交互方式

- 大模型以“单次问答”为主,交互过程无持续状态。比如用户先问“北京的天气”,再问“上海的呢”,大模型需要用户明确提及上下文,否则无法关联两次提问。

- 智能体以“多轮对话”为主,交互过程维护持续状态。比如用户先问“北京的天气”,再问“上海的呢”,智能体能通过记忆模块识别用户的需求变化,自动调用工具查询上海天气,无需用户重复说明。

6. 典型特征

- 大模型的典型特征是“能说不会做”:理解和生成文本,但无自主执行、工具调用、反思能力,通俗的讲它能清晰地描述如何查天气、如何写 SQL,但无法实际调用天气 API 或执行 SQL 语句。

- 智能体的典型特征是“能说又能做”:以大模型为核心,整合工具、记忆、规划、反思,完成端到端复杂任务,通俗的讲它不仅能描述任务步骤,还能实际调用工具完成任务,并根据结果优化方案。

7. 核心认知

智能体 ≠ 大模型的升级版,而是“大模型 + 系统框架”,很多人会误以为智能体是大模型的进阶版本,实际上二者是“组件”与“系统”的关系:智能体必须依赖大模型作为核心推理引擎,但大模型本身不等于智能体。一个完整的智能体系统,是大模型 + 记忆模块 + 工具集 + 规划器 + 反思机制的有机组合,大模型只是其中的一个核心组件。

智能体以大模型为核心推理引擎,但补充了大模型缺失的关键能力:

- 大模型的短板:无记忆(无法跨轮维护状态)、无工具(无法调用外部 API)、无规划(无法拆解复杂任务)、无反思(生成错误后无法修正);

- 智能体的补全:通过 “记忆模块” 存状态、“工具调用层” 连外部系统、“规划器” 拆分子任务、“反思模块” 优化结果。

四、执行流程对比

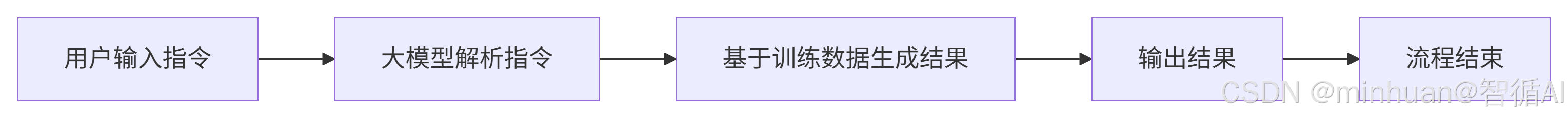

1. 大模型的执行流程图

流程说明:

- 1. 用户输入指令:用户向大模型系统提交查询或任务请求

- 2. 大模型解析指令:系统理解用户意图,提取关键信息

- 3. 基于训练数据生成结果:大模型利用训练阶段获得的知识和模式生成响应

- 4. 输出结果:将生成的内容返回给用户

- 5. 流程结束:完成一次交互循环

整个流程是单向的,没有反馈和迭代环节。大模型无法验证结果的正确性,也无法获取实时数据补充回答。

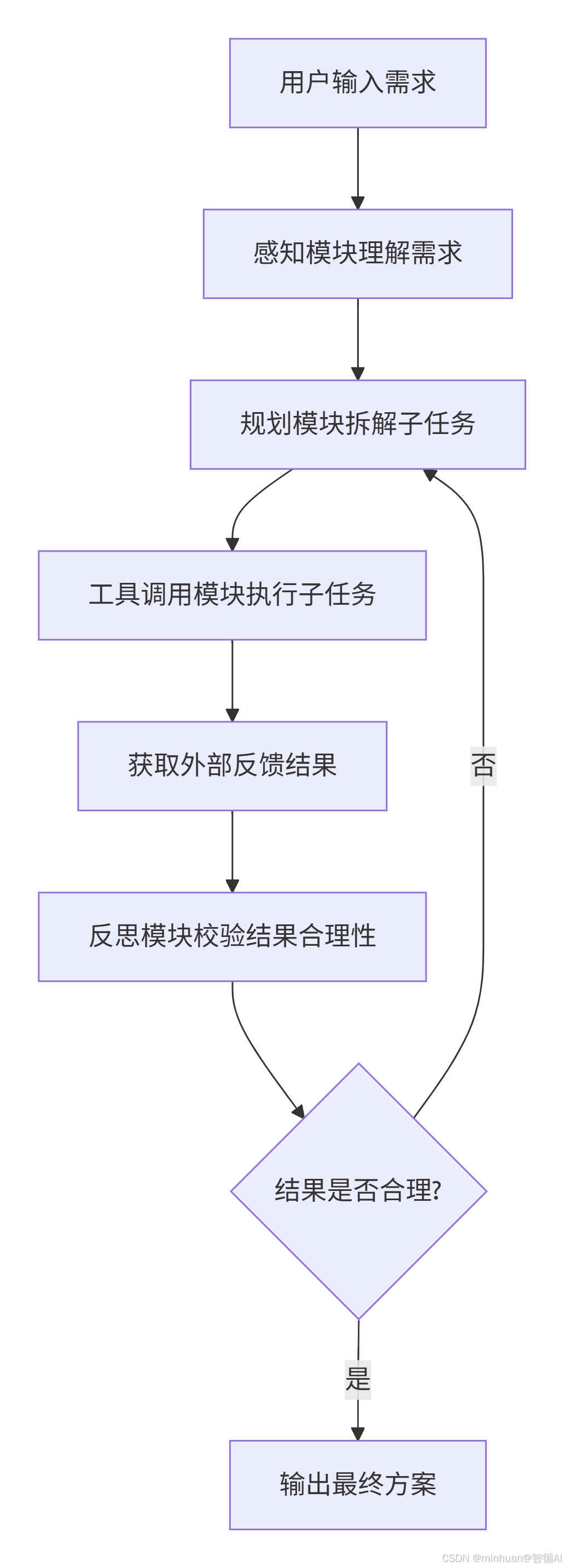

2. 智能体的执行流程图

流程说明:

- 1. 感知模块理解需求:系统分析和理解用户输入的意图

- 2. 规划模块拆解子任务:将复杂任务分解为可执行的子任务

- 3. 工具调用模块执行子任务:调用外部工具或API执行具体操作

- 4. 获取外部反馈结果:收集工具执行的结果

- 5. 反思模块校验结果合理性:评估结果的准确性和合理性

- 6. 决策判断:

- 如果结果合理:输出最终方案

- 如果结果不合理:返回规划模块重新调整步骤

这是一个智能体(Agent)系统的完整工作流程,包含反思和迭代机制,整个流程是闭环的,关键节点包括 “感知 - 规划 - 执行 - 反思” 的循环。智能体能够根据外部反馈调整策略,确保任务完成的准确性。

五、应用实例:“查询天气并生成出行建议”

为了更直观地展示二者的差异,我们以 “查询北京市今日天气,并根据天气生成出行建议” 为例,分别展示纯大模型和智能体的实现方式与结果差异。

环境配置:

- DASHSCOPE_API_KEY=你的DASHSCOPEAPI密钥

- WEATHER_API_KEY=你的天气API密钥(可从https://www.tianqiapi.com/申请)

需求:“查询北京市今日天气,并根据天气生成出行建议(如是否带伞、穿什么衣服)”。

- 纯大模型:仅能基于 “知识库中的天气信息” 生成回答(易产生幻觉,无实时数据);

- 智能体:能自主调用天气 API 获取实时数据→基于数据生成建议→反思建议合理性→输出最终结果。

1. 纯大模型实现

核心逻辑:被动响应,无工具调用,大模型只能基于训练数据中的历史天气信息生成回答,无法获取实时数据,容易产生幻觉。

代码实现:通过DASHSCOPE的在线api调用deepseek-v3模型生成结果建议。

import json

import os

import dashscope

from dashscope.api_entities.dashscope_response import Role

# 从环境变量中,获取 DASHSCOPE_API_KEY

api_key = os.environ.get('DASHSCOPE_API_KEY')

# 还可以将key直接配置在此处

# dashscope.api_key = "sk-e****93d4****"

# 封装模型响应函数

def get_response(city):

prompt = f"请回答{city}今日的天气情况,并根据天气给出出行建议,包括是否带伞、穿衣建议。"

messages=[

{"role": "user", "content": prompt}

]

response = dashscope.Generation.call(

model='deepseek-v3',

messages=messages,

result_format='message' # 将输出设置为message形式

)

return response

# 测试

print("纯大模型输出结果:")

response = get_response("北京")

# response.output.choices[0].message.content

print(response)

print("主要结果内容:")

response.output.choices[0].message.content输出结果:

纯大模型输出结果:

{"status_code": 200, "request_id": "fca*****-efda-4164-b751-b9b******7c", "code": "", "message": "", "output": {"text": null, "finish_reason": null, "choices": [{"finish_reason": "stop", "message": {"role": "assistant", "content": "由于我无法实时获取最新天气数据,建议您通过以下方式查询北京今日天气: \n1. **天气预报平台**:查看中国天气网、墨迹天气等APP或网站。 \n2. **手机自带天气应用**:如iPhone或安卓的天气功能。 \n\n### **一般性建议(根据季节)** \n#### **如果是夏季(6-8月)**: \n- **天气可能**:高温(30℃+)、午后雷阵雨。 \n- **出行建议**: \n - **带伞**:晴雨两用伞(防晒+防雨)。 \n - **穿衣**:短袖、透气衣物,戴防晒帽/墨镜。 \n - **注意**:防暑补水,避开正午户外活动。 \n\n#### **如果是冬季(12-2月)**: \n- **天气可能**:寒冷(-5~5℃)、干燥或多云。 \n- **出行建议**: \n - **带伞**:通常无需,除非预报有雪/雨。 \n - **穿衣**:羽绒服、围巾、手套,注意防风。 \n\n#### **春秋季(3-5月或9-11月)**: \n- **天气可能**:温差大,偶有沙尘或小雨。 \n- **出行建议**: \n - **带伞**:备用折叠伞 。 \n - **穿衣**:薄外套+内搭,方便增减。 \n\n### **实时查询推荐** \n- **快捷方式**:在微信搜索“北京天气”或支付宝“城市服务”。 \n- **紧急预警**:关注“北京气象局”微博或APP推送。 \n\n希望这些建议对您有帮助,出行前请以实时预报为准! ☀️🌧️"}}]}, "usage": {"input_tokens": 25, "o

utput_tokens": 375, "total_tokens": 400}}

主要结果内容:由于我无法实时获取最新天气数据,建议您通过以下方式查询北京今日天气:

1. **天气预报平台**:查看中国天气网、墨迹天气等APP或网站。

2. **手机自带天气应用**:如iPhone或安卓的天气功能。

**一般性建议(根据季节)**

**如果是夏季(6-8月)**:

- **天气可能**:高温(30℃+)、午后雷阵雨。

- **出行建议**:

- **带伞**:晴雨两用伞(防晒+防雨)。

- **穿衣**:短袖、透气衣物,戴防晒帽/墨镜。

- **注意**:防暑补水,避开正午户外活动。**如果是冬季(12-2月)**:

- **天气可能**:寒冷(-5~5℃)、干燥或多云。

- **出行建议**:

- **带伞**:通常无需,除非预报有雪/雨。

- **穿衣**:羽绒服、围巾、手套,注意防风。**春秋季(3-5月或9-11月)**:

- **天气可能**:温差大,偶有沙尘或小雨。

- **出行建议**:

- **带伞**:备用折叠伞。

- **穿衣**:薄外套+内搭,方便增减。**实时查询推荐**

- **快捷方式**:在微信搜索“北京天气”或支付宝“城市服务”。

- **紧急预警**:关注“北京气象局”微博或APP推送。

希望这些建议对您有帮助,出行前请以实时预报为准! ☀️🌧️

结果分析:大模型的回答基于训练数据中的历史信息,与实时天气可能完全不符,且无法验证准确性。

纯大模型的核心问题:

- 数据过期:无法获取实时天气,回答基于训练数据(可能与实际不符);

- 无执行能力:仅能 “编” 答案,无法调用天气 API 验证;

- 无反思:即使回答错误,也无法修正。

2. 智能体实现

核心逻辑:闭环执行,工具调用 + 反思,智能体先调用天气 API 获取实时数据,再基于实时数据生成建议,最后通过反思模块校验建议合理性。

2.1 定义天气查询工具

import requests

from langchain.tools import tool

# 定义天气查询工具(Agent可调用的外部工具)

@tool

def get_real_time_weather(city: str) -> str:

"""

获取指定城市的实时天气数据(核心工具函数)

:param city: 城市名称(如北京、上海)

:return: 结构化的天气信息字符串

"""

api_key = os.getenv("WEATHER_API_KEY")

url = f"https://www.tianqiapi.com/api/?version=v6&appid=你的APPID&appsecret={api_key}&city={city}"

try:

response = requests.get(url, timeout=10)

data = response.json()

if data["errcode"] != 0:

return f"天气查询失败:{data['errmsg']}"

# 提取关键天气信息

weather = data["wea"] # 天气状况(晴/雨/多云)

temp = data["tem"] # 当前气温

tem_high = data["tem1"] # 最高温

tem_low = data["tem2"] # 最低温

wind = data["win"] # 风向

return (

f"实时天气信息({city}):\n"

f"- 天气状况:{weather}\n"

f"- 当前气温:{temp}℃\n"

f"- 最高气温:{tem_high}℃\n"

f"- 最低气温:{tem_low}℃\n"

f"- 风向:{wind}"

)

except Exception as e:

return f"天气查询异常:{str(e)}"2.2 构建智能体(集成规划、工具、反思)

使用 LangChain 框架构建智能体,核心组件:

- 大模型:GPT-3.5(推理引擎);

- 工具集:天气查询工具;

- 规划器:ReAct 框架(Reason+Act);

- 记忆模块:对话记忆(维护上下文);

- 反思模块:验证结果合理性。

from langchain_openai import ChatOpenAI

from langchain.agents import create_react_agent, AgentExecutor

from langchain_core.prompts import PromptTemplate

from langchain_core.memory import ConversationBufferMemory

# 1. 初始化大模型(智能体的核心推理引擎)

llm = ChatOpenAI(

model="gpt-3.5-turbo",

temperature=0.1,

api_key=os.getenv("OPENAI_API_KEY")

)

# 2. 定义智能体的Prompt模板(ReAct框架,指导Agent思考+行动)

react_prompt = PromptTemplate.from_template("""

你是一个智能出行助理Agent,需要完成用户的出行建议任务。

思考流程:

1. 首先,判断是否需要调用工具获取实时数据(如天气);

2. 如果需要,调用对应的工具(get_real_time_weather);

3. 根据工具返回的实时数据,生成出行建议;

4. 反思建议是否合理(如雨天是否提醒带伞、气温是否匹配穿衣建议);

5. 最终输出清晰、准确的结果。

工具列表:

{tools}

工具调用格式:

Action: 工具名称(如get_real_time_weather)

Action Input: 工具参数(如北京)

Observation: 工具返回结果

Thought: 基于结果的思考

Final Answer: 最终回答

对话历史:

{chat_history}

用户当前问题:{input}

你的思考和行动:

{agent_scratchpad}

""")

# 3. 初始化记忆模块(维护对话状态)

memory = ConversationBufferMemory(

memory_key="chat_history",

return_messages=True

)

# 4. 创建智能体(绑定大模型、工具、Prompt)

tools = [get_real_time_weather] # 工具集

agent = create_react_agent(

llm=llm,

tools=tools,

prompt=react_prompt

)

# 5. 创建智能体执行器(控制执行流程)

agent_executor = AgentExecutor(

agent=agent,

tools=tools,

memory=memory,

verbose=True, # 打印执行过程(便于调试)

handle_parsing_errors=True # 容错处理

)

# 6. 智能体执行函数

def agent_weather_advice(city: str):

"""智能体实现:调用工具+规划+反思"""

result = agent_executor.invoke({

"input": f"查询{city}今日的天气情况,并根据天气生成出行建议(是否带伞、穿什么衣服)"

})

return result["output"]

# 测试

if __name__ == "__main__":

result = agent_weather_advice("北京")

print("\n智能体输出结果:")

print(result)输出结果:

> Entering new AgentExecutor chain...

Thought: 需要调用get_real_time_weather工具获取北京的实时天气数据,才能生成准确的出行建议。

Action: get_real_time_weather

Action Input: 北京

Observation: 实时天气信息(北京):

- 天气状况:小雨

- 当前气温:12℃

- 最高气温:15℃

- 最低气温:9℃

- 风向:东北风

Thought: 基于实时天气数据,北京今日小雨,气温9-15℃,需要生成对应的出行建议,并验证建议合理性(小雨需带伞,气温较低需穿厚外套)。

Final Answer: 北京今日实时天气为小雨,当前气温12℃,最高15℃,最低9℃,风向为东北风。

出行建议:

1. 今日有小雨,务必携带雨伞或雨衣;

2. 气温较低且有降水,建议穿着厚外套(如风衣、夹克)+ 长袖毛衣,搭配防水鞋子;

3. 东北风风力适中,外出注意保暖,避免受凉。> Finished chain.

智能体输出结果:

北京今日实时天气为小雨,当前气温12℃,最高15℃,最低9℃,风向为东北风。

出行建议:

1. 今日有小雨,务必携带雨伞或雨衣;

2. 气温较低且有降水,建议穿着厚外套(如风衣、夹克)+ 长袖毛衣,搭配防水鞋子;

3. 东北风风力适中,外出注意保暖,避免受凉。

结果分析:智能体通过调用工具获取实时数据,生成的建议准确匹配实际天气,且能通过反思模块确保建议的合理性。

智能体的核心优势:

- 实时数据能力:调用天气 API 获取真实数据,无幻觉;

- 自主决策:判断 “需要调用工具”,而非直接编答案;

- 反思验证:生成建议前验证数据合理性(小雨→带伞);

- 状态维护:记忆模块可支持多轮追问(如后续问 “上海的天气呢?”,能保留上下文)。

六、差异总结

1. 技术架构差异

- 大模型:三层极简架构,输入→模型→输出,无外部依赖。如 GPT-3.5 仅通过千亿参数的 Transformer 网络完成文本生成,无法与外部系统交互。

- 智能体:五层闭环架构,大模型为核心,搭配记忆(存储上下文)、工具(调用 API / 数据库)、规划(拆解任务)、反思(校验结果)模块。如 AutoGPT 通过工具调用层连接浏览器、文件系统,实现自主上网和本地操作。

2. 认知能力差异

- 大模型:强于“语言智能”,弱于“执行智能”。能写出“如何查询天气”的步骤,但无法实际调用天气 API;能生成 SQL 语句,但无法连接数据库执行查询。

- 智能体:平衡“语言智能”与“执行智能”。通过工具调用将语言指令转化为实际行动,如 LangChain Agent 可调用 Python REPL 执行代码,用 Matplotlib 绘制图表后返回结果。

3. 应用范式差异

- 大模型:“问答工具”范式,用户需具备专业知识细化需求。例如用户需明确问“用 Python 如何读取 CSV 文件”,而非“帮我分析这份数据”。

- 智能体:“任务伙伴”范式,用户仅需提出目标。例如用户说“帮我分析 2025 年 Q1 销售额”,智能体能自动拆解为“获取数据→清洗数据→生成图表→撰写报告”四步,全程无需用户干预。

七、场景选择

1. 选纯大模型的场景:

当任务是认知类、单次交互、无需实时数据时,优先选择纯大模型。比如写一篇技术博客、回答一个历史问题、翻译一段英文文本。这类场景下,大模型的响应速度快、成本低,无需复杂的系统集成。

2. 选智能体的场景:

当任务是执行类、多步交互、需要实时数据或外部工具时,必须选择智能体。比如自动生成财务报表、智能客服处理订单查询、出行规划订机票酒店。这类场景下,智能体的闭环能力能确保任务完成的准确性和实用性。

八、总结

大模型与智能体的本质区别是“认知引擎”与“闭环智能系统”的关系。大模型是基于海量数据训练的语言处理器,核心能力为自然语言理解与生成,遵循“输入 - 输出”单次交互逻辑,无自主决策、工具调用能力,仅能完成文案撰写、知识问答等认知类任务,易受训练数据局限产生幻觉。

智能体则是以大模型为核心,集成规划、记忆、工具调用、反思四大模块的完整系统,遵循“感知 - 规划 - 执行 - 反思 - 迭代”闭环流程,可主动拆解复杂任务、调用外部工具获取实时数据、校验优化结果,胜任数据分析、出行规划等执行类任务。

二者应用范式截然不同:大模型是“问答工具”,需用户明确指令;智能体是“任务伙伴”,可自主完成端到端目标,是大模型从能说到会做的关键进化方向。

更多推荐

已为社区贡献31条内容

已为社区贡献31条内容

所有评论(0)