自适应对话策略:提升AI Agent的交互质量

在当今数字化时代,AI Agent在众多领域得到了广泛应用,如智能客服、智能助手等。然而,目前很多AI Agent的交互质量仍有待提高,用户在与AI Agent对话时常常会遇到回答不准确、不灵活等问题。本文的目的是深入研究自适应对话策略,通过该策略来优化AI Agent的交互流程,使其能够根据不同的对话场景、用户需求和反馈信息,动态调整对话策略,从而显著提升AI Agent的交互质量。本文的范围涵

自适应对话策略:提升AI Agent的交互质量

关键词:自适应对话策略、AI Agent、交互质量、自然语言处理、机器学习

摘要:本文围绕自适应对话策略展开,旨在探讨如何通过该策略有效提升AI Agent的交互质量。首先介绍了相关背景,包括目的、预期读者等内容。接着阐述了自适应对话策略的核心概念及其联系,详细讲解了核心算法原理与具体操作步骤,并用数学模型和公式进行理论支撑。通过项目实战案例展示了代码实现与分析,介绍了其实际应用场景。同时推荐了相关的学习资源、开发工具框架以及论文著作。最后总结了未来发展趋势与挑战,并提供了常见问题解答和扩展阅读参考资料,为提升AI Agent的交互质量提供全面且深入的技术指导。

1. 背景介绍

1.1 目的和范围

在当今数字化时代,AI Agent在众多领域得到了广泛应用,如智能客服、智能助手等。然而,目前很多AI Agent的交互质量仍有待提高,用户在与AI Agent对话时常常会遇到回答不准确、不灵活等问题。本文的目的是深入研究自适应对话策略,通过该策略来优化AI Agent的交互流程,使其能够根据不同的对话场景、用户需求和反馈信息,动态调整对话策略,从而显著提升AI Agent的交互质量。

本文的范围涵盖了自适应对话策略的核心概念、算法原理、数学模型、实际应用案例以及相关的工具和资源等方面。旨在为从事AI Agent开发、自然语言处理等相关领域的技术人员提供全面且深入的技术参考。

1.2 预期读者

本文预期读者主要包括以下几类人群:

- AI开发人员:负责AI Agent的设计、开发和维护工作,希望通过学习自适应对话策略来提升所开发AI Agent的交互性能。

- 自然语言处理研究者:对自然语言处理中的对话系统有深入研究兴趣,关注自适应对话策略在该领域的应用和发展。

- 技术管理者:负责技术团队的管理和技术方向的规划,需要了解自适应对话策略对提升产品竞争力的重要性。

- 对AI技术感兴趣的爱好者:希望了解自适应对话策略的基本原理和应用,拓宽自己在AI领域的知识面。

1.3 文档结构概述

本文将按照以下结构进行组织:

- 核心概念与联系:介绍自适应对话策略、AI Agent、交互质量等核心概念,并阐述它们之间的联系。

- 核心算法原理 & 具体操作步骤:详细讲解实现自适应对话策略的核心算法原理,并给出具体的操作步骤,同时用Python代码进行示例。

- 数学模型和公式 & 详细讲解 & 举例说明:用数学模型和公式对自适应对话策略进行理论描述,并通过具体例子进行说明。

- 项目实战:代码实际案例和详细解释说明:通过一个实际的项目案例,展示自适应对话策略的代码实现过程,并对代码进行详细解读。

- 实际应用场景:介绍自适应对话策略在不同领域的实际应用场景。

- 工具和资源推荐:推荐相关的学习资源、开发工具框架以及论文著作。

- 总结:未来发展趋势与挑战:总结自适应对话策略的未来发展趋势,并分析可能面临的挑战。

- 附录:常见问题与解答:对读者可能关心的常见问题进行解答。

- 扩展阅读 & 参考资料:提供相关的扩展阅读内容和参考资料,方便读者进一步深入学习。

1.4 术语表

1.4.1 核心术语定义

- 自适应对话策略:指AI Agent能够根据对话的上下文、用户的反馈、对话场景等信息,动态调整自身的对话方式和回复内容,以实现更好的交互效果。

- AI Agent:是一种能够感知环境、进行决策并采取行动的智能软件实体,在对话系统中表现为能够与用户进行自然语言交互的智能程序。

- 交互质量:衡量AI Agent与用户交互效果的指标,包括回答的准确性、相关性、灵活性、友好性等方面。

1.4.2 相关概念解释

- 自然语言处理(NLP):是计算机科学与人工智能领域中的一个重要方向,研究如何让计算机理解和处理人类语言。自适应对话策略是自然语言处理在对话系统中的具体应用。

- 机器学习(ML):是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。自适应对话策略常常借助机器学习算法来实现对对话策略的动态调整。

1.4.3 缩略词列表

- NLP:Natural Language Processing(自然语言处理)

- ML:Machine Learning(机器学习)

2. 核心概念与联系

核心概念原理

自适应对话策略

自适应对话策略的核心在于根据不同的对话情境进行动态调整。在对话过程中,AI Agent会不断收集对话信息,包括用户的提问、历史对话记录、当前对话的主题等。然后,基于这些信息,AI Agent会对当前的对话状态进行评估,判断出最适合的对话策略。例如,如果用户的提问比较模糊,AI Agent可能会采用追问策略,以获取更多的信息;如果用户对某个话题表现出浓厚的兴趣,AI Agent则可以提供更多相关的详细信息。

AI Agent

AI Agent是执行自适应对话策略的主体。它通常由多个模块组成,包括自然语言理解模块、对话管理模块和自然语言生成模块。自然语言理解模块负责解析用户的输入,将其转换为计算机能够理解的语义表示;对话管理模块根据自然语言理解模块的输出和当前的对话状态,选择合适的对话策略;自然语言生成模块则根据对话管理模块选择的策略,生成自然流畅的回复文本。

交互质量

交互质量是衡量AI Agent与用户交互效果的关键指标。它受到多个因素的影响,如回答的准确性、相关性、灵活性、友好性等。自适应对话策略的目标就是通过动态调整对话策略,提高AI Agent在这些方面的表现,从而提升交互质量。

架构的文本示意图

+-------------------+

| 用户输入 |

+-------------------+

|

v

+-------------------+

| 自然语言理解模块 |

+-------------------+

|

v

+-------------------+

| 对话管理模块 |

| (自适应对话策略) |

+-------------------+

|

v

+-------------------+

| 自然语言生成模块 |

+-------------------+

|

v

+-------------------+

| 用户输出 |

+-------------------+

Mermaid流程图

graph TD;

A[用户输入] --> B[自然语言理解模块];

B --> C[对话管理模块(自适应对话策略)];

C --> D[自然语言生成模块];

D --> E[用户输出];

3. 核心算法原理 & 具体操作步骤

核心算法原理

自适应对话策略的核心算法可以基于强化学习来实现。强化学习是一种通过智能体与环境进行交互,不断尝试不同的动作,并根据环境反馈的奖励信号来学习最优策略的机器学习方法。

在自适应对话策略中,AI Agent作为智能体,对话环境就是与用户的交互过程。AI Agent的动作就是选择不同的对话策略,如回答问题、追问信息、转移话题等。环境的奖励信号可以根据交互质量的评估指标来定义,例如,如果AI Agent的回答准确且相关,就给予正奖励;如果回答不准确或不相关,则给予负奖励。

具体操作步骤

步骤1:定义状态空间

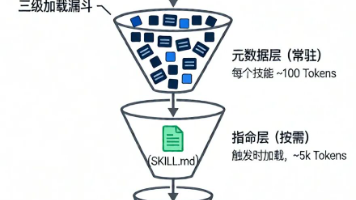

状态空间表示对话的当前状态,包括用户的提问、历史对话记录、当前对话的主题等信息。可以将这些信息进行编码,转换为一个向量表示,作为强化学习中的状态。

步骤2:定义动作空间

动作空间表示AI Agent可以选择的对话策略,例如:

- 直接回答问题

- 追问更多信息

- 转移话题

- 提供相关建议

步骤3:定义奖励函数

奖励函数用于评估AI Agent的动作效果。可以根据交互质量的评估指标来设计奖励函数,例如:

- 回答准确性:如果回答与问题相关且正确,给予正奖励;否则给予负奖励。

- 信息完整性:如果回答提供了足够的信息,给予正奖励;否则给予负奖励。

- 用户满意度:可以通过用户的反馈(如好评、差评)来调整奖励值。

步骤4:选择动作

在每个对话步骤中,AI Agent根据当前的状态,使用强化学习算法(如Q-learning、深度Q网络等)选择一个最优的动作。

步骤5:执行动作并更新状态

AI Agent执行选择的动作,生成回复文本并发送给用户。然后,根据用户的反馈更新对话状态。

步骤6:更新策略

根据环境反馈的奖励信号,使用强化学习算法更新AI Agent的策略,使得在未来的对话中能够选择更优的动作。

Python源代码示例

import numpy as np

# 定义状态空间

state_space_size = 10

# 定义动作空间

action_space_size = 4

# 初始化Q表

q_table = np.zeros((state_space_size, action_space_size))

# 定义超参数

learning_rate = 0.1

discount_rate = 0.9

exploration_rate = 1.0

max_exploration_rate = 1.0

min_exploration_rate = 0.01

exploration_decay_rate = 0.001

# 模拟对话过程

num_episodes = 1000

for episode in range(num_episodes):

# 初始化状态

state = np.random.randint(0, state_space_size)

done = False

while not done:

# 选择动作

exploration_rate_threshold = np.random.uniform(0, 1)

if exploration_rate_threshold > exploration_rate:

action = np.argmax(q_table[state, :])

else:

action = np.random.randint(0, action_space_size)

# 执行动作并获取奖励和新状态

new_state = np.random.randint(0, state_space_size)

reward = np.random.randint(-1, 2)

# 更新Q表

q_table[state, action] = q_table[state, action] + learning_rate * (

reward + discount_rate * np.max(q_table[new_state, :]) - q_table[state, action]

)

state = new_state

# 模拟对话结束条件

if np.random.rand() < 0.1:

done = True

# 衰减探索率

exploration_rate = min_exploration_rate + (

max_exploration_rate - min_exploration_rate

) * np.exp(-exploration_decay_rate * episode)

4. 数学模型和公式 & 详细讲解 & 举例说明

数学模型

自适应对话策略的强化学习模型可以用马尔可夫决策过程(MDP)来描述。马尔可夫决策过程由一个四元组 (S,A,P,R)(S, A, P, R)(S,A,P,R) 组成,其中:

- SSS 是状态空间,表示对话的所有可能状态。

- AAA 是动作空间,表示AI Agent可以选择的所有对话策略。

- P(s′∣s,a)P(s'|s, a)P(s′∣s,a) 是状态转移概率,表示在状态 sss 下执行动作 aaa 后转移到状态 s′s's′ 的概率。

- R(s,a,s′)R(s, a, s')R(s,a,s′) 是奖励函数,表示在状态 sss 下执行动作 aaa 并转移到状态 s′s's′ 后获得的奖励。

公式

Q-learning算法

Q-learning是一种无模型的强化学习算法,用于学习最优的动作价值函数 Q(s,a)Q(s, a)Q(s,a)。Q-learning的更新公式如下:

Q(st,at)←Q(st,at)+α[R(st,at,st+1)+γmaxaQ(st+1,a)−Q(st,at)] Q(s_t, a_t) \leftarrow Q(s_t, a_t) + \alpha [R(s_t, a_t, s_{t+1}) + \gamma \max_{a} Q(s_{t+1}, a) - Q(s_t, a_t)] Q(st,at)←Q(st,at)+α[R(st,at,st+1)+γamaxQ(st+1,a)−Q(st,at)]

其中:

- sts_tst 是当前状态。

- ata_tat 是当前动作。

- R(st,at,st+1)R(s_t, a_t, s_{t+1})R(st,at,st+1) 是执行动作 ata_tat 后从状态 sts_tst 转移到状态 st+1s_{t+1}st+1 获得的奖励。

- α\alphaα 是学习率,控制每次更新的步长。

- γ\gammaγ 是折扣率,用于权衡当前奖励和未来奖励的重要性。

详细讲解

在自适应对话策略中,Q-learning算法的工作原理如下:

- 初始化Q表:Q表是一个二维数组,用于存储每个状态和动作组合的Q值。

- 选择动作:在每个对话步骤中,根据当前状态和Q表选择一个动作。可以使用 ϵ\epsilonϵ-贪心策略,即有一定的概率(ϵ\epsilonϵ)随机选择一个动作,以探索新的策略;否则选择Q值最大的动作。

- 执行动作并更新Q表:执行选择的动作,获取奖励和新状态,然后根据Q-learning更新公式更新Q表。

- 重复步骤2和3,直到对话结束。

举例说明

假设我们有一个简单的对话系统,状态空间 S={s1,s2,s3}S = \{s_1, s_2, s_3\}S={s1,s2,s3},动作空间 A={a1,a2}A = \{a_1, a_2\}A={a1,a2}。初始时,Q表如下:

| 状态 | a1a_1a1 | a2a_2a2 |

|---|---|---|

| s1s_1s1 | 0 | 0 |

| s2s_2s2 | 0 | 0 |

| s3s_3s3 | 0 | 0 |

当前状态 st=s1s_t = s_1st=s1,选择动作 at=a1a_t = a_1at=a1,执行动作后转移到状态 st+1=s2s_{t+1} = s_2st+1=s2,获得奖励 R(s1,a1,s2)=1R(s_1, a_1, s_2) = 1R(s1,a1,s2)=1。假设学习率 α=0.1\alpha = 0.1α=0.1,折扣率 γ=0.9\gamma = 0.9γ=0.9。

根据Q-learning更新公式:

Q(s1,a1)←Q(s1,a1)+0.1[1+0.9maxaQ(s2,a)−Q(s1,a1)] Q(s_1, a_1) \leftarrow Q(s_1, a_1) + 0.1 [1 + 0.9 \max_{a} Q(s_2, a) - Q(s_1, a_1)] Q(s1,a1)←Q(s1,a1)+0.1[1+0.9amaxQ(s2,a)−Q(s1,a1)]

由于 Q(s2,a1)=Q(s2,a2)=0Q(s_2, a_1) = Q(s_2, a_2) = 0Q(s2,a1)=Q(s2,a2)=0,则:

Q(s1,a1)←0+0.1[1+0.9×0−0]=0.1 Q(s_1, a_1) \leftarrow 0 + 0.1 [1 + 0.9 \times 0 - 0] = 0.1 Q(s1,a1)←0+0.1[1+0.9×0−0]=0.1

更新后的Q表如下:

| 状态 | a1a_1a1 | a2a_2a2 |

|---|---|---|

| s1s_1s1 | 0.1 | 0 |

| s2s_2s2 | 0 | 0 |

| s3s_3s3 | 0 | 0 |

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

操作系统

可以选择Windows、Linux或macOS等操作系统。建议使用Linux系统,因为它在开发和部署方面具有更好的稳定性和兼容性。

Python环境

安装Python 3.7及以上版本。可以使用Anaconda来管理Python环境,它提供了方便的包管理和虚拟环境创建功能。

相关库

安装以下Python库:

numpy:用于数值计算。pytorch:用于深度学习模型的开发和训练。transformers:用于自然语言处理任务,提供了预训练的语言模型。

可以使用以下命令安装这些库:

pip install numpy torch transformers

5.2 源代码详细实现和代码解读

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

# 加载预训练的语言模型和分词器

tokenizer = AutoTokenizer.from_pretrained("gpt2")

model = AutoModelForCausalLM.from_pretrained("gpt2")

# 定义自适应对话策略函数

def adaptive_dialogue(user_input, history=[]):

# 将用户输入和历史对话拼接成输入文本

input_text = " ".join(history + [user_input])

# 对输入文本进行分词

input_ids = tokenizer.encode(input_text, return_tensors="pt")

# 生成回复

output = model.generate(input_ids, max_length=100, num_beams=5, no_repeat_ngram_size=2, early_stopping=True)

# 解码生成的回复

response = tokenizer.decode(output[0], skip_special_tokens=True)

# 提取回复内容(去除输入文本)

response = response[len(input_text):].strip()

# 更新历史对话

history.append(user_input)

history.append(response)

return response, history

# 模拟对话过程

history = []

while True:

user_input = input("你: ")

if user_input.lower() == "退出":

break

response, history = adaptive_dialogue(user_input, history)

print("AI: ", response)

代码解读与分析

加载预训练的语言模型和分词器

tokenizer = AutoTokenizer.from_pretrained("gpt2")

model = AutoModelForCausalLM.from_pretrained("gpt2")

使用transformers库加载预训练的GPT-2语言模型和对应的分词器。

定义自适应对话策略函数

def adaptive_dialogue(user_input, history=[]):

input_text = " ".join(history + [user_input])

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids, max_length=100, num_beams=5, no_repeat_ngram_size=2, early_stopping=True)

response = tokenizer.decode(output[0], skip_special_tokens=True)

response = response[len(input_text):].strip()

history.append(user_input)

history.append(response)

return response, history

input_text:将用户输入和历史对话拼接成输入文本,以便模型能够考虑对话的上下文。input_ids:对输入文本进行分词,并转换为模型可以接受的张量形式。output:使用模型生成回复,设置了最大长度、束搜索数量、避免重复的n-gram等参数。response:解码生成的回复,并去除输入文本,得到最终的回复内容。history:更新历史对话,将用户输入和回复添加到历史记录中。

模拟对话过程

history = []

while True:

user_input = input("你: ")

if user_input.lower() == "退出":

break

response, history = adaptive_dialogue(user_input, history)

print("AI: ", response)

通过一个循环不断接收用户输入,调用adaptive_dialogue函数生成回复,并将回复输出给用户。当用户输入“退出”时,结束对话。

6. 实际应用场景

智能客服

在智能客服场景中,自适应对话策略可以帮助AI Agent更好地理解用户的问题,并根据用户的反馈动态调整回复策略。例如,当用户对某个产品的功能不太清楚时,AI Agent可以通过追问策略获取更多的信息,然后提供详细的解答;当用户对解答不满意时,AI Agent可以尝试提供其他的解决方案或转移话题,以提高用户的满意度。

智能助手

智能助手如语音助手、聊天机器人等也可以应用自适应对话策略。智能助手可以根据用户的使用习惯和偏好,调整对话风格和回复内容。例如,对于喜欢简洁回答的用户,智能助手可以提供简短明了的回复;对于喜欢详细信息的用户,智能助手可以提供更丰富的内容。

教育领域

在教育领域,自适应对话策略可以用于智能辅导系统。智能辅导系统可以根据学生的学习进度和问题,提供个性化的辅导和建议。例如,当学生在某个知识点上遇到困难时,智能辅导系统可以通过追问策略了解学生的困惑所在,然后提供针对性的讲解和练习。

医疗领域

在医疗领域,自适应对话策略可以用于智能医疗咨询系统。智能医疗咨询系统可以根据患者的症状描述,进行初步的诊断和建议。如果患者的描述不清晰,系统可以通过追问策略获取更多的信息,以提高诊断的准确性。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《自然语言处理入门》:这本书系统地介绍了自然语言处理的基本概念、算法和应用,适合初学者入门。

- 《深度学习》:深度学习是自适应对话策略的重要技术基础,这本书对深度学习的理论和实践进行了全面的介绍。

- 《强化学习:原理与Python实现》:强化学习是实现自适应对话策略的核心算法,这本书详细讲解了强化学习的原理和Python实现方法。

7.1.2 在线课程

- Coursera上的“自然语言处理专项课程”:由知名教授授课,涵盖了自然语言处理的各个方面,包括词法分析、句法分析、语义理解等。

- edX上的“深度学习基础”:介绍了深度学习的基本概念、算法和应用,为学习自适应对话策略提供了理论基础。

- Udemy上的“强化学习实战”:通过实际案例讲解强化学习的应用,帮助学习者掌握强化学习的实践技能。

7.1.3 技术博客和网站

- 机器之心:提供了丰富的AI技术资讯和深度文章,包括自然语言处理、强化学习等领域的最新研究成果。

- 开源中国:是国内知名的开源技术社区,有很多关于AI开发的技术文章和经验分享。

- Medium:是一个全球知名的技术博客平台,有很多AI领域的专家分享自己的研究成果和实践经验。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:是一款专业的Python集成开发环境,提供了丰富的代码编辑、调试和项目管理功能。

- Visual Studio Code:是一款轻量级的代码编辑器,支持多种编程语言和插件扩展,适合快速开发和调试。

7.2.2 调试和性能分析工具

- TensorBoard:是TensorFlow提供的可视化工具,可以用于查看模型的训练过程、损失函数变化等信息。

- Py-Spy:是一个Python性能分析工具,可以帮助开发者找出代码中的性能瓶颈。

7.2.3 相关框架和库

- Transformers:是Hugging Face开发的自然语言处理框架,提供了丰富的预训练模型和工具,方便开发者进行自然语言处理任务的开发。

- Stable Baselines3:是一个基于PyTorch的强化学习库,提供了多种强化学习算法的实现,方便开发者进行强化学习模型的训练和评估。

7.3 相关论文著作推荐

7.3.1 经典论文

- 《Attention Is All You Need》:提出了Transformer模型,是自然语言处理领域的经典论文,为后续的预训练语言模型发展奠定了基础。

- 《Q-Learning》:介绍了Q-learning算法,是强化学习领域的经典论文。

7.3.2 最新研究成果

- 《Improving Language Understanding by Generative Pre-Training》:介绍了GPT模型的预训练方法,开启了预训练语言模型的新时代。

- 《Proximal Policy Optimization Algorithms》:提出了近端策略优化算法(PPO),是一种高效的强化学习算法。

7.3.3 应用案例分析

- 《Dialogue Systems for Conversational AI》:分析了对话系统在人工智能领域的应用案例,包括智能客服、智能助手等。

- 《Adaptive Dialogue Strategies in Healthcare Chatbots》:研究了自适应对话策略在医疗聊天机器人中的应用。

8. 总结:未来发展趋势与挑战

未来发展趋势

多模态交互

未来的AI Agent将不仅仅局限于文本交互,还将支持语音、图像、视频等多模态交互方式。自适应对话策略需要能够处理多模态信息,根据不同的模态信息动态调整对话策略。

个性化交互

随着用户数据的不断积累,AI Agent将能够更好地了解用户的个性化需求和偏好。自适应对话策略将更加注重个性化交互,为每个用户提供量身定制的对话体验。

跨领域应用

自适应对话策略将在更多的领域得到应用,如金融、交通、娱乐等。不同领域的对话场景和用户需求各不相同,需要开发更加通用和灵活的自适应对话策略。

挑战

数据质量和数量

自适应对话策略的训练需要大量高质量的数据。然而,在实际应用中,数据的收集和标注往往是一个难题。数据质量不高或数量不足会影响模型的性能和泛化能力。

模型可解释性

深度学习模型在自适应对话策略中得到了广泛应用,但这些模型往往是黑盒模型,缺乏可解释性。在一些关键领域,如医疗、金融等,模型的可解释性是非常重要的。

伦理和安全问题

随着AI Agent的广泛应用,伦理和安全问题也日益凸显。例如,AI Agent可能会生成虚假信息、传播不良内容等。自适应对话策略需要考虑如何避免这些问题的发生。

9. 附录:常见问题与解答

问题1:自适应对话策略需要大量的训练数据吗?

是的,自适应对话策略通常需要大量的训练数据来学习不同的对话场景和策略。训练数据的质量和数量会直接影响模型的性能和泛化能力。可以通过收集真实的对话数据、使用数据增强技术等方法来获取更多的训练数据。

问题2:如何评估自适应对话策略的效果?

可以从多个方面评估自适应对话策略的效果,如回答的准确性、相关性、灵活性、友好性等。可以使用人工评估和自动评估相结合的方法。人工评估可以邀请专业人员或普通用户对对话结果进行打分;自动评估可以使用一些指标,如准确率、召回率、F1值等。

问题3:自适应对话策略可以应用于实时对话系统吗?

可以,自适应对话策略可以应用于实时对话系统。但需要考虑模型的推理速度和性能,以确保能够在短时间内生成回复。可以使用一些优化技术,如模型压缩、量化等,来提高模型的推理速度。

问题4:如何处理用户的模糊提问?

当遇到用户的模糊提问时,自适应对话策略可以采用追问策略,向用户询问更多的信息,以明确问题的含义。例如,可以询问用户具体的需求、背景信息等。

10. 扩展阅读 & 参考资料

扩展阅读

- 《自然语言处理:从理论到实践》:深入介绍了自然语言处理的各种技术和应用,包括文本分类、情感分析、机器翻译等。

- 《强化学习实战:基于Python和TensorFlow》:通过实际案例详细讲解了强化学习的应用,包括游戏、机器人控制等领域。

参考资料

- Hugging Face官方文档:https://huggingface.co/docs

- Stable Baselines3官方文档:https://stable-baselines3.readthedocs.io/en/master/

- 《人工智能:一种现代方法》:全面介绍了人工智能的基本概念、算法和应用,是人工智能领域的经典教材。

更多推荐

已为社区贡献76条内容

已为社区贡献76条内容

所有评论(0)