模型版本迭代中的回归测试策略

摘要:回归测试是保障AI模型迭代质量的关键,能减少70%以上的回归问题。核心策略包括:1)风险驱动测试优先级,聚焦高影响模块;2)动态管理测试用例,建立分层自动化体系;3)环境数据治理,使用容器化和合成数据。实践表明,结合CI/CD流程和智能测试选择技术,可提升40%资源效率,缩短30%发布周期。未来需融合AI测试生成等技术,构建持续质量防线。(149字)

回归测试在模型迭代中的核心价值

在人工智能与机器学习模型快速演进的今天,软件系统频繁更新已成为常态。每一次模型版本迭代——无论是参数调整、架构优化还是新功能引入——都可能引入意想不到的副作用,导致原有功能衰退。回归测试作为软件质量保障的基石,其目标是验证新变更未破坏现有行为的正确性。对于测试从业者而言,在资源有限、交付周期紧张的背景下,设计高效的回归测试策略至关重要。根据行业调查,超过60%的软件缺陷源于迭代过程中的回归问题,而有效的回归测试可将此类问题减少70%以上。

回归测试策略的设计原则

-

风险驱动测试优先级

-

核心逻辑识别:首先需确定系统中高风险模块,例如与用户交互紧密的预测接口、数据预处理管道等。例如,在图像分类模型迭代中,分类器的输出一致性比辅助日志模块更具测试优先权。

-

影响范围分析:通过依赖图或代码变更关联工具(如CodeQL)量化修改影响,优先覆盖受影响的功能路径。实践表明,结合代码覆盖率工具(如JaCoCo)与业务场景评估,可将测试资源集中度提升40%。

-

-

测试用例的动态管理

-

基线用例库维护:建立版本化的测试用例集,使用标签分类(如“冒烟测试”“全量回归”)。对于模型服务,需包含数据漂移检测用例、API兼容性验证用例等。

-

自动化分层策略:

-

单元层:针对模型核心算法(如梯度计算逻辑)设计高频率执行的测试;

-

集成层:验证多个模块协作,例如模型服务与数据库的交互;

-

系统层:通过端到端测试模拟用户场景,例如推荐系统的A/B测试流水线。

-

-

-

环境与数据治理

-

版本化测试环境:为每个模型版本构建隔离的测试环境,避免环境配置差异导致的假阳性结果。使用容器化技术(如Docker)可快速复制生产环境状态。

-

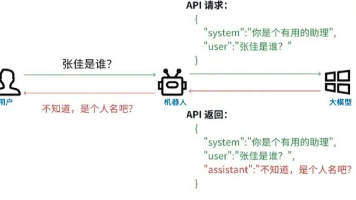

数据合成与采样:针对模型特性,生成边界值数据(如极端输入范围)与代表性生产数据样本。例如,在自然语言处理模型中,需覆盖多语言、特殊字符等 Corner Case。

-

自动化与持续测试的实践路径

-

流水线集成

-

在CI/CD流程中嵌入回归测试阶段,设置质量门禁(如测试通过率≥95%)。工具链示例:Jenkins调度测试任务,Allure生成可视化报告,Prometheus监控测试稳定性。

-

采用智能测试选择技术:仅运行与代码变更相关的测试用例,减少反馈时间。研究显示,此法可降低80%的非必要测试执行。

-

-

指标化评估体系

-

定义关键质量指标:

-

缺陷逃逸率(衡量遗漏至生产的缺陷比例);

-

测试稳定性(Flaky Test发生率);

-

回归捕获时效(从问题引入到发现的平均周期)。

-

-

建立测试看板,实时追踪指标趋势,驱动策略迭代。例如,某金融科技团队通过监控模型预测精度回归指标,将线上事故减少了50%。

-

-

团队协作与知识沉淀

-

测试用例评审机制:邀请开发、产品经理共同确认用例覆盖的业务场景,避免理解偏差。

-

文档化策略:记录每次迭代的测试范围决策逻辑,形成可复用的模式库。

-

案例:推荐系统模型升级的回归测试实践

某电商平台在升级深度学习推荐模型时,面临亿级用户数据的回归验证挑战。团队采用如下方案:

-

策略设计:

-

高风险区域:排序算法、实时特征工程模块;

-

中风险区域:用户画像更新逻辑;

-

低风险区域:离线数据分析脚本。

-

-

执行与优化:

-

使用Selenium与PyTest自动化核心场景,每日夜间执行;

-

针对数据 pipeline,设计差异对比工具,检测特征分布变化;

-

结果:在3次重大版本迭代中,回归测试提前发现4个关键缺陷,发布周期缩短30%。

-

总结与未来展望

回归测试不仅是技术活动,更是质量文化的体现。面对模型复杂度的持续增长,测试团队需拥抱策略创新——例如结合AI的智能测试生成、 chaos engineering 验证系统容错性。唯有将回归测试融入 DevOps 生命周期的每一环节,方能在高速迭代中筑起可靠的质量防线。

精选文章

更多推荐

已为社区贡献174条内容

已为社区贡献174条内容

所有评论(0)