基于七元组架构的自然语言驱动数据更新系统:NL2API技术深度研究报告

虽然图灵机也被定义为7元组 $M = \langle Q, \Gamma, b, \Sigma, \delta, q_0, F \rangle$ 9,但在智能体(Agent)上下文中,我们采用POMDP的定义 $\mathcal{M} = \langle S, A, T, R, \Omega, O, \gamma \rangle$ 1。7元组元素符号数学定义NL2API 数据更新场景中的业务映射状

1. 执行摘要与技术范式转型

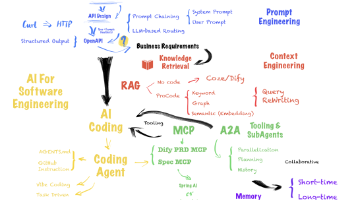

随着大语言模型(LLM)从单纯的文本生成器向能够执行复杂任务的智能体(Agent)演进,软件交互范式正经历着从图形用户界面(GUI)向语言用户界面(LUI)的根本性变革。本报告针对特定技术需求——即引入自然语言到API(NL2API)技术,将历史数据重构为“七元组”结构,并实现通过自然语言指令更新数据库——进行了详尽的深度研究与架构设计。

在传统的软件工程中,数据更新(Update)操作通常受到严格的表单验证和硬编码逻辑的约束。然而,用户提出的“通过自然语言说我要更新某个数据”的需求,实质上要求构建一个具备语义理解、状态感知和执行决策能力的智能体系统。这不仅涉及自然语言处理(NLP),更深入到了部分可观测马尔可夫决策过程(POMDP)的数学领域 。

本报告的核心论点是:要实现安全、精准的自然语言数据更新,不能仅依赖通用的聊天机器人模型,而必须构建一个基于7元组(7-tuple)理论模型的专用架构。这个7元组在数学上对应于 POMDP 的 $langle S, A, T, R, \Omega, O, \gamma \rangle$,在工程实现上则对应于微调数据的七维特征向量。

在开源技术选型方面,报告通过对比分析得出结论:应采用Gorilla LLM(OpenFunctions v2)作为核心推理引擎,因其在API调用参数生成的准确性上通过了专门的微调训练 ;同时推荐使用LlamaIndex或LangGraph作为编排框架,以管理复杂的状态流转和人机回环(Human-in-the-Loop)的安全验证机制 。

报告将详细阐述如何进行“数据考古”,即从旧有的系统日志和数据库事务中提取并重构出7元组数据,用于模型的少样本学习(Few-Shot Learning)或全量微调(Fine-Tuning)。这一过程将静态的“死数据”转化为具备因果逻辑链的“活轨迹”,赋予智能体理解业务逻辑的能力。

2. 理论框架:作为POMDP代理的NL2API系统

要实现“用户说更新数据,系统调用API更新”这一目标,必须首先建立严谨的理论模型。在人工智能领域,处理不确定性环境交互的标准模型是部分可观测马尔可夫决策过程(POMDP)。用户提到的“7元组”并非随意的数据格式,而是描述智能体与环境(数据库)交互的数学公理。

2.1 7元组的数学定义与业务映射

虽然图灵机也被定义为7元组 $M = \langle Q, \Gamma, b, \Sigma, \delta, q_0, F \rangle$ 9,但在智能体(Agent)上下文中,我们采用POMDP的定义 $\mathcal{M} = \langle S, A, T, R, \Omega, O, \gamma \rangle$ 1。

这一数学模型与本项目的业务目标存在精确的同构关系:

| 7元组元素 | 符号 | 数学定义 | NL2API 数据更新场景中的业务映射 |

| 状态 (State) | $S$ | 环境的真实状态 | 数据库的当前快照。智能体无法一次性“看见”整个TB级数据库,因此它是部分可观测的。$S$ 包含了需要更新的目标行(Row)及其当前值。 |

| 动作 (Action) | $A$ | 智能体可选的动作集合 | API 接口集合。即系统暴露给智能体的所有RESTful API(如 POST /update_user, PUT /inventory)。NL2API的核心就是从 $A$ 中选择正确的 $a$ 并填充参数。 |

| 转移 (Transition) | $T$ | $T(s' \mid s, a)$:状态转移概率 | 业务逻辑与数据库约束。当执行 update_user 后,数据库从状态 $s$ 变为 $s'$(例如字段值改变)。这是不可逆的“写”操作。 |

| 奖励 (Reward) | $R$ | $R(s, a)$:即时奖励函数 | 执行结果反馈。若API返回 200 OK 且数据更新正确,则 $R>0$;若API报错或导致数据不一致,则 $R<0$。这是训练智能体避免错误操作的关键信号。 |

| 观测空间 (Observation Space) | $\Omega$ | 所有可能的观测集合 | API 响应模式 (Schema)。包括HTTP状态码、返回的JSON结构、错误信息等。 |

| 观测 (Observation) | $O$ | $O(o \mid s', a)$:观测概率 | 具体的 API 响应数据。智能体执行动作后,不仅看状态码,还要解析返回的JSON(如 {"id": 123, "status": "updated"})来更新其对世界的认知。 |

| 折扣因子 (Discount Factor) | $\gamma$ | $\gamma \in $:未来奖励权重 | 多轮对话的连续性。在复杂的更新任务中(如“先查询再更新”),智能体需要权衡当前查询的成本与最终更新成功的价值。 |

2.2 为什么“更新”操作必须基于7元组?

用户特别强调“更新数据”(Update Data)。与只读的检索增强生成(RAG)不同,写操作具有副作用(Side Effects)。

-

状态依赖性(State Dependency): 更新操作的合法性依赖于当前状态 $S$。例如,不能更新一个不存在的ID,也不能将库存更新为负数。7元组模型强制智能体在行动前考虑 $S$ 2。

-

部分可观测性(Partial Observability): LLM 的上下文窗口有限,无法加载整个数据库。它只能通过 API 调用的返回值 $O$ 来推断 $S$。这种“管中窥豹”的特性正是 POMDP 解决的核心问题 2。

-

动作空间的精确性(Action Precision): NL2API 不是模糊生成,而是精确调用。如果模型生成了错误的参数(如将

user_id填错),后果是灾难性的。7元组中的 $A$ 明确界定了允许的操作边界。

2.3 数据工程视角下的“7元组”

除了运行时的理论模型,用户提到的“将旧数据做成7元组”通常指微调(Fine-Tuning)或上下文学习(In-Context Learning)的数据格式。为了训练一个能执行上述 POMDP 逻辑的模型,我们需要将历史日志转化为以下结构的轨迹(Trajectory):

$$\text{DataTuple} = \langle \text{Instruction}, \text{Context}, \text{Thought}, \text{Tool}, \text{Args}, \text{Observation}, \text{Response} \rangle$$

这与 ToolBench、Gorilla 或 FireAct 等前沿数据集的格式高度一致 14。后文将详细阐述如何构建这一数据结构。

3. 开源技术生态深度评测与选型

用户询问:“应该用哪一个?有没有开源的库?”

当前的开源生态中,NL2API(或称为 Tool Use, Function Calling)已经分化为多个细分赛道。针对“数据更新”这一高风险操作,我们必须选择具备参数强校验和逻辑推理能力的库。

以下是对主流开源方案的深度横向评测:

3.1 核心模型层(The Brain):Gorilla LLM

Gorilla 是由加州大学伯克利分校(UC Berkeley)开发的一系列专门针对 API 调用进行微调的模型 。

-

技术优势:

-

幻觉抑制(Hallucination Reduction): 通用模型(如 Llama 2)在生成 JSON 参数时经常会臆造不存在的字段(例如给不接受

force参数的 API 加上force=true)。Gorilla 通过在大规模 API 数据集(APIBench)上的微调,显著降低了语法和参数错误率 。 -

约束感知(Constraint Awareness): Gorilla 能够理解 API 文档中的约束条件(如“该字段仅接受 'a', 'b' 枚举值”),这对于数据库更新操作至关重要 。

-

OpenFunctions v2: 其最新版本支持多步调用和并行调用,能够处理“先查询ID,再更新数据”的复合指令 。

-

-

适用性: 极高。它是目前开源界实现 NL2API 最精准的模型之一,特别适合作为系统的推理核心。

3.2 编排框架层(The Body):LlamaIndex vs. LangChain

仅有模型是不够的,还需要一个框架来管理上下文、连接数据库和执行代码。

3.2.1 LlamaIndex

LlamaIndex 以其强大的数据连接能力著称。

-

核心特性: 提供

FunctionTool抽象,允许开发者将任意 Python 函数封装为工具。其OpenAIAgent和ReActAgent内置了完整的“思考-行动-观察”循环 。 -

NL2API 支持: LlamaIndex 的

ObjIndex可以索引海量的 API 定义,并在运行时根据用户指令动态检索最相关的 API 注入到上下文,解决了 API 数量过多的问题 。 -

推荐指数: ⭐⭐⭐⭐⭐(构建数据密集型 Agent 的首选)。

3.2.2 LangChain / LangGraph

LangChain 是最流行的应用框架,而 LangGraph 则是其针对复杂 Agent 推出的状态机库。

-

核心特性:

LangGraph允许开发者显式定义 Agent 的状态流转图(Nodes & Edges)。这对于“更新”操作非常有用,因为你可以定义一个强制的“人工确认”节点(Human-in-the-Loop),确保在写入数据库前必须经过审核 。 -

推荐指数: ⭐⭐⭐⭐⭐(如果业务逻辑非常复杂,需要严格的状态控制)。

3.3 其他备选方案

-

NexusRaven-V2: 这是一个 13B 参数的模型,专门针对函数调用微调。它在处理嵌套函数调用(例如

update(get_id(name)))方面表现出色,如果你的 API 参数依赖性很强,这是一个强力的备选 。 -

ToolBench (ToolLLM): 这是一个研究项目,提供了包含 16,000+ API 的数据集和微调流程。如果你需要从零开始训练一个私有模型来理解极其特殊的内部 API,可以参考其数据构造管线 。

3.4 最终选型建议

针对用户的“旧数据转7元组 + NL2API 更新”需求,建议采用 “三明治”架构:

-

顶层框架(Orchestration): 使用 LlamaIndex 或 LangGraph。它们提供了现成的 Agent 循环和内存管理。

-

推理核心(Inference): 集成 Gorilla OpenFunctions v2。由于它对 API 定义的理解更深刻,能极大减少更新操作中的参数错误。

-

底层数据(Data): 构建符合 ToolBench/Gorilla 格式的 7元组数据集,用于微调或上下文增强。

4. 数据工程详解:将“旧数据”重构为7元组

这是用户技术目标的第一步,也是最具挑战性的一步。如何将历史的“死”日志转化为智能体可学习的“活”7元组?这一过程被称为轨迹挖掘(Trajectory Mining)或事后重标记(Hindsight Relabeling)。

4.1 目标数据结构:训练用的7元组

为了让模型学会如何更新数据,我们需要构建如下结构的 JSONL 数据:

| 字段名 | 含义 | 对应 POMDP | 内容示例 |

| Instruction | 用户指令 | - | “将用户 Alice 的邮箱更新为 alice@new.com” |

| Context | 初始状态 | $S$ | {"user_id": 88, "name": "Alice", "email": "alice@old.com"} |

| Thought | 思维链 | - | “用户想要更新邮箱。首先我需要确认用户 ID。根据上下文,Alice 的 ID 是 88。我应该使用 update_user 工具。” |

| Tool | 工具名称 | $A$ | api_update_user_profile |

| Args | 工具参数 | $A$ | {"uid": 88, "email": "alice@new.com"} |

| Observation | API返回 | $O$ | {"status": 200, "msg": "Update success"} |

| Response | 最终回复 | $R$ | “已成功将 Alice 的邮箱更新为 alice@new.com。” |

4.2 数据挖掘流水线(Pipeline)

假设我们拥有旧系统的 SQL 事务日志(Transaction Logs) 或 应用审计日志(Audit Logs),重构流程如下:

步骤 1:动作提取(Action Extraction)

从日志中提取出所有的写操作(INSERT/UPDATE/DELETE)。

-

原始日志:

2023-10-01 10:00:00 [INFO] User Admin executed UPDATE users SET status='active' WHERE id=501 -

提取出的 Tool:

update_user_status -

提取出的 Args:

{"id": 501, "status": "active"}

步骤 2:状态回溯(State Replay)

这是最难的一步。我们需要知道在执行上述 SQL 之前,数据库的状态是什么。

-

方法: 利用数据库的

Undo Logs或Binlogs,或者如果系统支持时间旅行查询(Time-travel query),查询 $T_{-1}$ 时刻的数据。 -

生成的 Context:

{"id": 501, "name": "Bob", "status": "inactive"} -

洞察: 如果没有旧状态,模型就无法学习“状态依赖性”(即为什么要把 inactive 改为 active)。

步骤 3:指令合成(Instruction Synthesis)

旧日志中没有自然语言指令。我们需要使用一个强大的教师模型(Teacher Model,如 GPT-4)进行反向生成。

-

Prompt: “给定一个数据库操作

UPDATE users SET status='active' WHERE id=501,请生成 3 个用户可能会说的自然语言指令。” -

生成结果:

-

“激活用户 501 的账号。”

-

“把 Bob (ID 501) 的状态设为 active。”

-

“解除用户 501 的封禁。”

-

步骤 4:思维链补全(Reasoning Completion)

为了增强模型的逻辑能力,我们需要合成“Thought”部分。

-

Prompt: “作为一个智能助手,你接到了指令‘激活用户 501’,并拥有工具

update_user。请写出你的思考过程。” -

生成结果: “用户意图是修改账号状态。我已获取目标 ID 为 501。检查工具库,发现

update_user支持修改状态字段。因此我将调用该工具。”

4.3 数据集的应用

生成数千条这样的 7元组数据后,有三种用法:

-

全量微调(Full Fine-Tuning): 使用如 Llama-Factory 等框架,将基础模型(如 Llama 3)微调为领域专用的 NL2API 模型。这效果最好,但成本最高。

-

LoRA 微调: 仅训练低秩适配器,保留基座能力。适合中等数据量。

-

少样本提示(Few-Shot Prompting): 将最相似的 5 个 7元组作为 Prompt 放入上下文。这是由 RAG 驱动的,即在运行时检索相似的历史操作记录供模型参考 19。

5. 架构设计:构建安全的“自然语言更新”系统

有了模型和数据,下一步是搭建运行时系统。对于“更新”操作,安全性是第一要素。

5.1 系统拓扑图

系统由四个核心组件构成:

-

感知层(Perception): 接收用户 NL 指令,检索上下文(Schema + RAG Memories)。

-

决策层(Decision - The 7-Tuple Brain): Gorilla/Fine-tuned Model。输入 $I, S$,输出 $T, Ag$。

-

安全层(Safety - The Governor): 校验参数,执行人机回环(HITL)。

-

执行层(Execution): 实际调用 REST API 更新数据库,并返回 $O$。

5.2 关键技术实现细节

5.2.1 状态感知的 Schema 注入

模型必须知道 API 的定义。不要直接把几千个 API 扔给模型。

-

技术: 使用 LlamaIndex 的

VectorStoreIndex索引所有 API 的 OpenAPI Spec。 -

流程: 用户提问 -> 检索 Top-5 相关 API -> 将这些 API 的 JSON Schema 放入 Prompt 的 System Message 中。这被称为 Retriever-Aware Training (RAT) 或 RAG for Tools 19。

5.2.2 幻觉防火墙(Hallucination Firewall)

在执行 API 调用前,必须进行严格的参数校验。

-

实现: 使用 Pydantic 模型定义 API 参数结构。

-

逻辑:

Pythonclass UpdateUserSchema(BaseModel): user_id: int email: EmailStr # 自动校验邮箱格式 role: Literal["admin", "user", "guest"] # 强制枚举值 try: # 尝试将 LLM 的输出解析为 Pydantic 对象 args = UpdateUserSchema(**llm_output) except ValidationError as e: # 如果校验失败,将错误信息作为 Observation 反馈给 LLM,让其重试 return f"Error: {e}. Please fix the arguments."

这种机制利用 Python 的强类型系统来弥补 LLM 的概率性缺陷 。

5.2.3 人机回环(Human-in-the-Loop, HITL)

对于所有“写”操作(POST/PUT/DELETE),系统不得自动执行。

-

架构模式: 采用 LangGraph 的

interrupt_before机制 。 -

工作流:

-

Agent 生成 API 调用请求

Request(tool='update', args={...})。 -

系统检测到这是一个敏感操作(Write),触发 中断(Interrupt)。

-

系统将“拟执行计划”以自然语言展示给用户:“我准备将用户 88 的邮箱改为 test@test.com。是否确认?”

-

系统挂起,保存当前状态快照(Checkpoint)。

-

用户点击“确认”。

-

系统恢复(Resume),执行 API 调用。

-

5.3 事务回滚与原子性

如果在 NL2API 执行过程中发生错误(如网络中断),必须保证数据的一致性。

-

建议: 所有的 API 应当设计为**幂等(Idempotent)**的。即重复调用三次

update_email产生的结果与调用一次相同。 -

实现: 在 7元组的 $A$(Action)设计中,引入

transaction_id,确保每个自然语言指令对应唯一的事务 ID。

6. 代码实现指南:从理论到实践

本节提供基于 Python 的核心实现片段,展示如何将 Gorilla、LlamaIndex 和 7元组数据结合。

6.1 定义数据结构(The 7-Tuple)

Python

from pydantic import BaseModel

from typing import Dict, Optional

class AgentTrajectory7Tuple(BaseModel):

"""

对应 POMDP: <S, A, T, R, Omega, O, Gamma>

用于数据收集和微调的数据结构。

"""

instruction: str # 用户指令

input_state: Dict # S: 执行前的数据库/上下文快照

thought_trace: str # CoT: 推理过程

tool_name: str # A: 选择的 API 名称

tool_args: Dict # A: 生成的参数

observation: Dict # O: API 返回结果

final_response: str # R: 给用户的最终回复

6.2 封装更新工具(The Update Tool)

使用 LlamaIndex 的 FunctionTool 封装更新逻辑。

Python

from llama_index.core.tools import FunctionTool

def update_product_price(product_id: int, new_price: float) -> str:

"""

更新产品的价格。这是一个写操作。

"""

# 1. 模拟数据库连接

# db = connect_db()

# 2. (可选) 检查前置条件 S (State Check)

# current_product = db.get(product_id)

# if not current_product: return "Error: Product not found."

# 3. 执行更新 T (Transition)

# db.execute("UPDATE products SET price=? WHERE id=?", (new_price, product_id))

# 4. 返回观测值 O (Observation)

return f"Success: Product {product_id} price updated to {new_price}."

# 创建工具

update_tool = FunctionTool.from_defaults(fn=update_product_price)

6.3 集成 Gorilla 模型

Python

from llama_index.llms.huggingface import HuggingFaceLLM

# 加载 Gorilla OpenFunctions v2

# 注意:这通常需要 GPU。如果在 CPU 环境,建议使用量化版或 vLLM 服务。

llm = HuggingFaceLLM(

model_name="gorilla-llm/gorilla-openfunctions-v2",

tokenizer_name="gorilla-llm/gorilla-openfunctions-v2",

context_window=4096,

max_new_tokens=512,

generate_kwargs={"temperature": 0.1}, # 低温度以保证参数生成的确定性

device_map="auto",

)

6.4 构建 Agent 循环

Python

from llama_index.core.agent import ReActAgent

# 初始化 Agent

agent = ReActAgent.from_tools(

tools=[update_tool],

llm=llm,

verbose=True, # 打印详细的 7元组 交互过程

max_iterations=10

)

# 执行任务

# 用户指令:我要更新某个数据

response = agent.chat("把 ID 为 101 的产品价格更新为 29.99")

print(response)

7. 深入洞察:被忽视的二阶效应与未来趋势

7.1 “语义编译器”的崛起

NL2API 技术的本质是将自然语言作为一种高级编程语言,而 LLM 则是编译器,API 是机器码。

-

洞察: 就像编译器需要类型检查一样,NL2API 系统需要语义检查。未来会出现专门针对 Prompt 的 CI/CD 流程,在代码部署前,自动化测试“自然语言指令”是否能正确编译为“API 调用” 33。

7.2 数据的“可供性(Affordance)”

将旧数据做成 7元组不仅仅是为了训练,它改变了数据的性质。

-

洞察: 传统的日志是结果导向的(记录了发生了什么)。7元组数据是意图导向的(记录了为什么发生)。这种数据资产的价值远高于原始日志,因为它可以被用来训练预测用户意图的模型,甚至用于自动化流程挖掘(Process Mining)。

7.3 从 RAG 到 LAM (Large Action Models)

当前的行业重心正从 RAG(检索信息)向 LAM(执行动作)转移。

-

趋势: 您的项目正处于这一趋势的前沿。未来的数据库不仅提供 SQL 接口,将原生集成 Agent 接口。Oracle 和 Databricks 等巨头已经开始在数据库内核中集成自然语言层 。这意味着“7元组架构”可能在未来几年内成为数据库中间件的标准配置。

8. 结论与实施建议

针对您的技术目标,本报告得出以下结论:

-

架构定调: 您的项目应被定义为一个 POMDP 智能体系统。请务必严格遵守 $\langle S, A, T, R, \Omega, O, \gamma \rangle$ 的 7元组设计原则,特别是在处理“状态观测”和“动作奖励”时,这是系统稳定性的基石。

-

数据策略: “将旧数据做成7元组”是项目的核心资产。建议开发一个自动化的 ETL 流水线,利用 GPT-4 将历史日志反向工程为

(Instruction, State, Tool, Args)格式的 JSONL 数据。这部分数据将决定系统的上限。 -

技术栈选择:

-

推理模型: 强烈推荐 Gorilla OpenFunctions v2,它是目前开源界处理 API 参数最严谨的模型。

-

编排框架: 选择 LlamaIndex 以快速落地,或 LangGraph 以实现更细粒度的安全控制(HITL)。

-

-

安全红线: 对于“更新”操作,必须在架构层面强制实施**“规划-审批-执行”**的三步走策略,杜绝 LLM 直接操作数据库的写权限。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)