机器学习:Python汽车销量分析预测系统 AI大模型 评论情感分析 爬虫 朴素贝叶斯分类 Flask框架 毕业设计

机器学习:Python汽车销量分析预测系统 AI大模型 评论情感分析 爬虫 朴素贝叶斯分类 Flask框架 毕业设计

博主介绍:✌全网粉丝50W+,前互联网大厂软件研发、集结硕博英豪成立软件开发工作室,专注于计算机相关专业项目实战6年之久,累计开发项目作品上万套。凭借丰富的经验与专业实力,已帮助成千上万的学生顺利毕业,选择我们,就是选择放心、选择安心毕业✌

> 🍅想要获取完整文章或者源码,或者代做,拉到文章底部即可与我联系了。🍅🍅感兴趣的可以先收藏起来,点赞、关注不迷路,大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助同学们顺利毕业 。🍅

1、毕业设计:2026年计算机专业毕业设计选题汇总(建议收藏)✅

1、项目介绍

技术栈:

python语言、Flask框架、requests爬虫、线性回归预测算法、Echarts可视化、情感分析、朴素贝叶斯分类器

汽车销售数据分析与预测系统功能模块介绍

本系统基于Flask框架搭建,整合爬虫、机器学习、数据可视化与情感分析技术,构建了一套覆盖数据采集、分析、预测、管理全流程的汽车销售数据分析体系,核心功能模块如下:

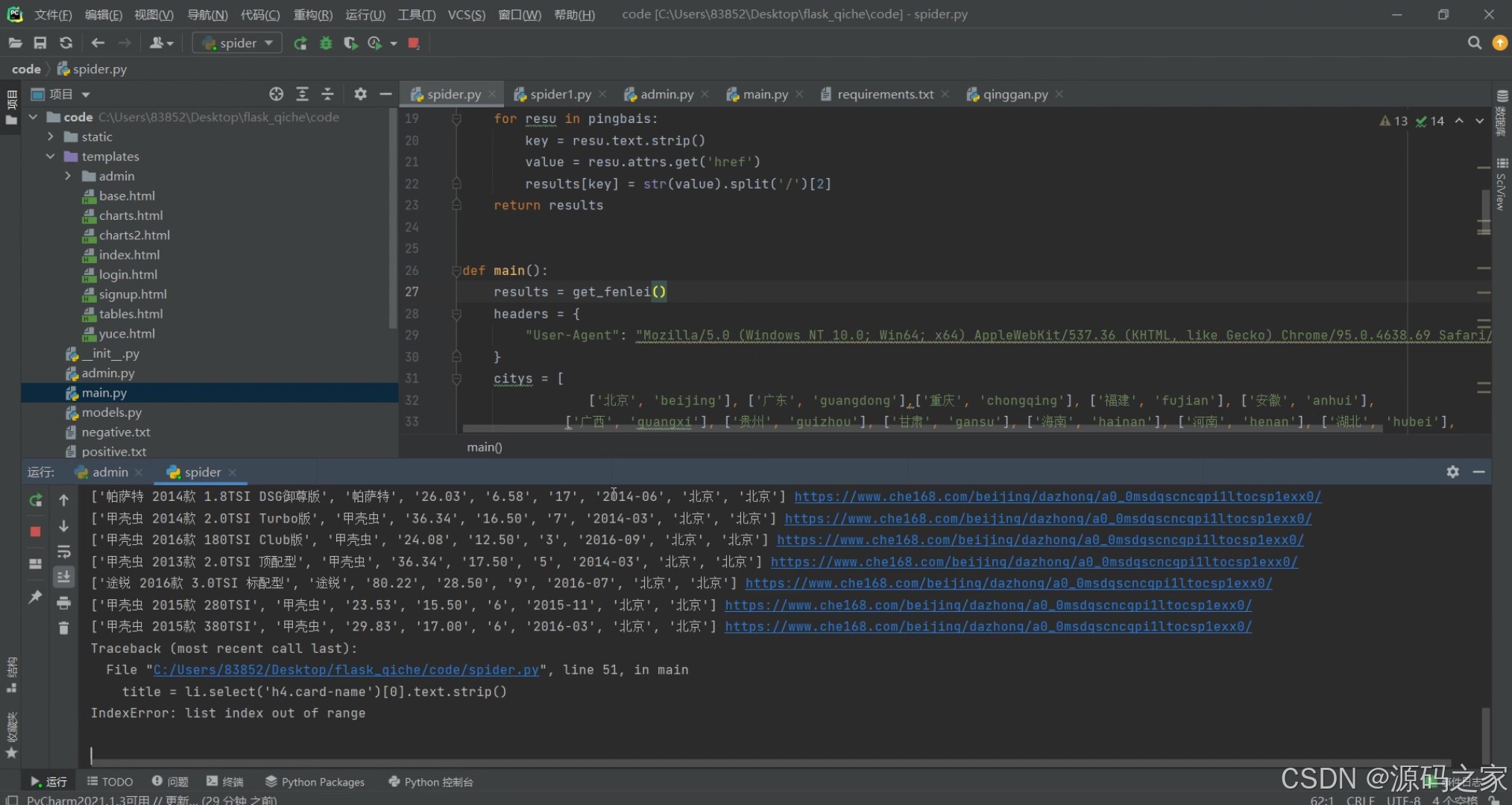

数据采集模块是系统的数据基础,通过requests库编写爬虫脚本,自动抓取汽车销售平台的销量数据、车辆行驶里程与价格关联数据、用户评论等核心信息,支持定时增量采集,保障数据的实时性与完整性,为后续分析提供可靠数据源。

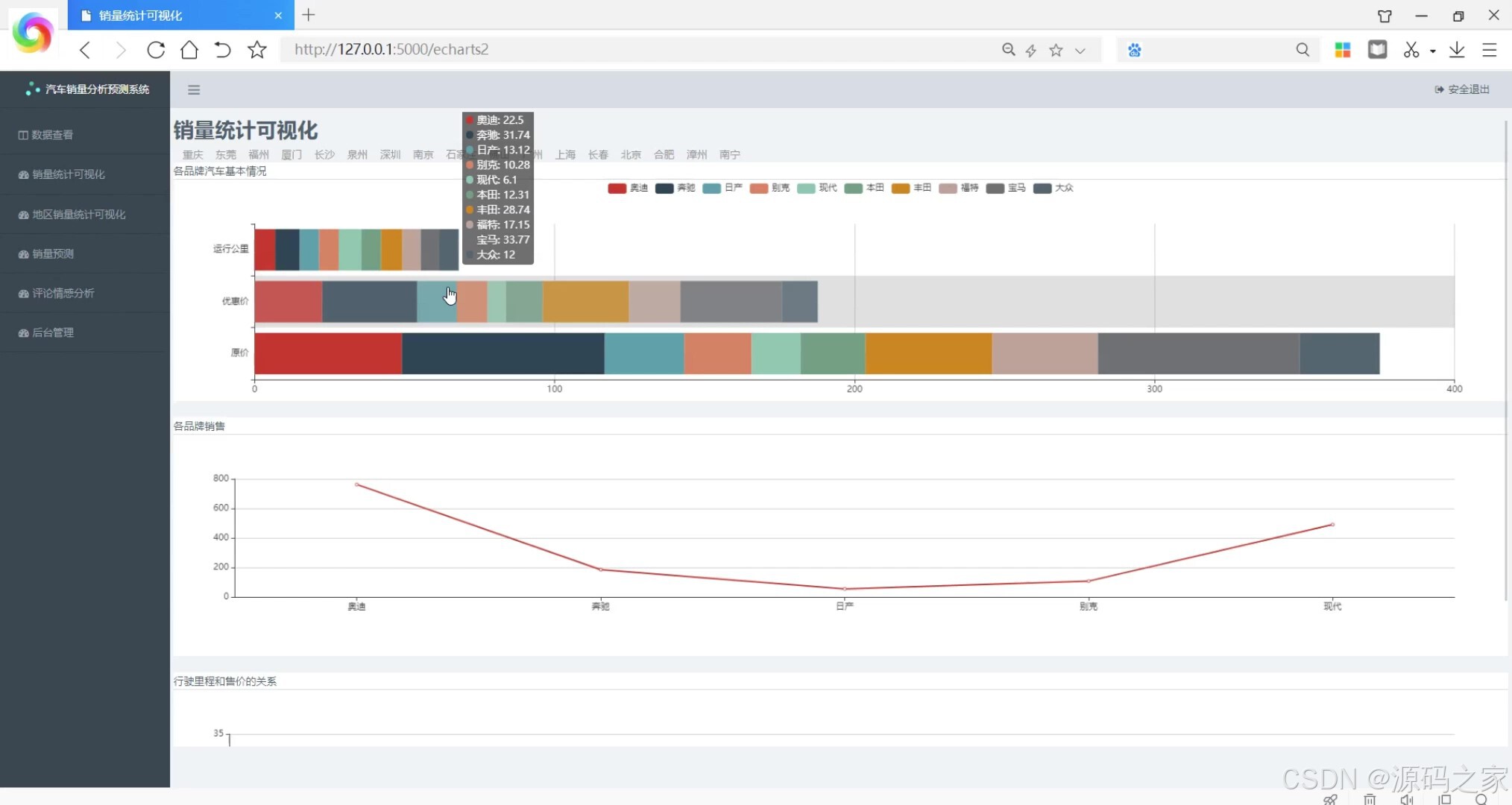

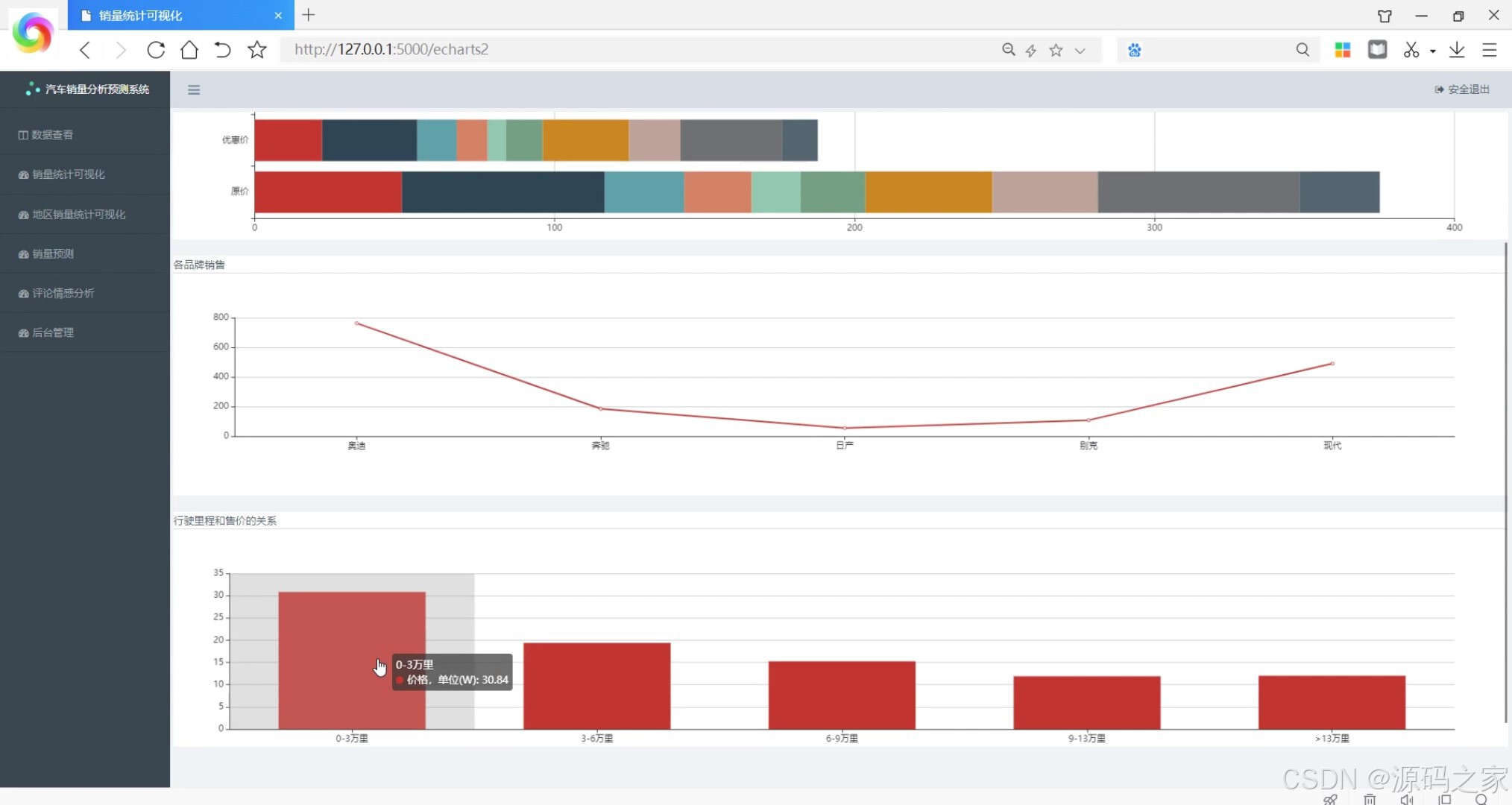

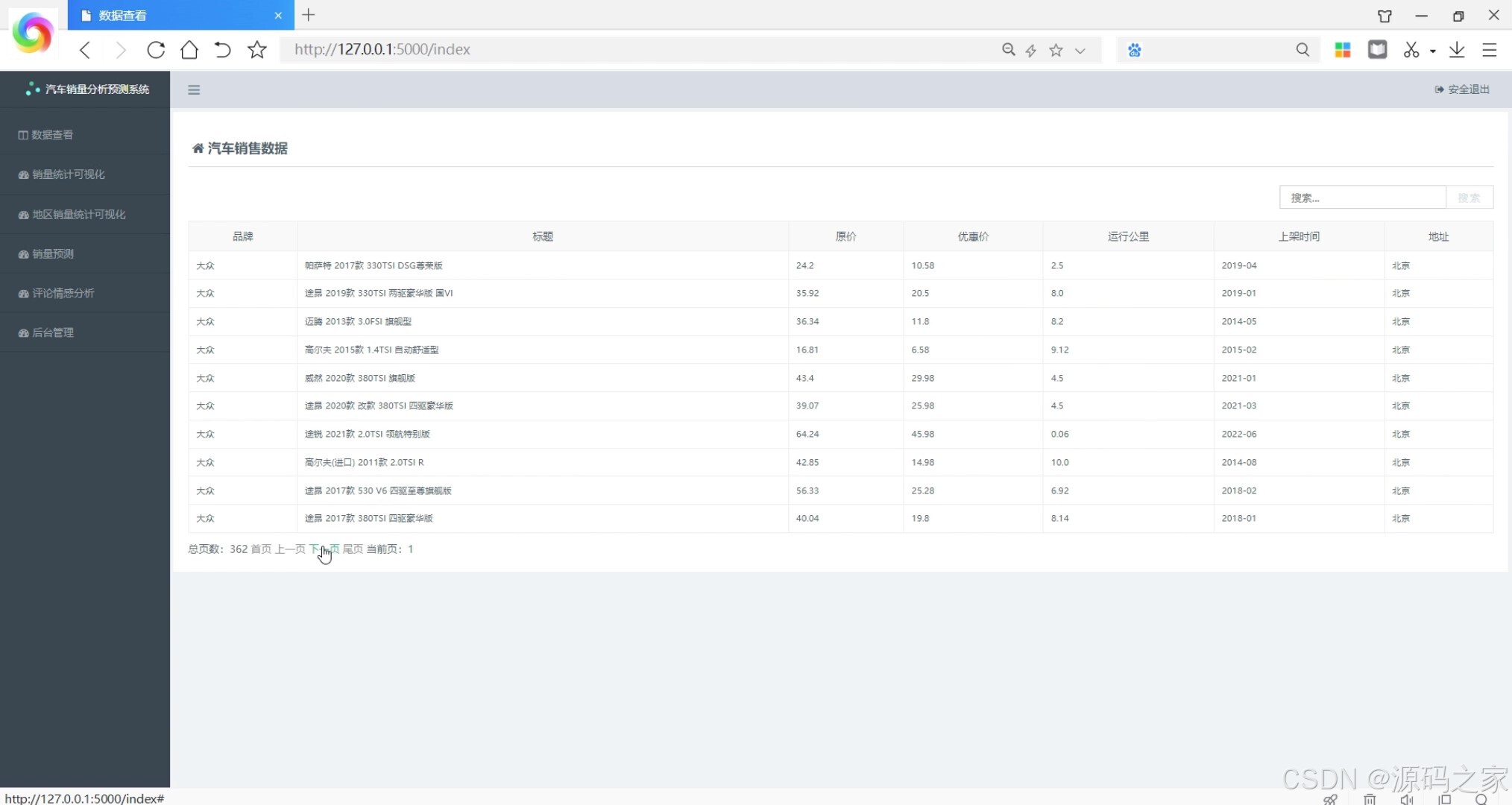

数据可视化模块借助Echarts实现多维度数据展示:销量统计分析可视化模块将销量数据以柱状图、折线图等形式呈现,直观展示不同时段、车型的销量趋势;行驶里程与价格关系模块通过散点图拟合二者关联规律,清晰呈现里程对二手车价格的影响;汽车销售数据模块则以表格+图表结合的方式,展示车型、价格、销量等核心维度的明细与汇总数据。

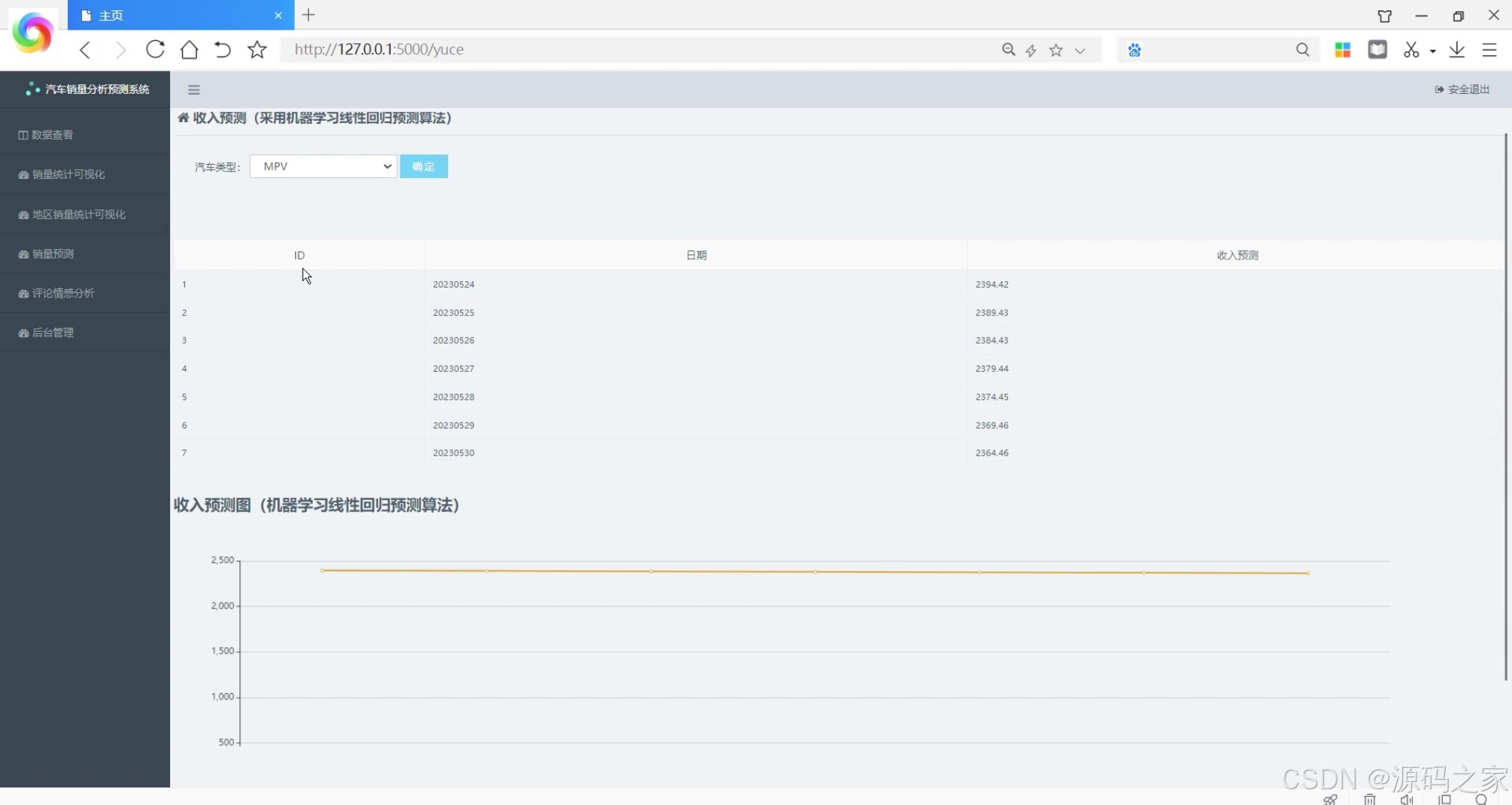

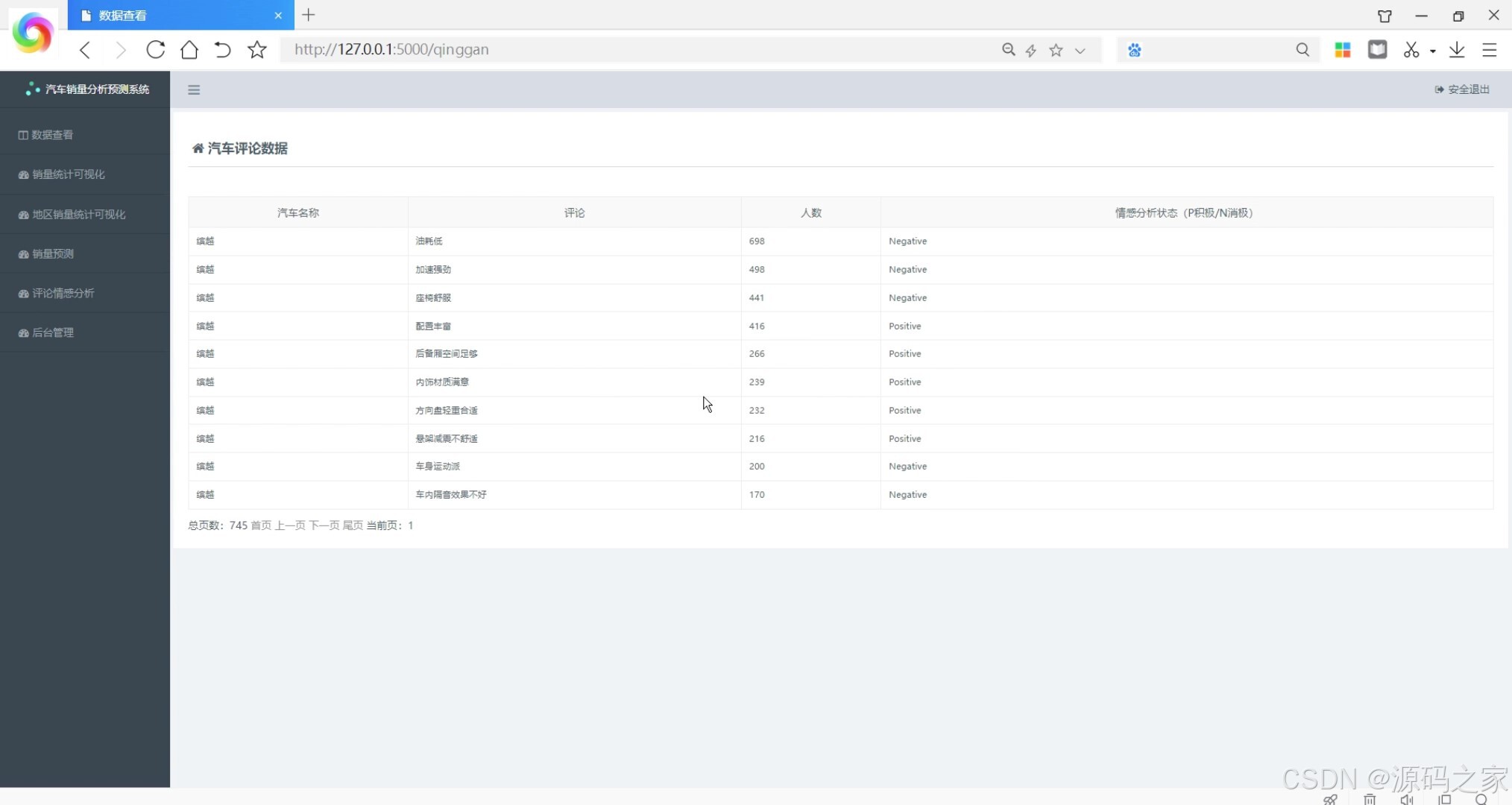

预测分析模块集成线性回归算法,基于历史销售数据构建收入预测模型,输入里程、车型、市场环境等特征参数,可精准预测未来销售收入,为经营决策提供量化依据;评论情感分析模块采用朴素贝叶斯分类器,对用户评论进行情感倾向判定,区分正面、负面评价,挖掘用户需求与产品痛点。

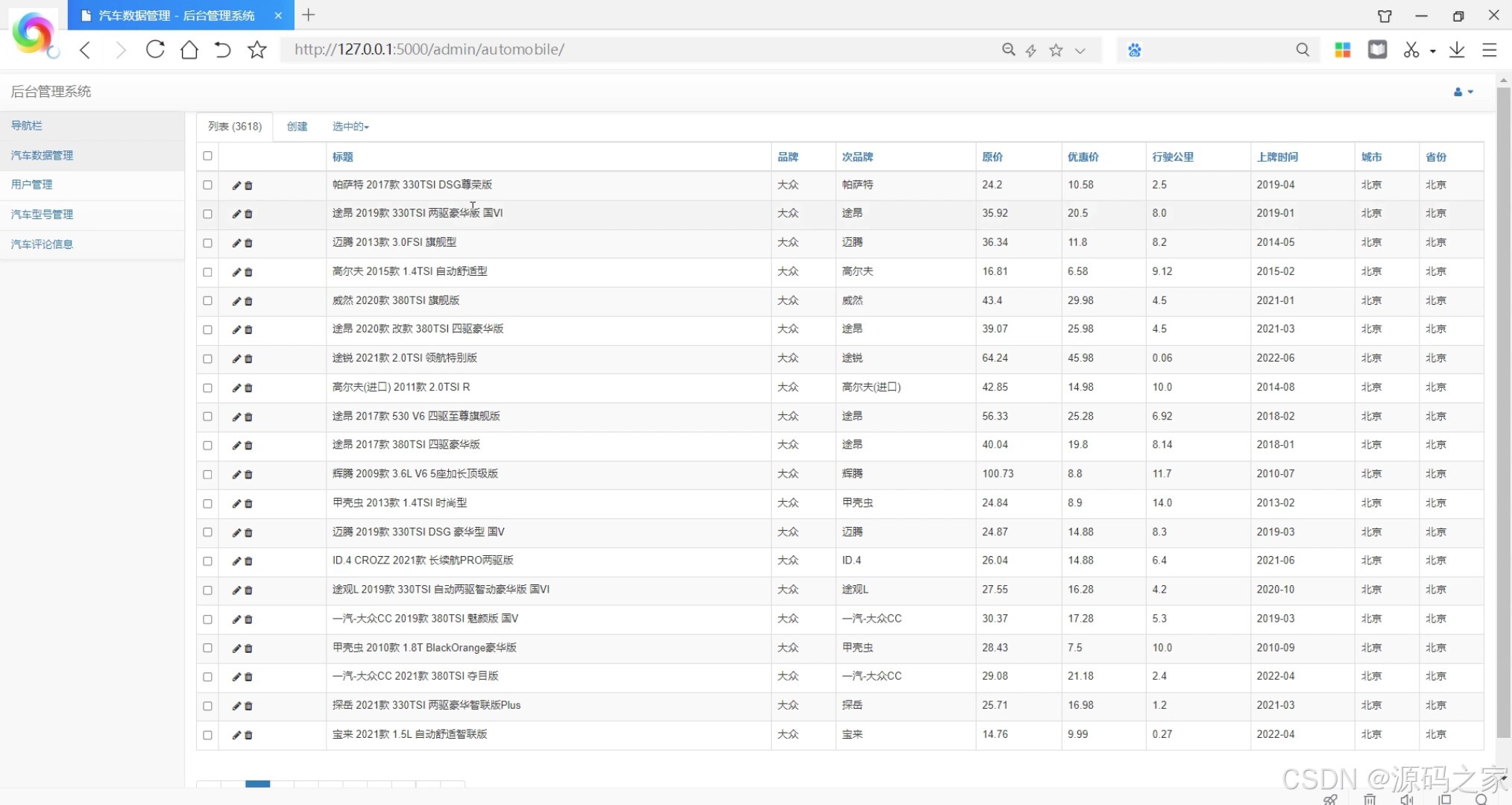

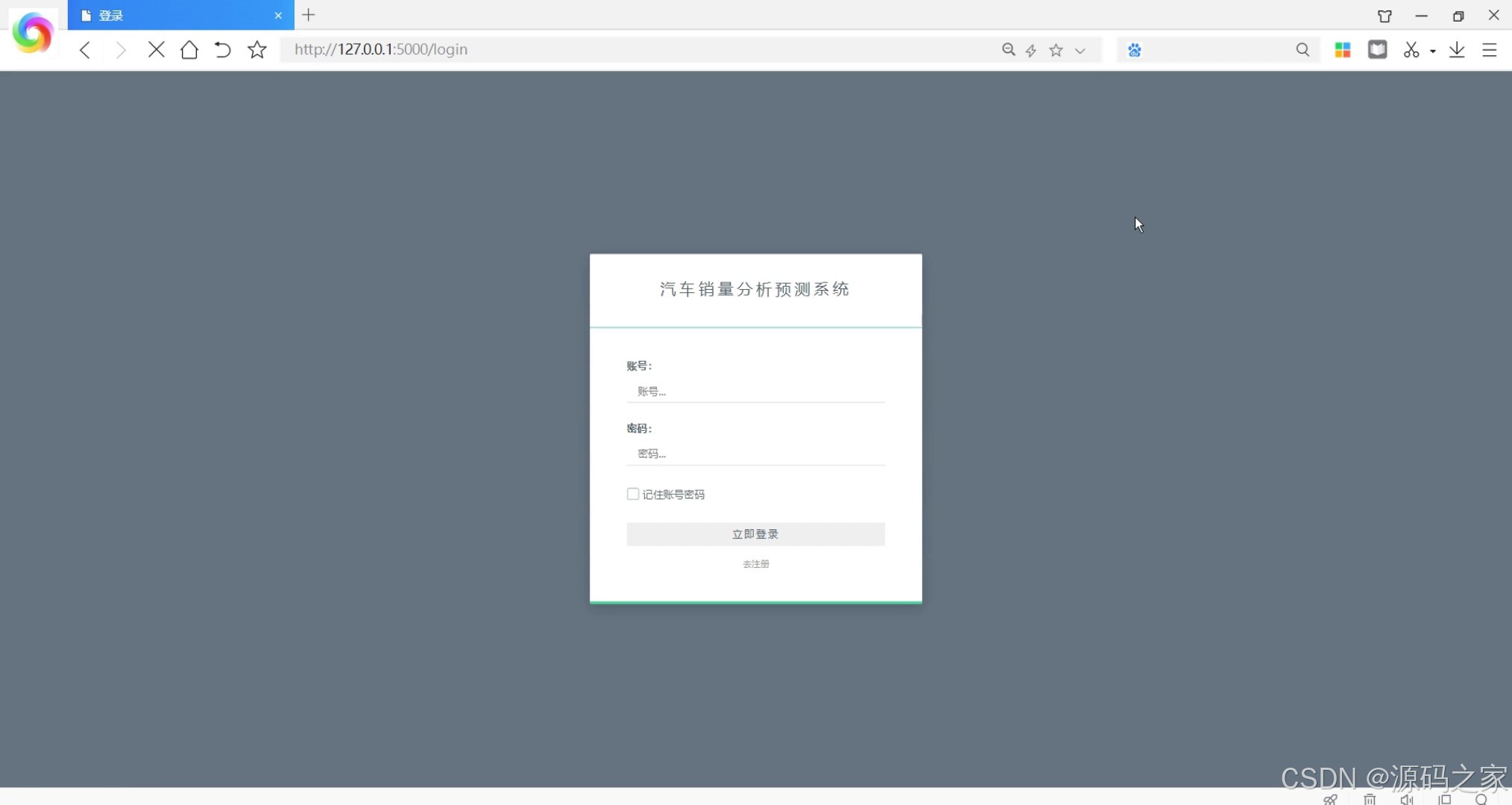

系统管理模块包含后台数据管理与用户权限控制:后台数据管理支持对采集的销售数据、评论数据进行增删改查、清洗与校验,保障数据质量;注册登录界面实现用户账号管理,不同角色可分配差异化操作权限,确保系统数据安全。

整体而言,系统打通了“数据采集-分析可视化-智能预测-管理维护”的闭环,为汽车销售行业的经营分析、决策制定提供了全方位的技术支撑。

2、项目界面

(1)销量统计分析可视化

(2)行驶里程与价格的关系

(3)汽车销售数据

(4)收入预测—机器学习线性回归预测算法

(5)汽车评论数据

(6)后台数据管理

(7)注册登录界面

(8)数据采集

3、项目说明

对于"Flask汽车销量分析预测+评论情感系统",您可以使用以下技术栈来实现:

Flask框架:作为后端框架,用于搭建Web应用程序的后端服务,处理前端请求并与数据库进行交互。

requests爬虫:用于从汽车之家网等网站上爬取汽车相关数据,包括销量数据和用户评论数据。

线性回归预测算法:通过对历史汽车销量数据进行线性回归分析,可以建立销量预测模型,基于现有的特征(如时间、价格、促销活动等)来预测未来的销量趋势。

Echarts可视化:使用Echarts库来创建可视化图表,将预测的销量数据以折线图或柱状图的形式展示在前端页面上,帮助用户直观地理解销量趋势。

情感分析:使用情感分析算法(如基于机器学习的朴素贝叶斯分类器)对用户评论进行情感分类,判断评论是积极的、消极的还是中性的。这可以帮助企业了解消费者对汽车的态度和情感倾向。

通过以上技术栈的组合,您可以搭建一个综合的汽车销量分析预测和评论情感分析系统。用户可以通过系统获取汽车销量预测结果,并查看对应的评论情感分析,以便更好地了解市场需求和产品口碑。

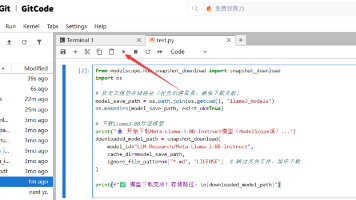

4、核心代码

# coding:utf-8

import nltk

# nltk.download()

import nltk.classify.util

from nltk.classify import NaiveBayesClassifier

from nltk.corpus import movie_reviews

import jieba

import models

# 分析句子的情感:情感分析是NLP最受欢迎的应用之一。情感分析是指确定一段给定的文本是积极还是消极的过程。

# 有一些场景中,我们还会将“中性“作为第三个选项。情感分析常用于发现人们对于一个特定主题的看法。

# 定义一个用于提取特征的函数

# 输入一段文本返回形如:{'It': True, 'movie': True, 'amazing': True, 'is': True, 'an': True}

# 返回类型是一个dict

def extract_features(word_list):

return dict([(word, True) for word in word_list])

def stopwordslist():

stopwords = [line.strip() for line in open('stopwords.txt', 'r', encoding='utf-8').readlines()]

return stopwords

# 我们需要训练数据,这里将用NLTK提供的评论数据

if __name__ == '__main__':

# 加载积极与消极评论

# positive_fileids = movie_reviews.fileids('pos') # list类型 1000条数据 每一条是一个txt文件

# negative_fileids = movie_reviews.fileids('neg')

# print(type(positive_fileids), len(negative_fileids))

# 将这些评论数据分成积极评论和消极评论

# movie_reviews.words(fileids=[f])表示每一个txt文本里面的内容,结果是单词的列表:['films', 'adapted', 'from', 'comic', 'books', 'have', ...]

# features_positive 结果为一个list

# 结果形如:[({'shakesp: True, 'limit': True, 'mouth': True, ..., 'such': True, 'prophetic': True}, 'Positive'), ..., ({...}, 'Positive'), ...]

features_positive = []

with open('positive.txt', 'r', encoding='utf-8')as f:

results = f.readlines()

for f in results:

# print(({f.strip():True}, 'Positive'))

features_positive.append(({f.strip(): True}, 'Positive'))

features_negative = []

with open('negative.txt', 'r', encoding='utf-8')as f:

results = f.readlines()

for f in results:

# print(({f.strip():True}, 'Positive'))

features_negative.append(({f.strip(): True}, 'Negative'))

# 分成训练数据集(80%)和测试数据集(20%)

threshold_factor = 0.8

threshold_positive = int(threshold_factor * len(features_positive)) # 800

threshold_negative = int(threshold_factor * len(features_negative)) # 800

# 提取特征 800个积极文本800个消极文本构成训练集 200+200构成测试文本

features_train = features_positive[:threshold_positive] + features_negative[:threshold_negative]

features_test = features_positive[threshold_positive:] + features_negative[threshold_negative:]

print("\n训练数据点的数量:", len(features_train))

print("测试数据点的数量:", len(features_test))

# 训练朴素贝叶斯分类器

classifier = NaiveBayesClassifier.train(features_train)

print("\n分类器的准确性:", nltk.classify.util.accuracy(classifier, features_test))

print("\n十大信息最丰富的单词:")

for item in classifier.most_informative_features()[:10]:

print(item[0])

# 输入一些简单的评论

input_reviews = [

"XXXXX",

]

datas = models.PingLun.query.all()

# 运行分类器,获得预测结果

print("\n预测:")

stopwords = stopwordslist() # 这里加载停用词的路径

for review1 in datas:

review = review1.content

segtmp = jieba.lcut(review, cut_all=False) # 把句子进行分词,以列表的形式返回

outstr = []

for word in segtmp:

if word not in stopwords:

if word != '\t':

if word != ' ' and word != '\n':

outstr.append(word.strip())

print("\n评论:", review)

probdist = classifier.prob_classify(extract_features(outstr))

pred_sentiment = probdist.max()

# 打印输出

print("预测情绪:", pred_sentiment)

print("可能性:", round(probdist.prob(pred_sentiment), 2))

review1.status = pred_sentiment

models.db.session.commit()

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目编程以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

5、源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

更多推荐

已为社区贡献42条内容

已为社区贡献42条内容

所有评论(0)