Agent 产品的交互设计实践

这篇文章将结合AI 落地中的实际观察与案例,聊聊:•什么样的 Agent 才叫“好”?•企业里做 Agent 产品时,有哪些必备的体验设计原则?•一个 Agent 的使用过程分成哪三个关键阶段?每个阶段的交互挑战是什么?•结合Datadog、Atlassian Rovo、v0.app 等10 多个产品案例,看看这些挑战如何应对

作者KK——Thoughtworks首席产品经理、总监咨询顾问

20年以上跨行业的大型企业产品管理经验,当前专注于AI创新咨询和解决方案设计,在金融/制造/汽车/零售等10+企业客户协助进行AI 场景探索及演进规划、Agent产品落地实施及知识工程的推进。她创立了「AI2.0 时代的产品经理」主站,设计开发了「产品经理 AI 搭子」和「AI创新加速器」工具箱以及「AI2.0 产品落地实践指南」,并持续更新「Agent 产品交互设计小站」。

▼

前段时间,我们聊过「AI 项目为什么常常落地不佳」。很多伙伴说深有同感——技术能力强不强是一回事,但让用户愿意长期使用、让业务真正受益,又是另一件更难的事。

这篇文章将结合AI 落地中的实际观察与案例,聊聊:

-

什么样的 Agent 才叫“好”?

-

企业里做 Agent 产品时,有哪些必备的体验设计原则?

-

一个 Agent 的使用过程分成哪三个关键阶段?每个阶段的交互挑战是什么?

-

结合Datadog、Atlassian Rovo、v0.app 等10 多个产品案例,看看这些挑战如何应对。

1、 Agent产品的交互设计原则和挑战

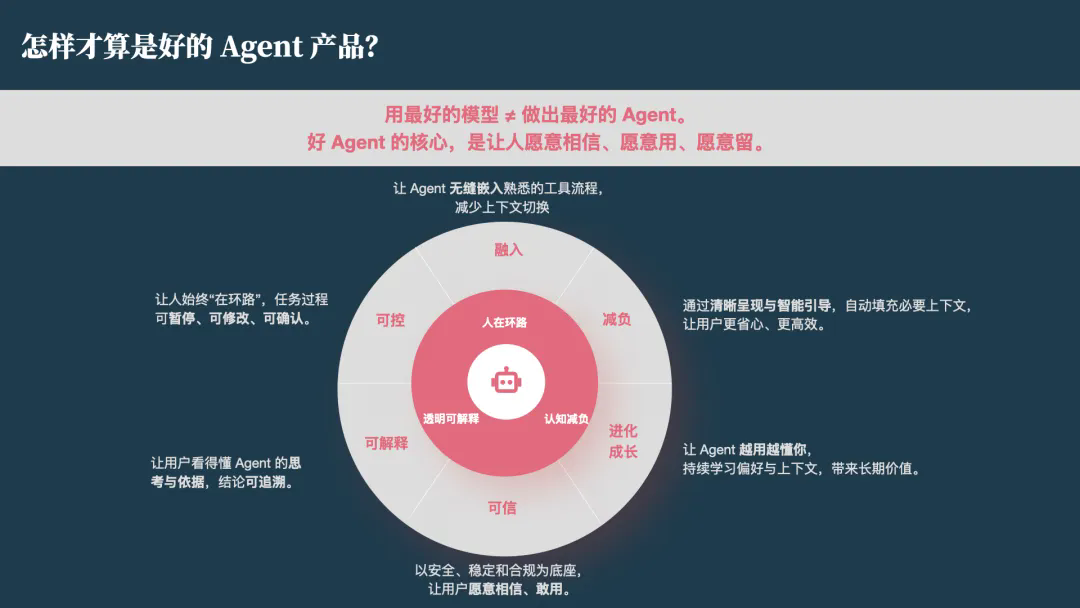

在 Software 3.0 的语境下,有了强大的模型和技术,并不等于就有了最好的 Agent。一个“好 Agent”的核心,是让人愿意相信、愿意用、愿意留。

我们将 Agent 产品的体验设计原则总结为三大基石:透明可释、认知减负、人在环路。

👉 原则 1:透明可释

用户最大的恐惧在于“黑盒”。Agent 在做什么?为什么这么做?依据是什么?

好的交互必须让 Agent 的思考过程外显。如果 Agent 得出一个结论,用户必须能看到背后的证据链和推导逻辑。只有看得懂,才能建立信任。

👉 原则 2:认知减负

AI 的价值在于提效,如果它让用户增加了记忆负担或操作复杂度,那就是本末倒置。

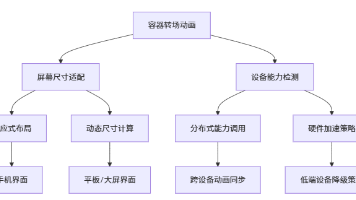

好的 Agent 懂得“自动建议”和“环境适配”。它应该自动读取上下文,不让用户重复输入;它应该无缝嵌入用户原本的工具链中,而不是强迫用户在多个窗口间来回切换。

👉 原则 3:人在环路

企业级 Agent 不追求“全自动驾驶”,而要追求“可控的自主”。 用户必须始终掌握控制权。任务执行中,人可以随时暂停、修改、确认,或者仅仅是看着它跑。智能不是越自动越好,而是越可控越好。

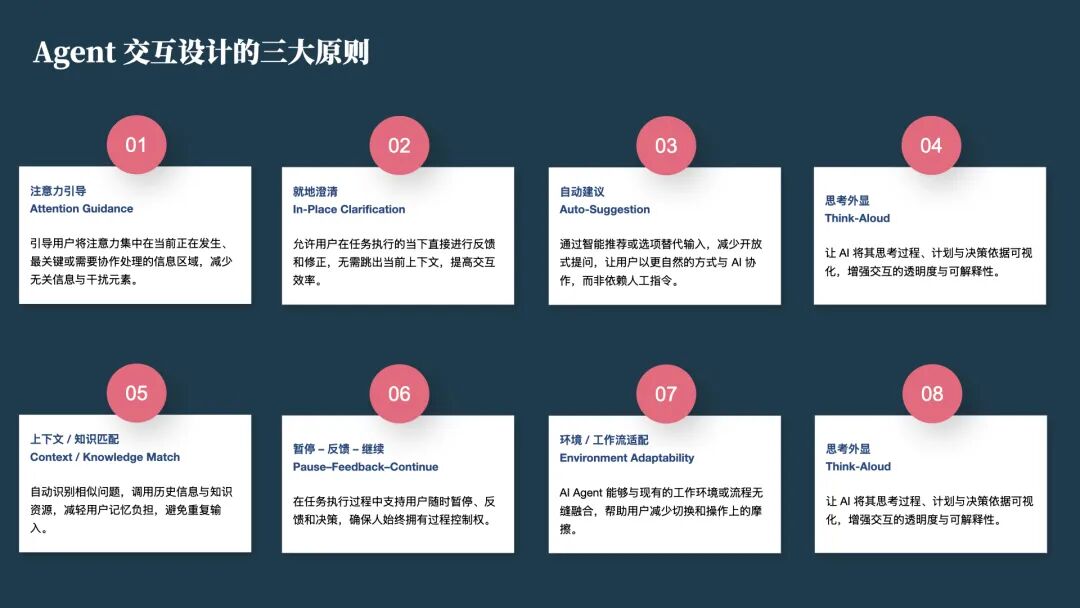

优秀的Agent 产品快速迭代演进。从这些快速演进的产品中,我们看到了 8 个常用的交互设计模式:注意力引导、就地澄清、自动建议、思考外显、上下文/知识匹配、暂停-反馈-继续、环境/工作流适配、自主性滑竿。

下面来结合案例对这些设计模式进行拆解。

2、 Agent 产品案例及设计模式应用拆解

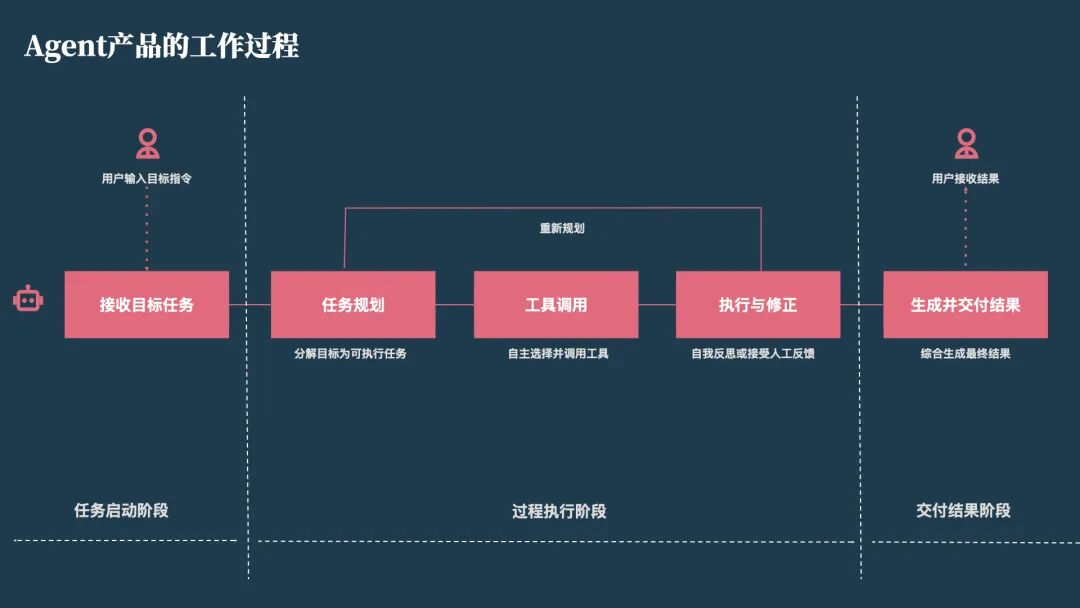

一个 Agent 的完整使用过程,可以认为是个“三段式旅程”:

任务启动(Start):唤起 Agent + 让它理解你的任务

过程执行(Execute):规划、推理、调用工具、反思

结果交付(Deliver):输出结果、修改、复用、版本管理

我们发现,每一个阶段都有其独特的“劝退点”。接下来,我们将逐一拆解这些阶段面临的核心挑战,并结合行业标杆案例,看看它们是如何通过特定的“交互设计模式”被解决的。

2.1 任务启动阶段

在这个阶段,用户最常见的心态是迷茫:不知道 Agent 能干什么,也不知道该怎么下指令。

🚩 核心挑战:

-

上手门槛:如何让用户轻松上手,解决“空白框焦虑”?

-

信任建立:如何让用户快速建立信任,产生尝试的意愿?

-

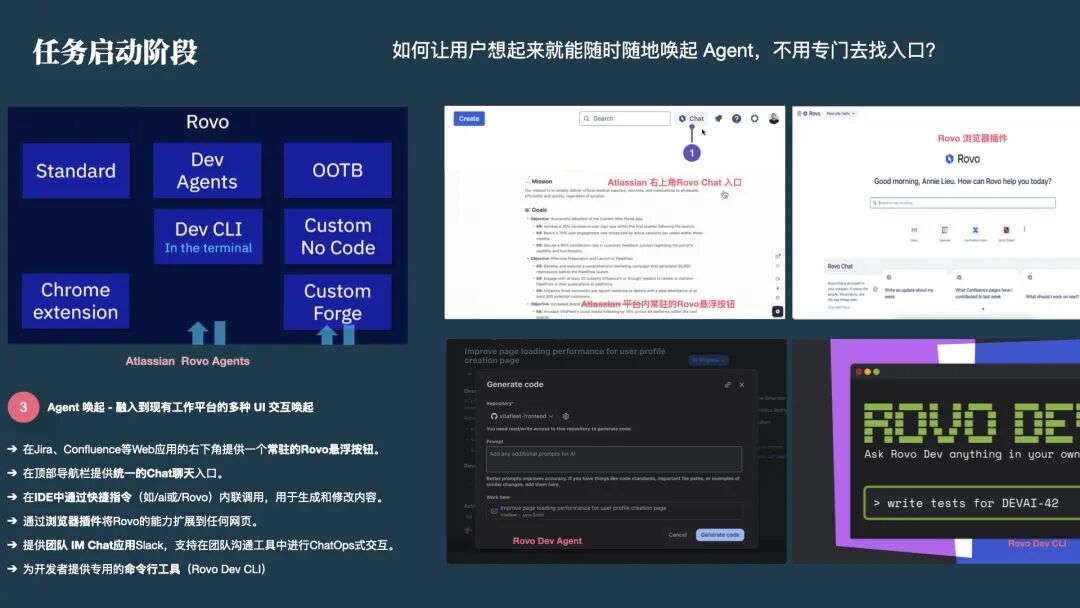

唤起便捷性:如何让用户想起来就能直接唤起 Agent,而不用专门切换入口?

-

意图理解:如何清晰、准确地理解用户的模糊目标或复杂指令?

✅ 应对策略与案例:

1)针对上手与信任:统一入口与“示例生态”

-

案例:GenSpark & v0.app

为了解决“不知道问什么”的问题,这些产品不仅提供简洁的统一入口,更重要的是展示了丰富的“参考示例生态”和“可见的能力范围”。比如 v0.app 会展示社区生成的 UI 组件,暗示用户“你也能做出这样的东西”。这种自动建议(Auto-Suggestion) 的模式激发了用户的尝试欲,降低了首次使用的心理门槛。

2)针对唤起便捷性:环境适配与无缝融入

-

案例:GenSpark & v0.app

为了解决“不知道问什么”的问题,这些产品不仅提供简洁的统一入口,更重要的是展示了丰富的“参考示例生态”和“可见的能力范围”。比如 v0.app 会展示社区生成的 UI 组件,暗示用户“你也能做出这样的东西”。这种自动建议(Auto-Suggestion) 的模式激发了用户的尝试欲,降低了首次使用的心理门槛。

2)针对唤起便捷性:环境适配与无缝融入

-

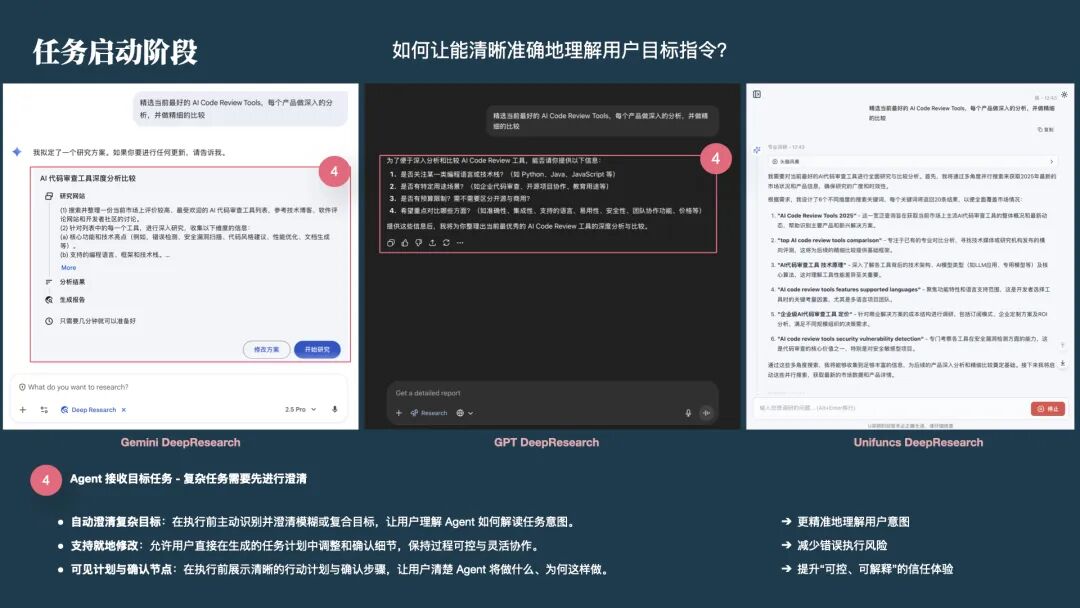

案例:Gemini / ChatGPT / Unifuncs DeepResearch

当用户指令模糊(如“调研代码审查工具”)时,比如 Gemini 和 ChatGPT Agent 不会盲目执行,而是采用就地澄清(In-Place Clarification) 模式。它会生成一个“研究方案”或提出具体问题(“关注哪种语言?预算多少?”),请求用户确认。这种交互确保了 Agent 在开跑前与用户达成共识,避免了“做多错多”。而另外一个 Unifuncs DeepResearch 则会直接执行,当用户发现错了就只能强行停止。

2.2 过程执行阶段

任务开始后,最怕的是 AI 进入“黑盒模式”,用户不知道它在瞎忙什么,也不敢信它的结果。

🚩 核心挑战:

-

透明度与负载的平衡:面对复杂的任务规划,如何既透明化展示思考过程,又不给用户带来额外的信息负载?

-

上下文填充:如何主动、自动地填充上下文,既不增加用户操作负担,又能保证依据可回溯?

-

安全边界:如何让用户明确知道 Agent 拥有哪些权限,会进行哪些操作?

-

可控性:如何让用户能自主地暂停、修正、继续或重启 Agent?

✅ 应对策略与案例:

1)针对透明度与上下文:思考外显与可视化路径

-

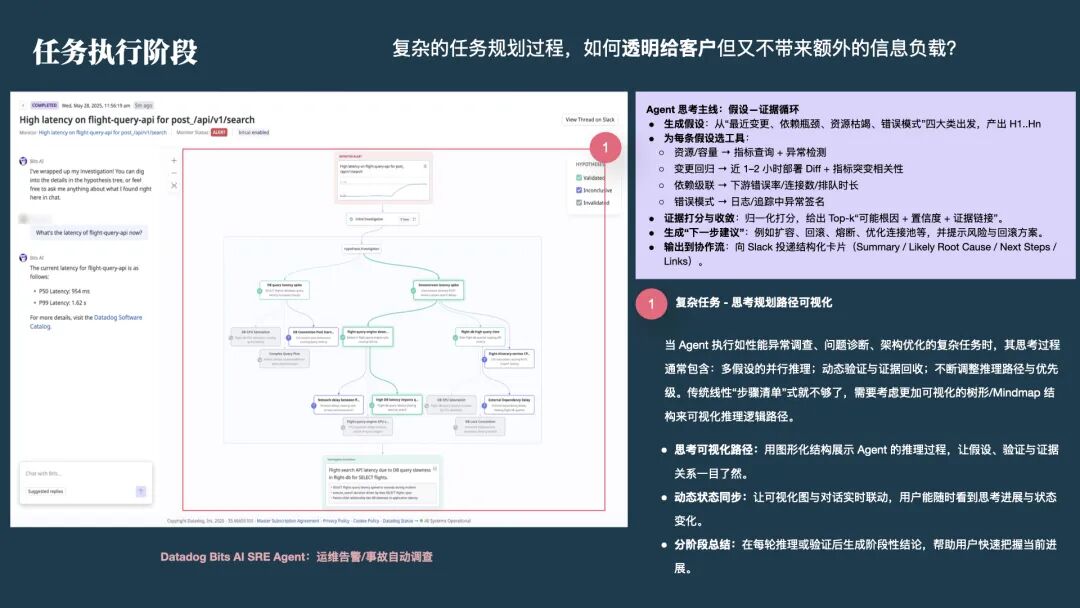

案例:Datadog Bits AI

在处理“运维告警调查”这种高认知负载任务时,Datadog 没有扔出一堆日志,而是应用了思考外显(Think-Aloud) 模式。它展示了一个图形化的“假设树”:从资源枯竭、依赖瓶颈等角度生成假设,并实时展示每一条假设的验证状态。这种树形结构让用户一眼就能看懂 AI 的推理逻辑,实现了透明度与信息密度的完美平衡。

-

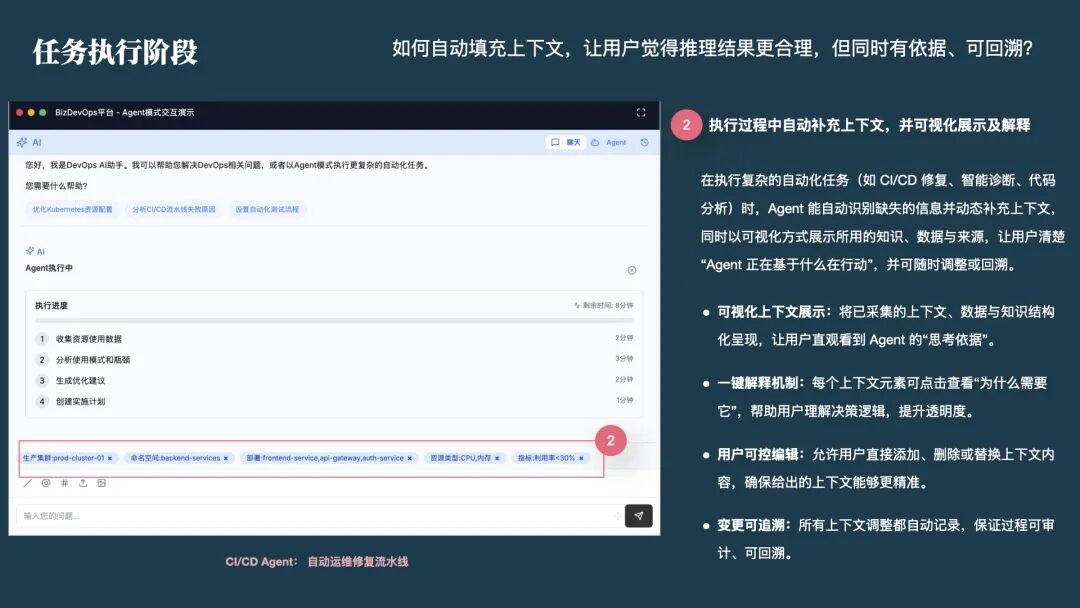

案例:CICDAgent / Augment

Augment 会在执行中自动匹配上下文(Context Match),并可视化展示它正在读取哪些文件或文档。用户如果发现它读错了文件,可以立即干预修正,确保推理的准确性。

2)针对安全边界:权限确认机制

-

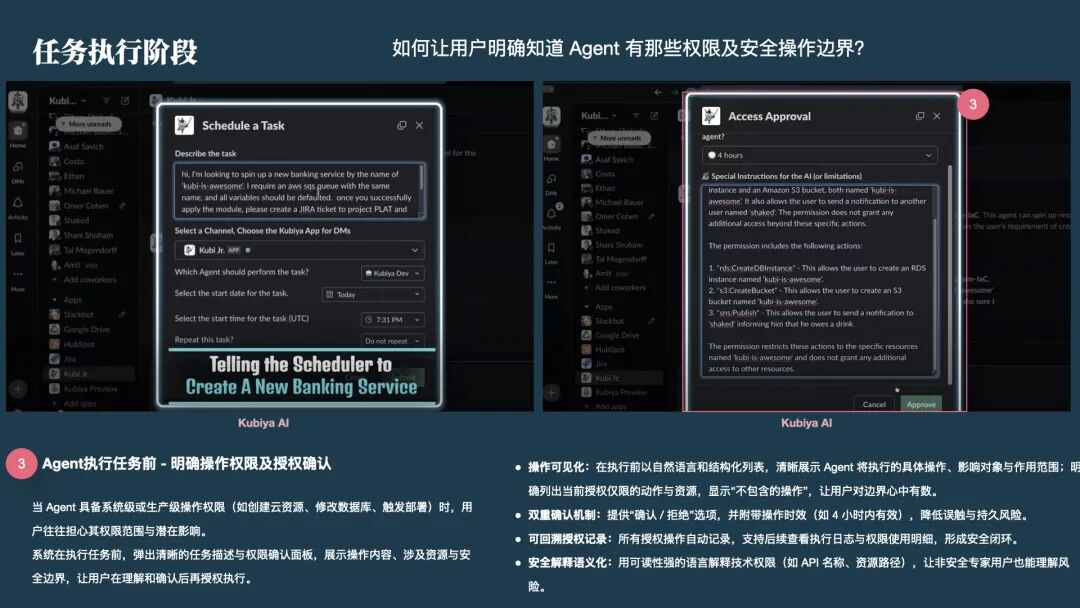

案例:Kubiya AI

Kubiya 在执行敏感操作(如创建 AWS 资源)前,会弹出一个清晰的权限确认面板。它明确列出:Agent 将执行什么操作、涉及哪些资源、以及(最关键的)“不包含哪些操作”。只有用户点击 Approve 后,Agent 才会获得临时的、一次性的执行权。这解决了用户对“黑盒操作”的恐惧。

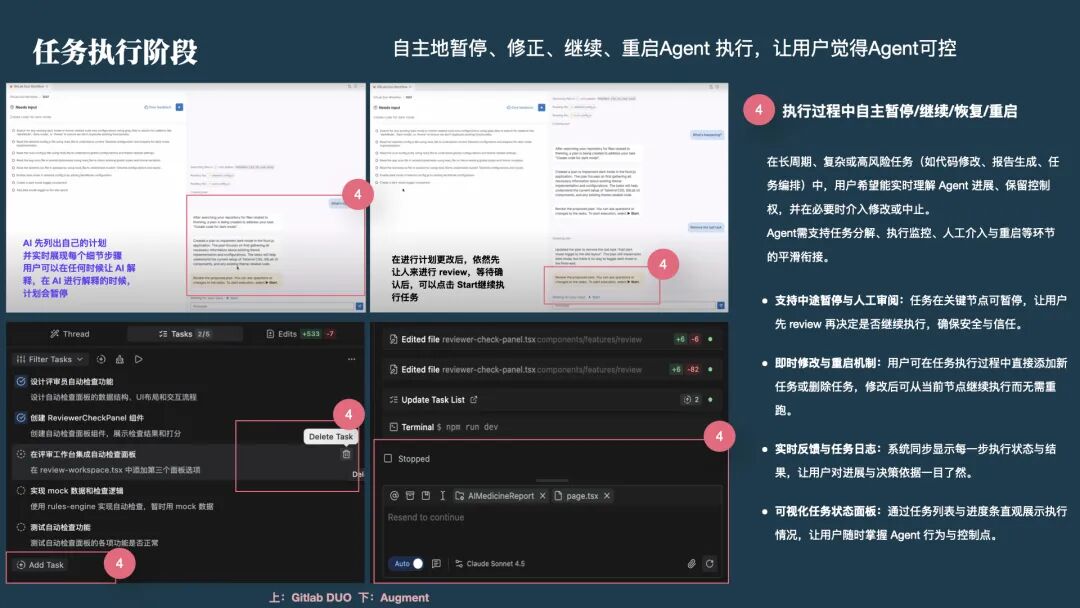

3)针对可控性:暂停-反馈-继续

-

案例:GitLab Duo Workflow 和 Augment

该产品支持暂停-反馈-继续(Pause-Feedback-Continue) 模式。Agent 会先列出执行计划,用户可以在执行前增加新步骤或删除多余步骤,或者在执行中途暂停 Agent,查看生成的中间代码。如果发现跑偏,用户可以修改指令后让 Agent 从当前节点“重启”或“继续”,而无需从头再来。

2.3 结果交付阶段

Agent 给出的结果往往不是终点,而是用户下一步工作的起点。

🚩 核心挑战:

-

质量自检:如何确认任务是否按规划完成?如何自检质量及发现改进点?

-

无缝衔接:如何让用户方便地修改结果,并轻松应用到下一步工作流中?

-

版本管理:面对多次迭代,如何做好版本管理,支持多版本对比分析及回滚?

✅ 应对策略与案例:

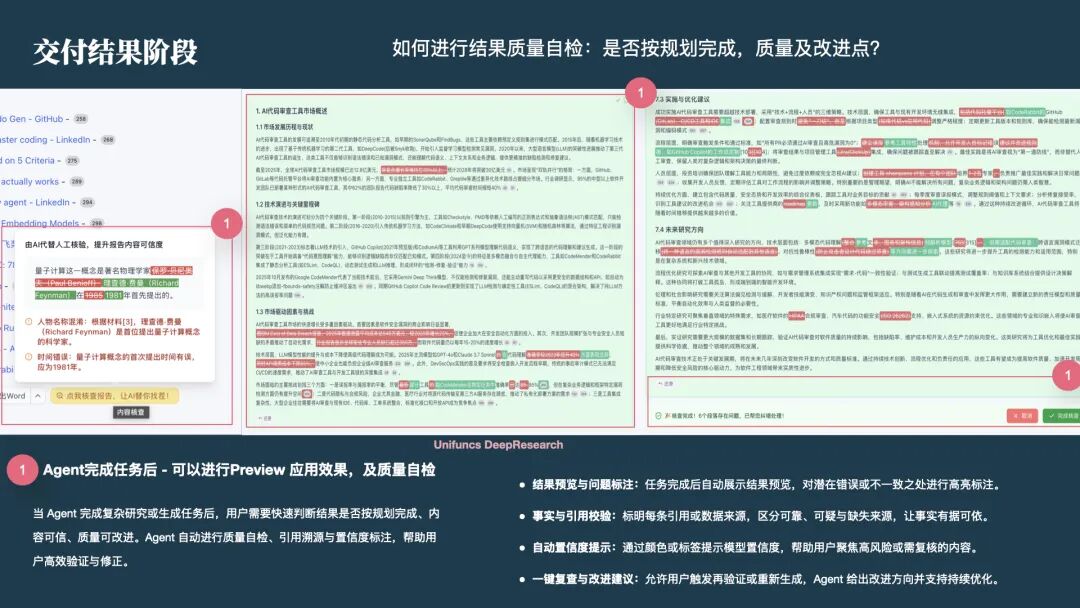

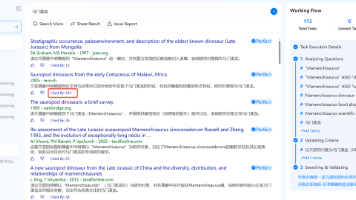

1)针对质量自检:置信度标注与引用溯源

-

案例:Unifuncs DeepResearch

Agent 生成的报告或代码,必须经过自检。Unifuncs 会在报告中标注每一处引用的来源,甚至对潜在的幻觉(如人物名称混淆、时间错误)进行高亮预警,提示用户“此处置信度低,请人工核验”。这种坦诚展示不确定性的设计,反而增加了产品的可信度。

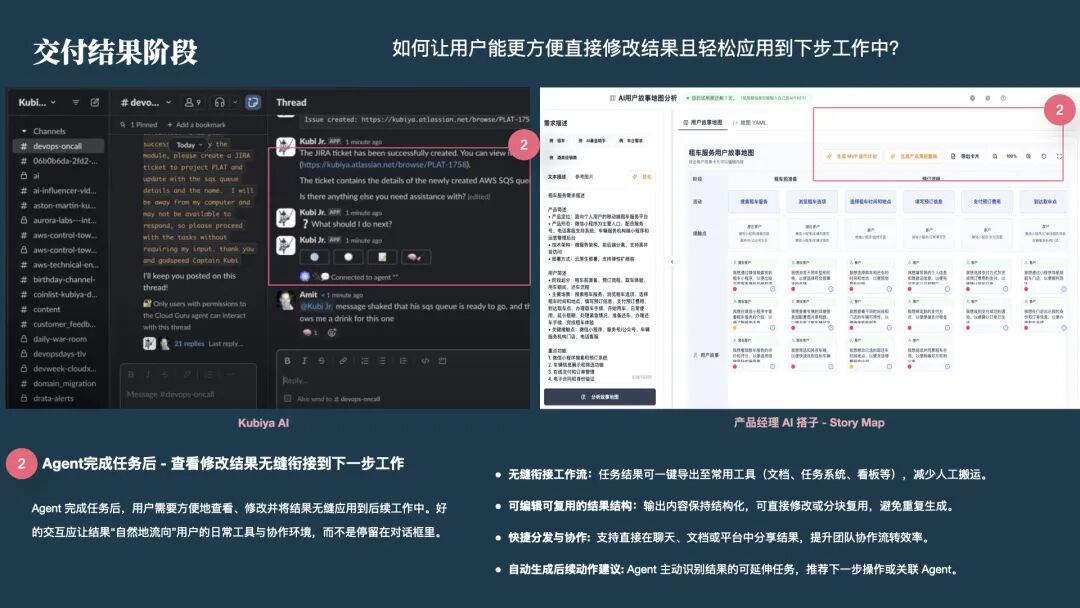

2)针对无缝衔接:工作流集成

-

案例:Kubiya AI / 产品经理 AI 搭子

对话框不应该是工作的终点。Kubiya 在排查完问题后,会主动建议:“需要我为此创建一个 Jira Ticket 吗?”并直接生成链接。产品经理AI搭子中生成的用户故事地图可以一键导出为 MVP 迭代计划。这体现了环境/工作流适配模式,让结果自然流转。

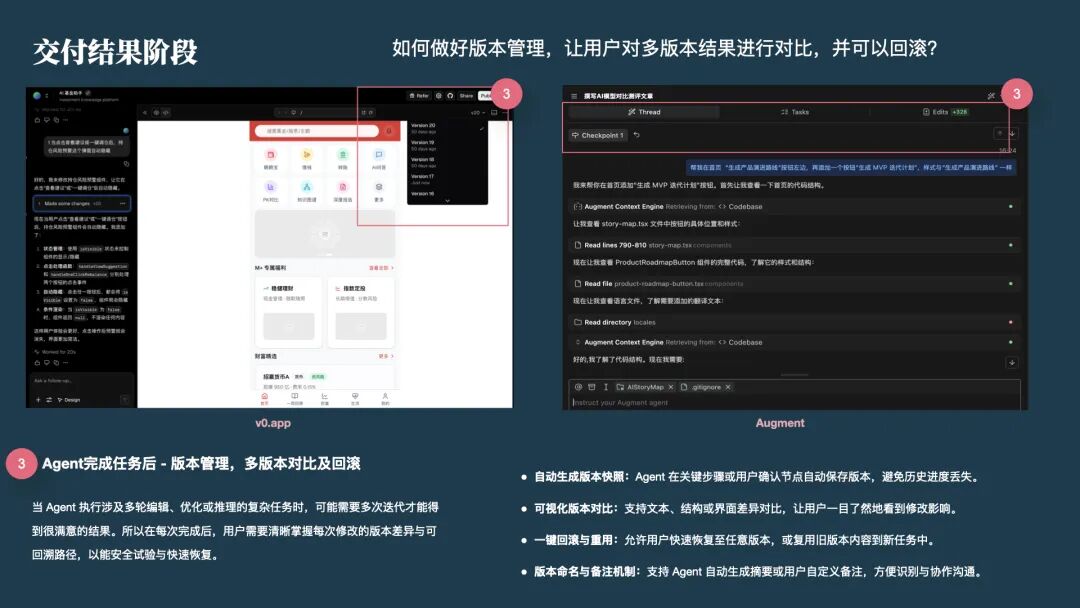

3)针对版本管理:可视化对比与回滚

-

案例:v0.app / Augment

用户往往需要多次尝试才能得到满意结果。这些产品支持版本快照与回滚。用户可以像浏览 Git 历史一样查看 Version 16 和 Version 20 的区别,并一键回退。这让 AI 的产出物真正变成了可维护的工程资产,而不仅仅是一次性的对话记录。

3、 Agent 产品设计实践中的一些体悟

-

Agent 应让人自主选择协作深度,而非被动接受自动化。 不同场景需要不同的人类介入水平,真正的智能是让人自由切换“自己做”与“交给 AI 做”。

-

Agent 应把信任作为目标,而非追求完全自主。 设计的核心不是替代人,而是通过透明与可控的体验,让用户敢于把后背交给 AI。

-

Agent 应坦诚地外显自己的缺点,而非隐藏。 主动展示不确定性和边界,是建立真实信任的最快路径。

-

Agent 应以人的认知负荷为边界,而非算法能力。 再强大的智能,也要让人能轻松跟上思考与决策,否则便失去了“协作”的意义。

-

Agent 应在交互中学习成长,而非停留在静态能力。 通过每一次的“暂停-反馈-修正”,Agent 实际上是在学习用户的偏好,实现人机共进化。

希望这篇文章能帮助你在企业内部推进 Agent 产品,从“试试看”走向“用得好”。

推荐活动

#AI+产品创新峰会· 2026上海站

📅2026年1月16-17日 | 📍上海

届时,kk老师将作为演讲嘉宾带来《Agent产品交互设计的取舍之道》主题演讲。本讲将结合真实案例,讨论如何在协作深度、信任感、认知负荷与持续学习之间找到平衡,让 Agent 产品真正做到“让人愿意信任、愿意使用,并持续留下来”。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)