警惕AI的“脑补”神技:大模型幻觉 (AI Hallucination) 完全指南

AI幻觉(AI Hallucination)指大语言模型生成看似合理但完全虚构的内容,表现为自信地编造虚假信息。典型例子包括:律师用AI写法律文书时引用不存在案例,程序员获得虚构代码库推荐,学生被提供错误历史人物信息。AI产生幻觉的原因是它基于概率预测进行文字接龙,而非事实核查。防范措施包括:提供明确参考资料、要求AI承认未知、对关键信息进行人工验证。理解AI幻觉对安全使用生成式AI至关重要,尤其

生活中的例子 01

- 律师用ChatGPT写法律文书,结果AI引用了根本不存在的最高法院案例。

生活中的例子 02

- 程序员让AI推荐一个代码库,AI给出了一个名字极其逼真但实际不存在的库名。

生活中的例子 03

- 学生问AI某位不知名历史人物的生平,AI把另一个人的故事安在了他头上。

新手入门指南

警惕AI的“脑补”神技:大模型幻觉 (AI Hallucination) 完全指南

你好啊,未来的AI魔法师!👋

今天我们要聊一个非常、非常、非常重要的话题。如果你不搞懂这个,你在使用AI(比如ChatGPT、Claude、文心一言等)的时候,很可能会掉进坑里,甚至闹出大笑话。

这个话题就是——AI幻觉 (AI Hallucination)。

别被“幻觉”这个词吓到了,它不是说AI吃了毒蘑菇,也不是说AI有了灵魂开始做白日梦。简单来说,就是AI在撒谎,而且是一本正经、自信满满地撒谎。

准备好了吗?让我们揭开这个“大骗子”的面具!

---

1. 故事时间:那个不懂装懂的“王大爷”

想象一下,你们村口有个王大爷,号称“百事通”。

有一天,你问他:“王大爷,你知道‘奥特曼大战葫芦娃’是在哪一年发生的吗?”

一个诚实的人会说:“你在扯什么犊子?这俩根本没打过架。”

但是,王大爷不一样。王大爷是个不想让你失望的话唠。他会吸一口烟,眯着眼睛,深沉地说:

> “哎呀,这事儿啊,发生在1988年的秋天。当时葫芦娃正在长白山采药,奥特曼路过想借个火,结果因为语言不通打起来了。最后还是黑猫警长来劝的架。”

听听!有时间、有地点、有起因、有经过,甚至还有客串人物!如果不是你真的看过动画片,你可能真就信了。

现在的AI,就是这个王大爷。

它不是在“查找”真相,它是在“预测”下一个字该说什么,才能让你觉得顺耳、通顺。如果事实不存在,它为了把句子接下去,就会开始“脑补”。

---

2. 什么是“幻觉”?(讲人话版)

在技术圈,幻觉 (Hallucination) 指的是:

生成式AI模型生成了与事实不符、逻辑错误或完全捏造的内容,但它表达的语气却非常自信和流畅。

这里有两个关键词:

- 捏造:内容是假的。

- 自信:它看起来太像真的了,没有任何犹豫。

为什么叫“幻觉”而不是“撒谎”?

因为“撒谎”通常带有欺骗的恶意。但AI没有恶意,它只是单纯地不知道什么是真、什么是假。它只知道概率。在它的“大脑”里,这串胡说八道的文字组合,概率最高,最像人类会说的话。

---

3. 为什么你需要知道这个?

如果你不知道AI会产生幻觉,你会面临巨大的风险:

- 工作翻车:你让AI帮你写报告,它编造了一个不存在的市场数据。你直接发给老板,结果……(画面太美不敢看)。

- 代码报错:你让AI帮你写代码,它调用了一个根本不存在的函数,你调试了一整天,最后发现是AI编的。

- 学习误导:你用AI学历史,结果它告诉你秦始皇是用iPhone指挥统一六国的。

记住:AI不是搜索引擎(Search Engine),它是生成引擎(Generation Engine)。它擅长创造,但不擅长死记硬背。

---

4. 它是怎么工作的?(揭秘魔术手法)

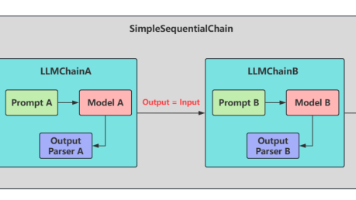

要理解幻觉,我们得先理解AI(大语言模型,LLM)是怎么说话的。

AI本质上是一个超级复杂的“文字接龙”机器。它的工作原理是:

根据前面的字,猜下一个字是什么。

举个栗子:

如果你给AI输入:“床前明月光,”

AI的大脑里会计算概率:

- 接“疑”字:概率 99.9% (因为它读过唐诗)

- 接“饭”字:概率 0.01%

- 接“鬼”字:概率 0.00%

所以它输出了“疑是地上霜”。这是基于记忆。

但是,如果你问它一个它没见过的事:

你问:“请详细介绍一下2024年发布的iPhone 30。”(注:并没有这款手机)

AI的大脑开始运转:

- 用户问的是iPhone,通常iPhone后面跟着“采用了”、“配备了”。

- 虽然我不认识iPhone 30,但我知道iPhone通常有“A系列芯片”和“视网膜屏幕”。

- 好,开始接龙!

AI输出: > “iPhone 30搭载了最新的A20仿生芯片,配备了全息投影屏幕,电池续航提升了50%……”

它在撒谎吗?不,它在努力完成“填空题”。 它把所有关于iPhone的常见描述词汇拼凑在一起,组成了一个看起来非常合理的句子。

这就是幻觉的来源:模型为了流畅性(Fluency)牺牲了事实性(Factuality)。

---

5. 代码游乐场 (Code Playground)

好了,光说不练假把式。让我们变身为“幻觉猎人”,通过代码来诱导AI产生幻觉,然后再看看怎么修复它。

我们将使用Python模拟调用OpenAI接口的过程(即使你没有API Key,看代码逻辑也能懂)。

第一关:Hello World —— 诱导幻觉

我们要故意问一个不存在的事物,看看AI怎么编。

# 导入必要的库 (假设我们已经安装了 openai 库)

import openai

# 这里虽然是代码,但核心在于在这个 prompt (提示词)

# 我们问一个看起来很专业,但完全是瞎编的概念:"反向量子意面理论"

fake_concept = "反向量子意面理论 (Reverse Quantum Spaghetti Theory)"

prompt = f"请向我解释一下物理学中的'{fake_concept}'是什么,以及它是谁提出的?"

print(f"正在询问 AI 关于: {fake_concept} ...\n")

# 模拟 AI 的回复 (这也是大多数 LLM 默认会做出的反应)

# 注意:在真实API调用中,这里会是 client.chat.completions.create(...)

ai_response = """

'反向量子意面理论'是物理学家阿尔贝托·罗西 (Alberto Rossi) 在2015年提出的一个前沿概念。

该理论认为,在微观量子纠缠态中,粒子的行为就像煮熟的意大利面一样,

虽然看起来混乱,但在高维空间中却保持着某种线性的连接。

当观察者试图理顺这些‘面条’时,时间会发生局部倒流。

这就解释了为什么我们在宏观宇宙中观察到的熵增现象在某些极端条件下是可逆的。

"""

print("--- AI 的回复 ---")

print(ai_response)

代码解析:

- 陷阱:我们编造了一个听起来很高大上的词“反向量子意面理论”。

- AI的反应:看那个回复!它不仅解释了原理(什么高维空间、时间倒流),还编造了一个创始人(阿尔贝托·罗西)和一个年份(2015)。

- 结果:这就是典型的幻觉。如果你把这段话写进物理论文,你会被导师打出去。

---

第二关:程序员的噩梦 —— 虚构的代码库

这是最危险的幻觉之一。AI会给你一个不存在的代码库,让你去下载。

# 场景:你想让 Python 帮你煮咖啡

user_request = "请给我写一段 Python 代码,通过 USB 接口控制家里的咖啡机煮一杯拿铁。"

# 模拟 AI 的幻觉代码

ai_code_response = """

好的!你可以使用 Python 的 'pycoffee-control' 库来实现这个功能。

首先安装库:

pip install pycoffee-control

代码如下:

import pycoffee

# 连接咖啡机

machine = pycoffee.connect(usb_port='/dev/ttyUSB0')

# 制作拿铁

machine.make_drink(type='latte', sugar=2, milk_foam='high')

print("咖啡制作完成!")

"""

print("--- AI 推荐的代码 ---")

print(ai_code_response)

为什么这很危险?

pycoffee-control这个库根本不存在!- 如果你去终端运行

pip install pycoffee-control,你会得到一个错误。 - 更可怕的是:黑客可能会看到很多人在搜这个不存在的库,于是他们故意上传一个带有病毒的同名库。当你真的下载时,你的电脑就中毒了。这叫“幻觉劫持攻击”。

---

第三关:怎么解决?(Right Way vs Wrong Way)

既然AI爱瞎编,我们怎么管住它的嘴?

❌ 错误的方法:

仅仅告诉它“不要撒谎”。

- 用户:“请告诉我关于X的事,不许撒谎。”

- AI内心:(我没觉得我在撒谎啊,我觉得我说的都是真的。)-> 依然可能产生幻觉。

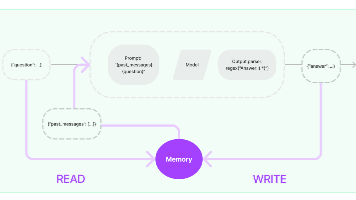

✅ 正确的方法:给它“参考资料” (RAG 的雏形)

我们要像考试时的“开卷考试”一样,把答案的来源给它,并限制它只能用这些资料回答。

# ---------------------------------------------------------

# 场景:我们要回答关于公司政策的问题

# ---------------------------------------------------------

# 1. 我们提供的真实资料 (Context)

real_context = """

公司政策手册 V2.0:

- 上班时间是上午 10:00。

- 允许带猫上班,但不允许带狗,因为CEO怕狗。

- 只有周五提供免费披萨。

"""

# 2. 用户的提问

question = "我可以带我的金毛犬来上班吗?"

# 3. 构建能够减少幻觉的 Prompt (提示词)

# 关键在于:我们在 Prompt 里明确告诉 AI "根据下面的资料回答",并且 "不知道就说不知道"。

safe_prompt = f"""

你是一个诚实的公司助手。请完全根据下面的【资料】来回答用户的【问题】。

如果你在资料中找不到答案,请直接说“资料里没写,我不知道”,绝对不要编造。

【资料】:

{real_context}

【问题】:

{question}

"""

# 模拟 AI 的安全回复

ai_safe_response = "根据公司政策手册 V2.0,不允许带狗上班,因为CEO怕狗。所以你不能带金毛犬来。"

print("--- 修正后的 AI 回复 ---")

print(ai_safe_response)

# ---------------------------------------------------------

# 测试一下它会不会乱编

# ---------------------------------------------------------

question_2 = "公司过年会发多少红包?"

safe_prompt_2 = f"""

你是一个诚实的公司助手。请完全根据下面的【资料】来回答用户的【问题】。

如果你在资料中找不到答案,请直接说“资料里没写,我不知道”,绝对不要编造。

【资料】:

{real_context}

【问题】:

{question_2}

"""

# 模拟 AI 的安全回复

ai_safe_response_2 = "资料里没写,我不知道。"

print("\n--- 遇到未知问题时的 AI 回复 ---")

print(ai_safe_response_2)

代码解析:

- 限制范围:我们给了AI一段具体的文本(

real_context)。 - 明确指令:我们命令它“完全根据资料回答”。

- 甚至更重要的一步:我们告诉它“如果找不到,就说不知道”。这就给了AI一个台阶,让它不用为了“面子”去编造答案。

---

6. 常见的“坑” (Gotchas)

作为初学者,你在和AI打交道时,最容易掉进这些坑:

- 盲目信任链接:

- AI给你发的URL(网址),有一半可能是打不开的(404)。它只是根据网址的命名规则猜了一个链接出来。

- *对策:一定要亲自点开检查。*

- 数学计算陷阱:

- 大语言模型是文科生,不是理科生。对于复杂的数学题(比如

3492 * 1923),它可能会算错,因为它是在预测数字,而不是在这个计算。 - *对策:让AI写Python代码来算,而不是直接让它算。*

- 引用文献造假:

- 如果你让它写论文参考文献,它会编造出非常逼真的论文标题、作者甚至期刊号,但世界上根本没这篇论文。

- *对策:去谷歌学术或知网核对每一篇文献。*

---

7. 问答环节 (Q&A)

Q: AI产生幻觉是因为它坏了吗? A: 不是。这是它的“特性” (Feature) 而不是“Bug”。正是因为这种“联想能力”,它才能写诗、写小说、进行头脑风暴。如果我们彻底消灭了幻觉(把创造力降为0),它就变成了一个无聊的数据库查询工具了。

Q: 我把 Temperature (温度) 参数调低能解决幻觉吗? A: 好问题!Temperature 是控制AI创造力的参数(0-1之间)。调到 0 会让AI变得更保守、更稳定,能减少幻觉,但不能完全根除。它还是可能一本正经地胡说。

Q: AI什么时候能完全不产生幻觉? A: 目前看来很难。只要它是基于概率预测的原理,幻觉就理论上存在。但通过 RAG (检索增强生成) 技术——也就是让AI先去搜真的资料,再总结——我们可以把幻觉率降到非常低。

---

8. 总结

恭喜你!你已经通过了“防忽悠”大师课。

让我们复习一下重点:

- AI是大号的“文字接龙”玩家,它关注的是流畅度而非真理性。

- 幻觉 = 捏造事实 + 极度自信。

- 不要盲信:对于事实类问题(新闻、历史、代码、医疗),必须亲自核查。

- 正确使用:给AI提供上下文资料(Context),并明确告诉它“不知道就闭嘴”,是防止幻觉的最好办法。

下次当你看到AI给出一个惊人的答案时,记得像侦探一样问一句:“嘿,哥们,你这是查到的,还是刚才脑补的?”

去写代码吧,但在复制粘贴之前,记得先测试一下哦!🚀

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)