AiOnly平台x FastGPT:一键调用Gemini 3 Pro系列模型从零构建AI工作流

谷歌最新发布的Gemini3Pro和NanoBananaPro在多模态能力上表现惊艳,但直接使用海外大模型面临注册繁琐、成本高昂等问题。文章介绍了AiOnly这一MaaS服务平台,它整合了80+国内外大模型,提供一键调用、按量计费等便捷功能。通过FastGPT智能体平台集成Gemini3Pro和NanoBananaPro,作者详细演示了如何搭建学习规划师应用,并提供了三个实用代码案例(多轮对话、论

摘要:谷歌最新发布的Gemini3Pro和NanoBananaPro在多模态能力上表现惊艳,但直接使用海外大模型面临注册繁琐、成本高昂等问题。文章介绍了AiOnly这一MaaS服务平台,它整合了80+国内外大模型,提供一键调用、按量计费等便捷功能。通过FastGPT智能体平台集成Gemini3Pro和NanoBananaPro,作者详细演示了如何搭建学习规划师应用,并提供了三个实用代码案例(多轮对话、论文摘要、小红书文案生成)。AiOnly平台有效解决了开发者使用顶级大模型的门槛问题,让AI应用开发更加高效便捷。

前言

实在是没想到,谷歌近期发布的Gemini 3 Pro让人惊喜的程度直接拉满了,在推理、多模态、Agent工具调用等关键基准测试中,直接实现了全方位霸榜。与此同时,搭载Gemini 3技术的Nano Banana Pro也跟着火出了圈,不仅角色一致性和世界知识理解能力出色,创意能力更是MAX。这两个顶级模型的出色表现,直接点燃了我学习的热情,也萌生了搭建自己专属工作流的想法。接下来,我将从零开始,基于Gemini 3 Pro以及Nano Banana Pro,构建一个学习规划师,让学习效率,事半功倍。

一、AI开发使用国外顶级模型的困境

正当我兴致满满准备开展工作的时候,出现了个尴尬的问题。要想使用这两个顶级大模型,首先要注册登录谷歌,然后再进行一系列的流程,最后才可以申请API,而且还不一定能成功。一想到这,刚才还高涨的热情一下子就被这盆冷水浇灭了一半。其实这种情况,我们日常AI开发过程中就会碰到,不仅如此,还会面临其他的几种情况:

1.大模型厂家平台繁琐的接入步骤、复杂的订阅、付款程序

以谷歌为例,单单账户注册就劝退了很多人。更不要提后续的订阅付款、需要准备的东西更是麻烦,最后还有可能过不了审核。相信这点大家也深有体会。

2.顶级模型的使用成本昂贵、且有随时被封号的风险

Gemini 3Pro 官方的定价为每百万输入代币2至4美元,每百万输出代币12至18美元,比Claude Sonnet 4.5便宜,但比GPT-5.1贵。而且还有被封号的危险,号与大模型皆失。

3.同时使用多平台的大模型,需要每个平台都要登录注册,管理混乱

使用谷歌的大模型,得去谷歌官网注册,GPT5模型,要去OpenAI的官网,使用不同厂家的模型越多,意味着管理的难度越大。

这上面一层层的阻碍,难道,就要止步于此了吗?

二、大模型MaaS服务平台的选择

出一款名为AiOnly的大模型MaaS服务平台出现,直接打破了这一僵局。AiOnly秉承着"开发无门槛,创意零边界"的理念,具有以下特点:

1.高效便捷,不再需要复杂的注册、订阅环节

一站融合海内外热门大模型,无需跨平台、多重注册等,尤其是海外大模型,免繁琐开户订阅,畅享高速专线,开箱即用,方便快捷。

2.极致的性价比

平台提供更优价格,一般低于官方刊例价(即标准定价),并采取按量计费(Token或次数),也支持先用后付、优惠量包等计费模式,极大降低模型使用成本,性价比高。

3.国内外顶级模型,一网打尽

大模型覆盖文本、图像、视频、语音、多模态等广泛场景,比如Claude、Gemini、GPT、VEO等海外模型家族,以及DeepSeek、Qwen、Seedream、Hailuo等国内系列模型,并持续上架最新模型。

4.官方正版授权,稳定流畅

平台集成大模型,均为官方正规授权,API接口标准化,兼容原厂全参数,一键调用稳定流畅,开通模型服务后,获取API Key,再配置到环境变量即可,助力提升开发效率。

5.与OpenAI保持同一标准,支持第三方集成

平台完全遵循了OpenAI的接口标准,可无缝切换以及集成,主打的就是丝滑流畅。

6.平台已经上线了两大核心功能

一是模型广场(已上架模型80+个),可浏览开通大模型服务,并创建和管理API Key,支持可视化查看调用情况

二是体验中心,可在线体验文本对话、图片生成、视频生成、语音合成等主流大模型能力

三、AiOnly开通Gemini 3 Pro系列模型

接下来,手把手教大家如何轻松接入这两个顶级模型。

1.进入AiOnly官网

2. 账户注册

完成基本的注册流程,通常支持多种登录方式。

整个注册的过程30秒搞定。

整个注册的过程30秒搞定。

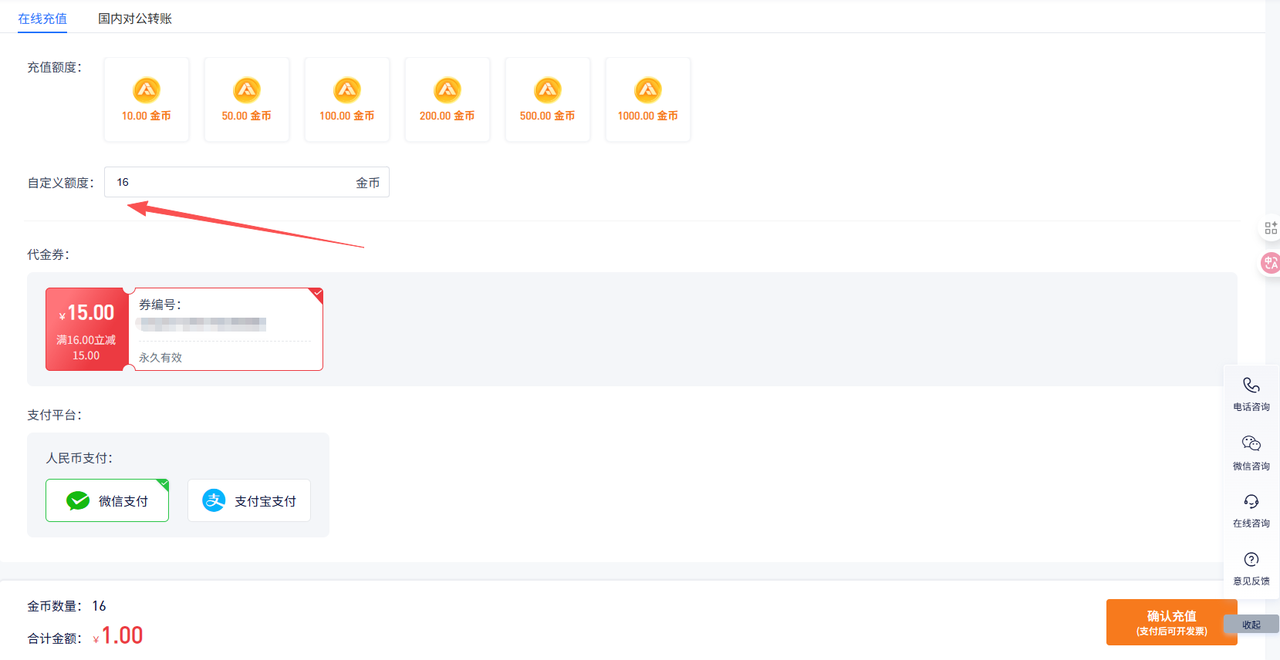

3.资源充值

根据平台规则进行资源充值,新用户通常有体验额度。

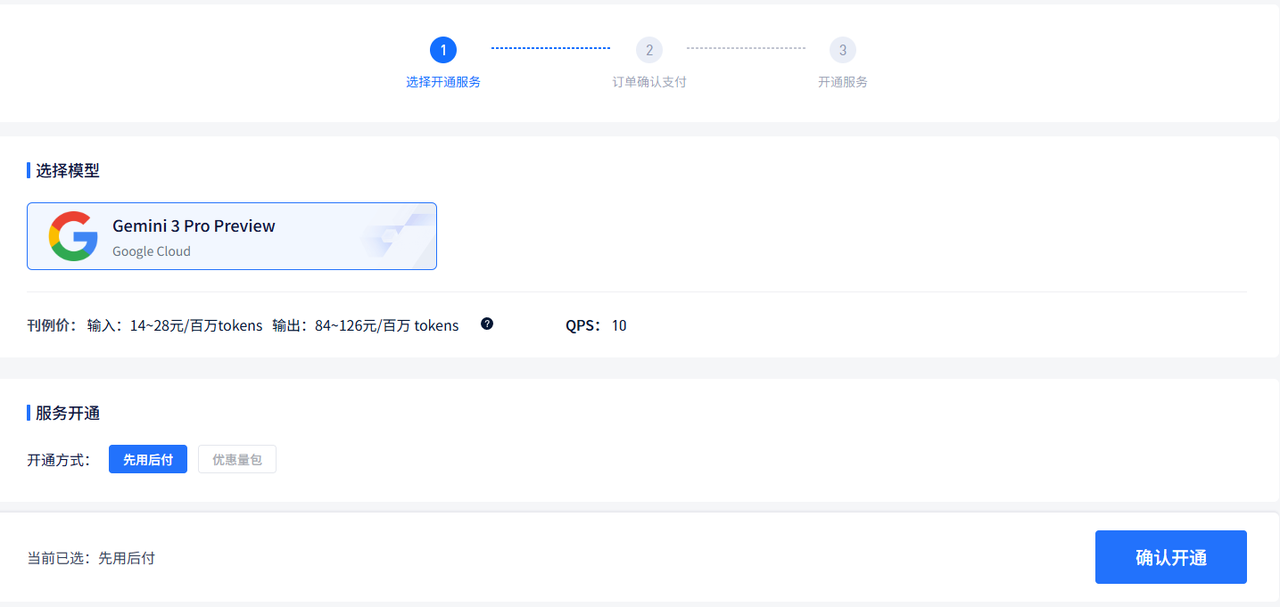

4.选择大模型

选择需要的大模型,点击开通服务(这里我以Gemini 3 Pro Preview为例子)。

确认开通

开通后,可以在开通管理看到已开通的大模型了。

nano banana Pro preview的开通也是同样的步骤,这里不再赘述了。这个时候,两个大模型我们都已经开通好了。

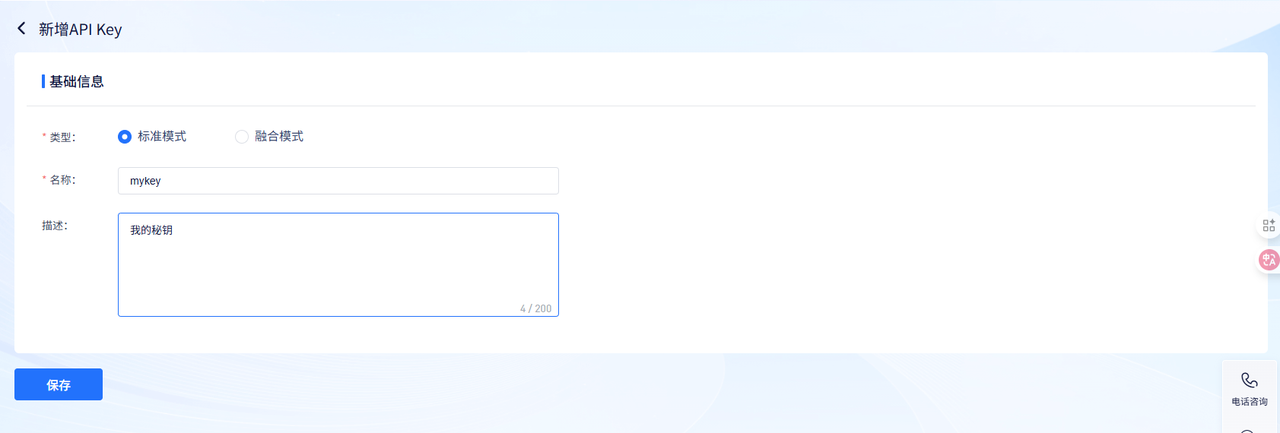

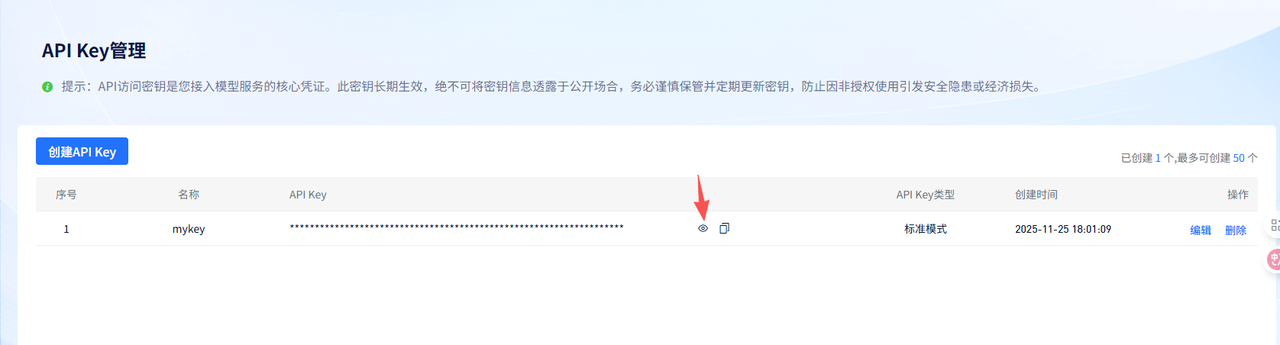

5.获取apikey(最重要的一步,没它不行)

1.点击菜单【API Key】,点击【创建API Key】

2.选择标准模式、填入名称、点击保存。

3.查看、复制API Key,密钥到手!

四、部署FastGPT智能体开发平台

FastGPT 是一个开源的基于 LLM 大语言模型的知识库问答系统,将智能对话与可视化编排完美结合,让 AI 应用开发变得简单自然。无论您是开发者还是业务人员,都能轻松打造专属的 AI 应用。fastgpt分为商业版、社区版。我们是自己用,安装PgVector版本就好了。(注意:教程是基于Linux系统)

1.准备 Docker 环境

# 安装 Docker

curl -fsSL https://get.docker.com | bash -s docker --mirror Aliyun

systemctl enable --now docker

# 安装 docker-compose

curl -L https://github.com/docker/compose/releases/download/v2.20.3/docker-compose-`uname -s`-`uname -m` -o /usr/local/bin/docker-compose

chmod +x /usr/local/bin/docker-compose

# 验证安装

docker -v

docker-compose -v2.使用脚本部署

执行bash <(curl -fsSL https://doc.fastgpt.cn/deploy/install.sh) --region=cn --vector=pg

下载 config.json 文件

#所有 docker-compose.yml 配置文件中 MongoDB 为 5.x,需要用到AVX指令集,部分 CPU 不支持,

#需手动更改其镜像版本为 4.4.24**(需要自己在docker hub下载,阿里云镜像没做备份)3.开放外网端口/配置域名

以下两个端口必须被访问到:

1.指向 3000 端口(FastGPT 主服务)

2.指向 9000 端口(S3 服务)

4.修改环境变量

修改 yml 文件顶部的S3_EXTERNAL_BASE_URL变量,改成 S3 的可访问地址(要求使用者可以访问)。

5.修改 config.json 配置文件

修改config.json文件中的mcpServerProxyEndpoint值,设置成mcp server的公网可访问地址,yml 文件中默认给出了映射到 3005 端口,如通过 IP 访问,则可能是:120.172.2.10:3005。

6.启动容器

docker-compose up -d7.访问 FastGPT

可通过第三步开放的端口/域名访问 FastGPT。

登录用户名为 root,密码为docker-compose.yml环境变量里设置的 DEFAULT_ROOT_PSW。

每次重启容器,都会自动初始化 root 用户,密码为 1234(与环境变量中DEFAULT_ROOT_PSW一致)。

8.配置模型

首次登录FastGPT后,系统会提示未配置语言模型和索引模型,并自动跳转模型配置页面。系统必须至少有这两类模型才能正常使用。

目前已知可能问题:首次进入系统后,整个浏览器 tab 无法响应。此时需要删除该tab,重新打开一次即可。

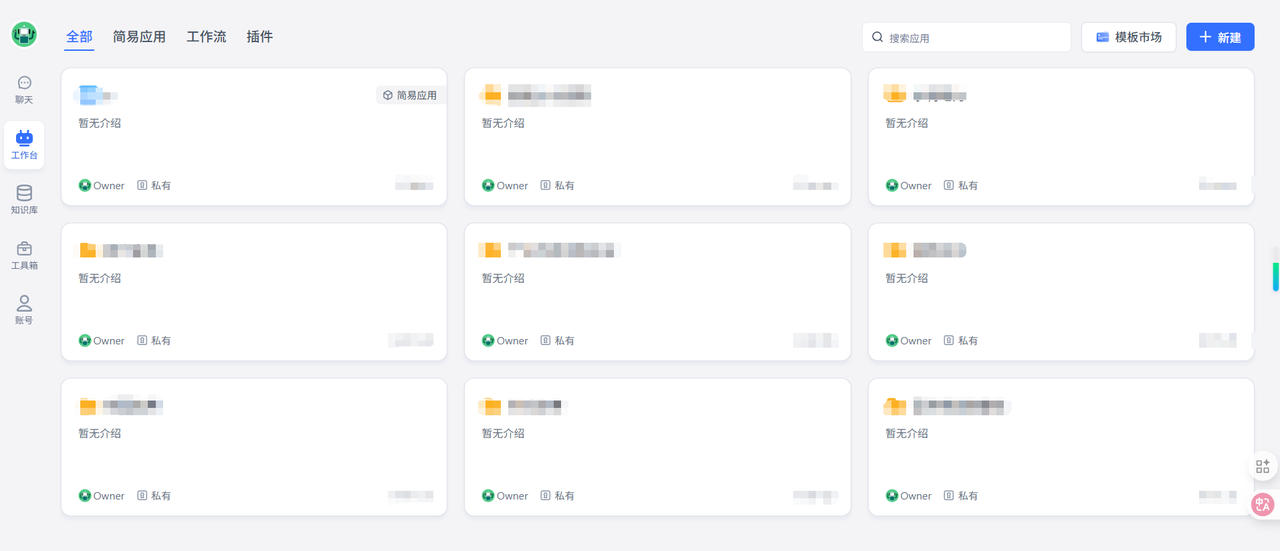

9.显示如下,证明系统已正常运行

五、FastGpt集成Gemini 3 Pro、Nano Banana Pro Preview

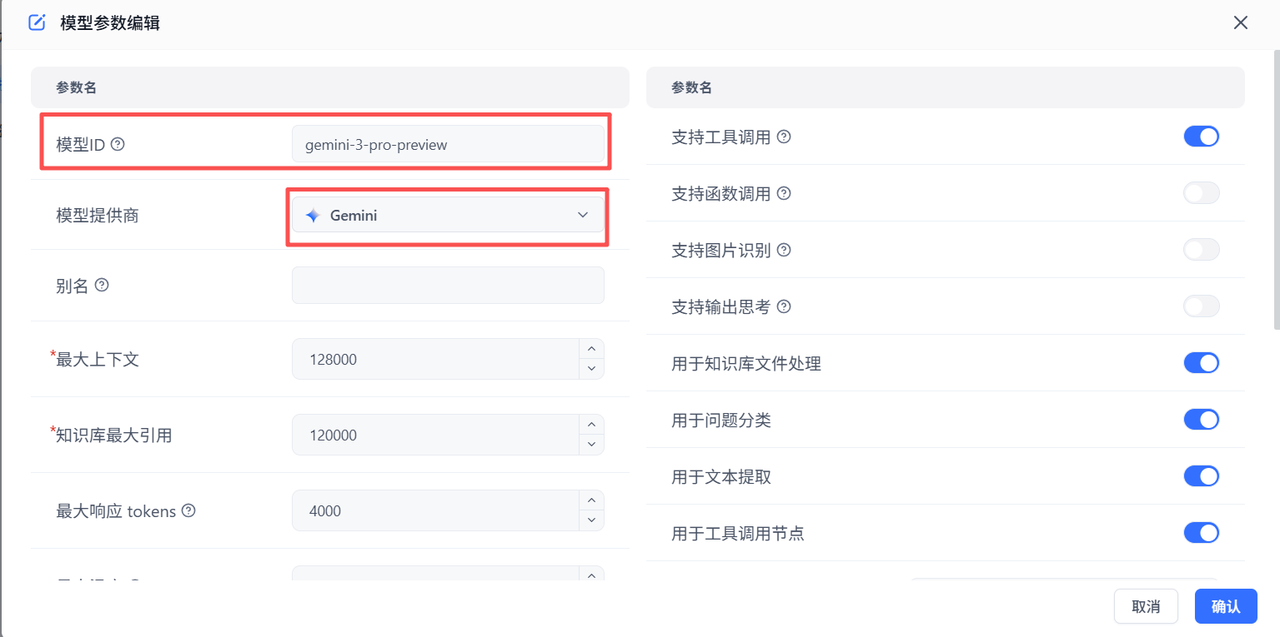

1.新增模型

点击左上角的头像>模型提供商>模型配置>新增模型----选择语言模型

2.填写对应的模型参数

注意:密钥就是我们获取apikey 这一步骤获取的密钥

Nano Banana Pro Preview的添加也是同步骤,不再赘述。

添加成功后,如下图所示

六、搭建学习规划师

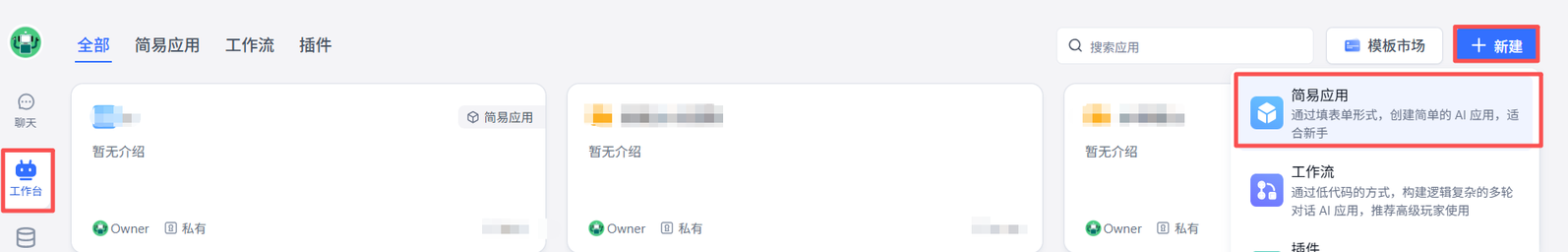

1.点击工作台>右上角新建>简易应用

2.填入名字,点击确认

3.选择Gemini3 Pro 模型,填入提示词、点击右上角的保存

4.点击左上角的【对话】,开始使用,见证奇迹时刻

输入内容:

我想深入了解java虚拟机、请给出可行的学习规划。

当前知识基础:Java工程师

可用时间:周六日

回复内容如下:

一份详细、周密、可落地的学习计划瞬间就完成了。

七、搭建学习规划师增强版(基于Nano Banana Pro)

虽然上面的学习计划已经规划好了,但都是文字的形式,相对来说比较枯燥,所以我决定借助Nano Banana Pro的能力,再打造个增强版。

1.整体的搭建步骤与上面的基本一致,只是第三步的模型选择要换成Nano Banana Pro

2.进行提问,再次见证奇迹时刻

图文结合,学习效率直线上升

八、经典代码案例

案例 1:30 行代码完成「多轮对话 + 自动统计 token」

import requests, json, os

AIIONLY_KEY = os.getenv("AIIONLY_KEY") # 把密钥放在环境变量里

MODEL = "gemini-3-pro-preview" # 也可换成 nano-banana-pro-preview

URL = "https://api.aiionly.com/v1/chat/completions"

def chat(messages):

"""messages 为 OpenAI 格式的列表,返回 (回复文本, 总花费 token)"""

r = requests.post(

URL,

headers={"Authorization": f"Bearer {AIIONLY_KEY}",

"Content-Type": "application/json"},

json={"model": MODEL, "messages": messages, "stream": False}

)

r.raise_for_status()

body = r.json()

reply = body["choices"][0]["message"]["content"]

usage = body["usage"]["total_tokens"]

return reply, usage

if __name__ == "__main__":

history = [{"role": "system",

"content": "你是一位学习规划师,请用中文给出可落地的步骤。"}]

while True:

user = input(">>> ")

if user.lower() == "q":

break

history.append({"role": "user", "content": user})

answer, tk = chat(history)

print("AI:", answer)

history.append({"role": "assistant", "content": answer})

print(f"[本次消耗 {tk} tokens]\n")逐行解释

-

密钥走环境变量,避免硬编码泄漏。

-

MODEL 字符串与 AiOnly「模型广场」里的 id 完全一致,换模型只改这一行。

-

URL 固定为

https://api.aiionly.com/v1/chat/completions,与 OpenAI SDK 完全兼容。 -

返回体中的 usage 字段实时给出 prompt+completion 总 token,方便按量计费。

案例 2:5 行代码把 Gemini-3-Pro 变成「论文速读」摘要器

import requests, os, sys

text = open(sys.argv[1], encoding="utf-8").read() # 读取本地论文 txt

prompt = f"用 3 段中文总结下文核心贡献与实验结果,每段不超过 80 字:\n\n{text}"

r = requests.post("https://api.aiionly.com/v1/chat/completions",

headers={"Authorization": f"Bearer {os.getenv('AIIONLY_KEY')}"},

json={"model": "gemini-3-pro-preview",

"messages": [{"role": "user", "content": prompt}],

"temperature": 0.3})

print(r.json()["choices"][0]["message"]["content"])保存为 summarize.py,命令行一键执行:python summarize.py paper.txt

→ 30 秒给出 240 字中文摘要,温度 0.3 保证事实一致性。

案例 3:30 行代码完成「批量生成小红书文案 + 自动重试」

import csv, os, time, requests

ENDPOINT = "https://api.aiionly.com/v1/chat/completions"

KEY = os.getenv("AIIONLY_KEY")

MODEL = "nano-banana-pro-preview" # 创意能力 MAX 版本

def gen_copilot(topic, retry=3):

payload = {

"model": MODEL,

"temperature": 0.9,

"messages": [{"role": "user",

"content": f"给「{topic}」写 1 条小红书爆款文案,"

"带 emoji 和标签,字数 120~150。"}]

}

for i in range(retry):

try:

r = requests.post(ENDPOINT, headers={"Authorization": f"Bearer {KEY}"},

json=payload, timeout=30)

return r.json()["choices"][0]["message"]["content"]

except Exception as e:

print("retry", i+1, e)

time.sleep(2**i) # 指数退避

return ""

# 读取 100 个选题,批量落库

with open("topics.csv", newline="", encoding="utf-8") as f, \

open("xiaohongshu.csv", "w", newline="", encoding="utf-8") as wf:

reader, writer = csv.reader(f), csv.writer(wf)

writer.writerow(["topic", "copy"])

for row in reader:

t = row[0]

writer.writerow([t, gen_copilot(t)])

time.sleep(0.5) # 限速,避免突增并发关键设计

-

温度 0.9 + nano-banana-pro-preview,保证创意发散。

-

指数退避重试,网络抖动或 429 限额时自动回血。

-

统一走 csv,方便后续直接导入飞书/Notion 数据库。

九、总结

在人工智能技术快速发展的背景下,通过合理的工具选择和系统集成,可以相对便捷地构建出功能强大的AI应用。而AiOnly的横空出世,恰如一把精准的钥匙,以"唯此一钥,万模之门"的底气,轻巧叩开了这扇曾遥不可及的大门,为人们架起了触碰最新AI动向的桥梁。

驾驭不同它以"开发无门槛,创意零边界"为初心,将免费注册的便捷、高性价比的实惠与多模型聚合的强大融于一体,既打破了开发者被单一平台束缚的局限,更让普通人也能轻松模型的特性。从教育场景的个性化辅导,到办公领域的效率革新,AiOnly正让专属AI工具的打造不再是专业人士的专利,而是每个人释放创意与效率潜能的抓手。在实际使用前详细了解相关服需要注意的是,不同平台的服务内容和计费方式可能存在差异,建务条款。同时,技术方案的选择应该基于项目需求和个人技术能力进行综合考量。

AiOnly企业级MaaS平台官网:https://aiionly.com

GPT/Claude/Gemini API接入文档:https://aiionly.com/document

文章关键字解说:

1. AiOnly – 一站式 MaaS 平台,聚合 80+ 海内外官方正版模型,OpenAI 接口标准,免翻墙、免外币卡。

2. MaaS – Model-as-a-Service,把大模型当水电用,按 Token/次数计费,开箱即用。

3. Gemini-3-Pro – 谷歌最新多模态旗舰,推理、代码、长文理解三榜第一,AiOnly 已上架。

4. Nano-Banana-Pro – 同系创意模型,角色一致性、世界知识、图文混排能力 MAX,适合做营销/教育素材。

5. API-Key – 平台唯一凭证,创建即得,放入请求头 Bearer 即可调用,支持随时滚动更新。

6. Token – 计费单元,1K 汉字≈1.8k token,AiOnly 价低于官方刊例,先充后用。

7. 按量计费 – 用多少扣多少,无最低消费,支持先用后付、优惠量包,适合个人及企业。

8. 官方授权 – 所有模型均与原厂签约,接口全参数兼容,稳定性>99.9%,无惧封号。

9. 模型广场 – 可视化货架,一键开通/关闭模型,实时查看 QPS、Token、费用曲线。

10. 体验中心 – 在线免代码试聊、试画、试视频,30 秒验证效果再决定接入。

11. FastGPT – 开源 LLM 编排系统,支持知识库、插件、工作流,本文用 PgVector 版一键 Docker。

12. 工作流 – 把“提示词+模型+后置脚本”串成 Pipeline,可复用、可分享、可上线。

13. 学习规划师 – 本文实战案例,用 Gemini-3-Pro 生成文字版计划,Nano-Banana-Pro 再出图文混合增强版。

14. 多轮对话 – 基于 messages 数组上下文记忆,Token 实时统计,随时插入系统提示纠偏。

15. 指数退避 – 批量调用时的容错策略,遇 429/网络抖动自动 2ⁿ 秒重试,保障任务完整率。

更多推荐

已为社区贡献49条内容

已为社区贡献49条内容

所有评论(0)