文献 ADPretrain: Advancing Industrial Anomaly Detection Via Anomaly Representation Pretraining

论文提出ADPretrain框架,针对工业异常检测任务设计预训练表示方法。通过角度和范数导向对比损失优化特征差异,在RealIAD数据集预训练避免分布偏移。实验表明,该方法在五个数据集上优于ImageNet预训练特征,验证了异常表示预训练的有效性。主要创新包括:1)专为AD任务设计的预训练框架;2)基于残差特征的类泛化表示;3)角度和范数导向对比损失。当前局限在于固定特征提取器和适用范围限制。代码

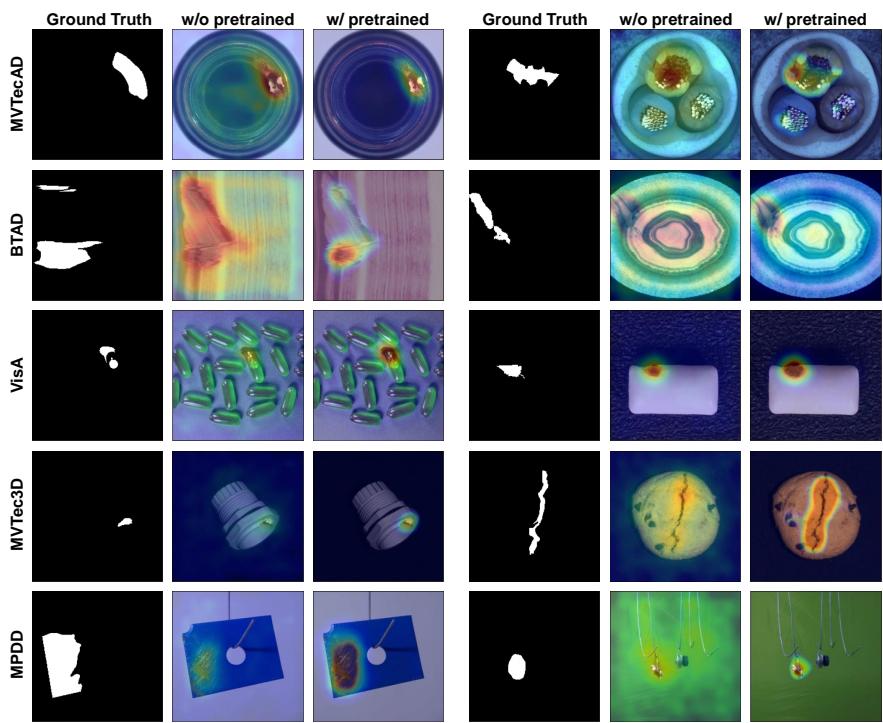

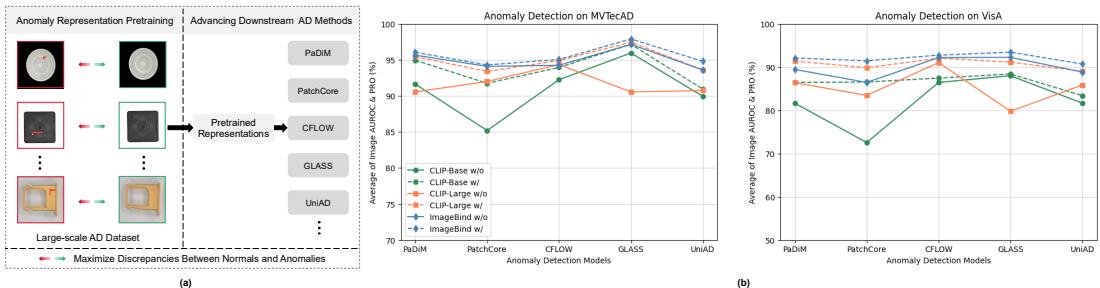

当前主流异常检测方法多依赖ImageNet预训练的特征网络,但ImageNet预训练目标与异常检测任务(区分正常与异常)不一致,且自然图像与工业场景图像存在分布偏移,导致ImageNet预训练特征对AD任务效果不佳。为此,论文提出ADPretrain框架,专为AD任务学习鲁棒且具有判别性的预训练表示。该框架围绕AD目标,通过角度和范数导向的对比损失,同时最大化正常与异常特征的角度差异和范数差异;为避免分布偏移,预训练在AD数据集RealIAD上进行;为缓解预训练与下游数据的潜在偏移,基于类通用表示(残差特征)学习预训练表示。评估时,将预训练表示替换五种基于嵌入的AD方法的原始特征,在五个AD数据集和五种骨干网络上实验,结果一致证明其优越性,代码已开源。

关键词

Anomaly Detection,Anomaly Representation Pretraining

引用

@InProceedings{yao2025ADPretrain,

title={ADPretrain: Advancing Industrial Anomaly Detection via Anomaly Representation Pretraining},

author={Xincheng Yao and Yan Luo and Zefeng Qian and Chongyang Zhang},

year={2024},

booktitle={Thirty-Ninth Annual Conference on Neural Information Processing Systems, NeurIPS 2025},

url={https://arxiv.org/abs/2511.05245},

primaryClass={cs.CV}

}论文作者介绍

-

本文作者包括四位专家:Xincheng Yao,专注于异常检测和深度学习研究,任职于上海交通大学电子信息与电气工程学院;Yan Luo,研究兴趣广泛,目前聚焦于异构架构和系统、软件定义网络及深度学习,担任马萨诸塞大学洛威尔分校电气与计算机工程系教授;Zefeng Qian,为上海交通大学的一名博士研究生;张重阳,工学博士、研究员、博士生导师,主要研究方向为计算机视觉与机器学习,任职于上海交通大学电子信息与电气工程学院及人工智能学院。作者们的研究领域涵盖了深度学习、目标检测、异常检测、群体计数、行为分析等多个方面。

-

摘要

- 现有的异常检测 (AD) 方法主要基于 ImageNet 预训练的特征网络,但 ImageNet 预训练的目标与 AD 任务不符,且存在自然图像与工业图像数据分布差异的问题。

- 本文提出 ADPretrain,一个专门为工业 AD 任务学习鲁棒和判别性预训练表示的框架。

- ADPretrain 使用 RealIAD 数据集进行预训练,避免自然图像与工业图像的分布差异。

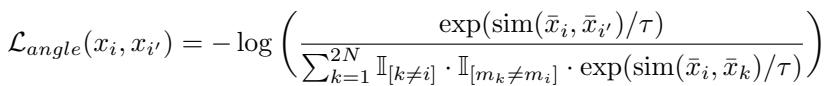

- ADPretrain 提出角度和范数导向对比损失,同时最大化正常和异常特征之间的角度大小和范数差异。

- ADPretrain 基于类泛化表示,残差特征,进一步缓解预训练数据与下游 AD 数据集之间的潜在差异。

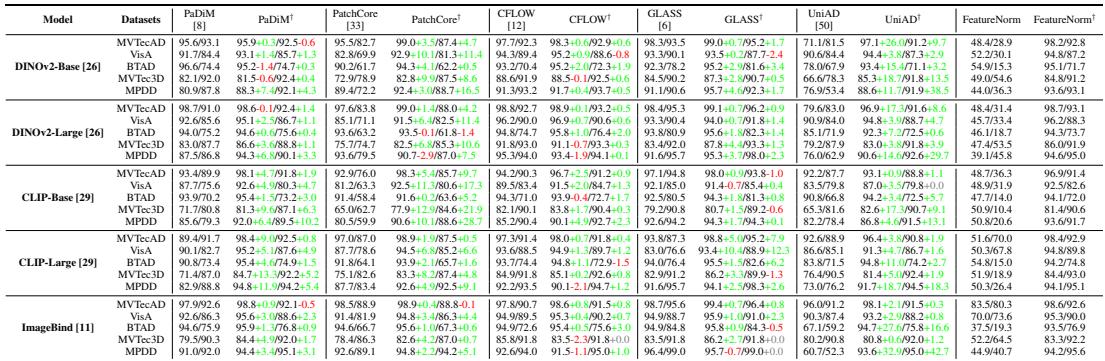

- 在五个基于嵌入的 AD 方法和五个骨干网络上进行的广泛实验表明,ADPretrain 的预训练特征优于原始特征。

1. 引言

- AD 领域的快速发展,各种深度 AD 方法被提出。

- AD 方法的本质是特征表示能力,即正常和异常特征是否具有高度判别性。

- 由于异常样本的稀缺性和不确定性,AD 主要采用无监督学习范式,这导致学习高度判别性表示的困难。

- 利用 ImageNet 预训练的特征网络可以显著提高 AD 性能,但仍然存在局限性。

- 本文探索异常表示预训练问题,旨在学习专门针对 AD 任务的预训练表示。

2. 相关工作

- 异常检测与预训练特征:主流 AD 方法基于 ImageNet 预训练的特征网络,但存在分布差异问题。

- 特征适应 AD 任务:由于分布差异,预训练特征需要适应目标分布,但简单的微调容易导致性能下降。

- 本文工作与现有方法的区别:本文专注于学习鲁棒和判别性的预训练特征,而不仅仅是特征适应。

3. 方法

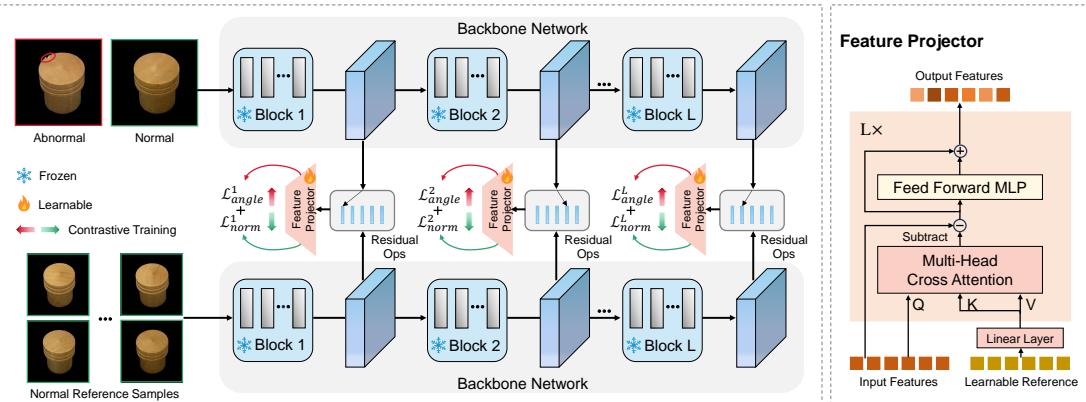

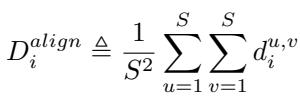

- 概述:ADPretrain 框架基于残差特征,使用角度和范数导向对比损失进行预训练。

- 基本异常检测表示的构建:使用残差特征作为基本 AD 表示,并学习预训练特征。

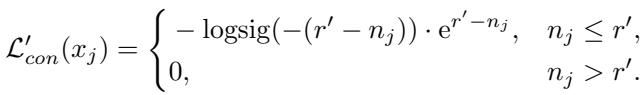

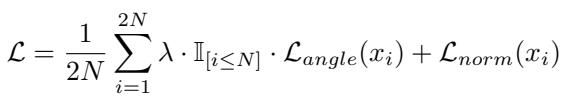

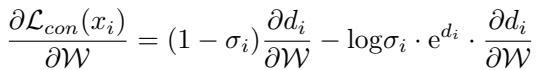

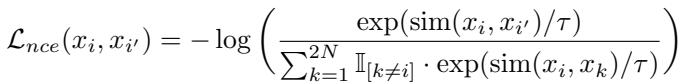

- 异常表示预训练的对比损失:提出角度和范数导向对比损失,最大化正常和异常特征之间的差异。

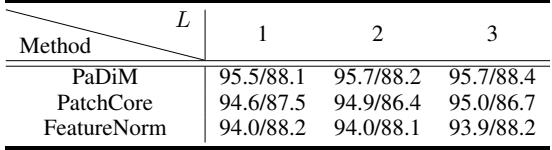

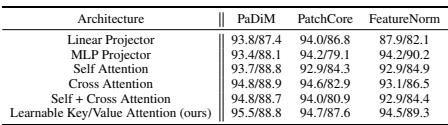

- 特征投影器:使用 Transformer 网络作为特征投影器,并使用可学习的键/值注意力机制。

4. 实验

- 数据集:MVTecAD、VisA、BTAD、MVTec3D 和 MPDD。

- 评价指标:AUROC 和 PRO。

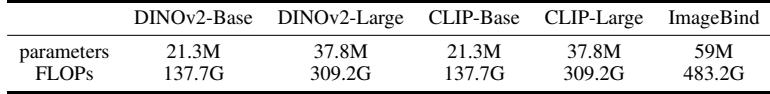

- 实现细节:使用多个骨干网络进行预训练,并使用 Adam 优化器进行训练。

- 设置:将 ADPretrain 的预训练特征应用于现有的基于嵌入的 AD 方法。

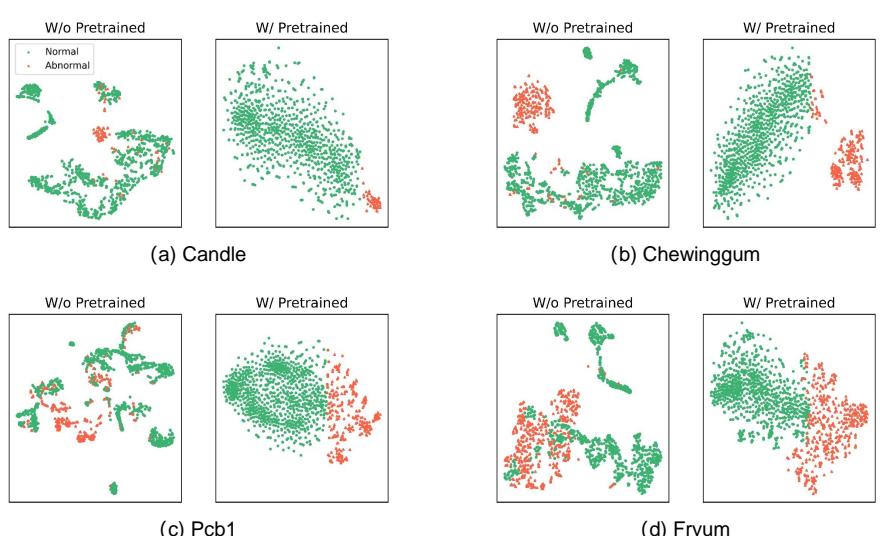

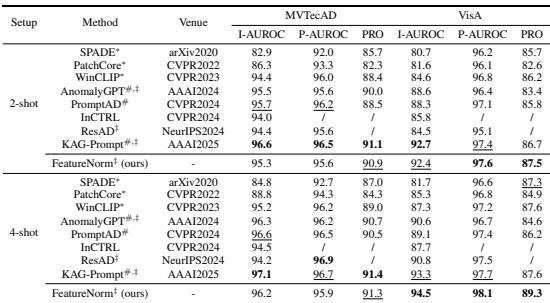

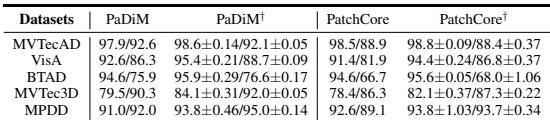

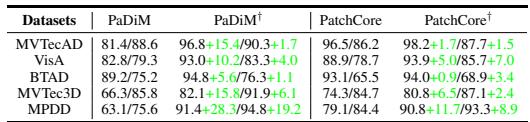

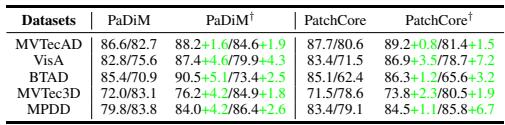

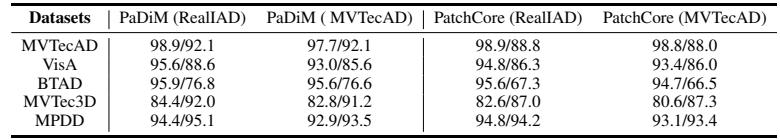

- 主要结果:ADPretrain 的预训练特征在多个数据集和骨干网络上优于原始特征。

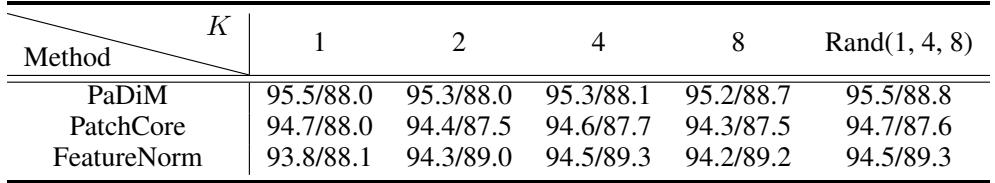

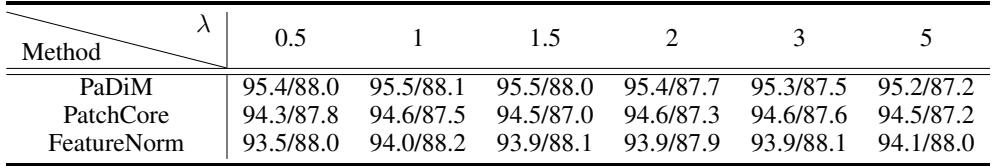

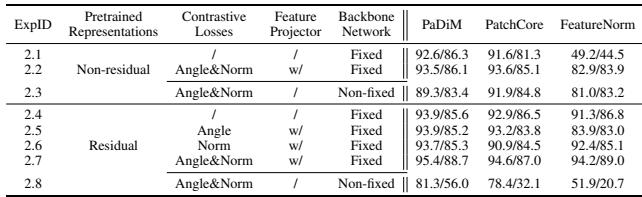

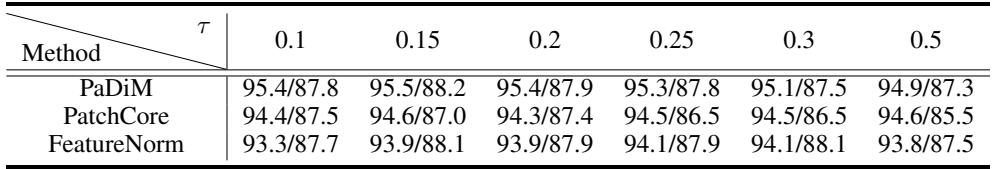

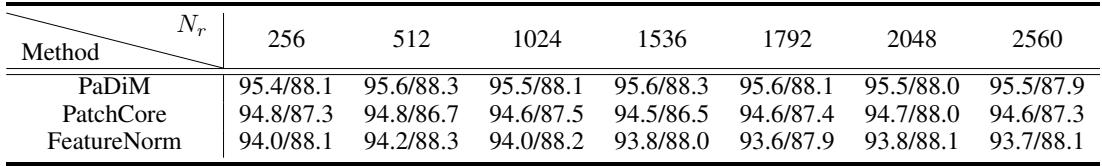

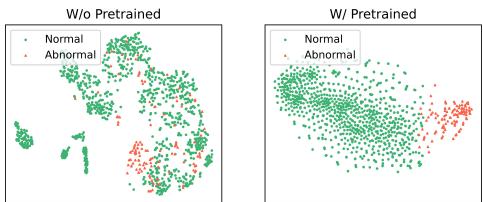

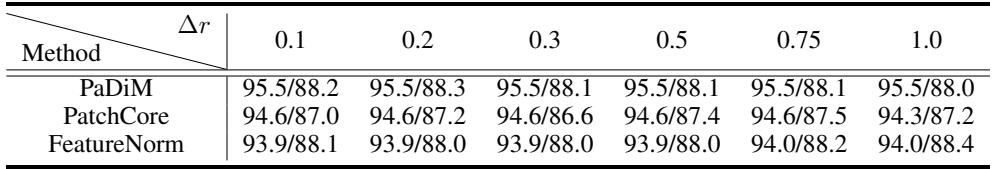

- 消融实验:验证了预训练特征的有效性、残差特征的优越性、对比损失的有效性以及鲁棒性。

- 少样本异常检测:ADPretrain 的预训练特征可以用于少样本异常检测,并取得良好的性能。

5. 结论

- 本文探索了异常表示预训练问题,并提出了 ADPretrain 框架。

- ADPretrain 的预训练特征在多个 AD 任务中表现出优越的性能。

- 未来工作可以探索针对 AD 特征提取网络的设计,并探索预训练框架在更多 AD 方法中的应用。

关键问题

-

Q:论文具体用了哪些研究方法?

- 异常表示预训练框架: 该框架旨在学习鲁棒且区分度高的预训练表示,专门用于工业异常检测。

- 角度和范数导向对比损失: 该损失函数旨在同时最大化正常和异常特征之间的角度大小和范数差异,从而优化特征差异。

- 残差特征: 作为预训练表示的基础,残差特征被认为是类泛化表示,能够在不同数据分布下保持一致性。

- 特征投影器: 基于Transformer网络,用于将残差特征转换为潜在空间并进行优化。

- 可学习的键/值注意力: 用于增强特征投影器的性能,通过将输入特征视为查询向量,并将可学习的参考表示视为键和值向量,然后进行交叉注意力。

Q:主要的研究发现和成果是什么?

- 异常表示预训练的有效性: 通过在大型异常检测数据集RealIAD上进行预训练,可以学习到比ImageNet预训练特征更优的异常检测表示。

- 残差特征的优越性: 与直接由特征提取器产生的特征相比,残差特征作为预训练表示具有更好的性能。

- 角度和范数导向对比损失的优势: 该损失函数能够有效地优化特征差异,从而提高异常检测的性能。

- 简单异常检测方法的潜力: 基于特征范数的简单异常检测方法,在少量正常样本的情况下也能取得良好的性能。

Q:这项研究目前有哪些局限性?

- 固定特征提取器: 该方法仅优化特征投影器,而未对特征提取器进行专门设计,限制了性能的进一步提升。

- 适用范围: 该方法主要适用于基于嵌入的异常检测方法,无法应用于其他类型的异常检测方法。

- 参考集敏感性: 残差特征依赖于少量正常参考样本,不同参考样本可能导致性能差异。

图&表&公式

![]()

![]()

![]()

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)