Elasticsearch:如何创建知识库并使用 AI Assistant 来配置连接器

本文详细介绍了如何为AIAssistant创建和配置大模型连接器知识库。首先需部署Elasticsearch和Kibana环境,并设置DeepSeek作为默认连接器。接着通过安装特定知识库,指导AIAssistant自动创建混元大模型连接器,包括配置API参数和认证信息。文章展示了如何用中英文指令成功创建"hunyuan-4b-1"和"hunyuan-4b-2&quo

在我之前的文章 “AI 驱动的案例分流:几分钟内构建并部署”,我们详细地描述了如何创建知识库。在今天文章里,我来详述如何创建一个用来配置大模型连接器的知识,并让它被 AI Assistant 来进行使用。AI Assistant 可以运用这个知识自动帮我们创建一个可以被使用的连接器。在进行下面的练习之前,请阅读如下的文章:

-

Elasticsearch:在 Elastic 中玩转 DeepSeek R1 来实现 RAG 应用 - 部署 DeepSeek 作为 AI Assistant 的大模型

-

如何在本地部署腾讯混元大模型并连接到 Elasticsearch 进行使用 - 部署混元大模型

安装

如果你还没有部署好自己的 Elasticsearch 及 Kibana,请参考文章 “Elasticsearch:在 Elastic 中玩转 DeepSeek R1 来实现 RAG 应用” 安装好自己的 Elasticsearch 及 Kibana。另外,我们还需要启动白金试用功能。另外,我们需要安装好 ELSER 模型。

注意:为了能够让 AI Assistant 能够自动调用 APIs 来帮我们配置,我们需要在 kibana.yml 里添加如下的一个配置。这个也可能是因为版本的变化而引起的。

server.publicBaseUrl: "http://localhost:5601" server.host: "0.0.0.0"

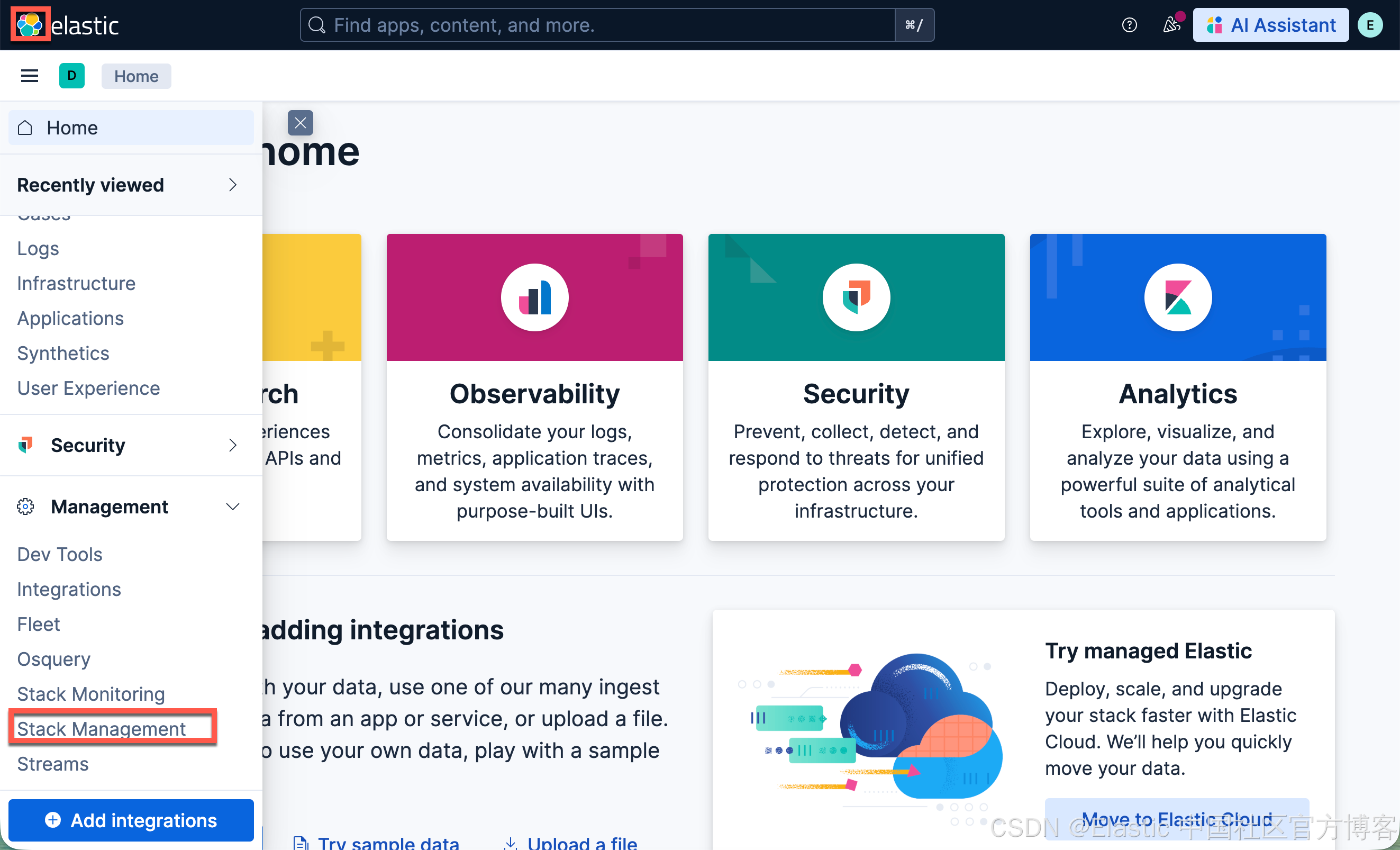

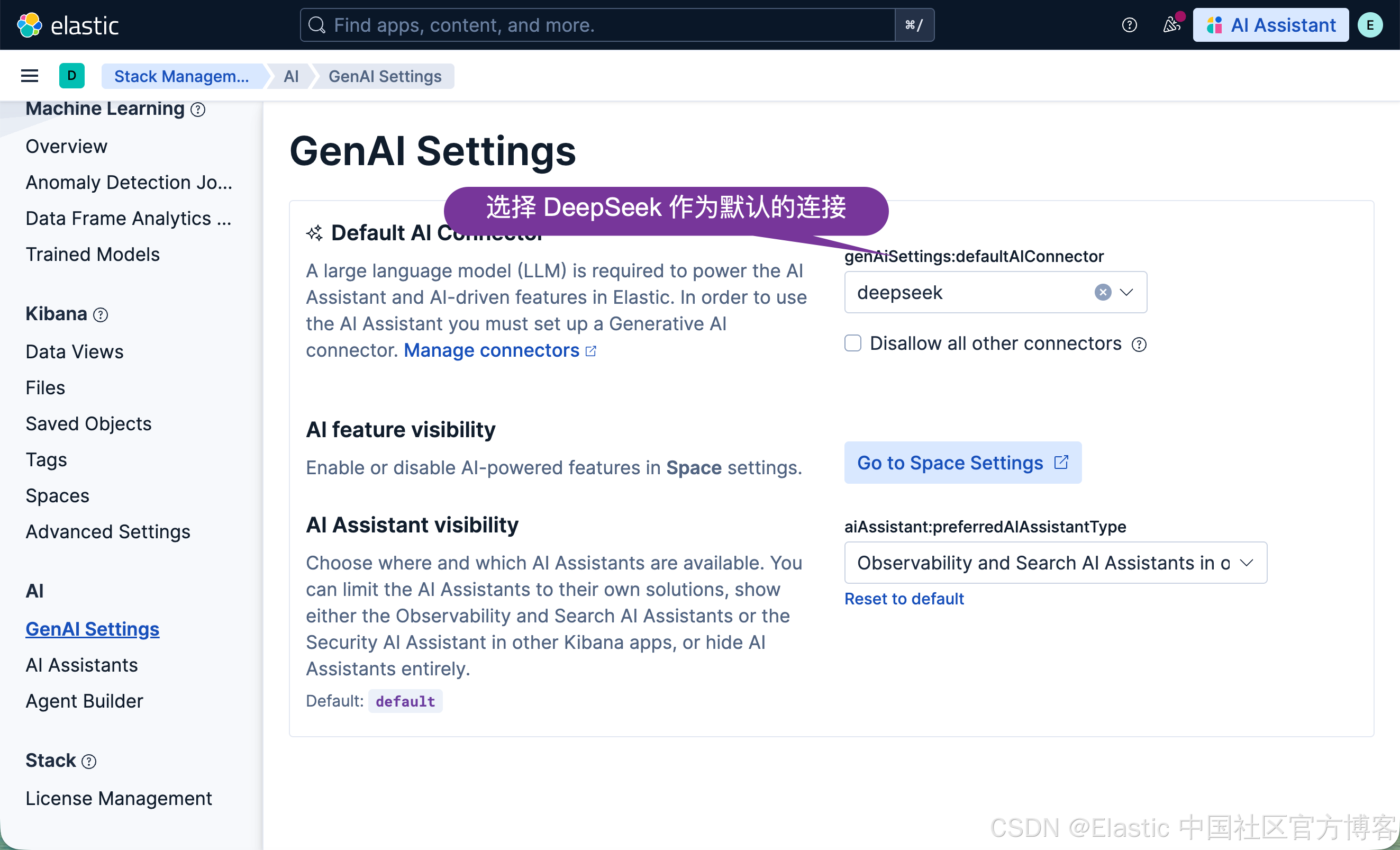

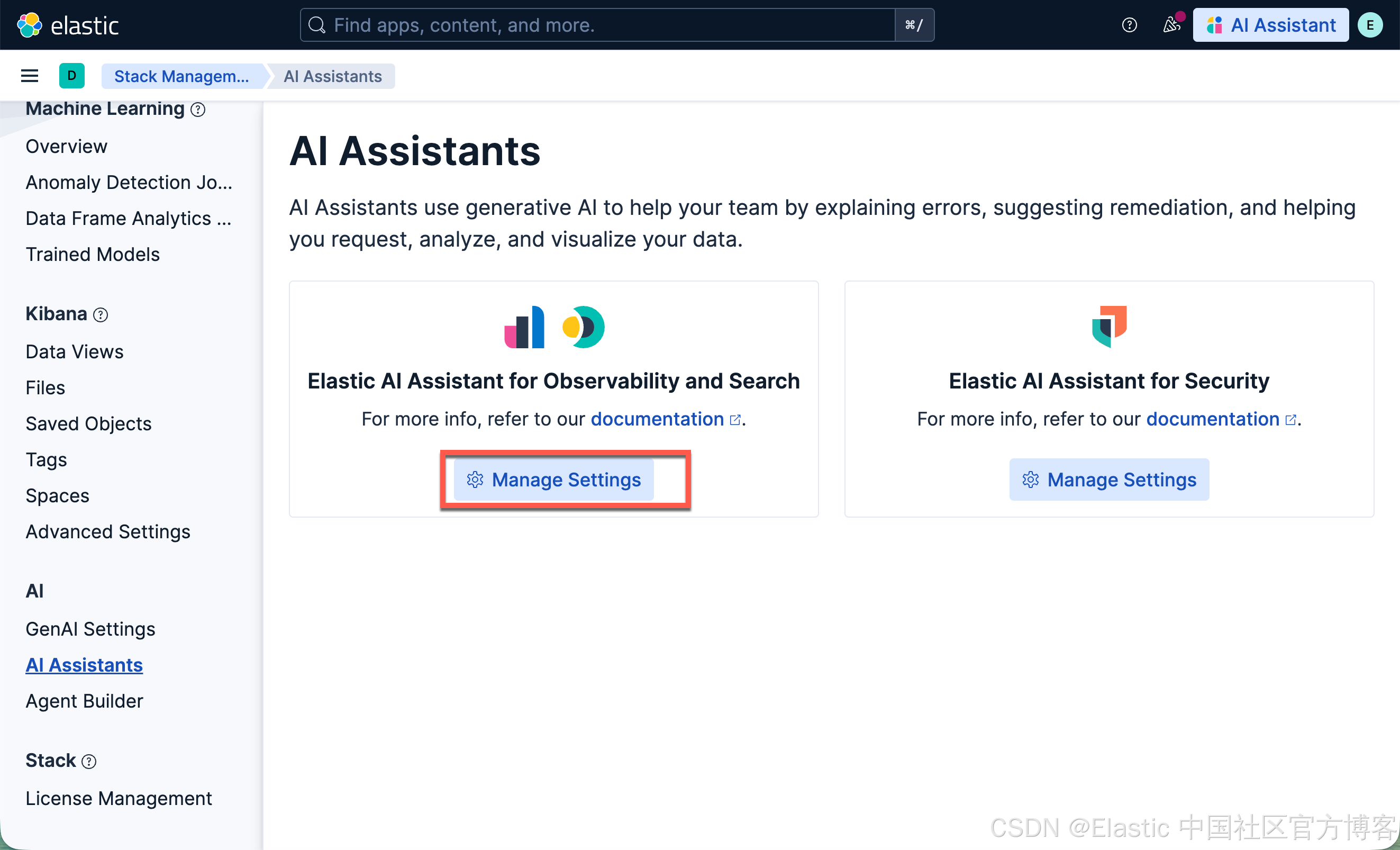

接下来,我们来配置 AI Assistant:

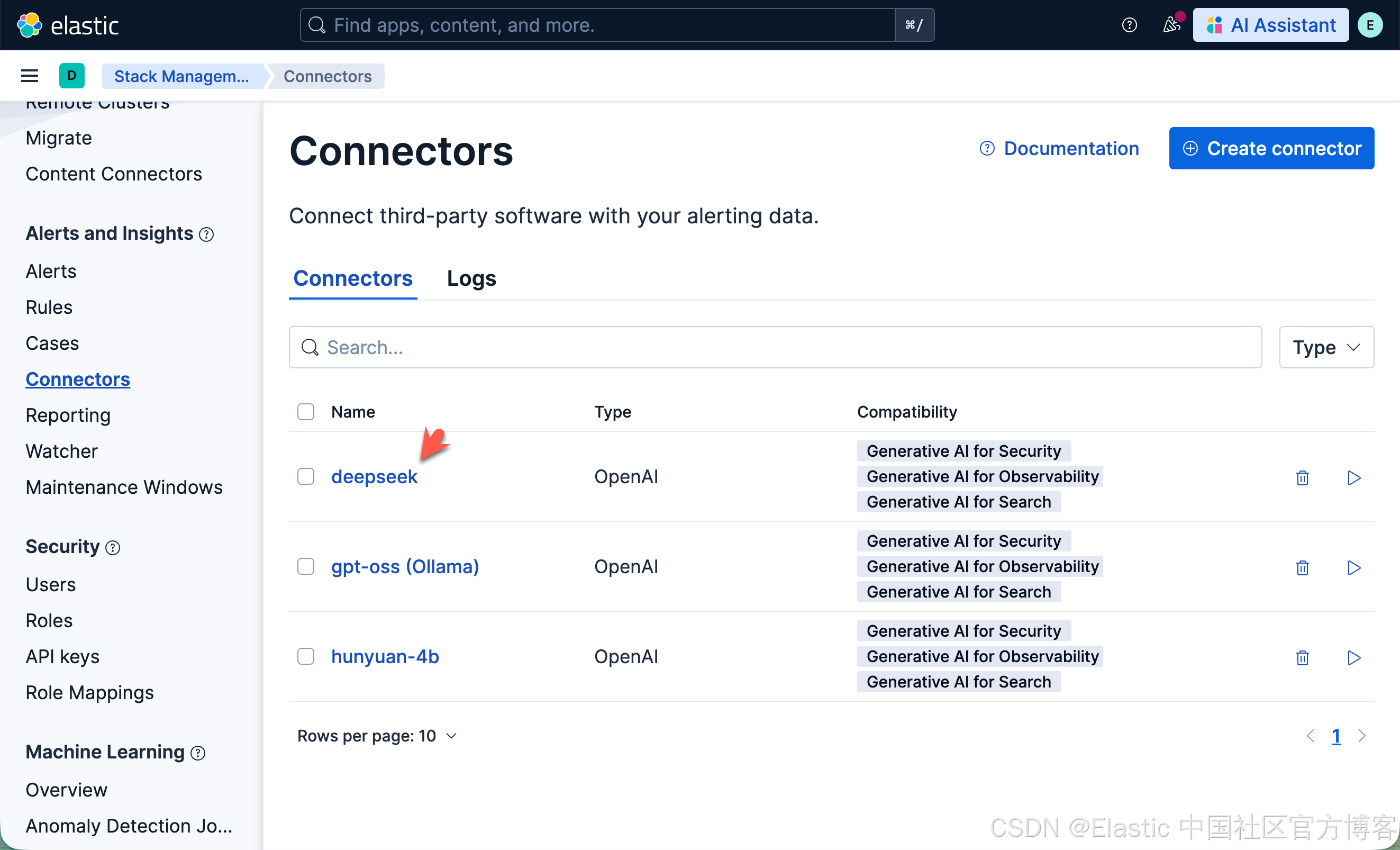

在上面,我们选择 deepseek 作为我们 AI Assistant 的默认连接器。你必须先按照 “Elasticsearch:在 Elastic 中玩转 DeepSeek R1 来实现 RAG 应用” 文章来配置。在我的展示中,我使用官方的 DeepSeek 来进行配置:

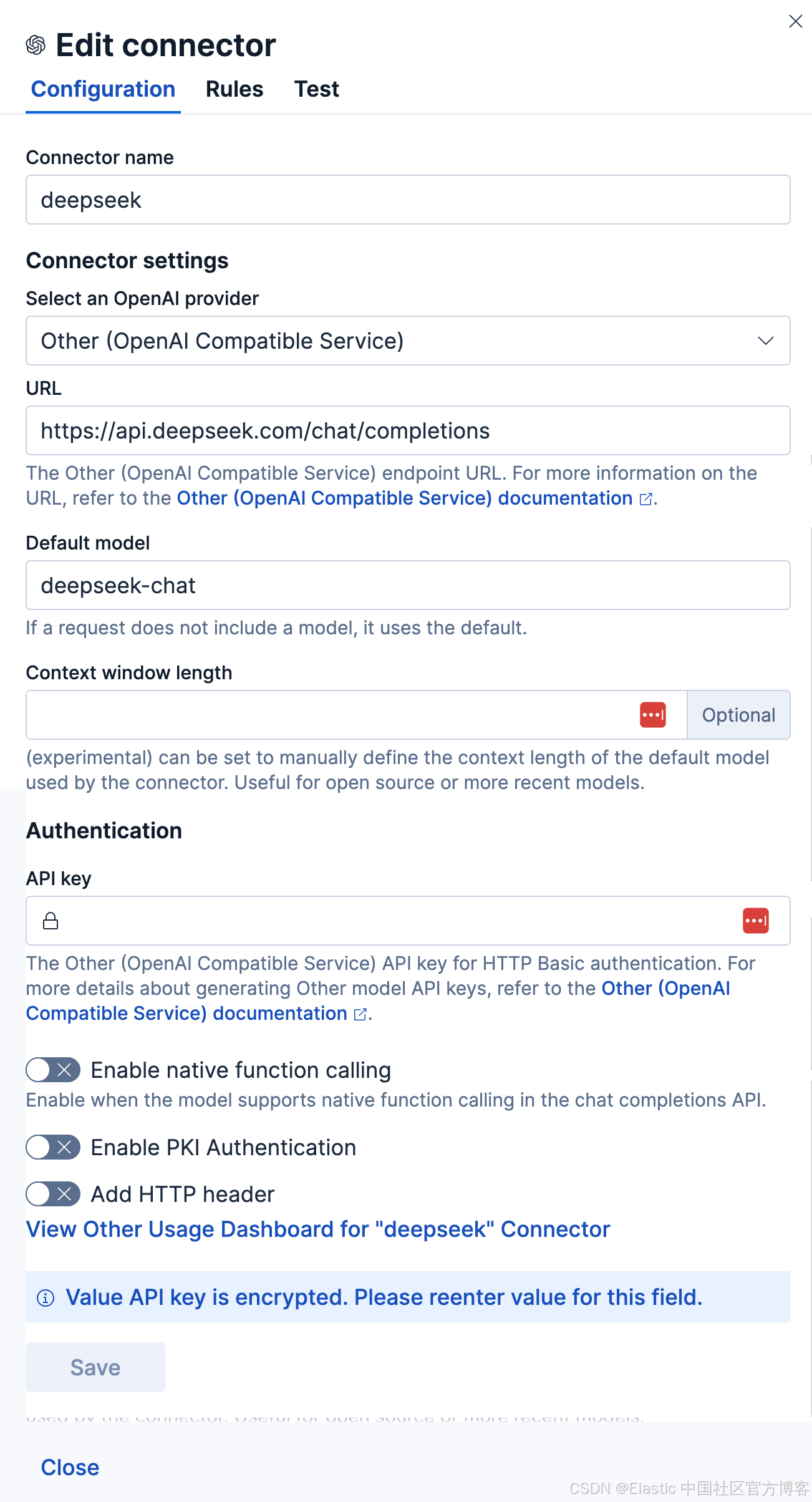

它的配置如下:

安装知识库

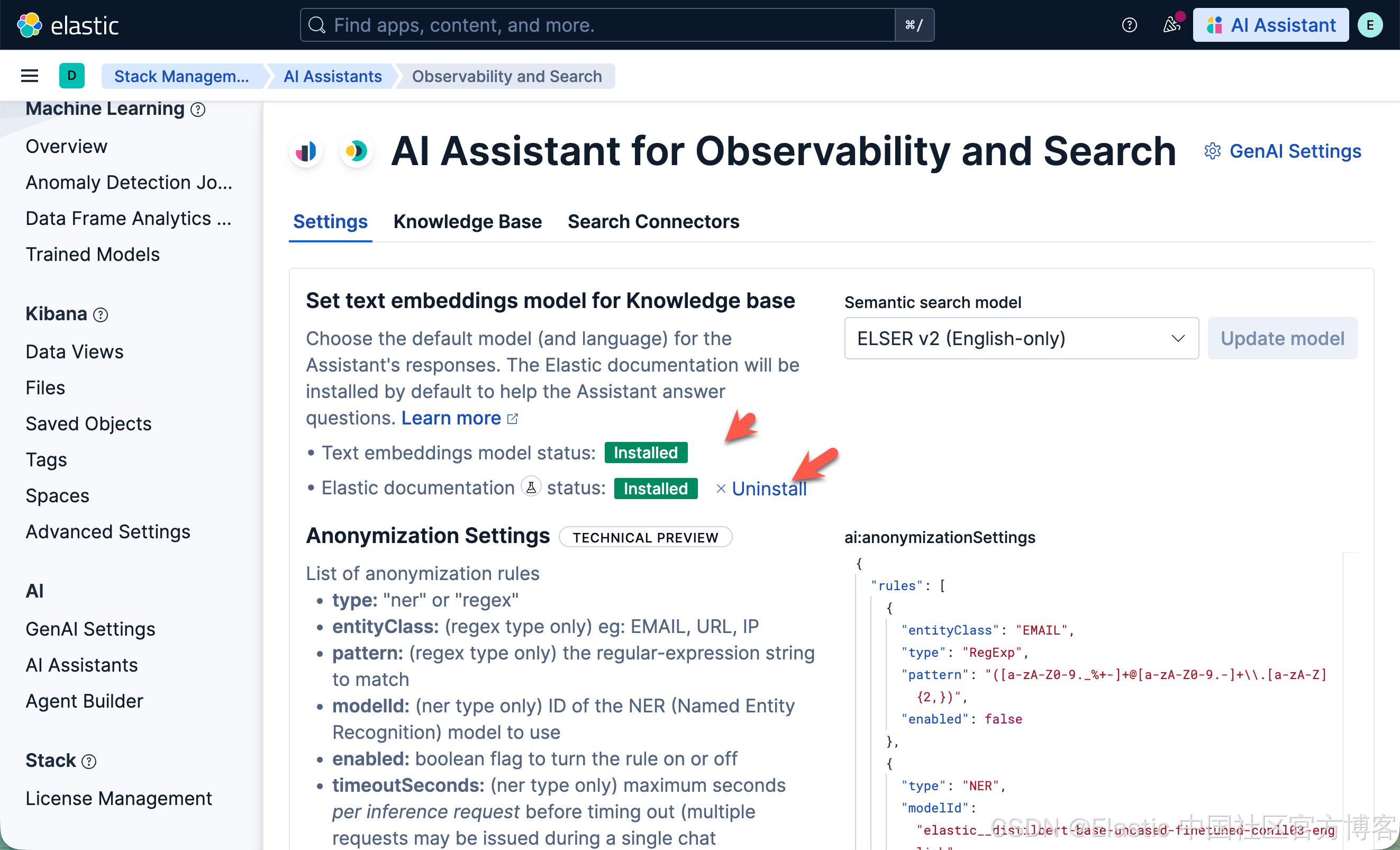

我们接下来安装 AI Assistant 所需要的知识库:

我们必须确保上面的知识库已经被成功地安装。

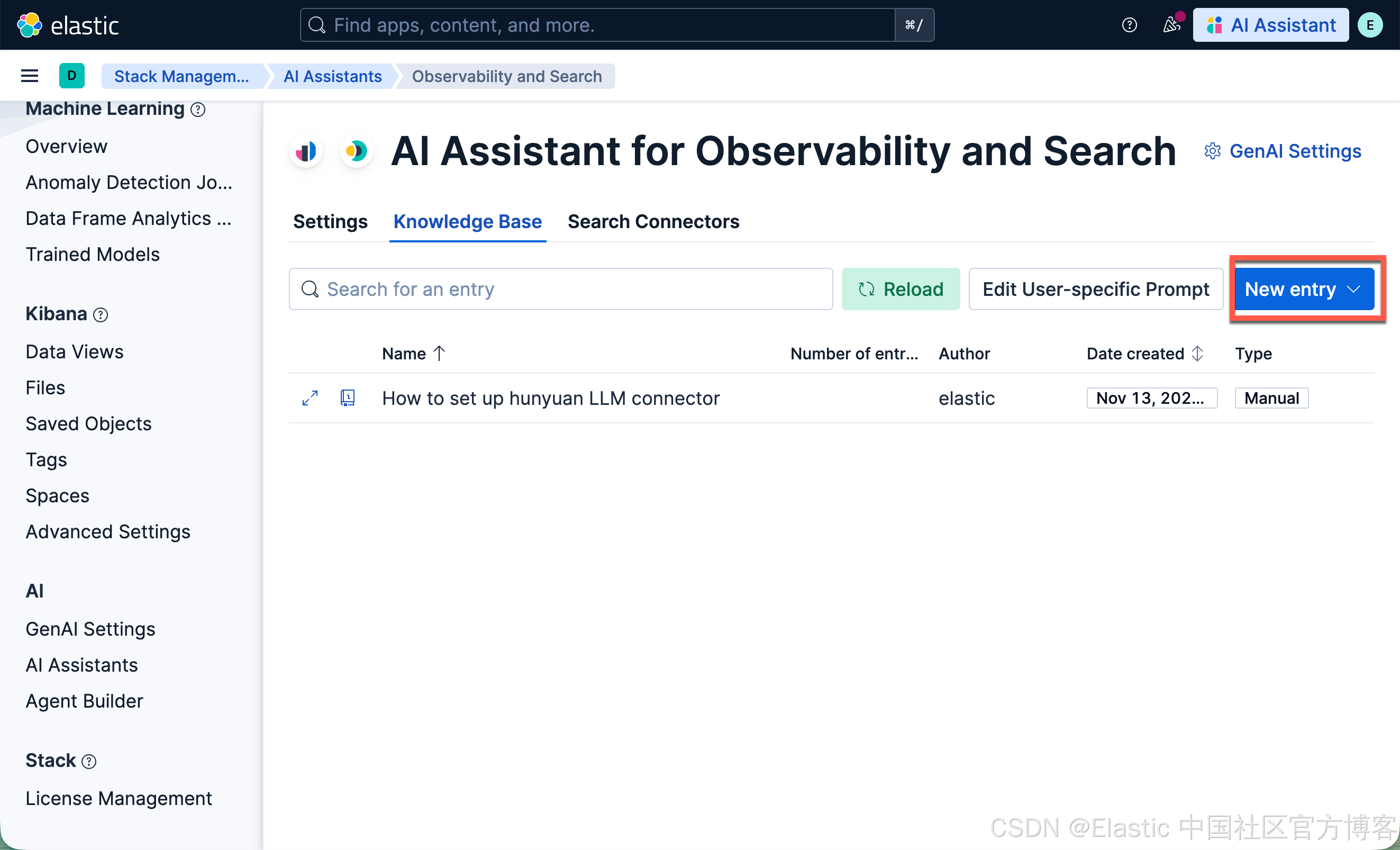

创建知识库

我们可以参考之前的文章 “AI 驱动的案例分流:几分钟内构建并部署” 来创建一个知识库:

How to set up hunyuan LLM connectorPlease use the following settings to create a hunyuan LLM connector.

- **Type**: Other(OpenAI Compatible Service)

- **Configuration**:

- "apiProvider": "Other"

- **API URL**: http://localhost:11434/v1/chat/completions

- **Default Model**: hunyuan-4b

- Authentication, **API key**: "Anything"

Please find the corresponding Kibana APIs to create the connector without human interaction. Once it is set, please conduct a test as well. When creating, please do not show the above settings during the creation.

这样我们的知识库就创建好了。

使用知识库创建混元连接器

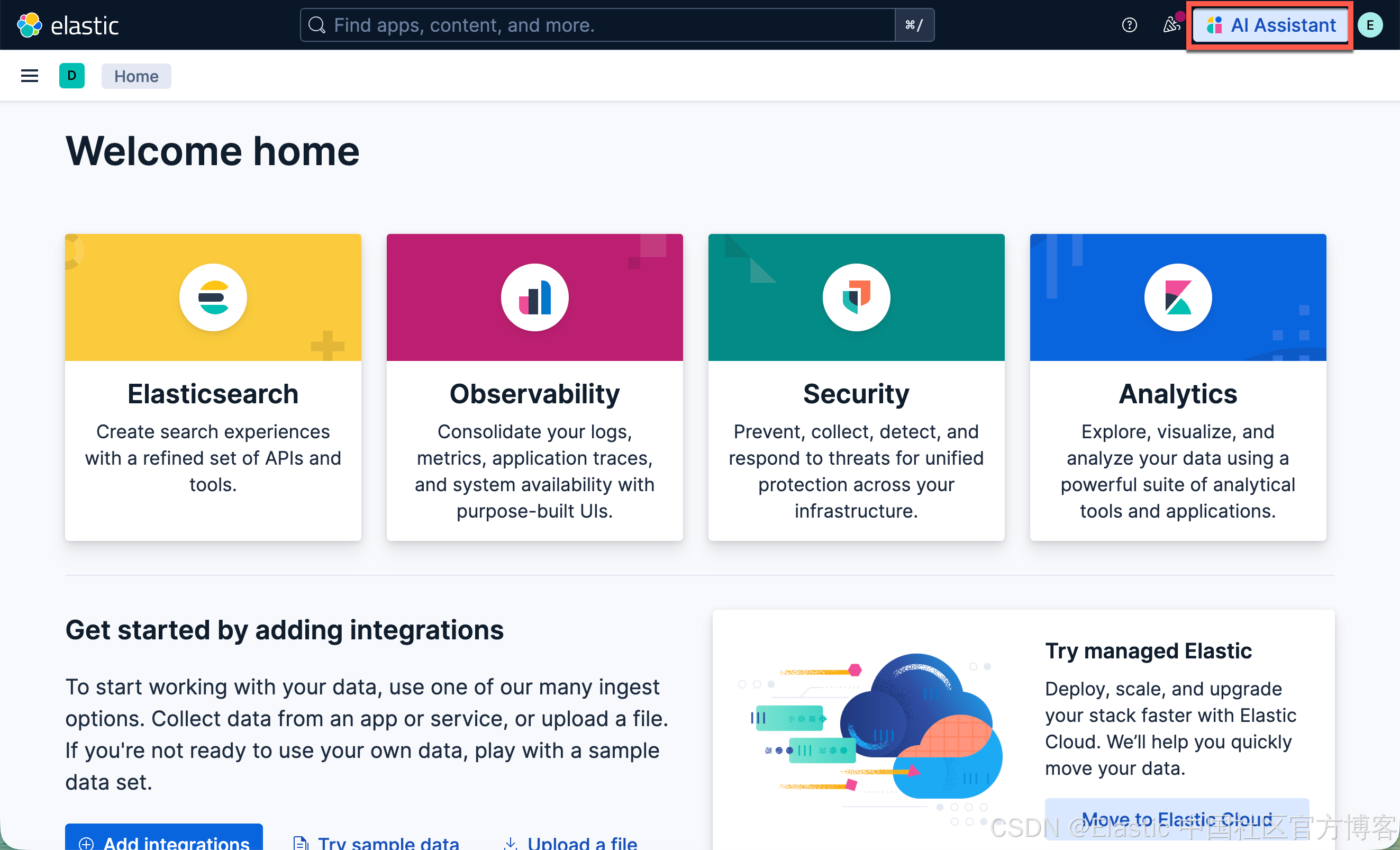

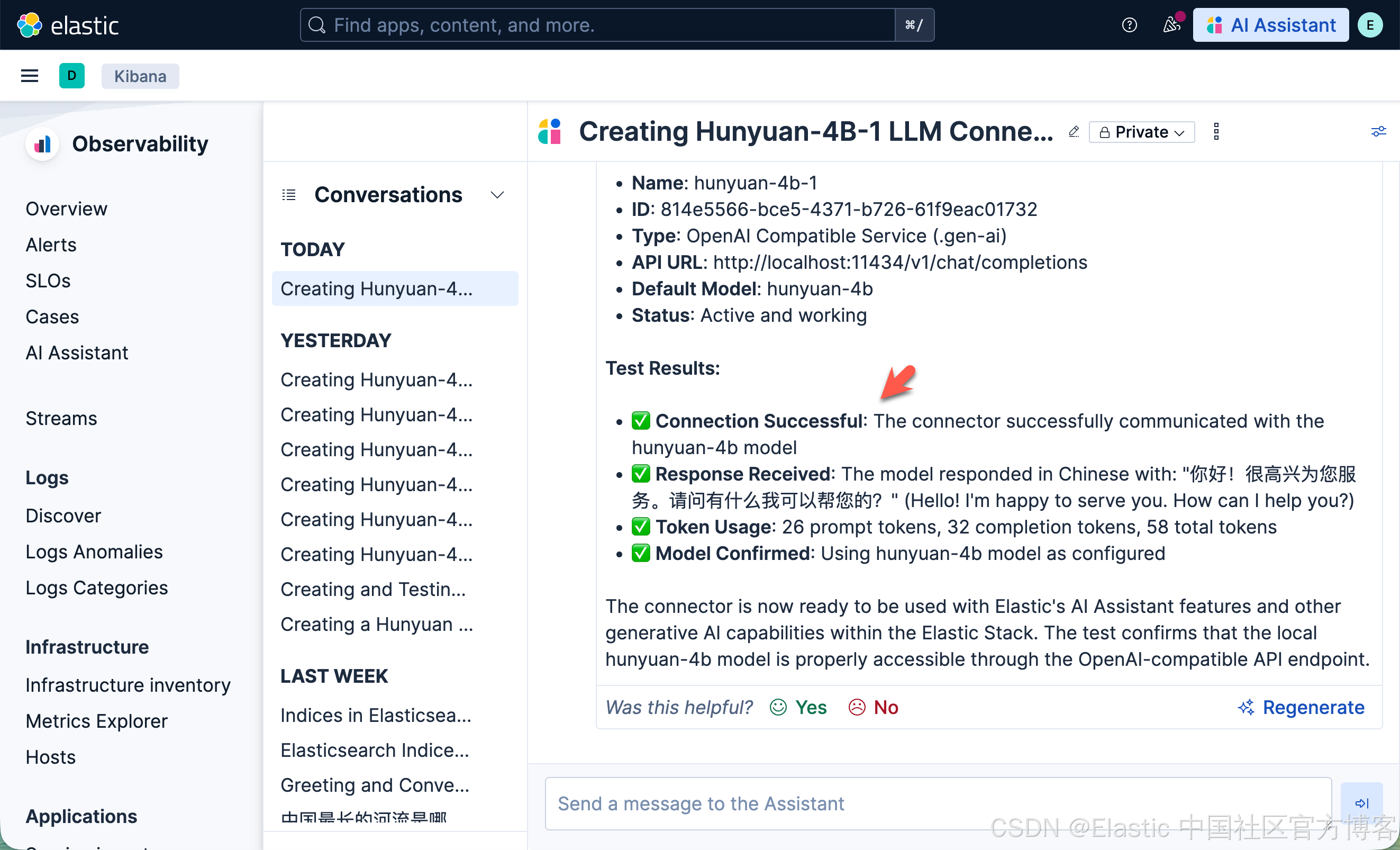

我们可以使用 AI Assistant 来创建一个叫做 hunyuan-4b-1 的连接器。首先我们打开 AI Assistant:

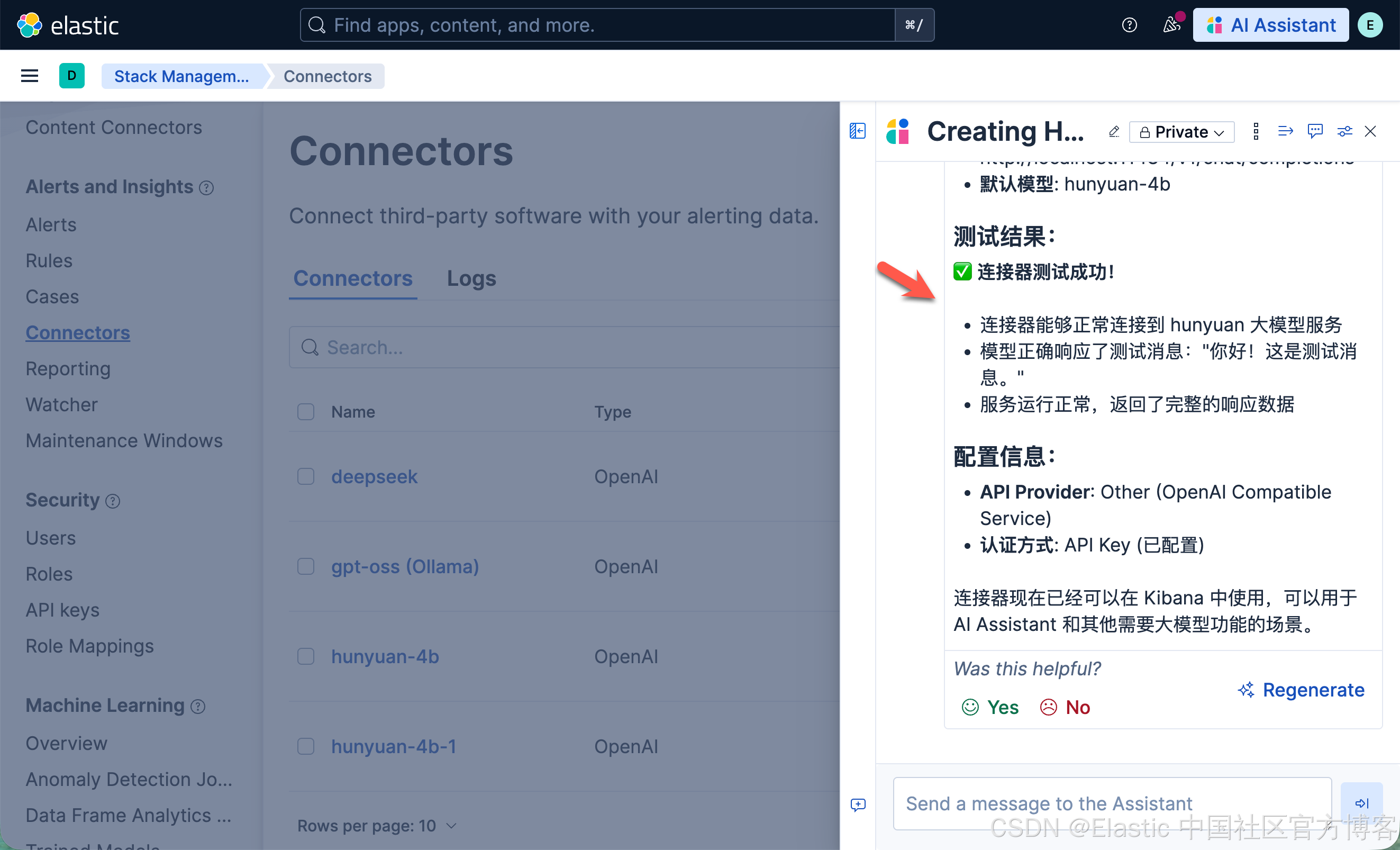

Please create a named "hunyuan-4b-1" hunyuan LLM connector

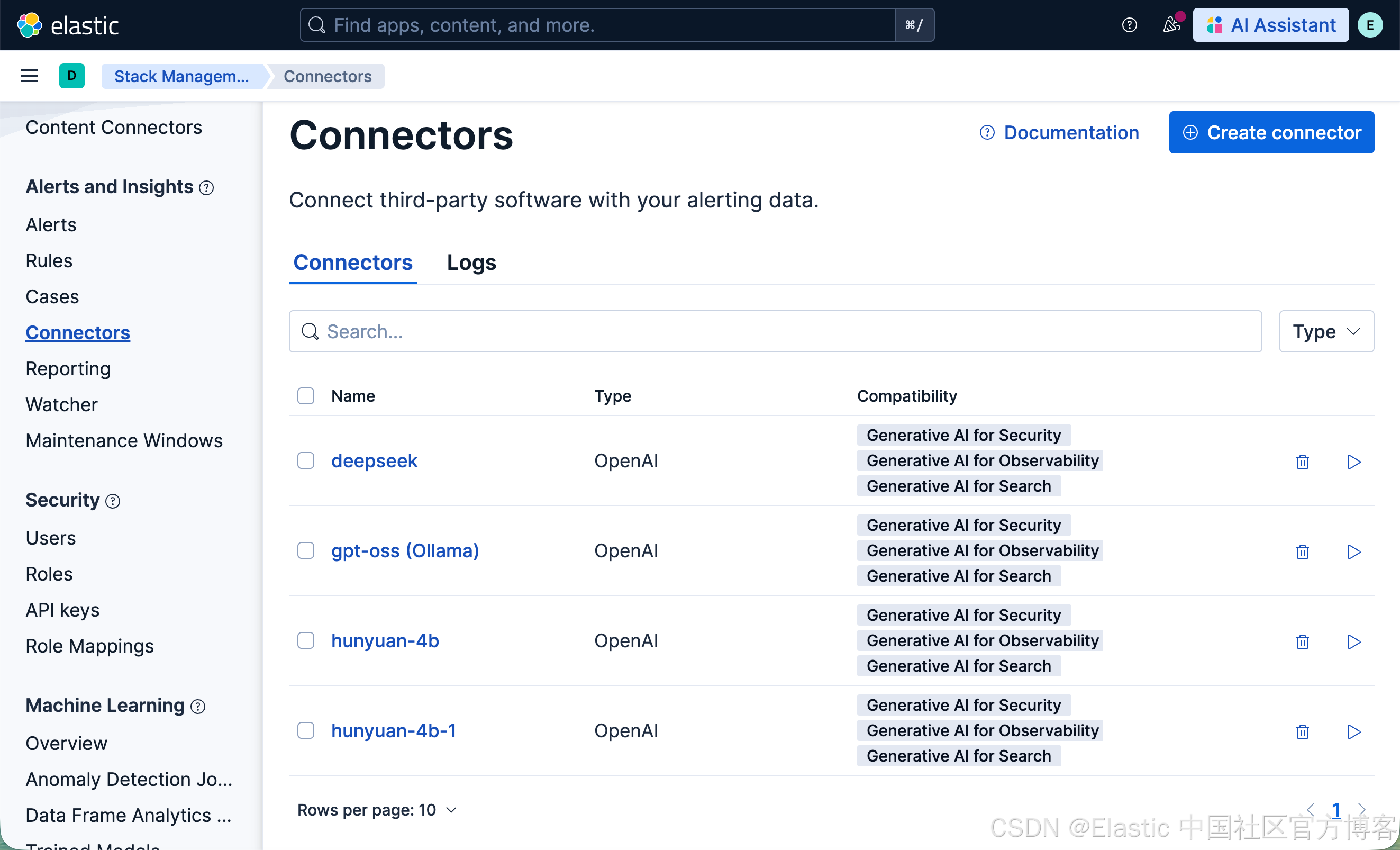

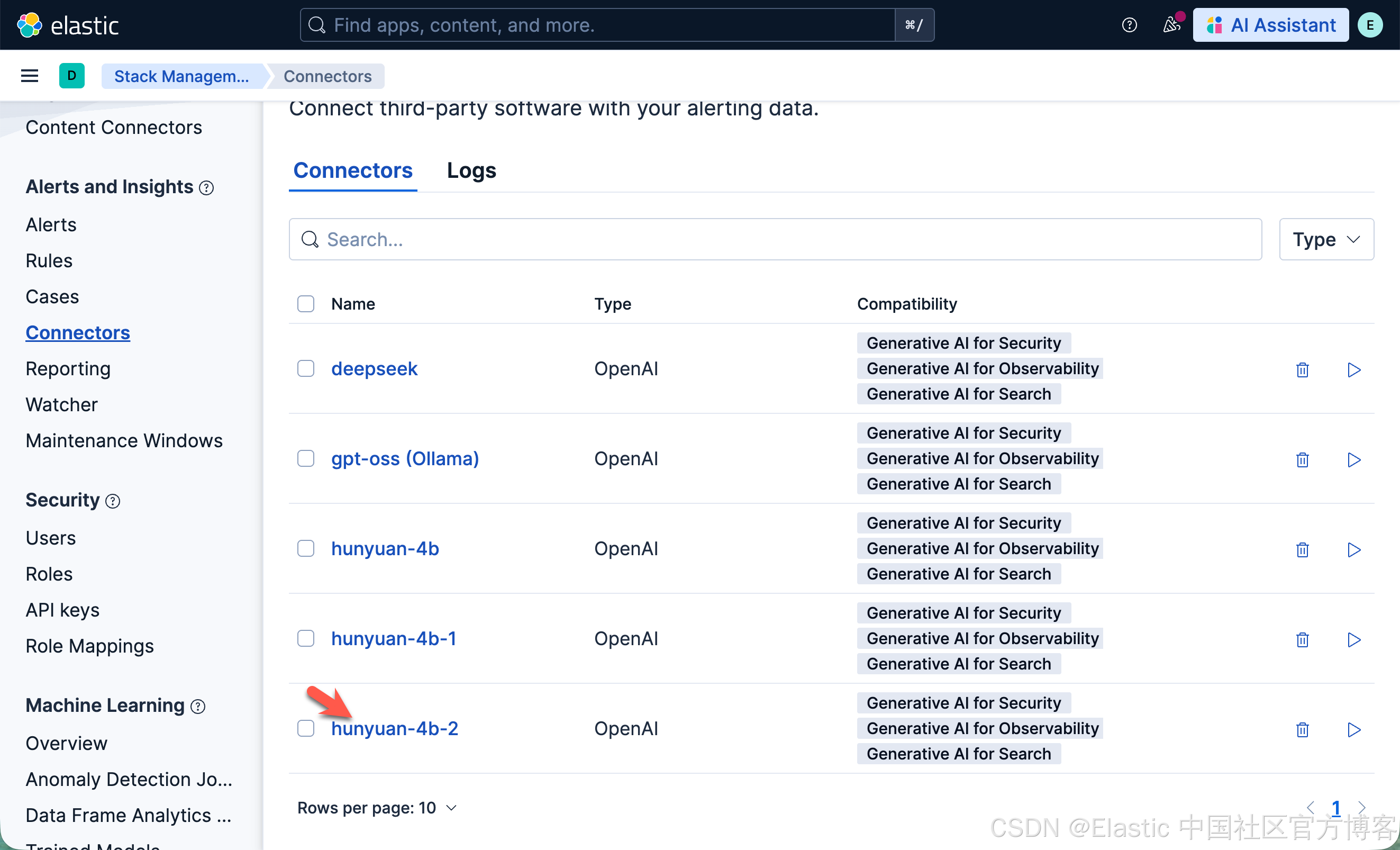

从返回的结果看,新创建的连接器已经成功测试。我们到 Connectors 页面进行查看:

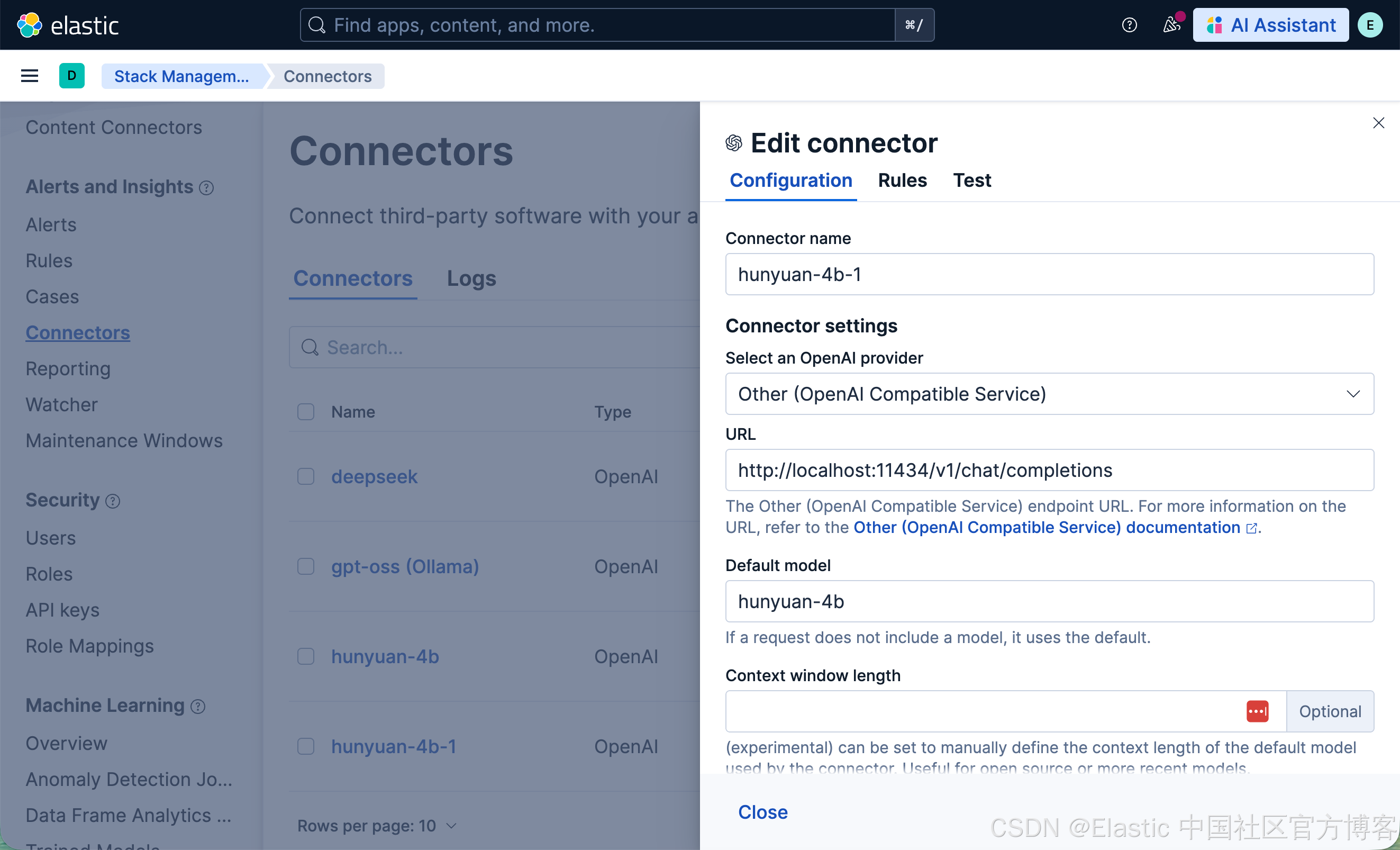

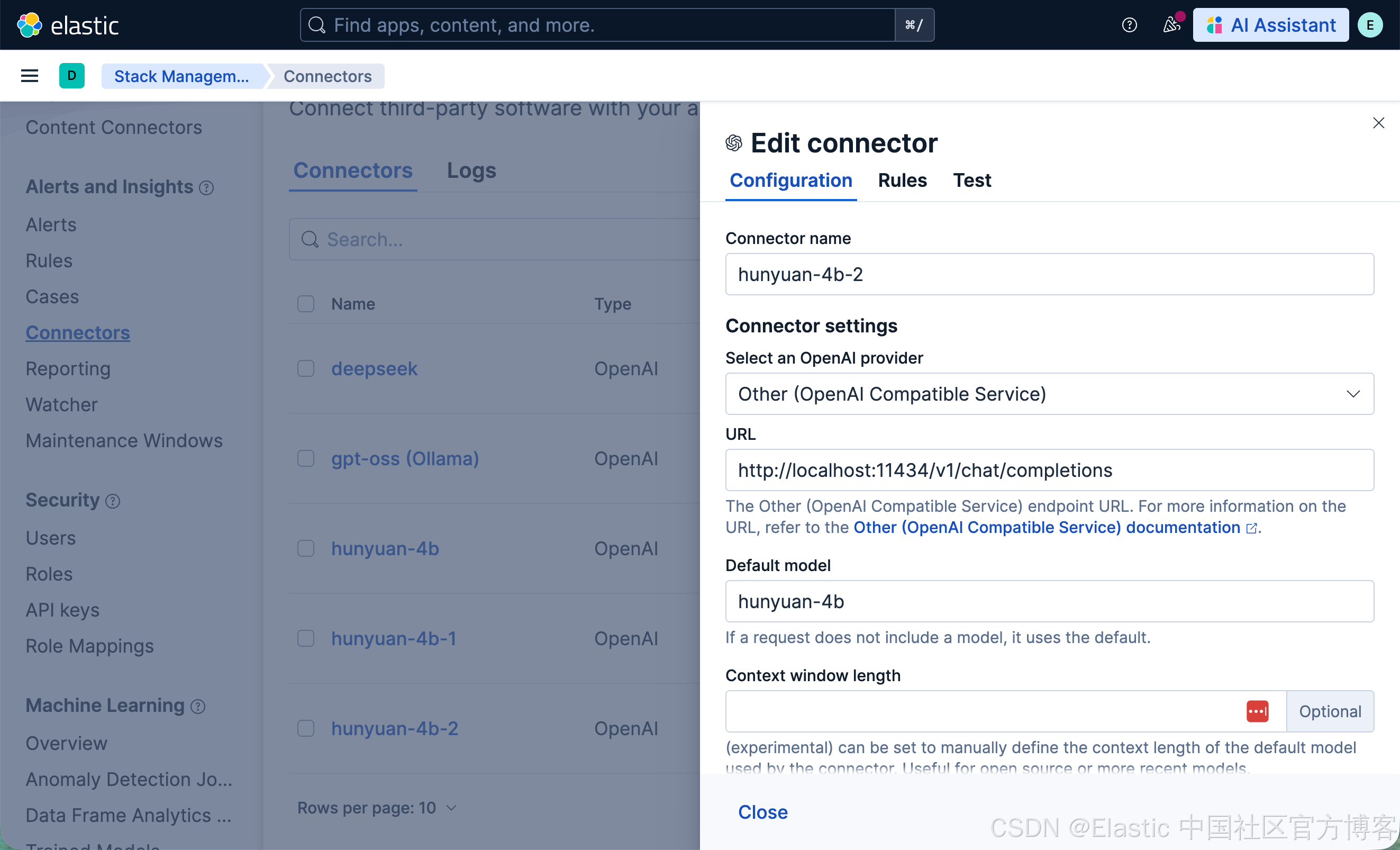

我们查看一下他的配置:

很显然它是按照我们的要求进行配置的。

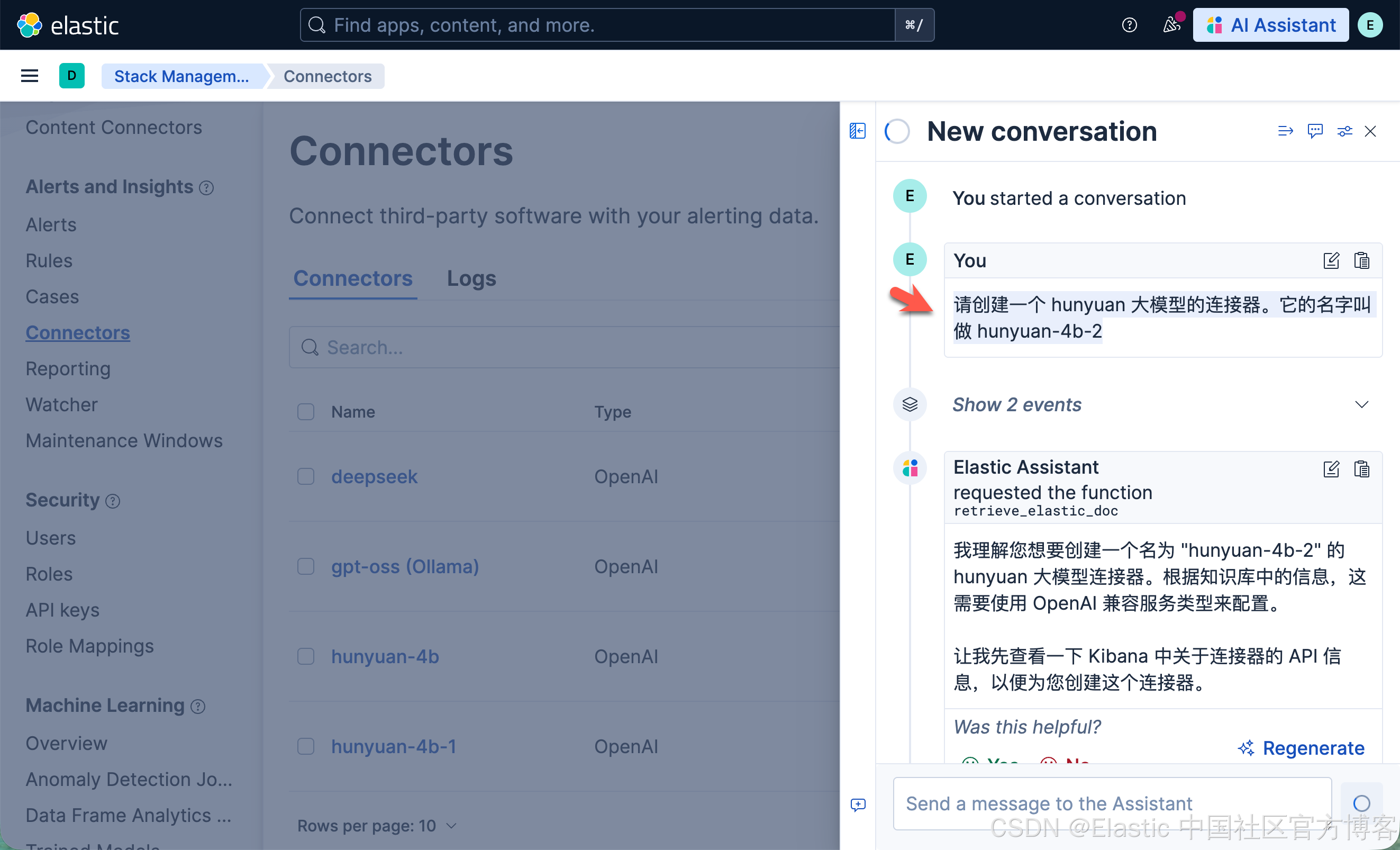

我们接下来使用中文来进行操作:

请创建一个 hunyuan 大模型的连接器。它的名字叫做 hunyuan-4b-2

我们接下来来查看它已经配置好的参数:

完美!它完全按照我们的意思进行了创建。是不是很奇妙?我们可以利通知识库做很多的事情。这里的展示只是运用人工智能进行操作的一个小的例子。你可以创建更多的案例来方便我们的操作及管理!

更多推荐

已为社区贡献104条内容

已为社区贡献104条内容

所有评论(0)