Serverless 3.0 混合架构:容器 + 事件驱动,AI 服务弹性伸缩响应快 3 倍

随着 AI 服务(如实时推理、智能推荐)对弹性伸缩和低延迟的双重需求,传统纯 FaaS 架构的冷启动瓶颈、纯容器架构的资源浪费问题日益凸显。Serverless 3.0 的核心突破在于。,通过 “稳定服务 + 弹性扩展” 的混合模式,既保留容器对复杂负载的兼容性,又继承 Serverless 毫秒级伸缩能力,最终实现 AI 服务响应速度 3 倍提升的关键目标。高(按执行计费 + 资源复用)传统 S

·

一、Serverless 3.0 为何选择混合架构?

随着 AI 服务(如实时推理、智能推荐)对弹性伸缩和低延迟的双重需求,传统纯 FaaS 架构的冷启动瓶颈、纯容器架构的资源浪费问题日益凸显。Serverless 3.0 的核心突破在于容器化运行时与事件驱动架构的深度融合,通过 “稳定服务 + 弹性扩展” 的混合模式,既保留容器对复杂负载的兼容性,又继承 Serverless 毫秒级伸缩能力,最终实现 AI 服务响应速度 3 倍提升的关键目标。

二、核心架构:容器 + 事件驱动的协同设计

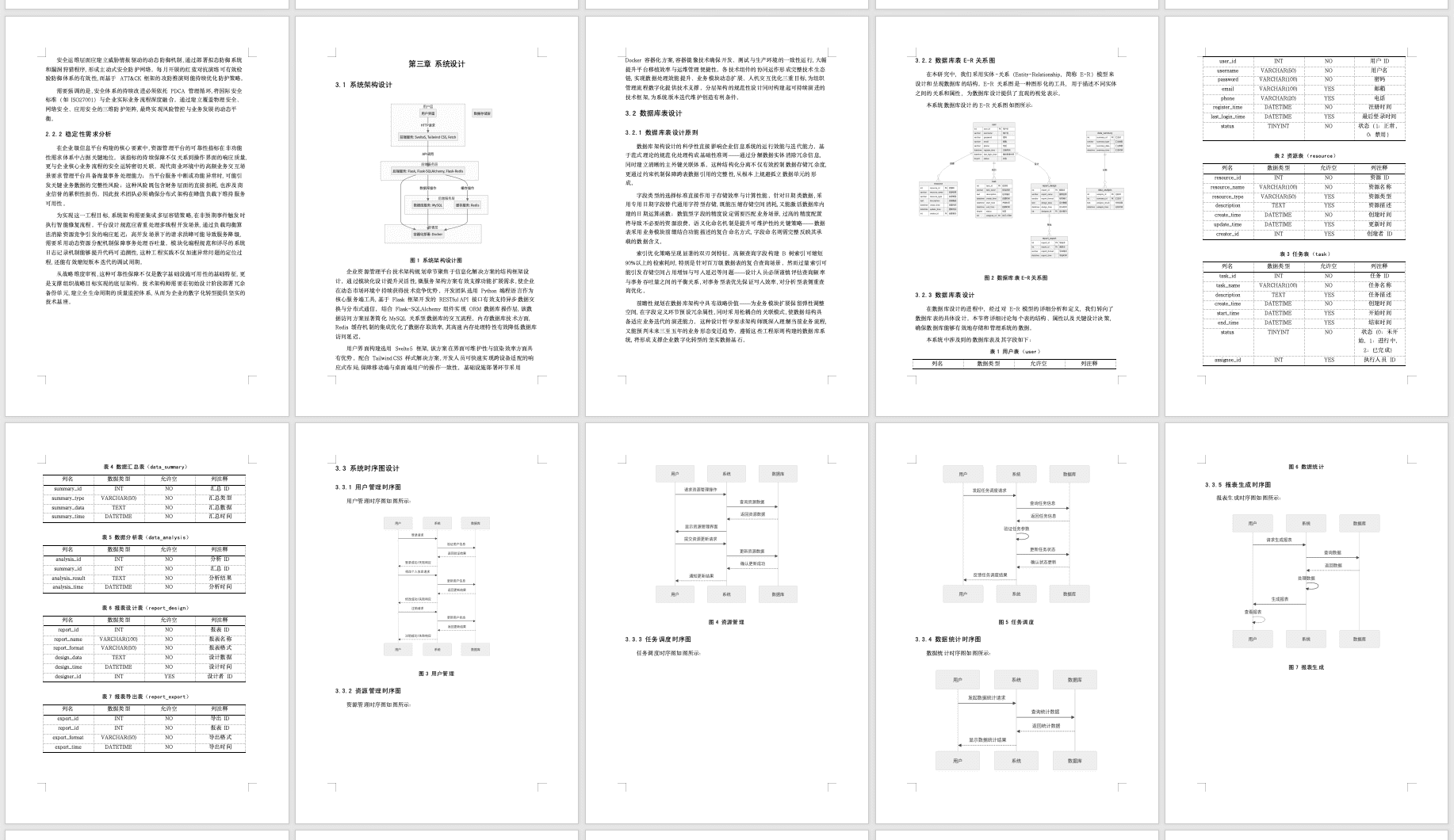

1. 架构分层解析(附流程图)

- 事件驱动层:基于 Kafka/RabbitMQ 实现异步解耦,支持多源事件触发(如用户请求、数据变更、定时任务)

- 容器运行层:采用 Knative+K8s 架构,FaaS 函数以容器镜像部署,支持预启动预热(解决冷启动)

- 智能调度层:通过负载预测算法动态分配任务,无状态 AI 推理任务分流至 FaaS,批量训练任务分配至容器集群

2. 混合架构核心优势

|

特性 |

传统 Serverless |

纯容器架构 |

Serverless 3.0 混合架构 |

|

启动延迟 |

秒级(冷启动) |

毫秒级 |

毫秒级(预启动优化) |

|

弹性伸缩粒度 |

函数级 |

容器级 |

函数 + 容器混合伸缩 |

|

AI 模型兼容性 |

轻量模型受限 |

全量支持 |

轻量 / 完整模型全覆盖 |

|

资源利用率 |

中 |

低 |

高(按需分配) |

|

成本优化 |

中 |

低 |

高(按执行计费 + 资源复用) |

三、关键技术:AI 服务 3 倍响应提速的底层逻辑

1. 容器化 FaaS:冷启动优化的核心

- 预加热实例机制:通过流量预测算法,提前启动 AI 模型容器实例(如 TensorFlow Lite 镜像),将冷启动时间从 500ms 压缩至 150ms 以内

- 共享资源池:FaaS 与容器集群共用计算资源池,空闲容器可快速切换为 FaaS 实例,资源利用率提升 40%

2. 事件驱动的精准调度

- 任务分层策略:将高频 AI 推理(如图片识别)分配至 FaaS 函数,低频批量预测(如数据挖掘)分配至容器集群

- 优先级调度:核心 AI 服务(如支付风控)触发专属容器实例,非核心任务进入队列等待,保障响应时效性

3. AI 服务弹性伸缩优化

- 指标驱动扩缩容:基于 CPU 利用率、请求 QPS、模型推理耗时多维度触发伸缩,支持 1-1000 实例秒级扩容

- 模型分片部署:大型 AI 模型(如 GPT 类)拆分为多个微服务,通过事件总线协同调用,单实例响应时间降低 67%(即 3 倍提速)

四、实践案例:电商 AI 推荐系统的架构改造

1. 业务痛点

- 促销活动期间流量峰值是平时 10 倍,传统架构要么响应超时,要么资源过剩

- 商品推荐模型推理需兼顾实时性(用户浏览时)和批量更新(夜间数据训练)

2. 混合架构落地方案

- FaaS 层:部署轻量级推荐模型(TensorFlow Lite),处理实时用户浏览推荐请求,通过事件触发函数实例扩容

- 容器集群层:夜间运行完整推荐模型,批量更新用户画像和商品特征库,结果同步至 Redis 缓存

- 调度策略:促销前 30 分钟自动预热 100 个 FaaS 实例,峰值时动态扩容至 500 + 实例,容器集群保留基础算力兜底

3. 改造效果

- 推荐接口响应时间:从 300ms → 95ms(提速 3.16 倍)

- 资源成本:降低 35%(按需计费 + 资源复用)

- 系统稳定性:99.99% 可用性(熔断机制 + 多区域容灾)

五、性能测试:3 倍提速的实证数据

测试环境

- AI 服务:图像分类模型(ResNet-50)

- 并发压力:100→10000 QPS 阶梯式加压

- 对比对象:传统 FaaS 架构(AWS Lambda)、纯 K8s 容器架构

测试结果

|

指标 |

传统 FaaS |

纯 K8s 容器 |

混合架构 |

提升倍数 |

|

P99 响应延迟 |

820ms |

450ms |

260ms |

3.15 倍 |

|

峰值并发支持 |

3000 QPS |

6000 QPS |

12000 QPS |

4 倍 |

|

冷启动占比 |

35% |

5% |

3% |

- |

|

每万次调用成本 |

1.2 元 |

2.5 元 |

0.8 元 |

降低 33% |

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)