项目分享 | RLinf:专为模型后训练而设计的大规模强化学习框架

RLinf是一个开源、灵活的强化学习训练基础设施,专为VLA等大模型的后训练优化设计。它统一支持具身智能、数学推理、智能体训练等多场景,集成了主流模型、仿真器与算法。其创新架构实现了高效的分布式训练,在ManiSkill、LIBERO等基准上取得SOTA性能,显著降低了前沿RL研究的工程门槛。

当你的大模型“学会”操作机械臂、解答数学难题、甚至编写代码时,背后可能正运行着这套开源引擎。

引言

在通往通用人工智能的道路上,强化学习(RL)正扮演着愈发关键的角色。无论是训练机器人灵巧操作,还是提升大模型的数学推理与代码能力,高效的RL训练框架都是不可或缺的“发动机”。然而,现有方案往往在灵活性、扩展性与易用性之间难以平衡。由清华大学等单位贡献的开源项目 RLinf ,它的名字寓意深刻:inf 既是 Infrastructure(基础设施),也是 Infinite(无限可能)。它旨在为大规模模型的后训练(尤其是RL)提供一个统一、高效、且无限扩展的“超级底座”,将强化学习的复杂性封装于内,将创新的可能性释放于外。

重新定义RL训练范式的“超级底座”

RLinf 究竟是什么?简单说,它是一个专为大模型(尤其是视觉-语言-动作模型VLA)通过强化学习进行后训练而设计的开源基础设施。它的目标并非替代某个特定的RL算法库,而是构建一个能承载从仿真环境交互、分布式数据收集、到多节点模型更新全流程的工业级系统。

其核心价值在于提供了三大场景的统一支持:

- 具身智能:支持在 ManiSkill、IsaacLab、MetaWorld、BEHAVIOR-1K 等主流机器人仿真器中,对 OpenVLA、π₀、π₀.₅、GR00T 等VLA模型进行RL微调,让机器臂“越练越巧”。

- 智能体RL:支持对代码、数学推理等领域的智能体进行在线强化学习训练,例如提升大模型解决复杂数学问题的能力。

- 高灵活性与扩展性:通过其创新的“从宏流到微流”的转换架构,将复杂的分布式RL流程模块化,用户可以用简洁的代码定义训练逻辑,而RLinf负责无缝扩展到成百上千的GPU上执行。

核心技术优势:不止于统一,更在于强大

RLinf 的竞争力,建立在几个坚实的技术支柱之上:

1. 顶级的性能表现,结果说话

- 在具身智能领域:基于RLinf,OpenVLA模型在ManiSkill任务上的成功率从基线的53.91%跃升至96.09%;OpenVLA-OFT在LIBERO基准上的平均成功率从65.43%提升至惊人的98.11%。

- 在数学推理领域:其训练的

RLinf-math-1.5B和RLinf-math-7B模型,在AIME、GPQA等权威数学基准上达到了同等规模模型的领先水平。 - 在尖端模型支持上:RLinf率先实现了对 DeepSeek 的 π₀ 和 π₀.₅ 模型家族的RL微调,通过“流匹配专家”方法,仅用少量数据就取得了显著性能提升。

2. 灵活与效率并重的系统设计

- 统一的工作流抽象:用户可以用直观的“宏流”定义训练任务(如数据收集、模型更新),系统自动将其编译为高效的“微流”在计算集群上并行执行。

- 混合后端支持:无缝集成 FSDP + HuggingFace/SGLang/vLLM 用于快速原型开发,也可对接 Megatron + SGLang/vLLM 用于追求极致效率的大规模生产训练。

- 卓越的吞吐量:针对具身RL的混合执行模式,相比基线方案带来了超过100%的吞吐量提升。

3. 全面的生态集成

项目像一个强大的“连接器”,集成了主流VLA模型、十多种机器人仿真器、以及PPO、GRPO、DAPO等多种RL算法。这种开箱即用的丰富性,极大降低了前沿研究的工程门槛。

快速入门与体系化学习路径

开始你的第一个RL训练

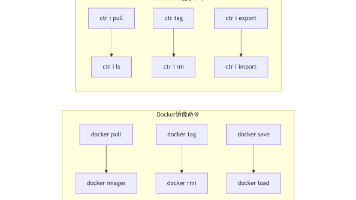

对于新用户,最推荐的启动方式是使用项目提供的 Docker镜像,以规避复杂的依赖环境。

- 环境准备:按照安装指南,拉取并运行RLinf Docker容器。

- 运行示例:参照快速开始文档,使用ManiSkill仿真器和OpenVLA模型,运行一个简单的具身RL训练示例。你将亲眼看到智能体在几次迭代后变得“熟练”。

- 探索更多:项目提供了详尽的示例库,覆盖从π₀模型微调到在线编码智能体训练的各种场景,是学习的最佳模板。

从使用者到贡献者

RLinf 采用模块化设计,核心的 Worker、调度器、通信层等接口清晰。如果你希望:

- 添加新的仿真器:实现标准化的 Worker 接口即可。

- 集成新的模型或算法:在现有的训练流水线框架内进行扩展。

- 优化系统性能:可以深入其分布式执行引擎。

项目欢迎社区贡献,并有清晰的贡献指南。

作为探索大模型强化学习前沿的绝佳平台,RLinf的完整架构设计与丰富应用实例已被系统性地收录于 AladdinEdu平台课题广场 中。

项目地址:AladdinEdu-课题广场

更多推荐

已为社区贡献20条内容

已为社区贡献20条内容

所有评论(0)