项目分享|Tinker Cookbook:你的大模型微调实战宝典

Tinker Cookbook是由Thinking Machines Lab推出的开源大模型微调工具集,包含`tinker`训练SDK与`tinker-cookbook`示例库。它通过API封装了分布式训练复杂性,提供对话、数学推理、RLHF、工具调用等多场景“食谱”,极大降低了定制AI模型的门槛,是研究者与开发者进行高效模型调优的利器。

无需操心分布式训练与硬件集群,仅凭API调用即可完成从SFT到RLHF的全流程大模型调优

引言

在大模型时代,微调(Fine-tuning)已成为释放模型潜力、适配垂直场景的核心技术。然而,对于大多数研究者和开发者而言,微调的门槛依然高耸:动辄需要协调多卡GPU、处理复杂的分布式训练框架、调试深不见底的超参数……整个过程如同在原始丛林里徒手建造摩天大楼。今天,由Thinking Machines Lab推出的 Tinker Cookbook 项目,旨在彻底改变这一局面。它将大模型微调封装为一套清晰、优雅的API与“食谱”,让你能像在设备齐全的厨房中跟随菜谱烹饪一样,轻松、高效地定制属于自己的AI模型。

什么是Tinker Cookbook?

Tinker Cookbook 是一个由两部分组成的开源项目,旨在为社区提供定制化语言模型的完整解决方案:

tinker- 训练SDK:这是核心引擎。它向用户暴露简洁的API(如forward_backward,optim_step),而将分布式训练、资源调度、底层框架兼容性等所有复杂性隐藏在云端。研究者只需关注模型逻辑本身。tinker-cookbook- 微调食谱库:这是建立在Tinker API之上的“实战指南”。它提供了一系列高级抽象和即用型示例(Recipes),覆盖了从监督学习到强化学习的各种主流微调场景。

简单来说,tinker 给了你一套顶级的厨具和灶台,而 tinker-cookbook 则提供了从“番茄炒蛋”到“佛跳墙”的详尽菜谱。二者结合,让AI模型的微调工作变得前所未有的标准化和可复现。

核心优势与创新理念

1. API驱动,极致简化

Tinker 最大的创新在于其 “云原生”的微调范式。用户无需搭建PyTorch分布式环境、无需关心NCCL通信或混合精度训练。通过几个直观的API调用,即可在远端强大的计算集群上启动和监控训练任务。这极大降低了实验的启动成本和运维负担。

2. 覆盖全面的“食谱”体系

Tinker Cookbook 并非空洞的框架,它提供了大量开箱即用、经过验证的实例,这些“食谱”本身就是宝贵的学习资源和工程实践参考:

- 对话微调:基于Tulu3等数据集进行有监督微调(SFT)。

- 数学推理:通过强化学习奖励模型正确解答数学问题。

- 完整RLHF流水线:展示SFT -> 奖励模型训练 -> RL优化三阶段全流程。

- 工具调用:训练模型更好地使用检索工具来回答问题。

- 多智能体对抗:优化LLM在与其他LLM对抗或自我对弈中的表现。

3. 聚焦核心创新,屏蔽底层杂音

项目提供了丰富的实用工具,如renderers(处理聊天消息格式)、hyperparam_utils(自动计算LoRA超参)、evaluation(模型评估框架)。这使得开发者能将精力100%投入到算法创新和业务逻辑上,而非重复造轮子。

4. 面向生产的实用主义设计

从支持模型权重下载,到与标准评测平台InspectAI的便捷集成,都体现了项目不仅关注“跑通实验”,更关注“产出可用、可评估、可部署的模型”,具备很强的工程实用价值。

快速上手指南

环境准备与安装

- 申请权限:首先通过官方等待列表申请Tinker的访问权限。

- 获取密钥:在Tinker控制台创建API Key,并设置为环境变量:

export TINKER_API_KEY=your_key_here。 - 安装客户端:通过pip安装核心SDK:

pip install tinker。 - 安装食谱库:建议在虚拟环境中安装cookbook以获得全部示例:

pip install -e .(在项目目录下)。

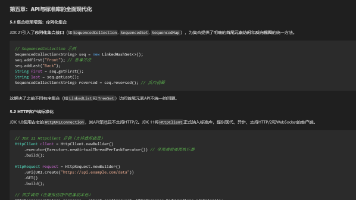

核心API初体验

使用Tinker进行微调的核心流程清晰明了:

import tinker

# 1. 创建服务客户端

service_client = tinker.ServiceClient()

# 2. 创建LoRA训练客户端,指定基座模型

training_client = service_client.create_lora_training_client(

base_model="meta-llama/Llama-3.2-1B", rank=32,

)

# 3. 执行训练循环(前向、反向、优化步骤)

# 4. 保存状态并获取用于推理的采样客户端

sampling_client = training_client.save_weights_and_get_sampling_client(name="my_model")

# 5. 使用微调后的模型进行采样

output = sampling_client.sample(...)

运行你的第一个“食谱”

项目中最简示例位于 tinker_cookbook/recipes/sl_basic.py 和 rl_basic.py。你可以直接运行它们来体验完整的监督学习或强化学习微调流程。每个高级“食谱”(如数学推理、工具使用)目录下都有详细的README,指导你理解原理、运行命令并验证效果。

下载与评估模型

微调完成后,你可以轻松下载完整的模型权重存档,以便离线部署或进一步分析。同时,利用内置的评估工具或对接InspectAI,可以系统化地衡量模型在标准基准测试上的性能提升。

该项目涵盖的完整RLHF流水线、多智能体优化等高级主题,已被系统性地梳理并纳入 AladdinEdu平台课题广场 ,等待你的深入探索与创新。

项目地址:AladdinEdu-课题广场

更多推荐

已为社区贡献20条内容

已为社区贡献20条内容

所有评论(0)